Nunca vou esquecer a primeira vez que vi alguém passando horas copiando e colando dados de um site para uma planilha, tudo na mão. Parecia tentar esvaziar uma piscina usando uma colherzinha. Hoje em dia, automação de processos virou item básico — principalmente quando falamos de web scraping. Mas, com cada vez mais equipes querendo automatizar tarefas repetitivas, surge aquela dúvida: vale mais a pena apostar no RPA tradicional (Automação Robótica de Processos) ou já partir para agentes de IA e um raspador web IA?

Se você trabalha com vendas, ecommerce ou operações, provavelmente já se deparou com esse dilema. Os dados não mentem: , e outros 19% estão de olho para começar logo. Enquanto isso, agentes de IA e raspadores web IA estão evoluindo rápido, prometendo dar conta até dos sites mais chatos e dinâmicos em poucos cliques. E aí, como decidir? Bora entender o que é automação de processos, as diferenças entre RPA e agentes de IA, e por que o futuro do web scraping está cada vez mais ligado à abordagem de IA da .

Desmistificando a Automação de Processos: O Que Isso Significa na Prática?

Pra começar do começo: automação de processos é basicamente deixar o software fazer o trabalho repetitivo por você. Imagina um lava-rápido automático, só que para as tarefas do escritório — as máquinas assumem o que é manual e chato, e você pode focar no que realmente importa (ou, pelo menos, tomar um café sossegado).

No dia a dia das empresas, automação de processos é sinônimo de operações mais ágeis, menos erros e mais tempo livre pra equipe. No web scraping, automação significa usar ferramentas para coletar dados de sites — tipo preços, contatos ou avaliações — sem precisar clicar em cada página. Em vez de perder horas copiando e colando, você configura um “robô” digital ou agente para fazer isso por você. É como um auto-responder de e-mail, só que para a internet inteira.

Os benefícios são evidentes: . E, falando como alguém que já desenvolveu SaaS e soluções de automação, posso garantir: depois que você automatiza o web scraping, nunca mais quer voltar pro trabalho manual.

RPA em Detalhes: O Que é Automação Robótica de Processos?

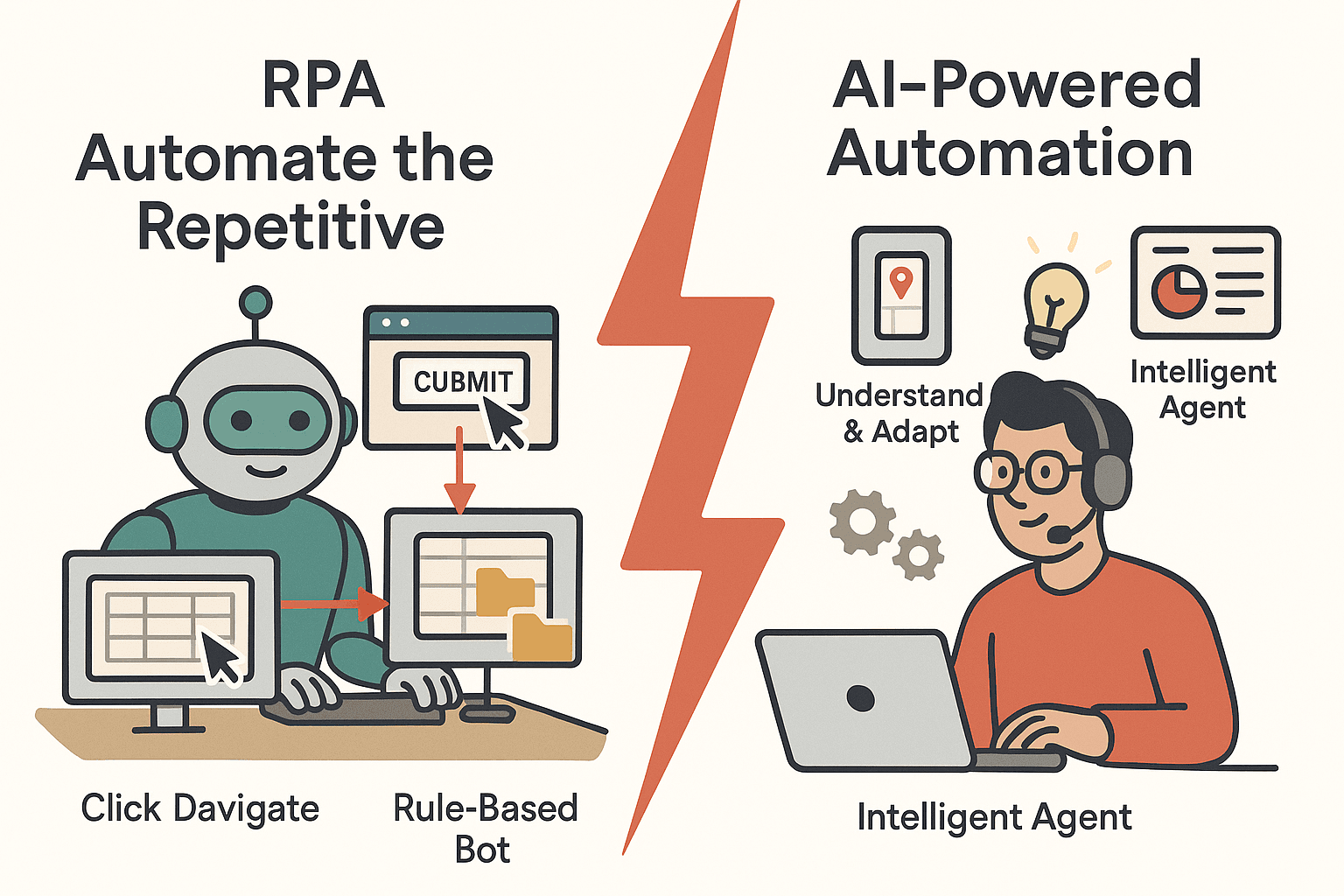

A Automação Robótica de Processos (RPA) é a velha conhecida da automação. O RPA usa “robôs” de software que imitam o que a gente faz no computador — clicam em botões, navegam em sites, copiam e colam dados entre sistemas. Esses bots seguem regras bem certinhas, sendo ótimos para tarefas repetitivas e organizadas.

Exemplos de Uso de RPA em Web Scraping

- Fazer login em um site e puxar dados de campos específicos

- Copiar informações de formulários online para bancos de dados internos

- Baixar relatórios de portais web em horários programados

O RPA é bastante usado em áreas como finanças, ecommerce e operações. Por exemplo, um varejista pode usar RPA para monitorar preços dos concorrentes toda noite, ou uma equipe financeira pode atualizar planilhas com cotações automaticamente.

Pontos Fortes do RPA

- Confiabilidade: Bots não cansam e não erram digitação. Funcionam 24/7 e são .

- Conformidade: Tudo fica registrado, facilitando auditorias.

- Implantação rápida: Para tarefas simples e repetitivas, o RPA é fácil de configurar — sem grandes integrações.

Limitações do RPA

Mas aí vem o porém: o RPA é super rígido. Se o site muda o layout, o bot pode travar. É como ensinar alguém a dirigir decorando cada curva — se a estrada muda, ele se perde. O RPA também sofre com:

- Conteúdo dinâmico: Rolagem infinita, pop-ups ou layouts que mudam exigem lógica extra e manutenção constante.

- Dados não estruturados: Se as informações mudam de lugar, o RPA se confunde.

- Manutenção: .

Ou seja, o RPA é ótimo para tarefas rotineiras e bem definidas, mas não é a solução mais flexível do pedaço.

Conheça o Novo: O Que é um Agente de IA?

Chegam os agentes de IA — uma geração nova de automação, muito mais esperta e adaptável. No web scraping, um agente de IA é um programa autônomo que recebe um objetivo (“pegue todos os nomes e preços de produtos deste site”) e descobre sozinho como chegar lá.

Como Agentes de IA Diferem do RPA

- Aprendizado e Adaptação: Agentes de IA usam machine learning e processamento de linguagem natural para entender, decidir e agir. Conseguem lidar com dados bagunçados, aprender com novos padrões e ajustar o que fazem conforme necessário.

- Compreensão de Contexto: Em vez de seguir regras duras, agentes de IA interpretam o conteúdo da página — reconhecem padrões, entendem contexto e até analisam imagens ou textos soltos.

- Instruções em Linguagem Natural: Muitas vezes, basta explicar para o agente de IA o que você quer, em português mesmo, e ele descobre o caminho sozinho.

Pensa no RPA como um funcionário que segue tudo à risca, enquanto o agente de IA é aquele assistente que improvisa e se vira em qualquer situação.

O Raspador Web IA: A Próxima Evolução

Os raspadores web IA vão além. Eles usam modelos avançados para detectar campos de dados automaticamente, lidar com paginação e rolagem infinita, e até extrair dados de subpáginas — tudo com configuração mínima. É aí que ferramentas como a brilham, tornando a automação acessível pra todo mundo, não só pra quem é dev.

Automação de Processos para Web Scraping: Por Que Automatizar?

Por que automatizar o web scraping? Porque fazer isso na mão é lento, cheio de erros e não escala. Automatizar traz:

- Economia de tempo: Bots extraem centenas de páginas em minutos — o que antes levava dias ou semanas.

- Redução de custos: ao trocar o trabalho manual por automação.

- Precisão: Dados mais consistentes e sem erro.

- Escalabilidade: Raspadores automatizados dão conta de milhares de produtos ou milhões de registros.

- Vantagem competitiva: Dados mais rápidos e atualizados permitem decisões melhores e respostas rápidas.

Olha só uma tabela com casos comuns de web scraping e os benefícios de automatizar cada um:

| Caso de Uso em Web Scraping | O Que é Coletado e Por Quê | Benefício da Automação |

|---|---|---|

| Monitoramento de Preços de Concorrentes | Preços de produtos, estoque | Inteligência de preços em tempo real, economiza horas de checagem manual |

| Geração de Leads | Nomes, e-mails, telefones | Alimenta o funil de vendas 24/7, libera equipe para vender |

| Pesquisa de Mercado | Avaliações, notas | Agrega opiniões rapidamente, identifica tendências |

| Agregação de Catálogo de Produtos | Detalhes de produtos | Mantém bancos de dados atualizados, acelera o lançamento de produtos |

| Listagens Imobiliárias | Preços, localizações | Insights diários do mercado, relatórios completos |

| Extração de Dados Financeiros | Cotações, relatórios | Atualizações em tempo real, escala para milhares de dados |

| Monitoramento de Conformidade | Uso de marca, políticas | Aplicação consistente, alertas instantâneos, trilha de auditoria |

Resumindo: .

RPA vs Agente de IA: Como Automatizam o Web Scraping?

Vamos ao que interessa. Como RPA e agentes de IA encaram o web scraping? Olha a comparação:

| Etapa | Abordagem RPA | Abordagem Agente de IA |

|---|---|---|

| Configuração Inicial | Usuário grava cada ação, define cada campo | Usuário fornece a URL e descreve os dados desejados; IA identifica os campos automaticamente |

| Flexibilidade | Frágil — quebra com mudanças no site | Adaptável — lida com mudanças de layout e novos padrões |

| Dados Estruturados | Funciona bem | Funciona bem |

| Dados Não Estruturados | Tem dificuldade | Excelente — interpreta texto, imagens, contexto |

| Paginação/Rolagem | Exige scripts específicos | Detecta e lida automaticamente |

| Manutenção | Alta — precisa de ajustes a cada mudança | Baixa — IA se adapta a pequenas alterações |

| Habilidade Técnica Necessária | Moderada — requer configuração | Baixa — sem código, prompts em linguagem natural |

| Escalabilidade | Limitada por licenças de bots | Nativo na nuvem, escala facilmente |

Quando Cada Um é Melhor?

- RPA é ideal para sites estáveis, previsíveis e com dados organizados — tipo portais internos ou sistemas antigos.

- Agentes de IA brilham quando o site é dinâmico, bagunçado ou muda toda hora, ou quando a equipe não é técnica.

RPA para Web Scraping: O Caminho Tradicional

Exemplo prático: usando RPA (tipo UiPath ou Automation Anywhere), você:

- Grava sua navegação: abre o navegador, faz login, clica nas páginas, copia os dados.

- O bot repete tudo, passando pelas páginas e jogando os dados na planilha ou banco de dados.

Desafios comuns:

- Mudanças no site: Um banner novo ou botão renomeado pode travar o bot.

- Paginação: Rolagem infinita ou botões “Carregar mais” exigem scripts extras.

- Conteúdo dinâmico: Bots precisam de comandos para esperar o carregamento.

- Medidas anti-bot: CAPTCHAs e bloqueios de IP podem parar o RPA.

- Escalabilidade: Rodar muitos bots ao mesmo tempo pode sair caro e ser complicado.

RPA é ótimo para sites internos e estáveis — mas pra web aberta, pode dar trabalho manter.

Raspador Web IA: A Nova Geração da Automação de Processos

Agora, veja como um raspador web IA faz o mesmo serviço:

- Abre o site, clica em “IA Sugerir Campos” e deixa a IA analisar a página.

- A IA sugere uma tabela com os dados que pode extrair — nomes de produtos, preços, avaliações, etc.

- Você ajusta ou aceita as sugestões e clica em “Raspar”.

- O agente de IA cuida da paginação, segue links de subpáginas e exporta os dados para Excel, Google Sheets, Airtable ou Notion.

Principais vantagens:

- Configuração mínima: Sem código, sem marcar campo por campo — só descrever o que quer.

- Lida com subpáginas e paginação: A IA detecta e segue links sozinha.

- Interpretação inteligente dos dados: A IA pode limpar, formatar e até categorizar os dados na hora.

- Exportação fácil: Um clique e os dados vão direto pra sua ferramenta favorita.

Pra quem não é técnico (e até pra quem é, mas não quer perder tempo), isso muda tudo. É como trocar aquele celular tijolão por um smartphone top.

Thunderbit em Destaque: Raspador Web IA como Agente de IA

Agora, deixa eu falar do projeto onde investi meu tempo (e muitas madrugadas): . O Thunderbit é uma extensão Chrome de raspador web IA que está evoluindo para ser um agente de IA completo para automação web. Nosso objetivo? Deixar o web scraping tão fácil que até sua avó consiga usar (e talvez até ache divertido).

O Que Torna o Thunderbit Diferente?

- IA Sugerir Campos: Um clique e a IA lê a página, sugerindo as melhores colunas pra raspar.

- Raspagem de Subpáginas: O Thunderbit visita cada subpágina (tipo páginas de detalhes de produtos) e enriquece sua tabela — sem configuração extra.

- Detecção de Paginação: Seja botão “Próximo” ou rolagem infinita, a IA do Thunderbit identifica e continua raspando.

- Exportação Instantânea: Exporte seus dados para Excel, Google Sheets, Airtable ou Notion com um clique — sem custo extra.

- Sem Código Necessário: Tudo pensado pra quem é de negócios, não só pra devs.

- Raspagem na Nuvem ou no Navegador: Escolha raspar na nuvem (rápido, paralelo) ou no seu navegador (ótimo pra sites com login).

- Utilitários IA Gratuitos: Extraia e-mails, telefones ou imagens de qualquer site com um clique.

- Raspador Agendado: Programe raspagens recorrentes com linguagem natural — “todos os dias às 9h” — e o Thunderbit faz o resto.

O Thunderbit nasceu pra ser o “assistente de dados IA” do seu navegador. Não é só sobre raspar dados — é sobre automatizar tudo, da extração à exportação, com o mínimo de esforço. E estamos só começando. O futuro são agentes de IA que não só leem a web, mas também agem nela.

Quer testar? .

Como Escolher: Quando Usar RPA, Agente de IA ou Ambos

Como decidir entre RPA e agentes de IA (tipo o Thunderbit) pra automação de web scraping? Olha esse checklist rápido:

| Fator de Decisão | RPA | Agente de IA / Raspador Web IA |

|---|---|---|

| Dados altamente estruturados e site estável | ✅ | |

| Dados desorganizados, não estruturados ou site muda com frequência | ✅ | |

| Precisa lidar com conteúdo dinâmico (rolagem infinita, pop-ups) | ✅ | |

| Equipe com habilidades técnicas/IT | ✅ | ✅ |

| Equipe não técnica | ✅ | |

| Conformidade/auditoria exige etapas rígidas e repetíveis | ✅ | |

| Precisa escalar rápido ou raspar muitos sites | ✅ | |

| Raspagem pontual ou ad-hoc | ✅ | |

| Processo recorrente e repetitivo | ✅ | ✅ |

| Quer combinar forças | Híbrido possível | Híbrido possível |

Dica: Muitas empresas já misturam as duas abordagens — usando RPA pra fluxos internos e estruturados, e agentes de IA pra dados externos e dinâmicos. O futuro é híbrido.

Superando Desafios Comuns na Automação de Web Scraping

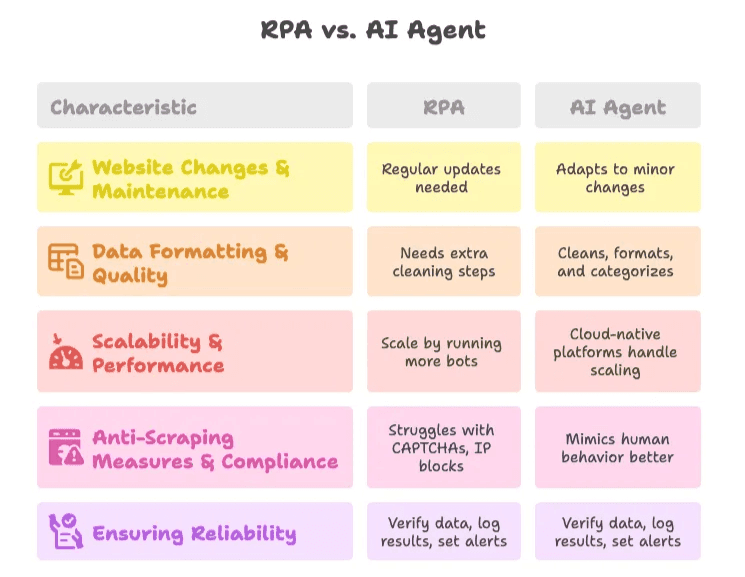

1. Mudanças em Sites & Manutenção

- RPA: Precisa de atualização toda vez que o site muda. Use scripts modulares e monitore pra pegar problemas cedo.

- Agente de IA: Mais resiliente — a IA se adapta a pequenas mudanças, mas vale revisar os resultados de vez em quando.

2. Formatação & Qualidade dos Dados

- RPA: Exige etapas extras pra limpar os dados ou integrar com scripts/Excel.

- Agente de IA: A IA pode limpar, formatar e até categorizar os dados durante a raspagem. Use prompts específicos pra resultados melhores.

3. Escalabilidade & Performance

- RPA: Escala rodando mais bots, mas fique de olho nos limites de acesso e custos de infraestrutura.

- Agente de IA: Plataformas nativas na nuvem, como Thunderbit, cuidam da escalabilidade pra você.

4. Medidas Anti-Scraping & Conformidade

- RPA: Pode sofrer com CAPTCHAs e bloqueios de IP. Prefira sites onde você tem permissão.

- Agente de IA: Alguns agentes de IA simulam melhor o comportamento humano, mas sempre respeite as regras do site e as leis de privacidade de dados.

5. Garantindo Confiabilidade

- Melhor Prática: Sempre confira os dados extraídos, registre resultados e configure alertas pra anomalias. Faça checagens manuais de tempos em tempos, principalmente em processos críticos.

O Futuro da Automação de Processos: Agentes de IA à Frente

Agora vem a parte legal. O mundo está migrando da automação pra autonomia. Agentes de IA não só seguem ordens — eles começam a tomar decisões, se adaptar a novos cenários e até sugerir ações com base nos dados coletados.

- .

- Até 2028, .

- Plataformas no-code e low-code estão deixando o desenvolvimento de agentes de IA acessível pra todo mundo — não só pra galera de TI.

Na Thunderbit, estamos construindo pra esse futuro. Nossa visão é deixar a automação de processos tão intuitiva que qualquer pessoa consiga automatizar web scraping, coleta de dados e até execuções de fluxos de trabalho com poucos cliques e comandos em linguagem natural. Não estamos só raspando dados — estamos criando os agentes de IA que vão puxar a próxima onda de automação nos negócios.

Quer ver pra onde estamos indo? Dá uma olhada no , ou aprofunde em temas como e .

Considerações Finais

Automação de processos não é mais só sobre trocar tarefas manuais por automáticas — é sobre dar poder pra equipe fazer mais, mais rápido e com menos esforço. RPA e agentes de IA têm seus papéis, mas a tendência é clara: raspadores web IA como o Thunderbit estão deixando a automação mais inteligente, resiliente e acessível pra todo mundo.

Se você ainda está copiando e colando dados na mão, tá na hora de largar a colherzinha e deixar os robôs fazerem o trabalho pesado. E se quiser ver o que agentes de IA podem fazer pelo seu negócio, . Seu futuro (e sua equipe) vão agradecer.

Perguntas Frequentes

1. Qual a diferença entre RPA e agentes de IA na automação de processos?

RPA (Automação Robótica de Processos) segue regras rígidas pra automatizar tarefas repetitivas, sendo ideal pra ambientes estáveis e organizados. Já agentes de IA interpretam contexto, se adaptam a mudanças e lidam com dados bagunçados usando machine learning e linguagem natural — perfeitos pra web scraping dinâmico e complexo.

2. Por que a automação de processos é importante para web scraping?

Fazer web scraping manualmente é lento, sujeito a erros e não escala. Automatizar economiza tempo, reduz custos, melhora a precisão e permite decisões em tempo real com dados sempre atualizados, sem precisar de intervenção manual.

3. Quando devo usar RPA em vez de um raspador web IA como o Thunderbit?

O RPA é mais indicado pra sites previsíveis, com dados organizados e quando é preciso documentação rigorosa de conformidade. Se sua equipe é técnica e os sites mudam pouco, o RPA pode ser uma escolha confiável.

4. O que diferencia o Thunderbit de ferramentas tradicionais de scraping?

O Thunderbit usa IA pra detectar campos automaticamente, lidar com paginação, extrair de subpáginas e exportar dados com um clique — sem precisar programar nada. É feito pra quem é de negócios e permite raspagem no navegador ou na nuvem, tornando a automação acessível pra quem não é dev.

5. RPA e agentes de IA podem ser usados juntos?

Sim. Muitas empresas usam RPA pra processos internos e estáveis, e agentes de IA como o Thunderbit pra sites externos e dinâmicos. Essa mistura aproveita o melhor das duas tecnologias pra uma automação mais completa e resistente.

Leituras recomendadas: