A primeira vez que muita gente se aventura no mundo da raspagem de dados é movida pela curiosidade e por um objetivo simples—tipo pegar informações de produtos de um site concorrente. Nessas horas, o BeautifulSoup logo aparece nas pesquisas, mas o começo pode assustar um pouco. Depois de alguns testes, rodar o comando pip install beautifulsoup4 e conseguir extrair um título de uma página HTML é aquele momento “eureka” que faz qualquer iniciante em Python se empolgar.

Se você está começando a explorar o universo da raspagem de dados, provavelmente já ouviu falar do BeautifulSoup. Não é por acaso: ele é fácil de usar, poderoso e há mais de dez anos é a biblioteca queridinha para web scraping em Python. Neste guia, vou te mostrar como instalar o BeautifulSoup usando o pip, trazer exemplos práticos de código e explicar por que ele ainda é tão adorado por devs e analistas de dados. Também vou ser direto sobre as limitações dele—e por que cada vez mais equipes (principalmente quem não programa) estão migrando para soluções com IA, como o .

O que é o BeautifulSoup e por que ele continua tão popular?

Vamos ao básico: o que é o BeautifulSoup? Pense nele como um “parser” de HTML super amigável para Python. Você entrega um pedaço de HTML ou XML, e ele devolve uma estrutura de árvore fácil de navegar, pesquisar e manipular com Python. É como enxergar o esqueleto das páginas web—de repente, todas aquelas tags e atributos bagunçados viram dados acessíveis.

Por que o BeautifulSoup ainda faz tanto sucesso?

Mesmo com o surgimento de frameworks mais modernos, o BeautifulSoup segue sendo a porta de entrada para a maioria dos iniciantes em Python. Para ter uma ideia, ele é baixado mais de no PyPI. E não é só fama—no Stack Overflow, já são mais de , ou seja, tem uma comunidade gigante pronta para ajudar quem está começando.

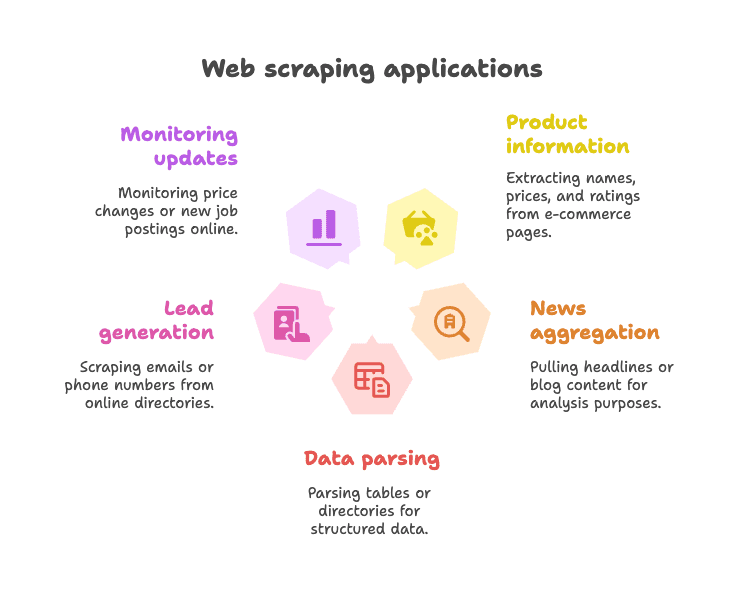

Principais usos:

- Extrair informações de produtos em lojas online (nome, preço, avaliações)

- Coletar manchetes de notícias ou posts de blogs para análise ou agregação

- Ler tabelas ou diretórios para pegar dados estruturados (tipo listas de empresas)

- Geração de leads ao capturar e-mails ou telefones em diretórios

- Monitorar atualizações (mudanças de preço, novas vagas, etc.)

O BeautifulSoup é especialmente útil para páginas estáticas—sites onde os dados já estão no HTML. Ele é flexível, tolerante (mesmo com HTML todo torto) e não te obriga a seguir um padrão rígido. Por isso, mesmo em 2025, ainda é o “primeiro amor” de muita gente que começa a raspar dados com Python ().

Pip Install BeautifulSoup: O Jeito Mais Fácil de Começar

O que é pip e por que usar?

Se você está começando com Python, o pip é o gerenciador de pacotes que permite instalar bibliotecas direto do Python Package Index (PyPI). É como uma loja de aplicativos, só que para código Python. Instalar o BeautifulSoup com pip é o caminho mais rápido e seguro para começar.

Dica: O nome certo do pacote é beautifulsoup4 (não só beautifulsoup). Sempre coloque o “4” para garantir a versão mais nova.

Passo a Passo: Instalando o BeautifulSoup

1. Veja sua versão do Python

O BeautifulSoup pede Python 3.7 ou mais recente. Confira no terminal:

1python --versionou

1python3 --version2. Instale o BeautifulSoup4 com pip

Abra o terminal ou prompt de comando e digite:

1pip install beautifulsoup4Se você tem mais de uma versão do Python, pode ser preciso:

1pip3 install beautifulsoup4No Windows, também dá para usar:

1py -m pip install beautifulsoup43. (Opcional, mas vale a pena) Instale um parser

O BeautifulSoup já funciona com o "html.parser" do Python, mas para mais velocidade e precisão, instale também lxml e html5lib:

1pip install lxml html5lib4. (Opcional) Instale o Requests

O BeautifulSoup não baixa páginas—ele só interpreta o HTML. A maioria usa a biblioteca para buscar o conteúdo:

1pip install requests5. Teste se deu tudo certo

Faça um teste no Python:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)Se aparecer <title>Example Domain</title>, está funcionando.

Instalando o BeautifulSoup em um Ambiente Virtual

Sempre recomendo usar um para projetos em Python. Assim, você mantém as dependências organizadas e evita dor de cabeça.

Como criar um ambiente virtual:

1python -m venv venv

2# No Windows:

3venv\Scripts\activate

4# No macOS/Linux:

5source venv/bin/activate

6pip install beautifulsoup4 requests lxml html5libTudo que você instalar fica isolado na pasta do projeto. Chega de problema com pacote faltando.

Outras formas de instalar (Conda, etc.)

Se você usa o , pode instalar o BeautifulSoup assim:

1conda install beautifulsoup4E para o parser:

1conda install lxmlSó não esqueça de ativar o ambiente conda antes.

BeautifulSoup Python: Primeiros Passos com Exemplos

Vamos colocar a mão na massa. Veja como usar o BeautifulSoup em um script Python de verdade.

Exemplo 1: Baixando uma página e pegando o título

1from bs4 import BeautifulSoup

2import requests

3url = "https://en.wikipedia.org/wiki/Python_(programming_language)"

4response = requests.get(url)

5soup = BeautifulSoup(response.content, "html.parser")

6# Pega o título da página

7title_text = soup.title.string

8print("Título da página:", title_text)Esse script acessa a página da Wikipedia sobre Python, interpreta o HTML e mostra o título. Moleza, né?

Exemplo 2: Pegando todos os links

1links = soup.find_all('a')

2for link in links[:10]: # Mostra os 10 primeiros links

3 href = link.get('href')

4 text = link.get_text()

5 print(f"{text}: {href}")Isso imprime o texto e o endereço dos 10 primeiros links da página.

Exemplo 3: Extraindo manchetes

1headings = soup.find_all('h2')

2for h in headings:

3 print(h.get_text().strip())Quer pegar todos os títulos <h2>? É só isso.

Exemplo 4: Usando seletores CSS

1items = soup.select("ul.menu > li")

2for item in items:

3 print(item.get_text())O método select() permite usar seletores CSS que você já conhece.

Exemplo 5: Pegando atributos e tags aninhadas

1first_link = soup.find('a')

2print(first_link['href']) # Acesso direto (dá erro se não existir)

3print(first_link.get('href')) # Acesso seguro (retorna None se não existir)Exemplo 6: Extraindo todo o texto

1text_content = soup.get_text()

2print(text_content)Isso pega todo o texto da página—ótimo para análises rápidas.

Tarefas comuns com BeautifulSoup para quem está começando

Veja algumas tarefas que você vai usar bastante com BeautifulSoup:

-

Encontrar um elemento:

soup.find('div', class_='price') -

Encontrar todos os elementos:

soup.find_all('p', class_='description') -

Pegar o texto:

element.get_text() -

Pegar o valor de um atributo:

element.get('href') -

Usar seletores CSS:

soup.select('table.data > tr') -

Lidar com elementos ausentes:

1price = soup.find('span', class_='price') 2if price: 3 print(price.get_text())

A sintaxe é fácil de ler, amigável para quem está começando e funciona até com HTML todo bagunçado ().

Limitações do BeautifulSoup para Raspagem Web Moderna

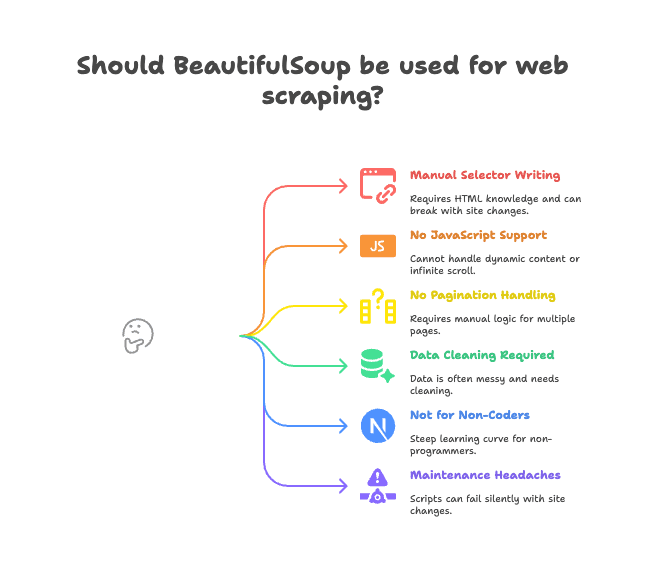

Agora, vamos falar dos desafios. O BeautifulSoup é ótimo para páginas estáticas e projetos pequenos, mas não resolve tudo.

Principais dificuldades:

- Seletores manuais: Você precisa analisar o HTML e escrever os caminhos certos. Se o site muda, o script quebra.

- Não lida com JavaScript: O BeautifulSoup só vê o HTML enviado pelo servidor. Se o site carrega dados via JavaScript (scroll infinito, conteúdo dinâmico), ele não enxerga ().

- Sem suporte nativo a paginação ou subpáginas: Para raspar várias páginas ou acessar detalhes de produtos, você precisa programar toda a lógica.

- Necessidade de limpar dados: Os dados extraídos costumam vir com espaços extras, caracteres estranhos, formatos inconsistentes.

- Não é para quem não programa: Se você trabalha com vendas, marketing ou operações e não sabe programar, o BeautifulSoup é um desafio.

- Manutenção trabalhosa: Se o site muda o layout, seu script pode parar de funcionar sem aviso.

Para muitas equipes, esses “detalhes” acabam virando gargalos reais de produtividade. Já vi projetos travarem porque o script de raspagem precisava de manutenção o tempo todo.

Por que equipes estão migrando para o Thunderbit para extração de dados web

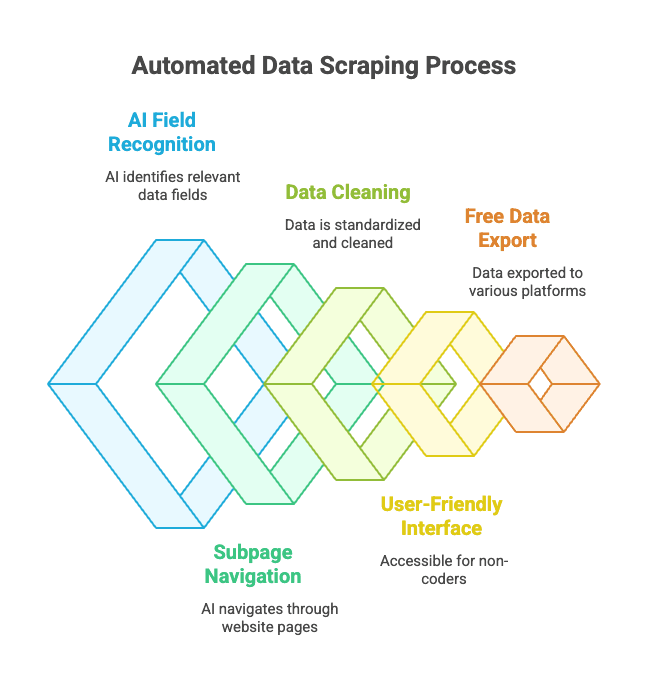

E qual é a alternativa? É aí que entra o . O Thunderbit não é só mais uma biblioteca Python—é uma extensão do Chrome que funciona como um assistente de dados web com IA.

Como funciona?

- Você abre o site que quer raspar.

- Clica em “AI Sugerir Campos”—a IA do Thunderbit lê a página e sugere as colunas certas (tipo “Nome do Produto”, “Preço”, “Localização”).

- Você pode ajustar os nomes e tipos das colunas se quiser.

- Clica em “Raspar” e o Thunderbit coleta, limpa e organiza os dados para você.

- Exporte para Excel, Google Sheets, Notion, Airtable ou sua ferramenta favorita com um clique.

Sem código. Sem seletores. Sem dor de cabeça com manutenção.

Destaques do Thunderbit:

- Reconhecimento de campos por IA: A IA entende quais dados você quer, mesmo com HTML bagunçado.

- Raspagem de subpáginas e paginação: Ele acessa páginas de produtos ou lida com “próxima página” automaticamente.

- Limpeza e formatação de dados: O Thunderbit padroniza telefones, e-mails, imagens e mais.

- Fácil para quem não programa: Se você sabe usar um navegador, sabe usar o Thunderbit.

- Exportação gratuita de dados: Exporte para Excel, Google Sheets, Airtable, Notion—sem bloqueio para exportações básicas.

- Raspagem agendada: Programe e deixe o Thunderbit coletar dados automaticamente.

Para quem trabalha com negócios, isso muda totalmente a forma de extrair dados da web. Em vez de lidar com scripts Python, basta apontar, clicar e receber os dados prontos.

Thunderbit vs. BeautifulSoup: Qual é o melhor para você?

Vamos comparar:

| Recurso | BeautifulSoup (Código Python) | Thunderbit (IA sem código) |

|---|---|---|

| Configuração | Requer Python, pip, código | Extensão Chrome, instalação em 2 cliques |

| Velocidade até os dados | Horas para o primeiro script | Minutos por site |

| Lida com JavaScript | Não (precisa de ferramentas extras) | Sim (roda no navegador) |

| Paginação/Subpáginas | Precisa de código manual | Nativo, opção de ativar |

| Limpeza de dados | Código manual | IA faz automaticamente |

| Exportação | Você mesmo gera CSV/Excel | Um clique para Sheets, Notion, etc. |

| Melhor para | Desenvolvedores, entusiastas | Usuários de negócios, quem não programa |

| Custo | Gratuito (mas consome tempo) | Freemium (grátis para tarefas pequenas) |

Quando usar o BeautifulSoup:

- Você já manja de Python e quer controle total.

- Precisa raspar sites estáticos ou lógica personalizada.

- Vai integrar a raspagem em um fluxo maior em Python.

Quando usar o Thunderbit:

- Quer resultados rápidos, sem programar.

- Precisa lidar com sites dinâmicos (JavaScript).

- Trabalha em vendas, marketing, operações ou não quer mexer com código.

- Quer exportar dados direto para suas ferramentas de trabalho.

Sendo bem sincero, mesmo como dev, às vezes uso o Thunderbit quando preciso de dados rápidos sem montar um projeto Python inteiro. É como ter um superpoder no navegador.

Boas práticas para instalar e usar o BeautifulSoup

Se você vai seguir com o BeautifulSoup, aqui vão algumas dicas para evitar dor de cabeça:

- Sempre use ambiente virtual: Mantém as dependências organizadas e evita o clássico “funciona só no meu PC”.

- Mantenha pip e pacotes atualizados: Rode

pip install --upgrade pipepip list --outdatedde vez em quando. - Instale os parsers recomendados:

pip install lxml html5libpara mais desempenho e robustez. - Escreva código modular: Separe a lógica de download e parsing para facilitar a manutenção.

- Respeite o robots.txt e limites de acesso: Não sobrecarregue sites—use

time.sleep()entre as requisições. - Use seletores descritivos e estáveis: Evite caminhos muito específicos que quebram fácil.

- Teste o parsing em HTML salvo: Baixe a página e teste offline para não repetir requisições.

- Aproveite a comunidade: é ótimo para tirar dúvidas.

Solução de problemas na instalação do BeautifulSoup

Deu ruim? Confira este checklist:

- “ModuleNotFoundError: No module named bs4”

- Você instalou o

beautifulsoup4no ambiente certo? Tentepython -m pip install beautifulsoup4.

- Você instalou o

- Instalou o pacote errado (

beautifulsoupem vez debeautifulsoup4)- Desinstale o antigo:

pip uninstall beautifulsoup - Instale o certo:

pip install beautifulsoup4

- Desinstale o antigo:

- Avisos de parser ou erros de Unicode

- Instale

lxmlehtml5libe especifique o parser:BeautifulSoup(html, "lxml")

- Instale

- Elementos não encontrados

- Os dados são carregados por JavaScript? O BeautifulSoup não vê. Confira o código-fonte da página, não o DOM renderizado.

- Erros do pip ou de permissão

- Use ambiente virtual, ou tente

pip install --user beautifulsoup4 - Atualize o pip:

pip install --upgrade pip

- Use ambiente virtual, ou tente

- Problemas com conda

- Tente

conda install beautifulsoup4ou use pip dentro do ambiente conda.

- Tente

Ainda com dúvidas? e o Stack Overflow cobrem quase todos os cenários.

Conclusão: O que levar deste guia sobre BeautifulSoup

-

BeautifulSoup é a biblioteca Python mais popular para raspagem web—simples, flexível e perfeita para quem está começando.

-

Instale com pip:

1pip install beautifulsoup4 lxml html5lib requests -

Use ambiente virtual para manter tudo organizado.

-

BeautifulSoup é ótimo para páginas estáticas e projetos pequenos, mas tem limitações com JavaScript, paginação e manutenção.

-

Thunderbit é a alternativa moderna com IA para quem não programa—sem código, sem complicação, só dados.

-

Escolha a ferramenta certa para sua necessidade:

- Desenvolvedores e entusiastas: BeautifulSoup dá controle total.

- Usuários de negócios e equipes: entrega resultados rápidos.

Teste os dois caminhos—às vezes, a melhor solução é a que resolve seu problema com menos esforço.

Perguntas Frequentes: Pip Install BeautifulSoup e mais

Q: Qual a diferença entre beautifulsoup e beautifulsoup4?

R: Sempre instale o beautifulsoup4—é a versão mais recente e compatível. O pacote antigo beautifulsoup está desatualizado e não funciona com Python 3. Você importa assim: from bs4 import BeautifulSoup ().

Q: Preciso instalar lxml ou html5lib junto com o BeautifulSoup?

R: Não é obrigatório, mas é super recomendado. Eles deixam o parsing mais rápido e robusto. Instale com pip install lxml html5lib ().

Q: O BeautifulSoup consegue lidar com sites cheios de JavaScript?

R: Não—o BeautifulSoup só vê o HTML estático. Para conteúdo dinâmico, use ferramentas como Selenium ou experimente uma solução com IA no navegador, como o ().

Q: Como desinstalo o BeautifulSoup?

R: Rode pip uninstall beautifulsoup4 no terminal ().

Q: O Thunderbit é gratuito?

R: O Thunderbit tem um modelo freemium—grátis para tarefas pequenas, com planos pagos para volumes maiores ou recursos avançados. Você pode testar de graça direto no navegador ().

Se quiser ver como o Thunderbit se sai em comparação ao BeautifulSoup em situações reais, confira nossa . E se quiser se aprofundar em raspagem web, não perca nossos guias sobre e .

Boas raspagens—e lembre-se: seja você fera em Python ou só quer seus dados em uma planilha, tem uma ferramenta (e uma comunidade) pronta para te ajudar a chegar lá.