A web em 2026 está mais agitada do que nunca — metade do tráfego online já vem de bots, e os crawlers open-source são os verdadeiros motores por trás de tarefas como monitoramento de preços e treinamento de IA. Depois de anos lidando com SaaS e automação, aprendi que escolher o crawler web auto-hospedado certo pode salvar sua equipe de meses de dor de cabeça (e algumas noites viradas corrigindo bug). Seja para extrair dados de algumas páginas de produto ou para rastrear milhões de URLs em pesquisas, as alternativas open-source ao Firecrawl que selecionei aqui vão cobrir qualquer necessidade — não importa o tamanho do seu projeto, stack de tecnologia ou nível de complexidade.

Mas fica o aviso: não existe bala de prata. Algumas equipes vão precisar da robustez do Scrapy ou da capacidade de arquivamento do Heritrix, enquanto outras podem achar que manter bibliotecas open-source sai caro demais. Por isso, vou detalhar as 9 melhores alternativas open-source ao Firecrawl para 2026, mostrar os pontos fortes de cada uma e te ajudar a escolher a ferramenta ideal para o seu negócio — sem perder tempo com tentativa e erro.

Como Escolher a Melhor Alternativa Open-Source ao Firecrawl para Sua Empresa

Antes de mergulhar na lista, vale pensar na estratégia. O universo dos crawlers open-source nunca foi tão diverso, e sua escolha deve considerar alguns pontos principais:

- Facilidade de uso: Você prefere uma interface visual ou se sente à vontade programando em Python, Go ou JavaScript?

- Escalabilidade: Precisa extrair dados de um único site ou rastrear milhões de páginas em centenas de domínios?

- Tipo de conteúdo: O site alvo é HTML estático ou depende de JavaScript pesado e carregamento dinâmico?

- Integração: Como você pretende usar os dados — exportar para Excel, enviar para um banco de dados ou alimentar um pipeline de analytics?

- Manutenção: Tem equipe para manter código próprio ou prefere uma ferramenta que se adapte automaticamente às mudanças dos sites?

Aqui vai um resumo rápido para ajudar na decisão:

| Cenário | Melhor Ferramenta(s) |

|---|---|

| Navegação offline, sem código | HTTrack |

| Rastreamento em larga escala | Scrapy, Apache Nutch, StormCrawler |

| Sites dinâmicos/com muito JS | Puppeteer |

| Automação de formulários/login | MechanicalSoup |

| Download/arquivamento de sites | Wget, HTTrack, Heritrix |

| Desenvolvedor Go, alta performance | Colly |

Agora, bora conhecer as 9 principais alternativas open-source ao Firecrawl para 2026.

1. Scrapy: Melhor para Crawling em Larga Escala com Python

é referência quando o assunto é raspador web open-source. Feito em Python, é a escolha de quem precisa escalar — pense em milhões de páginas, atualizações frequentes e lógica complexa de sites.

Por que escolher o Scrapy?

- Escalabilidade: Suporta milhares de requisições por segundo e é usado por empresas que extraem bilhões de páginas por mês ().

- Extensível e Modular: Permite criar spiders customizadas, usar middlewares para proxies, lidar com logins e exportar para JSON, CSV ou bancos de dados.

- Comunidade ativa: Muitos plugins, documentação e respostas no Stack Overflow.

- Testado em produção: Utilizado por equipes de e-commerce, notícias e pesquisa no mundo todo.

Limitações: Curva de aprendizado alta para quem não é dev, e exige manutenção constante dos spiders conforme os sites mudam. Mas, para quem busca controle total e escalabilidade, o Scrapy é imbatível.

2. Apache Nutch: Melhor para Motores de Busca Empresariais

é um dos pioneiros dos crawlers open-source, feito para rastreamento em escala de internet. Se você sonha em criar seu próprio motor de busca ou rastrear milhões de domínios, o Nutch é o caminho.

Por que escolher o Apache Nutch?

- Escalabilidade com Hadoop: Baseado em Hadoop, o Nutch pode rastrear bilhões de páginas em clusters de servidores ( utiliza para rastrear a web pública).

- Rastreamento em lote: Basta fornecer uma lista de URLs iniciais e deixar rodar — ideal para tarefas agendadas e de grande porte.

- Integração: Compatível com Solr, Elasticsearch e pipelines de big data.

Limitações: Configuração complexa (clusters Hadoop, arquivos de configuração Java) e foca mais em rastreamento bruto do que em extração de dados estruturados. Exagero para projetos pequenos, mas insuperável para rastreamento em escala web.

3. Heritrix: Melhor para Arquivamento Web e Compliance

é o crawler oficial do Internet Archive, criado para arquivamento digital e preservação de conteúdo online.

Por que escolher o Heritrix?

- Arquivamento completo: Captura todas as páginas, arquivos e links — ideal para compliance legal ou registros históricos.

- Saída em WARC: Armazena tudo em arquivos Web ARChive padronizados, prontos para análise ou replay.

- Administração via web: Permite configurar e monitorar rastreamentos por interface web.

Limitações: Exige bastante disco e memória, não executa JavaScript e gera arquivos brutos em vez de tabelas estruturadas. Indicado para bibliotecas, arquivos ou setores regulados.

4. Colly: Melhor para Desenvolvedores Go que Buscam Performance

é o queridinho dos devs Go — rápido, leve e altamente concorrente.

Por que escolher o Colly?

- Altíssima performance: A concorrência do Go permite ao Colly rastrear milhares de páginas com baixo consumo de CPU/RAM ().

- API simples: Defina callbacks para elementos HTML, gerencie cookies e robots.txt automaticamente.

- Ótimo para sites estáticos: Perfeito para páginas renderizadas no servidor, APIs ou integração com backends em Go.

Limitações: Não possui renderização JavaScript nativa (para sites dinâmicos, é preciso usar algo como Chromedp) e requer conhecimento em Go.

5. MechanicalSoup: Melhor para Automação Simples de Formulários

é uma biblioteca Python que faz a ponte entre requisições HTTP simples e automação de navegador.

Por que escolher o MechanicalSoup?

- Automação de formulários: Faça login, preencha formulários e mantenha sessões facilmente — ótimo para extrair dados atrás de autenticação.

- Leve: Usa Requests e BeautifulSoup, sendo rápido e fácil de configurar.

- Ideal para sites interativos: Se precisa submeter buscas ou acessar dados após login, é uma excelente escolha ().

Limitações: Não executa JavaScript, então não funciona em sites muito dinâmicos. Melhor para páginas estáticas ou renderizadas no servidor com interações simples.

6. Puppeteer: Melhor para Sites Dinâmicos e Carregados de JavaScript

é a ferramenta coringa para extrair dados de sites modernos e dinâmicos. É uma biblioteca Node.js que oferece controle total sobre um navegador Chrome sem interface.

Por que escolher o Puppeteer?

- Lida com conteúdo dinâmico: Extrai dados de SPAs, infinite scroll e páginas que carregam dados via AJAX ().

- Simulação de usuário: Clica em botões, preenche formulários, tira screenshots e até resolve CAPTCHAs (com plugins).

- Automação poderosa: Ótimo para testes, monitoramento e extração de qualquer coisa que um usuário real possa ver.

Limitações: Consome muitos recursos (executa instâncias completas do Chrome), é mais lento que raspadores baseados apenas em HTTP e exige infraestrutura robusta para escalar.

7. Wget: Melhor para Downloads Rápidos via Linha de Comando

é a clássica ferramenta de linha de comando para baixar sites e arquivos estáticos.

Por que escolher o Wget?

- Simplicidade: Baixe sites ou diretórios inteiros com um único comando — sem necessidade de programação.

- Velocidade: Escrito em C, é rápido e eficiente.

- Ótimo para conteúdo estático: Ideal para sites de documentação, blogs ou downloads em massa ().

Limitações: Não executa JavaScript nem lida com formulários, e baixa páginas brutas (não dados estruturados). Pense nele como um aspirador digital para sites estáticos.

8. HTTrack: Melhor para Navegação Offline (Sem Código)

é a versão amigável do Wget, com interface gráfica para espelhar sites.

Por que escolher o HTTrack?

- Facilidade via GUI: Assistente passo a passo facilita o uso para quem não é técnico.

- Navegação offline: Ajusta links para você navegar localmente pelo site espelhado.

- Ótimo para arquivamento: Perfeito para pesquisadores, profissionais de marketing ou quem quer um snapshot de um site sem programar ().

Limitações: Não suporta conteúdo dinâmico, pode ser lento em sites grandes e não foi feito para extração de dados estruturados.

9. StormCrawler: Melhor para Crawling Distribuído em Tempo Real

é o crawler distribuído e moderno para equipes que precisam de dados web em tempo real e em grande escala.

Por que escolher o StormCrawler?

- Crawling em tempo real: Baseado no Apache Storm, processa dados como streams — ideal para monitoramento de notícias ou motores de busca ().

- Modular e escalável: Adicione parsing, indexação e processamento customizado conforme necessário.

- Usado pelo Common Crawl: Alimenta o dataset de notícias de um dos maiores arquivos web abertos.

Limitações: Exige desenvolvimento em Java e um cluster Storm, sendo indicado para equipes com experiência em sistemas distribuídos. Exagero para projetos pequenos.

Comparando Alternativas Open-Source ao Firecrawl: Qual Concorrente Gratuito é Ideal para Você?

Veja um comparativo lado a lado das 9 ferramentas:

| Ferramenta | Melhor Uso | Principais Vantagens | Desvantagens | Linguagem / Instalação |

|---|---|---|---|---|

| Scrapy | Crawling em larga escala, frequente | Potente, escalável, grande comunidade | Curva de aprendizado, exige Python | Framework Python |

| Apache Nutch | Crawling empresarial, escala web | Escalável com Hadoop, comprovado | Configuração complexa, processamento em lote | Java/Hadoop |

| Heritrix | Arquivamento, compliance | Captura completa, saída WARC | Pesado, sem JS, arquivos brutos | Aplicação Java, web UI |

| Colly | Devs Go, scraping de alta performance | Rápido, API simples, concorrência | Sem JS, exige Go | Biblioteca Go |

| MechanicalSoup | Automação de formulários, login | Leve, gerencia sessões | Sem JS, escala limitada | Biblioteca Python |

| Puppeteer | Sites dinâmicos/com muito JS | Controle total do navegador, automação | Consome recursos, exige Node.js | Biblioteca Node.js |

| Wget | Download de sites estáticos, offline | Simples, rápido, CLI | Sem JS, páginas brutas | Ferramenta CLI |

| HTTrack | Usuários não técnicos, arquivamento | GUI, navegação offline fácil | Sem JS, lento em sites grandes | App desktop (GUI) |

| StormCrawler | Crawling distribuído em tempo real | Escalável, modular, tempo real | Exige Java/Storm | Cluster Java/Storm |

Vale a Pena Criar Seu Próprio Crawler ou Usar uma Alternativa Open-Source ao Firecrawl?

A real é: criar seu próprio crawler pode parecer interessante — até você se deparar com a manutenção, proxies e bloqueios anti-bot. As ferramentas open-source acima reúnem anos de experiência e conhecimento da comunidade. Segundo relatórios do setor, usar soluções já existentes é o caminho mais rápido e confiável para obter resultados e evitar reinventar a roda ().

- Adote open-source se: Suas necessidades já são atendidas pelas opções disponíveis, você quer economizar tempo de desenvolvimento e valoriza o suporte da comunidade.

- Crie do zero se: Tem requisitos realmente únicos, equipe técnica experiente e scraping é parte central do seu negócio.

Mas lembre: open-source não significa "de graça" quando se coloca na conta o tempo de engenharia, manutenção de servidores e atualizações constantes para driblar bloqueios. Se você quer os benefícios de um raspador web poderoso sem precisar programar, existe uma alternativa.

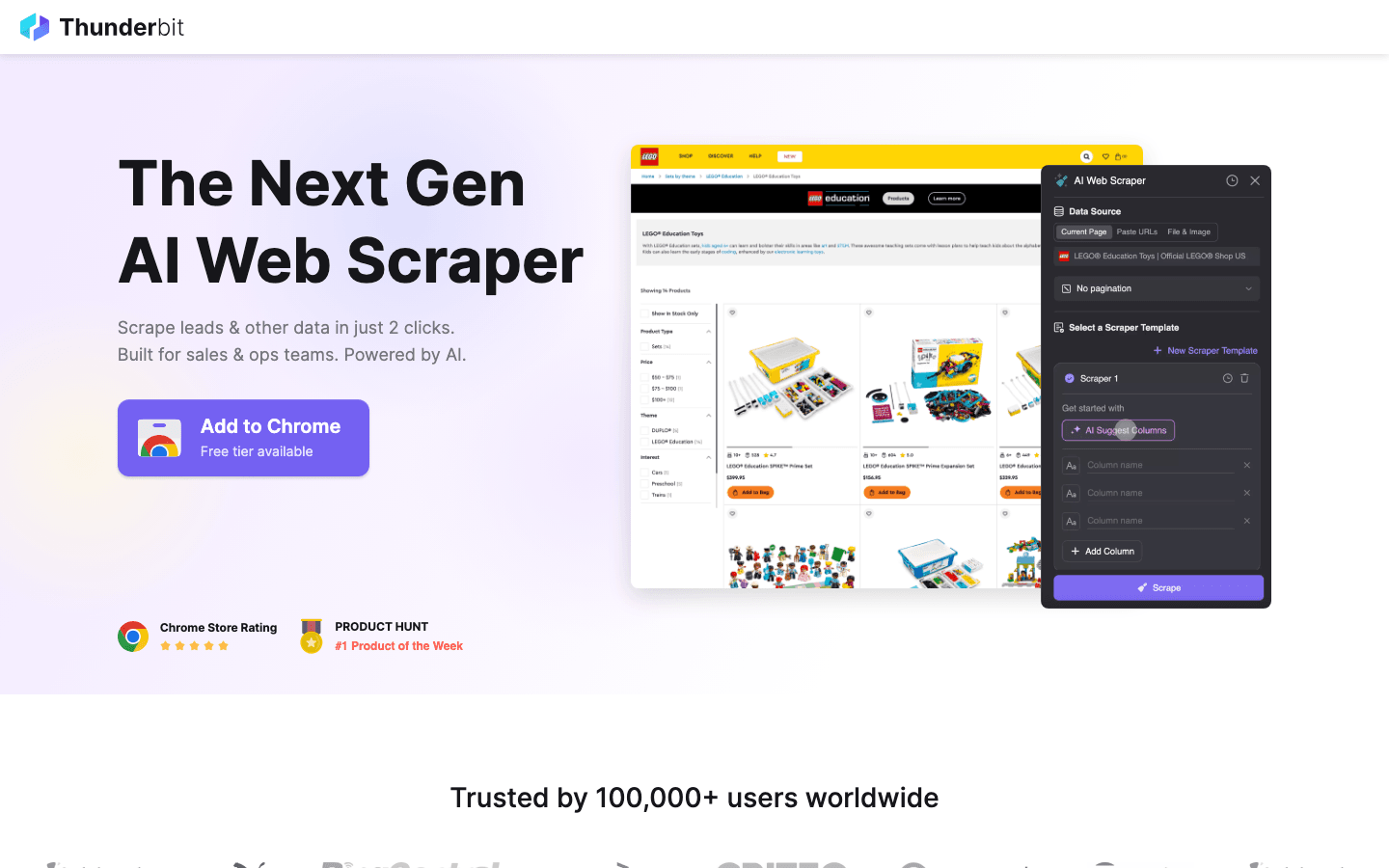

Bônus: Quando Open-Source é Complexo Demais, Experimente o Thunderbit

Apesar das ferramentas acima serem excelentes para devs, todas exigem conhecimento técnico, enfrentam dificuldades com anti-bots baseados em IA e demandam manutenção constante.

é minha principal recomendação para quem quer superar essas barreiras. Ele une poder de extração com facilidade de uso.

Por que considerar o Thunderbit em vez de open-source?

- Zero programação: Diferente do Scrapy ou Puppeteer, o Thunderbit é uma extensão do Chrome com IA. Basta clicar em “AI Sugerir Campos” e ele monta o raspador para você.

- Resolve o difícil: Conteúdo dinâmico, rolagem infinita e paginação são tratados automaticamente pela IA, poupando horas de scripts personalizados.

- Exportação instantânea: Extraia dados para Excel, Google Sheets ou Notion em poucos cliques.

- Sem manutenção: Não precisa atualizar código quando o site muda — a IA do Thunderbit se adapta automaticamente.

Se você é vendedor, profissional de marketing ou pesquisador e precisa de dados agora sem aprender Python ou Go, o Thunderbit é o complemento perfeito para as ferramentas open-source desta lista.

Quer ver na prática? e experimente.

Conclusão: Encontrando o Crawler Web Auto-hospedado Ideal para 2026

O universo de alternativas open-source ao Firecrawl nunca esteve tão completo. Seja pela escalabilidade do Scrapy ou Nutch, ou pela precisão de arquivamento do Heritrix, existe uma solução para cada cenário de negócio. O segredo é alinhar a ferramenta à sua necessidade — não complique se só precisa de uma extração rápida, e não economize se vai operar em escala de internet.

E lembre: se o caminho open-source parecer técnico ou demorado demais, ferramentas de IA como o Thunderbit estão prontas para facilitar sua vida.

Pronto para começar? Use o Scrapy no seu próximo projeto de dados ou para extração simples e inteligente. Quer mais dicas de raspador web? Confira o para tutoriais e conteúdos aprofundados.

Perguntas Frequentes

1. Qual a principal vantagem de usar alternativas open-source ao Firecrawl? Alternativas open-source oferecem flexibilidade, economia e a possibilidade de hospedar e personalizar seu próprio crawler web. Você evita dependência de fornecedores e conta com suporte e atualizações da comunidade.

2. Qual ferramenta é melhor para quem não tem conhecimento técnico e precisa de resultados rápidos? é uma ótima opção open-source para navegação offline. Mas, para extração de dados estruturados (como tabelas para Excel), recomendamos o Thunderbit devido à sua IA.

3. Como lidar com sites dinâmicos e carregados de JavaScript? é a melhor escolha — ele controla um navegador real, permitindo extrair qualquer conteúdo visível, inclusive SPAs e páginas AJAX.

4. Quando usar um crawler robusto como Apache Nutch ou StormCrawler? Se precisa rastrear milhões de páginas em vários domínios ou exige crawling distribuído em tempo real (como motores de busca ou monitoramento de notícias), essas ferramentas são feitas para escala e confiabilidade.

5. Vale mais a pena criar meu próprio crawler ou usar uma solução open-source existente? Para a maioria das equipes, usar e customizar uma ferramenta open-source é mais rápido, barato e confiável. Só crie do zero se tiver necessidades muito específicas e recursos para manter a solução a longo prazo.

Boas extrações — que seus dados estejam sempre atualizados, organizados e prontos para uso.

Saiba mais