A internet em 2025 está mais agitada do que nunca — e metade desse movimento nem é de gente de verdade. Isso mesmo: bots e crawlers já são mais de 50% de todo o tráfego online (), e só uma parte deles são os “bons” bots que você realmente quer: buscadores, prévias de redes sociais e ferramentas de análise. O resto? Nem sempre está ali para ajudar. Depois de anos criando soluções de automação e IA na , vi de perto como um crawler — seja ele do bem ou não — pode mexer com seu SEO, bagunçar suas métricas, gastar sua banda ou até causar problemas de segurança.

Se você cuida de um site, toca um negócio online ou só quer manter sua estrutura digital protegida, saber quem está batendo na porta do seu servidor nunca foi tão importante. Por isso, montei este guia 2025 com os crawlers mais relevantes — explicando o que fazem, como identificar cada um e como garantir que só os bots confiáveis tenham acesso ao seu site.

O que faz um Crawler ser “Conhecido”? User-Agent, IPs e Verificação

Vamos ao básico: o que é, afinal, um crawler “conhecido”? Em resumo, é um bot que se apresenta com um user-agent consistente (tipo Googlebot/2.1 ou bingbot/2.0) e, de preferência, opera a partir de faixas de IP ou blocos ASN publicados e verificáveis (). Os grandes nomes — Google, Microsoft, Baidu, Yandex, DuckDuckGo — publicam documentação sobre seus bots e, muitas vezes, oferecem ferramentas ou arquivos JSON com seus IPs oficiais (, , ).

Mas aqui está o pulo do gato: confiar só no user-agent é arriscado. Falsificação rola solta — bots mal-intencionados vivem se passando por Googlebot ou Bingbot para driblar suas defesas (). Por isso, o padrão ouro é a verificação dupla: conferir tanto o user-agent quanto o IP (ou ASN), usando reverse DNS ou listas oficiais. Se você usa uma ferramenta como a , dá pra automatizar tudo isso — puxando logs, cruzando user-agents e IPs pra montar uma lista confiável e sempre atualizada de quem está rastreando seu site.

Como Usar Esta Lista de Crawlers

E na prática, o que fazer com uma lista de crawlers conhecidos? Olha só como aplicar:

- Liberar bots confiáveis: Garanta que os bots que você quer (buscadores, prévias de redes sociais) nunca sejam barrados pelo firewall, CDN ou WAF. Use os IPs e user-agents oficiais pra liberar o acesso certinho.

- Filtrar nas análises: Tire o tráfego de bots das suas métricas pra que seus relatórios mostrem só visitantes humanos — e não só o Googlebot e o AhrefsBot passeando pelo seu site ().

- Gerenciar bots: Crie regras de crawl-delay ou limitação pra ferramentas de SEO mais agressivas, e bloqueie ou desafie bots desconhecidos ou suspeitos.

- Análise automatizada de logs: Use ferramentas de IA (tipo Thunderbit) pra extrair, classificar e rotular a atividade dos crawlers nos seus logs, identificando tendências, impostores e mantendo suas políticas sempre em dia.

Manter sua lista de crawlers atualizada não é coisa de “configurou, esqueceu”. Novos bots aparecem, antigos mudam de comportamento e os atacantes ficam cada vez mais espertos. Automatizar as atualizações — puxando dados de documentações oficiais ou repositórios do GitHub com Thunderbit — economiza tempo e evita dor de cabeça.

1. Thunderbit: Identificação de Crawlers com IA e Gestão de Dados

A vai muito além de ser só um Raspador Web IA — é um verdadeiro assistente de dados pra equipes que querem entender e controlar o tráfego de crawlers. Veja o que faz a Thunderbit ser diferente:

- Pré-processamento semântico: Antes de extrair dados, a Thunderbit transforma páginas e logs em conteúdo estruturado no estilo Markdown. Esse pré-processamento semântico faz a IA entender o contexto, os campos e a lógica do que está analisando. Isso é essencial pra páginas complexas, dinâmicas ou cheias de JavaScript (tipo Facebook Marketplace ou discussões longas), onde raspadores tradicionais não dão conta.

- Verificação dupla: A Thunderbit coleta rapidinho documentações oficiais de IPs e listas ASN de crawlers, cruzando com seus logs de servidor. O resultado? Uma “lista de bots confiáveis” realmente segura — sem precisar checar tudo na mão.

- Extração automatizada de logs: Manda seus logs brutos pra Thunderbit e ela transforma tudo em tabelas organizadas (Excel, Sheets, Airtable), rotulando visitantes frequentes, caminhos suspeitos e bots conhecidos. Depois, dá pra integrar os resultados ao seu WAF ou CDN pra bloqueio, limitação ou desafios automáticos (CAPTCHA).

- Conformidade e auditoria: A extração semântica da Thunderbit mantém um histórico claro — quem acessou, quando e como você lidou com cada acesso. Isso facilita auditorias e o cumprimento de normas como GDPR e LGPD.

Já vi equipes reduzirem em até 80% o tempo gasto com gestão de crawlers usando a Thunderbit — finalmente entendendo quais bots ajudam, quais atrapalham e quais só fingem ser legítimos.

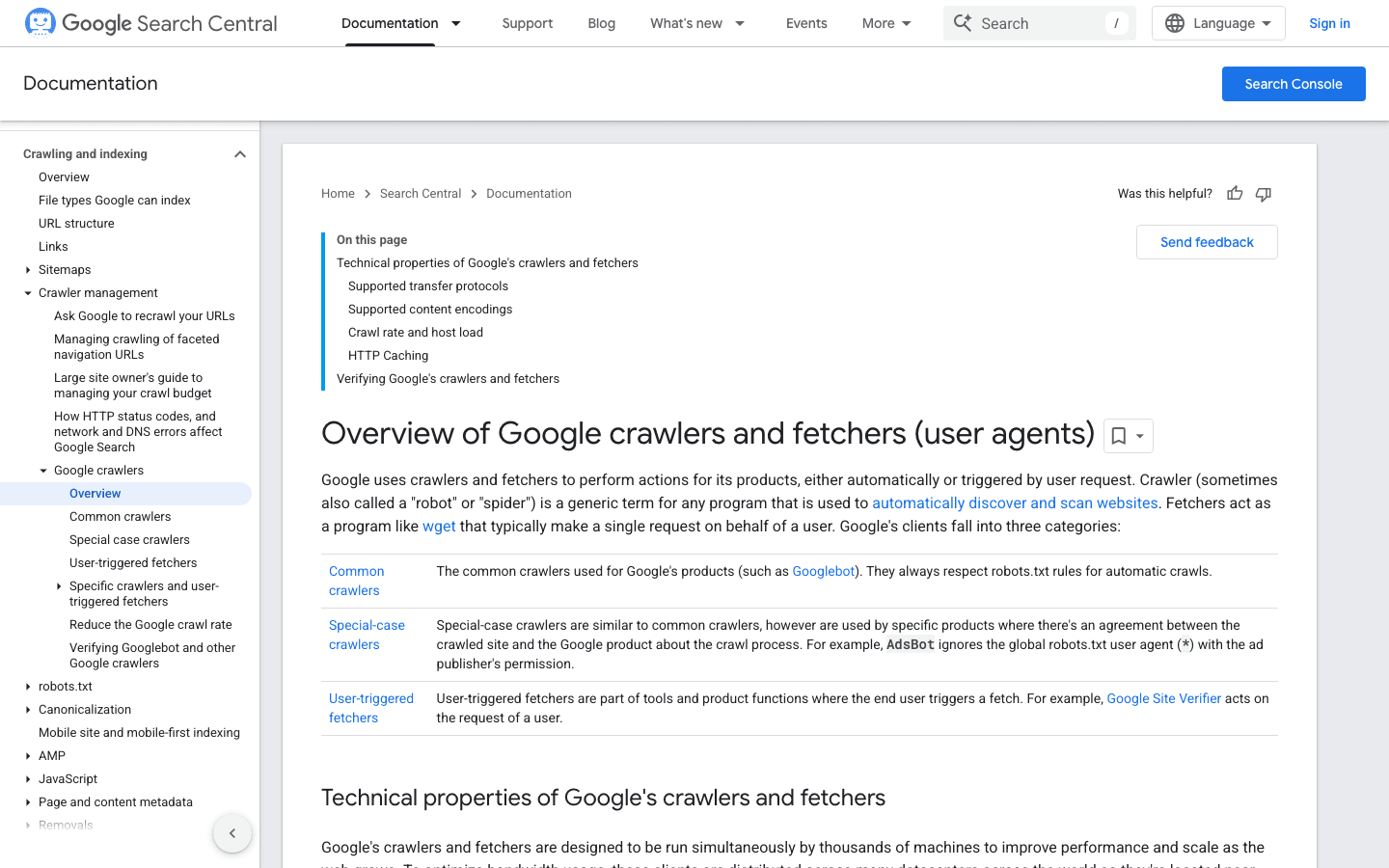

2. Googlebot: O Padrão dos Mecanismos de Busca

O é referência quando o assunto é crawler. Ele é quem indexa seu site no Google — bloquear ele é tipo colocar uma placa de “Fechado” na sua vitrine digital.

- User-Agent:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - Verificação: Use o ou a .

- Dicas de gestão: Sempre permita o Googlebot. Use o robots.txt pra orientar (não bloquear) o rastreamento e ajuste a taxa de crawl no Google Search Console se precisar.

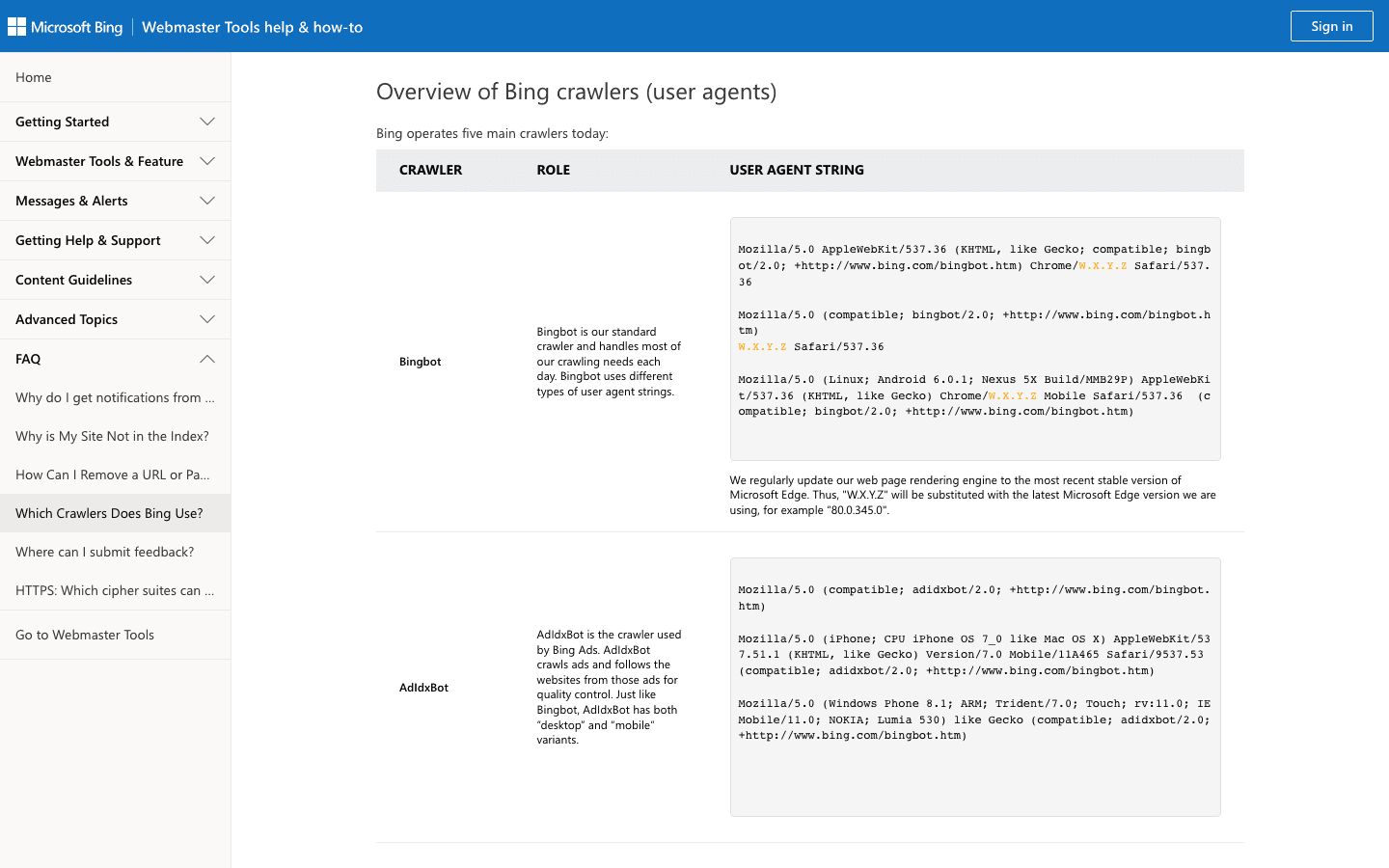

3. Bingbot: O Rastreador da Microsoft

O alimenta os resultados de busca do Bing e do Yahoo. É o segundo crawler mais importante pra maioria dos sites.

- User-Agent:

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) - Verificação: Use a e a .

- Dicas de gestão: Permita o Bingbot, gerencie a taxa de rastreamento no Bing Webmaster Tools e use o robots.txt pra ajustes finos.

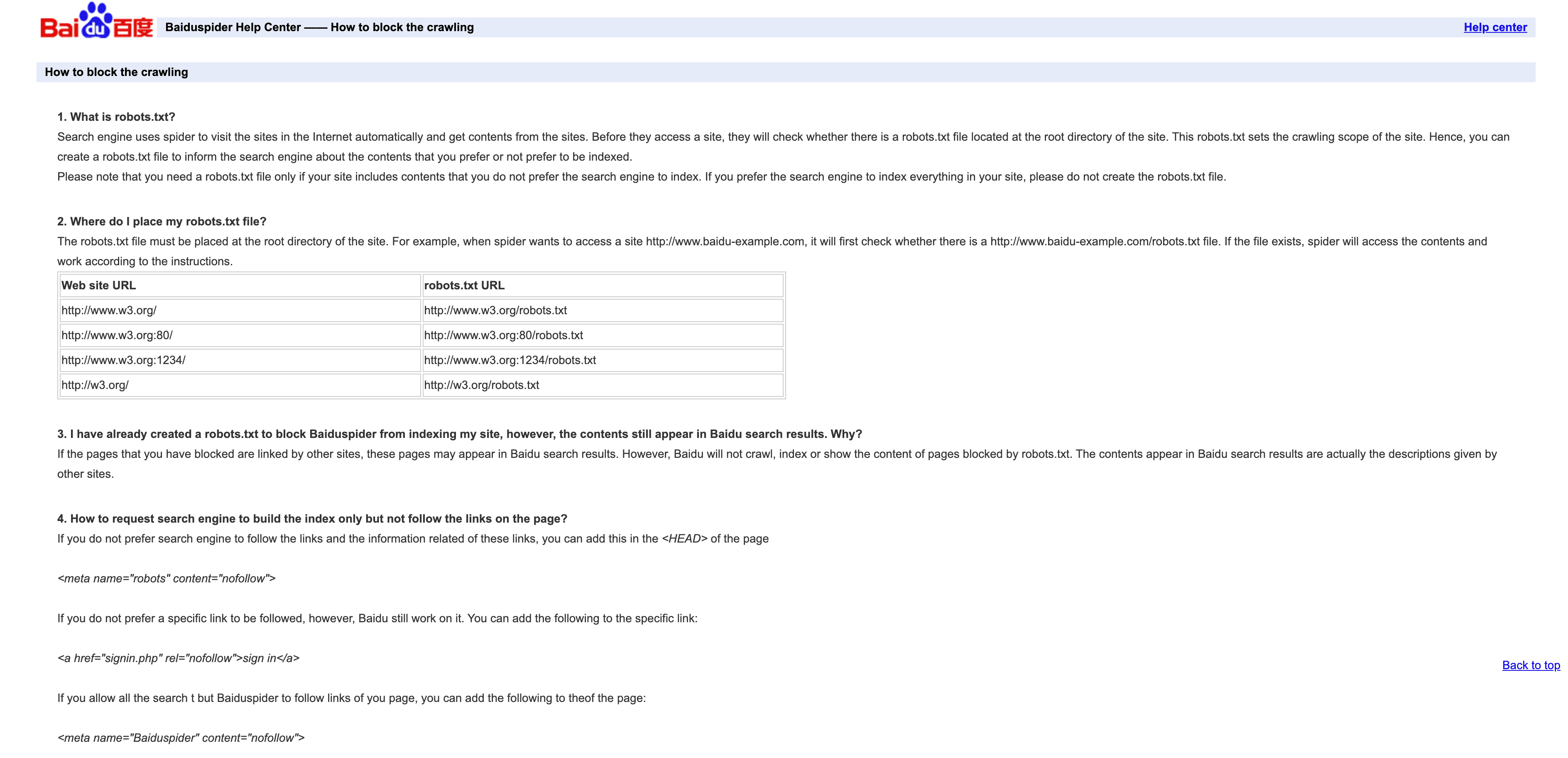

4. Baiduspider: O Rastreador Líder na China

O é a porta de entrada pro tráfego de buscas chinês.

- User-Agent:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) - Verificação: Não tem lista oficial de IPs; verifique por

.baidu.comno reverse DNS, mas tem limitações. - Dicas de gestão: Permita se quiser tráfego da China. Use o robots.txt pra definir regras, mas saiba que o Baiduspider pode ignorar. Se não precisa de SEO chinês, pense em limitar ou bloquear pra economizar banda.

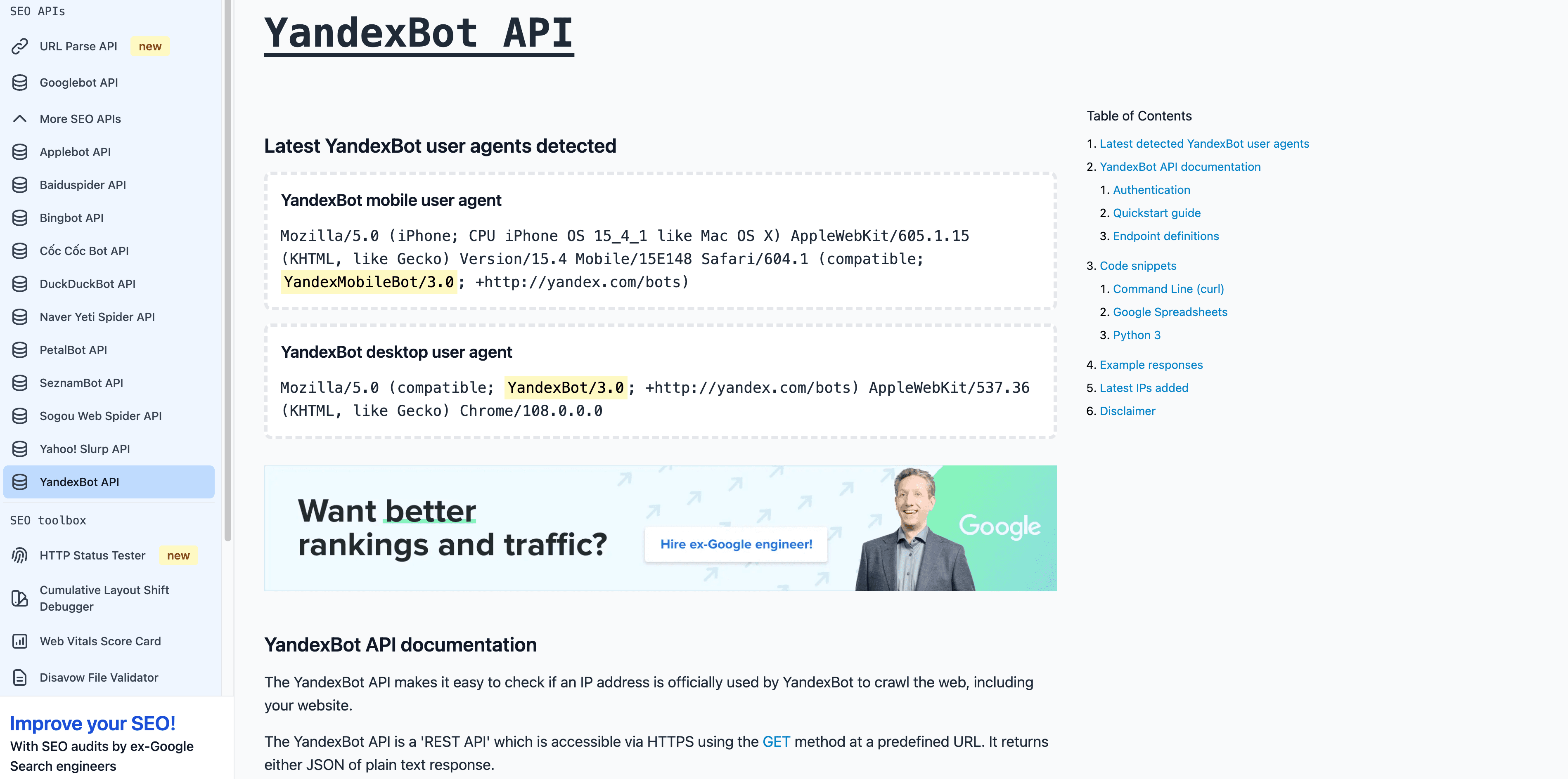

5. YandexBot: O Rastreador da Rússia

O é essencial pra quem mira mercados russos e da CEI.

- User-Agent:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots) - Verificação: O reverse DNS deve terminar em

.yandex.ru,.yandex.netou.yandex.com. - Dicas de gestão: Permita se o público for russo. Use o Yandex Webmaster pra controlar o rastreamento.

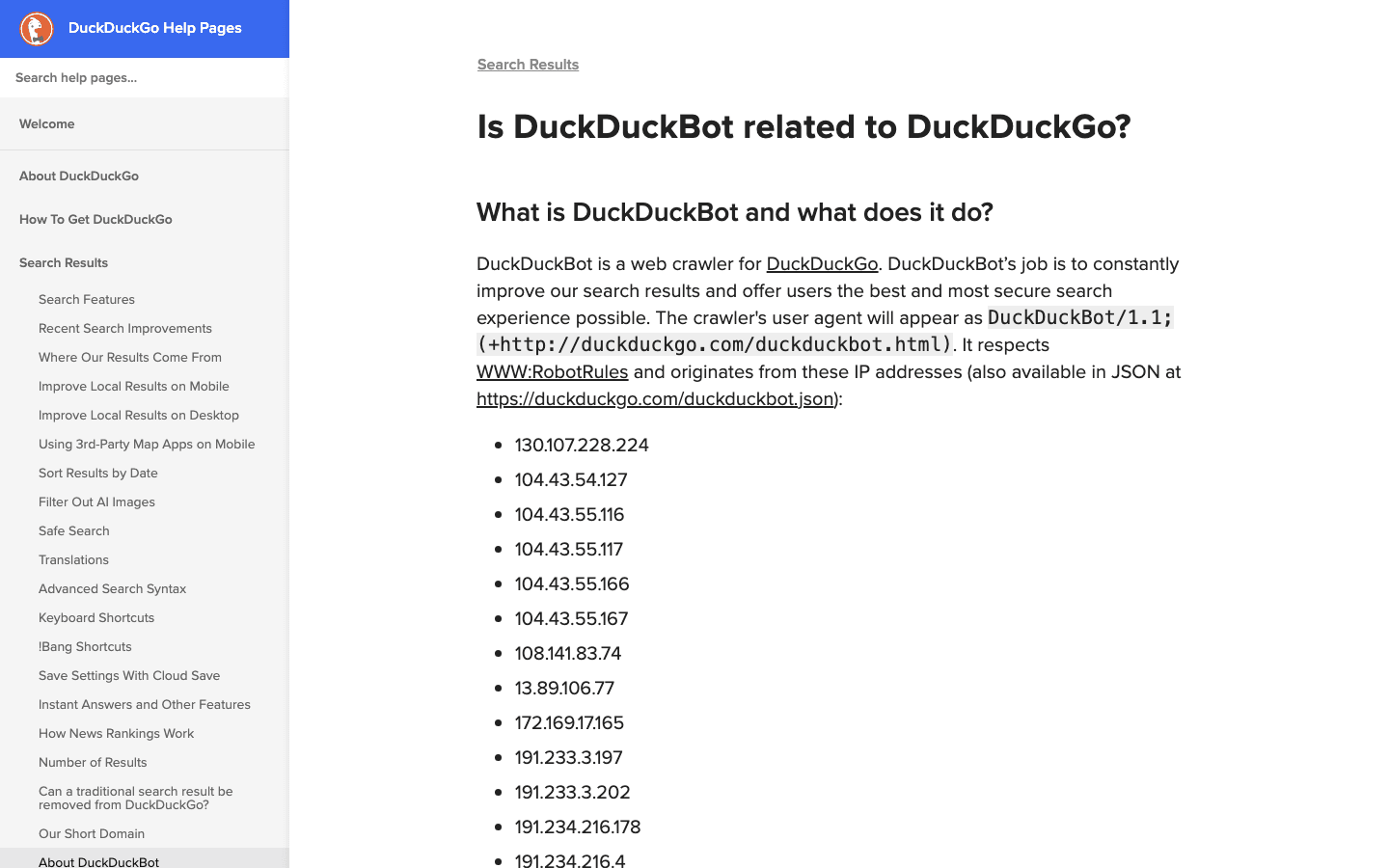

6. DuckDuckBot: Rastreador Focado em Privacidade

O alimenta o buscador DuckDuckGo, que prioriza privacidade.

- User-Agent:

DuckDuckBot/1.1; (+http://duckduckgo.com/duckduckbot.html) - Verificação: .

- Dicas de gestão: Permita, a não ser que não queira usuários preocupados com privacidade. Baixo impacto e fácil de gerenciar.

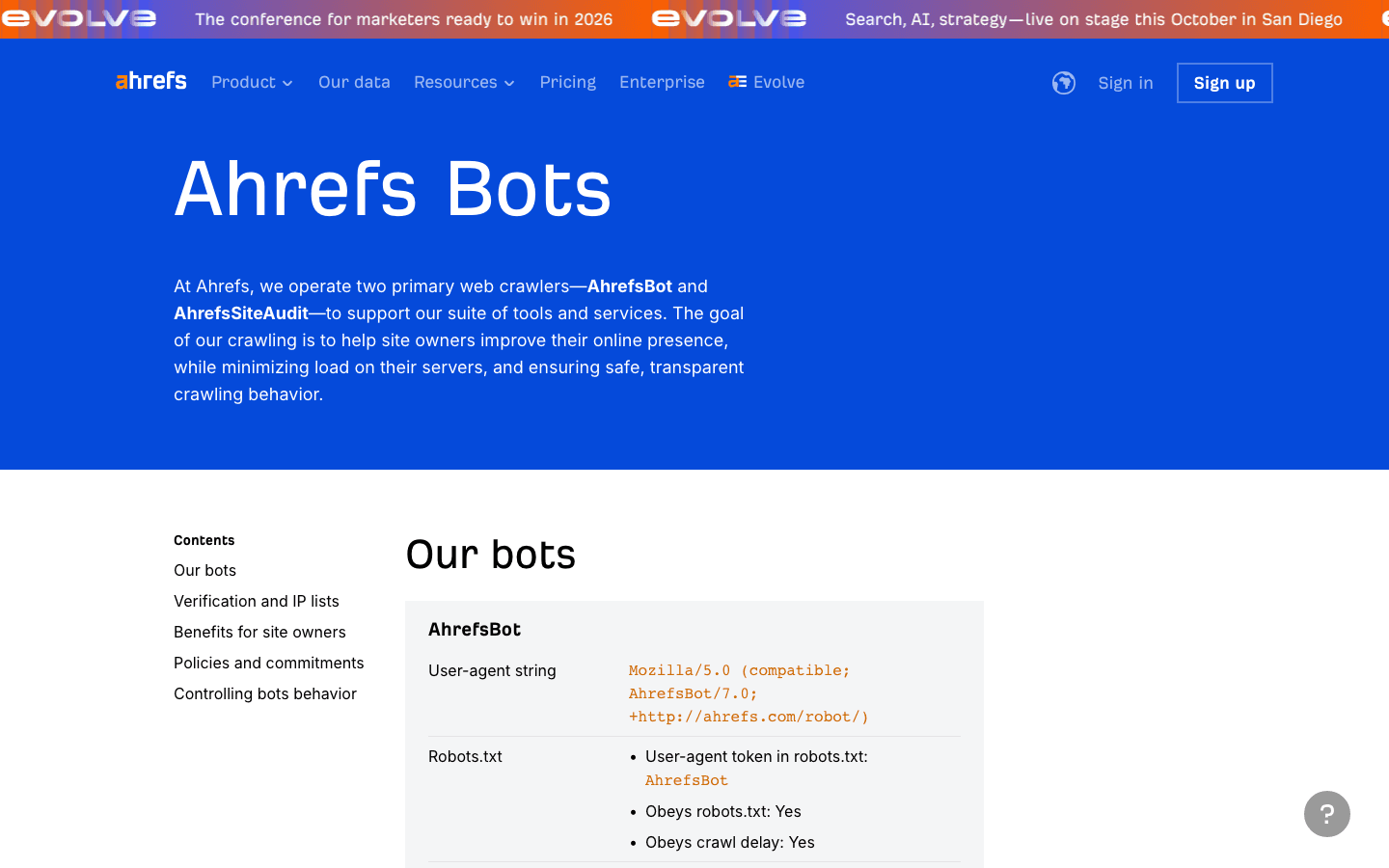

7. AhrefsBot: Análise de SEO e Backlinks

O é um dos principais crawlers de SEO — ótimo pra análise de backlinks, mas pode gastar muita banda.

- User-Agent:

Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/) - Verificação: Não tem lista pública de IPs; verifique por user-agent e reverse DNS.

- Dicas de gestão: Permita se usar o Ahrefs. Use o robots.txt pra limitar ou bloquear. Dá pra .

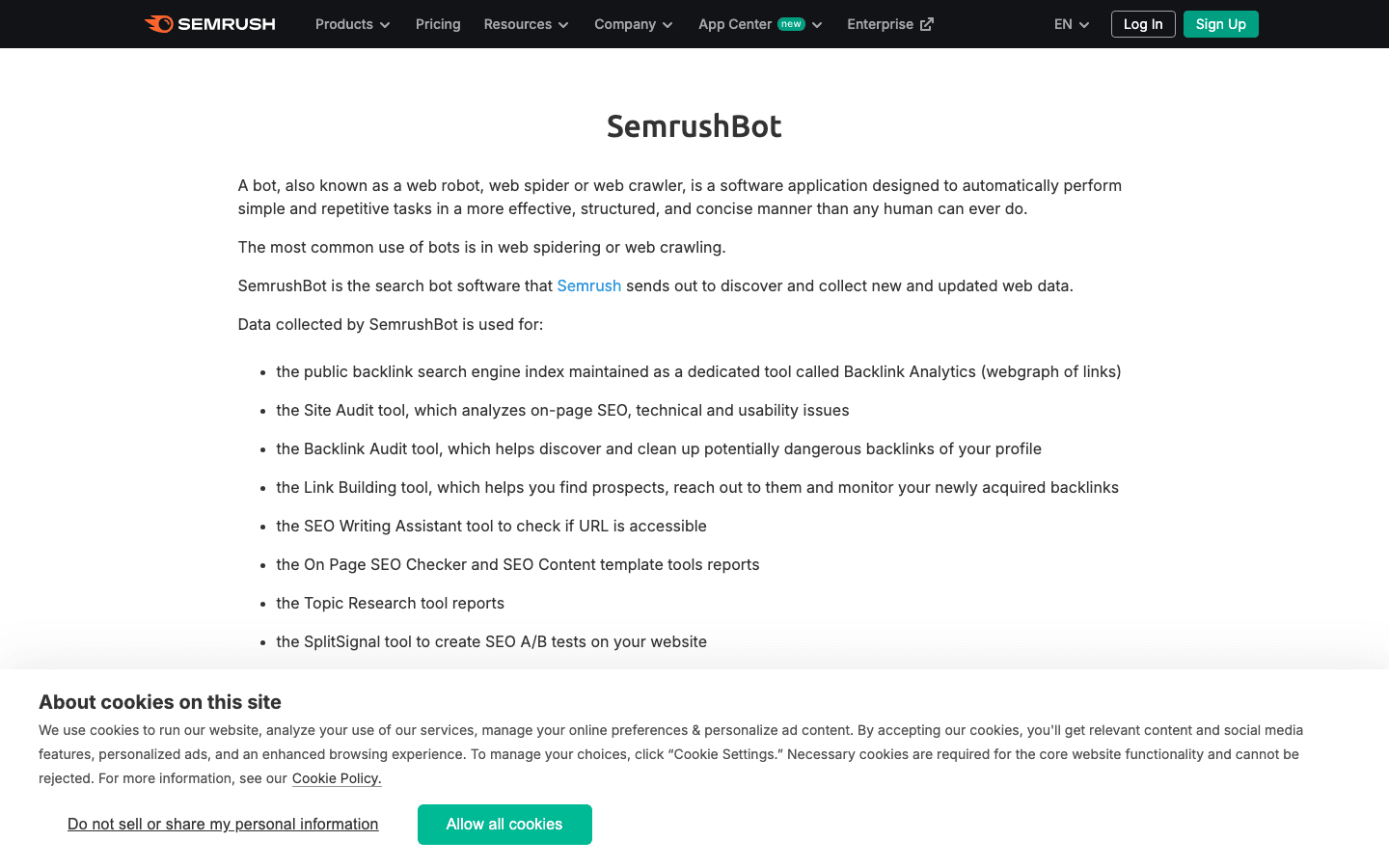

8. SemrushBot: Insights de SEO Competitivo

O é outro crawler importante pra SEO.

- User-Agent:

Mozilla/5.0 (compatible; SemrushBot/1.0; +http://www.semrush.com/bot.html)(e variantes comoSemrushBot-BA,SemrushBot-SI, etc.) - Verificação: Pelo user-agent; não tem lista pública de IPs.

- Dicas de gestão: Permita se usar o Semrush, senão limite ou bloqueie via robots.txt ou regras de servidor.

9. FacebookExternalHit: Bot de Prévia de Redes Sociais

O busca dados Open Graph pra prévias de links no Facebook e Instagram.

- User-Agent:

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) - Verificação: Pelo user-agent; IPs pertencem ao ASN do Facebook.

- Dicas de gestão: Permita pra garantir prévias ricas nas redes sociais. Bloquear impede miniaturas e resumos no Facebook/Instagram.

10. Twitterbot: Rastreador de Prévia de Links do X (Twitter)

O busca dados de Twitter Card pro X (Twitter).

- User-Agent:

Twitterbot/1.0 - Verificação: Pelo user-agent; ASN do Twitter (AS13414).

- Dicas de gestão: Permita pra prévias no Twitter. Use meta tags de Twitter Card pra melhores resultados.

Tabela Comparativa: Lista de Crawlers em Resumo

| Crawler | Finalidade | Exemplo de User-Agent | Método de Verificação | Impacto no Negócio | Dicas de Gestão |

|---|---|---|---|---|---|

| Thunderbit | Análise de logs/crawlers com IA | N/A (ferramenta, não bot) | N/A | Gestão de dados, classificação de bots | Use para extração de logs, criação de allowlist |

| Googlebot | Indexação do Google Search | Googlebot/2.1 | DNS & lista de IPs | Essencial para SEO | Sempre permitir, gerencie pelo Search Console |

| Bingbot | Busca Bing/Yahoo | bingbot/2.0 | DNS & lista de IPs | Importante para SEO Bing/Yahoo | Permitir, gerencie pelo Bing Webmaster Tools |

| Baiduspider | Busca Baidu (China) | Baiduspider/2.0 | Reverse DNS, user-agent | Fundamental para SEO na China | Permitir se focar na China, monitore banda |

| YandexBot | Busca Yandex (Rússia) | YandexBot/3.0 | Reverse DNS para .yandex.ru | Fundamental para Rússia/Eurásia | Permitir se focar em RU/CEI, use ferramentas Yandex |

| DuckDuckBot | Busca DuckDuckGo | DuckDuckBot/1.1 | Lista oficial de IPs | Público focado em privacidade | Permitir, baixo impacto |

| AhrefsBot | Análise de SEO/backlinks | AhrefsBot/7.0 | User-agent, reverse DNS | Ferramenta de SEO, pode consumir banda | Permitir/limitar/bloquear via robots.txt |

| SemrushBot | Análise SEO/competitiva | SemrushBot/1.0 (e variantes) | User-agent | Ferramenta de SEO, pode ser agressivo | Permitir/limitar/bloquear via robots.txt |

| FacebookExternalHit | Prévia de links sociais | facebookexternalhit/1.1 | User-agent, ASN Facebook | Engajamento em redes sociais | Permitir para prévias, use tags OG |

| Twitterbot | Prévia de links no Twitter | Twitterbot/1.0 | User-agent, ASN Twitter | Engajamento no Twitter | Permitir para prévias, use tags Twitter Card |

Como Gerenciar Sua Lista de Crawlers: Boas Práticas para 2025

- Atualize sempre: O cenário de crawlers muda rápido. Programe revisões trimestrais e use ferramentas como a Thunderbit pra extrair e comparar listas oficiais ().

- Verifique, não confie: Sempre cheque user-agent e IP/ASN. Não deixe impostores bagunçarem suas métricas ou roubarem seus dados ().

- Permita bons bots: Garanta que crawlers de busca e redes sociais nunca sejam bloqueados por regras anti-bot ou firewalls.

- Limite ou bloqueie bots agressivos: Use robots.txt, crawl-delay ou regras de servidor pra ferramentas de SEO que consomem muitos recursos.

- Automatize a análise de logs: Use ferramentas com IA (tipo Thunderbit) pra extrair, classificar e rotular a atividade dos crawlers — economizando tempo e identificando tendências.

- Equilibre SEO, métricas e segurança: Não bloqueie os bots que trazem resultado pro seu negócio, mas também não deixe os mal-intencionados agirem livremente.

Conclusão: Mantenha Sua Lista de Crawlers Atualizada e Eficiente

Em 2025, cuidar da sua lista de crawlers deixou de ser só tarefa de TI — virou peça-chave pra SEO, métricas, segurança e conformidade. Com bots dominando o tráfego web, é fundamental saber quem está acessando seu site, por quê e como agir. Mantenha sua lista sempre em dia, automatize o que der e use ferramentas como a pra se antecipar às mudanças. A web só vai ficar mais movimentada — e uma estratégia inteligente pra crawlers é sua melhor defesa (e ataque) nesse universo dominado por bots.

Perguntas Frequentes

1. Por que é importante manter uma lista de crawlers atualizada?

Porque bots já são mais da metade do tráfego web, e só uma parte é benéfica. Manter a lista atualizada garante que você permita os bons bots (pra SEO e prévias sociais) e bloqueie ou limite os ruins, protegendo suas métricas, banda e segurança de dados.

2. Como saber se um crawler é legítimo ou falso?

Não confie só no user-agent — sempre confira o IP ou ASN usando listas oficiais ou reverse DNS. Ferramentas como a Thunderbit automatizam esse processo, cruzando logs com IPs e user-agents de bots conhecidos.

3. O que fazer se um bot desconhecido estiver rastreando meu site?

Investigue o user-agent e o IP. Se não estiver na sua lista de permissão e não bater com um bot conhecido, pense em limitar, desafiar ou bloquear. Use IA pra classificar e monitorar novos crawlers conforme aparecem.

4. Como a Thunderbit ajuda na gestão de crawlers?

A Thunderbit usa IA pra extrair, estruturar e classificar a atividade dos crawlers nos logs, facilitando a criação de listas de permissão, identificação de impostores e automação de políticas. O pré-processamento semântico é especialmente eficiente pra sites complexos ou dinâmicos.

5. Qual o risco de bloquear um crawler importante como Googlebot ou Bingbot?

Bloquear crawlers de buscadores pode tirar seu site dos resultados de pesquisa, acabando com o tráfego orgânico. Sempre revise firewall, robots.txt e regras anti-bot pra garantir que os bots essenciais não sejam bloqueados sem querer.

Saiba mais: