Imagine só: segunda-feira de manhã, você mal terminou o café e o e-mail já está lotado de alertas. Mais uma ferramenta de IA virou manchete por vazar dados sensíveis. O CEO quer explicações, o jurídico está em modo de emergência e os clientes querem saber como os dados deles estão sendo usados por todos aqueles sistemas “inteligentes” que você implementou nos últimos meses. Bem-vindo a 2026, onde privacidade de dados em IA deixou de ser só um problema técnico e virou questão estratégica — capaz de definir o futuro de marcas e carreiras.

A real é que a IA já faz parte do cotidiano das empresas, do marketing ao mercado imobiliário e ao e-commerce. Só que, quanto mais a IA se espalha, maiores ficam os riscos. Só no último ano, incidentes de privacidade envolvendo IA cresceram incríveis 56%, e só 47% das pessoas no mundo confiam que empresas de IA realmente protegem seus dados pessoais — e esse número só cai (, ). Falo com propriedade: depois de anos desenvolvendo plataformas SaaS e automação (e agora como cofundador da ), posso garantir — conhecer as estatísticas mais recentes sobre privacidade de dados em IA não é só questão de cumprir regras, é o que separa quem vai prosperar de quem só vai sobreviver no mundo digital.

O Panorama da Privacidade de Dados em IA em 2026: Números Essenciais

Sem enrolação: se você precisa de dados de impacto para a próxima reunião ou proposta, olha só as estatísticas mais quentes sobre privacidade de dados em IA para 2026:

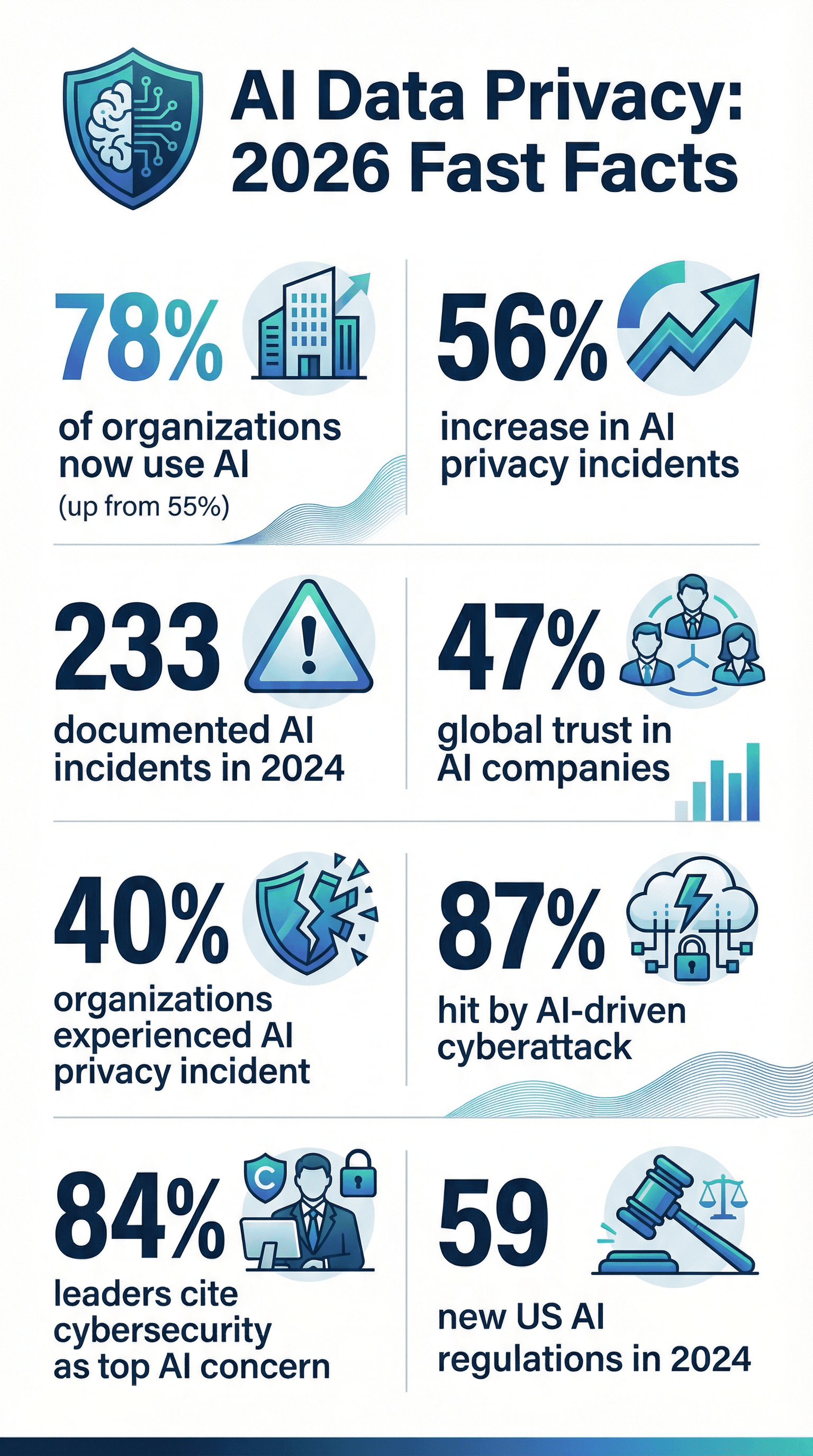

- IA está em todo canto: 78% das organizações relataram uso de IA em 2024, contra 55% no ano anterior ().

- Incidentes só aumentam: Casos de privacidade e segurança com IA subiram 56% em um ano, com 233 ocorrências documentadas em 2024 ().

- Vazamentos viraram rotina: 40% das empresas já passaram por incidentes de privacidade ligados à IA (), e 21% sofreram ataques cibernéticos no último ano ().

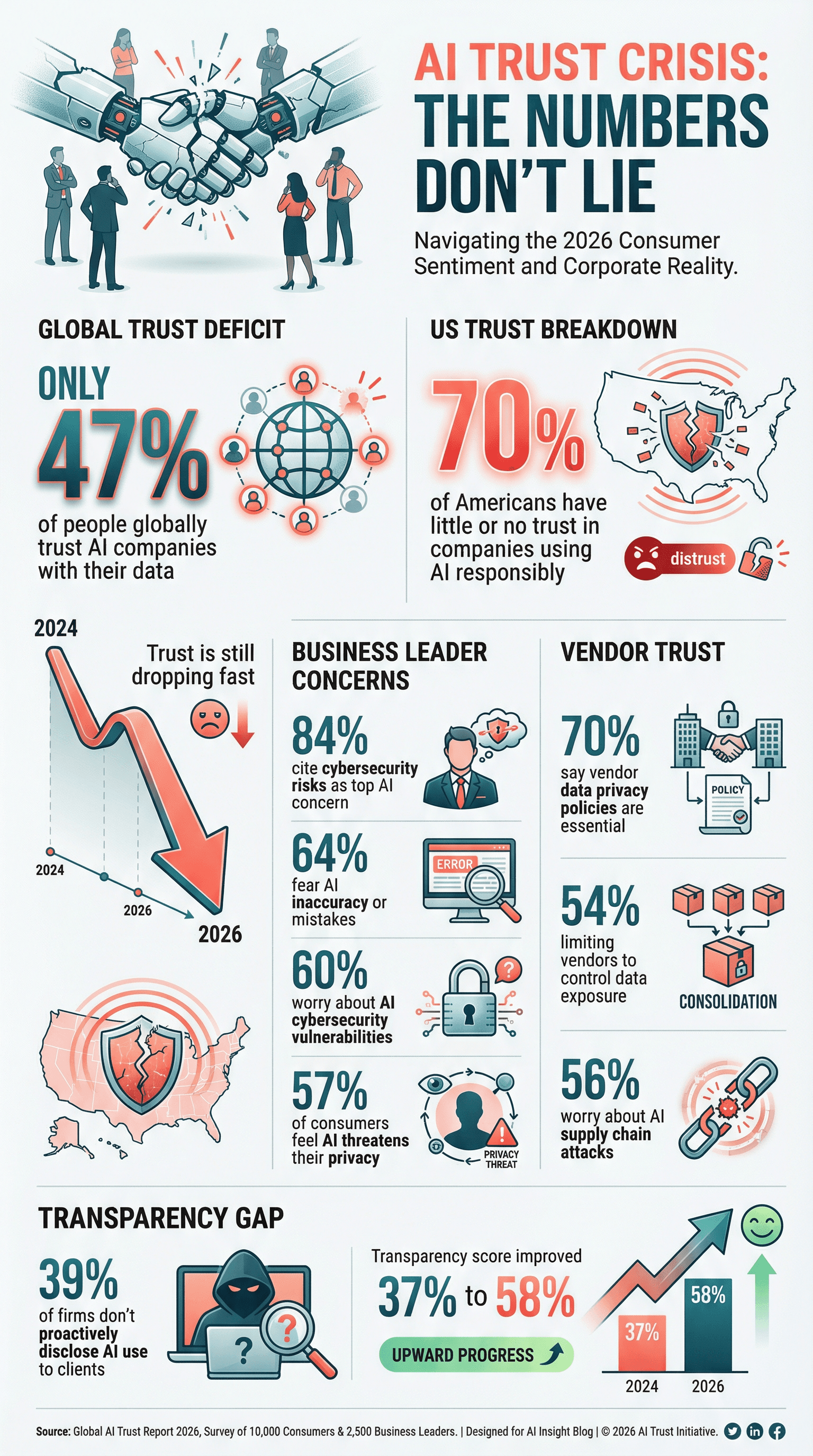

- Confiança está em baixa: Só 47% das pessoas no mundo confiam que empresas de IA cuidam bem dos seus dados; nos EUA, 70% têm pouca ou nenhuma confiança no uso responsável de IA pelas empresas ().

- Privacidade virou prioridade: 61% das organizações já colocam cibersegurança — incluindo proteção de dados em IA — entre suas três prioridades estratégicas ().

- Avaliação de fornecedores ficou mais rígida: 70% das empresas consideram as políticas de privacidade de dados dos fornecedores essenciais ao escolher parceiros de IA e tecnologia ().

- Executivos estão preocupados: 84% dos líderes de negócios apontam riscos de cibersegurança como principal preocupação na adoção de IA ().

- Regulação acelerou: Órgãos federais dos EUA emitiram 59 regulações relacionadas à IA em 2024, mais que o dobro do ano anterior ().

- Políticas formais ainda são minoria: Só 43% das empresas têm uma política de governança de IA, embora 77% estejam trabalhando nisso (, ).

- Ciberataques com IA já são rotina: 87% das organizações sofreram ataques cibernéticos impulsionados por IA no último ano ().

Esses números não são só curiosidade — são um alerta para quem lida com dados, conformidade ou transformação digital.

Por Que a Privacidade de Dados em IA Nunca Foi Tão Importante

IA não é só mais uma atualização de TI — é uma virada total na forma como empresas coletam, processam e usam dados. Diferente dos softwares tradicionais, sistemas de IA aprendem com volumes gigantescos de dados, muitas vezes desorganizados, que podem incluir de e-mails de clientes a prontuários médicos. E o detalhe: modelos de IA podem “memorizar” e reproduzir informações de formas inesperadas, expondo dados privados que nunca deveriam sair dali ().

A escala é absurda. Um único modelo de IA pode processar milhões de registros ou coletar dados da internet inteira — às vezes sem consentimento explícito. Isso aumenta (e muito) a responsabilidade de proteger esses dados. E como a IA toma decisões em segundos (como aprovar empréstimos ou selecionar candidatos), qualquer viés ou erro pode ser amplificado rapidinho, gerando violações de privacidade e até problemas jurídicos.

Se você pensa “temos uma política de privacidade, então está tudo certo”, é melhor repensar. A IA traz riscos inéditos — como envenenamento de dados, inversão de modelos e ataques adversariais — que controles tradicionais não dão conta. E o impacto na reputação de uma falha de privacidade em IA? É devastador. Clientes vão embora, órgãos reguladores multam pesado e a marca pode levar anos para se recuperar. Em 2026, privacidade de dados em IA não é só conformidade — é questão de sobrevivência.

Estatísticas de Privacidade de Dados em IA: Adoção, Preocupações e Conformidade

Adoção de IA Já É Quase Universal

Vamos ser francos: IA já não é mais “tecnologia do futuro”. É realidade. Em 2024, 78% das empresas já usavam IA, contra 55% no ano anterior (). Em áreas como jurídico e financeiro, a adoção é ainda maior — 42% dos escritórios de advocacia usavam IA em 2025, quase o dobro do ano anterior (). Esse crescimento significa mais dados sendo coletados, analisados e, às vezes, expostos.

Preocupações com Privacidade Só Crescem

Com grande poder vem grande responsabilidade — e muita preocupação. 57% dos consumidores no mundo já veem a IA como ameaça séria à sua privacidade (). Nos EUA, 70% dos que conhecem IA têm pouca ou nenhuma confiança no uso responsável dos dados coletados por IA pelas empresas (). Até líderes empresariais estão preocupados: 64% temem imprecisões ou erros da IA, e 60% citam vulnerabilidades de cibersegurança relacionadas à IA como grandes riscos ().

Com grande poder vem grande responsabilidade — e muita preocupação. 57% dos consumidores no mundo já veem a IA como ameaça séria à sua privacidade (). Nos EUA, 70% dos que conhecem IA têm pouca ou nenhuma confiança no uso responsável dos dados coletados por IA pelas empresas (). Até líderes empresariais estão preocupados: 64% temem imprecisões ou erros da IA, e 60% citam vulnerabilidades de cibersegurança relacionadas à IA como grandes riscos ().

Conformidade: Um Alvo em Movimento

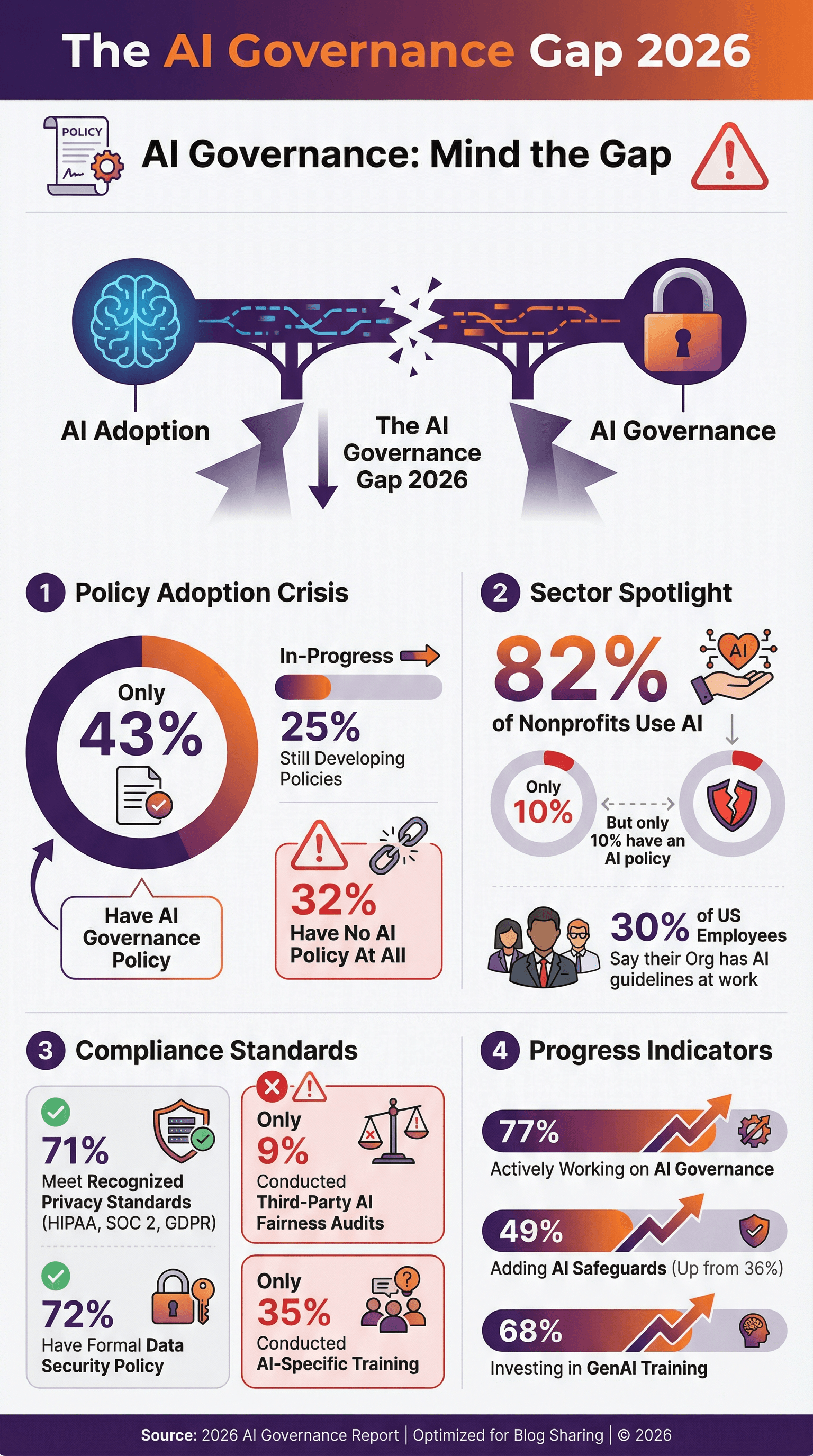

Empresas correm para acompanhar normas como GDPR, CCPA, HIPAA e SOC 2 — mas a IA traz novos desafios. 71% das organizações dizem cumprir padrões reconhecidos de privacidade (), e 72% têm política formal de segurança de dados. Mas menos da metade tem política específica de governança ou ética em IA. Só 43% das empresas têm política de governança de IA, e outras 25% estão desenvolvendo uma (, ). O resto? Está navegando no escuro.

Adoção de Políticas de Privacidade de Dados em IA

Políticas formais de privacidade em IA estão deixando de ser diferencial e virando obrigação. Mas os números mostram que ainda tem chão pela frente:

- Só 43% das empresas têm política de governança de IA, com outros 25% em desenvolvimento ().

- Nos EUA, só 30% dos funcionários dizem que sua empresa tem diretrizes ou políticas para uso de IA no trabalho ().

- Entre ONGs, 82% usam IA, mas só 10% têm política específica ().

- A boa notícia? 77% das empresas estão implementando medidas de governança em IA, e entre as que mais usam IA, esse número chega a quase 90% ().

Empresas mais avançadas já atualizam políticas para incluir restrições ao uso de IA, exigência de revisão humana e compromissos com transparência e justiça. Se sua empresa ainda não começou, o momento é agora — antes que um incidente ou nova lei obrigue.

Auditorias e Certificações em Privacidade de Dados em IA

Políticas são importantes, mas auditorias e certificações mostram que você realmente faz o que promete.

- 71% das empresas relatam conformidade com padrões como HIPAA, SOC 2 ou GDPR ().

- 51% exigem que fornecedores de saúde sejam compatíveis com HIPAA, e 45% exigem criptografia ponta a ponta ().

- Só 9% das empresas já fizeram auditorias independentes focadas em justiça ou viés em IA — mas esse número deve crescer com o avanço das regulações ().

Certificações como SOC 2, ISO 27001 e HITRUST estão virando diferencial competitivo. Se você é fornecedor, prepare-se para ser cobrado. Se é cliente, exija comprovação dos parceiros.

Cibersegurança em IA: Ameaças, Incidentes e Respostas

Vamos falar do elefante na sala: IA não é só alvo de ataques cibernéticos — também é ferramenta para atacantes. E os números assustam.

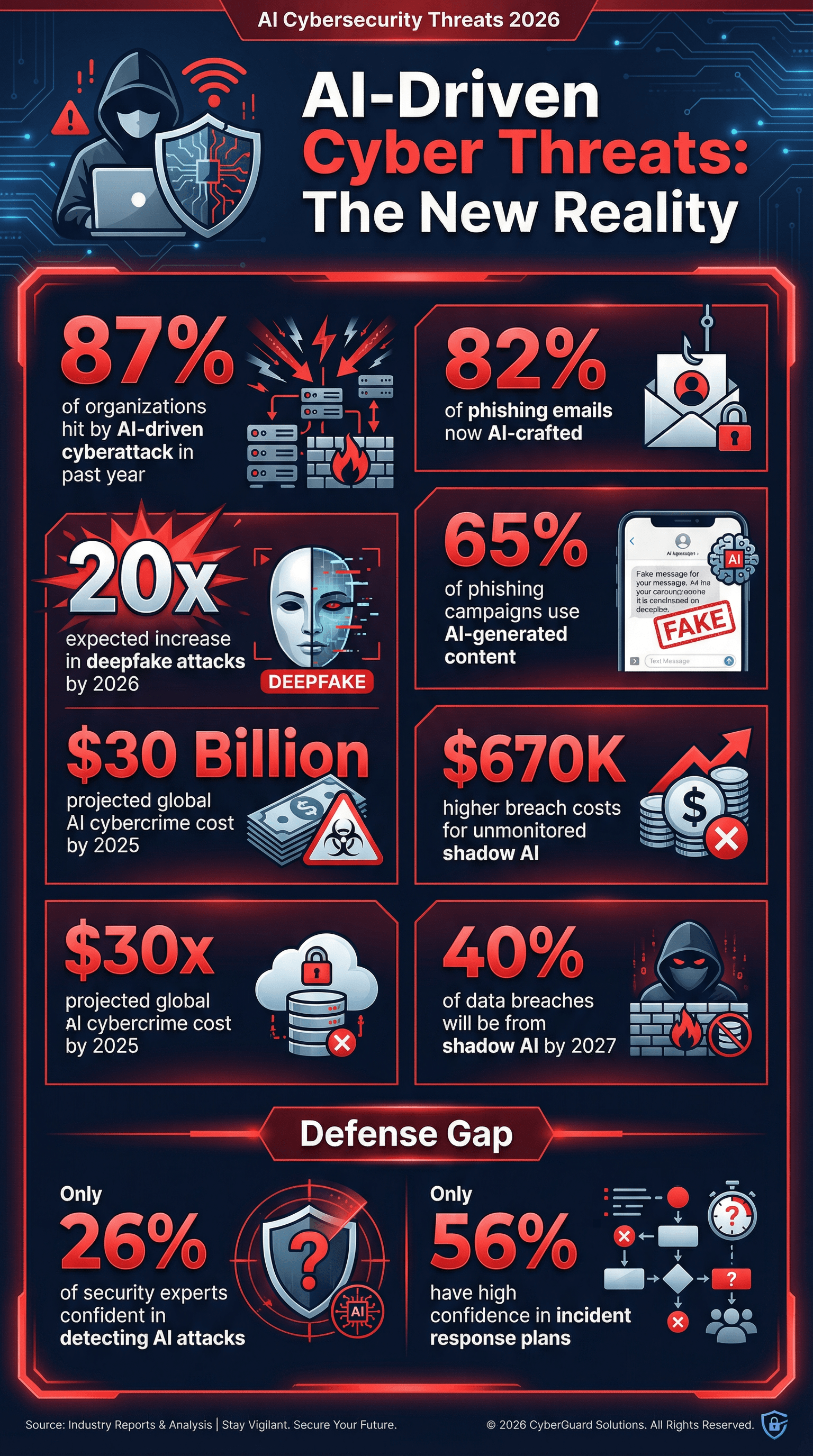

- 87% das empresas sofreram ataques cibernéticos impulsionados por IA no último ano ().

- 65% das campanhas de phishing já usam IA para imitar comunicações confiáveis ().

- 82% dos e-mails de phishing são estimados como criados com IA ().

- Ataques com deepfake devem crescer 20 vezes até 2026 ().

- Shadow AI (uso não autorizado de IA por funcionários) é um risco crescente — a Gartner prevê que 40% dos vazamentos de dados serão causados por mau uso de IA ou sistemas “shadow AI” até 2027 ().

E um dado que tira o sono dos CISOs: só 26% dos especialistas em segurança têm alta confiança na capacidade de detectar ataques impulsionados por IA (). É como jogar esconde-esconde com um mágico profissional.

Ciberataques com IA: O Que os Números Revelam

- 87% das empresas enfrentaram ataques com IA nos últimos 12 meses ().

- Phishing mais sofisticado: No fim de 2025, mais de 82% dos e-mails de phishing eram criados por IA ().

- Deepfakes em alta: Ataques com deepfake de áudio/vídeo devem crescer 20 vezes até 2026.

- Shadow AI é perigoso: Até 2027, 40% dos vazamentos de dados serão por mau uso de IA ou “shadow AI” ().

- Custo dos vazamentos é maior: Empresas com IA não monitorada ou shadow AI tiveram custos médios de vazamento $670.000 maiores que as com controles rígidos ().

- Custo global: Crimes cibernéticos com IA devem gerar US$ 30 bilhões em prejuízos até 2025 ().

Se você ainda não faz simulações de phishing com e-mails gerados por IA ou não testa defesas contra deepfakes, está correndo riscos.

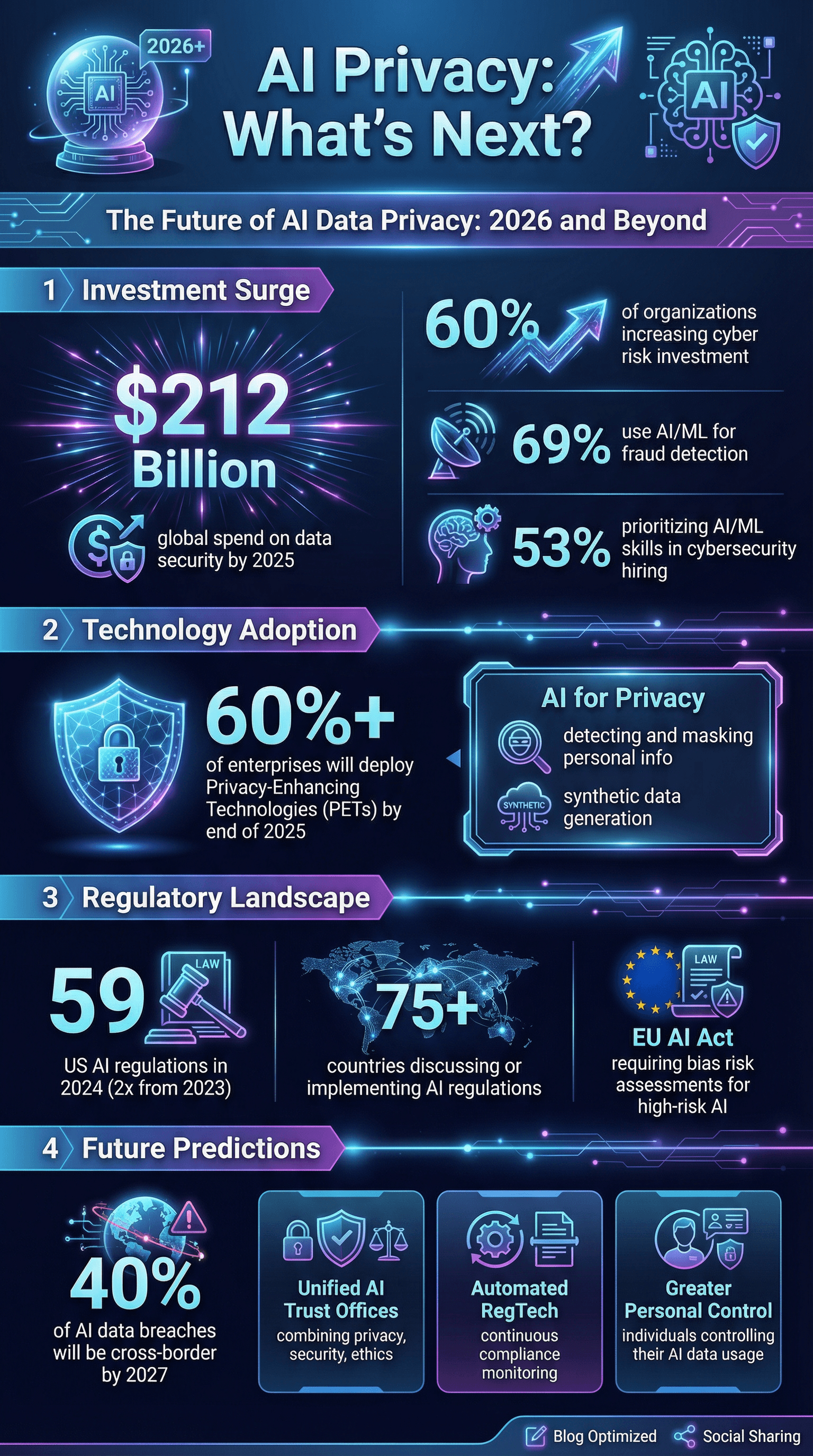

Investimento Organizacional em Cibersegurança de IA

A boa notícia? Empresas estão investindo mais do que nunca em cibersegurança para IA:

- 60% das empresas aumentaram investimentos em mitigação de riscos cibernéticos, com IA como fator principal ().

- 69% usam IA ou machine learning para detecção e prevenção de fraudes ().

- 53% priorizam habilidades em IA e ML nas contratações de cibersegurança ().

- Gastos globais com segurança de dados e gestão de riscos devem chegar a US$ 212 bilhões até 2025 ().

Mas ainda tem um desafio: só 56% das empresas têm alta confiança em seus planos de resposta a incidentes cibernéticos — e menos ainda abordam cenários específicos de IA.

Governança de Dados em IA: Treinamento, Supervisão e Mitigação de Viés

Não adianta ter tecnologia de ponta se pessoas e processos não acompanham — o risco continua.

- Só 35% das empresas ofereceram treinamentos específicos em IA para suas equipes sobre privacidade, segurança ou ética ().

- 68% das empresas investem em treinamento de IA generativa para funcionários ().

- 30% confiam na supervisão humana como medida de controle para IA ().

- Só 9% usam auditorias independentes para justiça em IA ().

- 49% estão implementando salvaguardas de governança em IA, contra 36% no ano anterior.

Viés também é um baita problema de privacidade. Sistemas de IA que tratam dados pessoais de forma desigual por raça, gênero ou outros fatores podem causar danos e até processos judiciais. 46% dos executivos dizem que garantir IA responsável — incluindo justiça — é prioridade nos investimentos em IA (). Mas medir e corrigir viés ainda é desafio para a maioria.

Viés e Justiça em IA: Impactos na Privacidade

- Incidentes de IA envolvendo viés ou segurança aumentam a cada ano ().

- Redução de 25% na disparidade de gênero em recomendações de candidatos após ações para mitigar viés.

- Pressão regulatória só cresce: a GDPR da UE e o futuro AI Act vão exigir avaliações de risco de viés para sistemas de IA “de alto risco”.

Se você não testa sua IA para viés, está arriscando não só a reputação, mas também processos e perda de negócios.

Riscos de Fornecedores e Ecossistema: Consolidação e Exposição a Terceiros

Nenhuma empresa é uma ilha. A maioria depende de uma rede de fornecedores, nuvem e parceiros — todos potenciais fontes de risco de privacidade.

- 54% das empresas estão reduzindo o número de fornecedores para controlar custos e minimizar exposição de dados ().

- 70% das empresas consideram políticas de privacidade essenciais ao avaliar fornecedores de tecnologia.

- 56% temem ataques à cadeia de suprimentos impulsionados por IA ().

A tendência? Consolidar fornecedores, exigir controles de privacidade mais fortes e tratar parceiros como extensão da sua própria segurança.

Pressão Regulatória e de Clientes: Transparência e Divulgação em Privacidade de Dados em IA

Reguladores e clientes estão apertando o cerco. Em 2024, os EUA tiveram 59 ações regulatórias ligadas à IA, mais que o dobro do ano anterior. No mundo, pelo menos 75 países já discutem ou implementam regulações para IA ().

- Transparência virou regra: Clientes querem saber sobre o uso de IA, mas 39% das empresas admitem não informar proativamente seus clientes ().

- Preparação para auditorias é essencial: Tenha como comprovar conformidade — HIPAA, SOC 2, lista de ferramentas de IA e controles de dados.

- Pontuação de transparência dos principais desenvolvedores de IA subiu de 37% para 58% em só seis meses ().

Se você não está pronto para uma auditoria ou questionário rigoroso de clientes, não está pronto para 2026.

O Futuro da Privacidade de Dados em IA: Previsões e Tendências

Olhando pra frente, veja o que está no radar (e o que especialistas estão apostando):

- Privacidade como diferencial competitivo: Empresas que comprovam IA segura, ética e com foco em privacidade vão conquistar clientes ().

- Governança unificada: Espere ver áreas de “Confiança em IA” reunindo privacidade, segurança e ética.

- Tecnologias de aprimoramento de privacidade (PETs): Mais de 60% das empresas planejam adotar PETs até o fim de 2025 ().

- Conformidade automatizada: Ferramentas RegTech para IA vão ser essenciais, monitorando sistemas de IA em tempo real.

- Desafios de dados transfronteiriços: Até 2027, 40% dos vazamentos de dados ligados à IA virão de uso indevido de dados entre países ().

- Mais controle para o usuário: Ferramentas para que as pessoas controlem como seus dados são usados em IA.

- IA para privacidade: IA será usada para detectar e mascarar dados pessoais, gerar dados sintéticos e mais.

- Resposta a incidentes e resiliência: Empresas vão focar não só em prevenção, mas em resiliência — incluindo seguro para incidentes com IA e planos de recuperação para envenenamento de dados ou corrupção de modelos.

Como alguém que respira automação e IA (e, sim, se preocupa com privacidade), aposto que os vencedores da próxima década serão aqueles que tratam privacidade e segurança como recursos essenciais — não como detalhe.

Principais Lições: O Que as Estatísticas de Privacidade de Dados em IA de 2026 Significam para Sua Empresa

Pra fechar, algumas dicas práticas — ninguém quer ser o case negativo do ano que vem:

- Coloque privacidade de dados em IA no centro da estratégia. Não trate como acessório — integre desde o início.

- Faça avaliações completas de risco em IA. Conheça seus sistemas, fluxos de dados e pontos críticos.

- Invista em treinamento e governança específicos para IA. Não deixe sua equipe ser o elo fraco.

- Reforce as defesas técnicas pensando em IA. Use IA para combater IA — implemente monitoramento e detecção avançados.

- Aperfeiçoe a gestão de fornecedores. Consolide, avalie e exija comprovação de conformidade.

- Seja transparente. Informe clientes e usuários sobre o uso de IA — antes que descubram sozinhos.

- Implemente tecnologias de aprimoramento de privacidade. Anonimize, criptografe e minimize dados sempre que possível.

- Prepare-se para o pior. Tenha um plano de resposta a incidentes com IA e teste-o com frequência.

- Fique de olho nas leis e padrões em evolução. O cenário regulatório muda rápido — não seja pego de surpresa.

- Faça da confiança seu norte. Em 2026 e além, confiança é seu maior patrimônio.

Fontes Citáveis e Leituras Complementares

Quer se aprofundar ou precisa de dados para sua próxima apresentação? Dá uma olhada nas melhores fontes usadas neste artigo:

- )

Para mais conteúdos sobre IA, automação e privacidade de dados, acesse o ou confira nossos guias sobre e .