Os web crawlers são como os verdadeiros “faz-tudo” invisíveis da internet. Sabe quando você pesquisa uma receita, confere o preço de um tênis ou compara hotéis para a próxima viagem? Pode apostar: um web crawler já passou por lá antes, coletando e organizando as informações que você encontra. Hoje, mais da é gerada por bots e crawlers, não por pessoas. Ou seja, enquanto você dorme, esses “exploradores digitais” estão mapeando a web sem parar, garantindo que a informação do mundo esteja sempre ao seu alcance.

Mas afinal, o que são web crawlers? Por que eles são tão importantes para empresas, pesquisadores e qualquer pessoa que dependa de dados atualizados? E como ferramentas modernas como o deixaram o web crawling acessível para todo mundo, não só para programadores ou gigantes da tecnologia? Depois de anos trabalhando com automação e IA, vi de perto como os web crawlers deixaram de ser “bichos de sete cabeças” para se tornarem aliados indispensáveis nos negócios. Bora entender de vez o universo dos web crawlers — o que são, como funcionam e por que são a base do acesso inteligente a dados em 2025.

Web Crawlers: os desbravadores de dados da internet

Então, o que são web crawlers, na prática? Basicamente, web crawlers (também conhecidos como spiders ou bots) são programas automáticos que navegam pela internet de forma sistemática, visitando páginas, coletando informações e seguindo links. Imagina um estagiário de pesquisa que nunca dorme, não reclama e consegue visitar milhões de páginas em um só dia.

Um web crawler começa com uma lista de endereços (os famosos “seeds”), visita cada um deles e segue os links encontrados para descobrir novas páginas. Nesse processo, copia conteúdos, indexa dados e constrói um verdadeiro mapa do universo online (). É assim que buscadores como o Google sabem o que existe na web, e como sites de comparação de preços ou ferramentas de pesquisa de mercado mantêm seus dados sempre atualizados.

Resumindo: os web crawlers são os desbravadores que tornam a internet pesquisável, comparável e útil.

Os diferentes tipos de Web Crawlers e suas funções principais

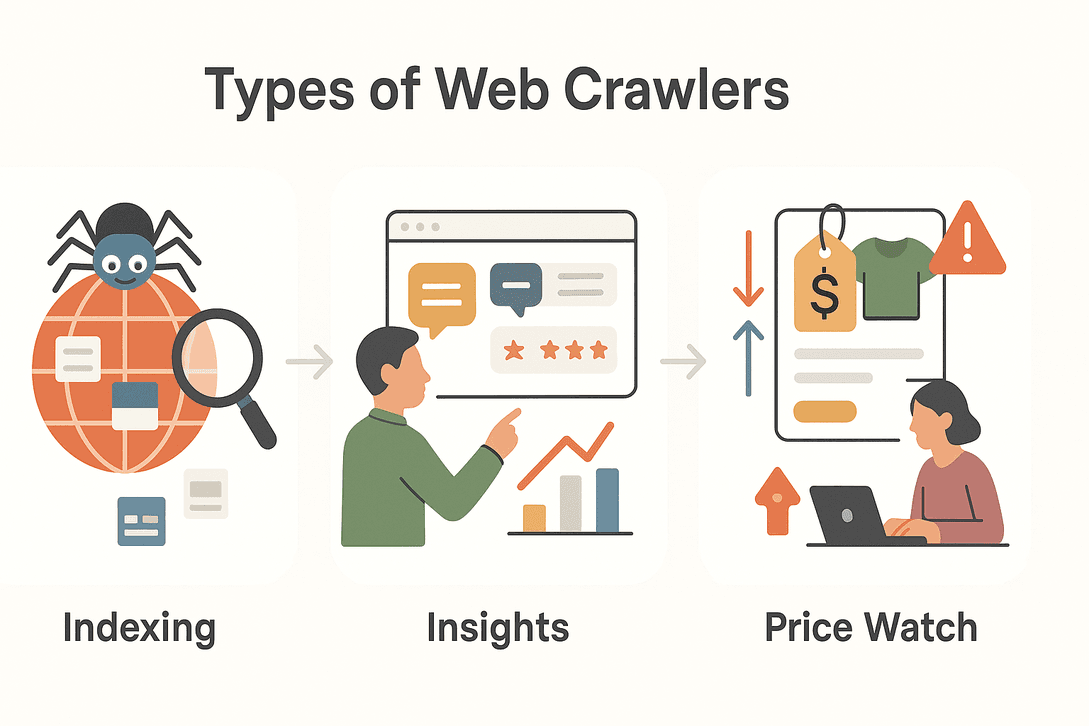

Nem todo web crawler tem o mesmo objetivo. Dependendo da missão, eles podem assumir diferentes formas e especialidades. Dá uma olhada nos principais tipos:

Nem todo web crawler tem o mesmo objetivo. Dependendo da missão, eles podem assumir diferentes formas e especialidades. Dá uma olhada nos principais tipos:

| Tipo | Função Principal | Exemplo de Uso |

|---|---|---|

| Crawlers de Buscadores | Indexam a web para resultados de busca | Googlebot, Bingbot indexando novos sites |

| Crawlers de Mineração de Dados | Coletam grandes volumes de dados para análise | Pesquisas de mercado, estudos acadêmicos |

| Crawlers de Monitoramento de Preços | Acompanham preços e disponibilidade de produtos | Comparação de preços, precificação dinâmica |

| Crawlers de Agregação de Conteúdo | Reúnem artigos, notícias ou posts para agregação | Portais de notícias, curadoria de conteúdo |

| Crawlers de Geração de Leads | Extraem contatos e dados de empresas | Prospecção de vendas, diretórios B2B |

Vamos detalhar alguns deles:

Crawlers de Buscadores

Quando você faz uma busca no Google, está contando com o trabalho dos crawlers de buscadores. Esses bots percorrem a web o tempo todo, descobrindo novas páginas, atualizando conteúdos antigos e indexando tudo para que apareça nos resultados de busca. Sem eles, os buscadores não teriam como saber o que há de novo ou o que mudou ().

Crawlers de Mineração de Dados e Pesquisa de Mercado

Empresas e pesquisadores usam crawlers para coletar grandes volumes de dados para análise. Quer saber quantas vezes uma marca concorrente foi mencionada online? Ou acompanhar a repercussão de um novo produto? Crawlers de mineração de dados vasculham fóruns, avaliações, redes sociais e muito mais, transformando o caos da web em informações estruturadas ().

Crawlers de Monitoramento de Preços e Produtos

No universo acelerado do e-commerce, preços e detalhes de produtos mudam o tempo todo. Crawlers de monitoramento de preços acompanham concorrentes, alertando sobre quedas de preço, mudanças de estoque ou lançamentos. Isso permite estratégias de precificação dinâmica e mantém as empresas competitivas ().

Por que os Web Crawlers são essenciais para o acesso moderno a dados

Vamos ser sinceros: a internet é grande demais para ser monitorada manualmente. Existem (e crescendo), com milhares de novas páginas surgindo a cada minuto. Os web crawlers tornam possível:

- Escalar a coleta de dados: Visitar milhões de páginas em poucas horas.

- Manter-se atualizado: Monitorar mudanças, novos conteúdos ou notícias em tempo real.

- Acessar informações dinâmicas: Reagir rapidamente a tendências, alterações de preços ou novidades do mercado.

- Tomar decisões baseadas em dados: Alimentar buscadores, pesquisas de mercado, gestão de riscos e modelos financeiros ().

Num cenário onde , os web crawlers são os motores que mantêm esse fluxo funcionando.

Principais aplicações dos Web Crawlers em diferentes setores

Web crawlers não são exclusividade de gigantes da tecnologia ou buscadores. Olha só como diferentes setores usam essas ferramentas:

| Setor | Aplicação | Benefício |

|---|---|---|

| Vendas | Geração de leads | Criar listas de prospects a partir de diretórios |

| E-commerce | Monitoramento de preços | Acompanhar preços, estoque e mudanças de produtos |

| Marketing | Agregação de conteúdo | Curadoria de notícias, artigos e menções em redes |

| Imobiliário | Agregação de anúncios | Unificar ofertas de diferentes portais |

| Viagens | Comparação de tarifas e hotéis | Monitorar preços, disponibilidade e políticas |

| Finanças | Monitoramento de riscos | Acompanhar notícias, documentos e sentimento do mercado |

Exemplo prático:

Uma imobiliária usa crawlers para reunir detalhes de imóveis, fotos e comodidades de vários portais, oferecendo aos clientes uma visão completa e atualizada do mercado ().

Já uma equipe de e-commerce configura crawlers para monitorar SKUs e preços dos concorrentes, ajustando sua estratégia em tempo real ().

Como funciona um Web Crawler: passo a passo

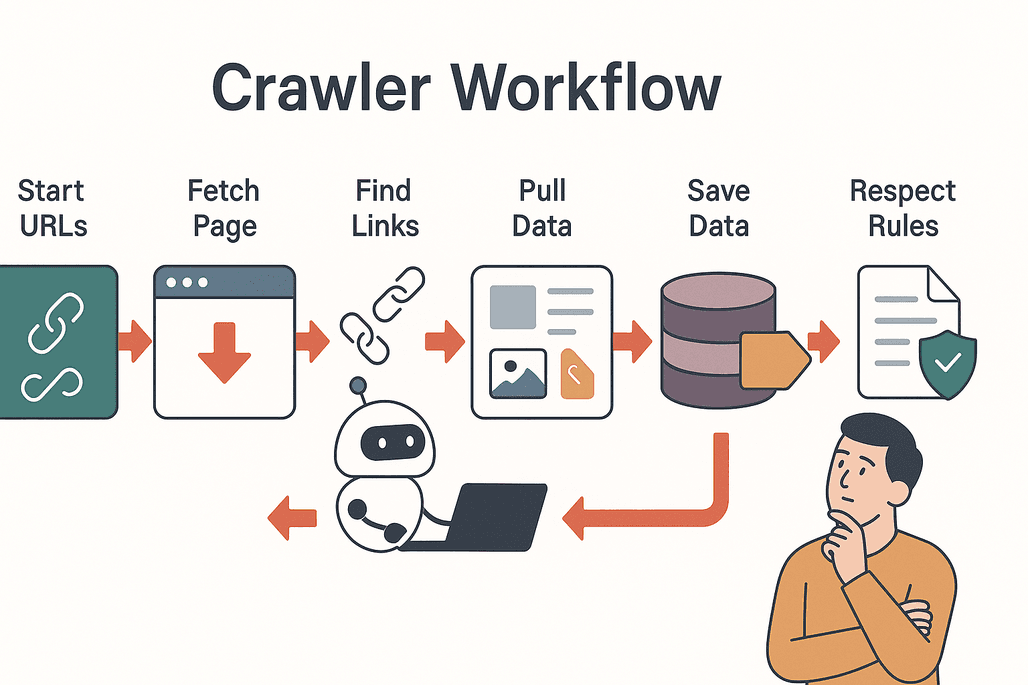

Vamos simplificar o processo. Veja como um web crawler normalmente opera:

Vamos simplificar o processo. Veja como um web crawler normalmente opera:

- Começa com seeds: O crawler inicia com uma lista de URLs de partida.

- Visita e coleta: Ele acessa cada página e baixa o conteúdo.

- Extrai links: Identifica todos os links presentes na página.

- Segue os links: Adiciona novos links não visitados à fila de exploração.

- Extrai dados: Copia e estrutura as informações relevantes (textos, imagens, preços etc.).

- Armazena os resultados: Salva os dados em um banco ou exporta para análise.

- Respeita regras: Verifica o arquivo

robots.txtde cada site para saber o que pode ou não acessar ().

Boas práticas:

- Seja educado ao rastrear (não sobrecarregue servidores).

- Respeite privacidade e limites legais.

- Evite conteúdo duplicado e requisições desnecessárias.

Desafios e cuidados ao usar Web Crawlers

Nem tudo são flores no mundo do web crawling. Veja alguns desafios comuns:

- Carga no servidor: Muitos acessos podem deixar um site lento ou até derrubá-lo.

- Conteúdo duplicado: Crawlers podem visitar as mesmas páginas repetidamente ou ficar presos em loops.

- Privacidade e legalidade: Nem todo dado pode ser coletado — sempre confira os termos de uso e leis de privacidade.

- Barreiras técnicas: Alguns sites usam CAPTCHAs, conteúdo dinâmico ou bloqueios anti-bot para dificultar o acesso ().

Dicas para ter sucesso:

- Use taxas de rastreamento respeitosas.

- Monitore mudanças na estrutura dos sites.

- Fique atento às normas de privacidade de dados.

Thunderbit: Web Crawlers acessíveis para todos

Agora vem a parte legal. Antigamente, configurar um web crawler era coisa de programador: precisava codar, ajustar configurações e perder horas resolvendo pepinos. Com o , isso ficou no passado.

O Thunderbit é um Raspador Web IA para Chrome pensado para quem trabalha com negócios — sem precisar programar nada. Olha só o que ele oferece:

- Instruções em linguagem natural: Só descrever o que você quer (“Pegue todos os nomes e preços dos produtos desta página”) e a IA do Thunderbit faz o resto.

- Sugestão de campos com IA: Clique em “AI Suggest Fields” e o Thunderbit analisa a página, sugerindo as melhores colunas para extração.

- Raspagem de subpáginas: Precisa de mais detalhes? O Thunderbit pode visitar subpáginas (como detalhes de produtos ou perfis do LinkedIn) e enriquecer seu conjunto de dados automaticamente.

- Modelos prontos: Para sites populares (Amazon, Zillow, Shopify etc.), use templates prontos para extrair dados com um clique.

- Exportação fácil: Envie seus dados direto para Excel, Google Sheets, Airtable ou Notion — sem complicação.

- Exportação gratuita: Baixe seus resultados em CSV ou JSON, totalmente grátis.

O Thunderbit já é usado por , de equipes de vendas a profissionais de e-commerce e imobiliárias.

Thunderbit vs. Web Crawlers tradicionais

Veja como o Thunderbit se compara ao método tradicional:

| Recurso | Thunderbit | Crawlers Tradicionais |

|---|---|---|

| Tempo de configuração | 2 cliques (IA faz tudo) | Horas/dias (configuração manual) |

| Habilidade técnica | Nenhuma (instruções em português) | Alta (código, seletores, scripts) |

| Flexibilidade | Funciona em qualquer site, adapta-se a mudanças | Quebra com alterações no layout |

| Raspagem de subpáginas | Integrada, sem configuração extra | Exige script manual |

| Opções de exportação | Excel, Sheets, Airtable, Notion, CSV, JSON | Normalmente só CSV/JSON |

| Manutenção | IA se adapta automaticamente | Requer ajustes frequentes |

Com o Thunderbit, você não precisa ser desenvolvedor nem perder tempo ajustando configurações. É só apontar, clicar e deixar a IA fazer o trabalho pesado ().

Como começar a usar Web Crawlers com o Thunderbit

Quer testar? Veja como começar com o Thunderbit rapidinho:

- Instale a .

- Abra o site que deseja explorar.

- Clique no ícone do Thunderbit e selecione “AI Suggest Fields”. A IA vai sugerir colunas com base no conteúdo da página.

- Ajuste os campos se precisar e clique em “Scrape”. O Thunderbit extrai os dados, inclusive de subpáginas se você quiser.

- Exporte seus resultados para Excel, Google Sheets, Airtable, Notion ou baixe em CSV/JSON.

Pronto — sem templates, sem código, sem dor de cabeça. Seja para monitorar preços, montar listas de leads ou agregar notícias, o Thunderbit deixa o web crawling tão fácil quanto pedir comida pelo app.

Conclusão: Web Crawlers são a chave para um acesso inteligente a dados

Web crawlers são os motores invisíveis que movem o mundo digital, tornando a informação acessível, pesquisável e útil para todo mundo. De buscadores a equipes de vendas, do e-commerce ao mercado imobiliário, eles viraram ferramentas indispensáveis para quem precisa de dados confiáveis e atualizados.

E graças a soluções modernas com IA como o , você não precisa ser programador para aproveitar todo esse potencial. Com poucos cliques, qualquer pessoa pode transformar a web em uma fonte estruturada de dados — impulsionando decisões mais inteligentes e novas oportunidades.

Quer descobrir como os web crawlers podem ajudar seu negócio? e comece a explorar os dados ocultos da web hoje mesmo. Para mais dicas e conteúdos, acesse o .

Perguntas Frequentes

1. O que é exatamente um web crawler?

Um web crawler é um programa automatizado (também chamado de spider ou bot) que navega sistematicamente pela internet, visitando páginas, seguindo links e coletando informações para indexação ou análise.

2. Qual a diferença entre web crawlers e raspadores web?

Web crawlers são feitos para descobrir e mapear grandes partes da web, seguindo links de página em página. Já os raspadores web focam em extrair dados específicos de páginas-alvo. Muitas ferramentas modernas (como o Thunderbit) unem as duas funções.

3. Por que web crawlers são importantes para empresas?

Eles permitem que empresas acessem informações atualizadas em grande escala — seja monitorando preços de concorrentes, agregando conteúdo ou montando listas de leads. Isso apoia decisões em tempo real e mantém a competitividade.

4. É legal usar web crawlers?

O uso de web crawlers geralmente é permitido quando feito de forma responsável e conforme os termos de uso e políticas de privacidade dos sites. Sempre confira o arquivo robots.txt e respeite as leis de privacidade de dados.

5. Como o Thunderbit facilita o uso de web crawlers?

O Thunderbit usa IA para automatizar a configuração, seleção de campos e extração de dados. Com instruções em linguagem natural e templates prontos, qualquer pessoa pode coletar dados de sites — sem precisar de código ou conhecimento técnico. Os dados podem ser exportados direto para Excel, Google Sheets, Airtable ou Notion para uso imediato.

Saiba mais