A internet é um verdadeiro mar de dados e, se você atua em vendas, operações ou basicamente qualquer área de negócios hoje em dia, já deve ter sentido aquela necessidade de transformar esse caos em informações realmente úteis. Tenho visto de perto equipes tentando automatizar a coleta de dados — seja para gerar leads, monitorar preços ou fazer pesquisa de mercado. E vamos ser sinceros: ninguém merece passar o dia inteiro copiando e colando informações de sites. É aí que entra o poder do 웹 스크래퍼, e por isso o Python virou a linguagem queridinha dessa galera.

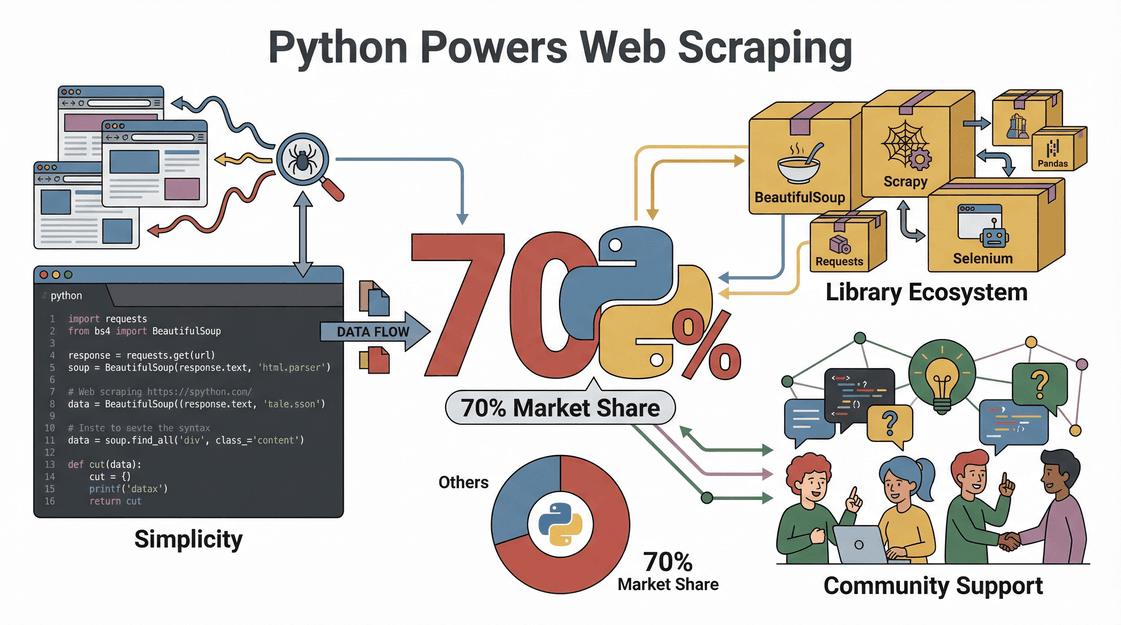

A fama do Python na raspagem de dados não é só modinha — os números mostram. Quase usam Python, graças à sua simplicidade, à quantidade absurda de bibliotecas e a uma comunidade super ativa que sempre tem uma solução na manga. Neste guia, vou te mostrar como fazer 웹 스크래퍼 com Python, passo a passo, desde montar o ambiente até rodar seu primeiro script — e também como o pode deixar tudo ainda mais fácil, principalmente se você prefere clicar do que programar.

O que é Web Scraping e Por que Usar Python?

Vamos começar do começo. Web scraping é o processo de extrair dados automaticamente de sites — tipo um assistente digital copiando informações de uma página e colando numa planilha, só que muito mais rápido e sem pedir pausa pro café. Empresas usam 웹 스크래퍼 pra tudo: desde .

Mas por que o Python é o favorito da galera para 웹 스크래퍼?

- Facilidade de uso: O Python tem uma sintaxe simples, fácil de entender até pra quem não é programador raiz.

- Bibliotecas completas: Com opções como Requests, BeautifulSoup, Selenium e Scrapy, o Python resolve desde HTML básico até sites cheios de JavaScript.

- Comunidade ativa: Se pintar um problema, alguém no Stack Overflow ou GitHub já deve ter passado por isso.

- Rápido e flexível: Dá pra adaptar scripts Python rapidinho pra novos sites ou formatos de dados, seja pra tarefas pontuais ou projetos grandes.

Resumindo: Python é o canivete suíço do 웹 스크래퍼 — poderoso, versátil e acessível até pra quem tá começando.

Valor para o Negócio: Como a Raspagem Web com Python Gera Resultados

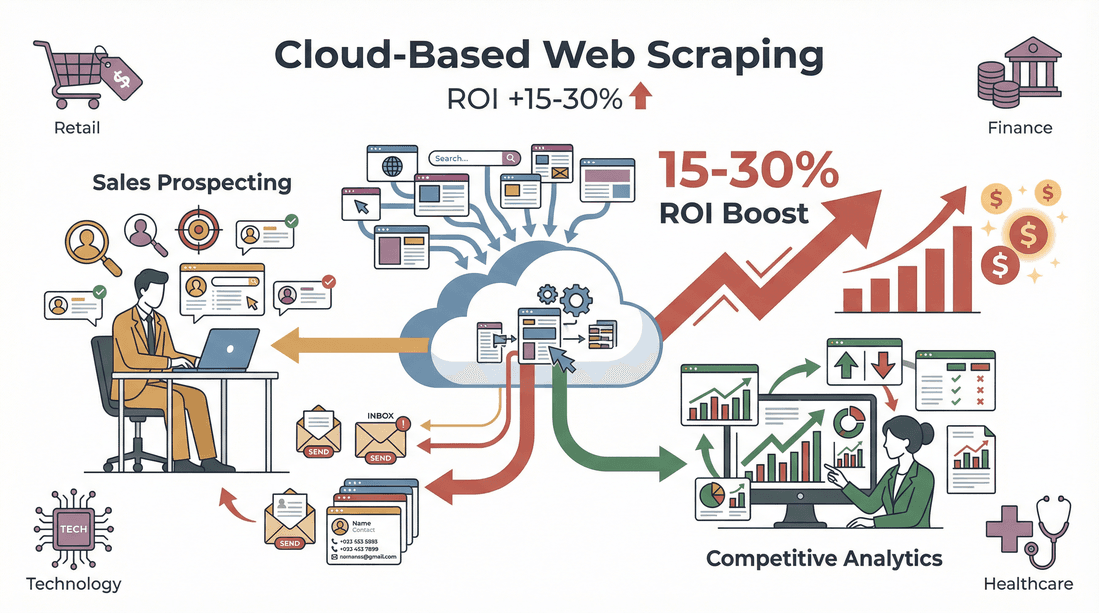

웹 스크래퍼 não é só uma técnica — é um turbo para negócios. Olha só como empresas estão usando Python pra sair na frente:

| Caso de Uso | Como o Python Ajuda | Impacto no Negócio |

|---|---|---|

| Geração de Leads | Extrai contatos de diretórios, LinkedIn, etc. | Preenche o CRM com leads novos e segmentados |

| Monitoramento de Preços | Acompanha preços da concorrência em e-commerces | Permite precificação dinâmica e competitividade |

| Pesquisa de Mercado | Agrega avaliações, artigos ou menções em redes | Identifica tendências e embasa decisões estratégicas |

| Coleta de Dados Imobiliários | Raspagem de anúncios em vários sites | Cria bancos de dados de mercado sempre atualizados |

| Gestão de Catálogo de Produtos | Busca especificações e estoque de fornecedores | Automatiza atualizações e reduz erros manuais |

E o retorno? Um mostrou que automatizar a coleta de leads economizou 8 horas por semana para recrutadores. Em vários setores, em prospecção e análise competitiva.

Como Preparar o Ambiente Python para Web Scraping

Antes de tudo, bora preparar o ambiente Python. Mesmo se nunca programou, segue o passo a passo:

1. Instale o Python

- Baixe o Python: Entre no e pegue a versão mais nova (3.10+ já tá ótimo).

- Adicione o Python ao PATH: No Windows, marca a opção “Add Python to PATH” na instalação. Isso facilita rodar o Python pelo terminal ().

2. Crie um Ambiente Virtual

Ambiente virtual serve pra organizar as bibliotecas do projeto e evitar bagunça.

1# No Windows

2python -m venv venv

3venv\Scripts\activate

4# No Mac/Linux

5python3 -m venv venv

6source venv/bin/activate3. Escolha um Editor de Código

- VS Code: Leve, gratuito e cheio de extensões.

- PyCharm: Ótimo pra projetos grandes, com sugestões inteligentes.

- Jupyter Notebook: Perfeito pra testar e visualizar dados.

4. Dicas de Solução de Problemas

- Se o Python não rodar, confere o PATH.

- Se der erro de permissão, abre o terminal como administrador.

- No Mac, talvez precise instalar o Xcode Command Line Tools (

xcode-select --install).

Principais Bibliotecas Python para Web Scraping

O segredo do Python tá nas bibliotecas. Veja as mais usadas e quando escolher cada uma:

| Biblioteca | Melhor Para | Facilidade | Velocidade | Suporte a JavaScript | Escalabilidade |

|---|---|---|---|---|---|

| Requests | Buscar páginas web (HTTP) | Fácil | Rápida | Não | Boa |

| BeautifulSoup | Analisar HTML/XML | Muito fácil | Média | Não | Boa |

| lxml | Análise rápida de XML/HTML | Média | Muito rápida | Não | Boa |

| Selenium | Interagir com sites dinâmicos | Média | Lenta | Sim (navegador) | Moderada |

| Scrapy | Raspagem automatizada em escala | Média | Muito rápida | Parcial/Sim | Excelente |

- Requests é ótimo pra buscar páginas simples.

- BeautifulSoup é queridinha pela facilidade — perfeita pra extrair dados de HTML.

- lxml é super rápida pra grandes volumes, mas menos amigável pra quem tá começando.

- Selenium abre o navegador e interage com sites cheios de JavaScript.

- Scrapy é um framework completo pra projetos robustos e escaláveis.

Pra quem tá começando, Requests + BeautifulSoup é a dupla imbatível ().

Passo a Passo: Como Fazer Web Scraping com Python

Vamos pra prática: extrair dados de produtos de um site de e-commerce (exemplo fictício).

1. Analise a Estrutura do Site

Abra as Ferramentas de Desenvolvedor do navegador (F12 ou botão direito > Inspecionar). Ache os elementos HTML com os dados que você quer — tipo títulos, preços ou avaliações. Esse passo é chave pra saber o que buscar no código ().

2. Faça uma Requisição HTTP

Use Requests pra acessar a página.

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. Analise o HTML com BeautifulSoup

Extraia os dados que precisa.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. Extraia e Limpe os Dados

Percorra cada produto e colete as informações.

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # Limpe o preço para cálculos

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. Exporte os Dados para CSV/Excel

Use o Pandas pra salvar os resultados.

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

Pronto — dados organizados, prontos pra análise ou pra subir no seu CRM.

Lidando com Conteúdo Dinâmico e Paginação

Nem todo site facilita. Alguns carregam dados via JavaScript ou dividem resultados em várias páginas. Veja como resolver:

Raspando Conteúdo Dinâmico

Se os resultados vierem vazios ou faltando dados, o site pode estar carregando conteúdo dinamicamente. Use o Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# Use o BeautifulSoup como antes()

Lidando com Paginação

Pra raspar várias páginas, faça um loop pelos números de página ou pelo botão “Próxima”.

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # Analise e extraia como antes()

Pra projetos grandes, o Scrapy automatiza a navegação por centenas de páginas ().

Exportando e Usando os Dados Raspados

Depois de coletar os dados, é hora de colocar pra rodar.

- Exporte para CSV/Excel: Como já mostrei, o Pandas facilita tudo.

- Limpe e normalize: Tire duplicatas, corrija erros e padronize formatos ().

- Integre aos fluxos de trabalho: Importe o CSV pro Salesforce, HubSpot ou sua ferramenta de análise favorita. Dá até pra automatizar com scripts Python.

Thunderbit: Facilitando a Raspagem Web em Python para Equipes de Negócios

Falando a real — Python é poderoso, mas nem sempre é o caminho mais rápido pra quem não programa. Por isso criamos o , uma feita pra quem quer resultado sem dor de cabeça.

Veja por que o Thunderbit virou o queridinho de times de vendas e operações:

- Mapeamento de Campos com IA: Clique em “Sugerir Campos com IA” e o Thunderbit analisa a página, sugere colunas (Nome, Preço, Email, etc.) e já configura tudo — sem precisar mapear manualmente.

- Raspagem de Subpáginas: O Thunderbit visita subpáginas (tipo detalhes de produtos ou perfis do LinkedIn) e turbina sua tabela com mais informações.

- Paginação e Conteúdo Dinâmico: Lida com listas paginadas e rolagem infinita numa boa — sem código.

- Modelos Prontos: Pra sites populares (Amazon, Zillow, Shopify, etc.), é só escolher o modelo e clicar em “Raspar”.

- Exportação Gratuita de Dados: Exporte direto pra Excel, Google Sheets, Airtable ou Notion — sem complicação.

- Sem Manutenção: A IA do Thunderbit se adapta às mudanças dos sites, sem você precisar ficar corrigindo script quebrado.

Já vi gente sair do “preciso desses dados, mas não sei nem por onde começar” pro “tá aqui minha planilha pronta” em menos de cinco minutos. E sim, tem pra testar sem compromisso.

Combinando Thunderbit e Python: O Kit Completo para Coleta de Dados

Se você é mais avançado ou analista de dados, não precisa escolher entre Thunderbit e Python — pode usar os dois juntos. Olha como eu costumo fazer:

- Use o Thunderbit para Extração: Rápido pra raspar dados estruturados de sites complexos ou desconhecidos, exportando pra CSV ou Excel.

- Processe com Python: Importe os dados no Pandas pra limpeza, análise ou automações extras.

- Automatize Fluxos: Agende raspagens regulares com o Thunderbit e dispare scripts Python pra processar e enviar os dados pra onde quiser.

Essa mistura dá agilidade, flexibilidade e evita retrabalho a cada novo projeto.

Considerações Legais e Éticas na Raspagem Web

Vamos direto ao ponto: web scraping é legal? Resposta curta: sim — desde que você siga as regras.

- Respeite o robots.txt e os Termos de Uso: Alguns sites proíbem a raspagem; sempre confira antes ().

- Não raspe dados pessoais ou protegidos por direitos autorais: Foque em informações públicas e abertas.

- Controle a frequência dos acessos: Não sobrecarregue servidores. Programe intervalos e respeite limites ().

- Cumpra as leis de privacidade: Se coletar emails ou dados pessoais, siga GDPR, CCPA e outras normas ().

O Thunderbit foi pensado pra te ajudar a ficar em dia com as regras, raspando só o que está visível e acessível no navegador e facilitando o respeito aos limites dos sites.

Dicas e Boas Práticas para Web Scraping com Python

Mesmo os melhores 웹 스크래퍼 enfrentam perrengues. Veja meu checklist pra resolver:

- Bloqueio de Requisições: Troque o user agent, use proxies ou diminua a velocidade dos acessos ().

- Falhas na Análise: Revise os seletores HTML — sites mudam o layout toda hora.

- Dados Faltando: Veja se o conteúdo não é carregado dinamicamente (use Selenium se precisar).

- Captcha ou Login: Alguns sites bloqueiam bots; às vezes só manual mesmo.

Boas práticas:

- Sempre teste seu 웹 스크래퍼 com poucos dados antes de escalar.

- Registre erros e trate exceções com carinho.

- Respeite as regras dos sites e evite dados sensíveis ou restritos.

- Documente seu código e mantenha modular pra facilitar ajustes.

- Programe manutenções regulares — sites mudam, seus 웹 스크래퍼 também precisam mudar ().

Conclusão & Principais Pontos

Fazer 웹 스크래퍼 com Python é um superpoder pra equipes modernas — transforma o caos da web em dados prontos pra ação. Lembre-se:

- Python é a melhor escolha pra 웹 스크래퍼, pela facilidade, bibliotecas poderosas e comunidade ativa.

- O fluxo é simples: inspecione o site, acesse a página, analise o HTML, extraia e limpe os dados, depois exporte pra CSV ou Excel.

- Thunderbit deixa tudo acessível pra quem não programa, automatizando mapeamento de campos, extração de subpáginas e exportação de dados em poucos cliques.

- Combine Thunderbit e Python pra unir extração rápida e processamento avançado de dados.

- Seja legal e ético: respeite as regras dos sites, evite dados pessoais e mantenha seus 웹 스크래퍼 amigáveis.

Pronto pra começar? Tente criar seu primeiro 웹 스크래퍼 em Python — ou, se quiser pular a programação, e veja como coletar dados pode ser fácil. Pra mais dicas e conteúdos, acesse o .

Perguntas Frequentes

1. O que é web scraping e por que o Python é tão popular para isso?

Web scraping é a extração automática de dados de sites. O Python bomba porque tem sintaxe fácil, bibliotecas poderosas (tipo Requests e BeautifulSoup) e uma comunidade gigante que ajuda todo mundo ().

2. Quais bibliotecas Python devo usar para web scraping?

Na maioria dos casos, começa com Requests (pra buscar páginas) e BeautifulSoup (pra analisar HTML). Pra sites dinâmicos ou cheios de JavaScript, vai de Selenium. Pra projetos grandes ou complexos, Scrapy é top ().

3. Como o Thunderbit se compara à raspagem web com Python?

O Thunderbit é uma extensão Chrome com IA que raspa dados em 2 cliques — sem programar nada. É perfeito pra quem quer resultado rápido, enquanto o Python dá mais liberdade pra projetos personalizados ou grandes ().

4. Web scraping é legal?

웹 스크래퍼 geralmente é legal se você pegar dados públicos, respeitar o robots.txt e os termos de uso, e evitar informações pessoais ou protegidas por direitos autorais. Sempre confira as regras do site antes ().

5. Como posso combinar Thunderbit e Python para fluxos avançados?

Use o Thunderbit pra extrair dados estruturados e exportar pra CSV ou Excel. Depois, use Python (com Pandas ou outras libs) pra limpar, analisar ou automatizar o processamento — aproveitando o melhor dos dois mundos.

Pronto pra transformar a web na melhor fonte de dados do seu negócio? Teste Python e Thunderbit — e deixe os dados trabalharem por você.

Saiba Mais