A internet virou um verdadeiro oceano de dados — só para ter uma ideia, em 2024 o mundo bateu a marca de de informações digitais. E olha que curioso: mais de 90% de todos os dados do planeta foram criados só nos últimos dois anos. Para quem trabalha com negócios, isso significa que a próxima grande sacada, lead ou vantagem competitiva provavelmente está escondida online — só falta saber como encontrar.

É aí que entra o raspador web. Seja para vendas, e-commerce ou pesquisa de mercado, automatizar a coleta e organização de dados de sites é praticamente um superpoder. E se você nunca programou, relaxa — Python deixa tudo muito mais fácil do que parece. Neste tutorial, vou te mostrar o caminho das pedras, desde a preparação do ambiente até a limpeza dos dados, e ainda te apresento um atalho sem código usando o para quem quer agilidade.

O que é Web Scraping com Python?

Resumindo: web scraping é o jeito automatizado de extrair dados de sites. Imagina que você quer pegar preços de produtos numa loja online, montar uma lista de leads num diretório ou ficar de olho nas notícias dos concorrentes. Em vez de copiar e colar tudo na mão (ninguém merece!), o raspador web permite criar um script que faz todo o trabalho pesado para você.

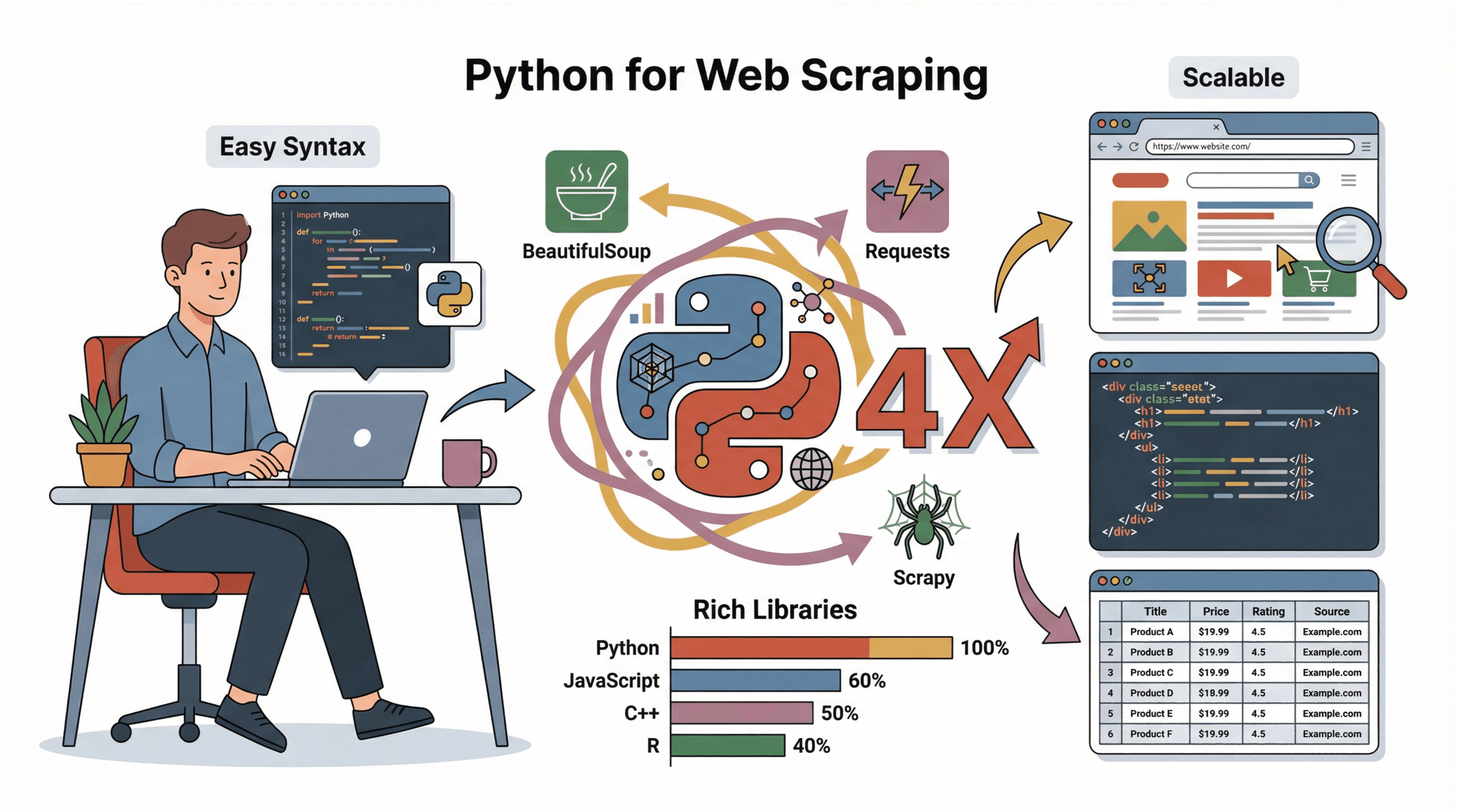

Web scraping com Python é usar a linguagem Python para automatizar esse processo. Com uma sintaxe super amigável e bibliotecas poderosas, Python é perfeito até para quem está começando. Dá para buscar páginas, analisar o conteúdo e salvar os dados organizados rapidinho.

O pessoal de negócios usa raspador web para:

- Geração de leads: Montar listas de possíveis clientes em diretórios ou sites de avaliações.

- Monitoramento de preços: Acompanhar preços de concorrentes ou estoque de produtos.

- Pesquisa de mercado: Juntar notícias, avaliações ou menções em redes sociais.

- Operações: Coletar informações de fornecedores, vagas de emprego ou anúncios de imóveis.

Resumindo: se o dado está em um site, Python te ajuda a capturar — rápido e em grande escala.

Por que Python é a Melhor Opção para Web Scraping

Já testei várias linguagens para scraping (e sim, já passei pelo famoso “por que isso não funciona?!”). Mas Python é imbatível, e aqui vai o porquê:

Já testei várias linguagens para scraping (e sim, já passei pelo famoso “por que isso não funciona?!”). Mas Python é imbatível, e aqui vai o porquê:

- Fácil de aprender: A sintaxe do Python é clara, ótima para quem não é programador.

- Ecossistema completo: Bibliotecas como , e facilitam baixar, analisar e salvar dados.

- Comunidade ativa: Tem tutorial, fórum e exemplo de código para tudo quanto é problema.

- Escalabilidade: Serve tanto para scripts rápidos quanto para projetos grandes de raspador web.

Comparando com JavaScript, C++ ou R, Python é mais acessível e perfeito para prototipar e analisar dados (). Por isso, é a escolha padrão de quem está começando e também das grandes empresas.

Começando: Como Preparar o Ambiente de Scraping em Python

Antes de sair extraindo dados, você precisa instalar o Python e algumas bibliotecas essenciais. Olha só como é simples, mesmo para quem nunca mexeu com Python:

-

Instale o Python:

- Baixe a versão mais recente em .

- No Windows, marque “Add Python to PATH” na instalação.

- No Mac, use o com

brew install python3. - No Linux, use:

sudo apt install python3 python3-pip.

-

Instale o pip (gerenciador de pacotes do Python):

- Normalmente já vem junto. Confira com

pip --version. - Se não aparecer, reinstale ou use

python -m ensurepip --upgrade.

- Normalmente já vem junto. Confira com

-

Crie um Ambiente Virtual (opcional, mas recomendado):

- No seu projeto, rode:

python -m venv env - Ative o ambiente:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- No seu projeto, rode:

-

Instale as Bibliotecas Necessárias:

- Com o ambiente virtual ativo, rode:

1pip install requests beautifulsoup4 pandas scrapy - Para scraping avançado (sites dinâmicos), instale também o

selenium.

- Com o ambiente virtual ativo, rode:

-

Escolha um Editor de Código:

- Para quem está começando, , ou são ótimos.

Dicas para resolver pepinos:

- Se o

pipnão funcionar, tentepython -m pip install .... - Se der erro de permissão, abra o terminal como admin ou use

sudono Mac/Linux. - No Windows, reinicie o terminal depois de instalar o Python.

Inspecionando um Site Antes de Fazer Scraping

Antes de escrever qualquer linha de código, é essencial entender como o site organiza os dados. Eu faço assim:

-

Abra as Ferramentas de Desenvolvedor:

- No Chrome, clique com o direito em qualquer elemento e escolha “Inspecionar”, ou aperte

F12. - Você vai ver o HTML na aba “Elements”.

- No Chrome, clique com o direito em qualquer elemento e escolha “Inspecionar”, ou aperte

-

Encontre os Dados que Quer:

- Use o ícone de ponteiro para clicar no dado desejado (tipo título do produto ou preço).

- O HTML correspondente vai ficar destacado.

-

Identifique Padrões:

- Procure por tags, classes ou IDs únicos. Exemplo:

<h2 class="product-title">Notebook XYZ</h2>. - Veja se os dados estão em listas (

<ul>,<div class="item">, etc.) ou tabelas.

- Procure por tags, classes ou IDs únicos. Exemplo:

-

Verifique Paginação:

- Procure botões “Próxima” ou números de página no HTML. Se tiver URLs tipo

?page=2, dá para percorrer no seu script.

- Procure botões “Próxima” ou números de página no HTML. Se tiver URLs tipo

-

O Conteúdo é Dinâmico?

- Se o dado não aparece no código-fonte (

Ctrl+U), pode ser carregado via JavaScript. Aí talvez precise do Selenium ou achar um endpoint de API.

- Se o dado não aparece no código-fonte (

Se quiser um passo a passo visual, o é ótimo.

Usando Requests para Baixar o Conteúdo da Página

A biblioteca é o básico para baixar páginas web em Python. Olha só um exemplo simples:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # Dá erro se a resposta for ruim

6html = response.textDicas:

- Sempre coloque um

User-Agentrealista para evitar bloqueios (). - Confira

response.status_code(200 = OK, 404 = não achou, 403 = proibido, 429 = muitas requisições).

Extraindo Dados com BeautifulSoup: Como Pegar o que Importa

Agora que você já tem o HTML, é hora de extrair o que interessa. O facilita muito:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]Tarefas comuns:

- Extrair texto:

element.get_text(strip=True) - Pegar links:

[a['href'] for a in soup.select('a')] - Buscar por classe:

soup.find_all('span', class_='price') - Extrair imagens:

[img['src'] for img in soup.select('img')] - Trabalhar com tabelas: Use

soup.select('table')e percorra as linhas/células.

Dicas para HTML bagunçado:

- Use

soup.select_one()para pegar só o primeiro resultado. - Se um campo não existir, veja se é

Noneantes de acessar. - Para layouts confusos, talvez precise de lógica personalizada ou regex.

Scrapy: Framework para Web Scraping em Grande Escala

Quando o scraping cresce (centenas ou milhares de páginas), o é seu melhor amigo. Ele é um framework completo para rastrear sites, gerenciar requisições, seguir links e exportar dados.

Por que usar Scrapy?

- Velocidade: Scrapy busca várias páginas ao mesmo tempo (assíncrono).

- Recursos integrados: Já lida com tentativas, cache e exportação para CSV/JSON.

- Escalabilidade: Perfeito para projetos grandes ou coletas recorrentes.

Fluxo básico com Scrapy:

- Instale:

pip install scrapy - Crie um projeto:

scrapy startproject meu_projeto - Defina uma classe Spider com

start_urlse um métodoparse. - Use

yieldpara seguir links ou extrair dados. - Rode:

scrapy crawl nomedospider -o resultado.csv

Para começar rápido, veja a .

Alternativa Sem Código: Raspador Web IA do Thunderbit para Resultados Instantâneos

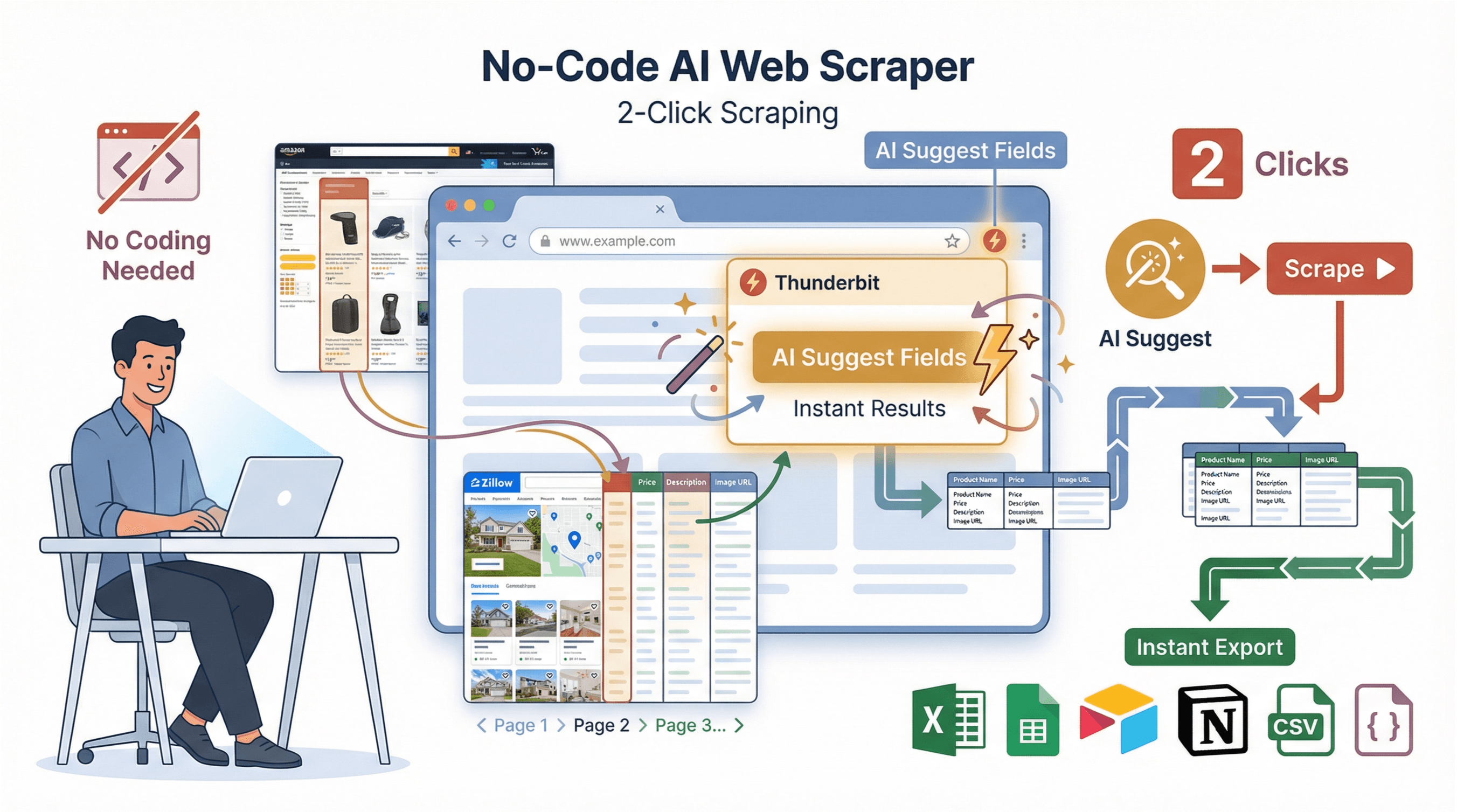

Vamos ser sinceros — nem todo mundo quer lidar com código, dependências ou bugs. Por isso criamos o : um raspador web IA, extensão para Chrome, feito para quem quer resultado em poucos cliques.

Vamos ser sinceros — nem todo mundo quer lidar com código, dependências ou bugs. Por isso criamos o : um raspador web IA, extensão para Chrome, feito para quem quer resultado em poucos cliques.

Como funciona o Thunderbit:

- Sugestão de Campos por IA: Clique em “AI Suggest Fields” e o Thunderbit analisa a página, sugerindo as melhores colunas para extrair.

- Raspagem em 2 cliques: Clique em “Scrape” e o Thunderbit faz o resto — incluindo paginação, subpáginas e layouts bagunçados.

- Raspagem de Subpáginas: Precisa de mais detalhes? O Thunderbit pode visitar cada subpágina (tipo detalhes de produtos ou perfis) e enriquecer sua tabela automaticamente.

- Modelos Prontos: Para sites populares (Amazon, Zillow, Instagram, Shopify), use templates prontos e exporte em 1 clique.

- Exportação Gratuita: Exporte para Excel, Google Sheets, Airtable, Notion, CSV ou JSON — sem complicação.

Thunderbit vs. Python: Comparativo Rápido

| Recurso | Python (Manual) | Thunderbit (Sem Código) |

|---|---|---|

| Tempo de Configuração | 30–60 minutos | 2 minutos |

| Precisa Programar | Sim | Não |

| Lida com Paginação | Com código personalizado | Sim, automaticamente |

| Raspagem de Subpáginas | Laços manuais | 1 clique |

| Exportação de Dados | Código para CSV/Excel | 1 clique para Sheets/Excel/Notion |

| Manutenção | Atualização manual se o site mudar | IA se adapta automaticamente |

| Melhor Para | Lógica personalizada, integração | Resultados rápidos, não programadores |

Quer saber mais? Dá uma olhada no .

Limpeza e Armazenamento: Como Deixar os Dados Prontos para Uso

Dado bruto quase nunca está pronto para análise. Veja como limpar e guardar usando o :

1import pandas as pd

2# Suponha que você tenha uma lista de dicionários chamada scraped_data

3df = pd.DataFrame(scraped_data)

4# Remover duplicatas

5df = df.drop_duplicates()

6# Filtrar linhas com valores ausentes

7df = df.dropna(subset=['title', 'price'])

8# Converter preço para float (remover $ e vírgulas)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# Salvar em CSV

11df.to_csv('results.csv', index=False)Boas práticas:

- Sempre confira dados ausentes ou inconsistentes.

- Padronize formatos (datas, preços, etc.).

- Salve em CSV para compartilhar fácil, ou use Excel/Google Sheets para colaboração.

- Para grandes volumes, pense em um banco de dados (tipo SQLite ou PostgreSQL).

Tutorial Prático: Web Scraping em Python do Zero ao Resultado

Vamos juntar tudo com um exemplo real: extrair títulos e preços de produtos de um site de e-commerce de exemplo.

1. Inspecione o Site

Suponha que você queira extrair dados de . Ao inspecionar a página, repare:

- Os títulos dos livros estão em tags

<h3>dentro de<article class="product_pod">. - Os preços estão em

<p class="price_color">.

2. Baixe a Página

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. Analise e Extraia os Dados

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. Limpe e Salve os Dados

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"Salvo {len(df)} livros em books.csv")5. Dicas para Resolver Problemas

- Se a lista

booksestiver vazia, revise seus seletores CSS. - Se der erro de codificação, abra o CSV com UTF-8.

- Para várias páginas, percorra URLs como

http://books.toscrape.com/catalogue/page-2.html.

Dica avançada: Para sites dinâmicos ou fluxos mais complexos, use Selenium ou Scrapy — ou deixe o Thunderbit fazer tudo para você.

Conclusão & Principais Aprendizados

Fazer raspador web com Python abre um mundo de possibilidades para negócios, de geração de leads a inteligência de mercado. Resumindo o que vimos:

- Python é a melhor escolha para raspador web pela simplicidade e bibliotecas poderosas.

- Requests e BeautifulSoup são essenciais para baixar e analisar HTML.

- Scrapy é ideal para projetos grandes e robustos.

- Thunderbit oferece uma alternativa sem código, com IA, para resultados instantâneos — perfeito para quem quer pular o código e ir direto ao dado.

- Limpeza e armazenamento são fundamentais para transformar dados brutos em insights valiosos.

Se quiser se aprofundar, tente criar seu próprio raspador em um site de testes ou e veja como é rápido conseguir dados organizados de qualquer site. Para mais dicas e tutoriais, acesse o .

Boas raspagens — e que seus dados estejam sempre limpos, organizados e prontos para uso.

Perguntas Frequentes

1. Web scraping é legal?

Na maioria dos casos, extrair dados públicos de sites é permitido, mas sempre respeite os termos de uso, o arquivo robots.txt e leis de privacidade como a GDPR. Evite coletar dados pessoais sem consentimento e nunca tente burlar logins ou barreiras de segurança ().

2. Qual a diferença entre Requests, BeautifulSoup e Scrapy?

- Requests faz o download das páginas.

- BeautifulSoup analisa e extrai dados do HTML.

- Scrapy é um framework completo para rastrear e extrair dados em grande escala, lidando com múltiplas páginas e exportações.

3. E se o site carregar dados via JavaScript?

Se os dados não estiverem no HTML inicial, use ou Playwright para automatizar o navegador, ou inspecione as requisições de rede para encontrar endpoints de API acessíveis.

4. Como evitar bloqueios ao fazer scraping?

Use cabeçalhos realistas (especialmente User-Agent), adicione intervalos aleatórios entre as requisições e não sobrecarregue o servidor. Para scraping em larga escala, alterne IPs ou use proxies ().

5. Posso extrair dados sem programar?

Com certeza. O permite extrair dados de qualquer site em dois cliques usando IA — sem precisar de código. Basta instalar a extensão do Chrome, descrever o que deseja e exportar os dados na hora.

Para mais guias e dicas avançadas, não deixe de conferir o .

Saiba Mais