Se você já tentou extrair uma lista de leads de vendas de algum site, provavelmente já passou pelo mesmo perrengue que eu. Pensei: “Manjo de JavaScript, vai ser moleza!” Só que, depois de algumas horas, já estava perdido no meio de seletores malucos, conteúdo sumindo do nada e trombando com bloqueios anti-bot. Descobri rapidinho que não era só eu nessa: já sacaram que dados são o novo ouro dos negócios, e o web scraping está no centro dessa onda. Só que, conforme os sites ficam mais espertos, fazer web scraping usando JavaScript vira tanto um superpoder quanto um baita quebra-cabeça.

Neste guia, vou dividir tudo que aprendi sobre web scraping usando JavaScript—desde o básico até os pepinos mais cabeludos, e como ferramentas modernas com IA, tipo o , podem te salvar dos pesadelos com seletores. Seja para montar um catálogo de produtos pro seu e-commerce ou criar uma lista de leads de vendas, bora juntos entender como extrair dados da web com JavaScript (e uma ajudinha da IA).

Web Scraping Usando JavaScript: O Básico e os Limites

Pra começar do começo: web scraping usando JavaScript é extrair dados de sites de forma automática, seja rodando scripts direto no navegador ou usando Node.js no backend. Como JavaScript é a alma da web, faz todo sentido usar ele pra scraping—principalmente com o monte de biblioteca boa, tipo Cheerio (pra HTML estático) e Puppeteer ou Playwright (pra automação de navegador headless).

Por que JavaScript é tão popular pra scraping?

- Acesso direto ao DOM: No navegador, você mexe no DOM igualzinho a um usuário normal.

- Ecossistema forte: O Node.js tem biblioteca pra tudo: requisição HTTP, parsing, automação.

- Flexibilidade: Dá pra automatizar login, clique, rolagem—tudo que você faz no Chrome pode ser roteirizado.

Mas aí vem o desafio: os sites de hoje mudam toda hora. Usam JavaScript pra carregar conteúdo dinâmico, reorganizam tudo e ainda colocam barreira anti-bot. Ou seja, seu script pode funcionar hoje e quebrar amanhã. Você vai ficar ajustando seletor, lidando com pop-up e correndo atrás de dado que carrega de forma assíncrona. É tipo um pega-pega, só que com chaves e colchetes.

Por Que Sites Modernos Complicam o Web Scraping Usando JavaScript

Antigamente, era só baixar o HTML e buscar o que queria. Agora, sites como Facebook Marketplace, Amazon ou até portais imobiliários locais usam frameworks JavaScript que montam o conteúdo em tempo real, escondem dados em rolagem infinita e organizam tudo num DOM super complicado.

Só fazer parsing do HTML não resolve mais. Por exemplo, pra extrair avaliações de produto ou comentários aninhados, não basta achar a <div> certa—tem que entender a relação entre os elementos, o contexto de cada campo e, às vezes, até o significado do dado.

É aí que entra o pré-processamento inteligente. Em vez de só pegar o HTML cru, você precisa entender de verdade a página: onde está o nome do produto, o preço, a avaliação do usuário? Isso é difícil só com JavaScript puro—mas é aí que ferramentas com IA fazem toda a diferença.

Ferramentas Tradicionais de Web Scraping Usando JavaScript

Vamos falar de ferramentas. O combo clássico de scraping em JavaScript geralmente envolve uma (ou mais) dessas opções:

- Cheerio: Perfeito pra parsing de HTML estático. Pensa nele como um jQuery do servidor.

- Puppeteer/Playwright: Automação de navegador headless. Eles abrem um navegador de verdade, executam JavaScript e deixam você interagir com a página como se fosse um usuário (ou um robô viciado em café).

O passo a passo clássico é:

- Fazer a requisição da página (com ou sem navegador headless).

- Esperar o conteúdo carregar (às vezes usando

waitForSelectorou algo parecido). - Fazer parsing do DOM pra buscar os dados que você quer.

- Extrair e organizar os resultados.

Parece fácil, né? Mas tem um porém: toda vez que o site muda o layout, seus seletores quebram. Se aparecer um pop-up novo, o script trava. Se mudarem a ordem dos campos, os dados ficam bagunçados. A manutenção vira um looping infinito.

Comparando as Principais Bibliotecas de Scraping em JavaScript

| Recurso | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| Melhor para | HTML estático | Páginas dinâmicas | Páginas dinâmicas |

| Automação de navegador | Não | Sim | Sim |

| Lida com conteúdo JS | Não | Sim | Sim |

| Velocidade | Rápido | Mais lento | Mais lento |

| API Simples | Simples | Moderada | Moderada |

| Evasão anti-bot | Limitada | Moderada | Moderada |

| Multi-navegador | Não | Só Chrome | Chrome, Firefox, WebKit |

| Casos de uso | Sites simples, APIs | Sites interativos | Sites interativos |

Cheerio é super rápido pra páginas estáticas ou APIs que devolvem HTML, mas não executa JavaScript. Puppeteer e Playwright são ideais pra páginas dinâmicas, mas são mais pesados e exigem mais configuração. Ambos automatizam login, clique, rolagem, mas você ainda tem que programar cada detalhe do site.

Thunderbit: Web Scraping com IA para Fluxos em JavaScript

Agora vem a parte legal. No Thunderbit, a gente percebeu que scraping não é só capturar HTML—é entender a página como um ser humano. Por isso criamos o , uma Extensão Chrome de Raspador Web IA que traz compreensão semântica pro web scraping.

Como funciona?

- O Thunderbit transforma a página numa versão Markdown—ou seja, um jeito mais limpo e organizado de enxergar o site.

- Depois, nossa IA analisa esse Markdown pra identificar campos, relações e contexto—entendendo o que é preço, avaliação ou só um emoji decorativo.

- O resultado? Você recebe dados estruturados e rotulados, resistentes a mudanças de layout, conteúdo dinâmico e alterações no DOM.

Pra quem trabalha com dados, isso significa menos limpeza manual, menos script quebrado e mais tempo pra análise de verdade. Pra dev, dá pra focar na automação da navegação (login, clique, rolagem) e deixar a extração complicada com o Thunderbit.

Passo a Passo: Web Scraping Usando JavaScript (Tradicional e com Thunderbit)

Bora pra prática. Vou mostrar um exemplo real: extrair listagem de produtos de um site de e-commerce. Primeiro, do jeito tradicional com Puppeteer. Depois, como turbinar tudo usando o Thunderbit.

Passo 1: Preparando o Ambiente de Scraping em JavaScript

Primeiro: instale o . Depois, instale o Puppeteer:

1npm install puppeteerSe preferir o Playwright (que suporta mais navegadores), use:

1npm install playwrightPra quem não é técnico: não precisa ser ninja em JavaScript. Só copiar e colar os códigos, vou explicar cada parte.

Passo 2: Navegando e Interagindo com Páginas Dinâmicas

Sites modernos adoram esconder dado atrás de login, pop-up e rolagem infinita. Olha como automatizar esses passos com Puppeteer:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // Acessa a página de login

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'seu_usuario');

8 await page.type('#password', 'sua_senha');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // Vai pra página de produtos

12 await page.goto('https://example.com/products');

13 // Rola pra carregar mais itens

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // Espera os produtos carregarem

21 await page.waitForSelector('.product-card');

22 // ... (vamos extrair os dados no próximo passo)

23})();Esse script faz login, navega até a página de produtos e rola pra carregar mais itens. O segredo é esperar os elementos aparecerem—senão, você acaba extraindo dado vazio.

Passo 3: Extraindo Dados com JavaScript

Agora, bora capturar os dados. Suponha que cada produto está numa div .product-card:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);Erros clássicos:

- Seletores frágeis. Se o site mudar

.product-titlepra.title, o script quebra. - Dados escondidos. Às vezes, preço ou avaliação carrega via AJAX depois da página pronta.

- Bloqueio anti-bot. Muitas requisições podem te bloquear.

Passo 4: Potencializando a Extração com IA do Thunderbit

Aqui entra o Thunderbit. Em vez de sofrer com seletor e lógica frágil, você pode mandar o HTML renderizado (ou até um print) pro Thunderbit extrair tudo com IA.

Como funciona na prática?

- Use Puppeteer ou Playwright pra automatizar navegação, login etc.

- Quando estiver na página certa, capture o HTML:

1const pageContent = await page.content();- Manda esse HTML pro Thunderbit (via ) pra extração com IA.

O Thunderbit vai:

- Converter a página pra Markdown pra facilitar a análise semântica.

- Usar IA pra identificar campos, relações e contexto.

- Gerar dados estruturados prontos pra exportar pro Excel, Google Sheets, Airtable ou Notion.

Chega de caçar seletor ou limpar dado bagunçado.

Lidando com Conteúdo Dinâmico e Carregamento Assíncrono

Conteúdo dinâmico é o terror de quem faz scraping. Sites adoram carregar dado depois do carregamento inicial—rolagem infinita, botão “Carregar Mais” ou avaliação via AJAX.

Táticas tradicionais:

- Use

waitForSelectorpra esperar elemento aparecer. - Espere o “network idle” (sem mais requisição) antes de extrair.

- Dispare rolagem ou clique manual pra carregar mais dado.

Mas esses métodos são frágeis. Se o site mudar a lógica de carregamento, o script quebra.

Como o Thunderbit resolve: Ao converter a página pra Markdown e deixar a IA analisar a estrutura, o Thunderbit depende menos do DOM ou de IDs específicos. Mesmo que o layout mude, se o conteúdo estiver lá, a IA do Thunderbit geralmente acha e extrai. Ou seja, menos manutenção e dados mais confiáveis.

Montando um Pipeline de Dados Sustentável: Do Script ao Insight

Scraping não é só uma tarefa pontual—é o começo de um pipeline de dados. Olha como costumo pensar:

- Automatize navegação e extração com JavaScript (Puppeteer/Playwright).

- Deixe o Thunderbit estruturar e rotular os dados com IA.

- Exporte os resultados pra sua ferramenta favorita: Excel, Google Sheets, Airtable, Notion.

- Agende tarefas recorrentes com o do Thunderbit—só descrever o intervalo (“toda segunda às 9h”), colar as URLs e deixar o Thunderbit fazer o resto.

- Feche o ciclo integrando os dados estruturados nos fluxos do seu negócio—seja pra prospecção, monitoramento de preço ou pesquisa de mercado.

Essa combinação—JavaScript pra automação, Thunderbit pra extração com IA—deixa seu pipeline repetível e de baixa manutenção, mantendo seu negócio sempre abastecido com dados frescos e confiáveis.

Conclusão: Qual a Melhor Maneira de Fazer Web Scraping Usando JavaScript?

Então, qual o melhor caminho pra fazer scraping com JavaScript? Minha visão:

- Scraping tradicional com JavaScript (Cheerio, Puppeteer, Playwright) é ótimo pra sites simples ou quando você quer controle total da automação. Mas dá trabalho manter—seletor quebra, layout muda e as barreiras anti-bot só aumentam.

- Extração com IA do Thunderbit traz compreensão semântica. É mais resistente a mudanças, reduz a limpeza manual e deixa você focar em insight, não em debugar script.

Quando usar cada um?

- Pra extrações rápidas e pontuais de páginas simples, use Cheerio ou Puppeteer.

- Pra sites complexos e dinâmicos—ou se quiser um fluxo à prova de mudanças—combine seus scripts JavaScript com a extração IA do Thunderbit.

- Pra quem não quer programar, a extensão do Thunderbit é o jeito mais fácil de transformar páginas em planilhas em poucos cliques.

Quer ver mais exemplos? Dá uma olhada no pra tutoriais sobre , e muito mais.

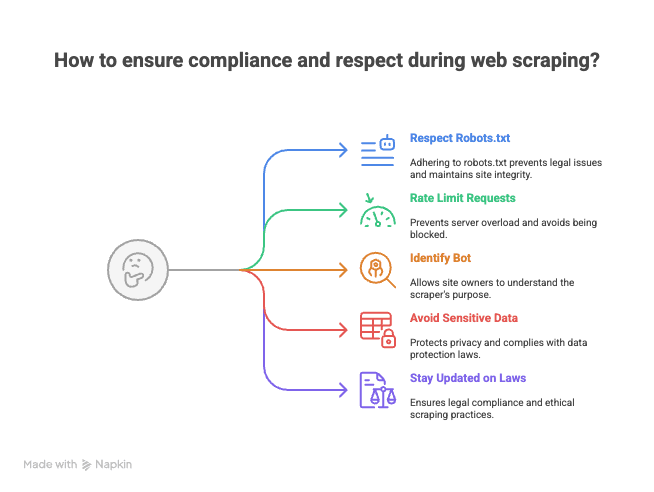

Bônus: Dicas Pra Fazer Scraping de Forma Ética e Legal

Antes de sair rodando script por aí, um toque rápido (de quem já levou uns e-mails “carinhosos” de admin de site):

- Respeite o robots.txt e os termos de uso. Nem todo site permite scraping.

- Limite a frequência das requisições. Não sobrecarregue o servidor—espalhe os acessos pra evitar bloqueio (ou até blacklist).

- Identifique seu bot. Use um User-Agent personalizado pra galera saber quem tá acessando.

- Evite dados sensíveis ou pessoais. Foque em informação pública e respeite a privacidade.

- Fique ligado nas leis e boas práticas. Web scraping pode ser uma área cinzenta em alguns países.

Lembre: com grande poder de scraping vem grande responsabilidade (e, às vezes, um e-mail de “pare imediatamente”).

Fazer web scraping usando JavaScript é tanto arte quanto ciência. Com as ferramentas certas—e uma ajudinha da IA—você transforma a web no seu próprio playground de dados organizados. E se travar, já sabe onde me achar (provavelmente debugando seletor com um café e o Thunderbit aberto).

Boas extrações!

Perguntas Frequentes

1. O que é web scraping usando JavaScript e por que é tão popular?

Web scraping usando JavaScript é extrair dados de sites de forma automática, rodando scripts no navegador ou usando Node.js no backend. É popular porque JavaScript permite acesso direto ao DOM, tem um ecossistema forte de bibliotecas pra requisições e automação, e oferece flexibilidade pra automatizar login, clique e rolagem.

2. Quais os principais desafios ao extrair dados de sites modernos e dinâmicos?

Sites modernos usam frameworks JavaScript pra carregar conteúdo dinâmico, esconder dados atrás de rolagem infinita ou pop-up e mudam o layout toda hora. Isso deixa as abordagens tradicionais frágeis, porque scripts quebram fácil quando seletor muda ou dado carrega de forma assíncrona.

3. Como as ferramentas tradicionais de scraping em JavaScript (Cheerio, Puppeteer, Playwright) se comparam?

- Cheerio é ideal pra HTML estático e é rápido, mas não lida com conteúdo renderizado por JavaScript nem automação de navegador.

- Puppeteer e Playwright são feitos pra páginas dinâmicas, suportam automação de navegador e lidam com conteúdo JavaScript, mas são mais lentos e exigem mais configuração. O Playwright suporta vários navegadores, enquanto o Puppeteer é focado no Chrome.

4. Quais vantagens o Thunderbit oferece em relação aos métodos tradicionais?

O Thunderbit usa IA pra entender semanticamente as páginas, convertendo elas em Markdown estruturado e extraindo campos rotulados. Essa abordagem é mais resistente a mudanças de layout, reduz a necessidade de limpeza manual e minimiza a manutenção comparado ao scraping baseado em seletor.

5. Quais as melhores práticas pra fazer web scraping de forma ética e legal?

- Sempre confira e respeite o robots.txt e os termos de uso do site.

- Limite a frequência das requisições pra não sobrecarregar o servidor.

- Identifique seu bot com um User-Agent personalizado.

- Evite extrair dados sensíveis ou pessoais, foque em informação pública.

- Fique por dentro das leis e boas práticas do seu país.

Saiba mais: