Nunca vou esquecer a primeira vez que tentei acompanhar todas as notícias durante o lançamento de um produto. Eu estava com três monitores ligados, uma dezena de abas do Google News abertas e aquela sensação de que ia perder alguma bomba—tipo um anúncio surpresa da concorrência ou uma crise de reputação de última hora. Descobri que não era só comigo: hoje em dia, mais de podem ser publicados em um único dia. É tanta manchete que não dá pra ler nem em uma vida inteira, imagina antes do próximo café.

Se você trabalha com vendas, marketing, operações ou comunicação, sabe bem como é impossível acompanhar tudo. Monitorar notícias manualmente é como tentar beber água de uma mangueira de incêndio. Por isso, automatizar a raspagem de notícias do Google News com Python é um verdadeiro superpoder: você automatiza a busca, organiza os dados para análise e não perde nada—seja para monitorar sua marca, ficar de olho nos concorrentes ou identificar tendências antes de todo mundo. Neste guia, vou te mostrar desde um exemplo básico até como criar um raspador google news python robusto e confiável. Vamos falar de código, boas práticas e como preparar seus dados para análise (com algumas histórias e piadas no caminho).

Por Que a Raspagem de Notícias do Google é Essencial para Empresas

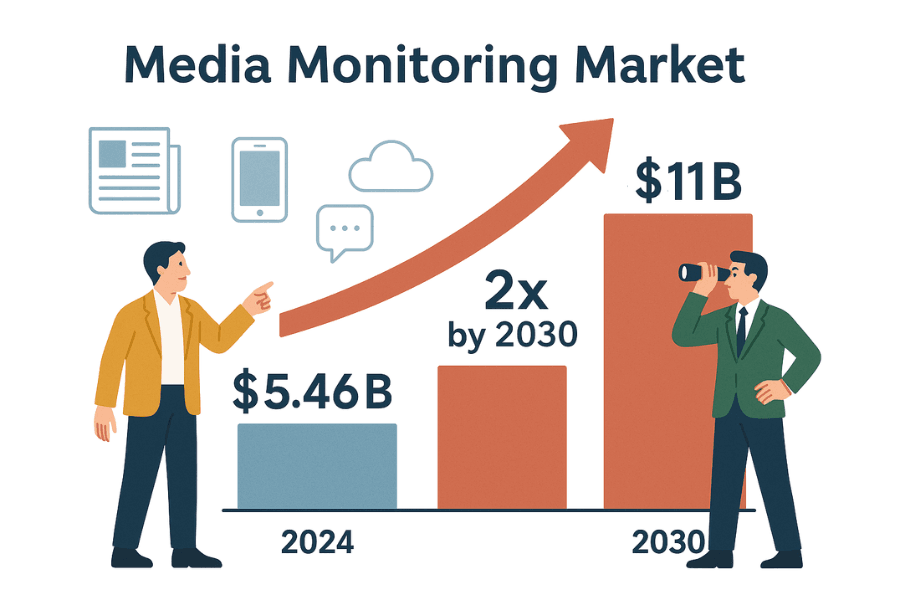

Vamos ser sinceros: o mundo dos negócios gira na velocidade das manchetes. Seja em comunicação, vendas ou estratégia, você precisa saber o que estão falando—e precisa saber agora. O mercado global de ferramentas de monitoramento de mídia já vale e deve dobrar até 2030. O motivo? Nenhuma empresa pode se dar ao luxo de perder uma notícia que pode afetar sua reputação, vendas ou até questões regulatórias.

Veja como extrair resultados do google news pode te transformar no herói do escritório (ou pelo menos na pessoa que nunca é pega de surpresa):

| Caso de Uso | Benefício da Automação de Notícias |

|---|---|

| Monitoramento de Reputação de Marca | Identifique notícias negativas ou crises rapidamente, permitindo resposta ágil (veja como a Dove evitou uma crise de imagem). |

| Inteligência Competitiva | Acompanhe lançamentos, mudanças de executivos ou fusões e aquisições dos concorrentes para ajustar sua estratégia (detalhes). |

| Geração de Leads de Vendas | Monitore empresas-alvo para rodadas de investimento, expansões ou eventos relevantes (case de uso). |

| Análise de Tendências e Mercado | Reúna notícias do setor para identificar tendências emergentes e o sentimento do mercado (por que isso importa). |

| Gestão de Riscos | Configure alertas para processos, regulamentações ou mudanças de políticas que possam impactar seu negócio (exemplos). |

Monitoramento manual? É lento, sujeito a erros e você pode perder oportunidades ou ameaças importantes (). Já a automação entrega um fluxo constante e organizado de notícias—sem FOMO, só inteligência pronta pra ação.

Primeiros Passos: Fundamentos de Web Scraping com Python (Exemplo para Iniciantes)

Antes de mergulhar no universo do web scraping google news, vamos praticar com um site aberto: . Ele foi feito para treinar raspagem, então você pode aprender sem medo de bloqueios ou problemas legais.

Nosso roteiro:

- Enviar uma requisição para a página inicial.

- Analisar o HTML com BeautifulSoup.

- Extrair títulos e preços dos livros.

- Salvar os dados em um DataFrame do pandas e exportar para CSV.

- Percorrer as páginas e tratar erros de forma elegante.

Passo 1: Enviando Requisições e Lendo o HTML

Primeiro, vamos buscar a página inicial usando a biblioteca requests do Python:

1import requests

2url = "http://books.toscrape.com/index.html"

3response = requests.get(url)

4print(response.status_code) # Deve imprimir 200 se tudo der certoUm status 200 significa que está tudo certo ().

Agora, vamos analisar o HTML:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(response.text, 'html.parser')Isso nos dá um objeto soup—uma forma prática de navegar pelo DOM da página ().

Passo 2: Extraindo Dados e Salvando em CSV

Vamos pegar todos os livros da página:

1books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

2print(f"Encontrados {len(books)} livros nesta página")Agora, extraia títulos e preços:

1book_list = []

2for item in books:

3 title = item.h3.a["title"]

4 price = item.find("p", class_="price_color").get_text()

5 book_list.append({"Título": title, "Preço": price})Salve em CSV usando pandas:

1import pandas as pd

2df = pd.DataFrame(book_list)

3df.to_csv("books.csv", index=False)Ou, se preferir, use o módulo csv:

1import csv

2keys = book_list[0].keys()

3with open("books.csv", "w", newline="", encoding="utf-8") as f:

4 writer = csv.DictWriter(f, fieldnames=keys)

5 writer.writeheader()

6 writer.writerows(book_list)Abra o books.csv no Excel e veja o resultado do seu superpoder de dados.

Passo 3: Lidando com Paginação e Erros

Quer todos os livros, não só da primeira página? Use um loop:

1all_books = []

2for page in range(1, 51): # 50 páginas no total

3 url = f"http://books.toscrape.com/catalogue/page-{page}.html"

4 try:

5 res = requests.get(url, timeout=10)

6 if res.status_code != 200:

7 break

8 soup = BeautifulSoup(res.text, 'html.parser')

9 books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

10 for item in books:

11 title = item.h3.a["title"]

12 price = item.find("p", class_="price_color").get_text()

13 all_books.append({"Título": title, "Preço": price})

14 except requests.exceptions.RequestException as e:

15 print(f"Falha na requisição: {e}")

16 continueEsse loop percorre as páginas, para se não existir mais e trata erros de rede. (Dica: adicione time.sleep(1) entre as requisições para ser educado.)

Parabéns! Agora você já domina o básico de web scraping: requisições, parsing, extração, paginação e tratamento de erros. Esses são os mesmos fundamentos para scraping google news python.

Raspando Notícias do Google com Python: Passo a Passo

Pronto para avançar? Vamos criar um raspador google news python capaz de coletar manchetes, links, fontes e horários—transformando o noticiário mundial em dados organizados para análise.

Preparando o Ambiente Python

Certifique-se de ter Python 3 e estas bibliotecas:

1pip install requests beautifulsoup4 pandas()

Você também vai precisar de um User-Agent para simular um navegador real—senão o Google pode bloquear seu acesso ().

Construindo o Raspador de Notícias do Google em Python

Vamos por partes:

1. Defina a URL de Busca e Parâmetros

URLs de busca do Google News seguem este padrão:

1https://news.google.com/search?q=SEU_TERMO&hl=pt-BR&gl=BR&ceid=BR:ptq: termo de buscahl: idioma (ex:pt-BR)gl: país (ex:BR)ceid: país:idioma (ex:BR:pt)

Veja como configurar no Python:

1base_url = "https://news.google.com/search"

2params = {

3 'q': 'tecnologia',

4 'hl': 'pt-BR',

5 'gl': 'BR',

6 'ceid': 'BR:pt'

7}

8headers = {

9 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)...'

10}()

2. Busque a Página de Resultados

1response = requests.get(base_url, params=params, headers=headers)

2html = response.text

3print(response.status_code)()

3. Analise e Extraia os Dados

Vamos analisar o HTML e extrair os artigos:

1soup = BeautifulSoup(html, 'html.parser')

2articles = soup.find_all('article')

3news_data = []

4for art in articles:

5 headline_tag = art.find('h3')

6 title = headline_tag.get_text() if headline_tag else None

7 link_tag = art.find('a')

8 link = link_tag['href'] if link_tag else ''

9 if link.startswith('./'):

10 link = 'https://news.google.com' + link[1:]

11 source_tag = art.find(attrs={"class": "wEwyrc"})

12 source = source_tag.get_text() if source_tag else None

13 time_tag = art.find('time')

14 time_text = time_tag.get_text() if time_tag else None

15 snippet_tag = art.find('span', attrs={"class": "xBbh9"})

16 snippet = snippet_tag.get_text() if snippet_tag else None

17 news_data.append({

18 "título": title,

19 "fonte": source,

20 "horário": time_text,

21 "link": link,

22 "resumo": snippet

23 })()

Agora, salve em CSV:

1df = pd.DataFrame(news_data)

2df.to_csv("google_news_results.csv", index=False)Lidando com Dados Faltantes

Sempre cheque se as tags existem antes de acessar. O HTML do Google pode variar—às vezes tem resumo, às vezes não. Se faltar algo, defina como None ou string vazia.

Raspando Várias Páginas e Lidando com Limites

O Google News usa rolagem infinita, não páginas numeradas. Com requests, normalmente você pega só o primeiro lote de resultados. Se quiser mais:

- Use o feed RSS da busca (pode trazer mais resultados; veja )

- Use um navegador automatizado (Selenium, Playwright) para rolar a página (avançado)

- Ou, simplesmente raspe com frequência (ex: a cada hora) para pegar novidades

Atenção: O Google pode bloquear se você raspar rápido demais. Usuários relatam erro 429 após apenas 10 requisições rápidas (). Para evitar:

- Adicione

time.sleep(random.uniform(2,6))entre as requisições - Altere User-Agents e IPs se for raspar em grande escala

- Detecte CAPTCHAs ou páginas de bloqueio no HTML e pare

Tornando Sua Raspagem do Google News Reprodutível e Pronta para Análise

Aqui está o segredo: raspagem de qualidade não é só “pegar os dados”—é garantir que eles sejam reprodutíveis e prontos para análise. Se você quer dashboards de BI, monitoramento de PR ou acompanhamento de concorrentes funcionando a longo prazo, precisa controlar idioma, região, tempo e duplicidade.

Filtrando por Idioma, Região e Tempo

O Google News personaliza bastante o conteúdo. Para resultados consistentes:

- Use os parâmetros

hl,gleceidpara idioma e região () - Exemplo:

hl=pt-BR&gl=BR&ceid=BR:ptpara notícias do Brasil em português

Para filtrar por tempo:

- O Google News não tem parâmetro direto para “últimas 24h”, mas normalmente os resultados vêm por ordem de publicação

- Você pode filtrar depois de raspar: se o campo

horáriocontiver “há horas”, “há minutos” ou “Hoje”, mantenha; senão, descarte - Para mais controle, use o feed RSS ou operadores avançados de busca (nem sempre funcionam)

Filtrando e Removendo Duplicatas

Duplicatas atrapalham qualquer análise. Veja como evitar:

- Lista branca de fontes/temas: Filtre os dados para incluir só certas fontes ou temas. Dá até para usar o operador

source:na busca (ex:q=Tesla source:Reuters). - Remova duplicatas por URL: Normalize URLs removendo parâmetros de rastreamento (como

utm_*). Exemplo:

1import urllib.parse

2clean_link = urllib.parse.urljoin(link, urllib.parse.urlparse(link).path)()

- Remova duplicatas por título: Se vários artigos têm títulos muito parecidos, mantenha só um. Pode comparar em minúsculas e sem pontuação.

- Controle de artigos já vistos: Se raspar diariamente, armazene um hash da URL normalizada. Antes de adicionar um novo artigo, veja se já existe.

Assim, seus dados ficam limpos e prontos para análise—sem manchetes duplicadas ou resultados distorcidos ().

Comparando Abordagens: Python Raspador vs. APIs de Notícias do Google

Vale mais a pena criar seu próprio raspador google news python ou usar uma API de terceiros? Veja a comparação:

| Critério | Raspador Python DIY | API de Notícias do Google de Terceiros |

|---|---|---|

| Esforço de Implementação | Escreva e depure o código; adapte a mudanças no site | Chamadas de API prontas; sem parsing de HTML |

| Flexibilidade | Extraia qualquer campo ou siga sublinks | Limitado aos campos e opções da API |

| Controle dos Dados | Controle total dos dados brutos | Dados pré-processados; confie no parsing do provedor |

| Escala & Velocidade | Limitado por IP/recursos; risco de bloqueio | Feito para escala; provedor gerencia proxies e bloqueios |

| Confiabilidade | Pode quebrar se o Google mudar o HTML ou bloquear IP | Muito confiável; APIs se adaptam às mudanças |

| Manutenção | Contínua: atualizar seletores, lidar com anti-bot | Mínima: provedor cuida da manutenção |

| Custo | Gratuito (exceto seu tempo e possíveis proxies) | Pago—por requisição ou mensal (exemplos de preços) |

| Risco de Bloqueio | Alto se não tomar cuidado; Google pode banir IP | Baixo; API lida com bloqueios e tentativas |

| Atualização dos Dados | Você controla quando raspar, mas frequência alta pode bloquear | Em tempo real; limites altos com plano adequado |

| Questões Legais/ToS | Você deve garantir conformidade com os termos do Google | Ainda precisa atenção, mas APIs alegam uso justo (não é conselho legal!) |

Para projetos pequenos ou aprendizado, DIY é ótimo para controle. Para produção ou grande escala, APIs economizam tempo e dor de cabeça. (E se quiser o melhor dos dois mundos—sem código, sem manutenção—veja o Thunderbit abaixo.)

Solucionando Problemas Comuns na Raspagem do Google News

Raspagem de notícias do google nem sempre é tranquila. Veja o que pode dar errado (e como resolver):

- CAPTCHAs ou páginas de “tráfego incomum”: Diminua a velocidade das requisições, alterne User-Agents e use proxies se necessário. Se aparecer CAPTCHA, pare e espere ().

- Erros HTTP 429/503: Você está sendo bloqueado. Implemente backoff exponencial, confira o robots.txt e evite rodar vários raspadores ao mesmo tempo.

- Mudanças no HTML: O Google atualiza o layout com frequência. Inspecione o novo HTML e atualize os seletores. Use try/except para evitar falhas.

- Campos ausentes: Nem todo artigo tem resumo ou fonte. Adapte o código para lidar com isso.

- Entradas duplicadas: Implemente deduplicação como explicado acima.

- Problemas de codificação: Use UTF-8 ao salvar arquivos.

- Conteúdo carregado por JavaScript: A maioria dos resultados do Google News é server-side, mas se precisar de conteúdo JS, use Selenium ou Playwright (avançado).

Para mais dicas, confira e o .

Boas Práticas para Raspagem Responsável do Google News

Vamos falar de ética e boas práticas—porque com grande poder de raspagem vem grande responsabilidade:

- Respeite o robots.txt: O robots.txt do Google News proíbe o acesso a alguns caminhos (). Mesmo que tecnicamente seja possível raspar, é bom seguir as regras.

- Evite sobrecarregar os servidores: Adicione intervalos, raspe fora do horário de pico e não sobrecarregue o site.

- Use os dados de forma permitida: Foque em manchetes, resumos e links para análise. Não replique artigos completos ().

- Cite as fontes: Se compartilhar insights, credite o Google News e os veículos originais.

- Monitore e atualize seu raspador: A web muda—seu código também deve mudar.

- Privacidade e conformidade legal: Armazene dados com segurança e siga as leis de privacidade.

- Uso justo e limites: Não exagere—raspe em escala moderada e esteja pronto para parar se solicitado ().

Resumindo: raspe como um bom cidadão digital. Seu eu do futuro (e o time de TI) agradecem.

Principais Lições e Próximos Passos

Resumo:

- Você aprendeu o básico de web scraping com requests e BeautifulSoup no Python—começando por um site estático e depois indo para o Google News.

- Você montou um fluxo reprodutível de raspagem de notícias do google: controlando idioma, região e tempo; removendo duplicatas; e deixando os dados prontos para análise.

- Você comparou raspagem DIY com APIs: entendendo as vantagens e desvantagens de cada abordagem.

- Você pegou dicas de troubleshooting e boas práticas para raspar de forma ética e responsável.

E agora? Aplique essas técnicas nas necessidades do seu negócio—seja para monitorar sua marca, acompanhar concorrentes ou criar um dashboard personalizado de notícias. Quer ir além? Experimente raspar outros sites de notícias, automatizar seu pipeline de dados ou até rodar análise de sentimento nas manchetes.

E se cansar de manter scripts Python (ou quiser economizar tempo), conheça o . O Thunderbit é uma extensão do Chrome com IA que permite extrair notícias do Google e de outros sites em poucos cliques—sem código. Com recursos como “Sugestão de Campos por IA”, raspagem agendada, navegação em subpáginas e exportação instantânea para Excel ou Google Sheets, é a forma mais fácil de automatizar a coleta de notícias para sua equipe. (Você pode .)

Para mais dicas de raspagem, acesse o , ou confira nossos guias sobre , e .

Boas raspagens—e que seus feeds de notícias estejam sempre atualizados, organizados e um passo à frente da concorrência.

Escrito por Shuai Guan, Co-fundador & CEO da Thunderbit. Tenho anos de experiência em SaaS, automação e IA, e ainda me divirto transformando caos em dados úteis. Se quiser trocar ideias ou histórias de raspagem, vamos conversar.

Perguntas Frequentes

1. Por que empresas devem considerar raspar o Google News com Python?

Raspar o Google News permite automatizar a coleta de notícias relevantes para sua marca, concorrentes ou setor. Isso facilita o monitoramento em tempo real de crises de imagem, movimentos da concorrência, insights de vendas, análise de tendências de mercado e gestão de riscos. O acompanhamento manual é lento e pode perder atualizações importantes, enquanto a automação garante um fluxo estruturado e atualizado de manchetes e notícias relevantes.

2. Quais são os passos básicos para raspar o Google News usando Python?

O processo envolve:

- Preparar o ambiente Python com bibliotecas como

requests,BeautifulSoupepandas. - Definir a URL de busca do Google News e os parâmetros (consulta, idioma, região).

- Enviar uma requisição para buscar a página de resultados com os headers adequados (incluindo User-Agent).

- Analisar o HTML para extrair detalhes dos artigos como título, link, fonte, horário e resumo.

- Salvar os dados extraídos em um arquivo CSV para análise.

- Tratar dados ausentes e remover duplicatas para garantir um conjunto limpo e pronto para análise.

3. Quais desafios posso enfrentar ao raspar o Google News e como resolvê-los?

Desafios comuns incluem:

- CAPTCHAs ou avisos de “tráfego incomum”: Diminua a frequência das requisições, alterne User-Agents e use proxies se necessário.

- Limite de requisições (erros HTTP 429/503): Implemente intervalos e evite raspagem paralela.

- Mudanças na estrutura do HTML: Atualize os seletores regularmente e use try/except.

- Campos ausentes ou inconsistentes: Sempre verifique se a tag existe antes de extrair.

- Entradas duplicadas: Remova duplicatas por URL ou título.

- Problemas de codificação: Use UTF-8 ao salvar arquivos.

- Conteúdo carregado por JavaScript: Para casos avançados, use Selenium ou Playwright.

4. Como tornar meu fluxo de raspagem do Google News reprodutível e pronto para análise?

Para garantir reprodutibilidade e dados limpos:

- Controle idioma e região usando os parâmetros

hl,gleceidna URL. - Filtre resultados por tempo, seja após a raspagem ou usando feeds RSS.

- Remova duplicatas normalizando URLs e comparando títulos.

- Controle artigos já vistos para evitar contagem dupla.

- Armazene os dados com segurança e documente o processo para futuras atualizações.

5. Devo criar meu próprio raspador do Google News ou usar uma API de terceiros?

Criar seu próprio raspador oferece controle total, flexibilidade e geralmente é gratuito (exceto pelo seu tempo e possíveis custos de proxy). Porém, exige manutenção contínua, pode quebrar se o Google mudar o HTML e tem maior risco de bloqueio. APIs de terceiros são mais confiáveis, fáceis de escalar e lidam com anti-bot para você, mas têm custo e podem limitar o controle sobre os dados. Para projetos pequenos ou aprendizado, DIY é ótimo; para produção ou grande escala, APIs costumam ser a melhor escolha.