Vivemos numa era em que os dados são o novo ouro, e a disputa para aproveitá-los só aumenta. Todos os dias, bilhões de páginas da web são varridas em busca de informações, preços, leads e pesquisas — alimentando desde batalhas de preços no e-commerce até avanços em IA (). O mercado global de web scraping deve passar de US$ 9 bilhões até o fim de 2025, e se você ainda não está usando um raspador eficiente, provavelmente está deixando muita oportunidade passar ().

Depois de anos trabalhando com SaaS e automação, vi de perto como a escolha do raspador pode ser decisiva para o sucesso de um projeto. E ultimamente, tenho me surpreendido com o que Rust entrega nesse cenário. Neste guia, vou te mostrar por que Rust é tão forte para criar web crawlers, como começar do zero e como você pode unir Rust a ferramentas com IA, como o , para juntar velocidade, segurança e praticidade.

Por que apostar em Rust para criar um Web Crawler?

Vamos direto ao ponto: por que Rust? Essa dúvida é comum, principalmente para quem já usa Python ou Node.js para scraping. Olha só o que faz Rust se destacar:

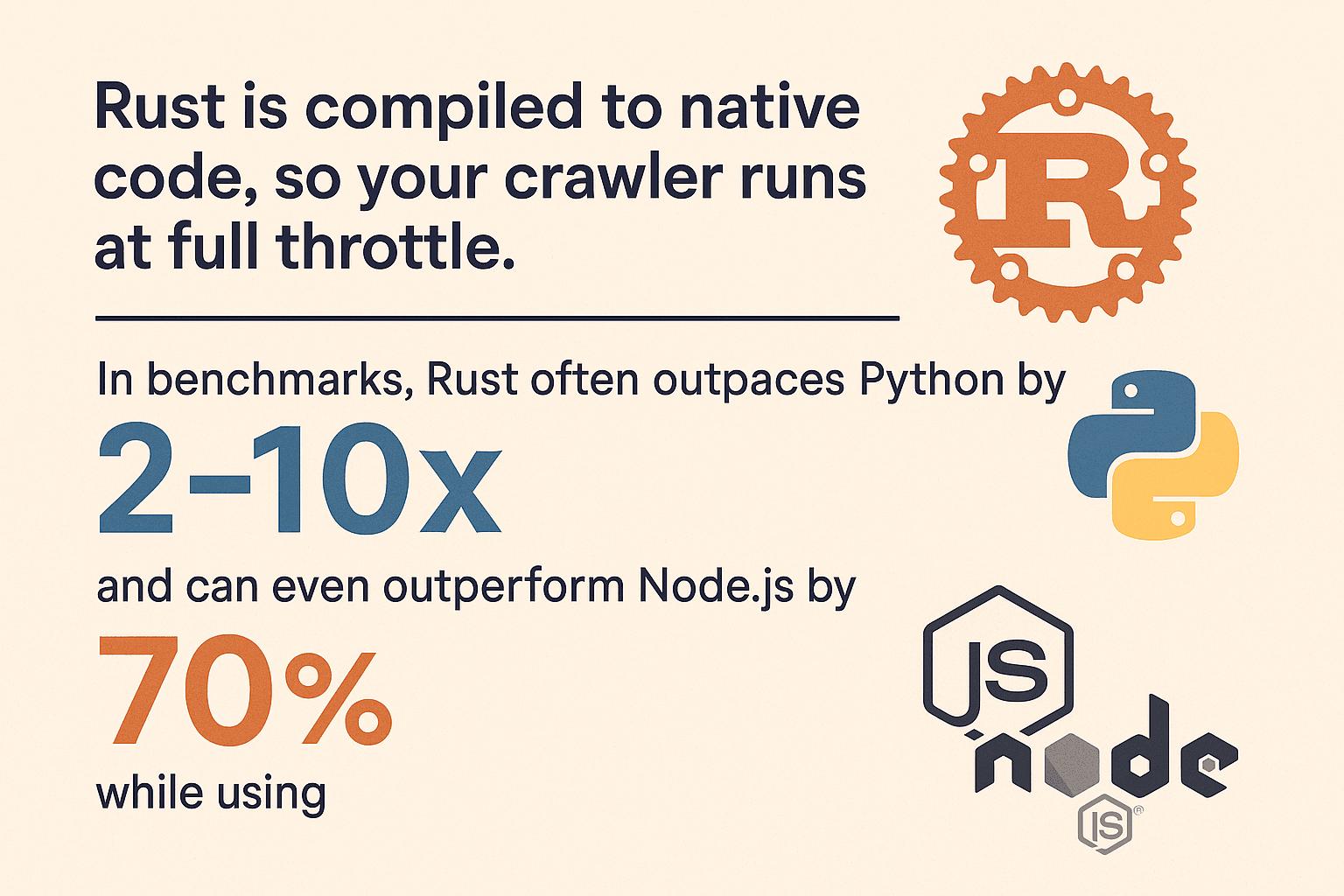

- Desempenho absurdo: Rust compila para código nativo, então seu crawler roda voando. Em testes, Rust costuma ser 2 a 10 vezes mais rápido que Python em tarefas pesadas e pode superar Node.js em até 70%, usando 90% menos memória (, ).

- Segurança de memória: O modelo de propriedade do Rust elimina aqueles bugs chatos e vazamentos de memória. O compilador pega os erros antes de virarem dor de cabeça.

- Concorrência sem susto: Rust foi feito para lidar com várias tarefas ao mesmo tempo. Quer buscar 100 páginas de uma vez? Vai fundo — o sistema de tipos do Rust mantém tudo seguro e evita condições de corrida.

- Confiabilidade: O tratamento de erros do Rust (com

ResulteOption) faz você pensar nos casos de falha. Seu crawler não vai travar por causa de uma requisição ruim. - Segurança: Sem buffer overflow, sem ponteiro nulo. As garantias de segurança do Rust deixam seu crawler menos vulnerável a conteúdos maliciosos ou malformados.

Comparando: Python é fácil, mas lento e pesado em memória; Node.js tem I/O rápido, mas é single-threaded e também consome bastante memória. Rust entrega performance e estabilidade de outro nível, principalmente quando o projeto cresce ().

Preparando o ambiente para seu Web Crawler em Rust

Pronto para botar a mão na massa? Olha como é simples configurar tudo:

1. Instale Rust e Cargo

Rust é distribuído via , que gerencia as versões do Rust e a ferramenta de build cargo. Baixe o instalador para seu sistema e siga as instruções. No Windows, talvez precise instalar o Visual C++ Build Tools.

Para conferir se deu certo:

1rustc --version

2cargo --versionSe aparecerem as versões, está tudo certo.

2. Crie um novo projeto

No terminal, rode:

1cargo new rust_web_crawler

2cd rust_web_crawlerIsso cria um projeto novo com Cargo.toml e src/main.rs.

3. Adicione as dependências essenciais

Para web crawling, você vai precisar de:

- (cliente HTTP)

- (parser HTML com seletores CSS)

- (runtime assíncrono, se quiser crawling async)

- (para exportar dados)

Adicione com:

1cargo add reqwest scraper csv tokio --features fullOu edite o Cargo.toml:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. Escolha seu editor e ferramentas

Eu curto muito o VS Code com a extensão . Ela traz autocompletar, documentação inline e linting. Para projetos maiores, JetBrains CLion ou IntelliJ com o plugin Rust também são ótimas pedidas.

5. Dicas para resolver problemas

- Se

cargonão for encontrado, veja se o.cargo/binestá no seu PATH. - No Windows, instale as ferramentas C++ se pedir.

- Se der erro de dependência, rode

cargo updateou confira se não tem erro de digitação noCargo.toml.

Passo a passo: criando seu primeiro Web Crawler em Rust

Vamos montar um crawler básico que busca uma página, extrai dados de produtos e exporta para CSV. O exemplo é simples, mas você pode turbinar depois.

Buscando páginas web com Rust

Comece importando o reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}Em produção, troque os unwrap() por um tratamento de erro mais cuidadoso:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};Extraindo e processando dados

Agora, use o scraper para analisar o HTML e puxar as informações dos produtos.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}Esse método, inspirado no , funciona para a maioria dos sites de e-commerce ou diretórios.

Gerenciando URLs e evitando duplicidade

Num crawler de verdade, é importante seguir links e evitar visitar a mesma página mais de uma vez. Veja um padrão clássico:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Buscar e analisar página...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // Use o crate `url`!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}Não esqueça de normalizar URLs (usando o crate ) para lidar com caminhos relativos, barras finais e fragmentos.

Implementando concorrência para acelerar o crawling

Aqui é onde Rust realmente mostra serviço. Buscar páginas uma a uma é lento — bora paralelizar.

Opção 1: Multi-threading

Crie algumas threads, cada uma processando a fila. Use Arc<Mutex<>> para compartilhar estado. Para crawlers pequenos, resolve bem.

Opção 2: Async/Await com Tokio

Para máxima velocidade, use async. Com tokio e reqwest assíncrono, você pode lançar centenas de requisições em paralelo sem estourar a memória.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;Rust assíncrono não é só rápido — é seguro. Sem condição de corrida, sem bug estranho. Só desempenho puro ().

Exportando e armazenando os dados extraídos

Depois de coletar os dados, provavelmente você vai querer exportar. O crate facilita muito:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();Você também pode serializar structs direto com ou exportar para JSON se precisar de dados mais complexos.

Usando Thunderbit para acelerar e simplificar a extração de dados web

Agora, vamos falar do . Por mais que eu goste de programar, tem hora que tudo o que você quer é o dado — rápido. O Thunderbit é uma extensão do Chrome com IA que permite extrair dados em poucos cliques, sem precisar programar nada.

Thunderbit é um Raspador Web IA para Chrome que ajuda profissionais a coletar dados de sites usando inteligência artificial. É uma ferramenta de produtividade que economiza tempo e automatiza tarefas repetitivas na web.

O que faz o Thunderbit ser diferente?

- Sugestão de campos com IA: O Thunderbit analisa a página e sugere colunas para extrair — nomes, e-mails, preços, o que você precisar ().

- Extração com um clique: Só clicar em “Scrape” e o Thunderbit organiza os dados em uma tabela estruturada.

- Extração de subpáginas: Precisa de informações de páginas de detalhes? O Thunderbit visita cada link e enriquece sua tabela automaticamente ().

- Paginação e scroll infinito: O Thunderbit detecta e lida com páginas paginadas ou com rolagem infinita.

- Exportação gratuita de dados: Exporte para Excel, Google Sheets, Notion, Airtable ou CSV — sem dor de cabeça.

- AI Autofill: Automatize preenchimento de formulários ou logins com IA, facilitando a extração de dados atrás de autenticação.

Thunderbit é um baita aliado tanto para profissionais de negócios quanto para devs — principalmente em sites dinâmicos ou pesados em JavaScript.

Quando usar Thunderbit ou Rust

- Thunderbit: Perfeito para protótipos rápidos, extrações pontuais ou para equipes que não programam.

- Rust: Melhor para crawlers de grande escala, altamente customizados ou integrados, onde performance e controle são essenciais.

E, na real, a mágica acontece quando você usa os dois juntos.

Comparando a performance do Web Crawler em Rust com outras tecnologias

Vamos aos números. Como Rust se sai frente aos concorrentes?

| Linguagem/Framework | Velocidade | Uso de Memória | Concorrência | Estabilidade | Ecossistema |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 Baixo | 🟢 Excelente | 🟢 Alta | Médio |

| Python (Scrapy) | 🚀 | 🔴 Alto | 🟡 Limitado | 🟡 Médio | 🟢 Grande |

| Node.js | 🚀🚀 | 🔴 Alto | 🟢 Bom | 🟡 Médio | 🟢 Grande |

| Go | 🚀🚀 | 🟢 Baixo | 🟢 Excelente | 🟢 Alta | Médio |

- Rust costuma ser 2 a 10 vezes mais rápido que Python e pode usar menos de 10% da memória (, ).

- Node.js é ótimo para I/O, mas é single-threaded para execução JS e pode travar com parsing pesado.

- Go é um concorrente forte, mas a segurança de memória e abstrações de baixo custo do Rust dão vantagem em crawlers robustos e de alta performance.

Se você precisa de escala ou máxima eficiência, Rust é difícil de bater.

Combinando Thunderbit e Rust para máxima eficiência

Meu fluxo de trabalho favorito: usar Thunderbit e Rust juntos.

- Prototipagem rápida: Use Thunderbit para mapear rapidamente um site e pegar dados de exemplo. Isso ajuda a entender a estrutura antes de programar.

- Divida e conquiste: Deixe o Thunderbit lidar com páginas dinâmicas, autenticadas ou complexas (com AI Autofill e subpáginas), enquanto seu crawler em Rust cuida das páginas estáticas ou APIs.

- Raspagem agendada: Programe extrações regulares com o Thunderbit e use o backend em Rust para processar ou combinar os resultados.

- Empodere não devs: Permita que equipes de operações ou marketing usem Thunderbit para demandas pontuais, liberando os devs para tarefas mais complexas.

- Resiliência: Se seu crawler em Rust quebrar por causa de mudanças no layout, a IA do Thunderbit pode se adaptar na hora — sem precisar mexer no código.

Essa abordagem híbrida junta o melhor dos dois mundos: velocidade e flexibilidade do Thunderbit, poder e controle do Rust.

Dicas e boas práticas para Web Crawlers em Rust

Fazer um crawler robusto vai além do código — é preciso antecipar os desafios do mundo real.

Desafios comuns

- Anti-bots: Use User-Agents realistas, respeite o

robots.txt, limite a frequência de requisições e considere proxies para scraping pesado (). - CAPTCHAs e logins: Para sites com CAPTCHAs ou logins chatos, use o AI Autofill do Thunderbit ou um navegador headless (ex: ou ) — só quando necessário.

- Sites pesados em JavaScript: Se os dados vêm via AJAX, procure as APIs por trás. Se precisar renderizar JS, use Thunderbit ou um navegador headless.

- Tratamento de erros: Sempre trate erros (

Result,Option), defina timeouts e registre falhas para depuração. - Concorrência: Use estruturas thread-safe (

Arc<Mutex<>>ouDashMap) e evite gargalos em estados compartilhados. - Gerenciamento de memória: Salve dados em disco se for extrair milhões de páginas — não tente guardar tudo na memória.

- Ética e conformidade: Respeite as regras dos sites, não sobrecarregue servidores e fique de olho nas leis de privacidade de dados.

Boas práticas

- Código modular: Separe lógica de busca, parsing e armazenamento para facilitar manutenção.

- Parâmetros configuráveis: Use arquivos de configuração ou argumentos de linha de comando para URLs, concorrência, delays etc.

- Logs: Use o crate

logpara logging estruturado. - Testes: Escreva testes unitários para o parsing usando HTML de exemplo.

- Monitoramento: Acompanhe o desempenho do crawler — CPU, memória, erros — especialmente em execuções longas.

Para mais dicas, confira o e o .

Conclusão & principais aprendizados

Construir um web crawler em Rust não é só um desafio técnico — é uma vantagem estratégica no mundo movido a dados. O que você deve levar daqui:

- Rust é uma potência para web crawling: rápido, seguro e feito para concorrência.

- Siga o passo a passo: Configure o ambiente, busque e processe páginas, gerencie URLs, adicione concorrência e exporte os dados.

- Thunderbit é seu trunfo para scraping rápido e sem código — especialmente em sites dinâmicos ou complexos.

- Combine os dois para máxima eficiência: Use Thunderbit para prototipagem e páginas difíceis, Rust para escala e personalização.

- Seja prático: Às vezes, a melhor solução é alguns cliques, não centenas de linhas de código.

Se quiser elevar o nível do seu web crawling, experimente Rust — e não hesite em deixar o fazer o trabalho pesado quando precisar. Quer mais dicas de scraping e automação? Confira o .

Boas extrações — que seus dados sejam sempre limpos, rápidos e cada vez mais inteligentes.

Perguntas frequentes

1. Por que usar Rust para criar um web crawler em vez de Python ou Node.js?

Rust entrega desempenho superior, segurança de memória e suporte avançado à concorrência. Python e Node.js são ótimos para scripts rápidos, mas Rust é ideal para crawlers de grande porte, que precisam de velocidade e confiabilidade ().

2. Quais bibliotecas são essenciais para criar um web crawler em Rust?

Você vai precisar de reqwest para requisições HTTP, scraper para parsing HTML, tokio para concorrência assíncrona e csv para exportar dados. O crate url também é útil para normalizar URLs.

3. Como lidar com sites pesados em JavaScript ou autenticados no Rust?

Para sites JS-heavy, procure as APIs por trás ou use um navegador headless com crates como fantoccini. Para páginas autenticadas, gerencie cookies com reqwest ou use o AI Autofill do Thunderbit para automatizar logins.

4. Qual a vantagem de combinar Thunderbit com Rust?

Thunderbit acelera a extração de dados com scraping sem código e IA — perfeito para prototipagem, páginas dinâmicas ou para equipes não técnicas. Rust é ideal para crawlers customizados e de alta performance. Juntos, você ganha agilidade e escala.

5. Como evitar bloqueios ou banimentos ao fazer crawling?

Respeite o robots.txt, use headers realistas, limite a frequência de requisições e considere proxies para scraping em grande volume. Sempre siga as regras dos sites e as leis de privacidade ().

Quer ver o Thunderbit em ação? e comece a extrair dados de forma inteligente hoje mesmo. Para mais conteúdos sobre automação web, acesse o .

Saiba mais