Se você já ficou curioso sobre como o Google consegue saber de praticamente tudo que existe na internet — até aquele post esquecido que você publicou em 2012 — pode ter certeza que não é o único. O segredo não é mágica nem um batalhão de estagiários tomando café e lendo a web sem parar. O que faz tudo acontecer são os crawlers: verdadeiros exploradores digitais que vasculham, catalogam e indexam sites do mundo inteiro sem descanso. Depois de anos criando ferramentas de automação e IA (e, confesso, às vezes derrubando um site sem querer no processo), aprendi a dar muito valor ao impacto desses bots no que a gente vê online. Se você tem um website, entender como funcionam os crawlers não é só uma curiosidade nerd — é o que separa ser encontrado de ser invisível.

Vamos desvendar juntos o que são os crawlers, como eles “enxergam” seu website, por que são essenciais para SEO e o que você pode fazer para garantir que seu conteúdo não fique perdido no limbo digital. E, como sou fã de automação inteligente, vou mostrar como ferramentas com IA, como a , estão mudando o jogo para quem tem site e para equipes que vivem de dados.

Crawlers: O Básico — O Que São e Como Funcionam?

Pensa num crawler como um bibliotecário digital — ou talvez uma aranha nerd, especialista em organização — cuja missão é explorar a web, um link de cada vez. Na prática, um crawler (também chamado de spider ou bot) é um software que navega sistematicamente pelos websites, acessando páginas, seguindo links e coletando informações sobre o que encontra. É assim que buscadores como Google, Bing e outros montam seus gigantescos índices de conteúdo online.

O processo é mais ou menos assim:

- Começa com uma lista de URLs conhecidas (tipo sua página inicial ou alguns sites “sementes”).

- Busca o conteúdo HTML de cada página.

- Extrai os hiperlinks e adiciona à lista de páginas para visitar.

- Repete o ciclo, pulando de link em link, catalogando novas páginas e atualizando o índice do buscador.

Se você imaginou um bibliotecário correndo entre prateleiras, anotando cada título e cruzando referências — só que na velocidade da internet — acertou em cheio. Sem crawlers, a maior parte da web seria invisível para os buscadores e, consequentemente, para todo mundo.

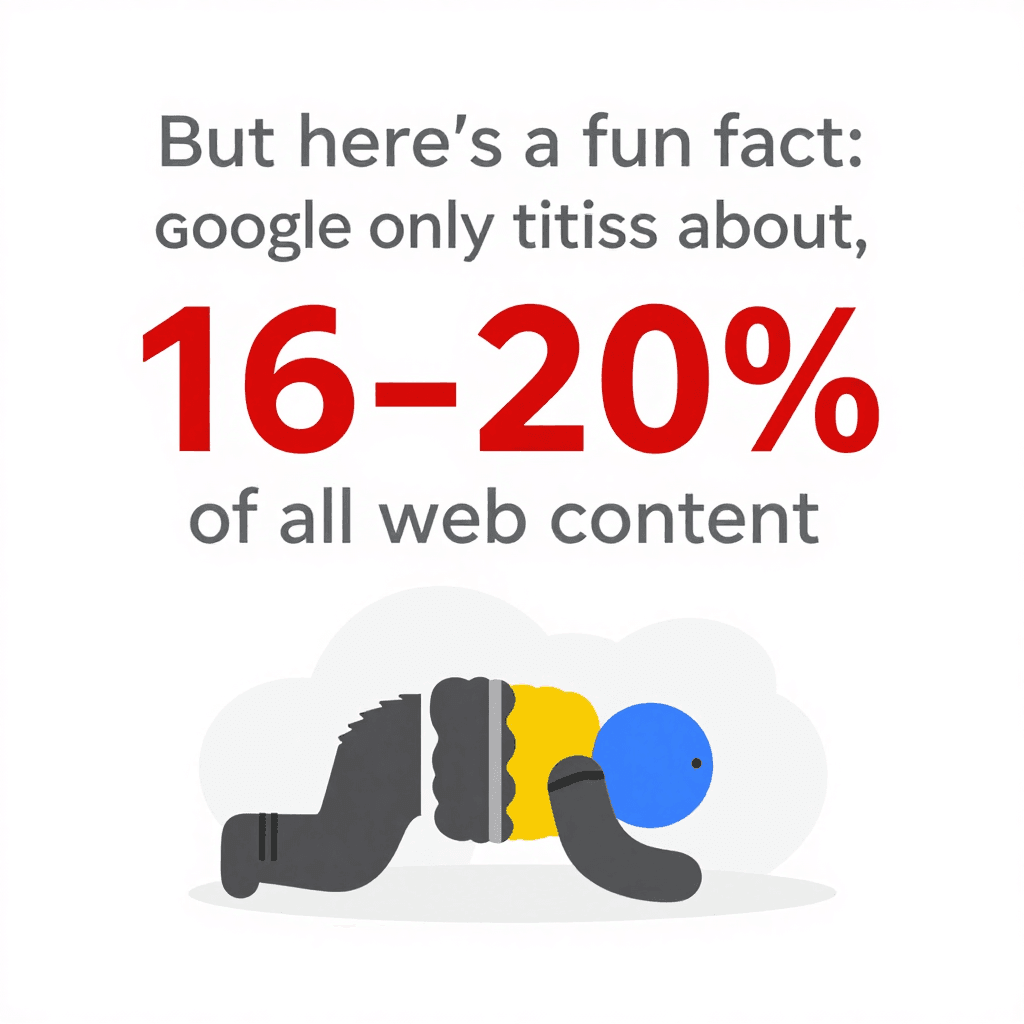

Curiosidade: mesmo com todo esse poder de varredura, o Google indexa só cerca de . O resto fica na chamada “deep web”, fora do alcance da maioria dos bots. Ou seja, a forma como você estrutura seu website — e o quanto facilita a vida dos crawlers — faz toda a diferença.

Curiosidade: mesmo com todo esse poder de varredura, o Google indexa só cerca de . O resto fica na chamada “deep web”, fora do alcance da maioria dos bots. Ou seja, a forma como você estrutura seu website — e o quanto facilita a vida dos crawlers — faz toda a diferença.

Como os Crawlers Enxergam e Interpretam o Conteúdo do Website

Crawlers não veem seu website como um visitante comum. Eles não ligam para fontes bonitas, imagens incríveis ou aquele efeito parallax que você ficou horas ajustando. O que importa para eles é o HTML puro: eles leem o texto, analisam as tags e seguem os links. É como olhar a planta de um prédio em vez de passear pelos cômodos.

O que mais importa para os crawlers:

- Estrutura HTML: Eles buscam títulos, parágrafos, listas e links.

- Links internos: São as rotas que levam os crawlers para diferentes partes do seu website. Se uma página não tem links apontando para ela, é praticamente invisível para o crawler.

- Navegação e sitemaps: Menus bem organizados e sitemaps atualizados funcionam como GPS, guiando os crawlers até o conteúdo mais importante.

- Metadados e dados estruturados: Tags como

<title>,<meta description>e marcações Schema.org ajudam os crawlers a entender do que se trata cada página — mesmo que o texto principal não deixe isso tão claro.

Se quiser pensar de forma mais técnica, imagine seu website como uma cidade. Os crawlers são os entregadores, e seus links internos e sitemaps são as placas e mapas que ajudam a chegar em cada endereço.

O Papel do Sitemap e do Robots.txt no Comportamento dos Crawlers

Dois arquivos são essenciais para orientar os crawlers no seu website:

-

XML Sitemap: É uma lista, em formato que máquina entende, das páginas mais importantes do seu website. É como entregar ao bibliotecário uma relação de todos os livros e onde estão. Um bom sitemap garante que os crawlers não deixem conteúdo relevante de fora — mesmo que a navegação interna não seja perfeita. Para sites grandes ou complexos, um sitemap completo pode .

-

robots.txt: Um arquivo simples, colocado na raiz do website, que diz aos crawlers onde eles podem ou não acessar. Quer impedir bots de entrarem na área administrativa ou bloquear páginas duplicadas? É aqui que você faz isso. Mas cuidado: um erro de digitação (tipo

Disallow: /) pode bloquear seu website inteiro dos buscadores — erro clássico de SEO. Use o robots.txt para .

Dica: sempre indique o caminho do sitemap no robots.txt. É como dizer “Comece sua visita por aqui!”

Por Que Crawlers São Essenciais para Seu Website: SEO e Impacto nos Visitantes

Vamos direto ao ponto: se um crawler não consegue acessar uma página, ela é praticamente invisível. Sem crawl = sem indexação = sem tráfego de busca. Todo o esforço em conteúdo, design e marca? Vai por água abaixo se o Googlebot não encontrar.

Por que isso importa? Porque e . Se seu website não é amigável para crawlers, você está deixando de aproveitar a maior fonte de visitantes.

Um website bem rastreado significa:

Um website bem rastreado significa:

- Mais páginas indexadas: Mais chances de aparecer nos resultados de busca.

- Melhor posicionamento: Os buscadores conseguem avaliar melhor a relevância do seu conteúdo.

- Atualizações mais rápidas: Conteúdo novo é indexado e ranqueado rapidinho.

- Melhor experiência para o usuário: Visitantes acham o que procuram, aumentando sua credibilidade e tráfego.

Tem muito site que viu o tráfego disparar só por corrigir problemas de rastreamento — tipo links quebrados ou tags noindex esquecidas. É aquele clássico “escondido à vista de todos”.

Como Crawlers Influenciam o Ranqueamento nas Buscas

Os buscadores usam os dados coletados pelos crawlers para decidir quais páginas são mais relevantes para cada pesquisa. Eles analisam:

- Qualidade do conteúdo e palavras-chave

- Links internos e externos

- Atualização e frequência de novas publicações

- Compatibilidade com dispositivos móveis (o Google já prioriza a indexação mobile)

Para sites grandes, existe ainda o conceito de orçamento de rastreamento — o número de páginas que um buscador vai rastrear em determinado período. Se seu website tem 100 mil páginas, mas o Googlebot só rastreia 5 mil por dia, pode levar semanas para tudo ser indexado. Por isso, uma (onde a maioria das páginas está a poucos cliques da home) é tão eficiente: ajuda os crawlers a acessar e reindexar seu conteúdo com mais facilidade.

Limitações dos Crawlers Tradicionais: Desafios com Sites Modernos

Agora começa a complicar. A web de hoje é um labirinto de JavaScript, conteúdo dinâmico e áreas protegidas por login. Crawlers tradicionais — principalmente os mais simples — podem se perder, travar ou simplesmente desistir.

Os desafios mais comuns incluem:

- Conteúdo dinâmico e JavaScript: Muitos crawlers só enxergam o HTML inicial. Se o conteúdo carrega via JavaScript (tipo rolagem infinita ou botões “carregar mais”), um bot básico pode não ver nada. Mesmo o crawler do Google, que consegue renderizar JavaScript, às vezes só indexa parcialmente sites pesados em JS, especialmente se o conteúdo demora a aparecer ou depende de interação do usuário ().

- Conteúdo atrás de login: Se uma página exige login, a maioria dos crawlers não consegue acessar. Isso geralmente é intencional, mas às vezes conteúdo público importante fica preso atrás de um login por engano.

- robots.txt ou metatags mal configurados: Um deslize pode bloquear seções inteiras do seu website para os crawlers.

- Barreiras anti-bot: CAPTCHAs, limites de acesso ou bloqueio de user agents desconhecidos podem barrar os crawlers.

Com , os crawlers tiveram que evoluir muito. Mas ainda tem muito obstáculo que pode deixar seu conteúdo invisível.

Quando Ferramentas de Crawlers Tradicionais Não Dão Conta: Conteúdo Dinâmico e JavaScript

Imagina que você tem um e-commerce onde os produtos aparecem conforme o usuário rola a página. Um crawler tradicional pode enxergar só os primeiros 20 itens, ignorando o resto. Ou talvez suas avaliações só apareçam ao clicar em uma aba — de novo, invisíveis para a maioria dos bots.

O resultado? Conteúdo valioso não é indexado e você perde tráfego de busca. A solução é oferecer caminhos alternativos (como paginação ou HTML renderizado no servidor) e testar como os crawlers veem seu website usando ferramentas como a Inspeção de URL do Google Search Console.

Crawlers Inteligentes: Como a Thunderbit Lida com Páginas Complexas

É aqui que a coisa fica interessante — porque foi justamente para esse tipo de desafio que criamos a . A Thunderbit não é só mais um crawler; é um raspador de dados com IA, capaz de “ler” sites como um humano, extrair dados estruturados e lidar com todas as manhas do design web moderno.

O que faz a Thunderbit ser diferente?

- Sugestão de Campos por IA: Em vez de você ter que fuçar o HTML ou programar, a IA da Thunderbit analisa a página e sugere as melhores colunas para extrair — tipo “Nome do Produto”, “Preço” ou “E-mail de Contato”. Você pode ajustar as sugestões, mas o trabalho pesado já está feito.

- Raspagem de Subpáginas: Precisa de mais detalhes? A Thunderbit pode visitar automaticamente cada subpágina (como detalhes de produtos ou perfis de usuários), coletar informações extras e enriquecer sua base de dados. Chega de clicar manualmente ou copiar e colar.

- Lida com JavaScript e logins: Como a Thunderbit funciona como extensão do Chrome (ou em um navegador real na nuvem), ela executa JavaScript, espera o conteúdo dinâmico carregar e até raspa páginas em que você está logado.

- Adapta-se a mudanças no site: Scrapers tradicionais quebram quando o layout do site muda. A IA da Thunderbit lê a página do zero a cada vez, então pequenas alterações não atrapalham seu fluxo de trabalho.

- Raspagem agendada: Quer monitorar preços ou atualizar uma lista de leads toda manhã? Basta agendar em linguagem natural (“toda segunda às 9h”) e a Thunderbit faz o resto.

A Thunderbit foi feita para quem trabalha com negócios — vendas, marketing, e-commerce, imobiliárias — e precisa de dados, não de dor de cabeça. E sim, exportar para Google Sheets, Notion ou Airtable é só um clique (e totalmente grátis).

Recursos de IA da Thunderbit para Otimização de Crawlers

A verdadeira mágica da Thunderbit está no processamento de linguagem natural. Ela não só captura texto bruto — entende o contexto. Por exemplo, diferencia um número de telefone, um e-mail e um preço de produto, podendo extrair, rotular e até traduzir dados automaticamente.

O feedback dos usuários tem sido excelente. Um deles comentou: “Thunderbit é minha ferramenta preferida para captar contatos de influenciadores. Antes eu pagava por bancos de dados, agora monto o meu em minutos.” É esse tipo de ganho de produtividade que me anima.

E se você já tentou raspar um site que muda o layout toda semana (olhando para vocês, plataformas de e-commerce), vai adorar a abordagem “sem manutenção” da Thunderbit. A IA se adapta, então você não precisa ficar corrigindo scripts quebrados.

Como Otimizar Seu Website para Crawlers: Estrutura, Estratégia e Ferramentas Inteligentes

O que você pode fazer para tornar seu website um paraíso para crawlers? Veja algumas estratégias que funcionam de verdade:

- Desenhe uma arquitetura lógica: Mantenha as páginas importantes a poucos cliques da home. Uma (navegação ampla, pouca profundidade) melhora a eficiência do rastreamento e a taxa de indexação.

- Use links internos robustos: Conecte páginas relacionadas com links contextuais. Faça auditorias e corrija links quebrados sempre que possível.

- Mantenha o sitemap XML atualizado: Liste todas as URLs importantes e envie para o Google Search Console e Bing Webmaster Tools.

- Otimize o robots.txt: Permita acesso ao conteúdo-chave, bloqueie só o necessário e revise sempre para evitar bloqueios acidentais.

- Velocidade importa: Páginas rápidas e sem erros são rastreadas com mais eficiência. Otimize imagens, use CDN e corrija erros de servidor.

- Gerencie conteúdo duplicado: Use tags canônicas e evite desperdiçar orçamento de rastreamento com páginas duplicadas ou quase duplicadas.

- Aproveite dados estruturados e metadados: Implemente Schema.org para produtos, artigos, eventos etc., e gerencie suas meta tags com inteligência.

- Monitore a atividade de rastreamento: Use os relatórios de Cobertura do Índice e Estatísticas de Rastreamento do Google Search Console para identificar problemas cedo.

- Teste com ferramentas inteligentes: Use Thunderbit ou similares para ver como seu website aparece para um crawler e manter seus fluxos de dados funcionando sem dor de cabeça.

Alinhando a Arquitetura do Website às Necessidades dos Crawlers

Uma estrutura bem pensada não beneficia só os bots — melhora a experiência dos usuários também. Auditorias regulares (com ferramentas como Screaming Frog ou Sitebulb) ajudam a identificar problemas de rastreamento, links quebrados e páginas órfãs antes que prejudiquem seu ranqueamento.

E não esqueça do mobile: com a indexação mobile-first do Google, seu site móvel precisa conter todo o conteúdo e links importantes do desktop. Caso contrário, você pode deixar páginas valiosas fora do índice ().

Thunderbit vs. Crawlers Tradicionais: Um Comparativo Rápido

Vamos resumir:

| Aspecto | Thunderbit (Raspador Web IA) | Crawler/Scraper Tradicional |

|---|---|---|

| Facilidade de Uso | Sem código, IA sugere campos, qualquer usuário de negócios começa em 2 cliques. | Configuração técnica, geralmente exige programação ou seleção manual de elementos. |

| Adaptabilidade | IA se adapta a mudanças no layout, quase sem manutenção. | Quebra se a estrutura do site muda, exige ajustes manuais. |

| Conteúdo Dinâmico | Lida com JavaScript, logins e elementos interativos por padrão. | Geralmente limitado a HTML estático, dificuldade com JS ou conteúdo protegido por login. |

| Rastreamento de Subpáginas | Raspagem de subpáginas e paginação integrada, dados combinados automaticamente. | Configuração manual para profundidade, rastreamento recursivo exige trabalho extra. |

| Estrutura dos Dados | IA gera tabelas prontas para uso com colunas relevantes, suporta vários tipos de dados (texto, números, e-mails, imagens, PDFs etc.). | Saída bruta, usuário precisa definir estrutura, limitado ao HTML salvo programação customizada. |

| Integração | Exportação em um clique para Google Sheets, Notion, Airtable, CSV etc. | Normalmente exige exportação/importação manual, poucas integrações diretas. |

| Obstáculos para Bots | Gerencia proxies, user agents, tentativas automáticas; abordagem em cascata para maximizar sucesso. | Usuário precisa lidar com bloqueios de IP, CAPTCHAs etc. — geralmente complexo e caro. |

| Público-alvo | Usuários de negócios não técnicos: vendas, marketing, operações, e-commerce, imobiliárias. | Desenvolvedores, TI, engenheiros de dados. |

| Preço | Baseado em créditos, plano gratuito disponível, pague pelo uso. | Assinatura, cobrança por usuário ou servidor; custos extras com proxies ou manutenção. |

Resumindo: a Thunderbit leva o poder do rastreamento avançado para todo mundo, não só para desenvolvedores. É rápida, precisa e acompanha as mudanças da web.

Principais Lições: Como Aproveitar os Crawlers no Seu Website

- Crawlers são os guardiões da visibilidade online. Se seu website não é amigável para eles, você perde tráfego e novos visitantes.

- Estrutura e estratégia fazem diferença. Navegação lógica, links internos, sitemaps e robots.txt são seus aliados.

- Sites modernos exigem crawlers mais inteligentes. JavaScript, conteúdo dinâmico e logins podem confundir bots básicos — mas ferramentas com IA como a dão conta do recado.

- Monitoramento constante é fundamental. Use Search Console, auditorias de rastreamento e ferramentas inteligentes para manter seu website saudável e visível.

- Atualize seu kit de ferramentas. Seja para SEO ou para construir fluxos próprios de dados, considere como crawlers mais inteligentes podem economizar tempo, aumentar a precisão e apoiar decisões de negócio melhores.

Quer ver como a Thunderbit pode ajudar você a rastrear, indexar e extrair dados até dos sites mais desafiadores? e experimente. Para mais dicas sobre web scraping, SEO e automação, acesse o .

Perguntas Frequentes

1. O que é um crawler e por que ele é importante para meu website?

Crawler é um bot de software que navega e indexa o conteúdo dos websites para buscadores. Se seu website não for amigável para crawlers, suas páginas podem não aparecer nos resultados de busca, dificultando que usuários encontrem você.

2. Como sitemaps e robots.txt afetam os crawlers?

Sitemaps orientam os crawlers para as páginas mais importantes, enquanto o robots.txt define onde eles podem ou não acessar. Ambos são essenciais para um rastreamento e indexação eficientes.

3. Quais problemas crawlers tradicionais enfrentam em sites modernos?

Crawlers tradicionais têm dificuldade com conteúdo carregado por JavaScript, elementos dinâmicos, páginas protegidas por login e barreiras anti-bot. Por isso, podem deixar de indexar ou indexar só parcialmente conteúdos importantes.

4. Como a Thunderbit lida de forma diferente com sites complexos?

A Thunderbit usa IA para “ler” páginas como um humano, lida com JavaScript e logins, e extrai dados estruturados — até de subpáginas e conteúdo dinâmico. Ela se adapta a mudanças no site e não exige programação.

5. Quais as melhores práticas para tornar meu website amigável para crawlers?

Mantenha uma estrutura lógica, use links internos, mantenha sitemap e robots.txt atualizados, otimize a velocidade e monitore a atividade de rastreamento regularmente. Use ferramentas inteligentes como a Thunderbit para testar e melhorar a rastreabilidade do seu website.

Quer se aprofundar? Veja mais guias no ou inscreva-se no nosso para novidades sobre automação web e scraping com IA.

Saiba Mais