Os dados da web viraram o novo ouro, e em 2025 já estão por trás de vendas mais inteligentes e pesquisas de mercado super precisas. Tenho visto de perto times de ecommerce, imobiliárias e SaaS correndo para transformar páginas bagunçadas em planilhas organizadas e cheias de valor. Se você chegou até aqui, provavelmente quer entrar nessa onda também. A boa notícia? Python é seu melhor parceiro para web scraping, e nunca foi tão simples começar — mesmo sem ser dev.

Neste guia, vou te mostrar o caminho das pedras do web scraping em Python, desde o primeiro script até como escalar usando frameworks como o Scrapy. Também vamos ver como ferramentas com IA, tipo o , estão mudando o jogo da extração de dados para quem trabalha com negócios, deixando tudo mais rápido e fácil. Seja você um curioso começando agora ou um profissional querendo turbinar as habilidades, aqui tem dicas práticas, exemplos de código e orientações para raspar dados como um verdadeiro especialista.

O que é Web Scraping em Python? Entenda o Básico

Web scraping nada mais é do que automatizar a coleta de informações de sites — tipo ensinar o computador a copiar e colar pra você, só que muito mais rápido e em grande escala. Com Python, você cria scripts que acessam páginas, analisam o HTML e puxam só o que interessa: preços, contatos, avaliações e por aí vai.

Para empresas, web scraping é um verdadeiro tesouro. Times de vendas montam listas de leads, ecommerce monitora preços dos concorrentes e analistas acompanham tendências — tudo isso transformando conteúdo bagunçado em dados prontos pra análise. Python se destaca porque é poderoso e fácil de usar, virando a linguagem queridinha pra projetos de scraping de qualquer tamanho ().

Por que Python é a Linguagem Preferida para Web Scraping

Mas afinal, por que tanta gente escolhe Python pra web scraping? Três motivos: simplicidade, um arsenal de bibliotecas e uma comunidade sempre pronta pra ajudar.

- Sintaxe fácil: O código em Python é direto ao ponto. Não precisa ser engenheiro pra começar.

- Bibliotecas poderosas: Ferramentas como BeautifulSoup, Scrapy e Requests deixam tudo mais fácil na hora de coletar, analisar e navegar pelas páginas.

- Versatilidade: Python não serve só pra scraping. Ele é referência em análise de dados e automação, então dá pra ir dos dados crus até os insights sem trocar de linguagem.

- Apoio da comunidade: Travou num HTML complicado? Alguém já deve ter resolvido isso no Stack Overflow.

Veja como Python se compara com outras linguagens:

| Linguagem | Vantagens | Desvantagens | Melhor Uso |

|---|---|---|---|

| Python | Sintaxe simples, bibliotecas robustas, comunidade ativa | Mais lento que C++/Java em performance bruta | Todo tipo de scraping, de pequeno a grande porte |

| JavaScript | Lida nativamente com sites dinâmicos em JS | Parsing HTML menos maduro, desafios com async | Apps de página única, sites dinâmicos |

| R | Ótimo para análise de dados | Poucas opções de frameworks para scraping | Tarefas pequenas e focadas em estatística |

| Java/C# | Rápidas, nível corporativo | Código mais extenso, mais burocrático | Sistemas grandes e integrados |

Python segue firme entre as linguagens mais usadas pra web scraping e, em 2023, passou até o SQL como a terceira mais popular do mundo ().

Ferramentas e Bibliotecas Essenciais para Web Scraping em Python

Aqui vai o kit básico pra começar:

- Requests: Biblioteca padrão pra fazer requisições HTTP. Busca páginas como se fosse seu navegador.

- BeautifulSoup: O canivete suíço pra analisar HTML e XML. Permite buscar, filtrar e extrair dados fácil.

- Scrapy: Framework completo pra scraping e crawling em larga escala.

- Selenium: Automatiza navegadores pra extrair dados de sites dinâmicos e cheios de JavaScript.

- Outros:

lxmlpra parsing rápido,pandaspra manipular dados ePlaywrightpra automação moderna de browsers.

Quando usar cada um?

- Requests + BeautifulSoup: Ideais pra páginas estáticas e projetos menores.

- Scrapy: Perfeito pra navegar por várias páginas, lidar com paginação e exportar grandes volumes de dados.

- Selenium/Playwright: Use quando precisar interagir com JavaScript ou simular ações de usuário.

Começando: Preparando o Ambiente de Web Scraping em Python

Vamos deixar tudo pronto. Mesmo pra quem nunca mexeu com Python, o processo é tranquilo:

-

Instale o Python: Baixe a versão 3.x em . Lembre de adicionar ao PATH do sistema.

-

Crie um ambiente virtual: Assim as dependências do projeto ficam organizadas.

1python3 -m venv venv 2# Ativar: 3# No Windows: 4venv\Scripts\activate 5# No Mac/Linux: 6source venv/bin/activate -

Instale as bibliotecas:

1pip install requests beautifulsoup4 scrapy selenium -

Organização do projeto: Pra scripts simples, um arquivo

.pyjá resolve. Pra Scrapy, usescrapy startproject meu_projetopra criar a estrutura. -

Teste seu ambiente:

1import requests, bs4, scrapy, selenium 2print("Todas as bibliotecas importadas com sucesso!") -

Defina um User-Agent (recomendado): Alguns sites bloqueiam "Python-requests". Imite um navegador:

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

Pronto, já dá pra começar a raspar dados!

Analisando HTML com BeautifulSoup: Seu Primeiro Raspador Web em Python

Vamos criar um raspador simples juntos. Vamos buscar frases e autores em — um site feito pra treinar scraping.

Passo 1: Inspecionando a Estrutura do Site

- Abra o site no Chrome.

- Clique com o botão direito em uma frase e selecione “Inspecionar”.

- Cada frase está em

<div class="quote">, com o texto em<span class="text">e o autor em<small class="author">.

Passo 2: Escrevendo e Executando o Raspador

Olha só um exemplo básico:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"Falha na requisição: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")Dicas pra evitar dor de cabeça:

- Se um elemento não existir, confira se não é

Noneantes de usar.get_text(). - Sempre revise seus seletores no navegador.

Escalando: Otimizando o Web Scraping em Python com Scrapy

Quando a missão passa de “só essa página” pra “o site inteiro e todas as subpáginas”, é hora de usar o Scrapy.

- Arquitetura: Scrapy usa “spiders” (classes que definem como navegar e extrair), pipelines (pra processar dados) e requisições assíncronas pra ganhar velocidade.

- Por que usar Scrapy? Ele foi feito pra escala — coleta milhares de páginas, lida com erros e exporta dados pra CSV/JSON sem complicação.

Quando Usar Scrapy em vez de BeautifulSoup

- Precisa navegar por muitas páginas ou seguir links automaticamente.

- Quer suporte nativo pra tentativas, controle de velocidade e pipelines de dados.

- Vai rodar o raspador com frequência ou compartilhar com o time.

Scrapy na Prática: Exemplo de Projeto

Veja um spider que coleta todas as frases de todas as páginas:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)Execute com:

1scrapy crawl quotes -O quotes.jsonE pronto, você vai ter um arquivo JSON com todos os dados — sem precisar de laços manuais.

Quando o projeto cresce, a arquitetura e velocidade do Scrapy fazem dele a melhor escolha pra extração de dados em grande escala.

Thunderbit: Ferramentas de IA que Potencializam o Web Scraping em Python

Vamos falar a real: mesmo com Python, scraping pode ser trabalhoso — principalmente em sites dinâmicos, com subpáginas ou layouts que mudam toda hora. É aí que entra o .

Thunderbit é uma extensão do Chrome com IA que permite raspar sites em só dois cliques:

- Sugestão de Campos por IA: A IA lê a página e já sugere as melhores colunas pra extrair (tipo “Nome do Produto”, “Preço” etc.).

- Raspar: Clicou de novo e o Thunderbit coleta tudo — lida com paginação, subpáginas e até rolagem infinita.

Por que eu indico o Thunderbit:

- Sem código: Perfeito pra analistas e profissionais de negócios.

- Lida com sites complexos: Conteúdo dinâmico, subpáginas e mudanças de layout? A IA resolve.

- Exportação instantânea: Jogue os dados direto pro Excel, Google Sheets, Airtable ou Notion.

- Raspagem de subpáginas: Precisa de detalhes de cada produto ou perfil? O Thunderbit visita cada subpágina e preenche sua tabela sozinho.

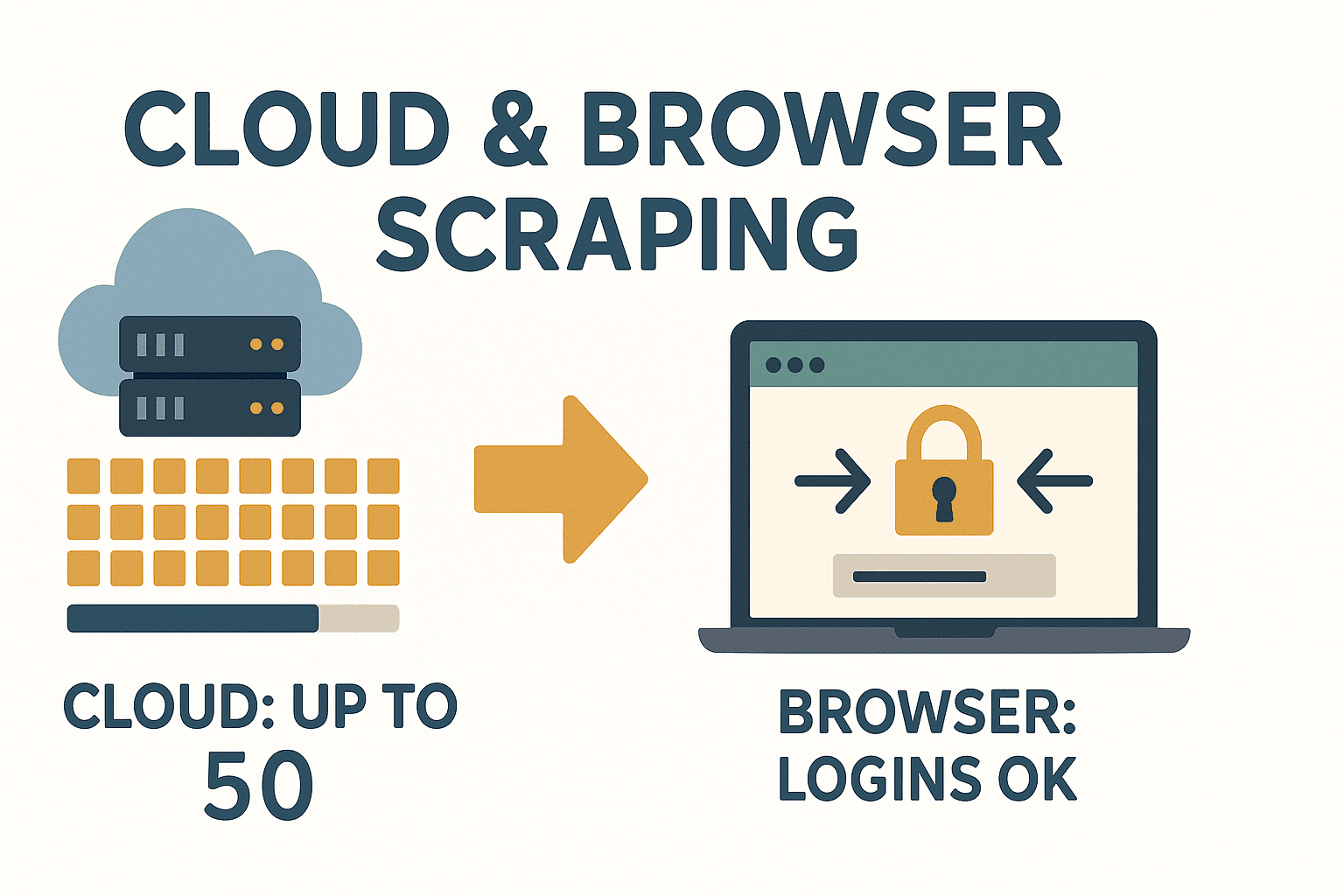

- Modo nuvem ou navegador: Raspe até 50 páginas de uma vez na nuvem, ou use o navegador pra sites que pedem login.

Thunderbit é um divisor de águas pra quem precisa de dados rápido e não quer ficar mexendo em código toda vez que um site muda.

Thunderbit é um divisor de águas pra quem precisa de dados rápido e não quer ficar mexendo em código toda vez que um site muda.

Quando Usar Ferramentas de IA como o Thunderbit

- Você precisa dos dados pra ontem e não quer depender do TI ou escrever código.

- O site é complicado, dinâmico ou muda sempre.

- Quer que colegas sem conhecimento técnico também possam coletar dados.

- Precisa raspar e enriquecer dados (traduzir, categorizar etc.) de uma vez só.

Thunderbit encaixa certinho no fluxo de trabalho com Python — use pra prototipar rápido, raspar sites difíceis ou quando quiser evitar dor de cabeça com manutenção. Pra saber mais, dá uma olhada no .

Lidando com Conteúdo Dinâmico e Paginação no Web Scraping em Python

Sites modernos usam muito JavaScript, o que pode complicar o scraping. Veja como contornar:

- Conteúdo dinâmico: Se os dados são carregados via JS (e não estão no HTML), use Selenium ou Playwright pra automatizar o navegador, esperar carregar e extrair.

- Paginação: Siga os links de “Próxima” ou incremente o número da página na URL. Scrapy faz isso fácil com o sistema de follow requests.

Exemplo: Paginação com BeautifulSoup

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...extrair frases...

12 page += 1Pra rolagem infinita ou botões “Carregar mais”: Use Selenium pra rolar ou clicar, ou inspecione a aba de rede pra achar APIs que possam ser acessadas via Requests.

Armazenando Dados: Salvando o que Você Raspou para Uso Empresarial

Depois de coletar os dados, é hora de salvar de um jeito útil.

- CSV: Universal, fácil de abrir no Excel/Sheets.

1import csv 2with open('dados.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['nome', 'preco']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel: Use pandas pra exportar rapidinho.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('dados.xlsx', index=False) - Banco de dados: Pra projetos grandes ou contínuos, use SQLite ou PostgreSQL.

1import sqlite3 2conn = sqlite3.connect('dados_raspados.db') 3# ...crie a tabela, insira os dados... 4conn.close()

Escolha o formato que mais combina com seu fluxo de trabalho. Pra compartilhar com o time, Excel ou Google Sheets costuma ser o melhor.

Considerações Legais e Éticas no Web Scraping com Python

Scraping é poderoso, mas pede responsabilidade. Veja como agir certo:

- Raspe só dados públicos: Se precisa de login ou está atrás de paywall, pense duas vezes.

- Confira os Termos de Uso: Alguns sites proíbem scraping. Ignorar pode dar bloqueio ou dor de cabeça jurídica ().

- Respeite o robots.txt: Não é lei, mas é boa prática.

- Evite dados pessoais: Leis como GDPR e CCPA proíbem coletar nomes, e-mails ou telefones sem consentimento.

- Não sobrecarregue servidores: Coloque intervalos, limite a frequência e prefira horários de pouco acesso.

Checklist rápido de conformidade:

- Leia os Termos de Uso e o robots.txt do site.

- Evite dados pessoais ou sensíveis.

- Cite as fontes dos dados.

- Seja educado: não sobrecarregue o servidor.

Pra mais dicas legais, veja .

Dicas e Boas Práticas para Web Scraping Confiável em Python

Nem sempre o scraping é tranquilo. Veja como driblar os perrengues:

- Erros HTTP (403, 404, 429): Use um User-Agent realista, diminua a velocidade das requisições e trate erros com carinho.

- IPs bloqueados: Use proxies ou alterne IPs em grandes volumes — mas sempre pense na ética.

- CAPTCHAs: Se aparecer, pense se vale a pena continuar. Existem serviços pra resolver, mas é uma área cinzenta.

- Mudanças no site: Use seletores robustos, confira se elementos existem e envolva o código em try/except.

- Problemas de codificação: Sempre use UTF-8 e teste a saída no Excel ou Sheets.

Boas práticas:

- Registre cada etapa — assim você descobre onde algo quebrou.

- Refaça tentativas com backoff em caso de falha.

- Teste o raspador em poucas páginas antes de escalar.

- Monitore a saída — se o número de itens cair, algo mudou.

E se cansar de consertar raspadores toda vez que um site muda, lembra: o usa IA pra se adaptar automaticamente a mudanças de layout.

A abordagem com IA do Thunderbit deixa você focar nos insights, não na manutenção.

Conclusão & Principais Aprendizados

Web scraping em Python é um superpoder pra empresas — transforma o caos da web em dados organizados e prontos pra uso. Resumindo:

- Python é a melhor escolha pra web scraping, por causa da sintaxe clara e bibliotecas poderosas.

- Requests + BeautifulSoup são ideais pra tarefas pequenas e estáticas; Scrapy é a ferramenta pra crawling automatizado em larga escala.

- Thunderbit traz IA pro jogo, deixando o scraping acessível pra todo mundo — sem código, sem dor de cabeça, só dados.

- Lide com conteúdo dinâmico e paginação usando Selenium ou recursos nativos do Scrapy.

- Armazene seus dados em CSV, Excel ou bancos de dados — o que for melhor pro seu negócio.

- Seja legal e ético: Raspe dados públicos, respeite as regras do site e evite informações pessoais.

- Construa raspadores robustos: Registre, refaça tentativas e monitore mudanças. Ou deixe a IA do Thunderbit cuidar disso pra você.

Pronto pra começar? Tente criar seu primeiro raspador em Python — ou, se quiser pular o código, e veja como é fácil extrair dados da web. Pra mais dicas e conteúdos, acesse o .

Perguntas Frequentes

1. Web scraping em Python é legal?

É permitido coletar dados públicos, desde que você respeite os termos de uso do site, o robots.txt e leis de privacidade como a GDPR. Evite informações pessoais e sempre confira as regras antes de começar ().

2. Qual a diferença entre BeautifulSoup e Scrapy?

BeautifulSoup é um analisador HTML leve — ótimo pra tarefas pequenas ou páginas únicas. Scrapy é um framework completo pra crawling de muitos sites, paginação e exportação em escala. Use BeautifulSoup pra scripts rápidos e Scrapy pra projetos grandes ().

3. Como lidar com sites pesados em JavaScript no Python?

Use Selenium ou Playwright pra automatizar o navegador, esperar o carregamento do JS e extrair os dados. Ou, se possível, encontre chamadas de API na aba de rede e use Requests.

4. O que diferencia o Thunderbit das bibliotecas de scraping em Python?

Thunderbit usa IA pra sugerir campos, lidar com subpáginas e se adaptar a mudanças de layout — sem código. É perfeito pra equipes que querem dados rápidos, sem dor de cabeça de manutenção ().

5. Como armazenar e compartilhar dados raspados com a equipe?

Exporte pra CSV ou Excel pra compartilhar fácil, ou use pandas pra salvar em bancos de dados em projetos maiores. O Thunderbit permite exportar direto pra Google Sheets, Airtable, Notion ou baixar como CSV/Excel de graça.

Boas raspagens — e que seus dados estejam sempre limpos, organizados e prontos pra uso.