A web está se expandindo numa velocidade impressionante e, se você trabalha com negócios, tecnologia ou é simplesmente fissurado por dados como eu, já percebeu: o verdadeiro ouro está nos dados que você consegue coletar—não só nos que aparecem na tela. Hoje em dia, empresas estão numa corrida para automatizar a coleta de dados online, e o mercado global de raspagem de dados deve bater . Olha só: mais de já usam rastreadores ou raspadores web para turbinar suas soluções de IA, análises e automações.

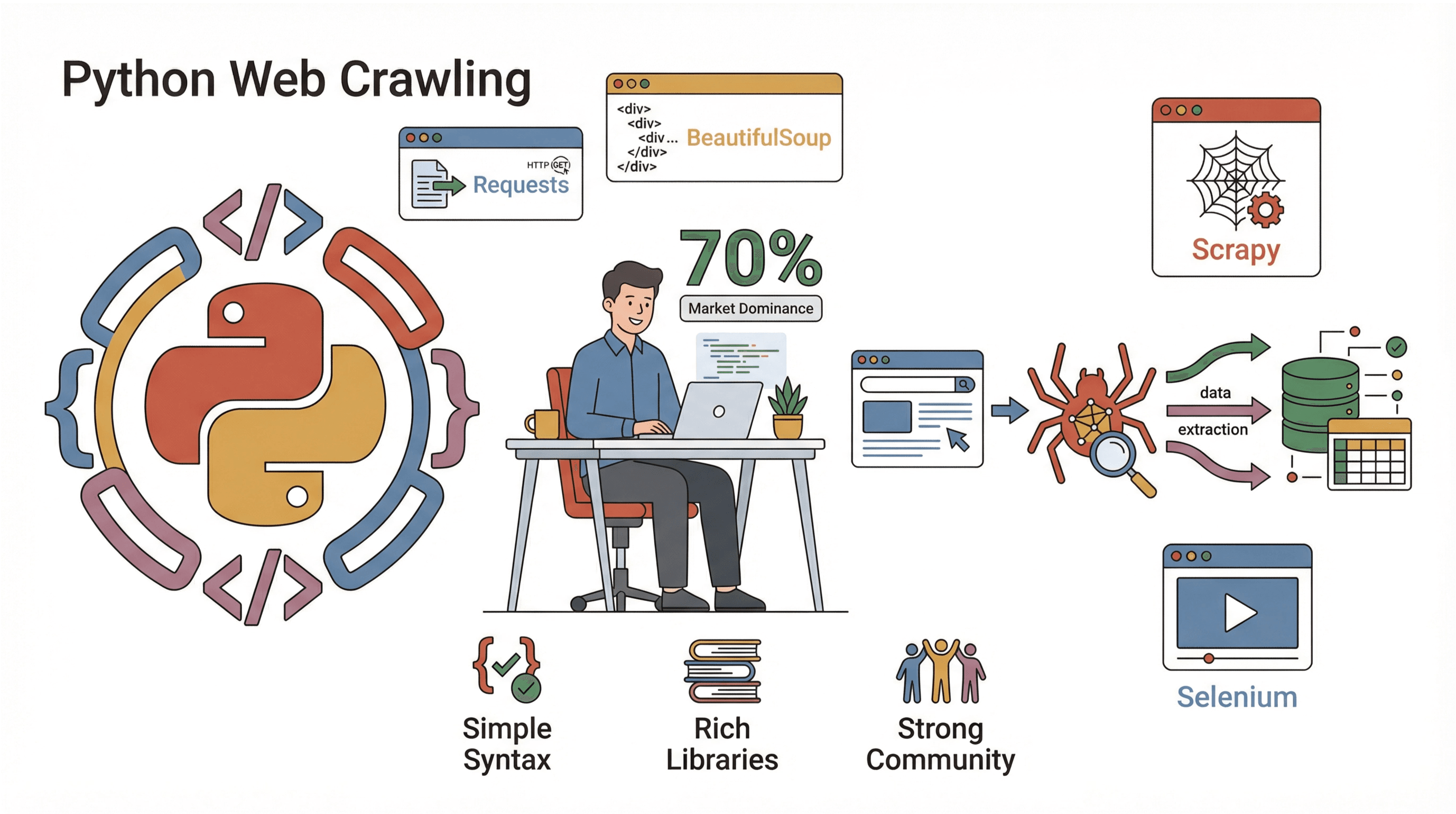

Mas como surfar nessa onda? Para a maioria, a resposta é Python. É a linguagem queridinha para criar rastreadores de sites—simples, poderosa e cheia de bibliotecas que facilitam tudo. Neste guia, vou te mostrar o que é um rastreador de sites, por que Python é a melhor escolha, como criar o seu passo a passo e como ferramentas como o podem deixar tudo ainda mais fácil (principalmente se você prefere clicar do que programar). Seja você dev, profissional de marketing que ama dados ou só quer automatizar tarefas chatas, aqui tem dicas para turbinar sua coleta de dados online.

O que é um Rastreadores de Sites? (E Por Que Isso Importa?)

Resumindo: um rastreadores de sites é um programa que navega automaticamente pela web, visitando páginas, seguindo links e (se quiser) coletando dados pelo caminho. Imagina um super navegador que nunca dorme, não se cansa e nunca fecha a aba errada. Rastreadores são a base dos buscadores (tipo o Googlebot), mas também são usados por empresas para monitorar preços, fazer pesquisa de mercado e muito mais.

Mas qual a diferença entre crawling e scraping? Crawling é o processo de descobrir e navegar pelas páginas (tipo mapear uma cidade), enquanto scraping é extrair dados específicos dessas páginas (como pegar todos os cardápios de restaurantes da cidade). Na prática, a maioria dos projetos faz os dois: rastreia para achar as páginas e raspa para pegar os dados que interessam ().

Exemplos reais de uso de rastreadores em negócios:

- Geração de leads: Coleta automática de contatos em diretórios ou redes sociais.

- Monitoramento de preços: Acompanhe preços e estoques dos concorrentes em milhares de produtos.

- Monitoramento de conteúdo: Receba alertas quando sua marca for citada em notícias, blogs ou fóruns.

- Auditoria de SEO: Analise seu próprio site em busca de links quebrados ou metadados faltando.

- Pesquisa de mercado: Junte anúncios de imóveis, vagas de emprego ou avaliações de produtos para análise.

Se você já quis se multiplicar para dar conta de tanta pesquisa online, um rastreador é seu melhor amigo.

Por Que Rastreadores de Sites São Essenciais para Automação Empresarial

Vamos ao que interessa: por que as empresas estão apostando em rastreadores e raspadores? Porque o retorno é gigante. Olha como diferentes equipes usam rastreadores—e o que ganham com isso:

| Caso de Uso | Benefício Principal | Quem Usa |

|---|---|---|

| Geração de Leads | Automatiza a criação de listas de prospects, economiza horas | Vendas, Recrutamento |

| Monitoramento de Preços | Insights em tempo real sobre concorrentes, precificação dinâmica | E-commerce, Produtos |

| Monitoramento de Conteúdo | Proteção de marca, identificação de tendências | Marketing, Relações Públicas |

| Auditoria de SEO | Saúde do site, melhora no ranqueamento | SEO, Webmasters |

| Pesquisa de Mercado | Dados atualizados e em grande escala para análise | Analistas, Pesquisadores |

Um case mostrou que automatizar uma tarefa semanal de coleta de dados (raspando 5-7 sites) economizou mais de 50 horas por ano de um único funcionário—multiplica isso por uma equipe e fica claro por que depois de adotar rastreadores.

Python: A Melhor Opção para Criar um Rastreadores de Sites

Por que Python reina absoluto no mundo do web crawling? Três motivos principais:

Por que Python reina absoluto no mundo do web crawling? Três motivos principais:

- Facilidade: A sintaxe do Python é clara, amigável para quem está começando e permite criar rastreadores funcionais com poucas linhas de código.

- Ecossistema de bibliotecas: Python tem uma variedade de bibliotecas para cada etapa—buscar páginas, analisar HTML, lidar com JavaScript e muito mais.

- Comunidade: Com quase usando Python, tem uma comunidade gigante, muitos tutoriais e respostas para quase tudo.

Principais bibliotecas Python para web crawling:

- Requests: O jeito mais simples de buscar páginas web (HTTP GET/POST).

- BeautifulSoup: Perfeito para analisar HTML e encontrar elementos.

- Scrapy: Framework completo para projetos grandes.

- Selenium: Automatiza navegadores para raspar sites cheios de JavaScript.

Comparado a outras linguagens (tipo Java ou C#), Python te leva da ideia ao rastreador funcionando em muito menos tempo. E se você trabalha com dados, pode jogar o resultado direto no Pandas para análise—sem dor de cabeça com exportação/importação.

Comparando Métodos de Extração: Regex vs. BeautifulSoup vs. Scrapy

Na hora de extrair dados das páginas, você tem opções. Olha só como os principais métodos se comparam:

| Método | Como Funciona | Vantagens 🟢 | Desvantagens 🔴 | Melhor Para |

|---|---|---|---|---|

| Regex | Busca padrões no HTML bruto | Rápido para padrões simples e conhecidos | Frágil, quebra se o HTML mudar | Hacks rápidos, extrair URLs |

| BeautifulSoup | Analisa HTML em árvore, busca por tags | Fácil, flexível, lida com HTML bagunçado | Mais lento em páginas grandes, lógica manual | Scripts de raspagem pequenos/médios |

| Scrapy | Framework completo, parsing CSS/XPath | Rápido, escalável, faz crawling e parsing | Curva de aprendizado maior, mais configuração | Rastreadores grandes e profissionais |

- Regex é tipo usar um detector de metais na praia—rápido, mas você pode perder algo se a areia mudar.

- BeautifulSoup é como ter um mapa e uma pá—você cava onde quiser, mas precisa andar pela praia.

- Scrapy é como levar uma equipe com caminhões e GPS—exagero para uma caixa de areia, mas imbatível para grandes operações.

Se está começando, recomendo Requests + BeautifulSoup. Assim você aprende o básico e pode migrar para o Scrapy quando quiser escalar.

Passo a Passo: Como Criar um Rastreadores de Sites Simples em Python

Bora colocar a mão na massa? Vamos criar um rastreador básico que visita páginas, segue links e coleta dados. Vou explicar cada etapa, com código para você adaptar.

Passo 1: Preparando o Ambiente Python

Primeiro, garanta que você tem Python 3.10+ instalado. (Confira com python --version.) Recomendo criar um ambiente virtual para o projeto:

1python -m venv venv

2source venv/bin/activate # No Windows: venv\Scripts\activateDepois, instale as bibliotecas necessárias:

1pip install requests beautifulsoup4Pronto! Abra seu editor de código favorito e bora programar.

Passo 2: Escrevendo Seu Primeiro Script de Rastreadores de Sites

Vamos começar buscando uma página. Olha um exemplo simples:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # Erro se não for 200 OK

5 print(response.text[:500]) # Mostra os 500 primeiros caracteres

6crawl_page("https://www.scrapingcourse.com/ecommerce/")Você vai ver um pedaço do HTML no console—prova de que está conversando com a web.

Passo 3: Seguindo Links e Coletando Mais Dados

Agora, vamos fazer o rastreador seguir links e visitar várias páginas. Vamos manter uma lista de URLs a visitar e um conjunto de URLs já visitados (para evitar loops):

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # Limite de segurança

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Falha ao acessar {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Rastreado: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)Esse script vai rastrear até 20 páginas, seguindo links dentro do mesmo site. Você vai ver cada URL conforme for visitada.

Passo 4: Extraindo Dados das Páginas

Suponha que você queira coletar nomes e preços de produtos em cada página. Veja como fazer:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ... (igual ao anterior)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ... (restante da lógica)

18# Salvar em CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Raspados {len(product_data)} produtos.")Agora você tem um arquivo CSV com todos os produtos coletados—pronto para análise, upload ou para mostrar pra galera.

Passo 5: Depurando e Otimizando Seu Rastreadores

Fazer um rastreador funcionar é uma coisa; deixar ele robusto é outra. Algumas dicas de quem já passou por uns perrengues:

- Defina um User-Agent: Alguns sites bloqueiam "Python-requests" por padrão. Finja ser um navegador:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - Trate erros com carinho: Use try/except para pular páginas quebradas ou bloqueadas.

- Evite loops infinitos: Sempre registre URLs visitadas e defina um limite de páginas.

- Diminua o ritmo: Adicione

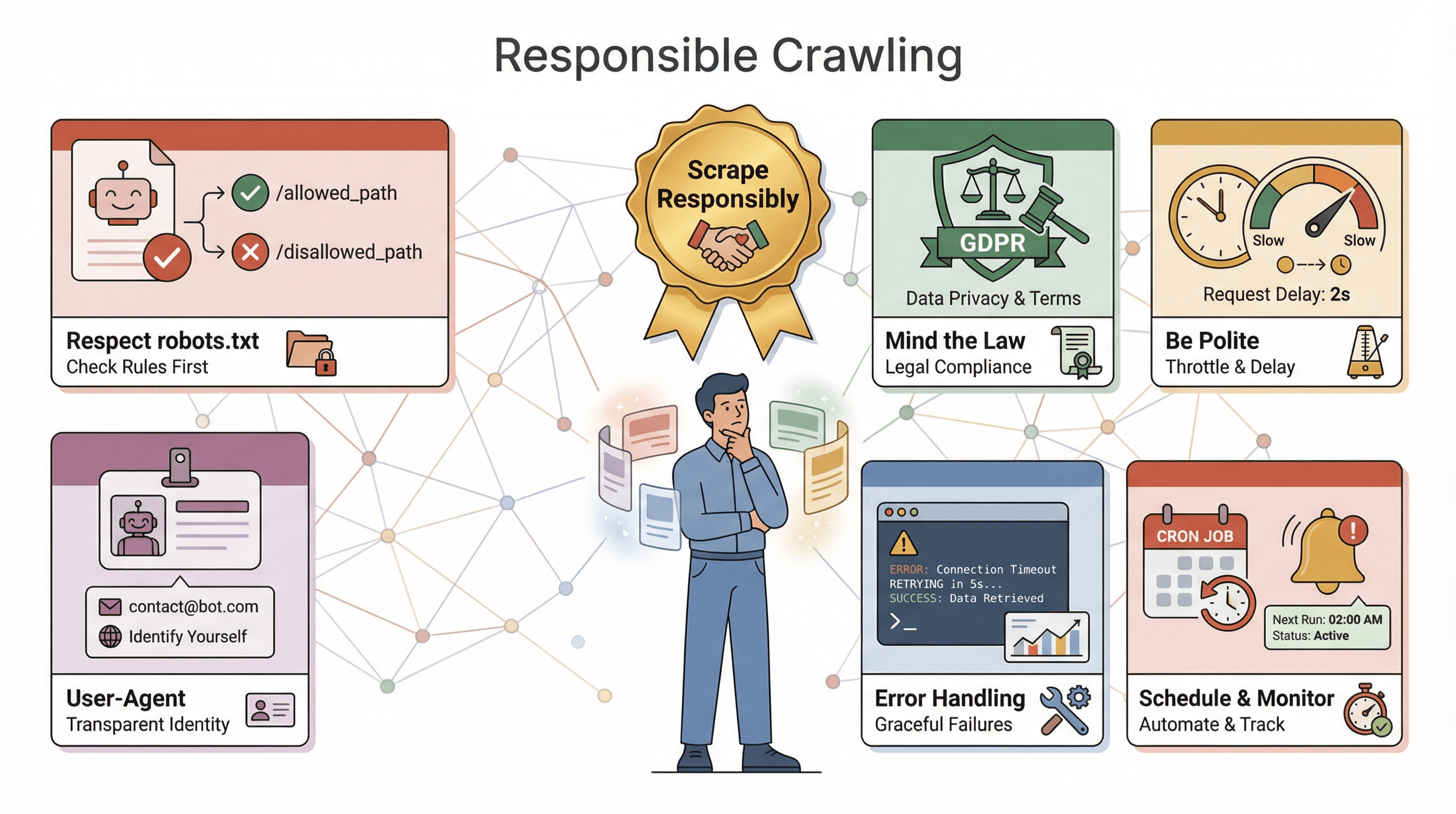

time.sleep(1)entre as requisições para evitar bloqueios. - Respeite o robots.txt: Sempre siga as regras de rastreamento do site ().

- Registre seu progresso: Imprima ou registre cada URL rastreada—isso ajuda muito na depuração.

Se seu rastreador for bloqueado, retornar conteúdo estranho ou faltar dados, revise os headers, diminua o ritmo e veja se não está batendo em proteções anti-bot.

Thunderbit: Facilitando o Rastreio de Sites com IA

Agora, vamos falar do “botão fácil” do web crawling: . Por mais que eu curta Python, às vezes você só quer os dados—sem ter que configurar, depurar ou manter scripts. O Thunderbit é um Raspador Web IA para Chrome que permite extrair dados de qualquer site em poucos cliques.

O que faz o Thunderbit ser diferente?

- Sugestão de campos por IA: A IA do Thunderbit analisa a página e sugere quais dados podem ser extraídos—sem precisar inspecionar HTML ou criar seletores.

- Sem código, direto no navegador: Funciona no seu navegador, inclusive em sites com login e páginas dinâmicas em JavaScript.

- Raspagem de subpáginas: Precisa de mais detalhes? O Thunderbit pode visitar automaticamente subpáginas (tipo detalhes de produtos) e enriquecer sua tabela.

- Exportação instantânea: Exporte seus dados para Excel, Google Sheets, Airtable ou Notion—sem dor de cabeça com CSV.

- Raspagem na nuvem ou local: Escolha entre raspagem rápida na nuvem (para sites públicos) ou modo navegador (para sites com login ou mais complexos).

- Agendamento: Programe raspagens automáticas—sem precisar de servidores ou cron jobs.

Para quem trabalha com negócios, o Thunderbit é revolucionário. Você vai do “preciso desses dados” ao “tá aqui minha planilha” em minutos. E se você é dev, o Thunderbit pode complementar seus scripts—use para tarefas rápidas ou como backup quando seu código precisar de um respiro.

Quer ver na prática? e experimente raspar seu site favorito. O plano gratuito permite raspar algumas páginas, e os planos pagos começam em só US$ 15/mês para 500 créditos.

Pontos Importantes ao Criar um Rastreadores de Sites em Python

Antes de soltar seu rastreador por aí, algumas dicas de ouro (e responsabilidade):

Antes de soltar seu rastreador por aí, algumas dicas de ouro (e responsabilidade):

- Respeite o robots.txt: A maioria dos sites publica um arquivo

robots.txtcom as regras para rastreadores. Ignorar pode dar bloqueio—ou até dor de cabeça jurídica. Sempre confira e siga essas orientações (). - Atenção à legislação: Alguns sites proíbem raspagem nos termos de uso. E se você coletar dados pessoais, leis como GDPR e CCPA podem se aplicar (). Em caso de dúvida, foque em dados públicos e não sensíveis.

- Seja educado: Não sobrecarregue sites com requisições—diminua o ritmo, varie os intervalos e evite horários de pico.

- Identifique-se: Use um User-Agent personalizado e, se for fazer raspagens em larga escala, inclua um contato.

- Trate erros e registre tudo: Espere mudanças nos sites, páginas quebradas e dados bagunçados. Implemente tratamento de erros, logs e monitoramento para corrigir rápido.

- Agende e monitore: Para raspagens regulares, use ferramentas de agendamento (como cron ou o agendador do Thunderbit) e configure alertas caso seu rastreador falhe ou não colete dados.

A regra de ouro: raspe com responsabilidade. A web é de todo mundo—não seja “aquele bot” que atrapalha geral.

Dicas Avançadas: Escalando e Aprimorando Seu Rastreadores de Sites em Python

Depois de dominar o básico, você pode querer ir além. Olha algumas estratégias avançadas:

- Lide com JavaScript: Use Selenium ou Playwright para raspar sites que carregam dados dinamicamente.

- Escale: Para grandes volumes, migre para Scrapy ou use bibliotecas assíncronas (tipo

aiohttp) para requisições simultâneas. - Use proxies: Alterne endereços IP para evitar bloqueios em raspagens de alto volume.

- Automatize pipelines de dados: Escreva direto em bancos de dados ou integre com armazenamento em nuvem para grandes volumes.

- Monitore e alerte: Implemente logs, checagens de saúde e notificações para rastreadores que rodam por muito tempo.

Se seu rastreador virar peça-chave, pense em serviços gerenciados ou APIs para facilitar a manutenção. E se for raspar vários sites com layouts diferentes, modularize seu código para atualizar os parsers sem dor.

Conclusão & Principais Aprendizados

Construir um rastreadores de sites em Python é uma das skills mais valiosas no mundo movido a dados de hoje. Resumindo o que rolou:

- Rastreadores de sites automatizam a visita e extração de dados de páginas web—essencial para automação, pesquisa e inteligência competitiva.

- Python é a escolha número um graças à sua sintaxe simples, bibliotecas poderosas e comunidade ativa.

- Métodos de parsing importam: use regex para tarefas rápidas, BeautifulSoup para a maioria dos scripts e Scrapy para grandes projetos.

- Passo a passo, você pode ir de buscar uma página a rastrear um site inteiro e salvar dados estruturados—sem precisar ser PhD.

- Thunderbit vai além, permitindo raspar dados com IA, sem código e com exportação instantânea—perfeito para negócios ou quem quer resultado rápido.

- Raspagem responsável é fundamental: respeite as regras dos sites, trate erros e sempre priorize a ética.

- Escalar é possível com as ferramentas certas—seja Selenium para JavaScript, Scrapy para concorrência ou Thunderbit para automação sem código.

A melhor forma de aprender é começar pequeno—escreva um script, teste o Thunderbit e descubra que dados você pode acessar. A web é seu buffet de dados (ou sua ostra, se preferir).

Quer se aprofundar? Olha esses recursos:

- para mais dicas, tutoriais e técnicas avançadas.

Boas raspagens—que seus raspadores sejam rápidos, seus dados limpos e o café nunca falte.

Perguntas Frequentes

1. Qual a diferença entre um rastreadores de sites e um raspador web?

Um rastreador visita e descobre páginas sistematicamente (tipo mapear um site), enquanto um raspador extrai dados específicos dessas páginas. Na prática, a maioria dos projetos usa os dois: rastreia para achar páginas, raspa para pegar os dados.

2. Por que Python é tão popular para criar rastreadores de sites?

Python é fácil de aprender, tem bibliotecas poderosas (Requests, BeautifulSoup, Scrapy, Selenium) e uma comunidade gigante. Quase 70% dos projetos de raspagem usam Python, então virou padrão do mercado.

3. Quando usar regex, BeautifulSoup ou Scrapy para parsing?

Use regex para padrões simples e previsíveis. BeautifulSoup é ideal para a maioria dos scripts—fácil e flexível. Scrapy é perfeito para rastreadores grandes ou profissionais que precisam de velocidade, concorrência e recursos robustos.

4. Como o Thunderbit se compara a programar um rastreador em Python?

O Thunderbit permite raspar dados com IA e sem código—basta clicar, selecionar campos e exportar. É perfeito para negócios ou tarefas rápidas. Python dá mais controle e personalização, mas exige programação e manutenção.

5. Quais questões legais ou éticas devo considerar ao rastrear sites?

Sempre confira e respeite o robots.txt, siga os termos de uso do site, evite coletar dados sensíveis ou pessoais sem consentimento e diminua o ritmo das requisições para não sobrecarregar servidores. Raspagem responsável mantém a web acessível para todos.

Pronto para testar? ou abra seu editor Python favorito e comece a rastrear. Os dados estão aí—vai lá buscar!

Saiba Mais