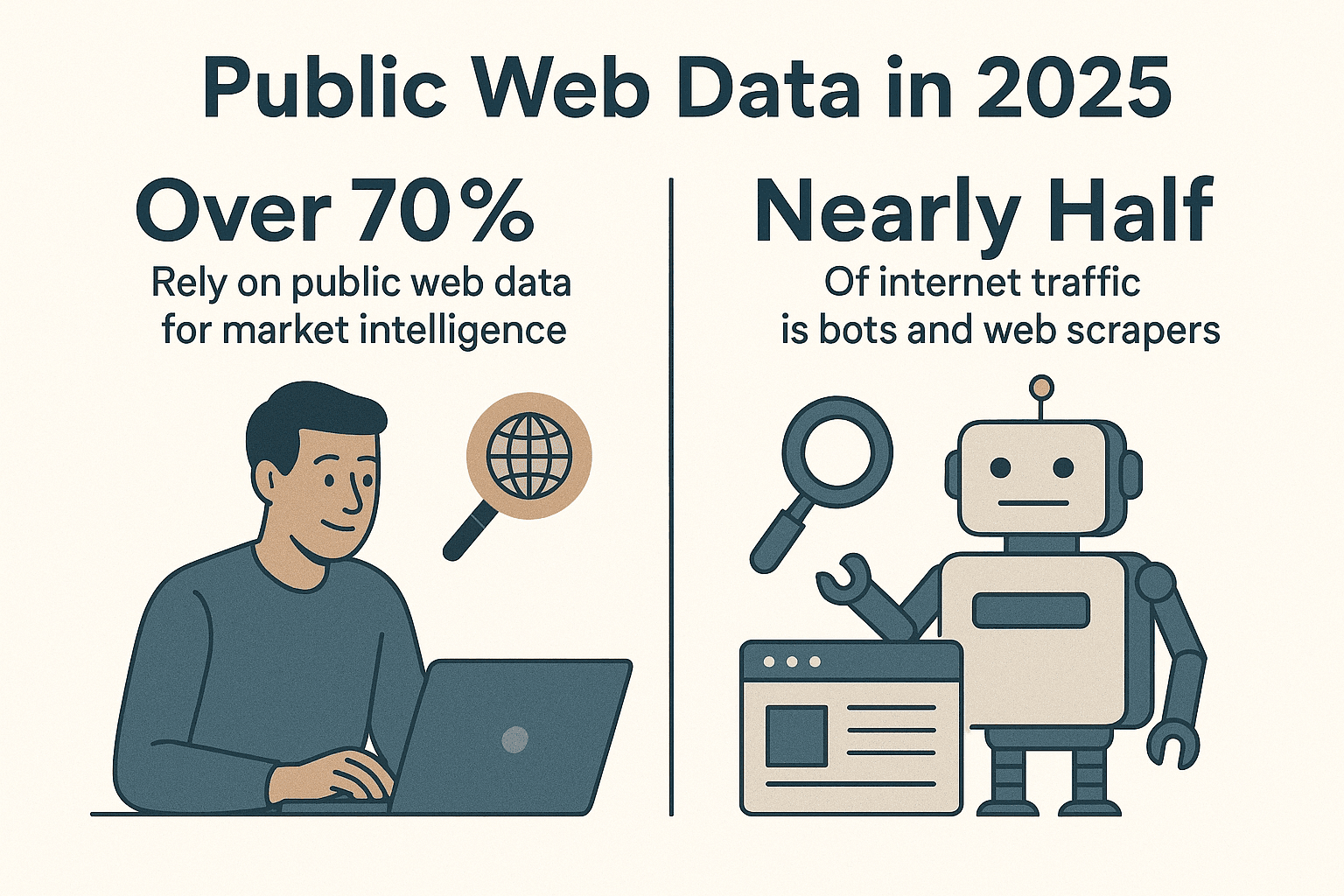

A internet é um verdadeiro mar de dados, e as empresas estão numa disputa acirrada para transformar esse caos em informação útil. Hoje em dia, mais de , e quase metade do tráfego online já vem de bots e raspadores, não de pessoas de verdade (). Depois de anos criando ferramentas de automação (e, sim, alguns spiders que já rodaram mais do que eu mesmo), posso garantir: se você ainda não está usando um spider web em Python para automatizar a coleta de dados, está deixando muita produtividade na mesa.

Python virou a linguagem queridinha para raspagem de dados, e não é por acaso. Seja você de vendas, marketing, operações ou pesquisa, um spider web bem feito em Python pode economizar horas do seu tempo e revelar insights que seriam impossíveis de outro jeito. Neste guia, vou te mostrar como criar um spider web eficiente do zero, compartilhar minhas bibliotecas favoritas e boas práticas, além de apresentar como ferramentas como o podem turbinar seu fluxo de trabalho—principalmente quando você se depara com sites dinâmicos que fazem até programador experiente pensar em largar tudo.

Por que Python é a escolha certa para criar um Spider Web?

Vamos direto ao ponto: Python reina absoluto no mundo da raspagem de dados. Segundo dados recentes, quase , superando JavaScript e outras linguagens. Em 2024, Python até passou o JavaScript como linguagem mais popular no GitHub (), muito por conta da sua força em ciência de dados e automação.

Por que Python é tão bom para spiders web?

- Sintaxe simples e direta: O código em Python é fácil de ler e entender, ótimo tanto para quem está começando quanto para quem já tem experiência.

- Ecossistema de bibliotecas: Ferramentas como , , , e cobrem tudo: desde buscar páginas até interpretar HTML e automatizar navegadores.

- Comunidade gigante: Se pintar algum problema, tem uma galera pronta pra ajudar, além de tutoriais e exemplos pra todo tipo de situação.

- Flexibilidade: Com Python, dá pra criar desde scripts simples até spiders robustos que rastreiam milhares de páginas.

Comparando com outras linguagens, Python oferece o equilíbrio perfeito entre poder e facilidade. JavaScript (Node.js) é ótimo pra conteúdo dinâmico, mas seu modelo assíncrono pode ser complicado pra quem está começando. Java e C# são robustos, mas exigem mais código. Python deixa você focar no que interessa: os dados.

Preparando o Terreno para seu Spider Web em Python

Antes de começar a tecer sua teia, é importante montar um ambiente redondo. Veja como costumo organizar meus projetos:

1. Instale o Python 3

Baixe a versão mais recente do Python 3.x em ou use o gerenciador de pacotes do seu sistema. Certifique-se de que python ou python3 está disponível no terminal.

2. Crie um Ambiente Virtual

Isole as dependências do projeto com um ambiente virtual:

1python3 -m venv .venv

2# No Unix/Mac

3source .venv/bin/activate

4# No Windows

5.venv\Scripts\activateAssim, seus pacotes ficam organizados e sem bagunça.

3. Instale as Bibliotecas Essenciais

Com o ambiente virtual ativado, instale as principais bibliotecas:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemyO que cada uma faz:

- Requests: Faz requisições HTTP para buscar páginas.

- BeautifulSoup: Interpreta e navega pelo HTML.

- lxml: Parsing rápido de HTML/XML (usado pelo BeautifulSoup para acelerar).

- Scrapy: Framework completo para raspagem em grande escala.

- Selenium: Automatiza navegadores para lidar com sites dinâmicos e cheios de JavaScript.

- pandas: Limpa e manipula dados.

- SQLAlchemy: Armazena dados em bancos de dados.

Agora você está pronto para criar desde scripts simples até um verdadeiro exército de spiders.

Escolhendo a Biblioteca Ideal para seu Spider Web em Python

Python oferece um verdadeiro cardápio de ferramentas para raspagem. Veja como costumo escolher:

| Biblioteca/Ferramenta | Facilidade de Uso | Velocidade & Escala | Melhor Para |

|---|---|---|---|

| Requests + BeautifulSoup | Muito fácil | Moderada (uma página por vez) | Iniciantes, páginas estáticas, tarefas rápidas |

| Scrapy | Curva de aprendizado maior | Muito rápida (assíncrona, concorrente) | Raspagem em larga escala, sites inteiros |

| Selenium/Playwright | Moderada | Mais lenta (overhead do navegador) | Sites com muito JavaScript, páginas com login |

| aiohttp + asyncio | Moderada (assíncrona) | Muito rápida (várias URLs ao mesmo tempo) | Raspagem de alto volume em páginas estáticas |

| Thunderbit (No-Code) | Mais fácil (IA) | Rápida (nuvem/local) | Quem não programa, sites dinâmicos, resultados rápidos |

Minha dica de ouro:

- Para poucas páginas estáticas, Requests + BeautifulSoup resolve fácil.

- Para centenas ou milhares de páginas, ou se quiser recursos de crawling, Scrapy é a pedida.

- Para páginas que exigem navegador real (scroll infinito, login), Selenium ou Playwright.

- Para “preciso desses dados agora e não quero programar”, salva o dia.

Montando um Spider Web Básico em Python: Passo a Passo

Vamos criar um spider simples para extrair títulos de notícias do Hacker News. É meu “hello world” favorito de raspagem.

1. Buscar a Página Web

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. Interpretar o HTML

1soup = BeautifulSoup(html_content, "html.parser")3. Extrair os Dados

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. Lidar com Paginação

O Hacker News tem um link “More” no fim da página. Veja como seguir para a próxima página:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (extrair artigos como acima)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # Seja educado!

11 else:

12 page_url = None5. Boas Práticas e Tratamento de Erros

- Sempre cheque

response.status_code. - Use

time.sleep()para não sobrecarregar o servidor. - Defina um User-Agent personalizado:

1headers = {"User-Agent": "MyWebSpider/0.1 (+seu_email@exemplo.com)"}

2requests.get(url, headers=headers)Esse spider básico pode ser adaptado para quase qualquer site estático. Para tarefas mais complexas, bora evoluir com o Scrapy.

Levando seu Spider para Outro Nível com Scrapy

Quando a raspagem fica mais pesada, o Scrapy é o próximo passo. Veja como começar:

1. Inicie um Projeto Scrapy

1scrapy startproject myspider2. Crie um Spider

Dentro de myspider/spiders/quotes_spider.py:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. Rode o Spider

1scrapy crawl quotes -o quotes.jsonO Scrapy vai rastrear todas as páginas, gerenciar concorrência, seguir links e exportar seus dados em JSON (ou CSV, XML, etc.)—tudo com pouco código.

Por que curto o Scrapy:

- Suporte nativo a concorrência, limites de taxa e crawling educado

- Respeita robots.txt automaticamente

- Exportação fácil de dados e pipelines para limpeza ou armazenamento

- Escala de poucas páginas a milhões

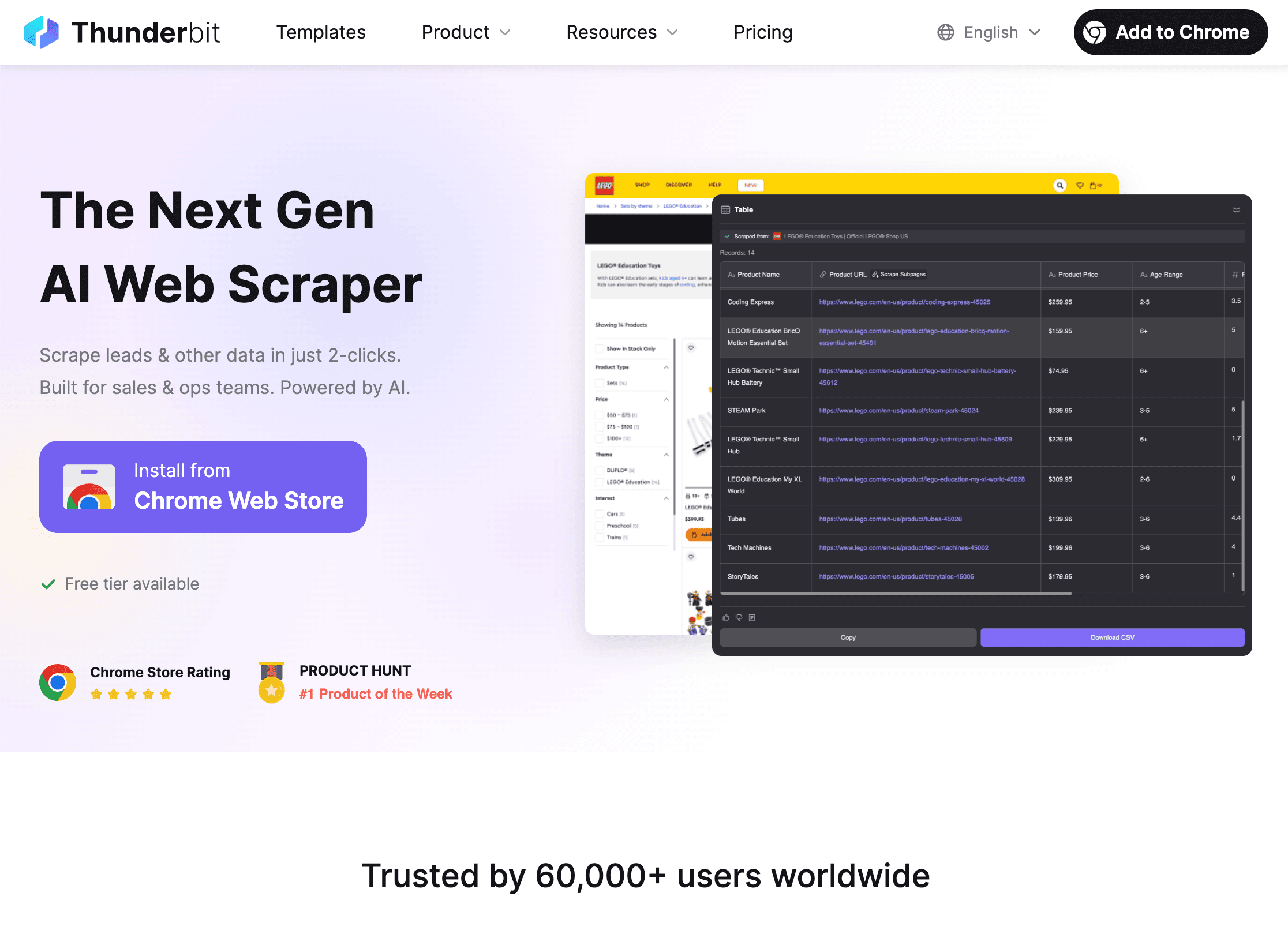

Usando o Thunderbit para Potencializar seu Spider Web em Python

Agora, vamos falar do “elefante na sala”: sites dinâmicos. Por mais que eu goste de Python, alguns sites são um desafio—JavaScript pra todo lado, bloqueios anti-bot ou layouts que mudam toda semana. É aí que entra o .

O que faz o Thunderbit ser diferente?

- Sugestão de Campos por IA: Abra a , clique em “AI Suggest Fields” e a IA do Thunderbit já indica automaticamente quais dados extrair—sem precisar inspecionar HTML ou criar seletores.

- Raspagem de Subpáginas: O Thunderbit segue links para páginas de detalhes (tipo produtos ou perfis) e junta esses dados à sua tabela principal.

- Lida com Conteúdo Dinâmico: Como o Thunderbit roda em um navegador real, ele consegue extrair dados de sites cheios de JavaScript, scroll infinito e até preencher formulários com o AI Autofill.

- Sem Código, Linguagem Natural: Só descrever o que você quer (“Extraia todos os cargos e localizações desta página”) e o Thunderbit faz o resto.

- Exportação Instantânea: Exporte seus dados para CSV, Excel, Google Sheets, Airtable ou Notion—de graça e sem limites.

- Raspagem Agendada: Programe tarefas recorrentes (“todo dia às 9h”) e receba dados atualizados automaticamente.

Como o Thunderbit Completa o Python

Meu fluxo de trabalho favorito é:

- Use o Thunderbit para extrair dados de sites dinâmicos ou complicados—principalmente quando precisa de resultados rápidos ou não quer manter código frágil.

- Exporte os dados em CSV ou Excel.

- Carregue no Python com pandas para limpeza, análise ou automação.

É o melhor dos dois mundos: Thunderbit cuida da extração difícil, Python faz o processamento pesado.

Quando Usar Thunderbit vs. Spider Web em Python

- Thunderbit: Perfeito pra quem não programa, sites dinâmicos, tarefas rápidas ou pra empoderar equipes de negócio a coletar dados sozinhas.

- Python: Melhor pra lógica personalizada, raspagem em grande escala ou quando precisa integrar com outros sistemas.

- Ambos: Use Thunderbit pra extrair, Python pra analisar e automatizar. É tipo “pão com manteiga e geleia”—funcionam bem separados, mas juntos são imbatíveis.

Quer saber mais sobre fluxos híbridos? Dá uma olhada em .

Legalidade e Respeito às Regras dos Sites

Raspagem de dados é poderosa, mas exige responsabilidade (e, às vezes, lidar com administradores de sistemas de cara feia). Veja como agir de forma ética e legal:

1. Respeite o robots.txt

A maioria dos sites publica um arquivo robots.txt dizendo o que pode ser rastreado. Você pode checar isso em Python:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("Raspagem não permitida pelo robots.txt")O Scrapy já respeita o robots.txt por padrão (ROBOTSTXT_OBEY=True).

2. Seja Gente Boa

- Use delays (

time.sleep()ouDOWNLOAD_DELAYdo Scrapy) pra não sobrecarregar servidores. - Defina um User-Agent descritivo com contato.

- Não raspe dados pessoais ou protegidos.

- Se o site bloquear ou pedir pra parar, respeite.

3. Lide com Limites e CAPTCHAs

- Se receber erro 429 (“Muitas Requisições”), diminua a frequência ou use proxies.

- Não tente burlar CAPTCHAs—se aparecer, é hora de parar.

Pra mais dicas sobre ética e conformidade, veja .

Organizando e Armazenando Dados com Python

Depois de extrair os dados, é hora de limpar, transformar e guardar pra análise. Veja como costumo fazer:

1. Limpe e Transforme com pandas

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. Exporte para CSV ou Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. Armazene em Banco de Dados com SQLAlchemy

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)Assim, você constrói um pipeline completo—do spider ao dashboard.

Automatizando Pipelines de Dados

Para tarefas recorrentes, automatize tudo:

- Cron jobs: Agende scripts Python pra rodar diariamente, de hora em hora, etc.

- Apache Airflow: Pra fluxos mais complexos, o Airflow orquestra raspagem, limpeza e relatórios.

- Agendamento Thunderbit: Deixe o Thunderbit cuidar da raspagem agendada e depois acione seu script Python pra processar os dados.

Quer saber mais? Veja .

Dicas para Resolver Problemas e Otimizar seu Spider Web em Python

Mesmo os melhores spiders encaram obstáculos. Veja meu checklist pra problemas comuns:

- Requisições Bloqueadas (403/429): Troque o User-Agent, diminua a velocidade ou use proxies. Confira o robots.txt.

- Dados Faltando: Revise seus seletores. O HTML pode ter mudado.

- Conteúdo Dinâmico: Use Selenium ou Thunderbit pra sites cheios de JavaScript.

- Performance: Use async (aiohttp) ou a concorrência do Scrapy pra mais velocidade. Grave dados aos poucos pra evitar problemas de memória.

- Depuração: Imprima logs, use as ferramentas do navegador e sempre revise os resultados.

Pra mais dicas, veja .

Conclusão & Principais Dicas

Criar um spider web eficiente em Python é uma jornada que traz grandes recompensas em produtividade e qualidade dos dados. Resumindo:

- Python é a melhor escolha pra spiders web, graças à simplicidade, bibliotecas e comunidade.

- Monte seu ambiente com virtualenv e as bibliotecas certas (Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy).

- Escolha a ferramenta ideal pra cada tarefa—scripts simples pra demandas pequenas, Scrapy pra escala, Selenium pra sites dinâmicos, Thunderbit pra raspagem sem código e com IA.

- Escreva spiders limpos e educados que respeitam o robots.txt e as regras dos sites.

- Armazene e processe os dados com pandas e SQLAlchemy, e automatize seu pipeline pra tarefas recorrentes.

- Combine Python e Thunderbit pra máxima flexibilidade—deixe a IA cuidar da extração difícil e use Python pra análise e automação.

Quer dar um salto na sua raspagem de dados? e veja como é fácil extrair dados até dos sites mais chatos. E pra se aprofundar, confira o com mais guias, dicas e exemplos reais.

Boas raspagens—e que seus spiders sempre tragam os dados que você precisa (e nunca fiquem presos em CAPTCHAs).

Perguntas Frequentes

1. Por que Python é a melhor linguagem para criar spiders web?

A sintaxe simples, o vasto ecossistema de bibliotecas (Requests, BeautifulSoup, Scrapy) e a comunidade ativa tornam Python fácil pra começar, escalar e manter spiders web. É amigável pra quem está começando e poderoso pra projetos profissionais.

2. Quando devo usar Thunderbit em vez de programar meu próprio spider em Python?

Thunderbit é ideal pra quem não programa, sites dinâmicos ou cheios de JavaScript, ou quando você precisa de dados rápido sem escrever/manter código. Pra projetos altamente personalizados, em grande escala ou integrados, spiders em Python ainda são a melhor escolha. Muitas equipes usam ambos: Thunderbit pra extração, Python pra análise.

3. Como garantir que meu spider web é legal e ético?

Sempre confira e respeite o robots.txt do site, use crawling educado (delays, user-agent) e evite raspar dados pessoais ou protegidos. Se o site pedir pra parar, pare. Pra mais detalhes, veja .

4. Qual a melhor forma de armazenar e processar os dados extraídos?

Use pandas pra limpar e transformar os dados, exporte pra CSV/Excel pra compartilhar e utilize SQLAlchemy pra guardar em bancos de dados (como SQLite ou PostgreSQL) pra volumes maiores ou tarefas recorrentes.

5. Como automatizar meu pipeline de raspagem de dados?

Use cron jobs ou Apache Airflow pra agendar scripts Python. O Thunderbit também permite raspagem agendada, que pode ser combinada com Python pra um pipeline totalmente automatizado.

Quer mais dicas práticas? Confira e se inscreva no pra tutoriais e demonstrações.