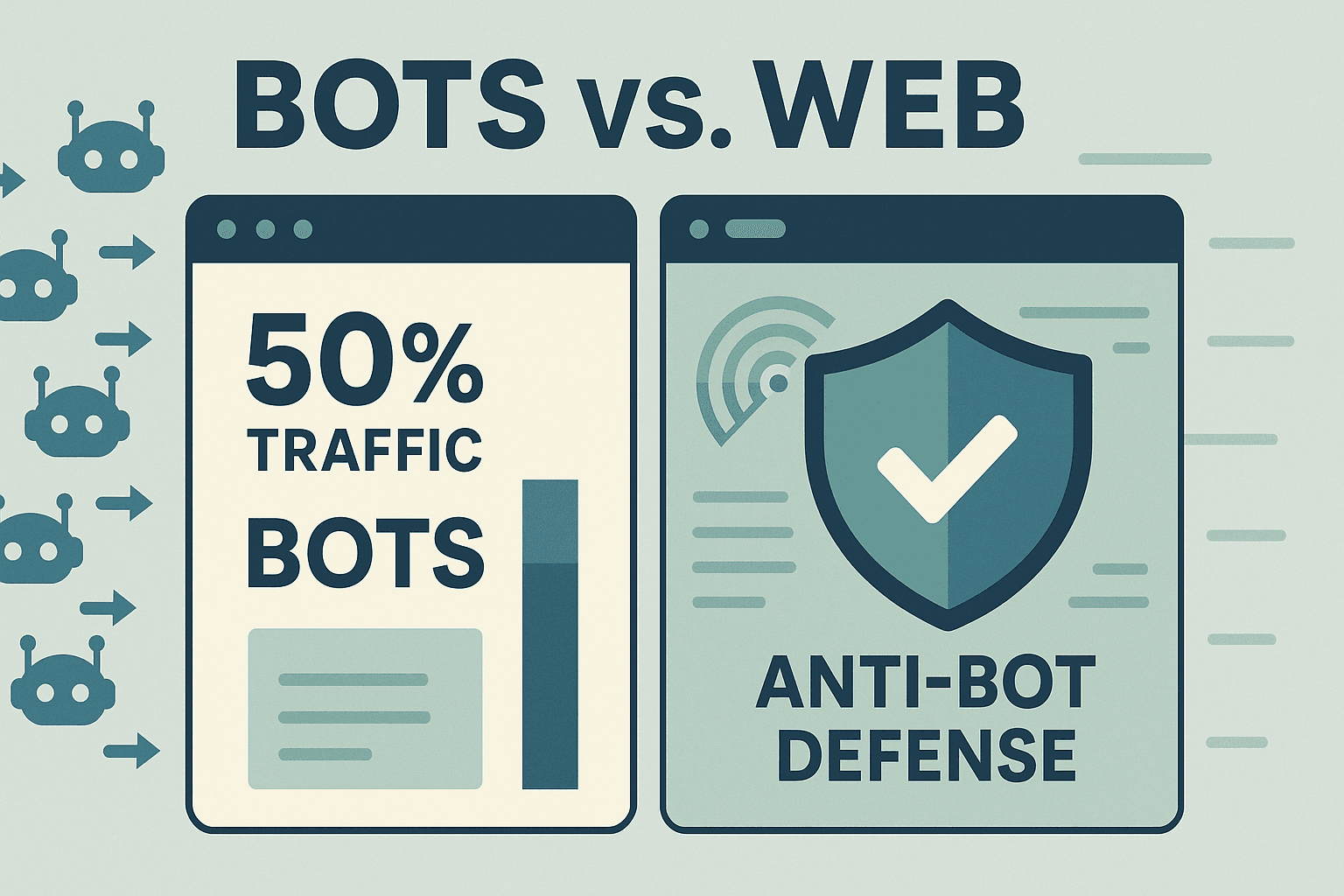

A web em 2025 está mais agitada do que nunca — metade do tráfego já não é de gente de verdade. Isso mesmo: bots já são quase , e os sistemas anti-bot estão cada vez mais espertos. Depois de anos criando automações e fluxos de raspagem, posso garantir: um deslize bobo — tipo escolher o user agent errado — pode acabar com seu projeto de dados. Para quem trabalha com vendas, e-commerce ou operações, ser bloqueado por um site não é só chato; pode significar perder oportunidades, trabalhar com preços desatualizados ou até deixar dinheiro na mesa.

Mas relaxa: você não precisa ser um gênio da tecnologia para driblar essas barreiras. Neste guia, vou te mostrar por que a estratégia de user agent é essencial para scraping, como evitar as armadilhas mais comuns e como o deixa a gestão de user agent tão automática que você nem percebe. Seja para captar leads, monitorar SKUs ou manter suas planilhas em dia, este é o manual para ficar sempre um passo à frente.

Por Que Escolher o Melhor User Agent para Scraping é Tão Importante

Vamos do começo: o que é um user agent? Pense nele como o “RG” do seu navegador. Toda vez que você entra em um site — seja você ou um bot — seu navegador manda uma string User-Agent nos headers da requisição. É tipo dizer: “Oi, sou o Chrome no Windows” ou “Sou o Safari no iPhone” (). Olha um exemplo clássico de user agent do Chrome:

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36Os sites usam essa informação basicamente para duas coisas:

- Entregar o conteúdo certo (layout para desktop ou mobile, por exemplo).

- Identificar bots e raspadores.

Se o seu user agent for algo tipo “python-requests/2.28.1” ou “Scrapy/2.9.0”, é como andar com uma placa dizendo “Oi, sou um bot!”. Muitos sites já bloqueiam esses identificadores na hora. Agora, se você usa um user agent de navegador real e atualizado, consegue se misturar na multidão.

Resumindo: seu user agent é seu disfarce. Quanto melhor o disfarce, maior a chance de conseguir os dados que você quer.

O Papel do User Agent no Sucesso do Web Scraping

Por que a escolha do user agent faz tanta diferença? Porque é a primeira barreira dos sistemas anti-bot. Olha o que pode dar ruim se você errar:

- Bloqueio imediato (erros 403/429): Usou o user agent padrão de uma biblioteca de scraping? Bloqueio na hora ().

- Dados vazios ou falsos: Alguns sites entregam páginas em branco ou “de mentirinha” para user agents suspeitos.

- CAPTCHAs ou redirecionamentos: Um user agent com cara de bot ativa desafios “Você é humano?” ou loops de login.

- Limitação e banimento: Se você usar o mesmo user agent sempre, pode ser bloqueado ou ter o IP banido.

Veja como diferentes user agents se comportam:

This paragraph contains content that cannot be parsed and has been skipped.

Moral da história? Escolha seu disfarce com carinho. E lembre: os sistemas anti-bot de hoje não olham só para o user agent. Eles checam se outros headers (tipo Accept-Language ou Referer) batem com o que você diz ser. Se você fala que é Chrome, mas não manda os headers certos, vai ser pego igual ().

É aí que o Thunderbit brilha. Já conversei com muita gente de vendas, e-commerce, imobiliária — todo mundo quer os dados, não um curso de HTTP. Por isso, o Thunderbit foi feito para deixar a gestão de user agent invisível e automática.

Thunderbit: Gestão de User Agent Simplificada para Todos

Com o , você não precisa se preocupar com user agent. Nossa IA faz tudo por você, escolhendo a assinatura de navegador mais realista e atualizada para cada site. Seja usando a (que usa o user agent real do Chrome) ou o scraping em nuvem (onde a IA alterna entre vários user agents de navegadores atuais), você sempre se mistura ao tráfego legítimo.

E não é só o user agent: o Thunderbit manda um pacote completo e coerente de headers — Accept-Language, Accept-Encoding, Client Hints, entre outros — para que suas requisições pareçam e se comportem como as de um navegador de verdade. Nada de headers esquisitos ou alertas de “bot”.

O melhor? Você não precisa configurar nada. A IA do Thunderbit cuida de tudo nos bastidores, para você focar no que interessa: dados confiáveis e de qualidade.

Por Que a Rotação Dinâmica de User Agent é Fundamental

Achou o user agent perfeito? Não use o mesmo em todas as requisições! Em 2025, repetir o mesmo user agent é pedir para ser descoberto. Usuários reais usam navegadores, versões e dispositivos diferentes. Se seu raspador acessar um site 500 vezes seguidas com o mesmo user agent, é tipo um exército de clones — impossível passar batido.

Por isso, rotacionar user agents dinamicamente virou padrão. A ideia é simples: alternar entre uma lista de user agents reais e atualizados a cada requisição ou sessão. Assim, seu raspador parece um grupo variado de visitantes reais, não um script automatizado ().

A rotação inteligente do Thunderbit vai além. Em crawls de várias páginas ou tarefas agendadas, o Thunderbit alterna automaticamente user agents e até combina com diferentes IPs de proxy. Se um site começa a desconfiar, o Thunderbit reage na hora — trocando user agents, ajustando headers ou diminuindo a velocidade das requisições. Tudo isso sem você precisar mexer em nada, mantendo o scraping invisível e os dados rolando.

User Agent e Headers: O Poder da Consistência

Dica de quem já apanhou: o user agent é só uma parte da “impressão digital” da sua requisição. Sistemas anti-bot modernos checam se o user agent bate com outros headers como Accept-Language, Accept-Encoding e Referer. Se você diz que é Chrome no Windows, mas manda Accept-Language em francês de um IP de Nova York, é suspeito ().

Boas práticas:

- Sempre envie um conjunto completo de headers compatíveis com seu user agent.

- Mantenha Accept-Language e Accept-Encoding coerentes com o user agent e, se possível, com a localização do IP.

- Use as ferramentas de desenvolvedor do navegador para inspecionar requisições reais e copiar todos os headers para o user agent escolhido.

O Thunderbit faz tudo isso por você. Nossa IA garante que cada requisição seja perfeitamente alinhada — user agent, headers e até fingerprint do navegador. Você recebe um perfil de requisição igualzinho ao de um humano, sem esforço.

Evite Erros Comuns: O Que NÃO Fazer com User Agents

Já vi muito projeto de scraping naufragar pelos mesmos motivos. Olha os principais erros para evitar:

- Usar user agents padrão de bibliotecas de scraping: Strings como

python-requests/2.x,Scrapy/2.9.0ouJava/1.8são bloqueadas na hora. - Versões antigas de navegador: Dizer que é Chrome 85 em 2025? Muito suspeito. Use sempre versões atuais.

- Headers inconsistentes: Não mande user agent do Chrome sem os headers certos (Accept-Language, Accept-Encoding, Client Hints).

- User agents de crawlers conhecidos: Qualquer coisa com “bot”, “crawler”, “spider” ou nomes de ferramentas (tipo AhrefsBot) é sinal de alerta.

- User agents em branco ou aleatórios: Às vezes passam, mas geralmente são suspeitos e pouco confiáveis.

Checklist rápido para user agents seguros:

- Use user agents reais e atualizados (Chrome, Firefox, Safari).

- Rotacione entre vários user agents.

- Mantenha os headers consistentes com o user agent.

- Atualize sua lista de user agents todo mês (os navegadores mudam rápido).

- Evite qualquer coisa que denuncie automação.

Thunderbit na Prática: Casos Reais para Vendas e Operações

Vamos ao que interessa. Veja como a gestão de user agent do Thunderbit ajuda equipes de verdade:

| Caso de Uso | Antigo: Scraping Manual | Com Thunderbit | Resultado |

|---|---|---|---|

| Geração de Leads | Muitos bloqueios, dados faltando | IA escolhe o melhor user agent, rotaciona, simula navegação real | Mais leads, maior qualidade, menos rejeições |

| Monitoramento de E-commerce | Scripts quebram, IPs banidos | Scraping em nuvem com rotação dinâmica de user agent e proxy | Monitoramento confiável de preços/estoque |

| Listagens Imobiliárias | Ajustes manuais, bloqueios | IA adapta user agent/headers, lida com subpáginas automaticamente | Listas completas e sempre atualizadas |

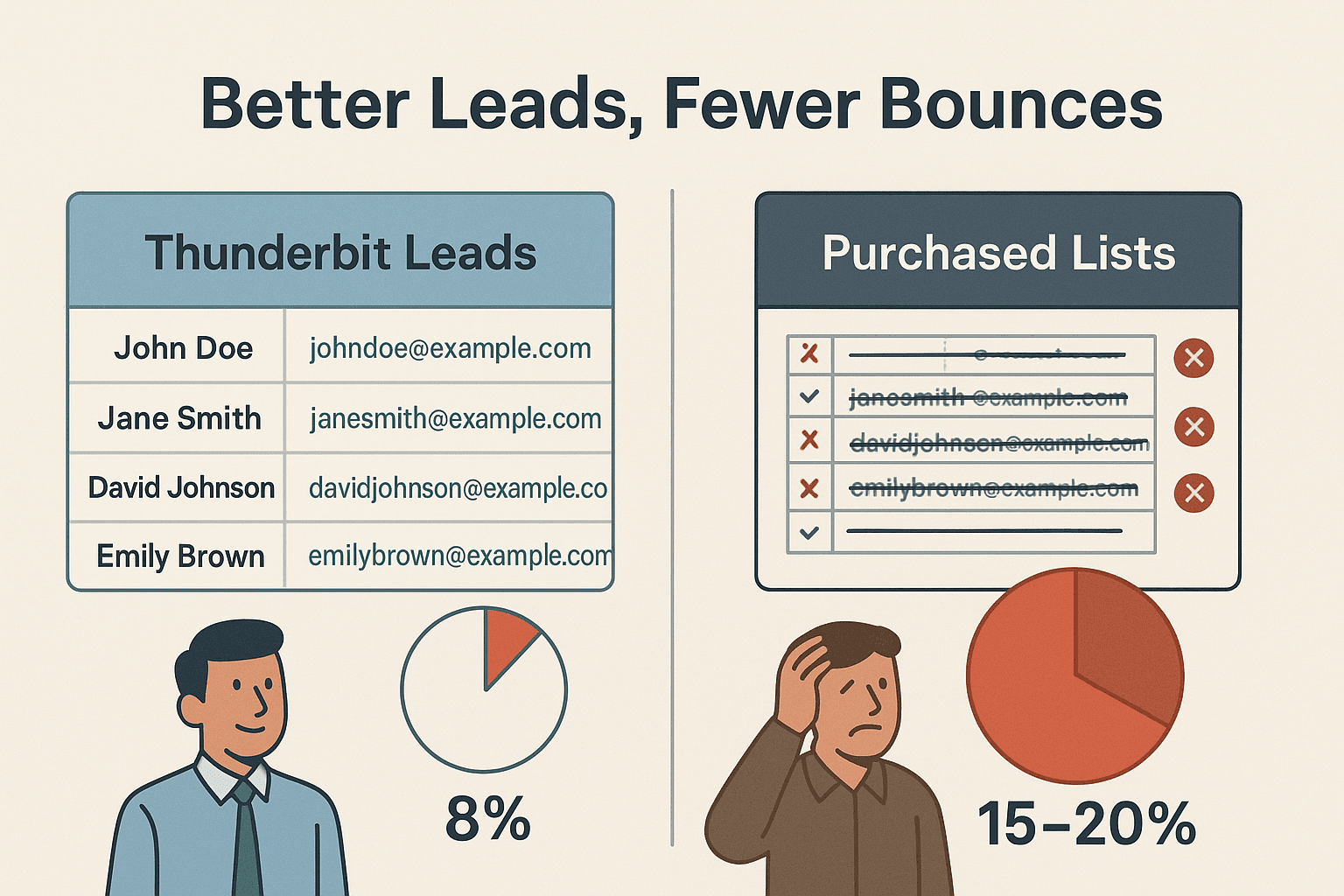

Uma equipe de vendas usando Thunderbit raspou milhares de sites para leads e teve só ~8% de taxa de rejeição de e-mails — contra 15–20% em listas compradas (). Isso é o poder do scraping atualizado e com perfil humano.

Passo a Passo: Como Fazer Scraping com o Melhor User Agent Usando Thunderbit

Olha como é fácil começar com o Thunderbit — sem precisar ser técnico:

- Instale a .

- Acesse o site que você quer. Faça login se precisar — o Thunderbit funciona até em páginas logadas.

- Clique em “IA Sugerir Campos”. A IA do Thunderbit analisa a página e sugere as melhores colunas para extrair.

- Revise e ajuste os campos se quiser. Renomeie, adicione ou remova colunas do jeito que preferir.

- Clique em “Extrair”. O Thunderbit coleta os dados, rotacionando user agents e headers automaticamente.

- Exporte seus dados. Mande direto para Excel, Google Sheets, Airtable, Notion ou baixe como CSV/JSON.

Não precisa escolher ou atualizar user agents — a IA do Thunderbit faz tudo, se adaptando a cada site para garantir o melhor resultado.

Comparando Thunderbit com a Gestão Tradicional de User Agent

Veja como o Thunderbit se sai em relação ao método manual tradicional:

| Recurso/Tarefa | Scraping Manual | Com Thunderbit |

|---|---|---|

| Configuração de User Agent | Pesquisar e definir no código | Automático, IA escolhe por site |

| Manter User Agents Atualizados | Manual, fácil de esquecer | IA atualiza conforme tendências dos navegadores |

| Rotação de User Agent | Programar lógica de rotação | Rotação inteligente embutida |

| Consistência de Headers | Ajustar headers manualmente | IA garante headers completos e consistentes |

| Lidar com Bloqueios/CAPTCHAs | Trocas manuais, manutenção constante | IA adapta, tenta novamente e rotaciona conforme necessário |

| Conhecimento Técnico Necessário | Alto (código, HTTP) | Nenhum — feito para usuários de negócios |

| Tempo com Problemas Técnicos | Frequente, frustrante | Mínimo — foque nos dados, não nos problemas |

O Thunderbit foi feito para quem quer scraping confiável e escalável — sem dor de cabeça técnica.

Resumindo: Como Construir uma Estratégia de User Agent à Prova de Futuro

O que aprendi (às vezes na marra) sobre gestão de user agent em 2025:

- Nunca use user agents padrão ou desatualizados. Eles são o principal motivo de bloqueios.

- Rotacione user agents dinamicamente. Diversidade é tudo — não deixe seu raspador parecer um robô em série.

- Mantenha headers consistentes e realistas. Seu user agent só é bom se os headers também forem.

- Mantenha-se atualizado. Versões de navegador mudam rápido; sua lista de user agents também deve mudar.

- Deixe a IA fazer o trabalho pesado. Ferramentas como Thunderbit já trazem as melhores práticas, para você focar nos resultados.

Se você está cansado de bloqueios, de ajustar scripts ou quer fazer scraping como um profissional sem dor de cabeça, . Nosso Raspador Web IA é usado por milhares de pessoas no mundo todo e foi feito para tornar dados web acessíveis a todos — sem complicação técnica.

Para mais dicas, tutoriais e conteúdos sobre scraping, acesse o .

Perguntas Frequentes

1. O que é um user agent e por que ele importa no web scraping?

User agent é uma string enviada em toda requisição web que identifica seu navegador e sistema operacional. Os sites usam isso para entregar o conteúdo certo e identificar bots. Usar o user agent correto ajuda seu raspador a passar despercebido e evitar bloqueios.

2. Por que não devo usar o user agent padrão da minha biblioteca de scraping?

User agents padrão como python-requests/2.x são facilmente reconhecidos como bots e bloqueados. Sempre use user agents reais e atualizados de navegadores.

3. Como o Thunderbit faz a rotação de user agent?

A IA do Thunderbit alterna automaticamente entre user agents reais e atuais de navegadores a cada requisição ou sessão. Assim, seu scraping parece tráfego humano e variado.

4. Preciso configurar headers como Accept-Language ou Referer manualmente no Thunderbit?

Não! A IA do Thunderbit garante que todos os headers estejam consistentes e compatíveis com o user agent, simulando um navegador real.

5. E se um site começar a bloquear minhas requisições?

O Thunderbit detecta bloqueios ou CAPTCHAs e reage em tempo real — trocando user agents, ajustando headers ou tentando novamente. Você recebe dados confiáveis sem precisar resolver problemas manualmente.

Quer fazer scraping de forma inteligente? e deixe a IA cuidar do jogo de gato e rato dos user agents para você. Boas extrações!

Saiba Mais