A internet está cheia de informações — e se você trabalha com vendas, marketing ou operações, sabe que ter o dado certo na hora certa faz toda a diferença. Mas vamos ser sinceros: ninguém quer passar o dia inteiro copiando e colando dados de sites para planilhas. Já vi equipes gastando dezenas de horas por mês só para “caçar dados”, e no fim das contas acabam com listas desatualizadas e cheias de erros. A boa notícia? As ferramentas modernas de screen scraping mudaram esse cenário, permitindo que qualquer pessoa — não só desenvolvedores — colete, organize e use dados da web em minutos, não em dias.

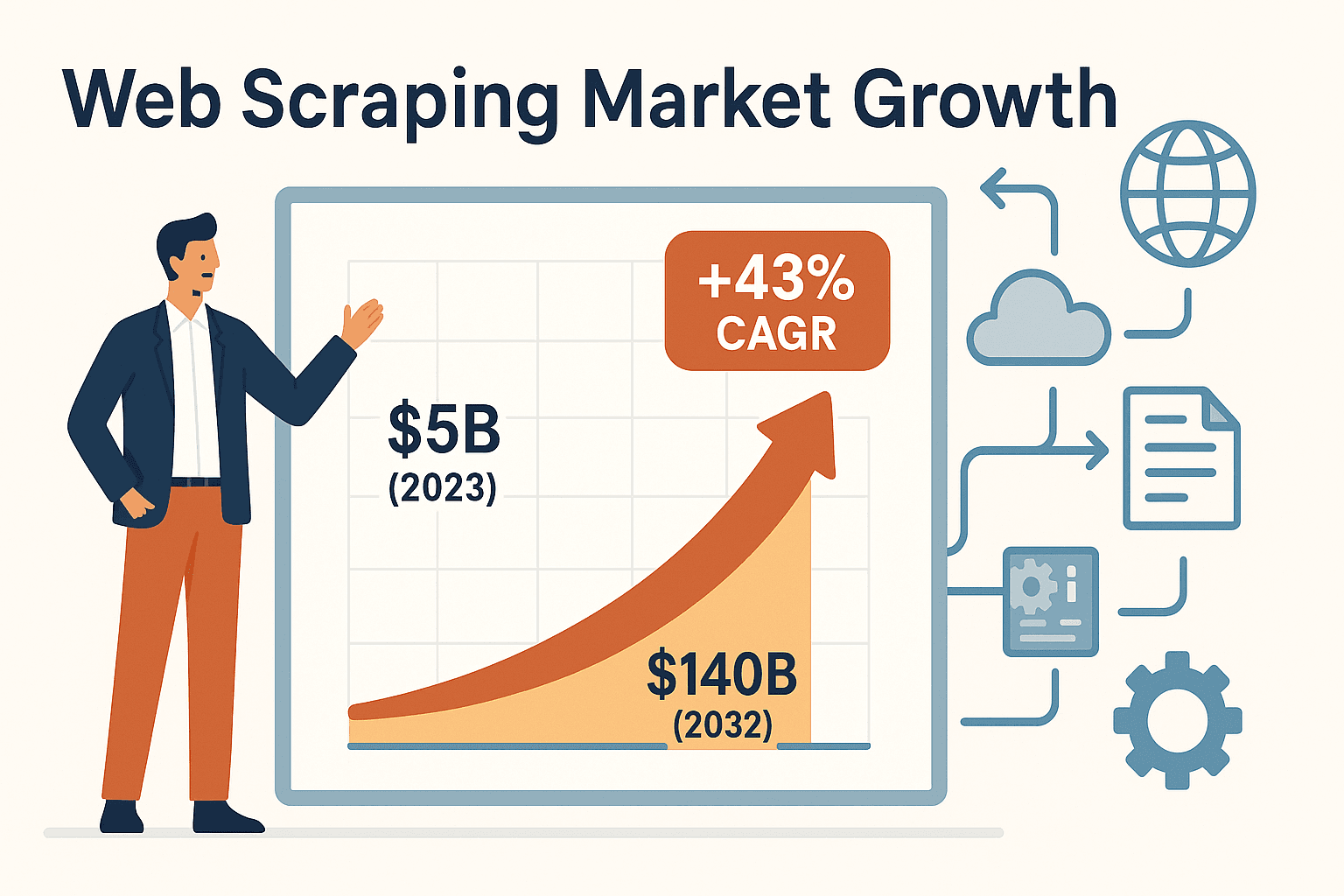

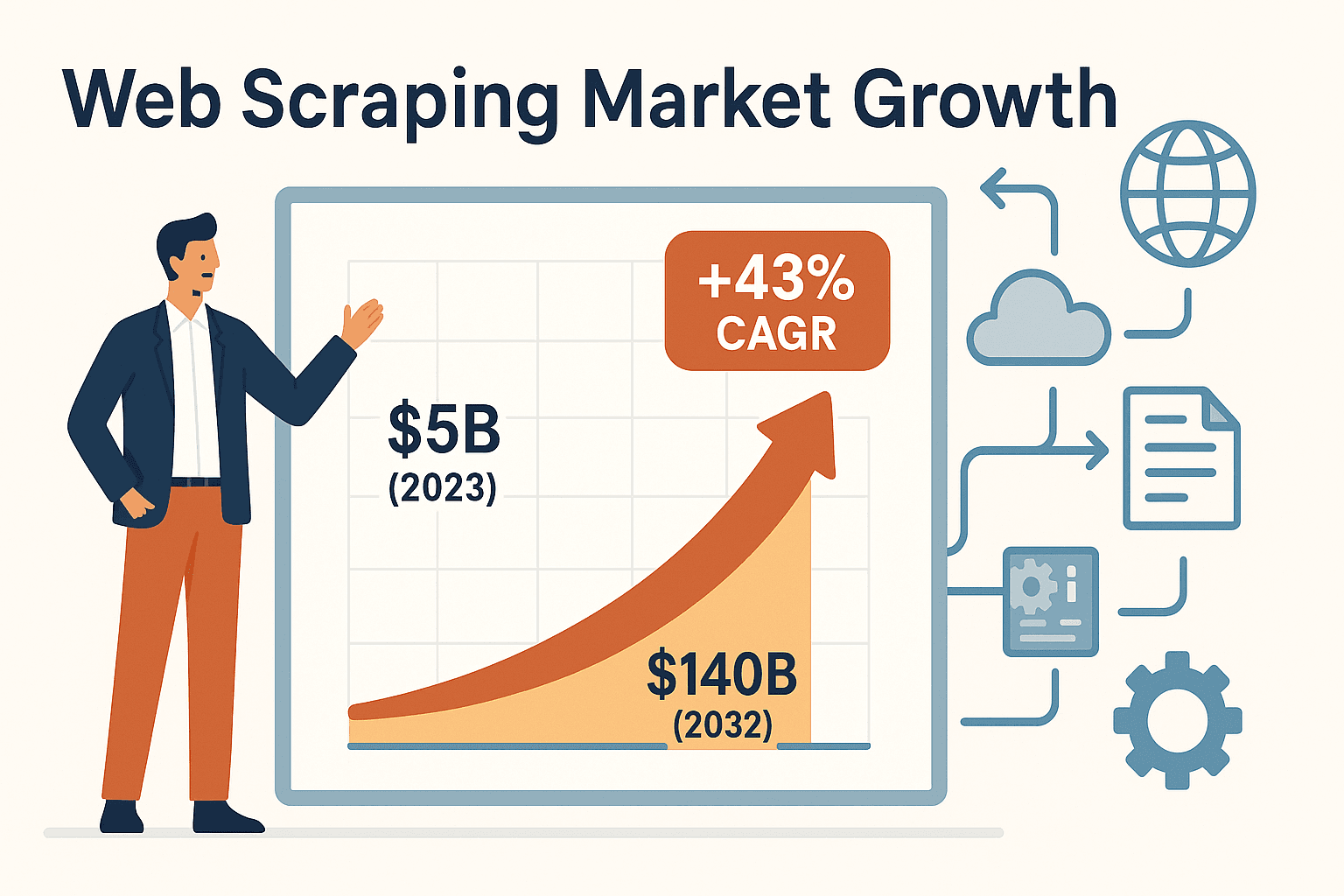

A busca por ferramentas de screen scraping está crescendo rápido. O mercado global de raspagem web foi avaliado em cerca de , com uma taxa de crescimento anual impressionante de 43%. O motivo? As empresas perceberam que automatizar processos não é mais um diferencial — é questão de sobrevivência para se manter competitivo. Seja para montar listas de leads, monitorar concorrentes ou acompanhar anúncios de imóveis, a ferramenta certa pode economizar de 30% a 40% do tempo gasto com dados e ainda reduzir custos de aquisição em até 40% ().

Vamos conhecer as seis melhores ferramentas de screen scraping para coletar dados de forma eficiente em 2025. Vou explicar o que diferencia cada uma, para quem são indicadas e como escolher a ideal para sua equipe — seja você alguém sem experiência técnica ou um desenvolvedor experiente.

Por que Ferramentas de Screen Scraping São Essenciais para Empresas

Se você já tentou manter uma lista de leads atualizada ou monitorar preços de concorrentes manualmente, sabe o quanto isso é trabalhoso. Coletar dados na mão é lento, cansativo e cheio de chances de erro. Para quem não é técnico — como vendedores, profissionais de marketing, corretores de imóveis e analistas de operações — as ferramentas de screen scraping são um verdadeiro salva-vidas. Elas automatizam tarefas repetitivas de copiar e colar, transformando horas de trabalho manual em poucos cliques.

Veja como essas ferramentas estão mudando o dia a dia das empresas:

- Geração de Leads: Extraia centenas de contatos de diretórios ou redes sociais em segundos, deixando sua equipe de vendas livre para focar no que realmente importa: vender.

- Monitoramento de Concorrentes: Programe coletas automáticas em sites de concorrentes para ter listas de preços sempre atualizadas ou descobrir lançamentos de produtos. Varejistas como a John Lewis tiveram um só usando scraping de preços.

- Coleta de Dados Imobiliários: Extraia anúncios de imóveis de sites como Zillow em segundos, mantendo seu portfólio e lista de clientes sempre atualizados.

- Automação de Fluxos de Trabalho: Exporte dados coletados direto para Excel, Google Sheets, Airtable ou Notion, e até automatize preenchimento de formulários e rotinas de software.

Resumindo: ferramentas de screen scraping dão autonomia para profissionais acessarem e usarem dados da web sem depender do time de TI. Isso significa decisões mais rápidas, informações sempre atualizadas e uma vantagem real sobre a concorrência.

Como Escolher a Ferramenta de Screen Scraping Ideal

Com tanta opção no mercado, escolher a ferramenta certa pode parecer como escolher um carro novo — você quer algo rápido e moderno, ou prefere praticidade e confiabilidade? Veja um checklist rápido para ajudar na escolha:

- Facilidade de Uso: Prefere uma solução sem código, só no clique, ou se sente confortável programando?

- Personalização: Precisa lidar com sites complexos, logins ou conteúdos dinâmicos (tipo rolagem infinita)?

- Tipos de Dados Suportados: Vai extrair textos, imagens, PDFs ou outros formatos?

- Escalabilidade: Vai coletar dados de poucas páginas ou precisa processar milhares diariamente?

- Opções de Exportação: É fácil enviar os dados para Excel, Google Sheets ou seu CRM?

- Preço: Qual seu orçamento? Busca uma ferramenta gratuita ou está pronto para investir em automação avançada?

- Suporte e Manutenção: Prefere um serviço gerenciado ou não se importa em manter scripts e resolver problemas?

Fique com esses pontos em mente enquanto analisamos as seis principais ferramentas. E lembre-se: a melhor ferramenta é aquela que sua equipe realmente vai usar.

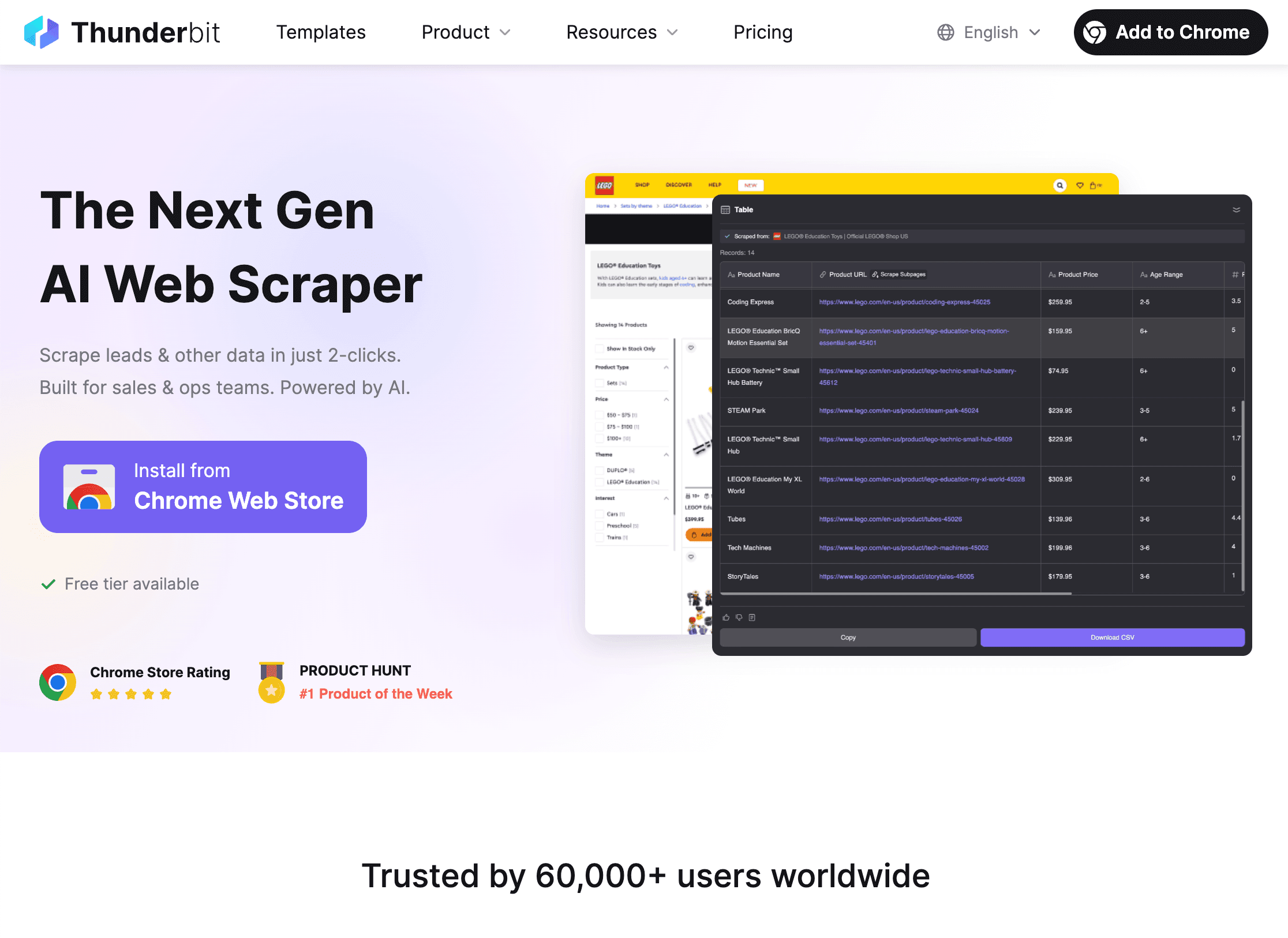

1. Thunderbit

é minha principal indicação para equipes sem perfil técnico que querem coletar dados da web de forma rápida — sem precisar de código, templates ou complicação. Como cofundador e CEO, posso ser suspeito, mas criei o Thunderbit justamente porque via profissionais de negócios sofrendo com ferramentas feitas só para desenvolvedores.

O que faz o Thunderbit se destacar? Simplicidade e potência:

- Sugestão de Campos com IA: Só clicar em “Sugerir Campos com IA” e a IA do Thunderbit lê a página, recomenda as melhores colunas (como nomes, preços, e-mails) e já define os tipos de dados.

- Raspagem em Dois Cliques: Acesse qualquer site, clique em “Raspar” e o Thunderbit faz o resto — sem configurações, sem selecionar elementos, sem dor de cabeça.

- Raspagem de Subpáginas e Paginação: Precisa coletar detalhes de subpáginas (como páginas de produtos ou perfis do LinkedIn)? O Thunderbit visita cada subpágina e preenche sua tabela automaticamente. Também lida com paginação, inclusive rolagem infinita.

- Templates Prontos: Para sites populares como Amazon, Zillow e Instagram, o Thunderbit oferece templates prontos — só inserir sua busca e exportar os dados.

- Exportação Gratuita: Exporte resultados para Excel, Google Sheets, Airtable ou Notion — totalmente grátis.

- Recursos Avançados: Extraia dados de PDFs, imagens e até automatize preenchimento de formulários com o AI Autofill (também gratuito). Programe coletas automáticas usando comandos em linguagem natural.

- Preço: O Thunderbit funciona por créditos — raspe até 6 páginas grátis (ou 10 com bônus de teste). Planos pagos a partir de apenas US$ 15/mês (ou US$ 9/mês no anual) para 500 linhas, acessível para equipes de todos os tamanhos.

O Thunderbit já é usado por mais de , de times de vendas e marketing a corretores de imóveis e operadores de e-commerce. O que mais ouço dos clientes? “Não acredito quanto tempo economizei — antes passava horas copiando leads de diretórios, agora faço em minutos.” Quer testar? e experimente.

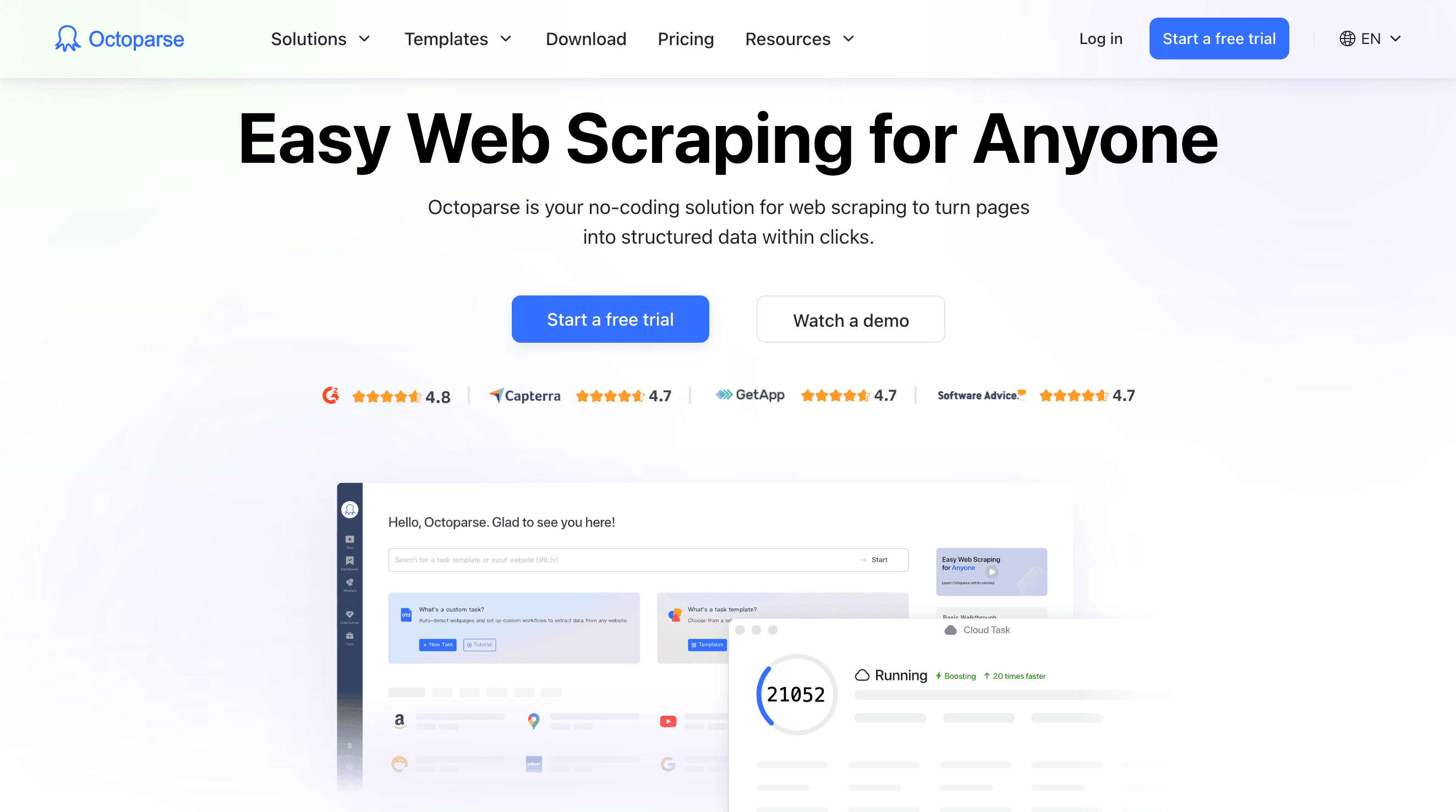

2. Octoparse

é um dos grandes nomes do scraping sem código, oferecendo uma interface visual de arrastar e soltar para criar fluxos de extração personalizados. Se você é um usuário avançado e precisa lidar com sites complexos — logins, AJAX, rolagem infinita, navegação em várias etapas — o Octoparse oferece as ferramentas, tudo sem precisar programar.

Principais recursos:

- Designer Visual de Fluxos: Clique em uma página de exemplo e o Octoparse identifica elementos semelhantes, ajudando a montar o fluxo de extração passo a passo.

- Suporte a Conteúdo Dinâmico: Funciona com sites pesados em JavaScript, rolagem infinita e páginas protegidas por login.

- Raspagem na Nuvem: Execute tarefas na nuvem (sem precisar deixar o computador ligado), agende coletas e processe grandes volumes de dados 24/7.

- Biblioteca de Templates: Mais de 100 templates prontos para sites populares como Amazon, LinkedIn e Twitter.

- Opções de Exportação: Baixe resultados em CSV, Excel ou JSON, ou envie direto para seu banco de dados.

- Preço: Plano gratuito com limitações; planos pagos a partir de cerca de US$ 75/mês para o Standard, com opções mais avançadas para maior volume e recursos extras.

O Octoparse é ideal para analistas, pesquisadores e pequenas empresas que precisam de scraping robusto, sem código e em escala média. Tem uma curva de aprendizado, especialmente para fluxos avançados, mas a interface visual e a documentação facilitam para quem tem alguma familiaridade com tecnologia.

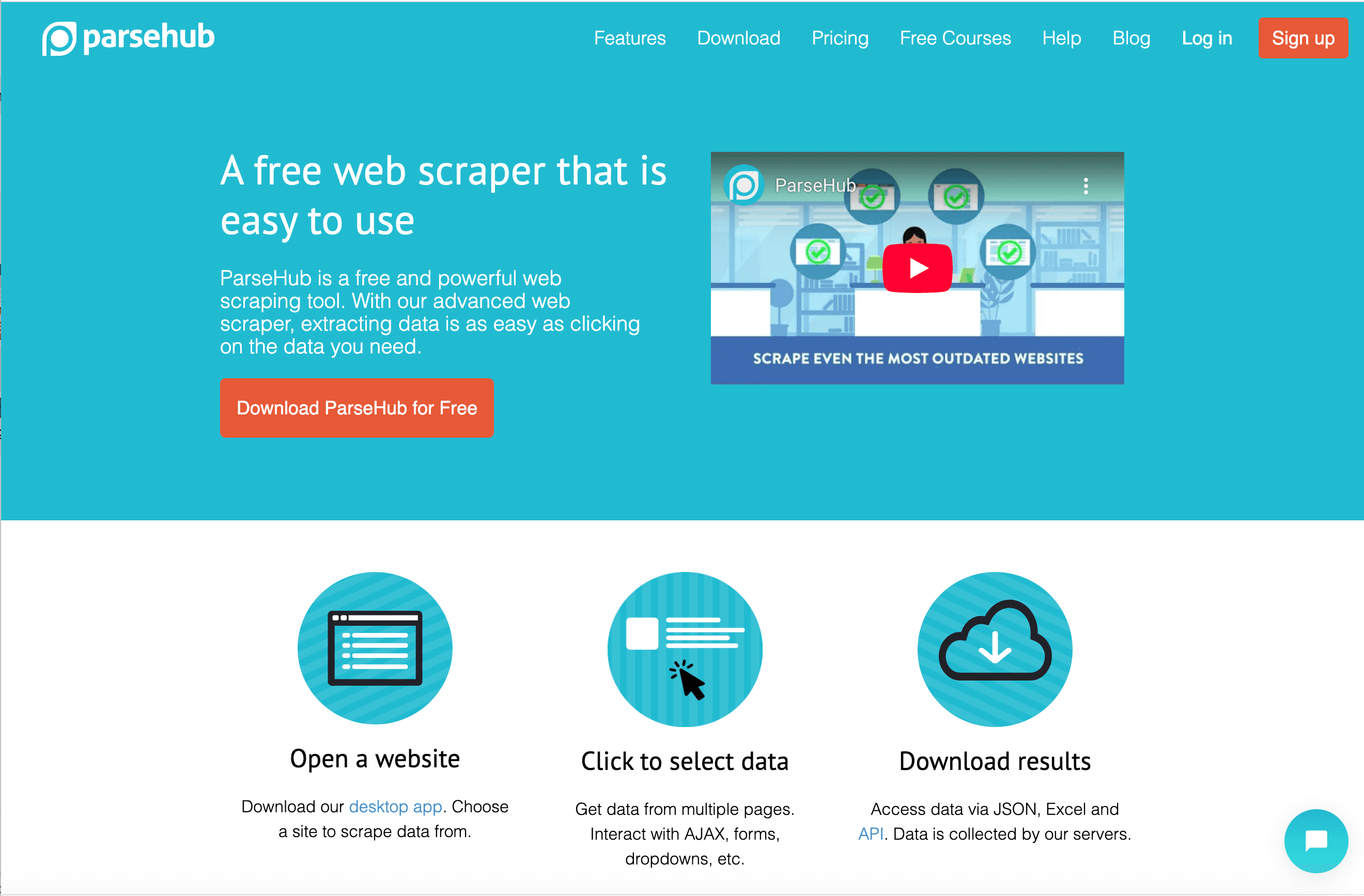

3. ParseHub

é outra ferramenta visual, famosa por lidar com sites dinâmicos e complexos através de um aplicativo desktop. Se você precisa extrair dados de páginas com muito JavaScript ou elementos interativos, o navegador simulado do ParseHub é uma ótima escolha.

Destaques do ParseHub:

- Raspador Visual para Desktop: Crie projetos clicando no site dentro do navegador integrado do app. O ParseHub identifica padrões e permite selecionar exatamente o que precisa.

- Suporte a JavaScript e AJAX: Espera o carregamento do conteúdo, clica em botões, preenche formulários e navega por sites interativos.

- Integração com API: Acione projetos e obtenha resultados de forma programática.

- Agendamento na Nuvem: Programe tarefas para rodar na nuvem (em planos superiores).

- Opções de Exportação: Baixe dados em CSV, Excel ou JSON.

- Preço: Plano gratuito permite raspar até 200 páginas por execução; planos pagos a partir de US$ 189/mês (Standard) e US$ 599/mês (Professional).

O ParseHub é muito usado por jornalistas de dados, pesquisadores e pequenas empresas que precisam extrair dados de sites dinâmicos e preferem trabalhar em ambiente desktop. O onboarding guiado ajuda iniciantes, mas o preço pode ser alto para quem precisa de grande volume.

4. Scrapy

é a escolha dos desenvolvedores e equipes técnicas que querem controle total sobre seus projetos de scraping. É um framework open-source em Python para criar crawlers personalizados — perfeito para tarefas grandes, complexas ou altamente customizadas.

Por que Scrapy é o favorito dos desenvolvedores:

- Flexibilidade Máxima: Escreva código Python para definir spiders, regras de navegação e pipelines de dados. O Scrapy gerencia concorrência, tentativas e exportação de dados.

- Performance: Projetado para velocidade e escala — raspe milhares ou milhões de páginas de forma eficiente.

- Extensibilidade: Integre com proxies, bancos de dados, APIs e middlewares personalizados.

- Open Source: Gratuito; custos ficam por conta da sua infraestrutura ou hospedagem em nuvem (como o Scrapy Cloud da Zyte).

- Comunidade: Ecossistema robusto, documentação madura e muitos tutoriais.

O Scrapy não é para iniciantes — tem uma curva de aprendizado acentuada e exige manutenção do código. Mas se você tem desenvolvedores na equipe e precisa de uma solução robusta e escalável, é difícil superar o Scrapy.

5. Diffbot

segue um caminho diferente: usa IA e machine learning para analisar e extrair dados estruturados de qualquer página da web. Em vez de criar scrapers, você envia uma URL (via API) e recebe um JSON limpo e estruturado — sem precisar configurar seletores.

O que torna o Diffbot único:

- Extração com IA: APIs pré-treinadas para artigos, produtos, discussões e mais. O Diffbot “lê” a página como um humano e extrai os campos principais.

- Crawlbot: Rastreie sites inteiros ou sitemaps automaticamente.

- Knowledge Graph: Acesse o enorme banco de dados do Diffbot, com mais de 1,2 bilhão de sites e 246 milhões de organizações.

- Escalabilidade: Feito para coleta de dados em escala empresarial.

- Preço: Plano gratuito (10.000 créditos/mês); planos pagos a partir de US$ 299/mês para 250.000 créditos, com opções para volumes maiores.

O Diffbot é ideal para empresas, cientistas de dados e quem precisa de grandes volumes de dados estruturados sem se preocupar em criar ou manter scrapers. Não é tão customizável quanto ferramentas baseadas em código, mas para extração automatizada e em larga escala, é imbatível.

6. DataMiner

é uma extensão de navegador (para Chrome e Edge) que facilita extrações rápidas e pontuais. Se você é um growth hacker, jornalista ou profissional de negócios que só quer pegar uma tabela ou lista de um site para o Excel, o DataMiner é seu novo aliado.

Por que o DataMiner é tão popular:

- Simplicidade no Clique: Clique nos elementos da página para criar uma “receita” ou use uma das mais de 60.000 receitas públicas para 15.000+ sites.

- Extração em Um Clique: Aplique a receita e exporte os dados instantaneamente para CSV ou Excel.

- Paginação e Raspagem em Massa: Lide com listas em várias páginas e até forneça uma lista de URLs para processamento em lote.

- Preenchimento de Formulários: Automatize envios de formulários usando dados de um CSV.

- Plano Gratuito: Raspe até 500 páginas por mês sem custo; planos pagos a partir de US$ 19,99/mês para 2.500 páginas.

O DataMiner é perfeito para tarefas pontuais, pesquisas rápidas e para quem prefere trabalhar direto no navegador. Não é feito para grandes volumes, mas para projetos pequenos e médios, é extremamente prático.

Tabela Comparativa Rápida: Ferramentas de Screen Scraping

| Ferramenta | Facilidade de Uso | Principais Recursos | Indicado Para | Modelo de Preço | Diferencial |

|---|---|---|---|---|---|

| Thunderbit | Muito fácil (sem código) | Sugestão de campos com IA, subpáginas/paginação, templates, exportação grátis | Usuários de negócios sem perfil técnico (vendas, operações, imóveis) | Grátis/A partir de US$ 9–15/mês | Configuração mais simples, IA, scraping rápido e pontual |

| Octoparse | Moderado (sem código) | Fluxo visual, nuvem, sites dinâmicos, templates | Analistas, pesquisadores com perfil técnico | Grátis/A partir de US$ 75/mês | Construtor visual, agendamento na nuvem, lógica avançada |

| ParseHub | Moderado (sem código) | App desktop, suporte JS/AJAX, API, nuvem | Sites dinâmicos, iniciantes técnicos | Grátis/A partir de US$ 189/mês | Lida com sites complexos, controle no desktop |

| Scrapy | Difícil (código Python) | Open-source, escalável, controle total, pipelines | Desenvolvedores, equipes de engenharia | Grátis (auto-hospedado) | Flexibilidade máxima, scraping customizado em larga escala |

| Diffbot | Fácil (para devs) | Extração com IA, APIs, Knowledge Graph, crawlbot | Empresas, cientistas de dados | Grátis/A partir de US$ 299/mês | Extração automatizada, dados em larga escala |

| DataMiner | Muito fácil (navegador) | Extensão, 60k+ receitas, um clique, formulários | Tarefas pontuais, jornalistas, growth hackers | Grátis/A partir de US$ 19,99/mês | Mais rápido no navegador, enorme biblioteca de templates |

Qual Ferramenta de Screen Scraping é Ideal para Você?

- Precisa de resultados instantâneos e sem código? Thunderbit ou DataMiner são as melhores opções. Thunderbit é ideal para scraping estruturado, multi-páginas ou subpáginas com ajuda de IA; DataMiner é perfeito para tarefas rápidas direto no navegador.

- Quer fluxos visuais e poder de nuvem? Octoparse é a escolha certa, especialmente para sites complexos ou coletas recorrentes.

- Vai extrair dados de sites dinâmicos e pesados em JavaScript? O ParseHub se destaca, principalmente para iniciantes técnicos.

- Tem desenvolvedores e precisa de controle total? Scrapy é referência para scraping customizado e em grande escala.

- Precisa de dados estruturados em escala empresarial, com IA? Diffbot entrega extração automatizada e um enorme knowledge graph.

Minha dica? Comece testando a versão gratuita — a maioria dessas ferramentas permite experimentar antes de contratar. Avalie seu nível técnico, volume de dados e necessidades de fluxo de trabalho para escolher a melhor opção. E não tenha medo de experimentar.

Conclusão: Potencialize a Coleta de Dados com a Ferramenta Certa

Ferramentas de screen scraping deixaram de ser exclusivas de desenvolvedores e se tornaram essenciais para produtividade nas empresas. Seja para buscar leads, monitorar preços ou reunir anúncios imobiliários, a ferramenta certa transforma a web em seu próprio banco de dados. O segredo é escolher aquela que se encaixa nas habilidades da sua equipe e nos objetivos do negócio — porque a melhor ferramenta é aquela que você realmente vai usar.

Pronto para parar de copiar e colar e começar a coletar dados como um profissional? ou teste uma das outras opções desta lista. E se quiser mais dicas, tutoriais e novidades, acesse o .

Perguntas Frequentes

1. O que é uma ferramenta de screen scraping e como funciona?

Uma ferramenta de screen scraping automatiza a extração de dados de sites. Em vez de copiar manualmente, você seleciona o que deseja e exporta em formato estruturado, como Excel ou CSV. Algumas usam IA ou fluxos visuais para facilitar o uso por quem não é técnico.

2. Quem deve usar ferramentas de screen scraping?

Qualquer pessoa que precise coletar dados da web de forma eficiente — equipes de vendas, marketing, corretores de imóveis, pesquisadores e analistas de operações. Seja para montar listas de leads, monitorar concorrentes ou reunir anúncios, essas ferramentas economizam tempo e reduzem erros.

3. Qual a diferença entre ferramentas de scraping sem código e com código?

Ferramentas sem código (como Thunderbit, Octoparse, ParseHub, DataMiner) têm interfaces intuitivas e são feitas para quem não programa. Ferramentas com código (como Scrapy) exigem conhecimento técnico, mas oferecem mais flexibilidade e escala para projetos complexos.

4. É legal usar ferramentas de screen scraping?

O screen scraping é permitido para dados públicos, mas é importante respeitar os termos de uso dos sites e as leis de privacidade. Evite coletar dados pessoais sem consentimento e não sobrecarregue sites com acessos excessivos.

5. Como escolher a melhor ferramenta de screen scraping para mim?

Considere seu nível técnico, volume de dados, complexidade dos sites, necessidades de exportação e orçamento. Comece com um teste gratuito, avalie seu caso de uso e veja qual ferramenta é mais intuitiva e entrega os resultados que você precisa.

Pronto para liberar o poder dos dados da web? Experimente uma dessas ferramentas e veja sua produtividade decolar.