A web virou o maior parque de diversões de dados do planeta — e vamos combinar, todo mundo quer construir o castelo de areia mais incrível. Seja você do time de vendas, e-commerce, pesquisa ou só um entusiasta de dados como eu, o 웹 스크래퍼 é aquele tempero secreto para tomar decisões mais inteligentes e agilizar qualquer rotina. Em 2025, não são só as gigantes de tecnologia que estão nessa: e dizem que decisões baseadas em dados são vitais para o negócio. E o detalhe? Python é a linguagem que puxa essa revolução, graças ao seu arsenal de bibliotecas e ferramentas para raspagem de dados.

Com anos de estrada em SaaS e automação, já vi de perto como a ferramenta certa de scraping em Python transforma horas de trabalho manual em tarefa de dois minutos. Mas com tanta opção — bibliotecas clássicas, automação de navegador, plataformas no-code e até soluções com IA — como saber qual escolher? Neste guia, vou te mostrar as 12 melhores bibliotecas Python para automação de 웹 스크래퍼, das mais amigáveis para quem está começando até as mais inovadoras com IA, como o . Seja você dev, gestor de operações ou só quer os dados sem dor de cabeça, tem uma opção aqui para cada perfil.

Por Que Escolher a Ferramenta Certa de 웹 스크래퍼 em Python Muda o Jogo

Vamos direto ao ponto: cada projeto de 웹 스크래퍼 é um universo. A ferramenta certa pode ser a diferença entre um processo automatizado e eficiente ou uma semana inteira tentando consertar script quebrado. Já vi agência de recrutamento multiplicar as vendas em 10× em só três meses automatizando a captação de leads — economizando 8 horas semanais por representante e gerando milhares de novos contatos (). Por outro lado, já vi equipes perderem dias porque escolheram biblioteca que não dava conta de conteúdo dinâmico ou era barrada por sistemas anti-bot.

Olha só por que a escolha faz tanta diferença:

- Impacto nos Negócios: A ferramenta certa automatiza geração de leads, monitoramento de preços, análise de concorrentes e fluxos de trabalho — trazendo vantagem real para vendas, e-commerce e pesquisa ().

- Dados Estáticos vs. Dinâmicos: Tem site que é HTML puro; outros são verdadeiras selvas de JavaScript. Se sua ferramenta não lida com conteúdo dinâmico, você pode perder informações valiosas.

- Escalabilidade e Confiabilidade: Vai raspar só algumas páginas? Quase qualquer solução resolve. Precisa processar milhares por dia? Prefira frameworks robustos como Scrapy ou soluções em nuvem.

Dica de quem vive isso: — tipo Beautiful Soup para páginas estáticas e Selenium para conteúdo dinâmico. O segredo está na mistura certa.

Como Avaliamos as Melhores Bibliotecas Python para 웹 스크래퍼

Com tanta opção no mercado, foquei no que realmente importa para quem é técnico e para quem é de negócios:

- Facilidade de Uso: Dá para usar sem saber programar? A API é amigável? Soluções visuais/no-code ganham pontos extras.

- Automação & Escalabilidade: Suporta raspagem de várias páginas, agendamento e grandes volumes de dados? Funciona em nuvem ou local?

- Suporte a Conteúdo Dinâmico: Consegue extrair dados de sites com JavaScript, rolagem infinita ou conteúdo protegido por login?

- Integração & Exportação: É fácil exportar para Excel, Google Sheets, bancos de dados ou integrar ao seu fluxo de trabalho?

- Comunidade & Manutenção: O projeto está ativo? Tem tutoriais e suporte?

- Custo: É gratuito, open-source ou pago? Vale a pena para equipes e empresas?

Testei as ferramentas, li avaliações de usuários e casos reais. Bora conhecer as 12 melhores.

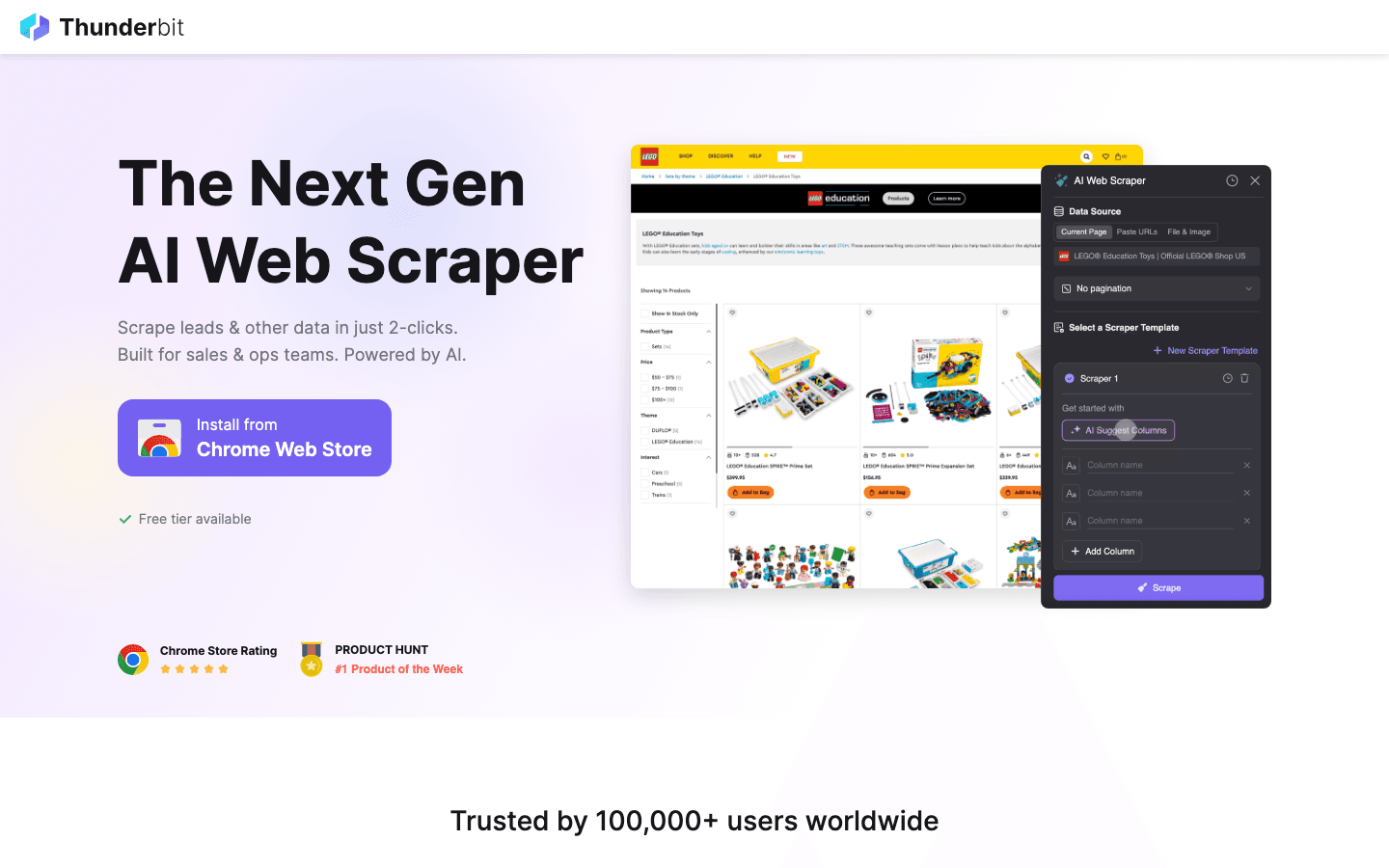

1. Thunderbit

é minha escolha número um para quem quer raspar dados da web sem complicação. É uma que permite extrair dados de qualquer site em só dois cliques — sem código, sem templates, sem estresse.

é minha escolha número um para quem quer raspar dados da web sem complicação. É uma que permite extrair dados de qualquer site em só dois cliques — sem código, sem templates, sem estresse.

Por que recomendo: O Thunderbit foi feito para quem é de negócios — vendas, operações, e-commerce, imobiliário — e precisa de dados rápido, mas não quer se enrolar com scripts Python. Só clicar em “Sugerir Campos com IA”, deixar a IA analisar a página e clicar em “Raspar”. O Thunderbit cuida de subpáginas, paginação, conteúdo dinâmico e até preenche formulários online para você. Exporte para Excel, Google Sheets, Airtable ou Notion de graça.

Destaques:

- Sugestão de Campos com IA: A IA do Thunderbit lê a página e sugere o que extrair — nomes, preços, e-mails, o que você quiser.

- Raspagem de Subpáginas: Quer mais detalhes? O Thunderbit visita subpáginas automaticamente (tipo páginas de produto ou contato) e enriquece sua tabela.

- Templates Instantâneos: Para sites como Amazon, Zillow ou Instagram, é só escolher um template e começar.

- Raspagem em Nuvem ou no Navegador: Raspe até 50 páginas de uma vez na nuvem, ou use o navegador para sites que pedem login.

- Exportação Gratuita de Dados: Sem barreira para exportar seus dados.

Ideal para: Equipes não técnicas, operações de vendas, e-commerce e qualquer um que quer resultado rápido — sem programar.

Limitações: Não é uma biblioteca Python de verdade, então se quiser integrar direto ao seu código Python, vai precisar exportar e importar os dados. Mas para 99% das necessidades de negócios, é uma mão na roda.

Quer ver na prática? Dá uma olhada no ou no nosso .

2. Beautiful Soup

é a biblioteca clássica de Python para analisar HTML e XML. Foi a primeira que usei para 웹 스크래퍼 e ainda recomendo para quem está começando.

é a biblioteca clássica de Python para analisar HTML e XML. Foi a primeira que usei para 웹 스크래퍼 e ainda recomendo para quem está começando.

Por que é ótima: Simples, tolerante a erros e perfeita para projetos rápidos. Você busca a página com Requests, passa o HTML para o Beautiful Soup e usa a API intuitiva para encontrar e extrair dados. Lida super bem com HTML bagunçado.

Ideal para: Projetos pequenos e médios, limpeza de dados e aprendizado de 웹 스크래퍼.

Limitações: Não suporta conteúdo dinâmico (JavaScript) nativamente. Para isso, precisa combinar com Selenium ou outra ferramenta de automação de navegador.

3. Scrapy

é o framework Python robusto para 웹 스크래퍼 em larga escala. Se você precisa extrair milhares (ou milhões) de páginas, construir pipelines de dados ou agendar tarefas, o Scrapy é o caminho.

é o framework Python robusto para 웹 스크래퍼 em larga escala. Se você precisa extrair milhares (ou milhões) de páginas, construir pipelines de dados ou agendar tarefas, o Scrapy é o caminho.

Por que é poderoso: Scrapy é assíncrono, rápido e feito para escalar. Você define “spiders” para navegar em sites, seguir links, lidar com paginação e processar dados em pipelines. É a base de muitos projetos empresariais de scraping.

Ideal para: Devs que precisam de crawlers robustos e escaláveis; raspagem de múltiplas páginas ou sites; pipelines de dados em produção.

Limitações: Curva de aprendizado mais puxada que o Beautiful Soup. Não lida com JavaScript nativamente — mas pode ser integrado ao Splash ou Selenium para sites dinâmicos.

4. Selenium

é a ferramenta de automação de navegador que permite controlar Chrome, Firefox e outros navegadores via Python. É indispensável para raspar sites dinâmicos, cheios de JavaScript, ou automatizar interações complexas.

é a ferramenta de automação de navegador que permite controlar Chrome, Firefox e outros navegadores via Python. É indispensável para raspar sites dinâmicos, cheios de JavaScript, ou automatizar interações complexas.

Por que é essencial: O Selenium simula ações humanas — cliques, preenchimento de formulários, rolagem — e extrai tudo que aparece no navegador, como se fosse um usuário real.

Ideal para: Sites dinâmicos, raspagem após login, rolagem infinita ou quando é preciso interagir com a página.

Limitações: Mais lento e consome mais recursos que bibliotecas HTTP puras. Não é ideal para raspagem em grande escala sem infraestrutura robusta.

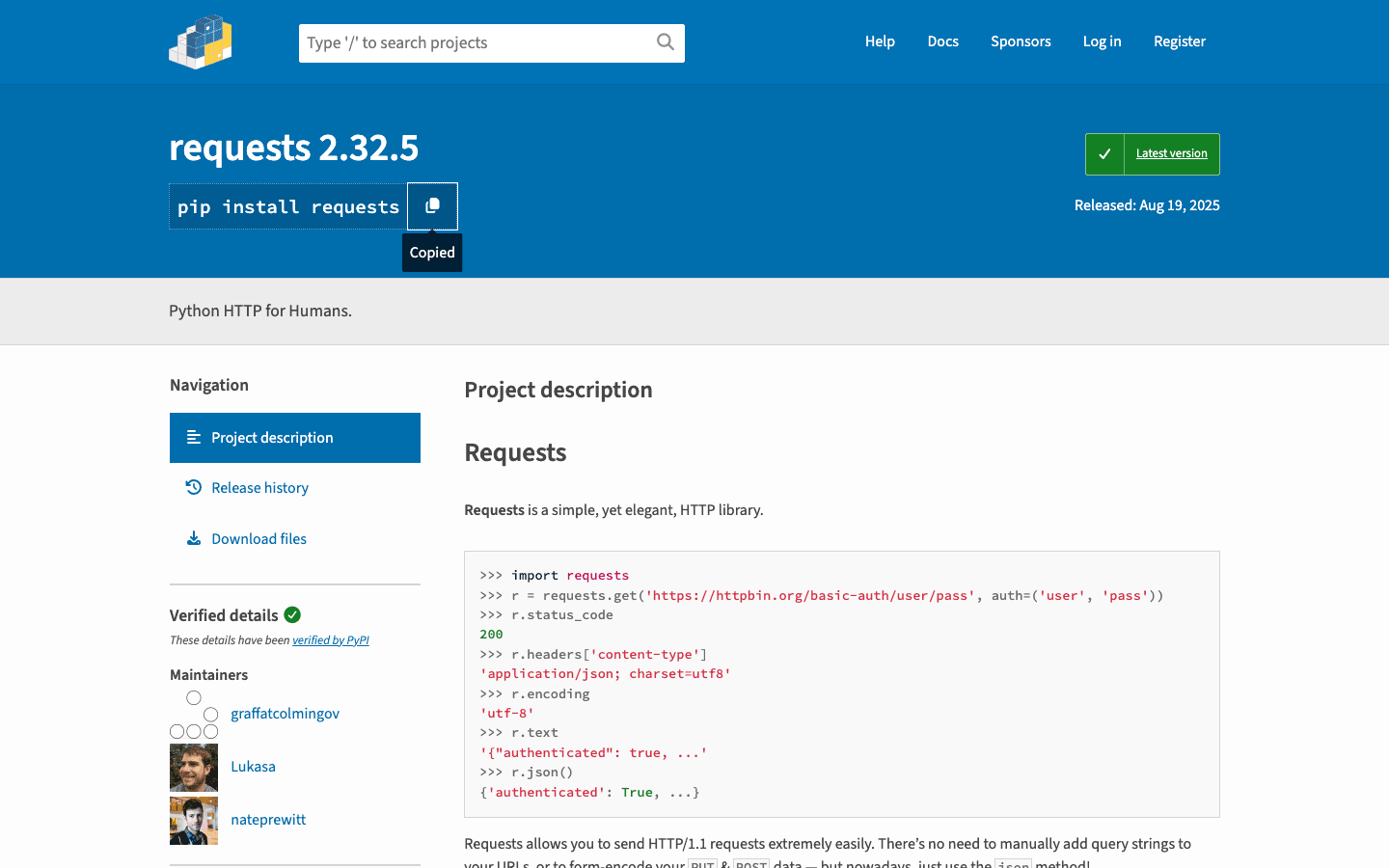

5. Requests

é a biblioteca “HTTP para Humanos”. É a base da maioria dos scripts de scraping em Python — busca páginas, envia formulários e gerencia cookies.

é a biblioteca “HTTP para Humanos”. É a base da maioria dos scripts de scraping em Python — busca páginas, envia formulários e gerencia cookies.

Por que é indispensável: API simples, confiável e integra perfeitamente com Beautiful Soup ou lxml. Ótima para sites estáticos e APIs.

Ideal para: Buscar HTML estático, consumir APIs ou como base para um 웹 스크래퍼 personalizado.

Limitações: Não lida com conteúdo gerado por JavaScript. Para sites dinâmicos, combine com Selenium ou similar.

6. LXML

é o analisador de HTML e XML de alta performance para Python. Extremamente rápido e com suporte a seletores XPath e CSS poderosos.

é o analisador de HTML e XML de alta performance para Python. Extremamente rápido e com suporte a seletores XPath e CSS poderosos.

Por que é favorito: Se você precisa raspar páginas grandes ou fazer consultas avançadas, o lxml é ideal. O Scrapy inclusive o utiliza internamente.

Ideal para: Projetos que exigem performance, grandes volumes de dados ou extração complexa via XPath.

Limitações: Curva de aprendizado um pouco maior e instalação pode ser complicada em alguns sistemas.

7. PySpider

é um framework de scraping Python com interface web. Lembra o Scrapy, mas com painel para gerenciar, agendar e monitorar tarefas de raspagem.

é um framework de scraping Python com interface web. Lembra o Scrapy, mas com painel para gerenciar, agendar e monitorar tarefas de raspagem.

Por que é diferente: Permite escrever spiders em Python, agendar execuções e visualizar resultados — tudo pelo navegador. Ótimo para equipes que querem controle e automação.

Ideal para: Equipes com múltiplos projetos de scraping, crawls agendados ou que preferem interface visual.

Limitações: Menos mantido que o Scrapy e suporte limitado para sites modernos com JavaScript.

8. MechanicalSoup

é uma biblioteca leve para automatizar tarefas simples de navegador — como preencher formulários e seguir links — sem a complexidade do Selenium.

é uma biblioteca leve para automatizar tarefas simples de navegador — como preencher formulários e seguir links — sem a complexidade do Selenium.

Por que é útil: Combina Requests e Beautiful Soup, facilitando login, envio de formulários e raspagem das páginas resultantes.

Ideal para: Automatizar logins, envios de formulários ou fluxos simples onde JavaScript não é necessário.

Limitações: Não lida com sites pesados em JavaScript ou interações complexas.

9. Octoparse

é uma ferramenta de 웹 스크래퍼 no-code com interface drag-and-drop. Perfeita para quem quer extrair dados sem escrever código.

é uma ferramenta de 웹 스크래퍼 no-code com interface drag-and-drop. Perfeita para quem quer extrair dados sem escrever código.

Por que faz sucesso: O Octoparse lida com paginação, conteúdo dinâmico e permite agendar raspagens na nuvem. Oferece templates prontos para sites populares e exporta dados para Excel, CSV ou Google Sheets.

Ideal para: Quem não programa, pesquisa de mercado, geração de leads e equipes que querem resultado rápido.

Limitações: O plano gratuito é limitado; recursos avançados exigem assinatura (a partir de US$ 75/mês).

10. ParseHub

é outra ferramenta visual que permite criar fluxos de raspagem complexos clicando no site. Excelente para lidar com sites dinâmicos, lógica condicional e agendamento de tarefas na nuvem.

é outra ferramenta visual que permite criar fluxos de raspagem complexos clicando no site. Excelente para lidar com sites dinâmicos, lógica condicional e agendamento de tarefas na nuvem.

Por que se destaca: A lógica condicional e os fluxos multi-etapas do ParseHub são ideais para sites com pop-ups, abas ou dados escondidos.

Ideal para: Quem não programa e precisa raspar sites dinâmicos e complexos; coleta de dados agendada.

Limitações: O plano gratuito tem restrições; planos pagos podem ser caros para grandes volumes.

11. Colly

é um framework de 웹 스크래퍼 de alta velocidade — escrito em Go, não em Python, mas vale a menção pelo desempenho. Algumas equipes Python usam o Colly como microserviço para crawls pesados, processando os dados depois em Python.

é um framework de 웹 스크래퍼 de alta velocidade — escrito em Go, não em Python, mas vale a menção pelo desempenho. Algumas equipes Python usam o Colly como microserviço para crawls pesados, processando os dados depois em Python.

Por que chama atenção: O Colly pode buscar milhares de páginas por segundo com baixo consumo de memória. Para raspagem em grande escala, é uma ótima opção cross-platform.

Ideal para: Equipes de engenharia que precisam de velocidade e concorrência; integração de crawlers em Go com fluxos Python.

Limitações: Exige conhecimento em Go; não é uma biblioteca Python direta.

12. Portia

é um 웹 스크래퍼 visual open-source da Scrapinghub (agora Zyte). Permite criar spiders Scrapy clicando nos elementos do navegador — sem código.

é um 웹 스크래퍼 visual open-source da Scrapinghub (agora Zyte). Permite criar spiders Scrapy clicando nos elementos do navegador — sem código.

Por que é interessante: O Portia aproxima não-programadores do poder do Scrapy. Você define regras de extração visualmente e pode rodar o spider no Scrapy ou na nuvem da Zyte.

Ideal para: Profissionais de dados sem experiência em programação, ou quem quer prototipar spiders Scrapy de forma visual.

Limitações: Manutenção limitada e dificuldades com sites muito dinâmicos ou interativos.

Tabela Comparativa: Melhores Bibliotecas Python para 웹 스크래퍼

| Ferramenta/Biblioteca | Facilidade de Uso | Conteúdo Dinâmico | Automação & Escala | Ideal Para | Preço |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | Não-programadores, negócios, resultados rápidos | Grátis + créditos |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Iniciantes, páginas estáticas, limpeza de dados | Grátis |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | Desenvolvedores, crawls em larga escala | Grátis |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | Sites dinâmicos, automação de navegador | Grátis |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | HTML estático, APIs, scripts rápidos | Grátis |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | Performance, grandes volumes, XPath | Grátis |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | Equipes, crawls agendados, interface web | Grátis |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | Automação de formulários, logins, fluxos simples | Grátis |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | No-code, negócios, raspagens agendadas | Grátis + pago |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | No-code, sites dinâmicos/complexos | Grátis + pago |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | Alta performance, cross-platform, integração Go | Grátis |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | Spiders visuais Scrapy, não-programadores | Grátis |

Como Escolher a Ferramenta de 웹 스크래퍼 em Python para Seu Negócio

E aí, qual ferramenta escolher? Olha meu resumo:

- Não-programadores ou usuários de negócios: Comece com , ou . São rápidas, visuais e não exigem programação.

- Devs, projetos em larga escala: Vá de ou se precisa de crawlers robustos e repetíveis.

- Sites dinâmicos/pesados em JavaScript: Use ou uma ferramenta visual com automação de navegador.

- Raspagem rápida de páginas estáticas: + ainda é o caminho mais ágil para começar.

- Performance ou integração cross-platform: Considere para microserviços em Go, ou use junto com Python para o melhor dos dois mundos.

- Prototipagem visual para Scrapy: é uma ótima ponte entre não-programadores e devs.

Minha dica: Comece pela ferramenta mais simples que resolva seu problema. Se estiver na dúvida, teste o para um resultado rápido, ou inicie um projeto Scrapy se busca escala.

E lembre: a melhor ferramenta é aquela que entrega os dados que você precisa — de forma confiável, eficiente e sem te deixar na mão.

Perguntas Frequentes

1. Por que Python é tão popular para 웹 스크래퍼?

Python reina na 웹 스크래퍼 por sua sintaxe simples, monte de bibliotecas e comunidade ativa. ), sendo a linguagem queridinha de iniciantes e profissionais.

2. Qual a melhor biblioteca Python para raspar sites dinâmicos (JavaScript)?

Para sites dinâmicos, é a escolha clássica, pois controla um navegador real. Para soluções sem código, , e também dão conta de páginas pesadas em JavaScript.

3. Como escolher entre Scrapy e Beautiful Soup?

Use o para projetos rápidos, simples ou para aprender. Prefira o para crawls automatizados em larga escala, projetos multi-página ou quando precisa de pipelines robustos e agendamento.

4. Posso usar o Thunderbit no meu fluxo Python?

Com certeza. O permite exportar dados para CSV, Excel ou Google Sheets, que você pode importar nos seus scripts Python para análise ou processamento extra.

5. Qual a forma mais fácil de começar a raspar dados se não sou dev?

Experimente o , ou . Essas ferramentas permitem extrair dados de forma visual — sem código. Para mais dicas, acesse o .

Boas raspagens — e que seus dados estejam sempre limpos, organizados e a um clique de distância.

Saiba Mais