O cenário do 웹 스크래퍼 em 2026 lembra muito uma feira livre logo cedinho: todo mundo correndo atrás dos dados mais frescos, e só quem tem as melhores ferramentas consegue sair na frente antes da multidão chegar. Com as empresas cada vez mais dependentes de dados extraídos para tudo — desde encontrar novos clientes até entender o que a concorrência está fazendo — escolher as bibliotecas Python certas para 웹 스크래퍼 vai muito além de uma decisão técnica: é uma jogada estratégica. E vamos combinar, com tanta opção (e tanto “guia definitivo” por aí), às vezes parece que você precisa de um diploma só pra montar seu arsenal de ferramentas.

Depois de anos mergulhado em SaaS e automação, vi de perto como as ferramentas certas de 웹 스크래퍼 em Python podem transformar uma tarefa que levaria uma semana em algo resolvido em poucas horas. Seja você um dev montando pipelines robustos ou alguém de negócios que só quer os dados limpinhos na planilha, esta lista traz as 12 melhores bibliotecas Python para 웹 스크래퍼 em 2026 — e ainda uma solução com IA que está mudando o jogo tanto pra quem programa quanto pra quem não programa.

Por Que Escolher a Biblioteca Python Certa Muda Tudo

Raspar dados não é só sair pegando informação — é garantir que você pega os dados certos, na velocidade certa, sem perder a cabeça. Em 2026, mais de nos EUA já usam 웹 스크래퍼 automatizado para vendas, pesquisa de mercado e operações, e o volume de páginas rastreadas por dia já chega a . O risco é alto: escolher errado pode significar perder oportunidades, scripts quebrando ou horas gastas só pra consertar bug.

Olha o que está em jogo quando você escolhe suas ferramentas Python pra 웹 스크래퍼:

- Desempenho: Aguenta grandes volumes sem travar?

- Facilidade de Uso: Você vai gastar mais tempo programando ou colhendo resultado?

- Suporte a Navegador & JavaScript: Dá conta de sites modernos e dinâmicos?

- Escalabilidade: Cresce junto com o seu projeto?

- Integração: Se encaixa fácil no seu fluxo de dados ou rotina de trabalho?

Os usos mais comuns? Geração de leads, monitoramento de preços, análise da concorrência e automação de tarefas repetitivas de entrada de dados. A biblioteca certa pode ser a diferença entre uma equipe de vendas sempre à frente e outra presa em planilhas infinitas.

Como Avaliamos as Melhores Bibliotecas Python para 웹 스크래퍼

Pra montar essa lista, olhei pra cada biblioteca pensando em:

- Desempenho & Escalabilidade: Como lida com grandes volumes e sites mais complexos?

- Facilidade de Uso: É amigável pra quem tá começando ou só pra quem já manja muito de Python?

- Manipulação de Navegador & JavaScript: Dá conta de conteúdo dinâmico e web apps modernos?

- Segurança & Manutenção: É atualizada e segura?

- Comunidade & Suporte: Tem documentação, tutoriais e uma galera ativa pra ajudar?

- Potencial de Integração: Dá pra combinar com outras ferramentas (ou soluções de IA como Thunderbit) pra turbinar ainda mais?

Também levei em conta as necessidades reais do dia a dia — porque, no fim das contas, seu código só vale o quanto entrega de dado útil.

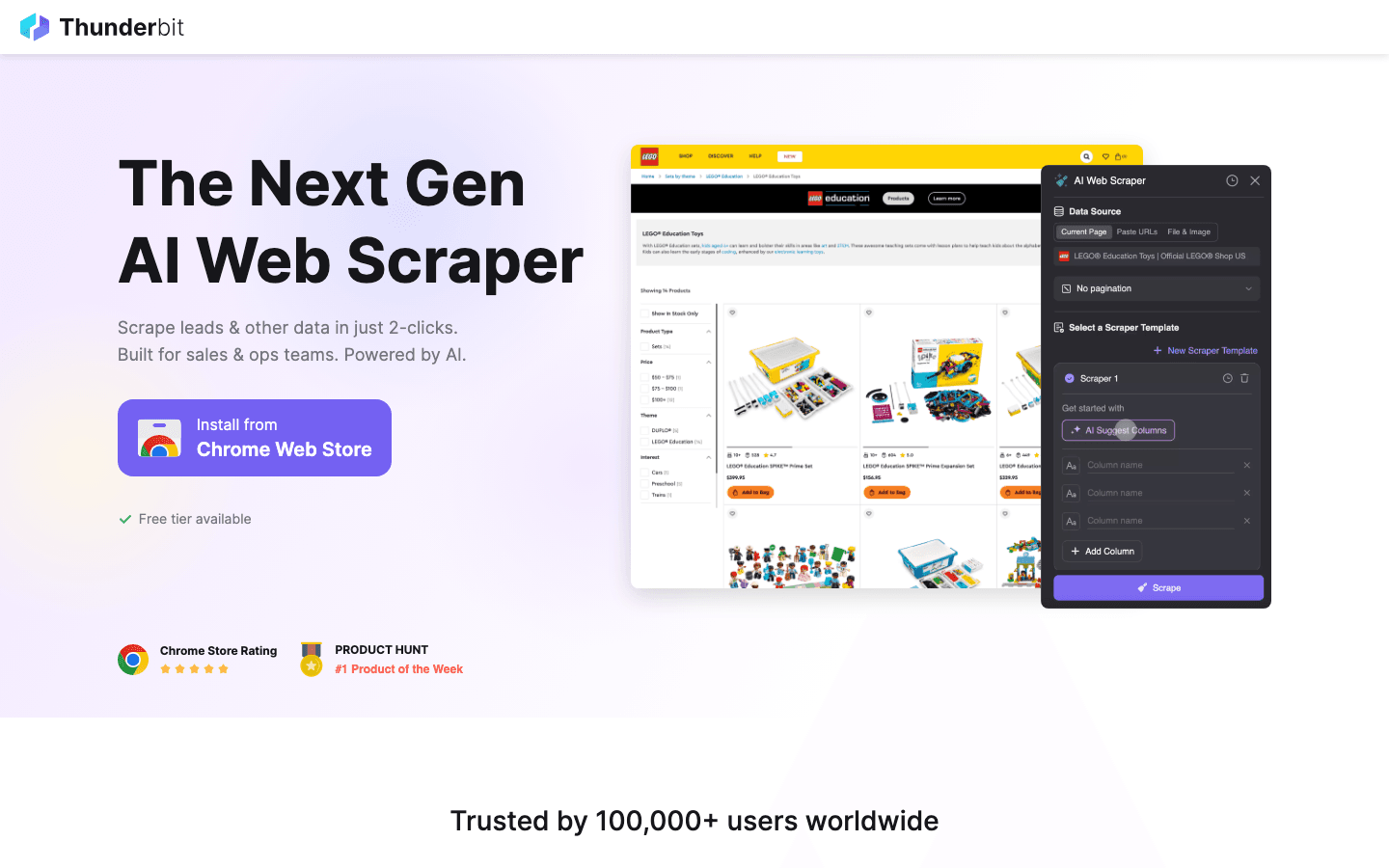

1. Thunderbit

não é uma biblioteca Python tradicional — é uma que está mudando como usuários de negócios e devs fazem 웹 스크래퍼 em 2026. Olha só porque ela merece destaque aqui.

não é uma biblioteca Python tradicional — é uma que está mudando como usuários de negócios e devs fazem 웹 스크래퍼 em 2026. Olha só porque ela merece destaque aqui.

Principais recursos:

- Sugestão de Campos com IA: Só descrever o que você quer e a IA do Thunderbit já identifica colunas e tipos de dados na hora.

- 웹 스크래퍼 de Subpáginas: Visita e extrai dados de subpáginas (tipo detalhes de produtos ou perfis do LinkedIn) automaticamente.

- Modelos Instantâneos: 웹 스크래퍼 com um clique pra sites populares (Amazon, Zillow, Shopify, etc.).

- Exportação Gratuita de Dados: Joga direto pra Excel, Google Sheets, Airtable, Notion, CSV ou JSON — sem pagar nada a mais.

- Fluxo Sem Código: Perfeito pra quem não programa, mas também integra com ferramentas Python pra fluxos avançados.

Melhores usos: Prospecção de clientes, monitoramento de preços em e-commerce, listagens imobiliárias, operações e qualquer situação que pede dados estruturados — rapidinho.

Vantagens:

- Não precisa programar — só apontar, clicar e descrever

- IA se adapta a mudanças no layout dos sites

- Lida fácil com dados bagunçados e sites long tail

- Dá pra combinar com bibliotecas Python (tipo Scrapy ou Beautiful Soup) pra fluxos híbridos

Desvantagens:

- Não é uma biblioteca Python pura (mas integra bem com pipelines Python)

- Melhor pra usuários de negócios ou como complemento à raspagem baseada em código

Dica de quem manja: Use o Thunderbit pra prototipar rápido seus 웹 스크래퍼 ou resolver tarefas pontuais e complexas. Pra automação em larga escala, exporte os dados estruturados do Thunderbit e processe nos seus scripts Python.

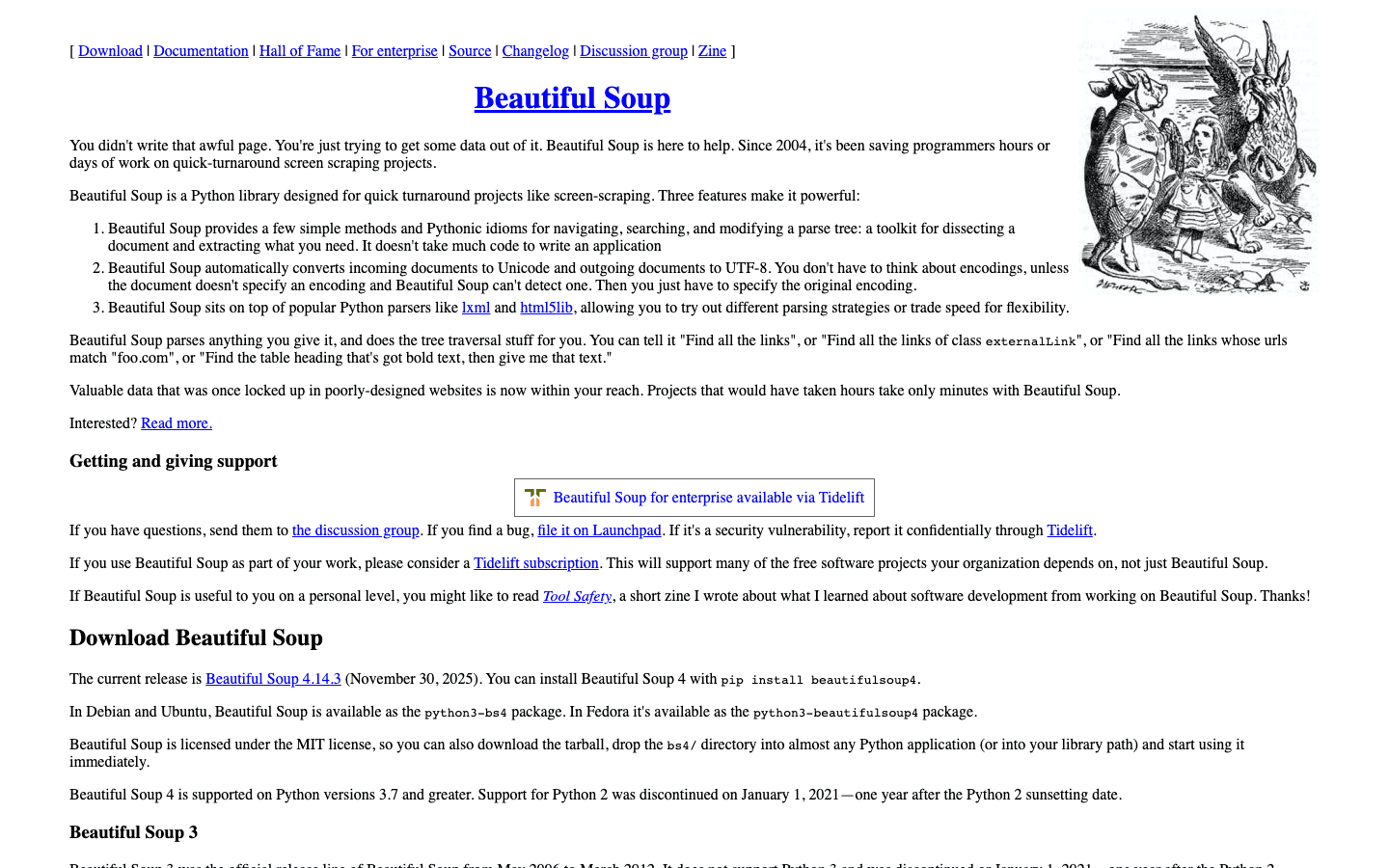

2. Beautiful Soup

é a biblioteca Python mais famosa pra analisar e navegar em HTML ou XML. Se você já precisou limpar uma página web toda bagunçada, sabe porque essa ferramenta é queridinha de quem tá começando e de quem já é veterano.

é a biblioteca Python mais famosa pra analisar e navegar em HTML ou XML. Se você já precisou limpar uma página web toda bagunçada, sabe porque essa ferramenta é queridinha de quem tá começando e de quem já é veterano.

Principais recursos:

- Sintaxe intuitiva pra buscar, navegar e modificar HTML/XML

- Lida bem com marcação malformada ou quebrada

- Integra fácil com pra buscar páginas

Melhores usos: 웹 스크래퍼 rápido, limpeza de dados, análise de páginas pequenas e médias.

Vantagens:

- Muito fácil de aprender

- Ótima pra limpar HTML bagunçado

- Flexível e tolerante a erro

Desvantagens:

- Mais lenta que em documentos grandes

- Não suporta JavaScript nativamente

Dica de quem manja: Pra mais velocidade, use o Beautiful Soup com o parser lxml. Pra sites dinâmicos, combine com Selenium ou Pyppeteer.

3. Selenium

é referência quando o assunto é automação de navegadores. Ele controla Chrome, Firefox, Edge e outros — perfeito pra raspar sites dinâmicos e pesados em JavaScript.

é referência quando o assunto é automação de navegadores. Ele controla Chrome, Firefox, Edge e outros — perfeito pra raspar sites dinâmicos e pesados em JavaScript.

Principais recursos:

- Automação de navegadores reais (Chrome, Firefox, etc.)

- Suporte a modo headless pra rodar mais rápido e sem abrir janela

- Interage com formulários, botões e simula ações de usuário

Melhores usos: 웹 스크래퍼 de sites que exigem login, cliques ou renderização pesada de JavaScript.

Vantagens:

- Lida com praticamente qualquer site, por mais dinâmico que seja

- Suporte a vários navegadores e plataformas

- Ótimo pra testes e 웹 스크래퍼 tudo em um só lugar

Desvantagens:

- Mais lento que soluções só headless

- Consome mais recursos

- Scripts podem quebrar se o layout do site mudar

Dica de quem manja: Use Selenium pra sites onde nada mais funciona, mas pra velocidade e escala, prefira Scrapy ou Pyppeteer.

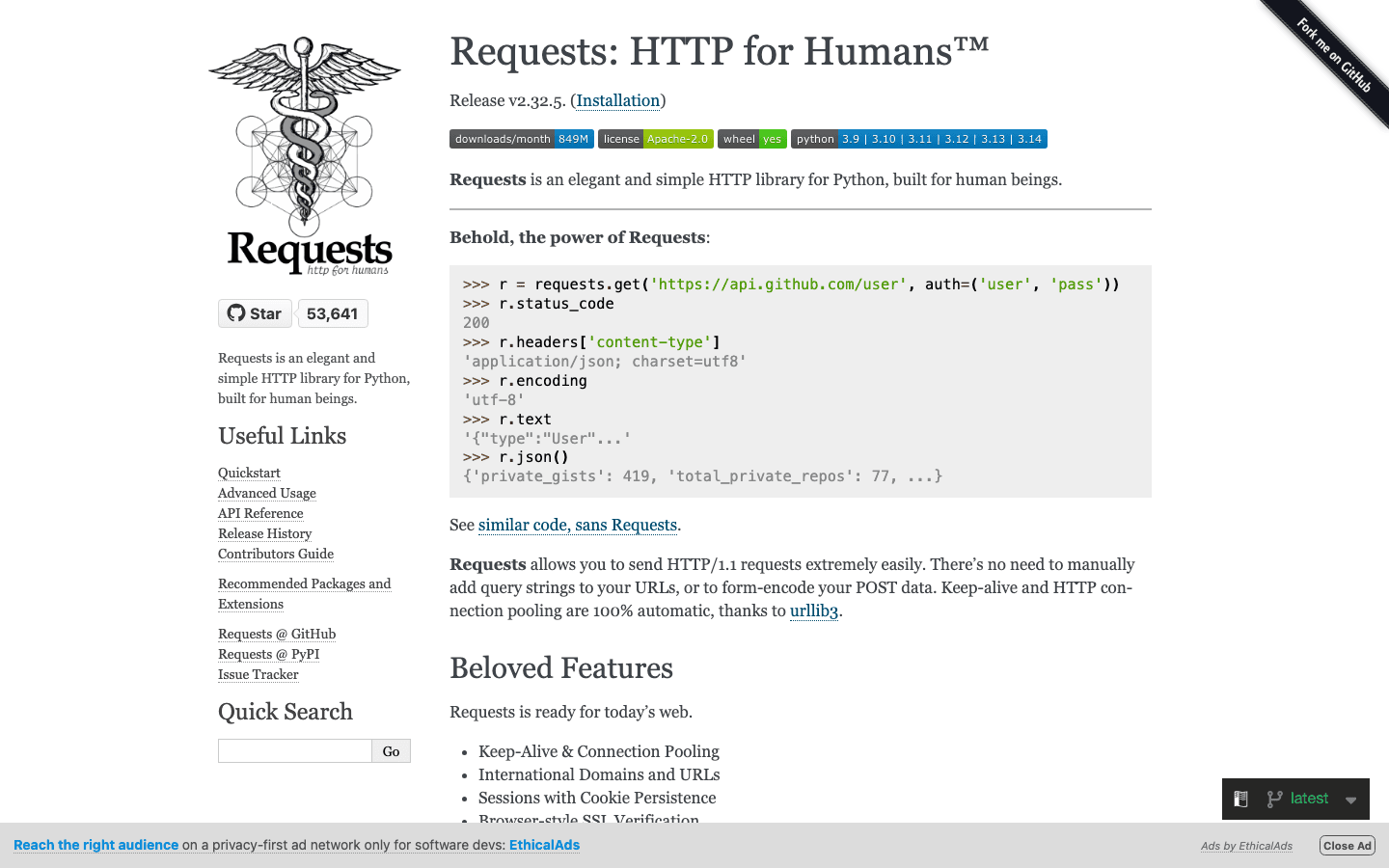

4. Requests

é a biblioteca HTTP essencial do Python. É a base de muitos fluxos de 웹 스크래퍼, facilitando o envio de requisições GET/POST e o tratamento das respostas.

é a biblioteca HTTP essencial do Python. É a base de muitos fluxos de 웹 스크래퍼, facilitando o envio de requisições GET/POST e o tratamento das respostas.

Principais recursos:

- API limpa e pythonica pra requisições HTTP

- Gerencia cookies, sessões e autenticação

- Integra fácil com parsers como Beautiful Soup e LXML

Melhores usos: Buscar páginas estáticas, APIs ou como base pra 웹 스크래퍼 personalizado.

Vantagens:

- Extremamente fácil de usar

- Confiável e bem mantida

- Perfeita pra scripts rápidos e prototipagem

Desvantagens:

- Não faz parsing de HTML nativamente

- Não lida com conteúdo renderizado por JavaScript

Dica de quem manja: Combine Requests com Beautiful Soup ou LXML pra uma pilha leve e eficiente de 웹 스크래퍼.

5. LXML

é a opção mais rápida pra análise de HTML/XML em Python. Se você precisa processar documentos enormes ou fazer consultas XPath complexas, LXML é a escolha.

é a opção mais rápida pra análise de HTML/XML em Python. Se você precisa processar documentos enormes ou fazer consultas XPath complexas, LXML é a escolha.

Principais recursos:

- Parsing ultrarrápido com backend em C

- Suporte completo a XPath e seletores CSS

- Lida tanto com HTML quanto com XML

Melhores usos: Análise em larga escala, estruturas de documentos complexas, projetos onde desempenho é prioridade.

Vantagens:

- Muito mais rápido que Beautiful Soup em grandes volumes

- Suporte poderoso a seletores

- Tratamento robusto de erros

Desvantagens:

- Menos tolerante a HTML malformado

- Curva de aprendizado um pouco maior

Dica de quem manja: Use LXML como parser do Beautiful Soup pra unir facilidade de uso e desempenho.

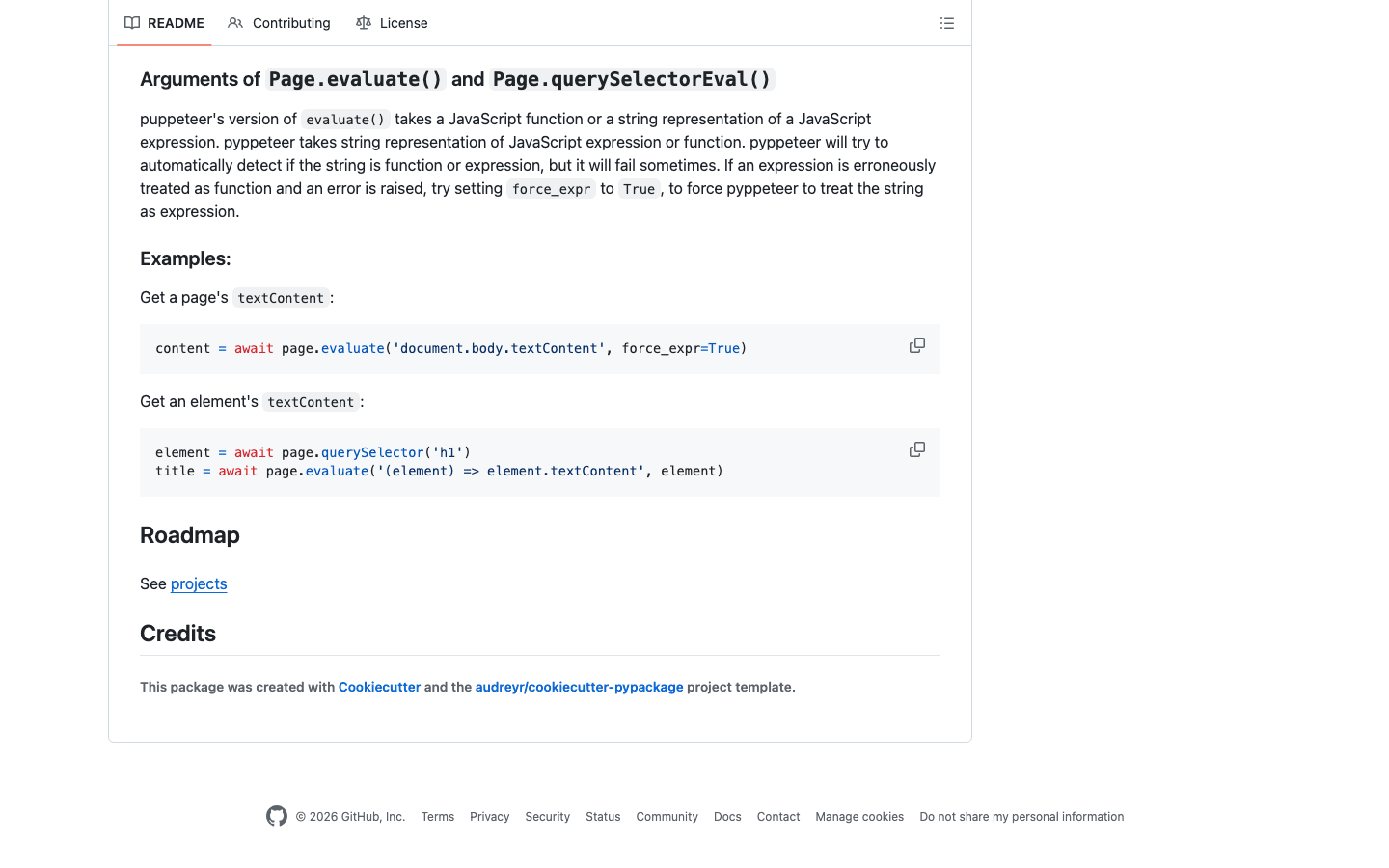

6. Pyppeteer

é a versão Python do Puppeteer, permitindo controlar o Chrome headless pra tarefas avançadas de 웹 스크래퍼. Ideal pra web apps modernos e pesados em JavaScript.

é a versão Python do Puppeteer, permitindo controlar o Chrome headless pra tarefas avançadas de 웹 스크래퍼. Ideal pra web apps modernos e pesados em JavaScript.

Principais recursos:

- Controle total do Chrome headless (ou Chromium)

- Excelente renderização de JavaScript e simulação de usuário

- Lida com navegação complexa, capturas de tela e geração de PDFs

Melhores usos: 웹 스크래퍼 de sites modernos e dinâmicos, automação de fluxos de usuário, contornar bloqueios anti-bot.

Vantagens:

- Suporte de alto nível a JavaScript

- Simula comportamento humano pra sites difíceis

- Ótimo pra SPAs (Single Page Apps)

Desvantagens:

- Mais pesado e lento que Requests ou Scrapy

- Manutenção pode variar — sempre confira se está atualizado

- Requer configuração extra

Dica de quem manja: Pra sites que não funcionam com Selenium, o Pyppeteer costuma resolver. Pra fluxos de negócios, use a IA do Thunderbit pra definir campos e depois use o Pyppeteer pra navegação.

7. Splash

é um navegador leve feito pra renderizar JavaScript em escala. É muito usado junto com o Scrapy pra raspar sites dinâmicos.

é um navegador leve feito pra renderizar JavaScript em escala. É muito usado junto com o Scrapy pra raspar sites dinâmicos.

Principais recursos:

- Navegador headless com API HTTP

- Renderiza JavaScript e retorna HTML, capturas de tela ou arquivos HAR

- Integração com Scrapy via middleware

Melhores usos: Processamento em lote de páginas dinâmicas, pipelines escaláveis de 웹 스크래퍼, renderização server-side.

Vantagens:

- Rápido e eficiente pra renderização em escala

- Baseado em API — fácil de integrar

- Consome menos recursos que automação de navegador completa

Desvantagens:

- Interatividade limitada comparado a Selenium ou Pyppeteer

- Exige configuração e aprendizado inicial

Dica de quem manja: Pra 웹 스크래퍼 em larga escala de sites dinâmicos, Scrapy + Splash é uma dupla poderosa.

8. MechanicalSoup

é uma biblioteca Python leve pra automação de formulários web e navegação simples. Usa Requests e Beautiful Soup por baixo dos panos.

é uma biblioteca Python leve pra automação de formulários web e navegação simples. Usa Requests e Beautiful Soup por baixo dos panos.

Principais recursos:

- Automatiza envio de formulários e navegação

- Mantém estado de sessão e cookies

- API simples e amigável pra quem tá começando

Melhores usos: Logins em sites, preenchimento de formulários, 웹 스크래퍼 de páginas estáticas ou pouco dinâmicas.

Vantagens:

- Configuração mínima — ótimo pra automação rápida

- Gerencia cookies e sessões automaticamente

- Perfeito pra sites com login ou formulários simples

Desvantagens:

- Não suporta JavaScript

- Não foi feita pra 웹 스크래퍼 em larga escala ou sites muito dinâmicos

Dica de quem manja: Use MechanicalSoup pra fluxos de login e depois continue com Requests + Beautiful Soup.

9. Twisted

é um motor de rede assíncrono pra Python. Não é um 웹 스크래퍼 por si só, mas serve de base pra pipelines personalizados de alta performance.

é um motor de rede assíncrono pra Python. Não é um 웹 스크래퍼 por si só, mas serve de base pra pipelines personalizados de alta performance.

Principais recursos:

- Rede assíncrona pra HTTP, TCP e mais

- Escala pra milhares de conexões simultâneas

- Usado em sistemas distribuídos de 웹 스크래퍼

Melhores usos: Construção de 웹 스크래퍼 personalizados de alto volume; integração com outros frameworks assíncronos.

Vantagens:

- Extremamente escalável e poderoso

- Suporte a vários protocolos

- Ótimo pra quem já é avançado

Desvantagens:

- Curva de aprendizado acentuada

- Exagero pra tarefas de 웹 스크래퍼 padrão

Dica de quem manja: Se você precisa raspar em escala massiva (milhões de páginas), vale a pena aprender Twisted.

10. Scrapy

é o canivete suíço dos frameworks de 웹 스크래퍼 em Python. Feito pra projetos de produção em larga escala, tem arquitetura assíncrona que permite rastrear milhares de páginas sem suar.

é o canivete suíço dos frameworks de 웹 스크래퍼 em Python. Feito pra projetos de produção em larga escala, tem arquitetura assíncrona que permite rastrear milhares de páginas sem suar.

Principais recursos:

- Motor assíncrono e orientado a eventos pra alta performance

- Suporte nativo a pipelines, middlewares e exportação de dados (JSON, CSV, XML)

- Gerencia rastreamento, parsing e limpeza de dados tudo em um só lugar

- Extensível com plugins pra proxies, user agents e mais

Melhores usos: 웹 스크래퍼 em nível empresarial, extração estruturada de dados, projetos que exigem velocidade e confiabilidade.

Vantagens:

- Muito rápido pra grandes volumes

- Altamente customizável e extensível

- Comunidade forte e documentação completa

Desvantagens:

- Curva de aprendizado pra quem tá começando

- Não é ideal pra sites dinâmicos pesados em JavaScript sem complementos

Dica de quem manja: Scrapy funciona muito bem com pra renderização de JavaScript, ou com pra detecção de campos via IA e estruturação de dados.

11. PyQuery

traz seletores no estilo jQuery pro Python. Se você curte a sintaxe do jQuery, vai se sentir em casa.

traz seletores no estilo jQuery pro Python. Se você curte a sintaxe do jQuery, vai se sentir em casa.

Principais recursos:

- API parecida com jQuery pra selecionar e manipular HTML

- Baseado em lxml pra velocidade

- Suporte a seletores CSS e manipulação do DOM

Melhores usos: Devs que já manjam de jQuery, prototipagem rápida, projetos que exigem seletores ágeis.

Vantagens:

- Rápido e eficiente

- Intuitivo pra quem já usou jQuery

- Bom pra parsing e modificação de HTML

Desvantagens:

- Comunidade menor que Beautiful Soup ou LXML

- Suporte limitado a HTML malformado

Dica de quem manja: Use PyQuery quando quiser o desempenho do lxml, mas prefere seletores CSS ao invés de XPath.

12. Parsel

é uma biblioteca poderosa pra extrair dados de HTML e XML usando XPath e seletores CSS. É o segredo por trás do motor de parsing do Scrapy.

é uma biblioteca poderosa pra extrair dados de HTML e XML usando XPath e seletores CSS. É o segredo por trás do motor de parsing do Scrapy.

Principais recursos:

- Suporte avançado a XPath e seletores CSS

- API limpa pra extração e limpeza de dados

- Pode ser usada sozinha ou dentro do Scrapy

Melhores usos: Extração de dados complexos, projetos que exigem lógica robusta de seletores, integração com Scrapy.

Vantagens:

- Extremamente flexível e poderosa

- Ótima pra lidar com layouts de página complicados

- Bem documentada e mantida

Desvantagens:

- Exige conhecimento de seletores

- Não é um framework completo de 웹 스크래퍼 — melhor como componente de parsing

Dica de quem manja: Use Parsel pro trabalho pesado em spiders customizadas do Scrapy ou scripts de parsing independentes.

Tabela Comparativa: Ferramentas Python de 웹 스크래퍼 em Resumo

| Biblioteca | Principais Recursos | Desempenho | Facilidade de Uso | Suporte a JavaScript | Melhor Para | Opções de Integração |

|---|---|---|---|---|---|---|

| Thunderbit | IA, sem código, subpáginas | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Sim (baseada em navegador) | Usuários de negócios, fluxos híbridos | Excel, Sheets, Notion, Python |

| Beautiful Soup | Parsing HTML/XML, tolerante | ⭐⭐ | ⭐⭐⭐⭐⭐ | Não | Limpeza de dados, tarefas pequenas | Requests, LXML, Thunderbit |

| Selenium | Automação de navegador, conteúdo dinâmico | ⭐⭐ | ⭐⭐ | Sim | Sites dinâmicos, interação de usuário | Beautiful Soup, PyQuery |

| Requests | Requisições HTTP, sessões | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Não | Páginas estáticas, APIs | Beautiful Soup, LXML |

| LXML | Parsing rápido, XPath, seletores CSS | ⭐⭐⭐⭐ | ⭐⭐⭐ | Não | Documentos grandes, parsing complexo | Beautiful Soup, PyQuery |

| Pyppeteer | Chrome headless, renderização JS | ⭐⭐ | ⭐⭐ | Sim | Sites JS modernos, SPAs | Thunderbit, Pandas |

| Splash | Renderização JS, API | ⭐⭐⭐ | ⭐⭐ | Sim | 웹 스크래퍼 JS em lote, pipelines | Scrapy, Thunderbit |

| MechanicalSoup | Manipulação de formulários, navegação | ⭐⭐ | ⭐⭐⭐⭐ | Não | Formulários simples, logins | Requests, Beautiful Soup |

| Twisted | Rede assíncrona, pipelines customizados | ⭐⭐⭐⭐⭐ | ⭐ | Não | Alto volume, 웹 스크래퍼 customizados | Scrapy, frameworks próprios |

| Scrapy | Alta performance, assíncrono, pipelines | ⭐⭐⭐⭐⭐ | ⭐⭐ | Limitado (via Splash) | Escala empresarial, dados estruturados | Splash, Parsel, Thunderbit |

| PyQuery | Seletores estilo jQuery, rápido | ⭐⭐⭐ | ⭐⭐⭐⭐ | Não | Fãs de jQuery, prototipagem rápida | LXML, Requests |

| Parsel | XPath/CSS, parsing flexível | ⭐⭐⭐⭐ | ⭐⭐⭐ | Não | Extração complexa, usuários Scrapy | Scrapy, Independente |

Como Escolher a Melhor Biblioteca Python de 웹 스크래퍼 pra Você

Olha um resumo pra te ajudar a decidir:

-

Vai lidar com páginas estáticas ou APIs?

Use Requests + Beautiful Soup ou LXML. -

Precisa raspar grandes volumes, rápido?

Scrapy é a melhor pedida. Pra rede assíncrona, pense em Twisted. -

Vai raspar sites dinâmicos e pesados em JavaScript?

Tente Selenium, Pyppeteer ou Splash (com Scrapy). -

Prefere seletores estilo jQuery?

PyQuery é a escolha. -

Precisa automatizar formulários ou logins?

MechanicalSoup é simples e eficiente. -

Não programa ou quer economizar tempo na configuração?

Thunderbit deixa você definir o que quer em linguagem natural e exporta dados estruturados pras suas ferramentas favoritas. -

Quer uma abordagem híbrida?

Use Thunderbit pra prototipar e estruturar dados rapidinho, depois processe em scripts Python.

Checklist pra escolher sua ferramenta:

- O site é estático ou dinâmico?

- Qual o volume de dados a ser extraído?

- Precisa interagir com formulários ou logins?

- Qual seu nível de conforto com Python e seletores?

- Precisa exportar pra ferramentas de negócios (Excel, Sheets, Notion)?

- Manutenção contínua é uma preocupação?

Conclusão: Desbloqueando o Poder do 웹 스크래퍼 em Python em 2026

웹 스크래퍼 com Python nunca foi tão poderoso — nem tão acessível. Seja escalando com Scrapy, limpando dados com Beautiful Soup, lidando com JavaScript via Selenium ou Pyppeteer, ou só querendo jogar dados na planilha sem escrever código, tem uma ferramenta pra você.

O segredo? Não tenha medo de misturar ferramentas. Cada biblioteca Python de 웹 스크래퍼 tem seus pontos fortes, e combinar (ou adicionar soluções com IA como o ) pode economizar horas, evitar dor de cabeça e gerar novos insights pro seu negócio.

Em 2026, não ganham só os programadores mais rápidos — ganham quem usa a ferramenta certa pra cada tarefa, automatiza o que é repetitivo e foca no que importa: transformar dados da web em valor real pro negócio.

Perguntas Frequentes

1. Qual a melhor biblioteca Python pra 웹 스크래퍼 pra quem tá começando?

Beautiful Soup é super recomendada pra iniciantes, por ser fácil de usar e tolerante a erros. Pra quem não programa, o Thunderbit é uma alternativa sem código, baseada em IA.

2. Qual ferramenta Python é melhor pra sites dinâmicos ou pesados em JavaScript?

Selenium, Pyppeteer e Splash são as melhores opções pra raspar conteúdo dinâmico. Pyppeteer brilha especialmente em apps modernos em JavaScript.

3. Posso combinar Thunderbit com bibliotecas Python como Scrapy ou Beautiful Soup?

Com certeza! O Thunderbit estrutura e exporta dados rapidinho, que você pode processar depois com suas bibliotecas Python favoritas.

4. Qual a biblioteca Python mais rápida pra analisar grandes documentos HTML?

LXML costuma ser a mais rápida pra parsing em larga escala, especialmente usando XPath ou seletores CSS.

5. Como escolher entre Scrapy e Selenium?

Use Scrapy pra 웹 스크래퍼 estruturada e em grande escala de sites mais estáticos. Prefira Selenium quando precisar interagir com elementos dinâmicos, logins ou páginas pesadas em JavaScript.

Quer ver como o Thunderbit pode turbinar seu fluxo de 웹 스크래퍼? e confira mais dicas no . Boas raspagens!

Saiba Mais