Gerir um site em 2025 pode ser uma verdadeira maratona. Num dia estás a corrigir links partidos, no outro já estás a planear uma migração de conteúdos, e de repente dás por ti a perguntar porque raio o Google indexou aquela página de “teste” de 2019. Eu conheço bem esse filme — já passei por isso mais vezes do que gostaria de admitir. E se és como eu, provavelmente já deste por ti a pesquisar no Google “melhor website crawler gratuito” às três da manhã, a torcer para encontrar uma ferramenta simples (e que não exija um curso de informática).

Mas há um detalhe importante: nem todo raspador de site é igual — e, spoiler, muita gente confunde “website crawler” com “web scraper” como se fossem a mesma coisa. Não são. Neste artigo, vou explicar a diferença, mostrar porque os crawlers online são mais importantes do que nunca e apresentar-te as 10 melhores opções gratuitas para 2025. E, como cofundador da , também vou dizer-te quando vale a pena saltar a parte técnica e usar uma solução com IA que te entrega exatamente os dados que precisas. Bora lá?

O que é um Website Crawler? Percebe o Conceito

Primeiro, vamos pôr tudo em pratos limpos: um website crawler não é o mesmo que um web scraper. Eu sei, os termos são usados como se fossem sinónimos, mas têm funções bem diferentes. Imagina o crawler como o cartógrafo do teu site — ele explora cada recanto, segue todos os links e constrói um mapa de todas as páginas. O objetivo é descobrir: encontrar URLs, mapear a estrutura do site e indexar o conteúdo. É assim que funcionam motores de busca como o Google, e também as ferramentas de SEO que analisam a saúde do teu site ().

Já o web scraper é como um garimpeiro de dados. Não quer o mapa todo — só está interessado no ouro: preços de produtos, nomes de empresas, avaliações, e-mails, entre outros. O scraper extrai campos específicos das páginas que o crawler encontra ().

Para simplificar, pensa assim:

- Crawler: É quem percorre todos os corredores do supermercado e anota todos os produtos.

- Scraper: Vai direto à prateleira do café e regista o preço de cada marca orgânica.

Porque é que isto interessa? Porque se só queres encontrar todas as páginas do teu site (para uma auditoria de SEO, por exemplo), precisas de um crawler. Se queres recolher todos os preços de produtos do site do concorrente, precisas de um scraper — ou, melhor ainda, de uma ferramenta que faça as duas coisas.

Porque Usar um Website Crawler Online? Vantagens para o Teu Negócio

Porque investir num crawler online em 2025? O mundo digital não pára de crescer. Mais de para otimizar os seus sites, e algumas ferramentas de SEO chegam a rastrear .

Vê o que um crawler pode fazer por ti:

- Auditorias de SEO: Identifica links partidos, títulos em falta, conteúdo duplicado, páginas órfãs e muito mais ().

- Verificação de Links & QA: Deteta erros 404 e loops de redirecionamento antes que os teus utilizadores reparem ().

- Geração de Sitemap: Cria sitemaps XML automaticamente para motores de busca e planeamento ().

- Inventário de Conteúdo: Lista todas as páginas, hierarquia e metadados do teu site.

- Conformidade & Acessibilidade: Verifica cada página quanto a requisitos de acessibilidade, SEO e normas legais ().

- Performance & Segurança: Identifica páginas lentas, imagens pesadas ou falhas de segurança ().

- Dados para IA & Análises: Alimenta ferramentas de análise ou IA com os dados recolhidos ().

Confere esta tabela rápida que relaciona casos de uso e perfis de negócio:

| Caso de Uso | Ideal Para | Benefício / Resultado |

|---|---|---|

| SEO & Auditoria de Site | Marketing, SEO, Pequenos Negócios | Identifique problemas técnicos, otimize estrutura, melhore rankings |

| Inventário de Conteúdo & QA | Gestores de Conteúdo, Webmasters | Audite ou migre conteúdo, encontre links/imagens quebrados |

| Geração de Leads (Scraping) | Vendas, Desenvolvimento de Negócios | Automatize prospecção, alimente o CRM com novos leads |

| Inteligência Competitiva | E-commerce, Gerentes de Produto | Monitore preços, lançamentos e estoque dos concorrentes |

| Clonagem de Sitemap & Estrutura | Desenvolvedores, DevOps, Consultores | Clone a estrutura do site para redesigns ou backups |

| Agregação de Conteúdo | Pesquisadores, Mídia, Analistas | Reúna dados de vários sites para análise ou tendências |

| Pesquisa de Mercado | Analistas, Equipes de IA | Colete grandes volumes de dados para análise ou treinamento de IA |

()

Como Escolhemos os Melhores Website Crawlers Gratuitos

Passei muitas noites (e litros de café) a testar crawlers, a ler documentação e a fazer experiências. Eis o que tive em conta:

- Capacidade Técnica: Aguenta sites modernos (JavaScript, login, conteúdo dinâmico)?

- Facilidade de Utilização: É fácil para quem não é técnico ou exige comandos avançados?

- Limites do Plano Gratuito: É mesmo grátis ou só uma amostra?

- Acesso Online: É uma ferramenta na nuvem, app de desktop ou biblioteca de código?

- Diferenciais: Tem algo especial — como extração por IA, sitemaps visuais ou crawling por eventos?

Testei cada ferramenta, avaliei feedback de utilizadores e comparei funcionalidades lado a lado. Se alguma me fez querer atirar o portátil pela janela, ficou de fora.

Tabela Comparativa: 10 Melhores Website Crawlers Gratuitos

| Ferramenta & Tipo | Principais Recursos | Melhor Uso | Requisitos Técnicos | Detalhes do Plano Gratuito |

|---|---|---|---|---|

| BrightData (Cloud/API) | Crawling corporativo, proxies, renderização JS, resolução de CAPTCHA | Coleta de dados em larga escala | Algum conhecimento técnico | Teste grátis: 3 scrapers, 100 registros cada (cerca de 300 registros) |

| Crawlbase (Cloud/API) | Crawling via API, anti-bot, proxies, renderização JS | Devs que precisam de infraestrutura backend | Integração via API | Grátis: ~5.000 chamadas API por 7 dias, depois 1.000/mês |

| ScraperAPI (Cloud/API) | Rotação de proxy, renderização JS, crawl assíncrono, endpoints prontos | Devs, monitoramento de preços, SEO | Configuração mínima | Grátis: 5.000 chamadas API por 7 dias, depois 1.000/mês |

| Diffbot Crawlbot (Cloud) | Crawl + extração por IA, knowledge graph, renderização JS | Dados estruturados em escala, IA/ML | Integração via API | Grátis: 10.000 créditos/mês (cerca de 10k páginas) |

| Screaming Frog (Desktop) | Auditoria SEO, análise de links/metadados, sitemap, extração customizada | Auditorias SEO, gestores de sites | App desktop, GUI | Grátis: 500 URLs por crawl, recursos básicos |

| SiteOne Crawler (Desktop) | SEO, performance, acessibilidade, segurança, exportação offline, Markdown | Devs, QA, migração, documentação | Desktop/CLI, GUI | Grátis e open-source, 1.000 URLs no relatório GUI (ajustável) |

| Crawljax (Java, OpenSrc) | Crawling por eventos para sites JS, exportação estática | Devs, QA de apps dinâmicos | Java, CLI/config | Grátis e open-source, sem limites |

| Apache Nutch (Java, OpenSrc) | Distribuído, plugins, integração Hadoop, busca customizada | Motores de busca próprios, crawling em larga escala | Java, linha de comando | Grátis e open-source, só custo de infraestrutura |

| YaCy (Java, OpenSrc) | Crawling peer-to-peer, privacidade, indexação web/intranet | Busca privada, descentralização | Java, interface web | Grátis e open-source, sem limites |

| PowerMapper (Desktop/SaaS) | Sitemaps visuais, acessibilidade, QA, compatibilidade de navegador | Agências, QA, mapeamento visual | GUI, fácil | Teste grátis: 30 dias, 100 páginas (desktop) ou 10 páginas (online) por scan |

BrightData: Crawler de Sites Corporativo na Nuvem

O BrightData é o “peso pesado” do web crawling. Plataforma cloud com uma rede gigante de proxies, renderização JavaScript, resolução de CAPTCHAs e IDE para crawls personalizados. Se precisas de monitorizar centenas de sites de e-commerce para preços, a infraestrutura do BrightData é imbatível ().

Vantagens:

- Lida com sites difíceis e anti-bot

- Escalável para grandes volumes

- Templates prontos para sites populares

Desvantagens:

- Não tem plano gratuito permanente (só teste: 3 scrapers, 100 registos cada)

- Pode ser “overkill” para auditorias simples

- Exige alguma aprendizagem para iniciantes

Se precisas de crawling em grande escala, o BrightData é como alugar um Fórmula 1. Só não esperes que seja grátis depois do test drive ().

Crawlbase: Crawler Gratuito via API para Programadores

O Crawlbase (antigo ProxyCrawl) é feito para crawling programático. Envias a URL para a API e recebes o HTML — proxies, geolocalização e CAPTCHAs são resolvidos automaticamente ().

Vantagens:

- Taxa de sucesso altíssima (99%+)

- Suporta sites pesados em JavaScript

- Ótimo para integrar em apps próprios

Desvantagens:

- Requer integração via API ou SDK

- Plano gratuito: ~5.000 chamadas API por 7 dias, depois 1.000/mês

Se és dev e queres escalar crawling (e scraping) sem dores de cabeça com proxies, o Crawlbase é uma excelente escolha ().

ScraperAPI: Crawling Dinâmico Simplificado

O ScraperAPI é o “vai lá buscar isso para mim” das APIs. Envias a URL, ele trata dos proxies, browsers headless, anti-bot e devolve o HTML (ou dados estruturados em alguns casos). É excelente para páginas dinâmicas e tem um plano gratuito generoso ().

Vantagens:

- Muito fácil para devs (basta uma chamada de API)

- Lida com CAPTCHAs, IP bans, JavaScript

- Grátis: 5.000 chamadas API por 7 dias, depois 1.000/mês

Desvantagens:

- Não gera relatórios visuais

- Precisas programar a lógica de navegação entre páginas

Se queres integrar crawling ao teu código em minutos, o ScraperAPI é aposta segura.

Diffbot Crawlbot: Descoberta Estruturada Automatizada

O Diffbot Crawlbot vai além do crawling: usa IA para classificar páginas e extrair dados estruturados (artigos, produtos, eventos, etc.) em JSON. É como ter um estagiário robô que percebe mesmo o que está a ler ().

Vantagens:

- Extração por IA, não só crawling

- Suporta JavaScript e conteúdo dinâmico

- Grátis: 10.000 créditos/mês (cerca de 10k páginas)

Desvantagens:

- Focado em devs (integração via API)

- Não é uma ferramenta visual de SEO — ideal para projetos de dados

Se precisas de dados estruturados em escala, especialmente para IA ou análises, o Diffbot é uma potência.

Screaming Frog: Crawler SEO Gratuito para Desktop

O Screaming Frog é o clássico dos crawlers de desktop para auditorias SEO. Rastreia até 500 URLs por varredura (versão gratuita) e entrega tudo: links partidos, metadados, conteúdo duplicado, sitemaps e mais ().

Vantagens:

- Rápido, completo e referência no SEO

- Não exige programação — basta colar a URL

- Grátis até 500 URLs por varredura

Desvantagens:

- Só para desktop (não tem versão cloud)

- Funcionalidades avançadas (renderização JS, agendamento) só na versão paga

Se levas o SEO a sério, o Screaming Frog é obrigatório — só não esperes rastrear 10 mil páginas à borla.

SiteOne Crawler: Exportação Estática e Documentação

O SiteOne Crawler é o canivete suíço das auditorias técnicas. Open-source, multiplataforma, faz crawling, auditoria e ainda exporta o site em Markdown para documentação ou uso offline ().

Vantagens:

- Cobre SEO, performance, acessibilidade e segurança

- Exporta sites para arquivo ou migração

- Grátis e open-source, sem limites de uso

Desvantagens:

- Mais técnico do que algumas ferramentas GUI

- Relatório GUI limitado a 1.000 URLs por padrão (ajustável)

Se és dev, QA ou consultor e gostas de open source, o SiteOne é uma pérola.

Crawljax: Crawler Open Source para Páginas Dinâmicas

O Crawljax é especialista em rastrear web apps modernos e pesados em JavaScript, simulando interações de utilizador (cliques, formulários, etc.). É orientado a eventos e pode até gerar uma versão estática de sites dinâmicos ().

Vantagens:

- Imbatível para SPAs e sites AJAX

- Open-source e extensível

- Sem limites de uso

Desvantagens:

- Requer Java e alguma configuração/programação

- Não indicado para quem não é técnico

Se precisas de rastrear apps em React ou Angular como um utilizador real, o Crawljax é o ideal.

Apache Nutch: Crawler Distribuído e Escalável

O Apache Nutch é o pioneiro dos crawlers open-source. Feito para crawls massivos e distribuídos — perfeito para criar o teu próprio motor de busca ou indexar milhões de páginas ().

Vantagens:

- Escala para biliões de páginas com Hadoop

- Altamente configurável e extensível

- Grátis e open-source

Desvantagens:

- Curva de aprendizagem alta (Java, linha de comandos, configs)

- Não indicado para sites pequenos ou uso casual

Se queres crawling em grande escala e não tens medo de comandos, o Nutch é para ti.

YaCy: Crawler Peer-to-Peer e Motor de Busca

O YaCy é um crawler e motor de busca descentralizado. Cada instância rastreia e indexa sites, e podes juntar-te a uma rede peer-to-peer para partilhar índices ().

Vantagens:

- Foco na privacidade, sem servidor central

- Ótimo para buscas privadas ou em intranets

- Grátis e open-source

Desvantagens:

- Resultados dependem da cobertura da rede

- Requer configuração (Java, interface web)

Se gostas de descentralização ou queres o teu próprio motor de busca, o YaCy é uma opção interessante.

PowerMapper: Gerador Visual de Sitemap para UX e QA

O PowerMapper é focado em visualizar a estrutura do site. Rastreia e gera sitemaps interativos, além de verificar acessibilidade, compatibilidade de browser e requisitos básicos de SEO ().

Vantagens:

- Sitemaps visuais ideais para agências e designers

- Verifica acessibilidade e conformidade

- Interface fácil, sem complicações técnicas

Desvantagens:

- Só teste grátis (30 dias, 100 páginas desktop/10 online por scan)

- Versão completa é paga

Se precisas de apresentar um mapa do site a clientes ou verificar conformidade, o PowerMapper é prático.

Como Escolher o Melhor Website Crawler Gratuito para Ti

Com tanta oferta, como decidir? Aqui vai um guia rápido:

- Para auditorias SEO: Screaming Frog (sites pequenos), PowerMapper (visual), SiteOne (auditorias profundas)

- Para web apps dinâmicos: Crawljax

- Para crawling em larga escala ou busca personalizada: Apache Nutch, YaCy

- Para devs que querem API: Crawlbase, ScraperAPI, Diffbot

- Para documentação ou arquivo: SiteOne Crawler

- Para uso corporativo com teste grátis: BrightData, Diffbot

Fatores a considerar:

- Escalabilidade: Qual o tamanho do teu site ou projeto?

- Facilidade de uso: Preferes código ou interface visual?

- Exportação de dados: Precisas de CSV, JSON ou integração com outras ferramentas?

- Suporte: Existe comunidade ou documentação de apoio?

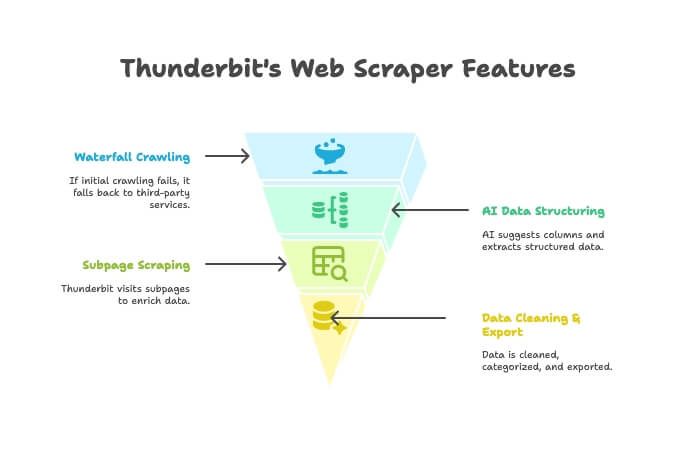

Quando Web Crawling se Junta ao Web Scraping: Por Que Thunderbit é a Solução Mais Inteligente

A verdade é: a maioria das pessoas não faz crawling só para criar mapas bonitos. O objetivo real é obter dados estruturados — seja lista de produtos, contactos ou inventário de conteúdos. É aqui que entra o .

O Thunderbit não é só crawler ou scraper — é uma extensão Chrome com IA que junta as duas funções. Vê como funciona:

- Crawler com IA: O Thunderbit explora o site como um crawler tradicional.

- Crawling em Cascata: Se o motor próprio não conseguir aceder à página (por bloqueios, por exemplo), usa serviços de crawling de terceiros automaticamente — sem mexeres em nada.

- Estruturação Inteligente de Dados: Depois de obter o HTML, a IA do Thunderbit sugere colunas e extrai dados estruturados (nomes, preços, e-mails, etc.) sem precisares de configurar seletores.

- Scraping de Subpáginas: Precisas de detalhes de cada página de produto? O Thunderbit visita cada subpágina e enriquece a tua tabela.

- Limpeza & Exportação de Dados: Resume, categoriza, traduz e exporta para Excel, Google Sheets, Airtable ou Notion num clique.

- Simplicidade Total: Se sabes usar um browser, sabes usar o Thunderbit. Sem código, sem proxies, sem complicações.

Quando usar Thunderbit em vez de um crawler tradicional?

- Quando queres uma folha de cálculo pronta a usar — não só uma lista de URLs.

- Quando queres automatizar todo o processo (crawling, extração, limpeza, exportação) num só sítio.

- Quando valorizas o teu tempo e praticidade.

Podes e perceber porque tantos profissionais estão a mudar.

Conclusão: Liberta o Potencial dos Website Crawlers Gratuitos em 2025

Os crawlers evoluíram imenso. Sejas tu marketeer, programador ou alguém que só quer manter o site em ordem, há uma ferramenta gratuita (ou pelo menos com teste grátis) para ti. Desde plataformas robustas como BrightData e Diffbot, passando por soluções open-source como SiteOne e Crawljax, até mapeadores visuais como PowerMapper, nunca houve tanta escolha.

Mas se procuras uma forma mais inteligente e integrada de transformar “preciso destes dados” em “aqui está a minha folha de cálculo”, experimenta o Thunderbit. Foi feito para quem quer resultados, não só relatórios.

Pronto para começar? Escolhe uma ferramenta, faz um scan e descobre o que andava a faltar. E se quiseres ir do crawling ao dado pronto em dois cliques, .

Para mais dicas e tutoriais práticos, visita o .

FAQ

Qual a diferença entre website crawler e web scraper?

O crawler descobre e mapeia todas as páginas de um site (como criar um índice). O scraper extrai campos específicos (preços, e-mails, avaliações) dessas páginas. O crawler encontra, o scraper recolhe ().

Qual crawler gratuito é melhor para quem não é técnico?

Para sites pequenos e auditorias SEO, o Screaming Frog é fácil de usar. Para mapas visuais, o PowerMapper é ótimo (enquanto dura o teste). O Thunderbit é o mais simples se queres dados estruturados e experiência sem código, direto no browser.

Existem sites que bloqueiam crawlers?

Sim — alguns usam ficheiros robots.txt ou barreiras anti-bot (CAPTCHAs, bloqueio de IP) para travar crawlers. Ferramentas como ScraperAPI, Crawlbase e Thunderbit (com crawling em cascata) costumam contornar esses bloqueios, mas usa sempre com responsabilidade e respeita as regras do site ().

Crawlers gratuitos têm limites de páginas ou funcionalidades?

Quase todos têm. Por exemplo, o Screaming Frog gratuito limita a 500 URLs por varredura; o PowerMapper, a 100 páginas no teste. Ferramentas via API costumam ter créditos mensais. Já open-source como SiteOne ou Crawljax não têm limites rígidos, mas dependem do teu hardware.

Usar um crawler é legal e está em conformidade com a privacidade?

No geral, rastrear páginas públicas é permitido, mas confirma sempre os termos de uso e o robots.txt do site. Nunca rastrees dados privados ou protegidos por senha sem autorização, e tem atenção às leis de privacidade ao extrair dados pessoais ().