Il web è davvero una fonte inesauribile di dati e, se nel 2025 hai un’azienda, sai che chi riesce a mettere le mani sulle informazioni migliori e più in fretta parte sempre avvantaggiato. Che tu sia nel commerciale, nell’e-commerce, nelle operations o nella ricerca di mercato, la capacità di estrarre dati dai siti web — in grande quantità e quando serve — è ormai un asso nella manica. Python è diventato il linguaggio di riferimento per questo: quasi il lo sceglie per l’estrazione di dati dal web, grazie alle sue librerie e alla sua fama di essere potente ma accessibile.

Ma c’è una novità: anche se Python è lo strumento più flessibile per estrarre dati dai siti, non è l’unica strada. Oggi esistono soluzioni no-code come che permettono a chiunque — anche a chi non ha mai scritto una riga di codice — di raccogliere, pulire e organizzare dati web in pochi clic. In questa guida ti mostro entrambi gli approcci: il metodo classico con Python (Requests, Beautiful Soup, Selenium, Scrapy, Pandas) e come Thunderbit può farti risparmiare tempo. Troverai esempi pratici, casi d’uso aziendali e qualche dritta da chi ci lavora ogni giorno. Partiamo subito.

Cosa vuol dire "Python pull data from website"?

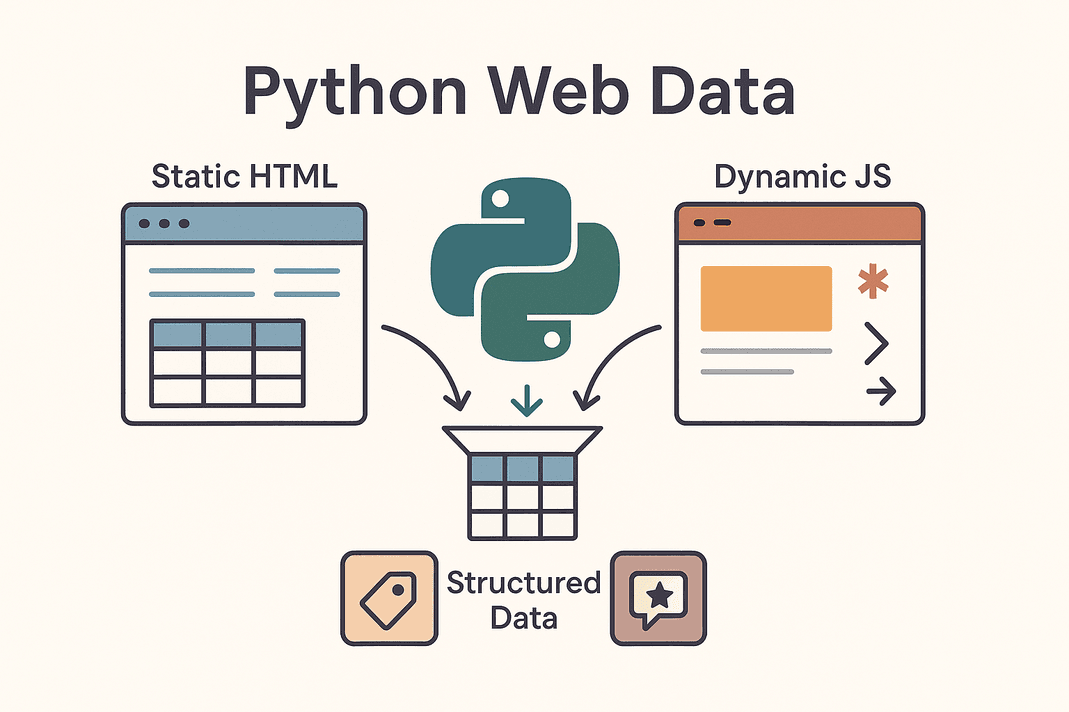

In parole semplici, "python pull data from website" significa usare script Python per recuperare ed estrarre automaticamente informazioni da pagine web, trasformando l’HTML caotico in dati ordinati e subito utilizzabili. Questa pratica si chiama web scraping. Invece di copiare a mano prezzi, contatti o recensioni, lasci che Python faccia il lavoro sporco.

In parole semplici, "python pull data from website" significa usare script Python per recuperare ed estrarre automaticamente informazioni da pagine web, trasformando l’HTML caotico in dati ordinati e subito utilizzabili. Questa pratica si chiama web scraping. Invece di copiare a mano prezzi, contatti o recensioni, lasci che Python faccia il lavoro sporco.

Ci sono due tipi principali di siti web:

- Siti statici: Tutto il contenuto è già nell’HTML che ricevi. Quello che vedi con “Visualizza sorgente” è quello che puoi estrarre. Qui il processo è diretto: scarichi l’HTML e lo analizzi.

- Siti dinamici: Usano JavaScript per caricare dati dopo che la pagina si è aperta. Pensa a scroll infiniti, prezzi che cambiano in tempo reale o contenuti che appaiono solo dopo un click. In questi casi serve simulare un browser (con strumenti come Selenium) o trovare le API nascoste che alimentano il sito ().

Le informazioni più richieste con il web scraping sono tabelle di prodotti, elenchi di lead, prezzi, recensioni, immagini e molto altro. Che tu debba costruire una lista di potenziali clienti, monitorare i prezzi dei concorrenti o raccogliere opinioni dal mercato, Python ti aiuta a trasformare il web nella tua fonte dati personale.

Perché le aziende scelgono Python per estrarre dati dai siti web

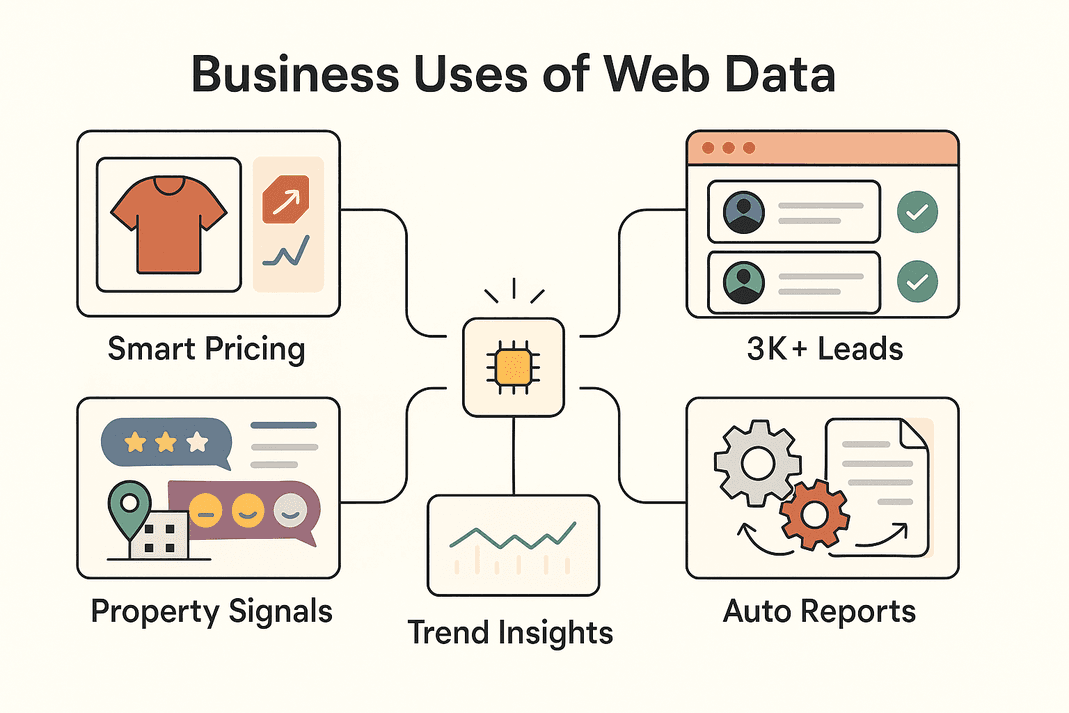

Andiamo dritti al punto: perché così tante aziende puntano sull’estrazione di dati dal web? Ecco alcuni degli usi più comuni — e il valore che portano:

| Caso d’uso aziendale | Dati estratti | ROI / Beneficio |

|---|---|---|

| Generazione Lead (Vendite) | Contatti da elenchi, social | Oltre 3.000 lead/mese, ~8 ore/settimana risparmiate per ogni commerciale (Thunderbit)) |

| Monitoraggio prezzi (E-commerce) | Prezzi prodotti, disponibilità | +4% vendite, -30% tempo analisti (blog.apify.com) |

| Ricerca di mercato | Recensioni, post social, commenti forum | Targeting più preciso; il 26% degli scraper punta ai social (Thunderbit) |

| Annunci immobiliari | Dati immobili, comparabili, statistiche | Scoperta più rapida di opportunità, dati sempre aggiornati |

| Automazione operativa | Inventari, report, dati ripetitivi | Risparmio del 10–50% sul lavoro manuale |

In breve: estrarre dati dal web con Python (o Thunderbit) permette ai team di lavorare più in fretta, prendere decisioni migliori e automatizzare attività ripetitive che prima portavano via ore. Non stupisce che il e continui a crescere a vista d’occhio.

Strumenti Python indispensabili per estrarre dati dai siti web

Il successo di Python nel web scraping è dovuto soprattutto al suo ecosistema. Ecco una panoramica dei principali strumenti e quando usarli:

| Strumento | Ideale per | Vantaggi | Svantaggi |

|---|---|---|---|

| Requests | Scaricare HTML statico o API | Semplice, veloce, perfetto per iniziare | Non gestisce JavaScript |

| Beautiful Soup | Analizzare HTML/XML in dati strutturati | Facile da usare, flessibile | Serve HTML già scaricato, non per siti JS |

| Selenium | Siti dinamici/ricchi di JS, login, click | Gestisce tutto ciò che fa un browser | Più lento, richiede più configurazione |

| Scrapy | Crawling su larga scala, multi-pagina | Veloce, asincrono, scalabile | Curva di apprendimento, no JS di default |

| Thunderbit | No-code/low-code, utenti business | AI, gestisce JS, esportazione facile | Meno personalizzabile per logiche complesse |

Nella pratica, spesso si usano più strumenti insieme: Requests + Beautiful Soup per lavori semplici, Selenium per siti dinamici, Scrapy per grandi volumi e Thunderbit quando servono rapidità e semplicità.

Step 1: Usare Python Requests per estrarre dati da un sito

Partiamo dalle basi. Requests è il cavallo di battaglia per scaricare pagine web in Python. Ecco come si usa:

-

Installa Requests:

1pip install requests -

Scarica una pagina:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Impossibile recuperare i dati: {response.status_code}")()

-

Consigli per la risoluzione dei problemi:

- Aggiungi headers per simulare un browser:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - Gestisci gli errori con

response.raise_for_status() - Per API che restituiscono JSON:

data = response.json()

- Aggiungi headers per simulare un browser:

Requests è perfetto per pagine statiche o API. Se però i dati non compaiono, probabilmente sono caricati via JavaScript: in questo caso serve Selenium.

Step 2: Analizzare il contenuto web con Beautiful Soup

Dopo aver ottenuto l’HTML, Beautiful Soup ti aiuta a estrarre le informazioni utili. Ecco come:

-

Installa Beautiful Soup:

1pip install beautifulsoup4 -

Analizza l’HTML:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

Estrai i dati:

- Trova tutte le schede prodotto:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - Per le tabelle:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # Estrai i dati delle celle come necessario

- Trova tutte le schede prodotto:

Consigli:

- Usa gli strumenti di sviluppo del browser per trovare i selettori giusti.

- Usa

.get_text()o.textper estrarre il testo. - Gestisci dati mancanti con controlli (

if price_elem else "N/A").

Requests + Beautiful Soup è la combinazione perfetta per la maggior parte dei siti statici: semplice, affidabile e veloce.

Step 3: Gestire contenuti dinamici con Selenium

Se un sito carica i dati tramite JavaScript, serve uno strumento che si comporti come un vero utente. Qui entra in gioco Selenium.

-

Installa Selenium:

1pip install seleniumScarica il driver del browser (es. ChromeDriver) e assicurati che sia nel PATH.

-

Automatizza il browser:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

Gestisci login e click:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

Attendi il caricamento dei contenuti dinamici:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

Modalità headless (senza finestra):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium è potente ma più pesante: ideale per siti che richiedono automazione completa del browser.

Step 4: Scalare con Scrapy per grandi volumi di dati

Se devi esplorare centinaia o migliaia di pagine, Scrapy è la scelta giusta.

-

Installa Scrapy:

1pip install scrapy 2scrapy startproject myproject -

Crea uno spider:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

Esegui lo spider:

1scrapy crawl products -o products.csv

Scrapy è asincrono, veloce e pensato per la scalabilità. Perfetto per esplorare interi siti o gestire paginazioni complesse.

Step 5: Potenziare l’estrazione dati con Thunderbit

Parliamo ora di : l’estrattore web AI senza codice che sta rivoluzionando il modo di lavorare dei team aziendali.

- AI Suggerisce i campi: Thunderbit analizza la pagina e suggerisce automaticamente le colonne migliori da estrarre — niente più caccia all’HTML.

- Gestisce pagine dinamiche: Visualizza la pagina come la vedi tu, quindi JavaScript, scroll infiniti e login non sono un problema.

- Estrazione da sottopagine: Thunderbit può cliccare su ogni dettaglio e arricchire il tuo dataset in automatico.

- Template preimpostati: Per siti come Amazon, Zillow o Shopify, puoi usare modelli pronti all’uso — nessuna configurazione necessaria.

- Estrazione con un clic: Vuoi tutte le email o i numeri di telefono di una pagina? Thunderbit lo fa in un attimo.

- Pianificazione e cloud scraping: Imposta estrazioni ricorrenti con linguaggio naturale (“ogni lunedì alle 9”) e lascia che il cloud Thunderbit gestisca fino a 50 pagine contemporaneamente.

- Esporta ovunque: Invia subito i dati su Excel, Google Sheets, Airtable, Notion o scarica in CSV/JSON — gratis e senza limiti.

Thunderbit è perfetto per i team che vogliono dati subito, senza scrivere codice. Puoi anche usare Thunderbit per estrarre i dati e poi analizzarli in Python: il meglio di entrambi i mondi.

Step 6: Pulire e analizzare i dati estratti con Pandas

Una volta ottenuti i dati (da Python o Thunderbit), è il momento di pulirli e analizzarli con Pandas.

-

Carica i dati:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

Pulisci i dati:

- Rimuovi i duplicati:

1df = df.drop_duplicates() - Gestisci i valori mancanti:

1df = df.fillna("N/A") - Uniforma i formati (es. prezzi):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- Rimuovi i duplicati:

-

Analizza:

- Statistiche rapide:

1print(df.describe()) - Raggruppa per categoria:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- Statistiche rapide:

Pandas è lo strumento ideale per trasformare dati grezzi in informazioni utili per il business.

Step 7: Organizzare e archiviare i dati estratti per l’azienda

Ora che hai dati puliti, rendili accessibili al tuo team.

- CSV/Excel: Usa

df.to_csv("out.csv", index=False)odf.to_excel("out.xlsx")per condividerli facilmente. - Google Sheets: Usa o la libreria Python

gspread. - Database: Per grandi volumi, salva con

df.to_sql()su database SQL. - Automazione: Automatizza con script o pianificazioni Thunderbit per dati sempre aggiornati.

- Best practice: Timbra sempre i dati, documenta le colonne e limita l’accesso se sono sensibili.

Scegli il metodo di archiviazione più adatto al tuo team: fogli di calcolo per la rapidità, database per la scalabilità.

Thunderbit vs. Python: quale approccio scegliere per il tuo team?

Ecco un confronto diretto:

| Fattore | Thunderbit (AI senza codice) | Librerie Python (con codice) |

|---|---|---|

| Competenze richieste | Nessuna (interfaccia web) | Serve programmare in Python |

| Tempo di setup | Minuti (AI, scraping immediato) | Ore/giorni (scrittura, debug, configurazione) |

| Gestione JS/Interattività | Sì, integrata (browser/cloud) | Sì, ma serve Selenium/Playwright |

| Manutenzione | Bassa—l’AI si adatta ai cambiamenti dei siti | Manuale—aggiornare il codice se il sito cambia |

| Scalabilità | Media (veloce per decine/centinaia di pagine via cloud) | Alta (Scrapy scala a migliaia di pagine) |

| Personalizzazione | Tramite opzioni UI e prompt AI | Illimitata (qualsiasi logica/integrazione) |

| Anti-bot/Proxy | Gestito internamente | Da implementare manualmente |

| Esportazione dati | 1 clic su Sheets, Excel, Notion, Airtable | Serve codice personalizzato |

| Ideale per | Utenti non tecnici, risultati rapidi, poca manutenzione | Sviluppatori, progetti complessi o su larga scala |

Consiglio: Usa Thunderbit per risultati rapidi e per dare autonomia al team business. Scegli Python quando servono personalizzazioni avanzate o grandi volumi. Molte aziende usano entrambi: Thunderbit per validare e raccogliere dati velocemente, Python per automatizzare o scalare successivamente.

Applicazioni aziendali reali dell’estrazione dati dai siti web

Ecco come i team sfruttano questi strumenti nella pratica:

Ecco come i team sfruttano questi strumenti nella pratica:

- E-commerce: John Lewis ha monitorando i prezzi dei concorrenti e aggiornando i propri in tempo reale.

- Vendite: I team raccolgono oltre 3.000 lead/mese, risparmiando 8 ore/settimana per ogni commerciale ()) — addio ricerche manuali.

- Ricerca di mercato: I marketer estraggono migliaia di recensioni o post social per analisi di sentiment, individuando trend prima che arrivino nei dashboard.

- Immobiliare: Gli agenti analizzano annunci per scoprire immobili sottoprezzo o nuove opportunità di mercato — più velocemente rispetto agli aggiornamenti MLS.

- Automazione operativa: I team operations automatizzano controlli inventario, report o anche FAQ di supporto estraendo dati da siti partner o interni.

Spesso il flusso di lavoro è ibrido: Thunderbit per raccogliere i dati, Python per pulirli e analizzarli, poi esportazione su Sheets o database per il team.

Conclusioni e punti chiave

Estrarre dati dai siti web con Python (e Thunderbit) è una competenza fondamentale per i team aziendali moderni. Ecco la sintesi:

- Requests + Beautiful Soup: Ideale per siti statici, veloce e semplice.

- Selenium: Per siti dinamici, ricchi di JS o con login.

- Scrapy: Per crawling su larga scala e multi-pagina.

- Thunderbit: Per scraping AI senza codice — rapido, facile e perfetto per utenti business.

- Pandas: Per pulire, analizzare e interpretare i dati.

- Esporta con criterio: CSV, Sheets o database — scegli ciò che si adatta al tuo flusso di lavoro.

Il consiglio migliore? Parti dallo strumento che si adatta alle tue competenze e alle esigenze aziendali. Combina più soluzioni man mano che cresci. E se vuoi scoprire quanto può essere semplice il web scraping, o visita il per altre guide.

Buon scraping — che i tuoi dati siano sempre puliti, ordinati e subito pronti all’uso.

Domande frequenti

1. Qual è il modo più semplice per estrarre dati da un sito con Python?

Per siti statici, usa la libreria Requests per scaricare l’HTML e Beautiful Soup per analizzare ed estrarre i dati. Per siti dinamici, probabilmente ti servirà Selenium.

2. Quando conviene usare Thunderbit invece del codice Python?

Thunderbit è perfetto quando hai bisogno di dati subito, non vuoi programmare o devi gestire pagine dinamiche, sottopagine o esportazioni istantanee su Sheets/Excel. Ideale per utenti business o progetti con tempi stretti.

3. Come gestire siti che caricano dati con JavaScript?

Usa Selenium (o Playwright) per automatizzare un browser, oppure prova la modalità browser/cloud di Thunderbit, che gestisce automaticamente il JS.

4. Qual è il modo migliore per pulire e analizzare i dati estratti?

Importa i dati in Pandas, rimuovi i duplicati, gestisci i valori mancanti, uniforma i formati e usa groupby o describe per insight rapidi.

5. Il web scraping è legale e sicuro per le aziende?

In generale, estrarre dati pubblici è legale, ma controlla sempre i termini d’uso del sito e il file robots.txt. Evita di raccogliere dati personali senza consenso e rispetta le risorse dei siti. Thunderbit e Python supportano pratiche di scraping etiche.

Vuoi portare il tuo lavoro con i dati al livello successivo? o mettiti all’opera con Python: in ogni caso, potrai estrarre dati preziosi dal web in pochissimo tempo.

Scopri di più