Devo essere onesto: la prima volta che ho messo insieme un estrattore web, mi sono sentito come se avessi sbloccato una skill segreta. Tutte quelle ore passate a copiare e incollare dati da siti per trovare contatti o tenere d’occhio i prezzi sono diventate solo un brutto ricordo. Scrivere un estrattore web con Python è quasi un rito d’iniziazione per chiunque voglia automatizzare le solite noiose attività online. E se lavori in azienda, può davvero cambiare le tue giornate: invece di passare il venerdì sera a litigare con Excel, puoi finalmente goderti l’aperitivo.

In questa guida ti spiego come costruire un estrattore web con Python, passo dopo passo, con esempi di codice già pronti. E poi ti racconto perché, per la maggior parte dei team aziendali, c’è una strada molto più semplice: usare un che ti fa avere i dati in due click, senza scrivere nemmeno una riga di codice. Che tu sia un fan di Python o voglia solo i dati senza sbattimenti, qui trovi la soluzione che fa per te.

Cos’è il Web Scraping con Python? Una panoramica veloce

Partiamo dalle basi. Web scraping vuol dire semplicemente raccogliere in automatico informazioni dai siti web. Immagina di avere un assistente robot che fa tutto il copia-incolla al posto tuo—ma senza mai lamentarsi o chiedere ferie.

Un estrattore web è uno script o programma che:

- Va su una pagina web (proprio come il tuo browser)

- Prende i dati che ti interessano (tipo nomi di prodotti, prezzi o contatti)

- Salva tutto in modo ordinato (come un file Excel o JSON)

Python è perfetto per questo perché è facile da leggere, ha un sacco di librerie utili ed è davvero il coltellino svizzero della programmazione. Infatti, .

Il flusso di lavoro tipico è questo:

- Prendi la pagina web (scarichi l’HTML)

- Analizzi l’HTML per trovare i dati che ti servono

- Salvi i risultati dove ti fanno comodo

È un po’ come cucinare: prendi gli ingredienti (HTML), scegli le parti buone (i dati) e servi il piatto (esporti il file).

Perché il Web Scraping è fondamentale per le aziende

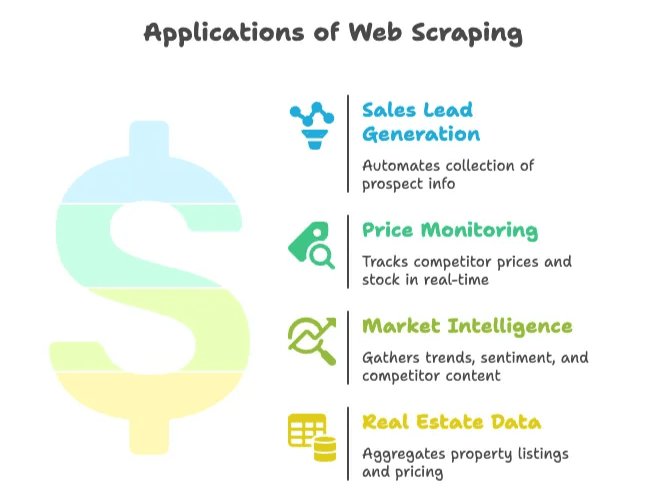

Il web scraping non è solo roba da nerd o appassionati di dati. Oggi è diventato essenziale per vendite, marketing, ecommerce, immobiliare e per chiunque abbia bisogno di dati freschi e affidabili dal web per decidere. Il e cresce del 28% ogni anno. Un’occasione enorme.

Ecco qualche esempio concreto di come viene usato in azienda:

| Caso d’uso | Vantaggio | Risultato concreto |

|---|---|---|

| Generazione di lead commerciali | Automatizza la raccolta di contatti da elenchi o social | Risparmiate ~8 ore/settimana per ogni venditore; 3.000 lead/mese raccolti, crescita vendite 10× in 3 mesi |

| Monitoraggio prezzi | Controllo in tempo reale dei prezzi e delle disponibilità dei concorrenti | Riduzione del 30% dei tempi di raccolta dati; +4% vendite grazie a prezzi più competitivi |

| Market intelligence | Analisi di trend, sentiment e contenuti dei competitor | Oltre il 70% delle aziende si affida a dati estratti dal web per l’analisi di mercato |

| Dati immobiliari | Aggrega annunci e prezzi da più portali | Le aziende monitorano Zillow/Trulia per anticipare i cambiamenti del mercato locale |

In breve: il web scraping ti fa risparmiare tempo, elimina il lavoro manuale e ti dà un vantaggio competitivo. Se stai ancora copiando e incollando, probabilmente i tuoi concorrenti sono già avanti.

Cosa serve per scrivere un Estrattore Web: strumenti e skill

Prima di buttarti a programmare, vediamo cosa ti serve davvero.

Le basi

- Python installato: Scarica l’ultima versione () e assicurati di poter lanciare

pythondal terminale. - Editor di codice: VS Code, PyCharm o anche Notepad++ vanno benissimo. Io preferisco VS Code per il supporto a Python.

- Ambiente virtuale: Non è obbligatorio, ma ti aiuta a gestire le dipendenze. Crealo con

python -m venv venv.

Librerie Python indispensabili

- Requests: Per scaricare le pagine web ().

- BeautifulSoup: Per analizzare l’HTML e trovare gli elementi che ti servono ().

- Selenium: Per estrarre dati da siti che caricano contenuti tramite JavaScript ().

Installa tutto con:

1pip install requests beautifulsoup4 lxml seleniumCapire l’HTML

Non serve essere web developer, ma è utile saper ispezionare il codice HTML di una pagina. Tasto destro, “Ispeziona” e vedi la struttura DOM. Qui trovi i tag e le classi da cui il tuo estrattore dovrà pescare i dati ().

Guida pratica: come scrivere un Estrattore Web con Python

Rimbocchiamoci le maniche e costruiamo un estrattore web semplice da zero. Userò un esempio reale—estrarre titoli di notizie o prodotti. Puoi adattarlo facilmente alle tue esigenze.

Configurare l’ambiente Python

Crea una cartella di progetto e un ambiente virtuale:

1mkdir my-scraper

2cd my-scraper

3python -m venv venv

4# Attiva l’ambiente virtuale:

5# Su Windows:

6venv\Scripts\activate

7# Su macOS/Linux:

8source venv/bin/activateInstalla le librerie:

1pip install requests beautifulsoup4 lxmlCrea un file chiamato scraper.py e aprilo nell’editor.

Scaricare e analizzare le pagine web

Scarichiamo l’HTML da un sito di esempio. In questo caso userò (un classico per le demo di scraping).

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()Ora analizziamo l’HTML con BeautifulSoup:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # Dovrebbe stampare "Hacker News"Estrarre i dati che ti servono

Supponiamo di voler raccogliere tutti i titoli delle notizie e i relativi link. Ispezionando la pagina, vedrai che ogni titolo è in un tag <a class="storylink">.

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)Se invece vuoi estrarre prodotti, cerca ad esempio <div class="product-item"> e prendi i campi all’interno. Ecco uno schema generico:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})Salvare i dati estratti in CSV o JSON

Ora salviamo i dati per poterli usare davvero.

In CSV:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])In JSON:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)Apri il CSV in Excel o il JSON in un editor di testo—e voilà, hai appena automatizzato ore di lavoro manuale.

Livello avanzato: gestire paginazione e contenuti dinamici

La maggior parte dei siti reali non sta tutta su una sola pagina. Ecco come affrontare scenari più complessi.

Paginazione

Se il sito usa la paginazione tramite URL (es. ?page=2), puoi ciclare sui numeri di pagina:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # Estrai i dati come prima()

Se invece c’è un pulsante “Avanti”, trova il link e seguilo:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # Estrai i dati

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = NoneContenuti dinamici (caricati via JavaScript)

Se i dati non sono nell’HTML (ad esempio vengono caricati da JavaScript), serve Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# Ora estrai i dati come prima()

Selenium può anche cliccare su “Carica altri” o scorrere la pagina. Occhio però: è più lento e pesante rispetto a Requests.

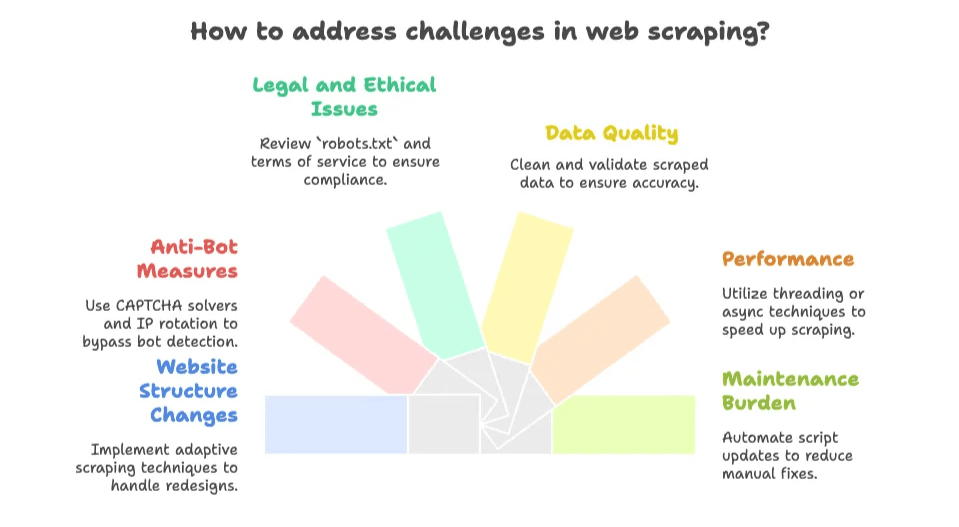

Le difficoltà più comuni quando scrivi un Estrattore Web

Qui si entra nel vivo. Scrivere un estrattore web è divertente—finché il sito non cambia e il tuo script si rompe alle 2 di notte prima di una scadenza. Ecco i problemi più frequenti:

- Cambiamenti nella struttura del sito: Se il sito viene ridisegnato o cambiano i nomi delle classi, il tuo estrattore può smettere di funzionare. La manutenzione è continua ().

- Sistemi anti-bot: CAPTCHAs, limiti di frequenza e blocchi IP sono ovunque. .

- Aspetti legali ed etici: Controlla sempre il

robots.txte i termini d’uso del sito. I dati pubblici di solito si possono estrarre, ma evita contenuti privati o protetti da copyright (). - Qualità dei dati: I dati estratti possono essere disordinati. Spesso serve pulire tag HTML, spazi o testo spezzato.

- Performance: Estrarre dati da tante pagine è lento se non usi thread o tecniche asincrone.

- Manutenzione: Ogni nuovo sito o cambiamento richiede di aggiornare gli script. È un lavoro infinito.

Se sei uno sviluppatore che ama le sfide, tutto questo può essere stimolante. Ma se vuoi solo i dati, può diventare frustrante in fretta.

L’alternativa smart: Estrattori Web AI come Thunderbit

Qui entra in gioco Thunderbit (che nella mia testa ha un cappellino a forma di fulmine). La maggior parte degli utenti aziendali non vuole scrivere o mantenere codice—vuole solo i dati, subito.

Per questo abbiamo creato , un che ti permette di estrarre dati da qualsiasi sito, PDF o immagine in due click. Niente codice, nessuna configurazione, zero conoscenze HTML richieste.

Cosa rende Thunderbit diverso?

- Configurazione in 2 click: Apri la pagina, clicca su “AI Suggerisci Campi”, poi su “Estrai”. Fatto.

- Suggerimenti AI per i campi: L’AI di Thunderbit legge la pagina e ti propone le colonne migliori (nome prodotto, prezzo, valutazione, ecc.).

- Estrazione da sottopagine e paginazione: Segue automaticamente i link “Avanti” o entra nelle pagine di dettaglio per arricchire i dati.

- Esportazione immediata: Esporta in Excel, Google Sheets, Airtable, Notion, CSV o JSON—gratis, senza complicazioni.

- Tipi di dati avanzati: Estrai email, numeri di telefono, immagini, persino testo da PDF o immagini (grazie all’OCR integrato).

- Estrazione in cloud o da browser: Puoi estrarre fino a 50 pagine alla volta in cloud, oppure usare il browser per siti che richiedono login.

- Zero manutenzione: L’AI si adatta automaticamente ai cambi di layout, così non devi più correggere script rotti.

Confronto diretto: Python vs. Thunderbit

| Aspetto | Estrattore Python | Thunderbit (Estrattore Web AI) |

|---|---|---|

| Tempo di configurazione | Ore per impostare, scrivere e testare il codice | Minuti—installa l’estensione, clicca e via |

| Competenze richieste | Alte (Python, HTML, CSS, debug) | Basse (punta e clicca, nessun codice) |

| Manutenzione | Devi aggiornarlo ogni volta che il sito cambia | L’AI di Thunderbit si adatta da sola |

| Paginazione/sottopagine | Devi scrivere cicli e logica personalizzata | Integrato, basta attivare l’opzione |

| Tipi di dati | Base; serve codice extra per immagini, PDF, email, ecc. | Estrazione con un click di testo, immagini, email, numeri di telefono, PDF e altro |

| Scalabilità e velocità | Limitata dal tuo codice e risorse | Estrazione cloud fino a 50 pagine; modalità browser per siti con login |

| Costo | Python è gratis, ma il tuo tempo no; server e proxy possono incidere | Piano gratuito disponibile; abbonamenti da ~16,5$/mese per 30.000 crediti/anno (prezzi) |

| Flessibilità e controllo | Massimo controllo per logiche personalizzate | Massima comodità per casi d’uso standard |

Per la maggior parte delle aziende, Thunderbit è la scorciatoia per ottenere dati strutturati senza stress.

Quando conviene scrivere un Estrattore Web o usare un Estrattore Web AI?

Qual è la scelta giusta per te? Ecco la mia opinione sincera:

Scrivi il tuo estrattore se:

- Hai bisogno di logiche molto personalizzate (es. login con 2FA, flussi multi-step, integrazione profonda con i tuoi sistemi).

- Hai ottime competenze di programmazione e ti piace sperimentare.

- Il sito è stabile e non ti spaventa la manutenzione.

- Vuoi integrare l’estrazione in un software più ampio.

- Devi estrarre dati protetti da login o non supportati dagli strumenti AI.

Usa un Estrattore Web AI (Thunderbit) se:

- Non vuoi programmare o gestire script.

- Ti serve il dato subito (per un’attività occasionale o ricorrente).

- Il sito cambia spesso o ha sistemi anti-bot (Thunderbit li gestisce per te).

- Vuoi funzionalità integrate come OCR, estrazione email/telefono o esportazione diretta nei tuoi strumenti preferiti.

- Vuoi risparmiare tempo e concentrarti sull’analisi, non sul debug.

Ecco una checklist rapida:

- I dati sono pubblici e non dietro login complicati? → Thunderbit è probabilmente la scelta migliore.

- È un’esigenza occasionale o spot? → Thunderbit.

- Serve personalizzazione o integrazione profonda? → Script Python.

- Hai uno sviluppatore a disposizione e ami programmare? → Script Python.

- Vuoi evitare problemi di manutenzione? → Thunderbit.

Ricorda: puoi sempre iniziare con Thunderbit per risultati rapidi e passare a script personalizzati se le esigenze diventano più complesse.

Per scoprire come funzionano gli estrattori web AI e quando usarli, leggi la nostra .

Riepilogo: come sfruttare il Web Scraping per la tua azienda

In sintesi:

- Il web scraping con Python è potente e flessibile, ma richiede tempo per imparare e mantenere gli script.

- Gli estrattori web AI come Thunderbit rendono l’estrazione dati accessibile a tutti—senza codice, senza configurazione, solo risultati.

- Per la maggior parte delle aziende, la via più rapida al valore è usare uno strumento AI, a meno che tu non abbia esigenze molto specifiche.

- Il web è una miniera d’oro di dati, e il metodo giusto può farti risparmiare ore (o giorni) di lavoro manuale.

Domande frequenti

1. Cos’è il web scraping e perché si usa spesso Python?

Il web scraping è il processo automatico di raccolta dati dai siti web. Python è molto usato perché è semplice da leggere, ha molte librerie dedicate (come requests, BeautifulSoup e Selenium) ed è perfetto per gestire contenuti HTML.

2. Quali sono i principali casi d’uso aziendali del web scraping?

Le aziende usano il web scraping per generare lead commerciali, monitorare prezzi, fare analisi di mercato e aggregare dati immobiliari. Automatizza la raccolta di dati ripetitivi e offre informazioni aggiornate per prendere decisioni.

3. Quali sono le principali difficoltà nello scrivere un estrattore web?

Le sfide più comuni sono: cambiamenti nella struttura dei siti, sistemi anti-bot come CAPTCHA, questioni legali/etiche, qualità dei dati e la manutenzione continua degli script.

4. In cosa si differenzia l’Estrattore Web AI di Thunderbit dagli script Python tradizionali?

Thunderbit offre una soluzione senza codice con suggerimenti AI per i campi, paginazione automatica ed esportazione rapida. Richiede pochissima configurazione, si adatta ai cambiamenti dei siti e può essere usato anche da chi non è sviluppatore, a differenza degli script Python che richiedono competenze tecniche e manutenzione manuale.

5. Quando conviene usare un estrattore AI come Thunderbit invece di programmare da zero?

Scegli Thunderbit se vuoi estrarre dati in modo rapido e affidabile senza programmare, soprattutto per dati pubblici o attività occasionali. Opta per uno script Python se ti serve il massimo controllo, integrazione profonda o devi estrarre dati complessi/protetti da login.

Per approfondire:

Se vuoi saperne di più sul web scraping, dai un’occhiata alle nostre altre guide:

E se vuoi provare il modo più semplice per estrarre dati dal web, e provala subito. I tuoi venerdì sera (e i tuoi dati) ti ringrazieranno.