האינטרנט כבר מזמן לא רק מגרש משחקים דיגיטלי – הוא הפך למאגר המידע הכי גדול שיש, וכל מי שנוגע במכירות, שיווק או ניתוח שוק מנסה להוציא ממנו את המקסימום. אבל בואו נדבר תכל'ס: לאסוף נתונים מהאינטרנט ידנית זה כמו להרכיב רהיט של איקאה בלי הוראות (ועם פי שניים ברגים מיותרים). ככל שעסקים נשענים יותר על מידע עדכני, תמחור תחרותי והפקת לידים, הצורך בכלי איסוף נתונים חכמים ואמינים רק הולך ותופס תאוצה. למעשה, כמעט בשביל לקבל החלטות, ושוק ה-Web Scraper העולמי צפוי .

אם נמאס לך להעתיק ולהדביק, לפספס לידים חמים, או פשוט בא לך לראות מה אפשר להשיג כשנותנים לאוטומציה לעבוד בשבילך – הגעת למקום הנכון. אחרי שנים של פיתוח ובדיקת כלי חילוץ נתונים (וכן, גם בניהול הצוות של ), אני יודע עד כמה הכלי הנכון יכול להפוך עבודה סיזיפית של שעות לפעולה של שתי קליקים. בין אם אתה לא טכנולוגי ורוצה תוצאות כאן ועכשיו, ובין אם אתה מפתח שמחפש שליטה מלאה – הרשימה של עשרת כלי חילוץ הנתונים המובילים תעזור לך למצוא את הפתרון המושלם.

למה חשוב לבחור את כלי חילוץ הנתונים הנכון

בוא נדבר דוגרי: ההבדל בין כלי חילוץ נתונים טוב לבינוני הוא לא רק עניין של נוחות – הוא יכול להשפיע ישירות על הצמיחה של העסק שלך. כשאתה משתמש באוטומציה לאיסוף נתונים, אתה לא רק חוסך זמן (למשל, משתמש אחד ב-G2 סיפר על ), אלא גם מצמצם טעויות, מגלה הזדמנויות חדשות ומבטיח שהצוות שלך תמיד עובד עם המידע הכי עדכני ומדויק. מחקר ידני איטי, מלא שגיאות, ובדרך כלל כבר לא רלוונטי כשהוא מסתיים. עם הכלי הנכון, תוכל לעקוב אחרי מתחרים, לעדכן מחירים או לבנות רשימות לידים – בדקות, לא בימים.

דוגמה מהשטח: קמעונאית בתחום היופי השתמשה ב-Web Scraper כדי לעקוב אחרי מלאי ומחירים של מתחרים, . זה סוג ההשפעה שלא תגיע אליו עם אקסלים ועבודה ידנית.

איך בחרנו את כלי חילוץ הנתונים הטובים ביותר

עם כל כך הרבה אפשרויות, לבחור כלי חילוץ נתונים זה כמו דייטים מהירים בכנס טכנולוגי. הנה הקריטריונים שהנחו אותי בהשוואה:

- קלות שימוש: האם אפשר להתחיל בלי תואר במדעי המחשב? יש ממשק ויזואלי או עזרה מבוססת AI למי שלא מתכנת?

- יכולות אוטומציה: האם הכלי מתמודד עם עמודים מרובי דפים, תוכן דינמי ותזמון משימות? האם אפשר להריץ בענן לפרויקטים גדולים?

- מחיר וגמישות: האם יש מסלול חינמי או תמחור נגיש? איך המחיר משתנה כשצרכי הנתונים גדלים?

- פיצ'רים ואינטגרציות: האם אפשר לייצא לאקסל, Google Sheets או דרך API? יש תבניות, תזמון או ניקוי נתונים מובנה?

- למי הכלי מתאים: האם הוא מיועד למשתמשי עסקים, מפתחים או צוותי אנטרפרייז?

בסוף תמצאו טבלת השוואה מהירה, כדי לראות איך כל כלי עומד מול האחרים.

עכשיו, בואו נצלול לעשרת כלי חילוץ הנתונים המובילים ל-2025.

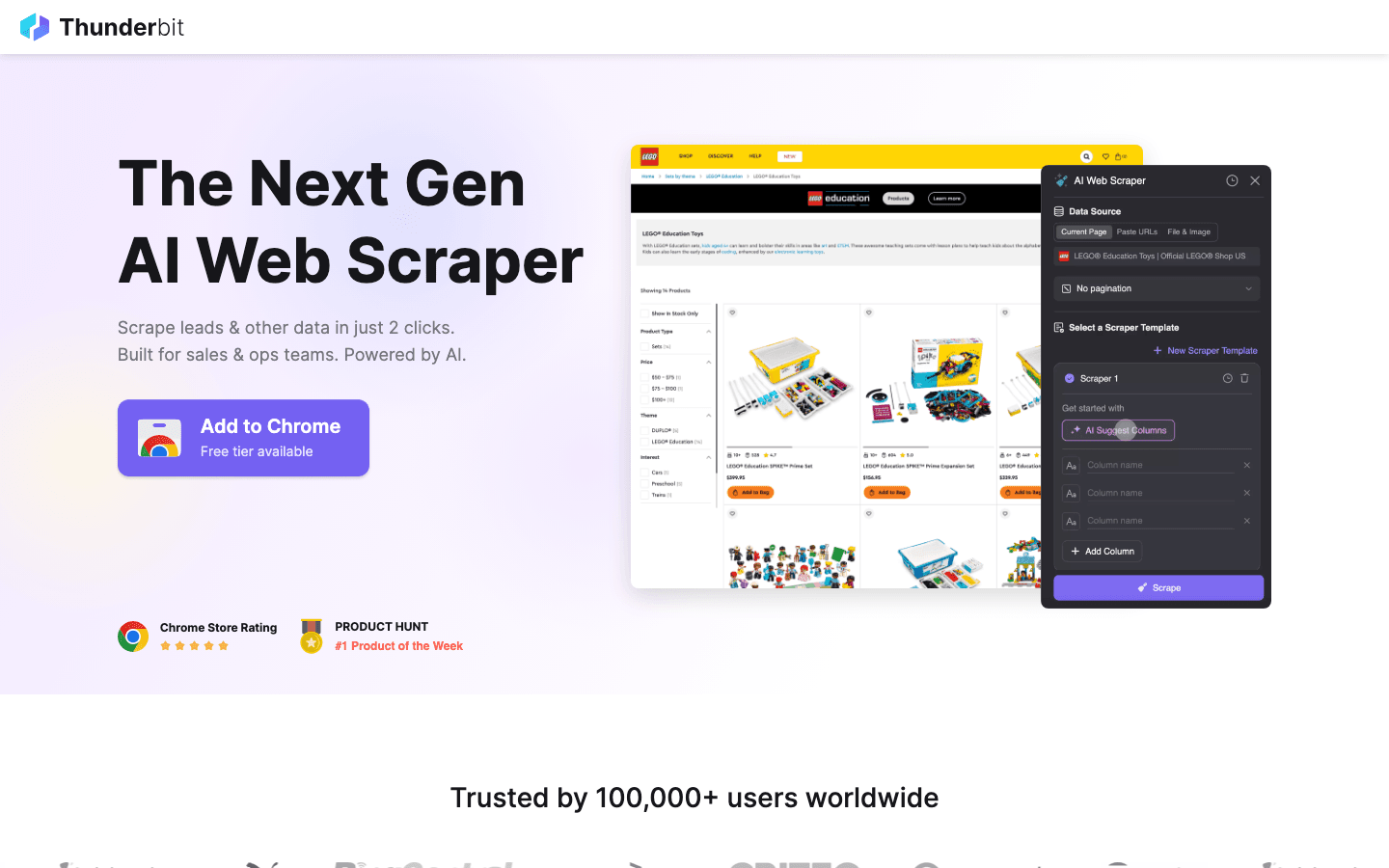

1. Thunderbit

הוא ההמלצה שלי לכל מי שרוצה לחלץ נתונים מהאינטרנט בקלות של הזמנת אוכל. כתוסף כרום מבוסס AI, Thunderbit מאפשר חילוץ נתונים בשתי קליקים: לוחצים על "AI Suggest Fields" – וה-AI מזהה אוטומטית אילו עמודות כדאי לשלוף, ואז לוחצים "Scrape" – והנתונים אצלך. בלי קוד, בלי התעסקות עם סלקטורים – תוצאות מיידיות.

הוא ההמלצה שלי לכל מי שרוצה לחלץ נתונים מהאינטרנט בקלות של הזמנת אוכל. כתוסף כרום מבוסס AI, Thunderbit מאפשר חילוץ נתונים בשתי קליקים: לוחצים על "AI Suggest Fields" – וה-AI מזהה אוטומטית אילו עמודות כדאי לשלוף, ואז לוחצים "Scrape" – והנתונים אצלך. בלי קוד, בלי התעסקות עם סלקטורים – תוצאות מיידיות.

מה הופך את Thunderbit לפייבוריט של צוותי מכירות, שיווק ואיקומרס? הוא בנוי לעבודה עסקית אמיתית:

- AI Suggest Fields: ה-AI קורא את הדף ומציע אילו עמודות כדאי לשלוף – שמות, מחירים, מיילים ועוד.

- חילוץ תתי-עמודים: צריך עוד פרטים? Thunderbit יכול להיכנס אוטומטית לכל תת-עמוד (כמו דפי מוצר או פרופילים בלינקדאין) ולהעשיר את הטבלה.

- ייצוא מיידי: שלח את הנתונים ישירות לאקסל, Google Sheets, Airtable או Notion – כל הייצוא חינמי.

- תבניות מוכנות בלחיצה: לאתרים פופולריים (Amazon, Zillow, Instagram) יש תבניות מיידיות לתוצאות מהירות.

- ייצוא חופשי: אין חסימה על הוצאת הנתונים שלך.

- חילוץ מתוזמן: הגדר משימות חוזרות באנגלית פשוטה ("כל יום שני ב-9:00") – מושלם למעקב מחירים או עדכון לידים שבועי.

Thunderbit פועל במודל קרדיטים (1 קרדיט = שורה אחת), עם עד 6 עמודים (או 10 עם בונוס ניסיון). מסלולים בתשלום מתחילים ב-15 דולר לחודש ל-500 קרדיטים – משתלם לכל גודל צוות.

רוצה לראות את Thunderbit בפעולה? קפוץ ל- או . זה הכלי שתמיד רציתי כששקעתי בעבודת הזנה ידנית.

2. Octoparse

הוא שחקן כבד בתחום חילוץ הנתונים, במיוחד לארגונים שצריכים עוצמה אמיתית. הוא מציע ממשק ויזואלי (ל-Windows ו-Mac) שבו אפשר לבנות תהליכי חילוץ בקלות – בלי קוד. אבל אל תתבלבל מהממשק הידידותי: Octoparse מתמודד עם כניסות, גלילה אינסופית, פרוקסי מתחלפים ואפילו פתרון CAPTCHA.

הוא שחקן כבד בתחום חילוץ הנתונים, במיוחד לארגונים שצריכים עוצמה אמיתית. הוא מציע ממשק ויזואלי (ל-Windows ו-Mac) שבו אפשר לבנות תהליכי חילוץ בקלות – בלי קוד. אבל אל תתבלבל מהממשק הידידותי: Octoparse מתמודד עם כניסות, גלילה אינסופית, פרוקסי מתחלפים ואפילו פתרון CAPTCHA.

- 500+ תבניות מוכנות: התחילו מהר עם תבניות ל-Amazon, Twitter, LinkedIn ועוד.

- חילוץ בענן: הריצו משימות על השרתים של Octoparse, תזמנו משימות והגדילו נפח בקלות.

- גישה ל-API: שלבו את הנתונים ישירות באפליקציות או במסדי נתונים שלכם.

- אוטומציה מתקדמת: מתמודד עם תוכן דינמי, עמודים מרובי דפים ותהליכים מורכבים.

יש עד 10 משימות, אבל רוב המשתמשים העסקיים יעדיפו את המסלול הסטנדרטי (~83 דולר לחודש) או המקצועי (~299 דולר). עקומת הלמידה מעט תלולה יותר מ-Thunderbit, אבל אם אתה צריך לחלץ אלפי עמודים – זה כלי מוביל.

3. Scrapy

הוא הסטנדרט למפתחים שרוצים שליטה מלאה בפרויקטי חילוץ נתונים. מדובר בפלטפורמת קוד פתוח ב-Python שמאפשרת לבנות "עכבישים" (crawlers) מותאמים לכל אתר. כל מה שתדמיין – אפשר לבנות עם Scrapy.

הוא הסטנדרט למפתחים שרוצים שליטה מלאה בפרויקטי חילוץ נתונים. מדובר בפלטפורמת קוד פתוח ב-Python שמאפשרת לבנות "עכבישים" (crawlers) מותאמים לכל אתר. כל מה שתדמיין – אפשר לבנות עם Scrapy.

- שליטה מלאה בקוד: כתוב קוד Python כדי להגדיר בדיוק איך לחלץ נתונים מכל אתר.

- מהיר וא-סינכרוני: מתמודד עם אלפי עמודים במקביל לפרויקטים גדולים.

- ניתן להרחבה: הוסף פרוקסי, דפדפנים ללא ראש או לוגיקה מותאמת.

- קהילה חזקה: המון מדריכים, תוספים ותמיכה במצבים מורכבים.

Scrapy הוא חינמי וקוד פתוח, אבל דורש ידע בתכנות. אם יש לך צוות טכני או רוצה לבנות תהליך מותאם – זה הכלי בשבילך. למי שלא מתכנת – פחות מתאים.

4. ParseHub

הוא כלי חילוץ נתונים ויזואלי ללא קוד, מושלם למי שלא מתכנת וצריך להתמודד עם אתרים מורכבים. הממשק מאפשר לבחור אלמנטים, להגדיר פעולות ולבנות תהליכי חילוץ – גם לאתרים עם תוכן דינמי או ניווט מסובך.

הוא כלי חילוץ נתונים ויזואלי ללא קוד, מושלם למי שלא מתכנת וצריך להתמודד עם אתרים מורכבים. הממשק מאפשר לבחור אלמנטים, להגדיר פעולות ולבנות תהליכי חילוץ – גם לאתרים עם תוכן דינמי או ניווט מסובך.

- בונה תהליכים ויזואלי: בחר נתונים, הגדר עמודים מרובי דפים וטפל בפופ-אפים או תפריטים נפתחים.

- מתמודד עם תוכן דינמי: עובד גם עם אתרים כבדים ב-JavaScript ודפים אינטראקטיביים.

- הרצה בענן ותזמון: הרץ חילוץ בענן ותזמן משימות חוזרות.

- ייצוא ל-CSV, Excel או API: אינטגרציה קלה לכלים המועדפים עליך.

ParseHub מציע מסלול חינמי (5 פרויקטים), ומסלולים בתשלום החל מ-. הוא יקר יותר מחלק מהמתחרים, אבל הגישה הוויזואלית הופכת אותו לנגיש לאנליסטים, משווקים וחוקרים שצריכים יותר מתוסף כרום בסיסי.

5. Apify

הוא גם פלטפורמה וגם שוק ל-Web Scraper. הוא מציע ספרייה ענקית של "Actors" מוכנים (סקרייפרים מוכנים מראש) לאתרים פופולריים, וגם אפשרות לבנות ולהריץ סקרייפרים מותאמים בענן.

הוא גם פלטפורמה וגם שוק ל-Web Scraper. הוא מציע ספרייה ענקית של "Actors" מוכנים (סקרייפרים מוכנים מראש) לאתרים פופולריים, וגם אפשרות לבנות ולהריץ סקרייפרים מותאמים בענן.

- 5,000+ Actors מוכנים: שלוף נתונים מ-Google Maps, Amazon, Twitter ועוד – בלחיצה.

- סקריפטים מותאמים: מפתחים יכולים להשתמש ב-JavaScript או Python לבניית סקרייפרים מתקדמים.

- הרצה בענן: הרץ משימות במקביל, תזמן משימות ונהל נתונים בענן.

- API ואינטגרציה: שלב תוצאות באפליקציות, תהליכים או צינורות נתונים.

Apify מציע , ומסלולים בתשלום החל מ-29 דולר לחודש (לפי שימוש). יש עקומת למידה, אבל אם אתה רוצה גם פתרונות מוכנים וגם התאמה אישית – זה כלי עוצמתי.

6. Data Miner

הוא תוסף כרום שמיועד לחילוץ נתונים מהיר על בסיס תבניות מוכנות. מושלם למשתמשי עסקים שרוצים לשלוף נתונים מטבלאות או רשימות בלי הגדרות מסובכות.

הוא תוסף כרום שמיועד לחילוץ נתונים מהיר על בסיס תבניות מוכנות. מושלם למשתמשי עסקים שרוצים לשלוף נתונים מטבלאות או רשימות בלי הגדרות מסובכות.

- ספריית תבניות ענקית: מעל אלף "מתכונים" לאתרים נפוצים (LinkedIn, Yelp ועוד).

- חילוץ בלחיצה: בחר תבנית, תצוגה מקדימה וייצוא מיידי.

- מבוסס דפדפן: עובד עם הסשן הנוכחי – כולל אתרים מאחורי כניסה.

- ייצוא ל-CSV או Excel: הנתונים אצלך בגיליון תוך שניות.

ה- מכסה 500 עמודים בחודש, ומסלולים בתשלום החל מ-20 דולר. מתאים למשימות קטנות או כשצריך נתונים מיידית – לא מיועד לפרויקטים ענקיים או אוטומציה מורכבת.

7. Import.io

הוא פלטפורמה ברמת אנטרפרייז לארגונים שצריכים אינטגרציה שוטפת ואמינה של נתוני אינטרנט. זה לא רק סקרייפר – זו מערכת מנוהלת שמספקת נתונים נקיים ומובנים ישירות למערכות העסקיות שלך.

הוא פלטפורמה ברמת אנטרפרייז לארגונים שצריכים אינטגרציה שוטפת ואמינה של נתוני אינטרנט. זה לא רק סקרייפר – זו מערכת מנוהלת שמספקת נתונים נקיים ומובנים ישירות למערכות העסקיות שלך.

- חילוץ ללא קוד: הגדרה ויזואלית של אילו נתונים לשלוף.

- הזנות נתונים בזמן אמת: הזרמת נתונים לדשבורדים, כלי BI או מסדי נתונים.

- עמידה ברגולציה ואמינות: מתמודד עם סיבוב IP, הגנות בוט וציות לחוק.

- שירות מנוהל: הצוות של Import.io יכול להקים ולתחזק את הסקרייפרים עבורך.

המחיר , עם ניסיון חינם ל-14 יום. אם העסק שלך תלוי בנתוני אינטרנט עדכניים (קמעונאות, פיננסים, מחקר שוק) – שווה בדיקה.

8. WebHarvy

הוא סקרייפר שולחני למשתמשי Windows שרוצים פתרון ויזואלי ללא מנוי. פופולרי במיוחד בקרב עסקים קטנים ואנשים פרטיים שמעדיפים רכישה חד-פעמית.

הוא סקרייפר שולחני למשתמשי Windows שרוצים פתרון ויזואלי ללא מנוי. פופולרי במיוחד בקרב עסקים קטנים ואנשים פרטיים שמעדיפים רכישה חד-פעמית.

- זיהוי תבניות ויזואלי: לחץ על אלמנטים – WebHarvy מזהה אוטומטית דפוסים חוזרים.

- חילוץ טקסט, תמונות ועוד: שולף את כל סוגי הנתונים הנפוצים, כולל מיילים וכתובות.

- עמודים מרובי דפים ותזמון: ניווט בין עמודים והגדרת חילוץ מתוזמן.

- ייצוא לאקסל, CSV, XML, JSON או SQL: גמישות מלאה לכל תהליך עבודה.

רישיון למשתמש בודד עולה , פתרון משתלם לשימוש קבוע – רק שים לב שהוא מתאים ל-Windows בלבד.

9. Mozenda

היא פלטפורמת חילוץ נתונים בענן, שנבנתה לצרכים עסקיים ולמשימות שוטפות. משלבת כלי עיצוב שולחני (Windows) עם הרצה ואוטומציה בענן.

היא פלטפורמת חילוץ נתונים בענן, שנבנתה לצרכים עסקיים ולמשימות שוטפות. משלבת כלי עיצוב שולחני (Windows) עם הרצה ואוטומציה בענן.

- בונה סוכנים ויזואלי: עיצוב תהליכי חילוץ בקלות עם ממשק גרפי.

- הרצה בענן: הרץ סוכנים במקביל, תזמן משימות ונהל נתונים במרכז אחד.

- קונסולת ניהול נתונים: שילוב, סינון וניקוי נתונים לאחר החילוץ.

- תמיכה לארגונים: מנהלי חשבונות ייעודיים ושירות מנוהל לצוותים גדולים.

המחירים מתחילים ב-, עם מסלולים גבוהים יותר לצוותים גדולים. מתאים במיוחד לחברות שצריכות נתוני אינטרנט אמינים כחלק מהפעילות היומיומית.

10. BeautifulSoup

היא ספריית Python קלאסית לניתוח HTML ו-XML. היא לא סקרייפר מלא, אבל מפתחים אוהבים אותה לפרויקטים קטנים ומותאמים אישית.

היא ספריית Python קלאסית לניתוח HTML ו-XML. היא לא סקרייפר מלא, אבל מפתחים אוהבים אותה לפרויקטים קטנים ומותאמים אישית.

- פירוק HTML פשוט: שליפת נתונים בקלות מדפים סטטיים.

- עובד עם Python Requests: שילוב עם ספריות נוספות לשליפה וחילוץ.

- גמיש וקל משקל: מושלם לסקריפטים מהירים או למטרות לימוד.

- קהילה ענקית: המון מדריכים ותשובות ב-Stack Overflow.

BeautifulSoup היא , אבל תצטרך לכתוב קוד ולבנות את הלוגיקה בעצמך. מתאימה למפתחים או לומדים שרוצים להבין לעומק איך עובד Web Scraper.

טבלת השוואה: כלים לחילוץ נתונים במבט מהיר

| כלי | קלות שימוש | רמת אוטומציה | מחיר | אפשרויות ייצוא | הכי מתאים ל... |

|---|---|---|---|---|---|

| Thunderbit | קל מאוד, ללא קוד | גבוהה (AI, תתי-עמודים) | ניסיון חינם, מ-15$/חודש | Excel, Sheets, Airtable, Notion, CSV | מכירות, שיווק, איקומרס, לא טכנולוגיים |

| Octoparse | בינונית, ממשק ויזואלי | גבוהה מאוד, ענן | חינם, 83–299$/חודש | CSV, Excel, JSON, API | ארגונים, צוותי דאטה, אתרים דינמיים |

| Scrapy | נמוכה (דורש Python) | גבוהה (מותאם אישית) | חינם, קוד פתוח | כל פורמט (בקוד) | מפתחים, פרויקטים גדולים מותאמים |

| ParseHub | גבוהה, ויזואלי | גבוהה (אתרים דינמיים) | חינם, מ-189$/חודש | CSV, Excel, JSON, API | לא טכנולוגיים, אתרים מורכבים |

| Apify | בינונית, גמישה | גבוהה מאוד, ענן | חינם, 29–999$/חודש | CSV, JSON, API, אחסון בענן | מפתחים, עסקים, סקרייפרים מוכנים או מותאמים |

| Data Miner | קל מאוד, דפדפן | נמוכה (ידני) | חינם, 20–99$/חודש | CSV, Excel | שליפות מהירות, נתונים קטנים |

| Import.io | בינונית, מנוהלת | גבוהה מאוד, אנטרפרייז | מותאם אישית, לפי נפח | CSV, JSON, API, אינטגרציה ישירה | ארגונים, אינטגרציה שוטפת של נתונים |

| WebHarvy | גבוהה, שולחני | בינונית (תזמון) | 129$ חד-פעמי | Excel, CSV, XML, JSON, SQL | עסקים קטנים, משתמשי Windows, חילוץ קבוע |

| Mozenda | בינונית, ויזואלית | גבוהה מאוד, ענן | 250–450$+/חודש | CSV, Excel, JSON, ענן, DB | פעילות עסקית שוטפת, פרויקטים גדולים |

| BeautifulSoup | נמוכה (דורש Python) | נמוכה (קוד ידני) | חינם, קוד פתוח | כל פורמט (בקוד) | מפתחים, לומדים, סקריפטים קטנים |

איך לבחור את כלי חילוץ הנתונים המתאים לצוות שלך

הבחירה בכלי חילוץ נתונים לא חייבת להיות "הכי חזק" – אלא הכי מתאים ליכולות, לצרכים ולתקציב של הצוות שלך. הנה ההמלצות שלי:

- לא טכנולוגיים או משתמשי עסקים: תתחיל עם Thunderbit, ParseHub או Data Miner לתוצאות מיידיות והגדרה פשוטה.

- צרכים ארגוניים או פרויקטים גדולים: בדוק את Octoparse, Mozenda או Import.io לאוטומציה, תזמון ותמיכה.

- מפתחים או פרויקטים מותאמים: Scrapy, Apify או BeautifulSoup יתנו שליטה וגמישות מלאה.

- תקציב מוגבל או משימות חד-פעמיות: WebHarvy (ל-Windows) או Data Miner (בדפדפן) – פשוטים ומשתלמים.

תמיד תנסה את הכלים המובילים שלך עם ניסיון חינם על האתרים הרלוונטיים – מה שעובד באתר אחד לא בהכרח יעבוד באחר. ואל תשכח לבדוק אינטגרציות: אם אתה צריך את הנתונים ב-Sheets, Notion או מסד נתונים – תוודא שהכלי תומך בזה מראש.

סיכום: למקסם ערך עסקי עם כלי חילוץ נתונים מתקדמים

נתוני אינטרנט הם הדלק החדש – אבל רק אם יש לך את הכלים הנכונים לשלוף ולעבד אותם. עם הכלים המודרניים, אפשר להפוך שעות של מחקר ידני לדקות של תובנות אוטומטיות – ולשפר מכירות, שיווק ותפעול. בין אם אתה בונה רשימות לידים, עוקב אחרי מתחרים או פשוט נמאס לך להעתיק ולהדביק – יש כאן כלי שיקל עליך משמעותית.

אז תבדוק מה הצוות שלך צריך, תנסה כמה מהכלים, ותגלה כמה אפשר להשיג כשנותנים לאוטומציה לעבוד בשבילך. ואם אתה רוצה לראות איך נראה חילוץ נתונים חכם בשתי קליקים – . חילוץ נעים – ושהנתונים שלך תמיד יהיו עדכניים, מסודרים ומוכנים לפעולה.

שאלות נפוצות

1. מהו כלי חילוץ נתונים ולמה צריך אותו?

כלי חילוץ נתונים (Data Crawling Tool) מאפשר לאסוף מידע מאתרים בצורה אוטומטית. הוא חוסך זמן, מצמצם טעויות ומסייע לצוותים לאסוף נתונים עדכניים למכירות, שיווק, מחקר ותפעול – הרבה יותר יעיל מהעתקה ידנית.

2. איזה כלי חילוץ נתונים הכי מתאים למי שלא מתכנת?

Thunderbit, ParseHub ו-Data Miner הם הבחירות המובילות למי שלא טכנולוגי. Thunderbit בולט בזכות תהליך AI מהיר בשתי קליקים, ו-ParseHub מציע גישה ויזואלית לאתרים מורכבים.

3. איך משתנים מודלי התמחור בין הכלים?

המחירים מגוונים: חלק מהכלים (כמו Thunderbit ו-Data Miner) מציעים מסלולים חינמיים ותוכניות חודשיות משתלמות, בעוד פלטפורמות אנטרפרייז (Import.io, Mozenda) עובדות לפי נפח או מחיר מותאם. תמיד תבדוק שהמחיר תואם את צרכי הנתונים שלך.

4. האם אפשר להשתמש בכלים האלה לחילוץ נתונים מתוזמן ומתמשך?

בהחלט – כלים כמו Thunderbit, Octoparse, Apify, Mozenda ו-Import.io תומכים בחילוץ מתוזמן או חוזר, מה שהופך אותם לאידיאליים למעקב מחירים, הפקת לידים או מחקר שוק שוטף.

5. מה כדאי לבדוק לפני שבוחרים כלי חילוץ נתונים?

בדוק את רמת הידע הטכנולוגי בצוות, מורכבות האתרים, נפח הנתונים, צרכי אינטגרציה ותקציב. תנסה כמה כלים על משימות אמיתיות לפני שמתחייבים למסלול בתשלום.

לעוד מדריכים מעשיים ומעמיקים, קפוץ ל-.

למידע נוסף