La web de hoy es un verdadero caos—y también mucho más entretenida—comparada con aquellos días en los que solo bastaba un “clic derecho, guardar como” y asunto resuelto. Ahora, los sitios web parecen auténticos laberintos llenos de contenido que se mueve, enlaces escondidos, pop-ups y menús que se abren en varios niveles. Si alguna vez intentaste juntar todos los datos de productos de una tienda online moderna o recopilar cada anuncio de un portal inmobiliario, seguro notaste que los raspadores web básicos ya no dan la talla. Aquí es donde los deep crawlers entran en juego: una nueva generación de herramientas de raspado web hechas para ir más allá, meterse hasta el fondo y traerte la información que realmente importa.

Pero, ¿qué es exactamente un deep crawler? ¿Por qué equipos de ventas, analistas de mercado y empresas de todo tipo están tan interesados en ellos? ¿Y cómo puede una herramienta como hacer que el deep crawling sea tan fácil como dar dos clics, incluso si no tienes ni idea de programación? Vamos a desmenuzar todo esto, desde lo más básico hasta el impacto real en los negocios, y ver por qué los deep crawlers se están volviendo el as bajo la manga para la extracción de datos web moderna.

¿Qué es un Deep Crawler? Lo Esencial

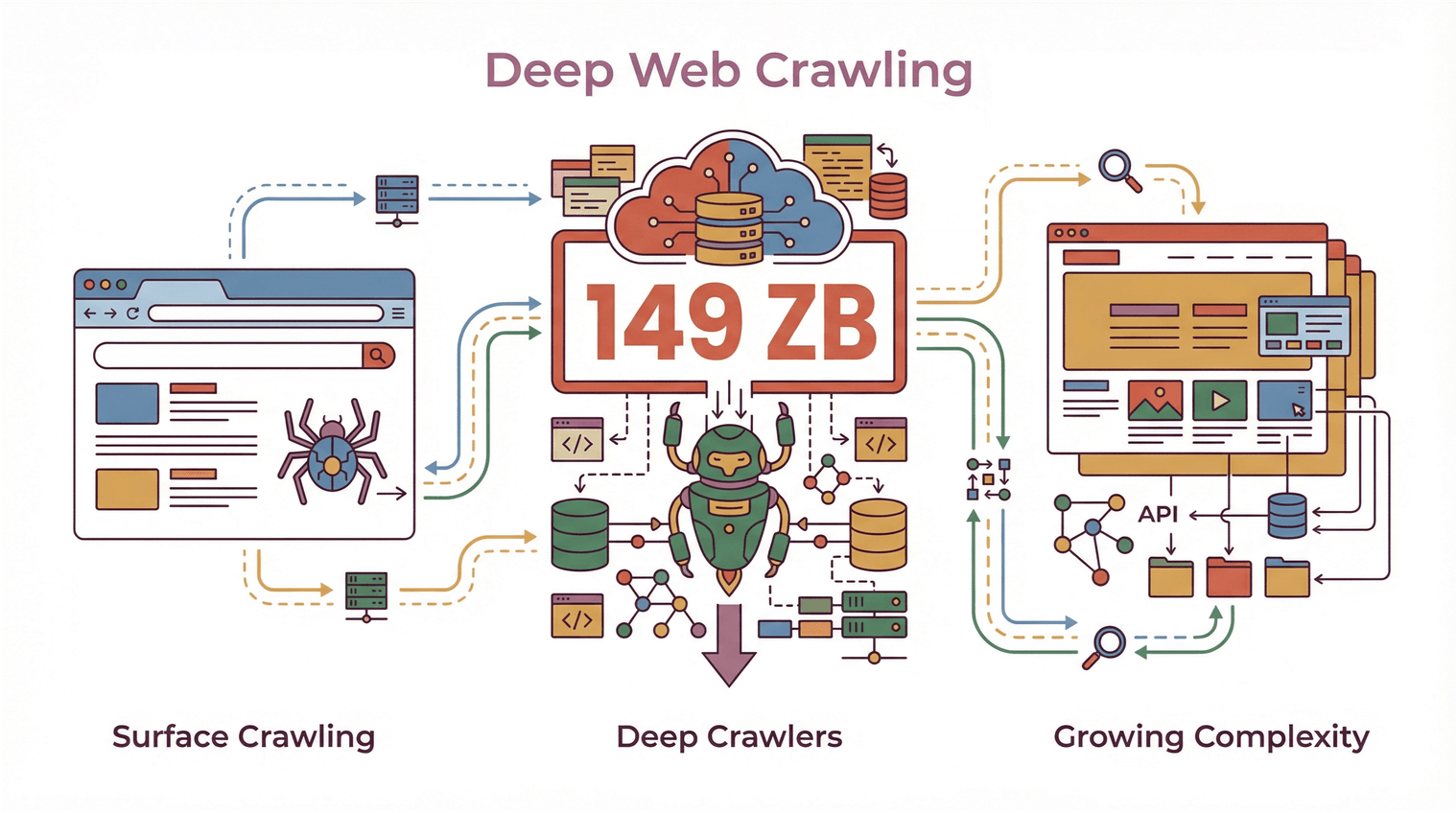

En pocas palabras, un deep crawler es un tipo especial de rastreador o raspador web pensado para navegar y sacar información de sitios web complejos, con muchas capas y, muchas veces, contenido que se genera al vuelo. A diferencia de los rastreadores clásicos—que solo recorren la superficie y capturan lo que se ve en la página principal—un deep crawler está preparado para seguir enlaces, moverse por varios niveles de navegación y lidiar con listas paginadas o información que está escondida tras pestañas o secciones que se expanden.

Piensa en un rastreador tradicional como alguien que da una vuelta rápida por una biblioteca y solo anota los títulos de los libros que ve en la entrada. Un deep crawler, en cambio, es el que recorre todos los pasillos, abre cada libro, revisa los pies de página y hasta mira detrás de la puerta de “Solo personal” (siempre que no esté cerrada, claro).

En el mundo del raspado web, esto significa que un deep crawler puede:

- Navegar por varias capas de un sitio web (categorías, subcategorías, páginas de detalle)

- Extraer contenido dinámico que se carga con JavaScript o aparece después de que el usuario interactúa

- Manejar paginaciones complicadas y scroll infinito

- Seguir enlaces internos para no dejar ningún dato importante sin capturar

Con el volumen global de datos web llegando a los y la complejidad de los sitios duplicándose cada pocos años, los deep crawlers se han vuelto imprescindibles para quienes necesitan mucho más que un vistazo superficial a la web.

Con el volumen global de datos web llegando a los y la complejidad de los sitios duplicándose cada pocos años, los deep crawlers se han vuelto imprescindibles para quienes necesitan mucho más que un vistazo superficial a la web.

Deep Crawler vs. Rastreador Tradicional: ¿Qué los Hace Diferentes?

Vamos a aterrizarlo un poco más. ¿Qué separa a un deep crawler de los “rastreadores” convencionales de los que seguro has escuchado?

Rastreadores Tradicionales: Solo la Superficie

Los rastreadores web tradicionales (a veces llamados “shallow crawlers”) están hechos para ir rápido y cubrir mucho. Son perfectos para escanear un sitio, agarrar lo que está en las páginas principales y seguir de largo. Así funcionan la mayoría de los buscadores: quieren indexar la mayor cantidad de páginas posible, lo más rápido que puedan, pero no se meten a fondo en cada rincón.

Limitaciones de los rastreadores tradicionales:

- Se saltan datos que están detrás de menús, pestañas o elementos dinámicos

- Les cuesta con sitios llenos de JavaScript o contenido que aparece después de cargar la página

- No pueden con navegaciones de varios pasos o estructuras complicadas

- Los datos que sacan suelen estar incompletos o a medias

Deep Crawlers: Van Mucho Más Allá

Un deep crawler, en cambio, está hecho para explorar a fondo un sitio web: sigue todos los enlaces importantes, navega por listas paginadas y saca información de subpáginas, pop-ups y contenido dinámico. Aquí lo que importa no es la velocidad, sino la profundidad y la precisión.

Lo que hace únicos a los deep crawlers:

- Navegación avanzada: Puede seguir enlaces de forma recursiva, manejar sitios con varios niveles y evitar páginas duplicadas o sin salida ().

- Extracción de contenido dinámico: Interactúa con JavaScript, expande secciones ocultas y saca datos que solo aparecen tras acciones del usuario ().

- Eficiencia mejorada: Se enfoca en las áreas que importan, reduce datos duplicados o irrelevantes y asegura que no falte nada importante ().

- Datos completos: Garantiza que toda la información—listados principales, páginas de detalle, documentos relacionados—se capture en una sola pasada.

Si alguna vez intentaste sacar todas las reseñas de una página de producto o conseguir cada anuncio de un portal inmobiliario (incluyendo la info del agente en una subpágina aparte), seguro te topaste con los límites de los rastreadores tradicionales. Ahí es donde los deep crawlers marcan la diferencia.

Cómo los Deep Crawlers Consiguen Datos Completos y Navegación Avanzada

¿Pero cómo logran los deep crawlers ese nivel de detalle? Todo se basa en seguir enlaces, navegación recursiva y manejo inteligente de contenido dinámico.

Raspado de Subpáginas y Navegación en Varias Capas

Un deep crawler no se queda en la primera página. Hace lo siguiente:

- Detecta enlaces internos (como “Ver detalles”, “Siguiente página” o “Ver más”)

- Sigue esos enlaces a subpáginas, vistas de detalle o incluso pop-ups

- Saca datos de cada nivel, juntando todo en un solo set de datos bien ordenado

A esto se le llama a veces “crawling recursivo” o “raspado multinivel”. Es clave en sitios donde la información está repartida en varias páginas—por ejemplo, listados de productos con páginas de detalle, o directorios donde los datos de contacto solo aparecen tras hacer clic.

Manejo de Paginación y Contenido Dinámico

Los sitios modernos suelen esconder datos tras botones de “Cargar más”, scroll infinito o pestañas controladas por JavaScript. Los deep crawlers están listos para:

- Detectar e interactuar con controles de paginación

- Hacer scroll o clic en elementos dinámicos

- Esperar a que el contenido cargue antes de sacar los datos

Así te aseguras de tener un set de datos completo, no solo lo que estaba visible al cargar la página ().

Seguimiento de Enlaces Profundos y Raspado Multinivel

Uno de los mayores retos del deep crawling es no dejar pasar datos escondidos o anidados. Los deep crawlers usan algoritmos para:

- Registrar qué enlaces ya se visitaron (evitando duplicados o bucles)

- Priorizar páginas importantes (como vistas de detalle o documentos descargables)

- Gestionar casos especiales (pop-ups, secciones que se expanden o contenido cargado por AJAX)

Esto es clave para empresas—perder un solo dato de contacto o especificación de producto puede significar oportunidades perdidas o análisis incompletos ().

Thunderbit: Deep Crawling Fácil con Herramientas de IA

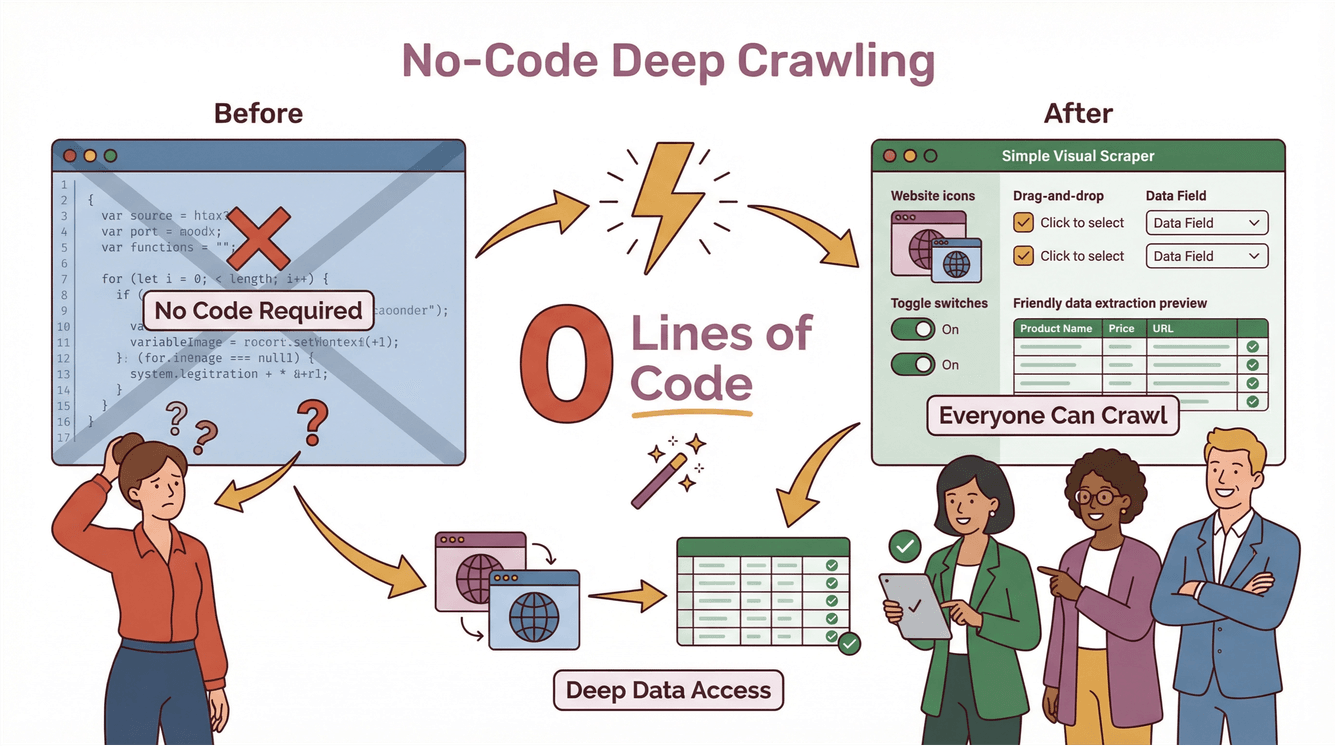

Seamos sinceros: antes, el deep crawling era solo para desarrolladores y expertos en datos. Había que programar scripts a medida, lidiar con casos raros y pasar horas arreglando el código cada vez que un sitio cambiaba. Pero con , la idea es que el deep crawling esté al alcance de cualquiera, aunque nunca hayas programado.

Así Funciona el Deep Crawler de Thunderbit

Esto es lo que hace que Thunderbit sea tan fácil para el deep crawling:

- AI Suggest Fields: Solo tienes que hacer clic en “AI Suggest Fields” y la IA de Thunderbit analiza la página, te sugiere las mejores columnas para extraer y crea prompts para cada campo.

- Raspado de Subpáginas: ¿Necesitas más información? Thunderbit puede visitar automáticamente cada subpágina (como detalles de productos, perfiles de agentes o pestañas de reseñas) y sumar esos datos a tu tabla.

- Manejo de Contenido Dinámico: Thunderbit interactúa con paginaciones, scroll infinito y elementos dinámicos—sin que tengas que configurar nada raro.

- Sin código, en dos pasos: Describe lo que necesitas, haz clic en “Scrape” y Thunderbit hace el resto. Exporta tus datos directo a Excel, Google Sheets, Notion o Airtable—sin costes extra ni límites ().

Ejemplo Paso a Paso: Deep Crawling con Thunderbit

Imagina que quieres sacar todos los anuncios inmobiliarios de un sitio, incluyendo la info de contacto de los agentes que está escondida en subpáginas:

- Abre la página de anuncios en Chrome.

- Haz clic en la extensión de Thunderbit.

- Usa “AI Suggest Fields” para que Thunderbit te recomiende columnas como “Título del anuncio”, “Precio”, “Dirección” y “Enlace del agente”.

- Haz clic en “Scrape”. Thunderbit recopila todos los anuncios principales.

- Haz clic en “Scrape Subpages”. Thunderbit visita cada perfil de agente, saca teléfonos, emails y más, y lo integra en tu tabla principal.

- Exporta tus datos a Google Sheets o Excel—listos para tu equipo de ventas u operaciones.

Sin código, sin plantillas, sin enredos. Y si el sitio cambia, la IA de Thunderbit se adapta sola ().

Beneficios para Empresas: Cómo los Deep Crawlers Impulsan Ventas y Marketing

Vale, los deep crawlers suenan bien—pero ¿qué ganan realmente los negocios? Aquí es donde se pone bueno.

Descubre Insights Valiosos en E-commerce, Inmobiliarias y Sitios de la Competencia

Para equipos de ventas y marketing, los deep crawlers son una mina de oro. Permiten:

- Sacar todos los productos, precios y reseñas de tiendas online—aunque los datos estén escondidos tras varias capas o pestañas

- Agrupar anuncios inmobiliarios (incluyendo info de agentes o detalles de propiedades que no están a simple vista)

- Vigilar sitios de la competencia para detectar nuevos productos, cambios de precios o movimientos del mercado ()

- Construir listas de leads más completas capturando datos de contacto en directorios, eventos o portales de nicho

Con el deep crawling, no solo tienes más datos—tienes datos de mejor calidad y utilidad que pueden marcar la diferencia en tus resultados.

Deep Scraping para Inteligencia Competitiva

Imagina que tu equipo de ventas quiere contactar empresas que acaban de lanzar un producto nuevo. Un deep crawler puede:

- Escanear sitios de la competencia en busca de nuevas páginas de productos

- Seguir enlaces a notas de prensa o actualizaciones para inversores

- Sacar detalles clave (fechas de lanzamiento, precios, características)

- Enviar esos datos a tu CRM o herramientas de análisis

¿El resultado? Decisiones más rápidas e inteligentes—y una ventaja real frente a quienes solo raspan la superficie.

Cumplimiento y Buenas Prácticas: Qué Tener en Cuenta al Usar Deep Crawlers

Un gran poder de rastreo implica una gran responsabilidad. Los deep crawlers pueden acceder a mucha información—pero eso no significa que debas recopilar todo lo que encuentres. Ten en cuenta lo siguiente:

Privacidad de Datos y Derechos de Autor

- Respeta los términos de servicio de los sitios: Muchos sitios dejan claro lo que está permitido en sus TOS. Ignorarlos puede traerte problemas legales ().

- Evita sacar datos personales o confidenciales sin permiso explícito.

- Cuida los derechos de autor: No publiques ni vendas contenido extraído sin revisar los derechos correspondientes.

Raspado Responsable

- Regula la frecuencia de tus solicitudes: No satures los sitios con demasiadas peticiones a la vez.

- Consulta el robots.txt: Aunque no es legalmente vinculante, es buena práctica respetar las preferencias de rastreo de los sitios.

- Mantente al día con la legislación: Normativas como GDPR y CCPA pueden afectar qué datos puedes recopilar y cómo los usas ().

Para más detalles, consulta .

Cómo Elegir el Deep Crawler Perfecto para tu Negocio

Entonces, ¿cómo elegir el deep crawler ideal? Esto es lo que yo miro:

- Facilidad de uso: ¿Puede usarlo alguien sin conocimientos técnicos? (Thunderbit: sí.)

- Escalabilidad: ¿Aguanta sitios grandes, muchas páginas y contenido dinámico?

- Herramientas de cumplimiento: ¿Te ayuda a mantenerte dentro de la legalidad?

- Integración: ¿Permite exportar datos a las herramientas que ya usas (Excel, Sheets, Notion, Airtable)?

- Mantenimiento: ¿Se adapta solo a los cambios de los sitios o tendrás que arreglar scripts cada semana?

Thunderbit está pensado para todo esto. Lo usan , desde emprendedores hasta grandes empresas, y su precio permite que incluso pequeños negocios puedan empezar desde solo $15/mes.

Conclusiones: El Futuro del Deep Crawling en la Estrategia de Datos Empresarial

En resumen:

- Los deep crawlers son clave para sacar datos completos y precisos de sitios web complejos y dinámicos.

- Van mucho más allá de los rastreadores tradicionales al manejar navegación multinivel, contenido dinámico y datos escondidos.

- Los equipos de negocio usan deep crawlers para descubrir insights, impulsar ventas, vigilar a la competencia y tomar decisiones más rápidas.

- El cumplimiento es fundamental: Siempre raspa de forma responsable, respeta la privacidad y sigue las normas.

- Thunderbit hace el deep crawling accesible para todos, con funciones de IA, sin necesidad de código y exportación de datos sencilla.

Si quieres dejar atrás el raspado superficial y empezar a profundizar, y comprueba lo fácil que puede ser el deep crawling. Y para más consejos, visita el para guías, buenas prácticas y lo último en raspado web con IA.

Preguntas Frecuentes

1. ¿Qué es un deep crawler y en qué se diferencia de un rastreador web normal?

Un deep crawler es una herramienta de raspado web hecha para navegar por varias capas de un sitio, sacando datos de subpáginas, contenido dinámico y secciones ocultas. A diferencia de los rastreadores tradicionales, que solo recorren la superficie, los deep crawlers aseguran una recopilación de datos completa siguiendo enlaces y gestionando estructuras complejas.

2. ¿Por qué las empresas necesitan deep crawlers en 2025?

Los sitios web son más complejos que nunca, con datos muchas veces escondidos tras menús, pestañas o elementos dinámicos. Los deep crawlers ayudan a las empresas a sacar sets de datos completos para ventas, marketing, investigación e inteligencia competitiva—algo que los raspadores básicos no pueden hacer.

3. ¿Cómo simplifica Thunderbit el deep crawling para usuarios sin experiencia técnica?

Thunderbit usa IA para sugerir campos, gestionar el raspado de subpáginas y manejar contenido dinámico—todo desde una interfaz sencilla y sin código. Solo tienes que describir lo que necesitas, hacer clic en “Scrape” y exportar los resultados a tus herramientas favoritas.

4. ¿Qué cuestiones de cumplimiento debo considerar al usar un deep crawler?

Respeta siempre los términos de servicio de los sitios, evita sacar datos personales o confidenciales sin permiso y mantente actualizado sobre leyes de privacidad como GDPR y CCPA. El raspado responsable y el uso adecuado de los datos son clave para evitar problemas legales.

5. ¿Pueden los deep crawlers ayudar a mi equipo de ventas y marketing a obtener mejores resultados?

Por supuesto. Los deep crawlers permiten acceder a datos más completos y útiles de e-commerce, inmobiliarias y sitios de la competencia—impulsando la generación de leads, el análisis de mercado y la toma de decisiones más rápida. Con herramientas como Thunderbit, incluso los equipos sin perfil técnico pueden acceder a los insights que necesitan para crecer.

Más información