¿Alguna vez te has preguntado cómo las empresas logran transformar montones de datos dispersos en paneles visuales y análisis con IA? Créeme, no eres el único. El truco está en la ingesta de datos: ese héroe silencioso que pone en marcha cualquier proceso empresarial basado en datos. En un mundo donde se calcula que para 2025 generaremos (sí, ¡21 ceros!), mover datos del punto A al B—de manera rápida, precisa y en un formato útil—es más importante que nunca.

Después de años metido en el mundo SaaS y la automatización, he visto de primera mano cómo una buena estrategia de ingesta de datos puede cambiar el rumbo de cualquier negocio. Ya sea que estés gestionando leads, monitoreando tendencias o simplemente asegurando que todo funcione sin líos, entender el significado de ingesta de datos (y cómo está evolucionando) es el primer paso para sacarle jugo real a la información. Así que vamos al grano: ¿qué significa ingerir datos, por qué es tan relevante y cómo herramientas modernas—como —están cambiando el juego para analistas, emprendedores y equipos de todo tipo?

¿Qué es la ingesta de datos? La base de los negocios data-driven

En pocas palabras, la ingesta de datos es el proceso de recolectar, importar y cargar datos desde diferentes fuentes hacia un sistema central—como una base de datos, un data warehouse o un data lake—para que luego puedan analizarse, visualizarse o usarse en la toma de decisiones. Piensa en la ingesta como la “puerta de entrada” a tu canal de datos: es la forma de llevar todos esos ingredientes crudos (hojas de cálculo, APIs, logs, páginas web, sensores) a tu cocina antes de empezar a preparar los insights.

La ingesta de datos es la primera parada de cualquier canal de datos (), rompiendo silos y asegurando que la información de calidad y a tiempo esté disponible para análisis, inteligencia de negocio y machine learning. Sin este paso, la información valiosa se queda atrapada en sistemas aislados—“invisible para quienes la necesitan”, como bien dice un experto del sector.

Así se ve el proceso general:

- Ingesta de datos: Recoge datos en bruto de varias fuentes y los lleva a un repositorio central.

- Integración de datos: Junta y alinea datos de diferentes orígenes para que trabajen juntos.

- Transformación de datos: Limpia, da formato y enriquece los datos para que estén listos para el análisis.

Imagina la ingesta como traer todas tus compras a casa desde diferentes tiendas. La integración es organizarlas en la despensa, y la transformación es preparar y cocinar la comida.

¿Por qué la ingesta de datos es clave para las empresas de hoy?

Hablemos claro: hoy, tener datos bien ingeridos y a tiempo es un activo estratégico. Las empresas que dominan la ingesta de datos pueden romper silos, obtener insights en tiempo real y tomar decisiones más rápidas e inteligentes. Si la ingesta falla, los reportes llegan tarde, se pierden oportunidades y las decisiones se basan en datos viejos o incompletos.

Algunos ejemplos de cómo una ingesta eficiente puede marcar la diferencia:

| Caso de uso | **¿Cómo ayuda una ingesta eficiente de datos? |

|---|---|

| Generación de leads de ventas | Junta leads de formularios web, redes sociales y bases de datos en un solo sistema casi en tiempo real, permitiendo que los equipos de ventas respondan más rápido y cierren más ventas. |

| Paneles operativos | Alimenta continuamente los datos de sistemas de producción en plataformas analíticas, mostrando KPIs actualizados y permitiendo tomar acciones rápidas. |

| Visión 360° del cliente | Une datos de clientes de CRM, soporte, e-commerce y redes sociales para crear perfiles completos y ofrecer marketing personalizado y atención proactiva (Cake.ai). |

| Mantenimiento predictivo | Ingresa grandes volúmenes de datos de sensores e IoT, permitiendo que los modelos analíticos detecten anomalías y predigan fallos antes de que ocurran, reduciendo tiempos de inactividad y costes. |

| Análisis de riesgo financiero | Transmite datos de transacciones y mercados a modelos de riesgo, dando a bancos y traders una visión en tiempo real de exposiciones y permitiendo detectar fraudes al instante. |

Y los números lo respaldan: , pero esas inversiones solo sirven si los datos pueden ingerirse y ser confiables.

Ingesta de datos vs. integración y transformación: despejando dudas

Es fácil hacerse un lío con los términos, así que vamos a aclarar:

- Ingesta de datos: El primer paso, recolectar e importar datos en bruto desde los sistemas fuente. Piensa: “Llevar todo a la cocina”.

- Integración de datos: Combinar y alinear datos de diferentes fuentes, asegurando consistencia y una visión unificada. Piensa: “Organizar la despensa”.

- Transformación de datos: Convertir los datos de crudos a utilizables—limpiando, formateando, agregando y enriqueciendo. Piensa: “Preparar y cocinar la comida”.

Un error común es pensar que ingesta y ETL (Extract, Transform, Load) son lo mismo. En realidad, la ingesta es solo la parte de “extraer”—traer los datos en bruto. La integración y transformación vienen después, dejando los datos listos para el análisis ().

¿Y esto por qué importa? Si solo necesitas un set de datos rápido de una web, una herramienta ligera de ingesta puede bastar. Pero si vas a combinar y limpiar datos de varios sistemas, también necesitarás integración y transformación.

Métodos clásicos de ingesta de datos: ETL y sus límites

Durante años, el método estrella para la ingesta de datos fue el ETL (Extract, Transform, Load). Los ingenieros de datos escribían scripts o usaban software especializado para extraer datos periódicamente, limpiarlos y cargarlos en un data warehouse. Normalmente, esto se hacía en lotes—por ejemplo, con actualizaciones nocturnas.

Pero a medida que el volumen y la variedad de datos crecieron, el ETL tradicional empezó a quedarse corto:

- Configuración compleja y lenta: Montar y mantener pipelines ETL requería mucho código y conocimientos técnicos. Los equipos no técnicos dependían de IT para todo ().

- Procesamiento por lotes: Los trabajos ETL se ejecutaban en lotes, retrasando la disponibilidad de los datos. En un mundo donde los insights instantáneos son clave, esperar horas o días ya no es opción ().

- Problemas de escalabilidad y velocidad: Los pipelines antiguos a menudo no soportan los volúmenes actuales, requiriendo ajustes y mejoras constantes.

- Rigidez: Añadir nuevas fuentes o cambiar esquemas era complicado y podía romper el pipeline.

- Alto mantenimiento: Los pipelines podían fallar por múltiples motivos, exigiendo atención continua de los ingenieros.

- Limitado a datos estructurados: El ETL clásico fue diseñado para datos ordenados, no para datos desestructurados (como páginas web o imágenes), que ahora representan .

En resumen: el ETL funcionó bien en tiempos más simples, pero hoy no da abasto con la velocidad, escala y diversidad de los datos actuales.

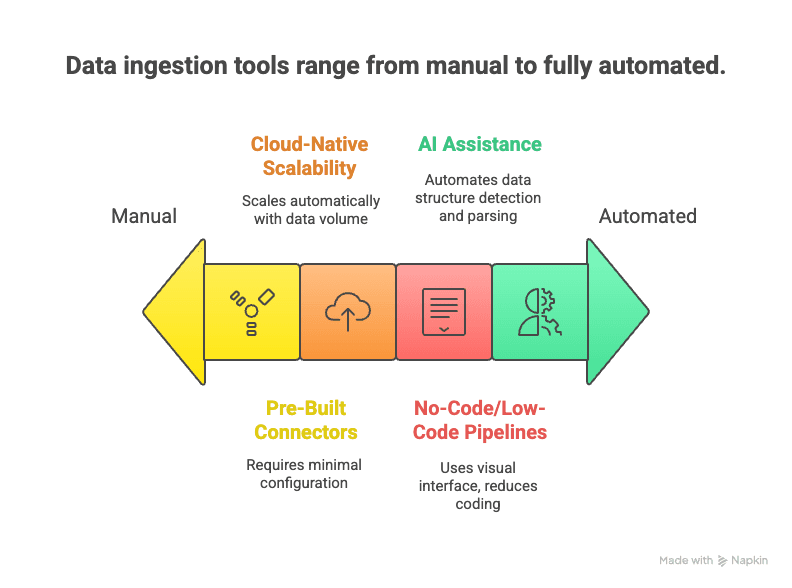

La nueva ola: ingesta de datos moderna con IA y automatización

Ahora llegan las nuevas soluciones: herramientas modernas de ingesta de datos que aprovechan la automatización, la nube y la inteligencia artificial para que recolectar datos sea más rápido, sencillo y flexible.

¿Qué las hace diferentes?

- Pipelines sin código o de bajo código: Interfaces visuales y asistentes de IA permiten armar flujos de datos sin programar ().

- Conectores listos para usar: Cientos de conectores para fuentes populares—solo mete tus credenciales y listo.

- Escalabilidad en la nube: Servicios elásticos que procesan grandes volúmenes de datos en tiempo real ().

- Soporte para tiempo real y streaming: Permiten ingesta tanto por lotes como en streaming, según lo que necesites ().

- Asistencia por IA: La IA puede detectar estructuras de datos, sugerir reglas de análisis y hasta hacer controles de calidad automáticamente ().

- Soporte para datos desestructurados: Técnicas de NLP y visión por computadora convierten páginas web, PDFs o imágenes en tablas estructuradas.

- Menor mantenimiento: Servicios gestionados que se encargan del monitoreo, escalado y actualizaciones—para que te concentres en usar los datos, no en mantener pipelines.

¿El resultado? Ingesta de datos más rápida de implementar, fácil de modificar y capaz de manejar la complejidad de los datos actuales.

Ingesta de datos en la vida real: aplicaciones y retos por sector

Veamos cómo se aplica la ingesta de datos en diferentes industrias y los desafíos que enfrentan.

Retail y e-commerce

Las tiendas integran datos de puntos de venta, webs, apps de fidelización y sensores en tienda. Al juntar transacciones, clics e inventarios, logran una visión en tiempo real de existencias y tendencias. El reto: manejar grandes volúmenes de datos rápidos (sobre todo en picos de ventas) e integrar canales online y offline.

Finanzas y banca

Bancos y firmas de trading procesan flujos de transacciones, mercados e interacciones de clientes. La ingesta en tiempo real es clave para detectar fraudes y gestionar riesgos. Pero los requisitos de seguridad y cumplimiento hacen que cualquier fallo sea crítico.

Tecnología y empresas de internet

Las grandes tecnológicas procesan enormes flujos de eventos en tiempo real (cada clic, like o share) para analizar el comportamiento de usuarios y alimentar motores de recomendación. El reto es filtrar el ruido y asegurar la calidad y consistencia de los datos.

Salud

Hospitales integran datos de historiales médicos, laboratorios y dispositivos para crear expedientes unificados y habilitar análisis predictivos. Los grandes obstáculos: interoperabilidad (diferentes sistemas “hablando” distintos lenguajes) y privacidad del paciente.

Inmobiliaria

Las empresas inmobiliarias recopilan datos de portales, webs de propiedades y registros públicos para construir bases de datos completas. El reto es fusionar datos de fuentes variadas—muchas veces desestructuradas—y mantenerlos actualizados a medida que cambian los listados.

Desafíos comunes en todos los sectores:

- Gestionar la variedad de datos (estructurados, semiestructurados, desestructurados)

- Equilibrar necesidades en tiempo real vs. por lotes

- Asegurar calidad y consistencia de los datos

- Cumplir requisitos de seguridad y normativas

- Escalar para manejar el crecimiento de los datos

Superar estos retos es clave para lograr mejores resultados: análisis más precisos, decisiones en tiempo real y mayor cumplimiento normativo.

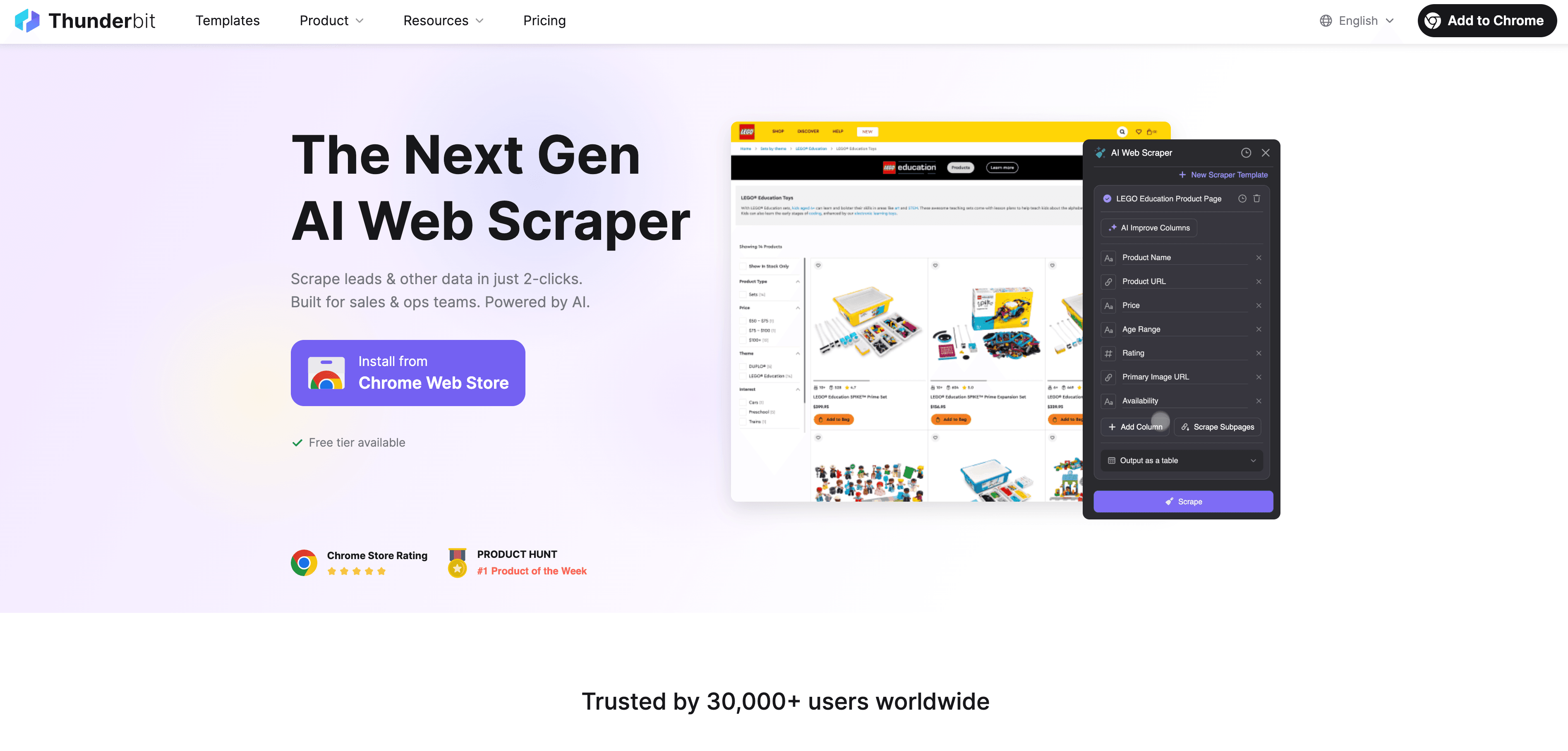

Thunderbit: ingesta de datos fácil con AI Web Scraper

Ahora, veamos cómo Thunderbit encaja en este panorama. es una extensión de Chrome con IA que permite a cualquiera extraer datos web fácilmente, sin saber programar.

¿Por qué Thunderbit es un antes y un después para los usuarios de negocio?

- Raspado web en 2 clics: Pasa de una web desordenada a un dataset estructurado en solo dos clics. Haz clic en “Sugerir campos con IA” y luego en “Extraer”—¡y listo!

- Sugerencias inteligentes de campos: La IA de Thunderbit analiza la página y recomienda las mejores columnas a extraer, ya sea un directorio de empresas, un listado de productos o un perfil de LinkedIn.

- Extracción automática de subpáginas: ¿Necesitas más detalles? Thunderbit puede visitar cada subpágina (como detalles de productos o perfiles individuales) y enriquecer tu tabla automáticamente.

- Gestión de paginación: Puede manejar listas paginadas y páginas con scroll infinito, para que no se te escape ningún dato.

- Plantillas predefinidas: Para sitios populares como Amazon, Zillow o Shopify, Thunderbit ofrece plantillas de un solo clic—sin configuración.

- Exportación gratuita de datos: Exporta tus datos directamente a Excel, Google Sheets, Airtable o Notion—sin coste adicional.

- Raspado programado: Programa extracciones automáticas con la frecuencia que necesites (por ejemplo, revisiones diarias de precios de la competencia).

- AI Autofill: Automatiza el llenado de formularios y tareas repetitivas en la web.

Thunderbit es perfecto para equipos de ventas buscando leads, analistas de ecommerce monitoreando precios o agentes inmobiliarios recopilando listados. El objetivo: transformar datos web desordenados en insights útiles, rápido.

Si quieres ver Thunderbit en acción, pásate por nuestro o explora nuestro para más guías.

Comparativa: ingesta de datos tradicional vs. moderna

Aquí tienes una comparación rápida:

| Criterio | Herramientas ETL tradicionales | Herramientas modernas IA/Nube | Thunderbit (AI Web Scraper) |

|---|---|---|---|

| Nivel de experiencia | Alto (requiere programación/IT) | Medio (bajo código, algo de configuración) | Bajo (2 clics, sin código) |

| Fuentes de datos | Estructuradas (bases de datos, CSV) | Amplias (bases de datos, SaaS, APIs) | Cualquier web, datos desestructurados |

| Velocidad de despliegue | Lenta (semanas/meses) | Más rápida (días) | Instantánea (minutos) |

| Soporte en tiempo real | Limitado (por lotes) | Fuerte (streaming/lotes) | Bajo demanda y programado |

| Escalabilidad | Difícil | Alta (nube nativa) | Media/Alta (raspado en la nube) |

| Mantenimiento | Alto (pipelines frágiles) | Medio (servicios gestionados) | Bajo (IA se adapta a cambios) |

| Transformación | Rígida, previa a la carga | Flexible, tras la carga | Básica (sugerencias IA) |

| Mejor caso de uso | Integración interna por lotes | Canales analíticos | Datos web, fuentes externas |

¿La conclusión? Elige la herramienta según la tarea. Para datos web o fuentes desestructuradas, Thunderbit suele ser la opción más rápida y sencilla.

El futuro de la ingesta de datos: automatización y cloud-first

Mirando hacia adelante, la ingesta de datos será cada vez más inteligente y automatizada. ¿Qué se viene?

- Tiempo real por defecto: El modelo por lotes va quedando atrás. Cada vez más pipelines se diseñan para datos en tiempo real y eventos ().

- Cloud-first y “Zero ETL”: Las plataformas en la nube facilitan conectar fuentes y destinos sin pipelines manuales.

- Automatización con IA: El machine learning tendrá un papel clave en configurar, monitorear y optimizar pipelines—detectando anomalías, corrigiendo errores y enriqueciendo datos al vuelo.

- No-code y autoservicio: Más herramientas permitirán a usuarios de negocio crear flujos de datos con lenguaje natural o interfaces visuales.

- Ingesta en el edge y IoT: A medida que se genera más información en el edge, la ingesta ocurrirá cerca de la fuente, con filtrado y agregación inteligente.

- Gobernanza y metadatos: Etiquetado automático, trazabilidad y cumplimiento estarán integrados en cada paso.

En resumen: el futuro es una ingesta de datos más rápida, accesible y confiable—para que puedas centrarte en los insights, no en la infraestructura.

Conclusión: lo que debes recordar si trabajas con datos

- La ingesta de datos es el primer paso esencial en cualquier iniciativa basada en datos. Si quieres insights, necesitas ingresar los datos—de forma rápida y fiable.

- Herramientas modernas con IA como Thunderbit democratizan la ingesta de datos. Con scraping en 2 clics, sugerencias inteligentes y tareas programadas, puedes convertir datos web desordenados en oro para tu negocio.

- Elegir la herramienta adecuada es clave: usa ETL tradicional para datos internos y estructurados; herramientas cloud para análisis amplios; y Thunderbit para datos web y desestructurados.

- Mantente a la vanguardia: la automatización, la nube y la IA están haciendo la ingesta de datos más inteligente y sencilla. No te quedes atrás—explora nuevas soluciones y prepara tu estrategia de datos para el futuro.

Preguntas frecuentes

1. ¿Qué es la ingesta de datos, en palabras simples?

La ingesta de datos es el proceso de recolectar e importar datos de diferentes fuentes (como webs, bases de datos o archivos) a un sistema central para analizarlos o usarlos en decisiones de negocio. Es el primer paso de cualquier canal de datos.

2. ¿En qué se diferencia la ingesta de la integración y la transformación de datos?

La ingesta es traer los datos en bruto. La integración los junta y alinea desde diferentes fuentes, mientras que la transformación los limpia y da formato para el análisis. Piensa: ingesta = reunir, integración = organizar, transformación = preparar y cocinar.

3. ¿Cuáles son los mayores retos de los métodos tradicionales de ingesta?

Los métodos clásicos como ETL son lentos de implementar, requieren mucho código, no manejan bien datos desestructurados y no se adaptan a las necesidades en tiempo real. Además, son difíciles de mantener y poco flexibles ante cambios en las fuentes.

4. ¿Cómo facilita Thunderbit la ingesta de datos?

Thunderbit usa IA para que cualquiera pueda extraer y estructurar datos web en solo dos clics—sin programar. Puede manejar subpáginas, paginación e incluso programar tareas recurrentes, exportando directamente a Excel, Google Sheets, Airtable o Notion.

5. ¿Cuál es el futuro de la ingesta de datos?

El futuro está en la automatización, las estrategias cloud-first y los pipelines impulsados por IA. Veremos más flujos de datos en tiempo real, gestión inteligente de errores y herramientas que permiten a los usuarios de negocio configurar la ingesta con lenguaje natural o interfaces visuales.

Más información: