¿Alguna vez te has preguntado cómo Google logra saberlo todo sobre internet, o cómo los sitios de comparación de precios actualizan sus ofertas en tiempo real? Detrás de todo esto, hay verdaderos ejércitos de “arañas” digitales que recorren la web sin parar, mapeando el caos online para que tú encuentres lo que buscas en segundos. Hoy en día, casi la mitad del tráfico en internet viene de bots—la mayoría, crawlers—que se dedican a recopilar, indexar y organizar información para buscadores, modelos de IA y empresas ().

Como alguien que lleva años desarrollando herramientas de automatización e IA en Thunderbit, te puedo decir que entender cómo funcionan los crawlers puede marcar la diferencia para cualquier negocio. Ya sea en ventas, ecommerce u operaciones, saber qué son los crawlers—y cómo soluciones modernas potenciadas por IA como trabajan—te abre la puerta a nuevos datos, automatización de investigaciones y una ventaja frente a la competencia. Vamos a ver cómo funcionan estos motores invisibles y por qué hoy son más importantes que nunca.

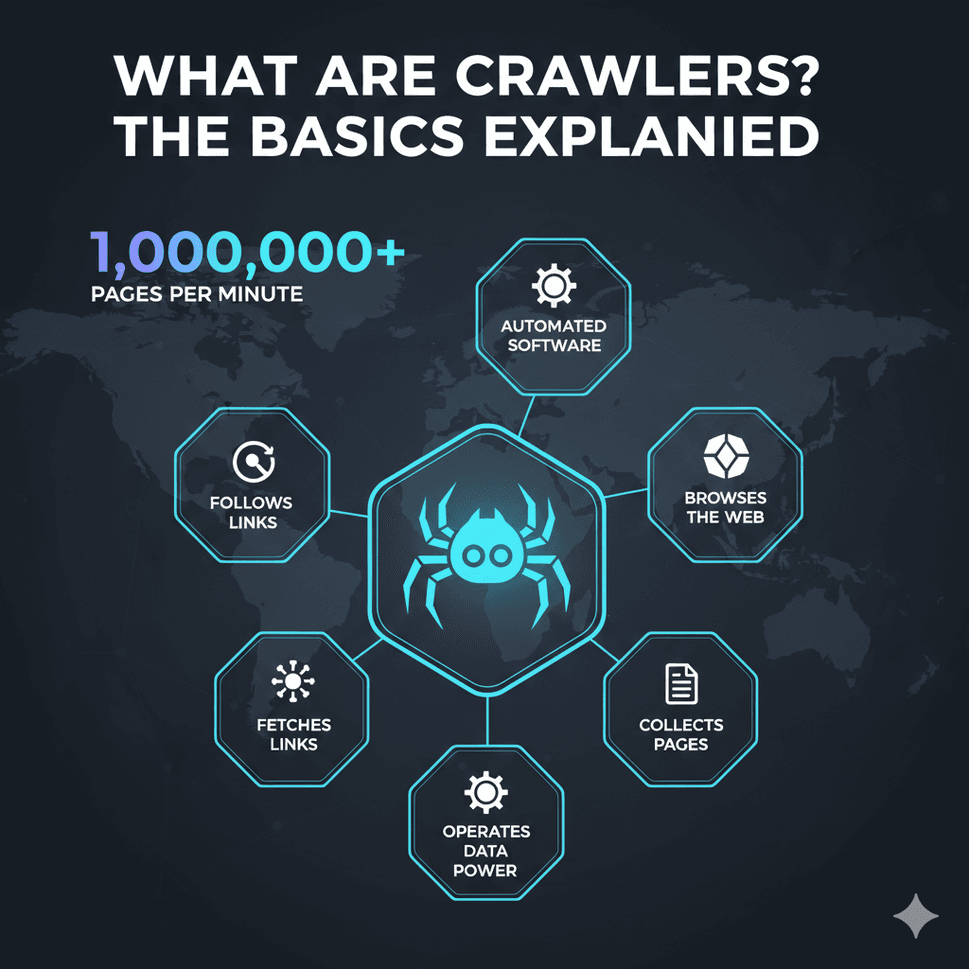

¿Qué son los crawlers? Conceptos básicos

Entonces, ¿qué es exactamente un crawler? En pocas palabras, un crawler (también llamado spider o bot) es un programa que navega por la web de forma automática, visitando páginas, siguiendo enlaces y recopilando información. Piensa en los crawlers como bibliotecarios incansables de internet: visitan sitios, leen su contenido y lo catalogan para que luego pueda ser encontrado (, ).

Una forma fácil de entenderlo: imagina la web como una ciudad gigante y a los crawlers como repartidores que empiezan en una dirección, anotan lo que ven y siguen cada señal (enlace) hacia el siguiente lugar. Repiten este proceso sin descanso, construyendo un gran mapa digital de internet.

Algunos de los crawlers más famosos son Googlebot (de Google), Bingbot (de Bing) y los nuevos bots de IA como GPTBot (de OpenAI). Estos bots son los responsables de indexar cientos de miles de millones de páginas web—solo el índice de Google ocupa más de 100 millones de gigabytes (). Sin crawlers, los buscadores, asistentes de IA y muchas herramientas empresariales simplemente no existirían.

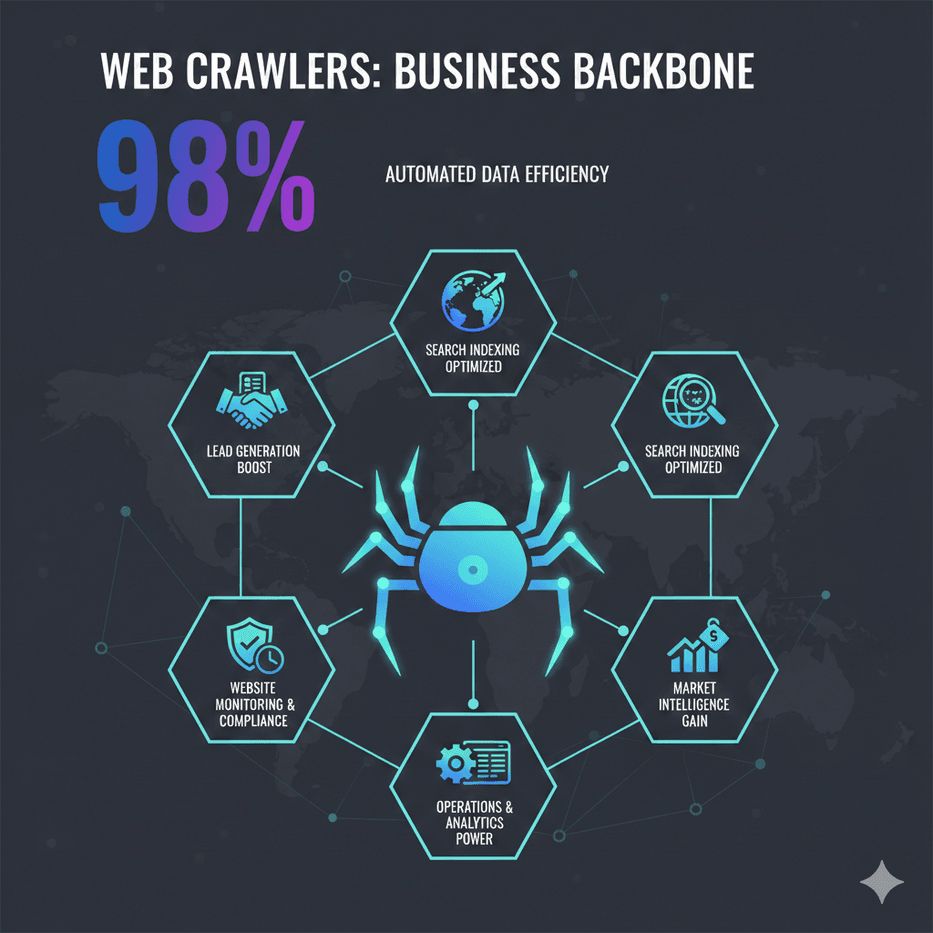

Por qué importan los crawlers: funciones clave y aplicaciones en negocios

Los crawlers no son solo cosa de buscadores—son la base de muchos procesos empresariales actuales. Esto es lo que mejor hacen:

- Indexación para buscadores: Los crawlers exploran la web para que los motores de búsqueda puedan mostrarte resultados relevantes al instante. Si tu sitio no es rastreado, no existes en Google ni Bing ().

- Extracción de datos e inteligencia de mercado: Las empresas usan crawlers (y raspadores) para recopilar precios de la competencia, detalles de productos, reseñas y más. Por ejemplo, el minorista británico John Lewis aumentó sus ventas un 4% usando crawlers para precios de la competencia, mientras que ASOS duplicó sus ventas internacionales gracias a datos web regionales ().

- Monitoreo web y cumplimiento: Los crawlers pueden vigilar tu propio sitio o el de la competencia para detectar cambios—como lanzamientos de productos, actualizaciones de precios o revisiones de cumplimiento.

- Generación de leads: Los equipos de ventas usan crawlers para recolectar información de contacto de directorios o listados empresariales, automatizando tareas que antes requerían horas de trabajo manual.

- Operaciones y analítica: Desde el seguimiento de inventarios hasta la agregación de listados inmobiliarios, los crawlers alimentan paneles y herramientas de análisis para tomar mejores decisiones.

Aquí tienes una tabla resumen de los usos de crawlers según el área de negocio:

| Equipo/Función | Caso de uso de crawler | Beneficio obtenido |

|---|---|---|

| Ventas & Leads | Recopilar contactos de sitios web o directorios | Listas de leads automatizadas; crecimiento del pipeline sin trabajo manual |

| Marketing/Investigación | Monitorear sitios de la competencia y reseñas online | Inteligencia de mercado en tiempo real; estrategias mejor informadas |

| Ecommerce & Retail | Raspado de precios y monitoreo de productos en sitios de la competencia | Precios dinámicos; mejores márgenes y más ingresos |

| Operaciones/Producto | Detección de cambios en sitios para cumplimiento o actualizaciones | Control de calidad; respuesta rápida a cambios externos |

| Analítica de datos & IA | Recolección masiva de datos para análisis o entrenamiento de IA | Insights basados en datos; material para aprendizaje automático |

()

¿Cómo funcionan los crawlers? Paso a paso

Aunque suene complicado, el proceso básico de un crawler es bastante directo ():

- URLs semilla: El crawler arranca con una lista inicial de direcciones web (las “semillas”). Puede ser una página principal, un sitemap o una lista personalizada.

- Recopilación: El crawler visita cada URL y descarga el HTML de la página (igual que tu navegador).

- Análisis y extracción: Lee la página, extrae información útil (texto, metadatos, enlaces) y apunta cada hipervínculo que encuentra.

- Almacenamiento e indexación: Los datos extraídos se guardan en una base de datos o índice, listos para búsquedas o análisis.

- Seguimiento de enlaces: Todos los nuevos enlaces se agregan a la cola y el crawler repite el proceso, explorando la web sin parar.

Los crawlers modernos son respetuosos: revisan el archivo robots.txt de cada sitio para saber qué pueden acceder y limitan la velocidad de sus solicitudes para no saturar los servidores (). Los buscadores incluso usan “presupuestos de rastreo” para decidir con qué frecuencia revisitar un sitio, priorizando las páginas más importantes o actualizadas.

Crawlers vs. Scrapers: ¿En qué se diferencian?

Muchas veces se usan los términos “crawling” y “scraping” como si fueran lo mismo, pero hay una diferencia clave ():

- Crawling se enfoca en descubrir e indexar la mayor cantidad de páginas posible (como mapear la web).

- Scraping consiste en extraer datos específicos de páginas concretas (por ejemplo, obtener precios de una ficha de producto).

En la práctica, suelen ir juntos: primero se rastrea un sitio para encontrar todas las páginas de productos y luego se extraen los detalles de cada una. Entender esta diferencia te ayuda a elegir la herramienta adecuada para cada tarea.

Tipos de crawlers: de buscadores a bots con IA

No todos los crawlers son iguales. Estos son los principales tipos que puedes encontrar ():

- Crawlers de buscadores: Los grandes como Googlebot, Bingbot, Baidu Spider y Yandex Bot. Su misión: indexar toda la web para que puedas buscar en ella.

- Crawlers enfocados: Diseñados para buscar páginas sobre un tema específico (por ejemplo, solo portales de empleo o noticias sobre “cambio climático”).

- Crawlers incrementales: Optimizados para detectar y recopilar solo contenido nuevo o actualizado, ahorrando tiempo y recursos.

- Crawlers de la web profunda: Capaces de acceder a contenido detrás de formularios, inicios de sesión o páginas ocultas.

- Crawlers de auditoría de sitios: Herramientas como Screaming Frog o la auditoría de sitios de SEMrush, usadas para revisar tu propio sitio en busca de errores SEO o de calidad.

- Crawlers de comparación/monitoreo: Utilizados por empresas para rastrear precios de la competencia, cambios de productos o cumplimiento en sitios concretos.

- Crawlers con IA: Los más recientes—como GPTBot de OpenAI o CCBot de Common Crawl—diseñados para recopilar datos para entrenar IA o usar IA para decidir qué y cómo rastrear ().

Los crawlers con IA están cambiando las reglas del juego. En 2025, los bots relacionados con IA ya representan cerca del 30% del tráfico web—y esa cifra sigue subiendo ().

Retos de los crawlers tradicionales y soluciones modernas

A medida que la web se complica, los crawlers clásicos se topan con varios retos:

- Defensas anti-crawling: CAPTCHAs, bloqueos de IP, límites de velocidad y técnicas de fingerprinting pueden frenar a los bots tradicionales. Más del 95% de los fallos en scraping se deben a medidas anti-bot ().

- Contenido dinámico: Muchos sitios cargan datos con JavaScript o scroll infinito, lo que los crawlers básicos no pueden manejar. Ahora son imprescindibles los navegadores sin cabeza y el análisis con IA ().

- Cambios frecuentes en sitios: Si un sitio cambia su diseño, los scrapers tradicionales se rompen y requieren ajustes manuales. El mantenimiento es un dolor de cabeza constante.

- Escalabilidad y velocidad: Rastrear millones de páginas rápido requiere sistemas distribuidos y cloud, algo que va mucho más allá de lo que puede hacer un solo ordenador.

- Cuestiones legales y éticas: Respetar

robots.txt, las leyes de privacidad y los términos de uso es más importante que nunca.

Las soluciones modernas—incluyendo herramientas con IA—están a la altura. Usan machine learning para adaptarse a cambios de diseño, simulan navegadores reales e incluso interpretan páginas como lo haría una persona. Por ejemplo, los scrapers con IA ya pueden extraer datos de PDFs, imágenes o páginas no estándar, siendo mucho más flexibles y resistentes.

Thunderbit: crawlers optimizados para la web diversa de hoy

Aquí es donde entra Thunderbit. En , hemos creado un crawler y raspador web con IA pensado para la web caótica y cambiante de 2025. ¿Nuestro objetivo? Que cualquier persona pueda acceder a datos web, no solo los desarrolladores.

¿Qué hace diferente a Thunderbit?

- Simplicidad impulsada por IA: Solo haz clic en “Sugerir campos con IA” y la IA de Thunderbit analiza la página, sugiere las mejores columnas de datos (como “Nombre del producto”, “Precio”, “Valoración”) y configura la extracción por ti. Sin código, sin complicaciones con HTML—solo haz clic y listo ().

- Manejo de páginas complejas y de nicho: La IA de Thunderbit se adapta a diseños inusuales, contenido dinámico e incluso páginas no estándar. Es especialmente eficaz extrayendo datos de sitios de nicho o páginas que rompen los scrapers tradicionales.

- Rastreo de subpáginas y paginación: ¿Necesitas detalles de cada producto en una categoría? Thunderbit sigue enlaces automáticamente, rastrea subpáginas y unifica los datos en una sola tabla—sin configuración manual ().

- Modos en la nube y navegador: Elige scraping rápido en la nube para sitios públicos, o modo navegador para sitios que requieren login o protección extra.

- Exportación gratuita de datos: Exporta tus datos directamente a Excel, Google Sheets, Airtable o Notion—sin costes ocultos ().

- Sin código, listo para negocios: Thunderbit está pensado para usuarios de negocio—ventas, marketing, ecommerce y operaciones—que solo quieren resultados, sin complicaciones técnicas.

Thunderbit vs. crawlers tradicionales: comparación de funciones

Así se compara Thunderbit con las herramientas clásicas:

| Funcionalidad | Thunderbit (con IA) | Crawlers/Scrapers tradicionales |

|---|---|---|

| Tiempo de configuración | 2 clics con IA | Configuración manual, curva alta |

| Adaptabilidad | La IA se ajusta a cambios | Se rompe con cambios de diseño |

| Manejo de contenido dinámico | Sí (IA y navegador sin cabeza) | Limitado o requiere ajustes |

| Rastreo de subpáginas/paginación | Automático, integrado | Requiere scripts manuales |

| Exportación de datos | Gratis a Excel, Sheets, Notion | Suele tener límites o coste extra |

| Habilidad técnica necesaria | Ninguna (sin código) | Requiere conocimientos técnicos |

| Mantenimiento | Mínimo (la IA reaprende) | Arreglos manuales frecuentes |

| Plantillas para sitios populares | 1 clic, siempre actualizadas | Comunidad/compartidas, pueden estar desactualizadas |

| Precio | Plan gratuito y opciones asequibles | Suele ser caro para funciones completas |

()

Dentro de Thunderbit: funciones innovadoras que simplifican el crawling

Veamos más de cerca qué hace especial a Thunderbit:

- Sugerencia de campos con IA: Mi favorita personal. Un solo clic y la IA de Thunderbit lee la página, sugiere las columnas más relevantes y hasta crea prompts de extracción. Olvídate de adivinar selectores o nombres de campos.

- Rastreo de subpáginas: Tras extraer una página de listado, haz clic en “Extraer subpáginas” y Thunderbit visitará cada enlace (como fichas de producto), enriqueciendo tu tabla automáticamente.

- Plantillas instantáneas: Para sitios populares (Amazon, Zillow, Instagram, Shopify), Thunderbit ofrece plantillas de 1 clic—sin configuración, solo resultados.

- Extractores gratuitos de emails, teléfonos e imágenes: ¿Necesitas todos los emails o imágenes de una página? Thunderbit lo hace en un clic, gratis.

- Scraping programado: Programa extracciones recurrentes (diarias, semanales, etc.) usando lenguaje natural. Ideal para monitoreo de precios o chequeos de mercado.

- Scraping en la nube o navegador: Elige el modo que más te convenga—nube para velocidad, navegador para sitios complejos.

Thunderbit ya es la herramienta de confianza de más de 30,000 usuarios en todo el mundo, desde emprendedores hasta grandes empresas (). Y sí, hay un para que lo pruebes sin compromiso.

Cómo gestionar el acceso de crawlers: buenas prácticas para empresas

Tanto si tienes un sitio web como si usas crawlers, gestionar el acceso es fundamental:

Para propietarios de sitios web:

- Usa

robots.txtpara definir reglas—bloquea secciones sensibles, permite bots de buscadores, bloquea crawlers no deseados (). - Añade metaetiquetas (

noindex,nofollow) para controlar qué se indexa. - Monitorea el tráfico de bots y ajusta la frecuencia de rastreo si es necesario.

- Equilibra SEO (visibilidad) y protección de contenido—no bloquees los bots que te interesan (como Googlebot).

Para empresas que usan crawlers:

- Respeta siempre

robots.txty los términos del sitio—la ética es clave. - Identifica tu bot con un user-agent claro.

- Limita la velocidad de las solicitudes para no saturar servidores.

- Usa APIs cuando estén disponibles y solo extrae datos públicos.

- Monitorea el impacto de tu crawler y ajusta según sea necesario.

Conclusión: el papel de los crawlers en la estrategia de datos empresarial

Los crawlers han pasado de ser simples “arañas” a convertirse en la columna vertebral de la búsqueda, la IA y la inteligencia de negocio. En un mundo donde los datos lo son todo, entender qué son los crawlers—y cómo aprovechar herramientas modernas con IA como Thunderbit—puede abrir nuevas oportunidades para cualquier equipo. Ya sea para mejorar tu SEO, automatizar investigaciones o construir pipelines de ventas más inteligentes, los crawlers son tus aliados invisibles.

Y a medida que la web sigue creciendo y cambiando, las empresas más exitosas serán las que adopten estas herramientas—de forma responsable y creativa. Si quieres descubrir lo que el crawling con IA puede hacer por tu negocio, y empieza a explorar. Para más guías y recursos, visita el .

Preguntas frecuentes

1. ¿Qué es un crawler web, explicado de forma sencilla?

Un crawler web es un programa que navega automáticamente por internet, visitando sitios, siguiendo enlaces y recopilando información. Es como un bibliotecario digital que cataloga páginas web para que los buscadores las encuentren o las empresas las usen como datos.

2. ¿En qué se diferencian los crawlers de los scrapers?

Los crawlers se enfocan en descubrir e indexar la mayor cantidad de páginas posible (mapear la web), mientras que los scrapers extraen datos concretos de páginas específicas. En la práctica, suelen trabajar juntos: primero se rastrea para encontrar páginas, luego se extraen los datos que necesitas.

3. ¿Por qué las empresas usan crawlers?

Las empresas usan crawlers para todo: desde SEO (asegurarse de que su sitio esté indexado) hasta inteligencia competitiva (seguir precios o cambios de productos), generación de leads, investigación de mercado y automatización de la recolección de datos para analítica o IA.

4. ¿Qué retos enfrentan los crawlers tradicionales?

Los crawlers clásicos tienen problemas con defensas anti-bot (CAPTCHAs, bloqueos de IP), contenido dinámico (JavaScript, scroll infinito), cambios frecuentes en sitios y restricciones legales o éticas. Las herramientas modernas con IA como Thunderbit están diseñadas para superar estos obstáculos.

5. ¿Cómo facilita Thunderbit el crawling para usuarios de negocio?

Thunderbit usa IA para reconocer automáticamente la estructura de las páginas, sugerir campos de datos y manejar tareas complejas como rastreo de subpáginas y contenido dinámico. Es sin código, rápido de configurar y exporta datos directamente a tus herramientas favoritas—haciendo que los datos web sean accesibles para todos, no solo para desarrolladores.

¿Listo para poner los crawlers a trabajar para tu empresa? y descubre lo fácil que es acceder a datos web.

Más información