La web está llena de datos valiosos: ya sea que trabajes en ventas, ecommerce o investigando el mercado, el raspado web es ese truco que nunca falla para conseguir leads, monitorear precios y analizar a la competencia. Pero aquí viene el problema: cada vez más empresas se suman al scraping, y los sitios web están subiendo el nivel de sus defensas. De hecho, más del , y los ya son el pan de cada día. Si alguna vez viste tu script de Python funcionando perfecto y de repente te topaste con un error 403, sabes lo frustrante que es.

Después de años metido en SaaS y automatización, he visto cómo proyectos de scraping pasan de “esto es facilísimo” a “¿por qué me bloquean en todos lados?” en cuestión de minutos. Así que vamos al grano: te voy a mostrar cómo hacer scraping web sin bloqueos en Python, compartirte técnicas clave y fragmentos de código, y contarte cuándo conviene mirar alternativas con IA como . Seas un crack en Python o estés empezando, aquí tienes un kit de herramientas para extraer datos sin que te cierren la puerta en la cara.

¿Qué significa scraping web sin bloqueos en Python?

En pocas palabras, hacer scraping web sin ser bloqueado es extraer datos de sitios web sin que te detecten los sistemas anti-bots. En el mundo Python, esto va mucho más allá de un simple bucle con requests.get(): se trata de camuflarse, imitar a usuarios reales y adelantarse a los sistemas de detección.

¿Por qué Python? , por su sintaxis sencilla, su ecosistema gigante (requests, BeautifulSoup, Scrapy, Selenium) y su flexibilidad para cualquier proyecto, desde scripts rápidos hasta crawlers distribuidos. Pero tanta fama tiene su precio: muchos sistemas anti-bots ya están afinados para cazar patrones típicos de scraping en Python.

Así que, si quieres raspar datos sin problemas, hay que ir más allá de lo básico. Eso implica entender cómo detectan los bots los sitios y cómo puedes esquivarlos—siempre respetando la ética y la legalidad.

Por qué evitar bloqueos es clave en proyectos de scraping con Python

Que te bloqueen no es solo un tema técnico: puede arruinar procesos de negocio enteros. Mira estos ejemplos:

| Caso de uso | Impacto de ser bloqueado |

|---|---|

| Generación de leads | Listas de prospectos incompletas o desactualizadas, pérdida de ventas |

| Monitoreo de precios | Cambios de precios de la competencia que pasan desapercibidos, malas decisiones de pricing |

| Agregación de contenido | Vacíos en noticias, reseñas o datos de investigación |

| Inteligencia de mercado | Falta de visibilidad sobre la competencia o el sector |

| Listados inmobiliarios | Datos de propiedades inexactos o desactualizados, oportunidades perdidas |

Cuando un raspador es bloqueado, no solo pierdes datos: también pierdes tiempo, recursos y puedes tomar malas decisiones por información incompleta. En un mundo donde el , la fiabilidad es clave.

Cómo los sitios detectan y bloquean raspadores web en Python

Los sitios web se han puesto las pilas para detectar bots. Estas son las defensas anti-scraping más comunes (, ):

- Bloqueo de IP: Si haces muchas peticiones desde la misma IP, te bloquean.

- Chequeo de User-Agent y headers: Headers genéricos o por defecto (como

python-requests/2.25.1) te delatan. - Limitación de velocidad: Si vas muy rápido, te frenan o te banean.

- CAPTCHAs: Pruebas para demostrar que eres humano, difíciles para los bots.

- Análisis de comportamiento: Detectan patrones robóticos, como hacer clic siempre igual o a intervalos exactos.

- Honeypots: Campos o enlaces ocultos que solo los bots tocan.

- Fingerprinting de navegador: Recopilan detalles de tu navegador/dispositivo para pillar automatizaciones.

- Gestión de cookies y sesiones: Si no gestionas bien cookies o sesiones, te cazan fácil.

Piensa en esto como el control de seguridad de un aeropuerto: si te comportas y te ves como todos, pasas sin problema. Si pareces sospechoso, te revisan a fondo.

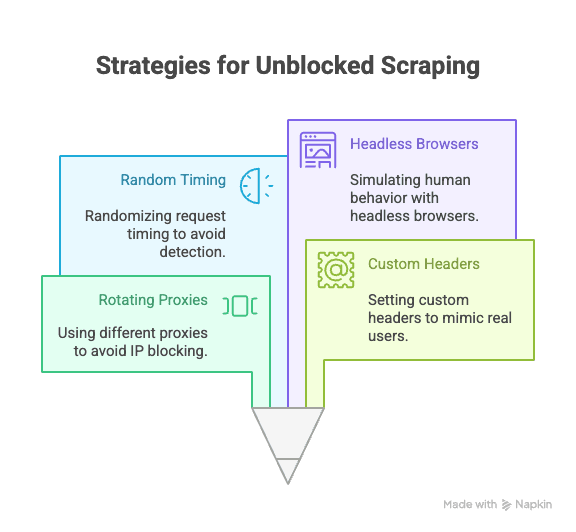

Técnicas esenciales en Python para scraping web sin bloqueos

Vamos a lo práctico: ¿cómo evitar bloqueos al raspar con Python? Estas son las estrategias clave que todo raspador debe conocer:

Rotación de proxies y direcciones IP

Por qué importa: Si todas tus peticiones salen de la misma IP, eres un blanco fácil. Usar proxies rotativos reparte las peticiones y dificulta que te bloqueen.

Cómo hacerlo en Python:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...más proxies

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # procesar respuestaPuedes usar servicios de proxies de pago (residenciales o rotativos) para mayor fiabilidad ().

Configuración de User-Agent y headers personalizados

Por qué importa: Los headers por defecto de Python te delatan. Imita navegadores reales configurando el user-agent y otros headers.

Ejemplo de código:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)Rota los user-agents para pasar más desapercibido ().

Aleatorizar tiempos y patrones de petición

Por qué importa: Los bots son rápidos y predecibles; los humanos somos más lentos y aleatorios. Añade retrasos y varía tu navegación.

Tip en Python:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # Espera entre 2 y 7 segundosSi usas Selenium, también puedes variar los clics y el scroll.

Gestión de cookies y sesiones

Por qué importa: Muchos sitios requieren cookies o tokens de sesión para acceder al contenido. Si tu bot ignora esto, te bloquean.

Cómo gestionarlo en Python:

1import requests

2session = requests.Session()

3response = session.get(url)

4# la sesión gestiona las cookies automáticamentePara flujos más complejos, usa Selenium para capturar y reutilizar cookies.

Simular comportamiento humano con navegadores headless

Por qué importa: Algunos sitios usan JavaScript, movimientos de ratón o scroll como señales de usuarios reales. Herramientas como Selenium o Playwright pueden imitar estas acciones.

Ejemplo con Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))Esto ayuda a superar análisis de comportamiento y contenido dinámico ().

Estrategias avanzadas: superar CAPTCHAs y honeypots en Python

Los CAPTCHAs están hechos para frenar bots. Aunque algunas librerías de Python pueden resolver CAPTCHAs simples, la mayoría de los scrapers serios usan servicios externos (como 2Captcha o Anti-Captcha) que los resuelven por un coste ().

Ejemplo de integración:

1# Pseudocódigo para usar la API de 2Captcha

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# Espera la solución y luego envíala con tu peticiónLos honeypots son campos o enlaces ocultos que solo los bots tocan. Evita hacer clic o enviar información que no sea visible en un navegador real ().

Cómo diseñar headers robustos con librerías de Python

Más allá del user-agent, puedes rotar y aleatorizar otros headers (Referer, Accept, Origin, etc.) para camuflarte aún más.

Con Scrapy:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # Más headers

7 }

8 }Con Selenium: Usa perfiles de navegador o extensiones para definir headers, o inyéctalos vía JavaScript.

Mantén tu lista de headers actualizada: copia los de navegadores reales usando las DevTools para inspirarte.

Cuando el scraping tradicional en Python no basta: el auge de la tecnología anti-bots

La realidad es que, a medida que el scraping se hace más popular, también lo hacen las defensas anti-bots. . La detección basada en IA, los umbrales dinámicos y el fingerprinting de navegador hacen que incluso los scripts de Python más avanzados tengan problemas ().

A veces, por más ingenioso que sea tu código, te vas a topar con un muro. Es ahí cuando conviene buscar otro enfoque.

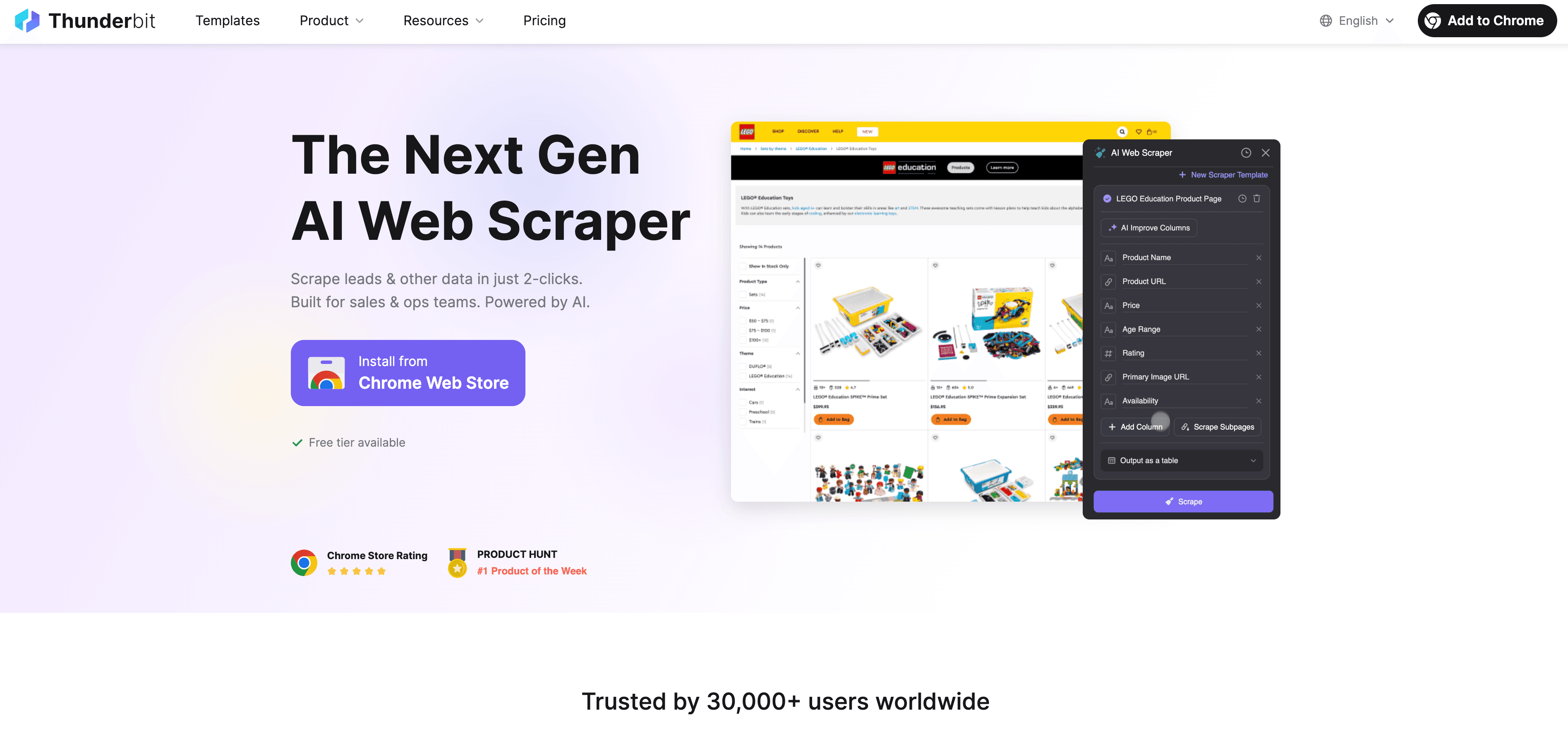

Thunderbit: una alternativa de Raspador Web IA frente al scraping en Python

Cuando Python ya no da más, aparece como un raspador web con IA y sin código, pensado para usuarios de negocio, no solo para desarrolladores. En vez de pelear con proxies, headers y CAPTCHAs, el agente de IA de Thunderbit lee la web, sugiere los mejores campos a extraer y se encarga de todo, desde navegar subpáginas hasta exportar los datos.

¿Qué hace diferente a Thunderbit?

- Sugerencia de campos con IA: Haz clic en “Sugerir campos con IA” y Thunderbit analiza la página, recomienda columnas y genera instrucciones de extracción.

- Scraping de subpáginas: Thunderbit puede visitar cada subpágina (como detalles de productos o perfiles de LinkedIn) y enriquecer tu tabla automáticamente.

- Scraping en la nube o en el navegador: Elige la opción más rápida: nube para sitios públicos, navegador para páginas protegidas con login.

- Raspado programado: Configura y olvídate: Thunderbit puede raspar en horarios definidos para que tus datos siempre estén actualizados.

- Plantillas instantáneas: Para sitios populares (Amazon, Zillow, Shopify, etc.), Thunderbit ofrece plantillas de un solo clic, sin configuración.

- Exportación gratuita de datos: Exporta a Excel, Google Sheets, Airtable o Notion sin costes extra.

Thunderbit ya lo usan más de , y no necesitas programar nada.

Cómo Thunderbit ayuda a evitar bloqueos y automatizar la extracción de datos

La IA de Thunderbit no solo imita el comportamiento humano, sino que se adapta en tiempo real a cada sitio, reduciendo el riesgo de bloqueos. Así lo consigue:

- La IA se adapta a cambios de diseño: Olvídate de scripts rotos cuando un sitio cambia su apariencia.

- Gestión automática de subpáginas y paginación: Thunderbit sigue enlaces y listas paginadas como un usuario real.

- Scraping en la nube a gran escala: Raspa hasta 50 páginas a la vez, de forma ultrarrápida.

- Sin código ni mantenimiento: Dedica tu tiempo al análisis, no a depurar scripts.

Si quieres saber más, revisa .

Comparativa: scraping en Python vs. Thunderbit, ¿cuál elegir?

Veamos una comparación directa:

| Funcionalidad | Scraping en Python | Thunderbit |

|---|---|---|

| Tiempo de configuración | Medio–Alto (scripts, proxies, etc) | Bajo (2 clics, la IA hace el resto) |

| Habilidad técnica | Requiere programación | No requiere código |

| Fiabilidad | Variable (fácil de romper) | Alta (la IA se adapta a cambios) |

| Riesgo de bloqueos | Moderado–Alto | Bajo (la IA imita y se adapta) |

| Escalabilidad | Requiere código propio/nube | Scraping en la nube y por lotes integrado |

| Mantenimiento | Frecuente (cambios, bloqueos) | Mínimo (la IA se ajusta sola) |

| Opciones de exportación | Manual (CSV, BD) | Directo a Sheets, Notion, Airtable, CSV |

| Coste | Gratis (pero consume tiempo) | Plan gratuito, opciones de pago para escalar |

Cuándo usar Python:

- Si necesitas control total, lógica personalizada o integración con otros flujos en Python.

- Si vas a raspar sitios con pocas defensas anti-bots.

Cuándo usar Thunderbit:

- Si buscas rapidez, fiabilidad y cero configuración.

- Si vas a raspar sitios complejos o que cambian a menudo.

- Si no quieres lidiar con proxies, CAPTCHAs ni código.

Guía paso a paso: cómo hacer scraping web en Python sin ser bloqueado

Vamos con un ejemplo práctico: extraer datos de productos de un sitio de prueba, aplicando las mejores prácticas anti-bloqueo.

1. Instala las librerías necesarias

1pip install requests beautifulsoup4 fake-useragent2. Prepara tu script

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # Sustituye por tus URLs

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # Extrae los datos aquí

16 print(soup.title.text)

17 else:

18 print(f"Bloqueado o error en {url}: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # Retraso aleatorio3. Añade rotación de proxies (opcional)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # Más proxies

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...resto del código4. Gestiona cookies y sesiones

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...resto del código5. Consejos para solucionar problemas

- Si ves muchos errores 403/429, baja la velocidad de tus peticiones o prueba nuevos proxies.

- Si te aparecen CAPTCHAs, considera usar Selenium o un servicio para resolverlos.

- Revisa siempre el

robots.txty los términos de uso del sitio.

Conclusión y puntos clave

El scraping web con Python es potente, pero el riesgo de bloqueos es constante y las defensas anti-bots evolucionan rápido. ¿La mejor forma de evitarlos? Combina buenas prácticas técnicas (proxies rotativos, headers inteligentes, retrasos aleatorios, gestión de sesiones y navegadores headless) con respeto por las normas y la ética de cada sitio.

Pero a veces, ni los mejores trucos de Python bastan. Ahí es donde brillan herramientas con IA como : ofrecen una solución sin código, resistente a bloqueos y pensada para negocios, para que extraigas los datos que necesitas, rápido y sin complicaciones.

¿Quieres ver lo fácil que puede ser el scraping? y pruébala tú mismo, o visita nuestro para más consejos y tutoriales.

Preguntas frecuentes

1. ¿Por qué los sitios web bloquean los scrapers en Python?

Bloquean scrapers para proteger sus datos, evitar sobrecarga en sus servidores y frenar el abuso de bots. Los scripts en Python son fáciles de detectar si usan headers por defecto, no gestionan cookies o mandan muchas peticiones muy rápido.

2. ¿Cuáles son las mejores formas de evitar bloqueos al hacer scraping con Python?

Usa proxies rotativos, configura user-agent y headers realistas, aleatoriza los tiempos de petición, gestiona cookies/sesiones y simula comportamiento humano con herramientas como Selenium o Playwright.

3. ¿Cómo ayuda Thunderbit a evitar bloqueos frente a los scripts en Python?

Thunderbit usa IA para adaptarse al diseño de cada sitio, imitar la navegación humana y gestionar subpáginas y paginación automáticamente. Reduce el riesgo de bloqueos camuflándose y ajustando su estrategia en tiempo real, sin necesidad de código ni proxies.

4. ¿Cuándo debo usar scraping en Python y cuándo una herramienta con IA como Thunderbit?

Usa Python si necesitas lógica personalizada, integración con otros scripts o vas a raspar sitios sencillos. Elige Thunderbit para scraping rápido, fiable y escalable, especialmente en sitios complejos, cambiantes o con defensas anti-bots avanzadas.

5. ¿Es legal el scraping web?

El scraping es legal para datos públicos, pero debes respetar los términos de uso, políticas de privacidad y leyes aplicables de cada sitio. Nunca raspees datos sensibles o privados y actúa siempre de forma ética y responsable.

¿Listo para raspar de forma más inteligente? Prueba Thunderbit y olvídate de los bloqueos.

Más información:

- Scraping de Google News con Python: guía paso a paso

- Cómo crear un rastreador de precios para Best Buy con Python

- 14 formas de hacer scraping web sin ser bloqueado

- 10 mejores consejos para evitar bloqueos al hacer scraping web