Si alguna vez has usado la terminal, seguro que te has cruzado con cURL. Es como el comodín de internet: discreto, instalado en miles de millones de dispositivos, siempre listo para descargar, enviar o depurar cualquier cosa que tenga una URL. De hecho, su creador calcula que hay en todo el mundo. No es un error: veinte mil millones.

Entonces, ¿por qué en 2025 tantos desarrolladores (y, siendo sinceros, también muchos profesionales de negocio) siguen apostando por cURL cuando hay tantas herramientas de scraping con IA? A veces, lo que buscas es rapidez, automatización y cero complicaciones. En esta guía te cuento por qué el raspado web con cURL sigue siendo clave, cuándo es la mejor opción, cómo sacarle el jugo y cómo puedes llevar tu flujo de trabajo al siguiente nivel con , nuestro Raspador Web IA que lleva el scraping a otro nivel.

¿Por qué el Web Scraping con cURL sigue siendo útil en 2025?

Lo admito: cURL me encanta. Hay algo especial en lanzar un comando y ver cómo llega la información en crudo. Y no soy el único. La mostró un 28% más de participantes el año pasado, y en Stack Overflow hay con la etiqueta “curl”. Los desarrolladores lo describen como “fiable”, “increíble” y “el idioma universal de las peticiones web”. Incluso con nuevas herramientas, cURL sigue evolucionando: ahora soporta HTTP/3 y mucho más.

Pero, ¿qué hace que cURL siga siendo tan útil para el raspado web?

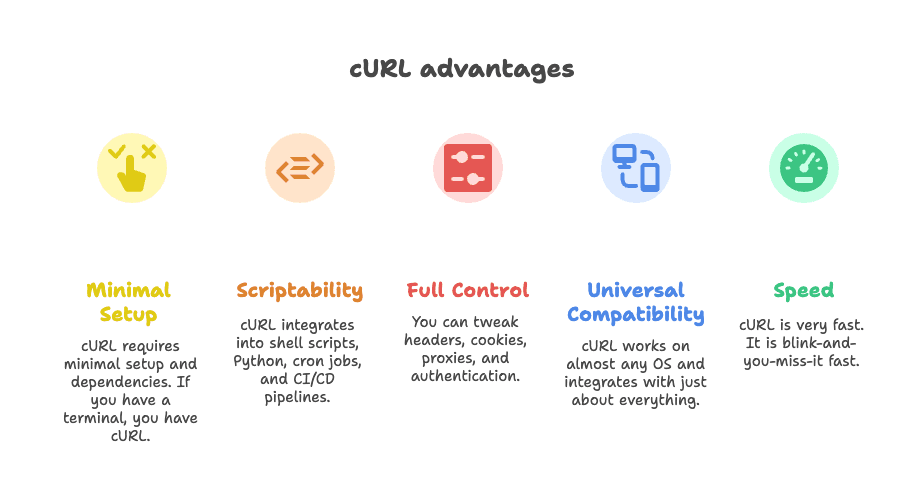

- Configuración mínima: No tienes que instalar mil dependencias. Si tienes terminal, tienes cURL.

- Automatizable: Se integra fácil en scripts de shell, Python, tareas programadas y pipelines de CI/CD.

- Control total: Puedes modificar cabeceras, cookies, proxies y autenticaciones a tu gusto.

- Compatibilidad total: Funciona en casi cualquier sistema operativo y se lleva bien con todo.

- Velocidad: Es rápido. Muy rápido.

Como dijo un desarrollador: “Todo lo que quieras hacer, cURL puede hacerlo.” ()

Usos principales de cURL para Web Scraping: ¿Cuándo elegir cURL?

Seamos claros: cURL no es la solución para todo. Pero hay situaciones donde es imbatible. Aquí es donde brilla:

1. Extraer datos JSON de APIs REST

Muchos sitios modernos cargan contenido usando APIs en segundo plano. Si das con el endpoint correcto (pista: revisa la pestaña Network del navegador), cURL puede traerte ese JSON con un solo comando. Perfecto para extracciones rápidas, pruebas de API o integraciones en scripts.

2. Extraer datos de páginas estáticas o bien estructuradas

Si la info que buscas está en el HTML (noticias, directorios, páginas de categorías), cURL la descarga al instante. Puedes combinarlo con herramientas como grep, sed o jq para un análisis básico.

3. Depurar y replicar peticiones HTTP complejas

¿Necesitas simular un login, probar un webhook o depurar una llamada API complicada? cURL te da acceso a todas las cabeceras, cookies y cargas. Es la herramienta favorita para ver exactamente qué pasa en cada petición.

4. Integrar extracciones rápidas en scripts

cURL es ideal para meter en scripts de shell, Python o incluso webhooks de Zapier. Es el pegamento de muchas automatizaciones.

Aquí tienes una tabla resumen sobre cuándo usar cURL y cuándo no:

| Caso de uso | Por qué cURL es útil | Limitaciones | Alternativas |

|---|---|---|---|

| Extraer APIs JSON | Rápido, automatizable, soporta cabeceras/tokens | No analiza JSON, autenticación compleja es manual | Python Requests, Postman, Thunderbit |

| Páginas HTML estáticas | Ligero, fácil de integrar con herramientas CLI | No analiza HTML, no soporta JavaScript | Scrapy, BeautifulSoup, Thunderbit |

| Scraping con sesión autenticada | Maneja cookies, cabeceras, auth básica | Tedioso para logins complejos, sin soporte JS | Requests sessions, Selenium, Thunderbit |

| Integración en Shell/Python | Universal, funciona en cualquier script | Análisis y manejo de errores manual | Librerías HTTP nativas, Thunderbit |

Si quieres profundizar, échale un ojo a .

Técnicas clave de Web Scraping con cURL para 2025

Vamos a lo práctico. Así puedes sacarle el máximo partido a cURL en 2025, con algunos de mis trucos favoritos.

Configurar cabeceras y User-Agent

Muchos sitios bloquean peticiones genéricas de cURL. Para pasar desapercibido, usa un User-Agent realista y las cabeceras necesarias:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/dataO para varias cabeceras:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/dataFalsificar cabeceras suele ser la diferencia entre conseguir datos o ser bloqueado. Más detalles en .

Manejar cookies y sesiones

¿Necesitas iniciar sesión o mantener una sesión activa? Usa el cookie jar de cURL:

1# Iniciar sesión y guardar cookies

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# Usar cookies en peticiones siguientes

4curl -b cookies.txt https://example.com/dashboardTambién puedes pasar cookies directamente:

1curl -b "SESSIONID=abcd1234" https://example.com/pageSi tienes que seguir redirecciones (como después de iniciar sesión), añade -L para mantener las cookies.

Usar proxies para evitar bloqueos

¿Te han bloqueado la IP? Envía tus peticiones a través de un proxy:

1curl --proxy 198.199.86.11:8080 https://target.comPara proxies rotativos, puedes hacer que cURL lea de una lista y los vaya alternando. Ojo: los proxies gratuitos suelen ser poco fiables.

Guardar y analizar respuestas

cURL te da los datos en crudo. Para analizarlos, combínalo con herramientas de línea de comandos:

-

Para JSON: Usa

jqpara formatear o extraer campos.1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

Para HTML: Usa

greposedpara patrones simples.1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

Para análisis más complejos: Prueba herramientas como

htmlq(para selectores CSS) o pasa a Python con BeautifulSoup.

Para una guía sobre cURL y jq, revisa .

Autenticación y límites de velocidad con cURL

Autenticación:

-

Auth básica:

1curl -u username:password https://api.example.com/data -

Tokens Bearer:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

Cookies de sesión: Usa las opciones

-cy-bcomo antes.

Para flujos más complejos (como OAuth), tendrás que automatizar el proceso; cURL puede hacerlo, pero requiere experiencia.

Límites de velocidad y reintentos:

-

Añadir pausas:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # pausa aleatoria entre 2-4 segundos 4done -

Reintentos:

1curl --retry 3 --retry-delay 5 https://example.com/data

Sé responsable: no satures los servidores y revisa siempre si recibes respuestas 429 Too Many Requests.

Limitaciones de cURL para Web Scraping: Lo que debes saber

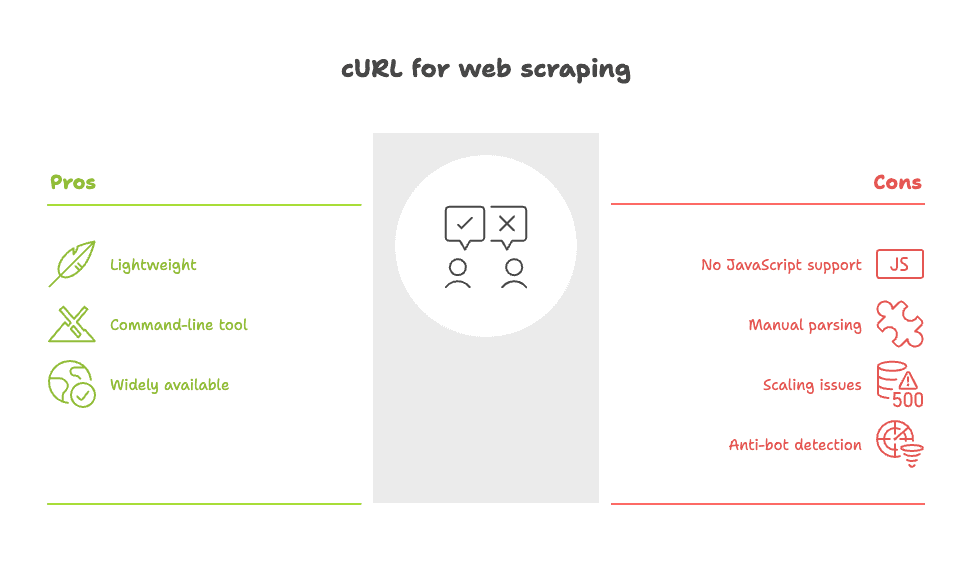

Ahora, un poco de realidad. Por mucho que me guste cURL, no siempre es la mejor opción. Aquí es donde se queda corto:

- No soporta JavaScript: cURL no ejecuta scripts ni renderiza contenido dinámico. Si los datos aparecen tras cargar la página, cURL no los verá. Tendrás que buscar la API o usar una herramienta basada en navegador.

- Análisis manual: Obtienes HTML o JSON en bruto. Estructurar esos datos depende de ti, lo que implica mucho

grep,sedo scripts personalizados. - Escalabilidad limitada: Si necesitas extraer cientos o miles de páginas, gestionar errores, reintentos y limpieza de datos se vuelve complicado.

- Fácil de detectar por sistemas anti-bots: Muchos sitios identifican el rastro de cURL y lo bloquean, incluso si modificas las cabeceras.

Como dijo un usuario en Reddit: “Curl o wget son suficientes para scraping sencillo, pero tendrás muchos problemas en sitios complejos.” ()

Para un análisis completo de los puntos débiles de cURL, revisa .

Potencia tu Web Scraping con cURL usando Thunderbit

¿Y si quieres la velocidad y control de cURL, pero sin el trabajo manual? Ahí es donde entra .

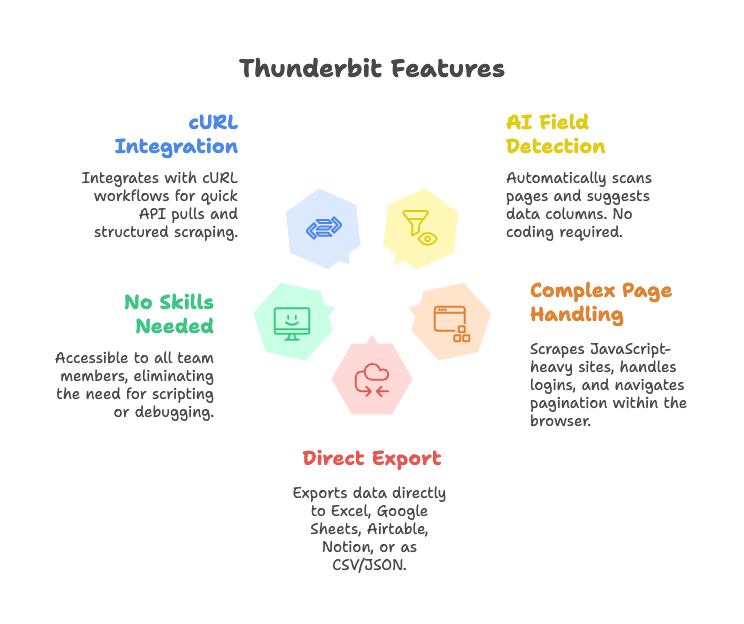

Thunderbit es una extensión de Chrome para el raspado web con IA que simplifica la extracción de datos. Así complementa a cURL:

- Detección automática de campos con IA: Haz clic en “Sugerir campos con IA” y Thunderbit analiza la página, sugiere columnas y estructura los datos—sin selectores ni código.

- Maneja páginas complejas: Thunderbit funciona dentro del navegador, por lo que puede extraer datos de sitios con JavaScript, gestionar logins y navegar por subpáginas o paginación.

- Exportación directa: Envía los datos a Excel, Google Sheets, Airtable, Notion o descárgalos como CSV/JSON.

- No requiere conocimientos técnicos: Cualquier persona del equipo puede usarlo, sin necesidad de programar ni depurar cabeceras.

- Se integra con flujos de cURL: Los desarrolladores pueden seguir usando cURL para extracciones rápidas o prototipos, y luego pasar a Thunderbit para scraping estructurado y repetible.

Si quieres ver Thunderbit en acción, prueba nuestra o visita nuestro para más ejemplos.

Thunderbit + cURL: Ejemplos de flujo de trabajo para equipos de negocio

Vamos a lo práctico. Así pueden los equipos combinar cURL y Thunderbit para obtener resultados reales:

1. Investigación de mercado rápida

- Usa cURL para comprobar si el sitio de un competidor tiene una API pública o HTML estático.

- Si es así, haz una extracción rápida para obtener una instantánea.

- Para análisis más profundos (como extraer listados de productos en varias páginas), cambia a Thunderbit: deja que la IA detecte campos, gestione la paginación y exporte a Sheets para análisis inmediato.

2. Generación de leads

- Usa cURL para obtener información de contacto de una API sencilla.

- Para sitios más complejos (como perfiles tipo LinkedIn o listados inmobiliarios), usa Thunderbit para extraer nombres, emails, teléfonos e incluso imágenes—sin análisis manual.

3. Monitoreo de productos o precios

- Programa scripts de cURL para consultar una API de precios.

- Para sitios sin API, deja que Thunderbit haga el scraping, estructure los datos y envíe actualizaciones a Airtable o Notion para tu equipo de operaciones.

Aquí tienes un diagrama rápido del flujo (imagina figuras de palitos y flechas):

1[Navegador/Terminal] --(prueba con cURL)--> [Extracción rápida]

2 |

3 v

4[Extensión de Chrome Thunderbit] --(extracción IA)--> [Datos estructurados] --> [Sheets/Airtable/Notion]Ventajas clave: Thunderbit vs. scripts manuales con cURL

Comparémoslo lado a lado:

| Funcionalidad | Thunderbit (Raspador Web IA) | cURL (Herramienta CLI) |

|---|---|---|

| Tiempo de configuración | Clics, IA detecta campos automáticamente | Scripting manual, requiere saber HTML |

| Facilidad de uso | Cualquiera puede usarlo, feedback visual | Solo CLI, curva de aprendizaje alta |

| Salida estructurada | Sí—tablas, columnas, exporta a Sheets/CRM | HTML/JSON en bruto, análisis manual |

| Maneja páginas dinámicas | Sí—funciona en navegador, soporta JS, subpáginas, paginación | No—solo HTML estático |

| Mantenimiento | Bajo—la IA se adapta a cambios en el sitio | Alto—los scripts fallan si el sitio cambia |

| Integración | Exportaciones a herramientas de negocio | Requiere código personalizado |

| Multi-idioma/Traducción | Sí—la IA puede traducir y normalizar campos | No—solo manual |

| Escalabilidad | Ideal para trabajos medianos, no para crawls masivos | Bueno para grandes volúmenes si programas los scripts |

| Coste | Plan gratuito, pagos desde ~$9/mes | Gratis, pero consume tiempo de desarrollo |

Para más detalles, revisa nuestro .

El enfoque con IA de Thunderbit te permite dedicar menos tiempo a programar y más a obtener resultados. Seas desarrollador o usuario de negocio, es la forma más rápida de convertir datos web en valor para tu empresa.

Retos y riesgos del Web Scraping con cURL

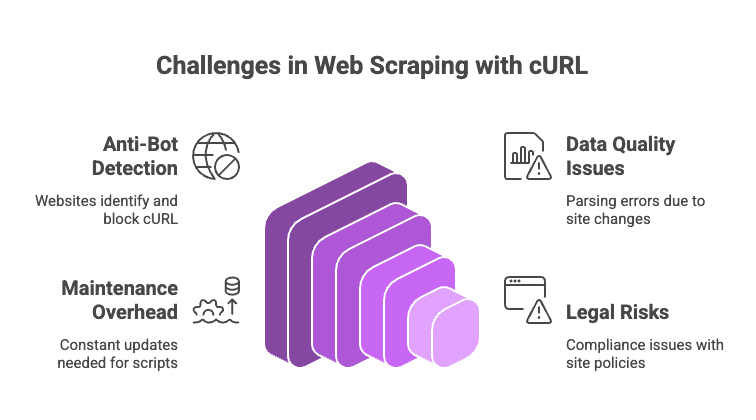

El scraping web en 2025 no es un camino libre de obstáculos. Ten en cuenta lo siguiente (y algunos consejos para evitarlos):

- Medidas anti-bots: Herramientas como Cloudflare, Akamai y DataDome detectan cURL fácilmente. Aunque modifiques cabeceras, buscan ejecución de JavaScript, huellas TLS y más. Si te topas con un CAPTCHA, cURL no podrá resolverlo.

- Calidad y consistencia de los datos: Analizar HTML con regex o grep es frágil. Cualquier cambio en la estructura del sitio puede romper tu script.

- Mantenimiento constante: Cada vez que un sitio cambia, tendrás que ajustar el código, selectores o lógica de análisis.

- Riesgos legales y de cumplimiento: Revisa siempre los términos de uso y políticas de privacidad de los sitios. Que puedas hacer scraping no significa que debas hacerlo.

Consejos pro:

- Rota user agents e IPs si te bloquean.

- Añade pausas aleatorias entre peticiones.

- Usa herramientas como

jqpara JSON yhtmlqpara HTML. - Para sitios dinámicos o protegidos, considera cambiar a una herramienta basada en navegador como Thunderbit o una API de scraping.

Para una lista completa de riesgos (y cómo evitarlos), revisa .

Conclusión: Eligiendo la mejor estrategia de Web Scraping en 2025

Mi opinión: cURL sigue siendo imbatible para scraping rápido y puntual—especialmente para APIs, páginas estáticas o depuración. Es la forma más veloz de explorar un sitio y ver qué es posible.

Pero si necesitas datos estructurados, contenido dinámico o flujos de trabajo amigables para negocio, es momento de usar herramientas más avanzadas. te permite olvidarte del trabajo manual, manejar sitios complejos y obtener los datos donde los necesitas—en minutos.

Así que elige la herramienta según la tarea. Para trabajos pequeños y automatizables, cURL es tu aliado. Para proyectos más grandes, dinámicos o colaborativos, deja que Thunderbit haga el trabajo pesado.

Preguntas frecuentes: Web Scraping con cURL en 2025

1. ¿Puede cURL extraer contenido generado por JavaScript?

No. cURL solo descarga el HTML inicial. Si los datos se cargan con JavaScript, tendrás que buscar la API o usar una herramienta basada en navegador como Thunderbit.

2. ¿Cómo evito bloqueos al hacer scraping con cURL?

Configura cabeceras realistas (User-Agent, Accept), rota IPs y user agents, añade pausas entre peticiones y reutiliza cookies. Para sistemas anti-bots avanzados (como Cloudflare), prueba o cambia a un navegador sin interfaz o una API de scraping.

3. ¿Cuál es la mejor forma de convertir la salida de cURL en datos estructurados?

Para JSON, usa jq. Para HTML, emplea grep, sed o analizadores HTML como htmlq. Para casos complejos, pasa a Python con BeautifulSoup o usa Thunderbit para extracción automática con IA.

4. ¿Es cURL adecuado para proyectos de scraping a gran escala?

Puede serlo, pero tendrás que programar mucho: gestionar reintentos, errores, proxies y limpieza de datos. Para grandes volúmenes, frameworks como Scrapy o herramientas basadas en navegador suelen ser más eficientes.

5. ¿Cómo mejora Thunderbit el scraping tradicional con cURL?

Thunderbit automatiza la detección de campos, maneja páginas dinámicas, gestiona sesiones y subpáginas, y exporta datos estructurados directamente a herramientas de negocio. Sin scripts, sin selectores y sin dolores de cabeza de mantenimiento.

¿Listo para hacer scraping más fácil? Prueba o instala nuestra y descubre cómo la IA puede transformar tu flujo de trabajo.

¿Prefieres seguir en la terminal? No te preocupes, cURL seguirá ahí. Solo recuerda tratar bien a los servidores... ¡y quizás invitar a tu sysadmin favorito a un café!

¿Quieres más consejos sobre web scraping, automatización y productividad con IA? Visita el para las últimas guías y novedades.