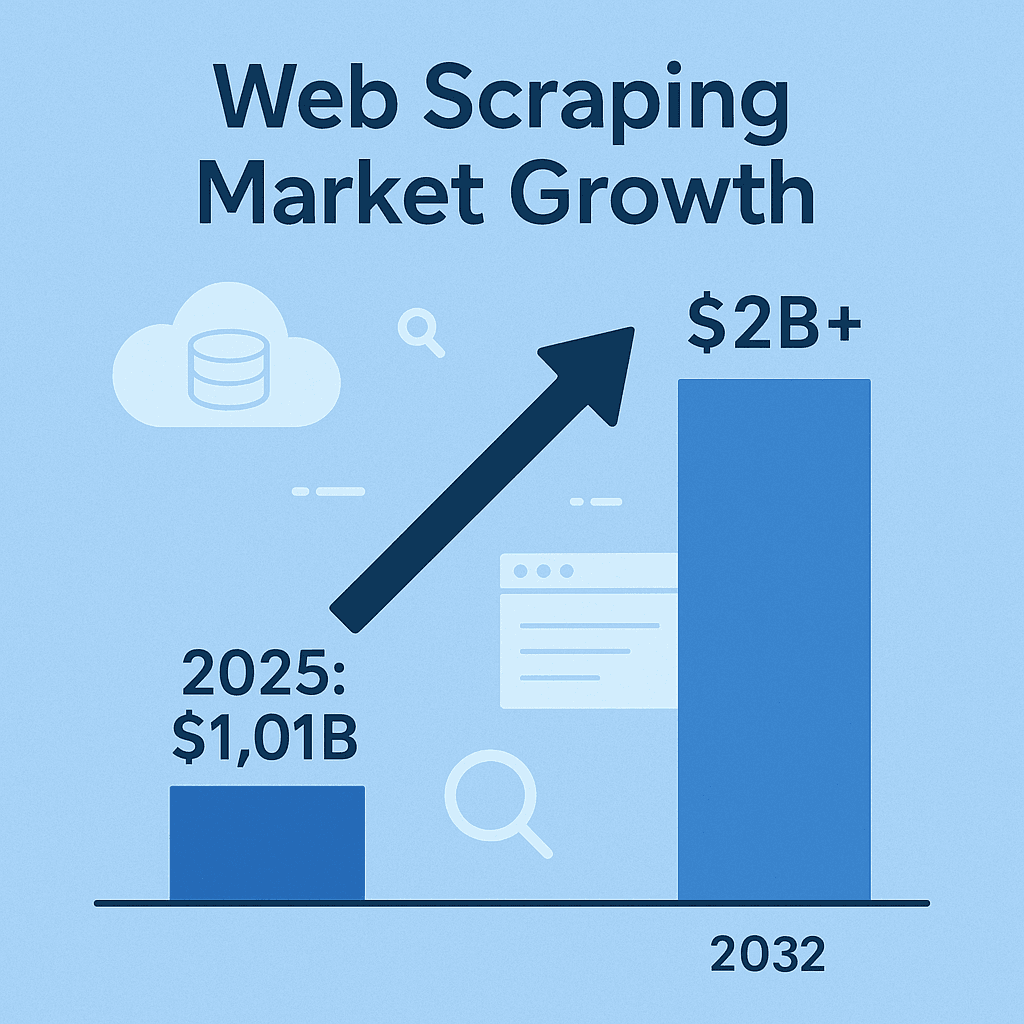

El raspador web java se ha vuelto, sin hacer mucho ruido, en el ingrediente secreto para la inteligencia de negocios moderna, ventas y análisis de mercado. Hoy por hoy, si no estás recolectando datos web—precios de la competencia, catálogos de productos, tendencias o leads—seguramente te estás perdiendo información que tus rivales ya están usando a su favor. De hecho, el mercado de software de raspador web apunta a los , y se espera que más que se duplique para 2032. No es solo una moda techie; es una ola que no para. Y aunque Python suele ser el protagonista, Java sigue siendo la apuesta segura para equipos que buscan estabilidad, velocidad e integración a nivel empresa.

Después de años metido en SaaS y automatización, te puedo decir que el tutorial web scraping java sigue más vigente que nunca—sobre todo en ambientes empresariales donde la estabilidad, el procesamiento en paralelo y la integración con sistemas de big data son clave. Pero ojo: hacer scraping no es solo sacar datos. Hay que hacerlo bien, de forma ordenada y, si no quieres líos legales, cumpliendo las reglas. Así que, vamos al grano: repasemos las mejores prácticas para dominar el raspador web java—ya sea que quieras crear tus propios scrapers o potenciar tu flujo de trabajo con herramientas de IA como .

Desmitificando el Web Scraping en Java: Lo Básico

En pocas palabras, el web scraping es el arte (y a veces la ciencia) de sacar información de páginas web de manera automática. El proceso típico es simple: tu código manda una petición HTTP a una página, recibe el HTML, lo analiza para encontrar los datos que buscas (precios, nombres de productos, reseñas, etc.) y luego exporta esa info a un formato útil para tu equipo—CSV, JSON o directo a una base de datos ().

¿Por qué Java? Aunque Python es perfecto para scripts rápidos, Java es el caballo de batalla para proyectos de scraping grandes, de larga duración y nivel empresa. Es fuertemente tipado, robusto y tiene un ecosistema lleno de librerías para redes, análisis de HTML y concurrencia. Además, si tu pipeline de datos ya está en Java, la integración es directa—sin dolores de cabeza por mezclar lenguajes ().

En resumen: los scrapers en Java pueden correr días enteros, manejar grandes volúmenes y encajar perfecto con el resto de tu infraestructura. Pero es clave saber qué herramientas usar y cuándo.

Herramientas y Librerías Populares para Web Scraping en Java

Vamos a lo práctico. Estas son las librerías más usadas para tutorial web scraping java, cada una con sus ventajas y detalles:

| Herramienta | Ideal para | Ventajas | Limitaciones |

|---|---|---|---|

| Jsoup | Páginas HTML estáticas, extracción rápida | Ligera, API sencilla, rápida, perfecta para tareas simples | No puede manejar JavaScript ni contenido dinámico |

| Selenium | Sitios dinámicos e interactivos | Automatiza navegadores reales, soporta JS, acciones de usuario, gran comunidad | Consume más recursos, más lenta, frágil ante cambios de UI, requiere drivers de navegador |

| HtmlUnit | Navegación sin interfaz, JS moderado | 100% Java, ejecuta algo de JS, no necesita navegador externo | Más lenta que Jsoup, soporte limitado para frameworks JS modernos, sin protección anti-bloqueo |

| Playwright | Sitios modernos con mucho JS, automatización | Rápida, eficiente, soporta varios navegadores, maneja pop-ups y flujos multipágina, autoespera | Ecosistema más nuevo, requiere recursos de navegador, menos nativa en Java que Selenium |

(, )

Jsoup: La Solución Rápida para HTML Estático

es la herramienta básica para scraping en Java cuando trabajas con páginas estáticas. Es como el jQuery de Java: conectas con Jsoup.connect(URL).get(), y luego usas selectores CSS para sacar los datos que necesitas. ¿Quieres todos los títulos <h1>? Fácil. ¿Todos los nombres de productos en <div class="product-name">? Lo tienes en un par de líneas.

Ejemplo: Extrayendo nombres de productos de una página de ecommerce

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup es rápido, sencillo y perfecto para extraer posts de blogs, listados de productos o noticias—pero ojo, no ejecuta JavaScript. Si los datos no están en el HTML original, Jsoup no los verá.

Selenium y HtmlUnit: Para Contenido Dinámico

A veces, los datos que buscas se cargan con JavaScript o aparecen tras acciones del usuario (como hacer clic en “Cargar más”). Ahí es donde brilla. Selenium permite que tu código Java abra un navegador real (Chrome, Firefox, etc.), interactúe con la página y obtenga el contenido como si fueras un usuario.

HtmlUnit es una alternativa más ligera y completamente en Java que puede ejecutar algo de JavaScript, pero no esperes que funcione bien con sitios modernos llenos de JS. Es útil para contenido dinámico sencillo, pero si el sitio está hecho con React o Angular, mejor usa Selenium o Playwright.

¿Cuándo usar un navegador sin interfaz? Si necesitas iniciar sesión, hacer clics o extraer contenido que aparece tras ejecutar scripts, la automatización de navegador es tu aliada. Solo ten en cuenta que será más lento y requerirá más mantenimiento—los sitios cambian su estructura todo el tiempo.

Playwright: Automatización Moderna y Potente

es la herramienta más reciente, desarrollada por Microsoft y pensada para velocidad y fiabilidad. Es hasta un 40–50% más rápida que Selenium, soporta varios motores de navegador y puede manejar escenarios complejos como pop-ups, scroll infinito y flujos multipágina con menos código repetitivo. Si necesitas extraer datos de sitios modernos renderizados en el cliente, Playwright es una excelente opción.

¿Cómo Elegir la Herramienta de Web Scraping en Java Más Adecuada?

No todos los proyectos necesitan la solución más compleja. Así suelo decidir yo:

- Complejidad del sitio: ¿HTML estático? Usa Jsoup. ¿Mucho JS? Mejor Selenium o Playwright. ¿Algo de JS pero sencillo? HtmlUnit puede servir.

- Volumen y frecuencia de datos: ¿Scraping puntual? Manténlo simple. ¿Tareas recurrentes y a gran escala? Busca herramientas con soporte para multihilo y manejo de errores robusto.

- Facilidad de uso vs. flexibilidad: Jsoup es fácil de aprender. Selenium/Playwright ofrecen más potencia, pero requieren más configuración y mantenimiento.

- Requisitos y presupuesto: Las librerías open source son gratis, pero tú te encargas de todo. Las APIs o servicios en la nube ahorran tiempo, pero tienen coste.

Matriz de decisión:

| Criterio | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| HTML Estático | ✔️ | ✔️ | ||

| JS Dinámico | ✔️ | (algo) | ✔️ | |

| Velocidad | ✔️ | ✔️ | ||

| Facilidad de uso | ✔️ | |||

| Maneja logins/clics | ✔️ | (básico) | ✔️ | |

| Escalabilidad/Paralelo | ✔️ | (más difícil) | (aceptable) | ✔️ |

| Económico | ✔️ | ✔️ | ✔️ | ✔️ |

Empieza por lo sencillo y solo complica si hace falta. Y no tengas miedo de combinar herramientas—muchas veces la mejor solución es híbrida.

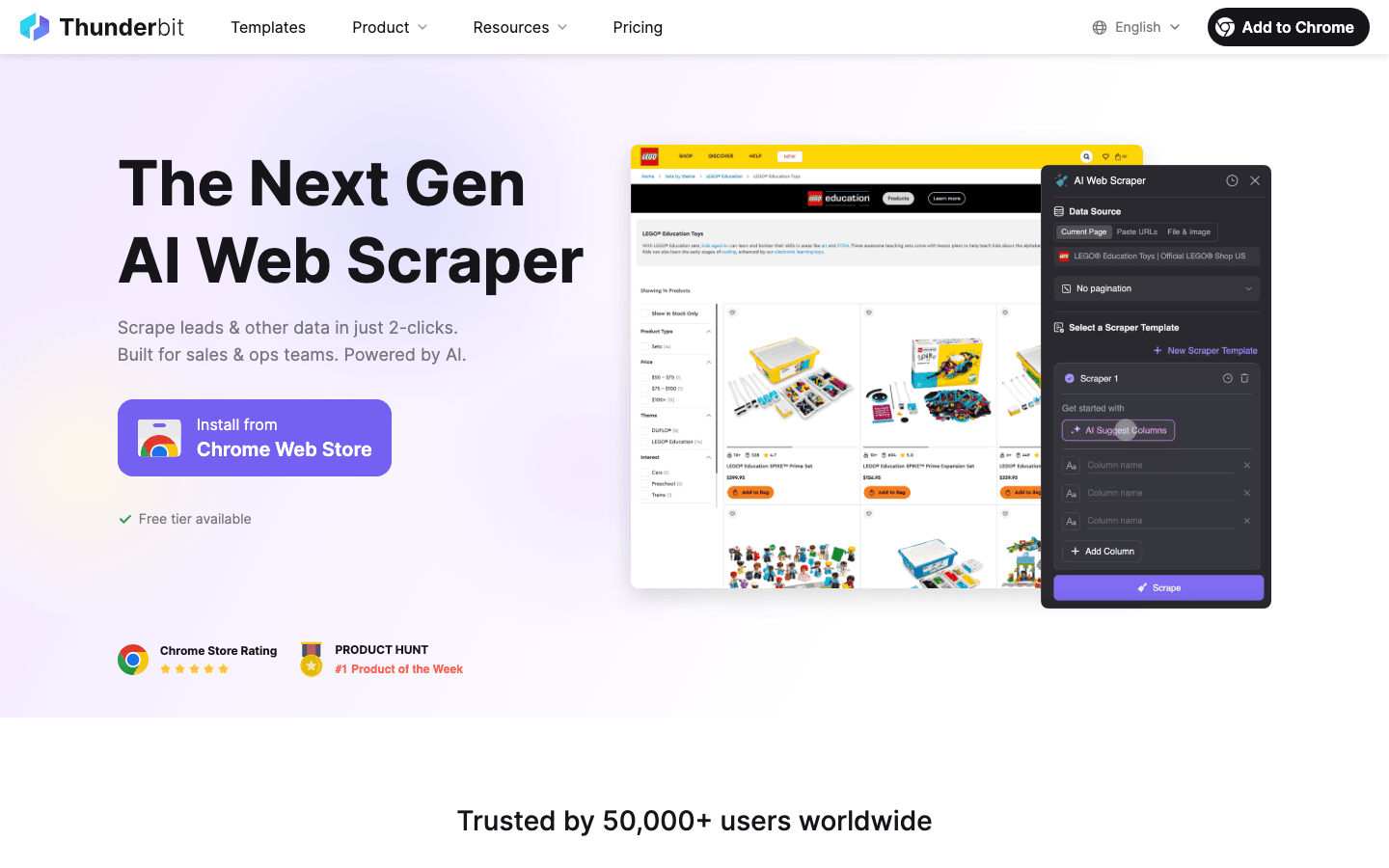

Thunderbit: Web Scraping Simplificado para Desarrolladores Java

Ahora, hablemos de lo que ha cambiado el juego para muchos equipos: . Thunderbit es un Raspador Web IA en forma de extensión de Chrome que te permite extraer datos estructurados de cualquier sitio en solo unos clics—sin código, sin plantillas, sin líos.

¿Cómo ayuda Thunderbit a desarrolladores Java y usuarios de negocio?

- Campos sugeridos por IA: La IA de Thunderbit analiza la página y sugiere las mejores columnas para extraer. Olvídate de buscar selectores CSS o escribir código frágil.

- Navegación por subpáginas: ¿Necesitas detalles de páginas enlazadas? Thunderbit puede hacer clic automáticamente y enriquecer tu dataset—ideal para listados de productos con páginas de detalle.

- Manejo de paginación y scroll infinito: Thunderbit puede hacer scroll, pulsar “Siguiente” y seguir hasta obtener todos los datos.

- Exportación estructurada: Exporta directo a Excel, Google Sheets, Airtable o Notion. O descarga como CSV/JSON para integrarlo en tu app Java.

- Scraping en la nube o en el navegador: Ejecuta extracciones en la nube (hasta 50 páginas a la vez—¡rapidísimo!) o en tu navegador para sitios que requieren login.

- Programación de tareas: Configura extracciones diarias, semanales o con tu propio horario. La IA de Thunderbit incluso entiende instrucciones en lenguaje natural (“cada lunes a las 9am”).

Para desarrolladores Java, Thunderbit ahorra muchísimo tiempo en prototipos, extracciones rápidas o incluso flujos de trabajo en producción—sobre todo si quieres que compañeros sin perfil técnico puedan recolectar datos por sí mismos.

Thunderbit: Un Puente para Equipos de Ventas y Operaciones

Thunderbit no es solo para desarrolladores. Equipos de ventas, marketing, ecommerce y bienes raíces lo usan a diario para:

- Generar leads: Extraer información de contacto de directorios, LinkedIn o listas de asistentes a eventos—sin escribir código.

- Monitorizar a la competencia: Seguir precios, catálogos o estrategias de marketing de la competencia con extracciones programadas.

- Unificar listados: Reunir productos, propiedades o vacantes de varios sitios en una sola tabla estructurada.

He visto equipos pasar de “ojalá tuviéramos estos datos” a “aquí tienes la hoja de cálculo” en menos de 10 minutos. Y gracias al scraping de subpáginas y la detección inteligente de campos, hasta los sitios más caóticos se vuelven accesibles.

Cómo Garantizar la Calidad de los Datos en Proyectos de Web Scraping con Java

Recolectar datos es solo la mitad del trabajo. Si los datos están incompletos, desordenados o desactualizados, estarás a ciegas. Así mantengo mis scrapers (y mi tranquilidad) bajo control:

- Valida y limpia: Revisa precisión, integridad y consistencia. Usa el tipado fuerte de Java para detectar valores raros (como un precio “N/A” en vez de un número). Normaliza formatos—fechas, monedas, teléfonos—para que los datos estén listos para análisis ().

- Elimina duplicados: Los datos extraídos suelen tener duplicados. Usa claves únicas (como URLs o IDs) y colecciones

Setde Java para filtrarlos. - Automatiza controles de calidad: Tras cada extracción, ejecuta comprobaciones—¿obtuviste el número esperado de elementos? ¿Hay campos vacíos inesperadamente? Registra anomalías y configura alertas si algo falla.

- Almacena datos de forma eficiente: Para grandes volúmenes, guarda los datos en una base de datos (Postgres, MongoDB, etc.) en vez de en memoria. Así es más fácil deduplicar y mantener el esquema ().

Manejo de Errores y Resiliencia: Scrapers Robustos

El raspador web java es un deporte de contacto. Los sitios caen, el HTML cambia, aparecen bloqueos anti-bots. Así evito que mis scrapers se detengan:

- Manejo de errores elegante: Captura errores HTTP (404, 500), timeouts y excepciones de análisis. Reintenta peticiones fallidas con backoff exponencial—no satures el servidor ().

- Resiliencia ante cambios: Usa selectores robustos, comprobaciones de nulos y lógica de respaldo. Si la estructura cambia, guarda el HTML para depuración.

- Logs y alertas: Registra cada petición, éxito y fallo. Configura alertas para problemas críticos—como extraer cero elementos cuando esperabas cien.

- Puntos de control: En tareas largas, guarda el progreso periódicamente. Si el scraper falla, puedes continuar donde lo dejaste.

- Limita las peticiones: Sé respetuoso—espera entre peticiones, limita la concurrencia y rota el User-Agent para evitar bloqueos.

Ejemplo de lógica de reintento en Java:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Intento " + attempt + " fallido: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // Backoff exponencial

9 }

10}()

Cumplimiento Legal y Ética en el Web Scraping

El raspador web java no es tierra de nadie. Hay reglas—ignóralas y te arriesgas a bloqueos, demandas o algo peor.

- Respeta la propiedad de los datos: Extraer datos públicos y no sensibles suele ser legal, pero los datos personales (nombres, emails) están protegidos por leyes como GDPR y CCPA. No extraigas PII sin base legal ().

- Sigue los Términos de Servicio y robots.txt: Si un sitio prohíbe el scraping, respétalo—o al menos sé consciente del riesgo. Cumple siempre con robots.txt y los límites de velocidad.

- No sobrecargues los servidores: Limita tus peticiones, controla la concurrencia y nunca extraigas datos tan agresivamente que afectes el rendimiento del sitio ().

- Evita contenido protegido o tras login: No extraigas ni publiques material con copyright, ni accedas a datos tras login sin permiso.

- Protege y anonimiza los datos: Si recolectas información sensible, almacénala de forma segura y cumple con solicitudes de eliminación.

Pasos Prácticos para un Web Scraping Ético

- Revisa los Términos de Servicio y robots.txt antes de extraer datos.

- Usa un User-Agent descriptivo (no solo “Java/1.8.0_201”).

- Limita la frecuencia y concurrencia de tus peticiones.

- Prefiere APIs o datasets públicos cuando existan.

- Lleva registro de qué datos extraes y por qué.

- Mantente actualizado sobre leyes y mejores prácticas ().

Optimización y Escalabilidad: Lleva tu Web Scraper en Java al Siguiente Nivel

Cuando tus necesidades de scraping crecen, el rendimiento importa. Así puedes escalar sin perder la cabeza (ni tu servidor):

- Paraleliza las peticiones: Usa

ExecutorServiceo pools de hilos en Java para procesar varias páginas a la vez. Controla la concurrencia para no saturar el sitio (). - Procesa datos en streaming: Escribe los resultados en una base de datos o archivo a medida que avanzas—no lo guardes todo en memoria.

- Análisis eficiente: Usa selectores de Jsoup para extraer solo lo necesario. Para grandes volúmenes, considera análisis en streaming o parsers más ligeros.

- Aprovecha la nube: Ejecuta scrapers en servidores cloud para mayor ancho de banda y fiabilidad. O usa plataformas de scraping en la nube (como el modo cloud de Thunderbit) para trabajos de alto volumen.

- Optimiza el uso de red: Usa compresión, ejecuta los scrapers cerca de los sitios objetivo y cachea respuestas cuando sea posible.

Ejemplo de scraping multihilo en Java:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();()

Resumen: Claves para el Éxito en Web Scraping con Java

Vamos a repasar lo esencial para dominar el tutorial web scraping java:

- Elige la herramienta adecuada: Jsoup para páginas estáticas, Selenium/Playwright para sitios dinámicos, HtmlUnit para scraping sin interfaz en Java.

- Aprovecha la automatización y la IA: Usa herramientas como para acelerar la detección de campos, el scraping de subpáginas y la exportación de datos—ideal para usuarios de negocio o prototipos rápidos.

- Prioriza la calidad de los datos: Valida, limpia, elimina duplicados y almacena tus datos de forma eficiente.

- Cumple con la normativa: Respeta los límites legales y éticos—extrae solo datos públicos, sigue las reglas del sitio y evita información personal sin base legal.

- Optimiza para escalar: Usa la concurrencia de Java, almacenamiento eficiente y recursos en la nube para manejar grandes volúmenes.

El raspador web java no es solo una habilidad técnica—es una ventaja competitiva. Ya seas desarrollador creando scrapers robustos en Java o parte de un equipo de ventas/operaciones usando Thunderbit para automatizar la recolección de datos, dominar estas buenas prácticas te pondrá en el camino del éxito.

¿Quieres probar el scraping con IA? y descubre lo fácil que es convertir cualquier web en un dataset estructurado. Y si quieres profundizar, visita el para más tutoriales, comparativas y casos reales de scraping.

Preguntas Frecuentes

1. ¿Por qué Java sigue siendo una gran opción para web scraping?

Java ofrece fiabilidad, multihilo robusto e integración directa con sistemas empresariales. Es ideal para scraping a gran escala, de larga duración o alto rendimiento—sobre todo si tu pipeline de datos ya está en Java ().

2. ¿Cuál es la diferencia entre Jsoup, Selenium, HtmlUnit y Playwright?

Jsoup es ideal para HTML estático; Selenium y Playwright manejan sitios dinámicos y con mucho JS; HtmlUnit es un navegador sin interfaz, 100% Java, para JS moderado. Elige según la complejidad del sitio y las necesidades de tu proyecto ().

3. ¿Cómo ayuda Thunderbit a desarrolladores Java y usuarios de negocio?

Thunderbit usa IA para automatizar la detección de campos, la navegación por subpáginas y la estructuración de datos—sin necesidad de código. Es perfecto para usuarios de negocio o desarrolladores que quieren prototipar o empoderar a compañeros no técnicos para recolectar datos ().

4. ¿Cuáles son las mejores prácticas para asegurar la calidad de los datos en web scraping?

Valida y limpia los datos, elimina duplicados, automatiza controles de calidad y almacena los resultados en bases de datos para grandes volúmenes. Considera los datos extraídos como materia prima que necesita procesamiento ().

5. ¿Cómo mantener el cumplimiento legal y ético al hacer scraping?

Extrae solo datos públicos y no sensibles; respeta robots.txt y los términos del sitio; no sobrecargues los servidores; y no recolectes información personal sin base legal. Mantente actualizado sobre leyes como GDPR y CCPA ().

¿Listo para llevar tu scraping al siguiente nivel? Prueba Thunderbit gratis o crea tu propio raspador web java siguiendo estas buenas prácticas. ¡Feliz scraping! Y recuerda: programa con responsabilidad, haz scraping de forma ética y revisa tus datos antes de tomar decisiones importantes.

Más información