Imagina la escena: lanzas tu página web esperando que lleguen montones de clientes, pero te das cuenta de que la mitad de las visitas... ¡son robots! No robots de película, sino rastreadores digitales: motores de búsqueda, bots de IA, spiders de analítica... todos paseándose por tu web a todas horas, como una fila interminable de visitantes invisibles. Para 2026, esto ya no es solo una rareza en los logs del servidor; es la nueva normalidad. Saber quién (o qué) está rastreando tu web, con qué frecuencia y para qué, se ha vuelto clave para cualquier negocio online.

Después de años metido en SaaS, automatización e IA, he visto cómo el web crawling pasó de ser un tema técnico a convertirse en un desafío estratégico para las empresas. Los números impresionan: los bots ya generan casi la mitad del tráfico en internet, y en algunos sitios hasta superan a los humanos. Con la llegada de rastreadores de IA que recolectan contenido para entrenar modelos de lenguaje, el impacto nunca fue tan grande: afecta tu infraestructura, tu presupuesto y tu reputación. Vamos a repasar las estadísticas más recientes, los estándares del sector y lo que todo esto significa para tu negocio en 2026.

El web crawling en 2026 está a otro nivel, tanto en escala como en complejidad. Todos los días, miles de millones de solicitudes automáticas recorren la red, generadas por una variedad cada vez mayor de rastreadores. Antes, los bots de motores de búsqueda como Googlebot y Bingbot eran los reyes, indexando páginas para que la gente las encontrara. Ahora, se suman los rastreadores de IA, scrapers de redes sociales, bots de analítica y más.

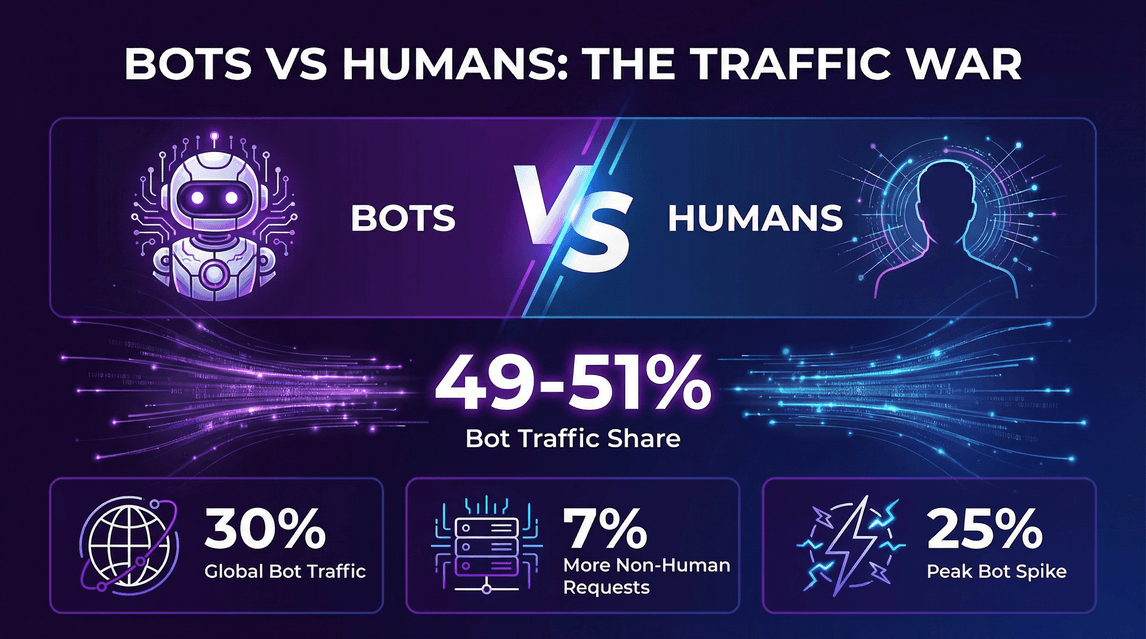

El dato que no puedes ignorar: , y en algunas zonas, el tráfico de bots incluso supera al de humanos. En la red de Cloudflare, . ¿Lo más importante? Este aumento no es solo por los motores de búsqueda: los rastreadores de IA que recolectan datos para alimentar chatbots y herramientas generativas son los grandes responsables.

El ecosistema es más variado que nunca:

- Bots “buenos”: indexadores de búsqueda, monitores de disponibilidad, scrapers legales.

- Bots “malos”: spam, intentos de hackeo, scraping sin permiso.

- Rastreadores de IA: los nuevos jugadores, recolectando contenido para entrenar IA y responder en tiempo real.

Los rastreadores de IA suelen comportarse diferente a los tradicionales. Pueden descargar páginas enteras para análisis semántico, no solo indexar palabras clave, y suelen operar a gran escala—llegando a saturar sitios con millones de solicitudes en pocos días. ¿El resultado? , mezclando el rastreo clásico con el apetito insaciable de la IA por los datos.

Vamos a los números que están marcando la web en 2026. No son solo datos curiosos: son referencias que deberían guiar tu infraestructura, tu estrategia de contenidos y tus decisiones de negocio.

Bots vs. Humanos: ¿Quién manda en el tráfico?

- Entre el 49% y el 51% del tráfico en internet es generado por bots, igualando o superando a los visitantes humanos ().

- Datos de Cloudflare: .

- Las solicitudes no humanas a páginas HTML fueron un 7% superiores a las de humanos ().

- En ciertos momentos, el tráfico de bots .

El boom de los rastreadores de IA

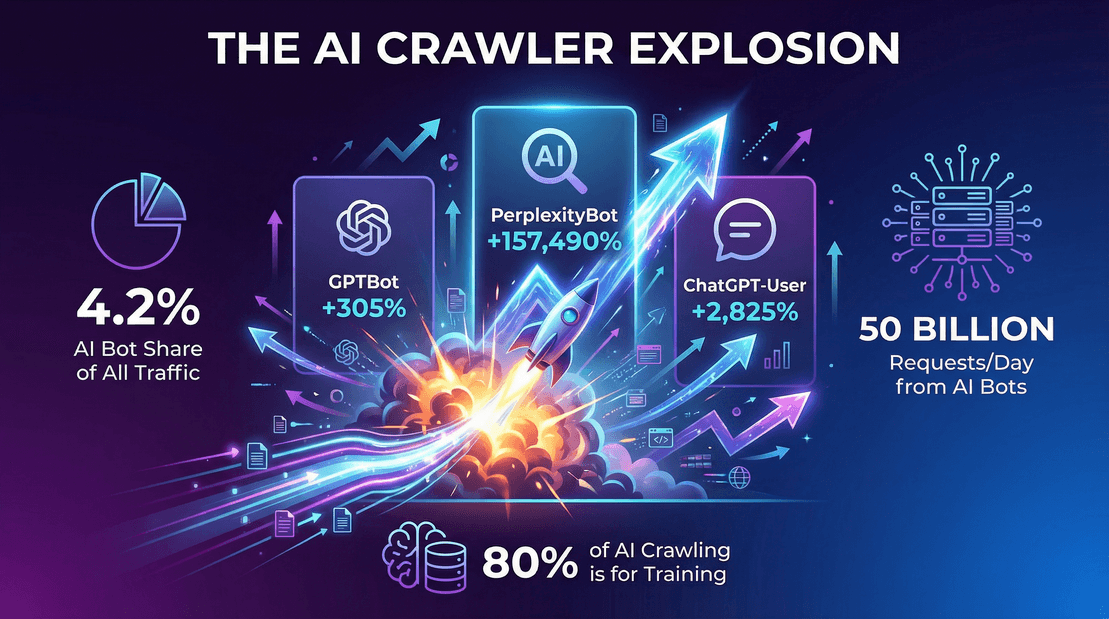

- Los bots de IA representaron el 4,2% de todas las solicitudes a páginas HTML en 2025 ().

- GPTBot de OpenAI: Pasó de cero a , creciendo un 305% en un año.

- Bot de Perplexity.ai: .

- Googlebot: , representando cerca del 50% de todas las solicitudes de rastreadores de búsqueda/IA.

Tráfico de rastreadores en la vida real

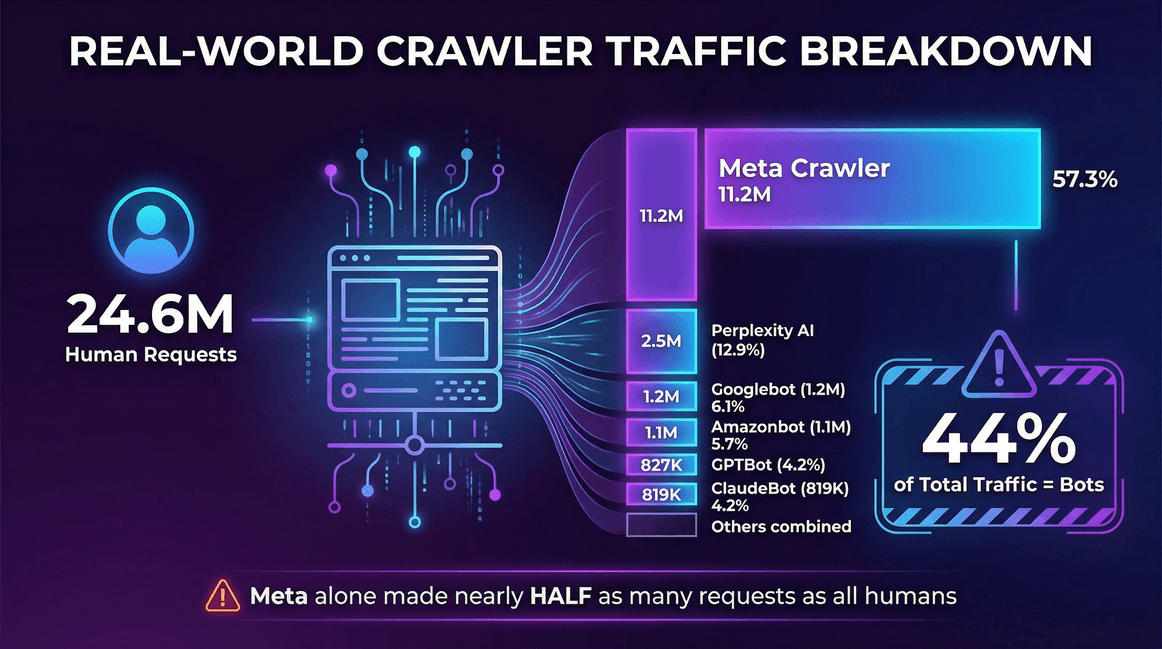

Ejemplo real de los registros de un servidor de :

| Fuente de tráfico | Solicitudes (mensual) | Porcentaje de rastreadores |

|---|---|---|

| Usuarios reales (humanos) | 24,647,904 | -- |

| Meta Crawler (Facebook) | 11,175,701 | 57.3% |

| Perplexity AI | 2,512,747 | 12.9% |

| Googlebot | 1,180,737 | 6.1% |

| Amazonbot | 1,120,382 | 5.7% |

| OpenAI GPTBot | 827,204 | 4.2% |

| ClaudeBot (Anthropic) | 819,256 | 4.2% |

| Bingbot | 599,752 | 3.1% |

| ChatGPT-User (OpenAI) | 557,511 | 2.9% |

| Ahrefs Crawler | 449,161 | 2.3% |

| ByteDance Spider | 267,393 | 1.4% |

En este sitio, los bots representaron el 44% del tráfico total—y solo el rastreador de Meta generó casi la mitad de solicitudes que todos los usuarios reales juntos.

La visión global

- El tráfico de rastreadores (búsqueda + IA) creció un 18% entre mayo 2024 y mayo 2025 en un grupo constante de sitios ().

- Los bots de entrenamiento de LLM representaron casi el 80% de todo el tráfico “bot” en algunos grandes CDNs ().

- La red de Cloudflare registró unos 50 mil millones de solicitudes diarias de rastreadores de IA a finales de 2025 ().

Hablemos del elefante (o mejor dicho, del robot) en la sala: los rastreadores de IA. Estos bots no solo indexan tu web para buscadores—también absorben contenido para entrenar modelos de lenguaje o dar respuestas instantáneas con IA. Y lo hacen a una escala que deja pequeño a cualquier motor de búsqueda tradicional.

¿Por qué están creciendo tanto los rastreadores de IA?

- Modelos de IA hambrientos de datos: Los LLM modernos necesitan montones de datos variados. La web es su buffet, y tu contenido está en el menú.

- Entrenamiento vs. respuestas en tiempo real: , no solo para responder consultas en vivo.

- Nuevos patrones de rastreo: Los bots de IA pueden atacar sitios en ráfagas masivas, rastreando millones de páginas en días, sobre todo al reentrenar o actualizar modelos.

Cómo se comportan diferente los rastreadores de IA

- Más volumen por bot: Un solo bot de IA puede generar millones de solicitudes mensuales a un mismo sitio ().

- Más tipos de contenido: No solo HTML—también PDFs, imágenes, código, etc.

- Menos respeto por robots.txt: Algunos rastreadores de IA ignoran o solo cumplen parcialmente las reglas de rastreo ().

- Casi sin tráfico de referencia: A diferencia de los buscadores, los bots de IA rara vez envían usuarios a tu web. .

Tráfico de rastreadores de IA por sector

No todos los sectores reciben el mismo nivel de rastreo. Por ejemplo:

- Noticias y medios: Mucha actividad de bots de IA, pero mejores ratios de referencia (por ejemplo, Perplexity tiene ratio 33:1 en sitios de noticias, frente a 118:1 en general) ().

- Tecnología y electrónica: GPTBot y Amazonbot dominan, con ratios de referencia aún altos (por ejemplo, OpenAI tiene ratio 402:1 en tecnología) ().

- Finanzas, academia y otros: Cada sector tiene su propio mix de bots y ratios de referencia, pero la tendencia es clara: los rastreadores de IA están en todas partes y la mayoría no devuelve tráfico.

¿Quiénes son los grandes jugadores en esto? Aquí tienes el ranking, según :

| Rastreador (Propietario) | % de rastreos (mayo 2025) | Crecimiento interanual |

|---|---|---|

| Googlebot (Google) | 50.0% | +96% |

| Bingbot (Microsoft) | 8.7% | +2% |

| GPTBot (OpenAI) | 7.7% | +305% |

| ClaudeBot (Anthropic) | 5.4% | –46% |

| GoogleOther (Google) | 4.3% | +14% |

| Amazonbot (Amazon) | 4.2% | –35% |

| Googlebot-Image (Google) | 3.3% | –13% |

| Bytespider (ByteDance) | 2.9% | –85% |

| YandexBot (Yandex) | 2.2% | –10% |

| ChatGPT-User (OpenAI) | 1.3% | +2825% |

| Applebot (Apple) | 1.2% | –26% |

| PerplexityBot | 0.2% | +157,490% |

Algunos puntos clave:

- Googlebot sigue siendo el rey, responsable de la mitad de la actividad de rastreo.

- GPTBot y el rastreador de Meta son los que más crecen, triplicando GPTBot su cuota en un año.

- PerplexityBot y ChatGPT-User aún tienen poca cuota, pero crecen a toda velocidad.

El web crawling no es solo cuestión de volumen, sino de velocidad y eficiencia. Esto es lo que tienes que saber sobre tasas de rastreo y benchmarks en 2026.

Tasa de rastreo: ¿A qué ritmo rastrean las páginas?

- La tasa de rastreo suele medirse en páginas por segundo (o solicitudes por segundo) ().

- Hilos/conexiones paralelas: Más hilos = más velocidad. Por ejemplo, 200 hilos con 2 segundos de espera por sitio pueden llegar a unas 100 páginas por segundo ().

- Benchmarks reales: 100–200 páginas por segundo es lo normal para un rastreador bien afinado en un clúster decente.

- Google y Bing: Probablemente rastrean miles de páginas por segundo a nivel global, repartidas en millones de sitios.

Factores que influyen en la tasa de rastreo

- Número de hilos/fetchers en paralelo: Más hilos, más velocidad (hasta que aparecen otros cuellos de botella).

- Número de sitios activos: Rastrear varios dominios a la vez multiplica el rendimiento.

- Retraso entre solicitudes: Más espera = menos velocidad.

- Límites de recursos: Ancho de banda, CPU, velocidad de escritura en base de datos pueden ser el cuello de botella.

- Rendimiento del sitio objetivo: Sitios lentos o con limitaciones bajan la velocidad de rastreo.

Por ejemplo, si tu rastreador tiene 100 hilos y 1 segundo de espera por sitio, podrías llegar a unas 100 páginas por segundo—salvo que tu base de datos no lo aguante, en cuyo caso el cuello de botella será el almacenamiento, no la red.

El web crawling no es solo una curiosidad técnica: es un tema de negocio, con costes y oportunidades reales.

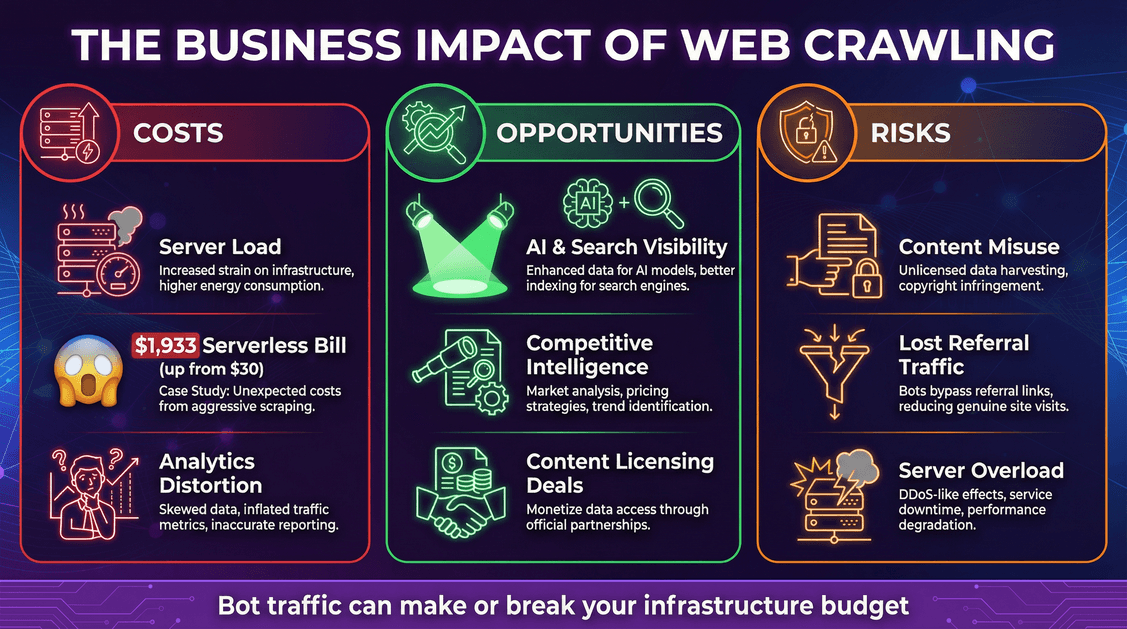

Costes: infraestructura y facturas inesperadas

- Carga en servidores: Cada solicitud de bot consume CPU, memoria y ancho de banda.

- Facturas en la nube: Si usas modelos de pago por uso (como serverless), los bots pueden disparar los costes. Un desarrollador vio cómo .

- Distorsión de analítica: Los bots pueden sesgar tus métricas web, complicando el análisis del comportamiento real de los usuarios.

Oportunidades: visibilidad y aprovechamiento de datos

- Visibilidad en IA y buscadores: Estar incluido en los datos de entrenamiento de IA o en los índices de búsqueda puede aumentar el alcance de tu marca ().

- Inteligencia competitiva: Las empresas usan rastreadores para investigación de mercado, monitoreo de precios, etc.

- Monetización: Algunos editores ya .

Riesgos: uso indebido de contenido y pérdida de tráfico

- Uso indebido de contenido: Los rastreadores de IA pueden incorporar tu contenido en sus modelos, a veces sin permiso ni compensación.

- Pérdida de tráfico de referencia: Las respuestas de IA pueden satisfacer al usuario sin enviarlo a tu web, provocando “desintermediación”.

- Seguridad y caídas: Los rastreadores agresivos pueden sobrecargar tus servidores, causando lentitud o caídas.

Entonces, ¿cómo evitar que los bots se coman tu presupuesto (o tus recursos)?

1. Optimiza tu robots.txt

- Usa

robots.txtpara permitir o bloquear bots específicos. La mayoría de rastreadores legales (como Googlebot) lo respetan, pero muchos bots de IA no (). - A mediados de 2025, cerca del 14% de los sitios principales ya incluían reglas explícitas para bots de IA ().

2. Usa herramientas de gestión de bots

- Firewalls de aplicaciones web (WAF) y servicios de gestión de bots pueden bloquear o limitar el tráfico sospechoso.

- Cloudflare y otros ofrecen funciones de mitigación de bots e incluso herramientas de “Auditoría de IA” para creadores de contenido ().

3. Implementa limitación de velocidad y caché

- Limita la velocidad de solicitudes de un mismo bot.

- Sirve contenido en caché a los bots siempre que puedas—evita que disparen funciones serverless o consultas costosas a la base de datos ().

4. Monitoriza y analiza el tráfico de bots

- Revisa tus logs de servidor. Identifica qué bots te visitan, con qué frecuencia y cuándo.

- Configura alertas para picos de tráfico inusuales.

5. Mantente al día con los nuevos estándares

- Estate atento a nuevas metaetiquetas o cabeceras HTTP para permisos de uso de IA (por ejemplo,

<meta name="ai:allow" content="no">). - Sigue iniciativas del sector como ) y protocolos de pago como .

El mundo del web crawling está cambiando a toda velocidad. Esto es lo que tengo en el radar (y tú también deberías):

- El rastreo impulsado por IA seguirá creciendo: Habrá más bots de IA, rastreando más tipos de contenido (texto, imágenes, vídeo).

- Licencias de contenido y estándares de pago: El “lejano oeste” da paso a y .

- La regulación está en camino: Se espera mayor claridad legal sobre lo que los bots pueden o no pueden hacer, especialmente en el entrenamiento de IA ().

- Nuevos estándares técnicos para el uso de contenido: Aparecerán nuevas metaetiquetas, extensiones de robots.txt y declaraciones de bots legibles por máquina.

- Colaboración editor-IA: Más editores negociarán feeds de datos estructurados o APIs para empresas de IA, en vez de ser solo objetivos pasivos.

En resumen: el web crawling es una fuerza dominante en 2026, y no va a frenar. Los bots automatizados—sobre todo los de IA—ya representan una parte enorme de tu tráfico, y su impacto en tu infraestructura, presupuesto y estrategia de contenidos solo va a más.

¿Qué deberías hacer?

- Prepárate para mucho tráfico de bots: Ajusta tu infraestructura, presupuesto y monitorización.

- Conoce a tus rastreadores: No todos los bots son iguales—adapta tu estrategia a cada uno.

- Monitorea tus métricas: Haz seguimiento del tráfico de bots igual que del de usuarios reales.

- Protege tu contenido y tu bolsillo: Usa controles técnicos, acuerdos legales y nuevos estándares.

- Aprovecha el lado bueno: Estar en los índices de IA y búsqueda puede impulsar tu marca—asegúrate de sacar provecho.

- Mantente informado y adáptate: El panorama cambia rápido. Vigila nuevos estándares, regulaciones y modelos de negocio.

Como alguien que lleva años creando herramientas de automatización e IA (y ahora en ), te lo digo claro: las empresas que prosperan en esta nueva era son las que ven el web crawling como una prioridad estratégica, no solo como un problema técnico. Ya sea en ventas, ecommerce, marketing o inmobiliaria, entender las estadísticas y referencias del sector es ahora imprescindible.

Así que, la próxima vez que revises tus logs y veas una avalancha de bots, no te resignes. Usa esos datos. Compara tu web. Ajusta tu estrategia. Y recuerda: en la era de la IA, los bots no solo están llegando—ya están aquí. Haz que trabajen para ti, no al revés.

Mantente atento, sigue aprendiendo y que tus logs siempre jueguen a tu favor.

¿Quieres saber más sobre web scraping, automatización y productividad con IA? Date una vuelta por el para guías, tutoriales y tendencias. Y si quieres tomar el control de tus datos, prueba la para web scraping con IA—sin código, sin líos, solo resultados.

Fuentes y lecturas recomendadas: