Imagina la escena: son las 8:30 de la mañana, tienes el café recién hecho y tu jefe (o el jefe de tu jefe) te pide una hoja de cálculo con los precios de todos los productos de la competencia, las opiniones de sus clientes y, para rematar, la pizza favorita del CEO. Podrías pasarte horas copiando y pegando, o dejar que Python haga el trabajo duro. Pero, ¿y si no sabes programar o no te apetece pelearte con HTML toda la mañana? Para eso está esta guía.

Soy Shuai Guan, cofundador y CEO de , y llevo años metido en el mundo SaaS, la automatización y la IA, ayudando a equipos a transformar el caos de los datos web en información útil. En este artículo te voy a mostrar las 10 mejores librerías de Python para web scraping en 2025: qué hacen, cómo funcionan, sus pros y contras, y en qué situaciones brillan. Y si piensas: “Todo esto suena bien, pero no sé ni cómo empezar con Python”, tranquilo. También te enseñaré cómo el raspador web IA de Thunderbit, sin necesidad de programar, puede darte los mismos resultados en solo dos clics—sin líos, sin código y sin pasarte de café.

¿Por qué las librerías de Python para Web Scraping son tan importantes para los equipos de negocio?

- Generación de leads y ventas: Extrae datos de directorios, redes sociales o foros para crear listas de contactos—nombres, emails, perfiles sociales, lo que necesites. Los equipos de ventas pueden automatizar tareas que antes eran eternas ().

- Monitoreo de precios e inteligencia competitiva: Los equipos de e-commerce pueden seguir los precios, el stock y las promociones de la competencia en tiempo real, ajustando su estrategia al vuelo ().

- Investigación de mercado y análisis de tendencias: Analizar reseñas, redes sociales o portales de noticias ayuda a marketing y producto a detectar tendencias y opiniones antes de que se pongan de moda ().

- Datos inmobiliarios: Agentes y analistas pueden reunir listados, precios y detalles de propiedades de varias fuentes, facilitando el análisis del mercado.

- Operaciones de e-commerce: Desde datos de proveedores hasta auditorías de catálogos, el scraping asegura precisión y ahorra horas de copiar y pegar.

En pocas palabras, . Pero ojo: la mayoría de las librerías de Python asumen que sabes programar. Para quienes no son técnicos, eso puede ser un muro. Por eso cada vez más gente apuesta por herramientas sin código y con IA como , de la que te hablaré más adelante.

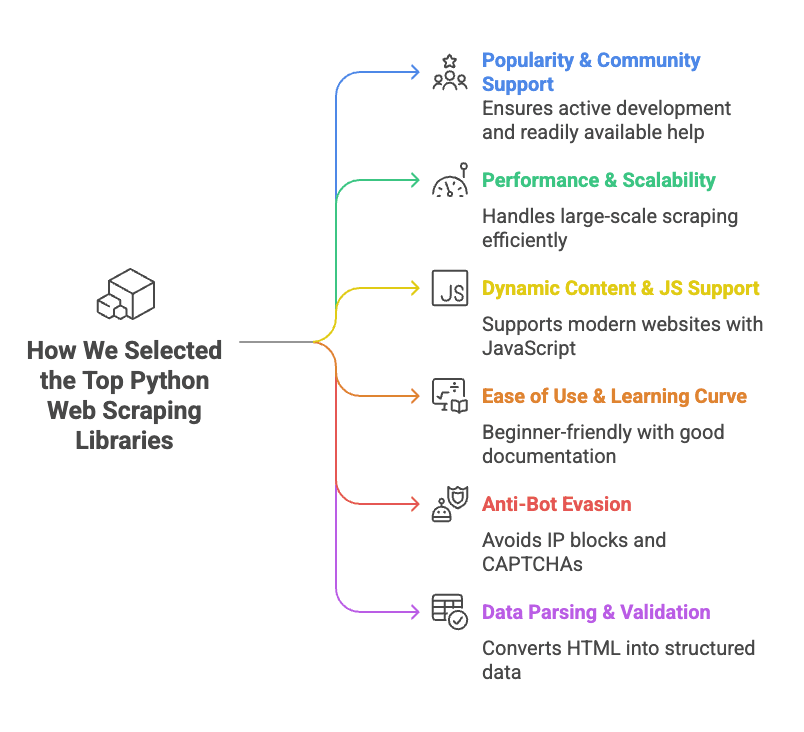

Cómo seleccionamos las mejores librerías de Python para Web Scraping

- Popularidad y comunidad: Librerías con muchas estrellas en GitHub, desarrollo activo y montones de tutoriales. Si te atascas, quieres encontrar ayuda, no silencio.

- Rendimiento y escalabilidad: ¿Aguanta miles de páginas? ¿Soporta concurrencia o peticiones asíncronas? ¿Es rápida o te hace desear haber contratado a un becario?

- Soporte para contenido dinámico y JavaScript: Muchos sitios modernos cargan datos con JavaScript. Las librerías que pueden con esto (usando automatización de navegador o APIs) suman puntos.

- Facilidad de uso y curva de aprendizaje: Algunas herramientas son plug-and-play; otras parecen un máster en “¿Por qué no funciona esto?”. Priorizamos las que son amigables para principiantes o bien documentadas.

- Evasión anti-bots: ¿La herramienta puede con bloqueos de IP, CAPTCHAs o límites de velocidad? Si no, podrías raspar cinco minutos y quedar bloqueado cinco días.

- Parseo y validación de datos: No basta con obtener HTML; necesitas convertirlo en datos limpios y estructurados. Las librerías que ayudan con esto suman puntos extra.

De cada librería te contaré qué es, cómo se usa, ventajas, desventajas y en qué casos destaca.

Tabla comparativa rápida: Las mejores librerías de Python para Web Scraping

Aquí tienes una comparativa de las 10 principales librerías, para que elijas la que mejor encaje contigo (¡y de paso quedes como un pro del scraping delante de tu jefe!):

| Librería | Facilidad de uso | Soporte JS | Peticiones HTTP | Parseo HTML | Anti-bot | Validación de datos | Ideal para |

|---|---|---|---|---|---|---|---|

| ZenRows | Muy fácil (API) | ✅ (navegador) | ✅ (API) | ✅ | ✅ (proxies, bypass CAPTCHA) | ❌ | Scraping masivo en sitios protegidos |

| Selenium | Media | ✅ (navegador) | ✅ (navegador) | Parcial | ❌ | ❌ | Sitios dinámicos e interactivos |

| Requests | Muy fácil | ❌ | ✅ | ❌ | ❌ | ❌ | Páginas estáticas, APIs |

| Beautiful Soup | Fácil | ❌ | ❌ | ✅ | ❌ | ❌ | Parseo de HTML en páginas estáticas |

| Playwright | Media | ✅ (navegador) | ✅ (navegador) | Acceso DOM | ❌ | ❌ | Apps web modernas, soporte multi-navegador |

| Scrapy | Media/Alta | Parcial (add-ons) | ✅ (async) | ✅ | ❌ | Limitado | Crawling estructurado a gran escala |

| urllib3 | Fácil (bajo nivel) | ❌ | ✅ | ❌ | ❌ | ❌ | HTTP personalizado, alta concurrencia |

| HTTPX | Fácil/Media | ❌ (async IO) | ✅ (async) | ❌ | ❌ | ❌ | Scraping asíncrono y de alto rendimiento |

| lxml | Media | ❌ | ❌ | ✅ (rápido) | ❌ | ❌ | Parseo rápido de HTML/XML complejo |

| Pydantic | Media | N/A | N/A | N/A | N/A | ✅ | Validación de datos tras el scraping |

Nota: “Soporte JS” indica si puede manejar contenido generado por JavaScript. “Anti-bot” se refiere a funciones integradas, no a lo que puedas añadir tú.

ZenRows: Solución todo en uno para Web Scraping en Python

¿Qué es?

es una API de scraping que se encarga de lo complicado: proxies rotativos, saltarse CAPTCHAs, fingerprinting de navegador y renderizado de JavaScript. Solo tienes que hacer una llamada a la API y ZenRows te devuelve la página.

Cómo se usa:

Te registras para conseguir una API key y usas la librería requests de Python para llamar a ZenRows:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])Ventajas:

- Esquiva la mayoría de bloqueos anti-bot (proxies, CAPTCHAs, etc.)

- Soporta webs con mucho JavaScript

- API sencilla—no tienes que gestionar navegadores ni proxies

- Escalable para grandes volúmenes

Desventajas:

- Es de pago (hay prueba gratis, pero el uso continuado cuesta)

- Dependencia de una API externa

Ideal para:

Scraping masivo, sobre todo en sitios que bloquean bots o requieren renderizado de JavaScript. Si te hartas de los bloqueos y los CAPTCHAs, ZenRows es una opción a tener en cuenta ().

Selenium: Automatiza navegadores para scraping dinámico

¿Qué es?

es el clásico para automatizar navegadores. Permite controlar Chrome, Firefox u otros navegadores desde Python, simulando clics, formularios, scroll y más. Si un humano puede hacerlo en el navegador, Selenium también.

Cómo se usa:

Instala Selenium y un driver de navegador (como ChromeDriver), luego:

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()Ventajas:

- Puede con cualquier sitio que soporte un navegador real (contenido dinámico, logins, pop-ups)

- Simula interacciones de usuario (clics, escribir, etc.)

- Soporte multi-navegador

Desventajas:

- Consume bastantes recursos (cada navegador usa RAM y CPU)

- Más lento que el scraping vía HTTP

- Curva de aprendizaje más alta (sobre todo para concurrencia)

- Puede ser detectado por sistemas anti-bot avanzados

Ideal para:

Scraping de sitios dinámicos y con mucha interacción, como LinkedIn, dashboards o páginas tras login ().

Requests: El cliente HTTP de referencia en Python

¿Qué es?

es la librería “HTTP for Humans”. Es la forma más sencilla y popular de obtener páginas web o APIs en Python.

Cómo se usa:

Para obtener una página estática:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])Ventajas:

- API muy sencilla

- Rápida y ligera

- Maneja cookies, redirecciones y la mayoría de necesidades HTTP

- Gran comunidad y muchos tutoriales

Desventajas:

- No ejecuta JavaScript ni maneja contenido dinámico

- No parsea HTML (debes combinarla con Beautiful Soup o lxml)

- Sin funciones anti-bot integradas (debes gestionar headers, proxies, etc.)

Ideal para:

Páginas estáticas, APIs o cualquier sitio donde los datos estén en el HTML inicial. Requests + Beautiful Soup es la combinación clásica ().

Beautiful Soup: Parseo sencillo de HTML en Python

¿Qué es?

(BS4) es una librería para parsear HTML y XML. No descarga páginas por sí misma—se usa junto a Requests o Selenium—pero facilita encontrar y extraer datos del HTML.

Cómo se usa:

Extraer nombres de productos de una página:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)Ventajas:

- Muy amigable para principiantes, tolera HTML desordenado

- Búsqueda flexible (por etiqueta, clase, selector CSS, regex)

- Ligera y rápida para la mayoría de usos

- Mucha documentación y ejemplos

Desventajas:

- No descarga páginas ni ejecuta JavaScript

- Más lenta que lxml en documentos muy grandes

- Menos potente para consultas complejas (usa lxml para XPath avanzado)

Ideal para:

Convertir HTML en datos estructurados—listados de productos, tablas o enlaces. Si ya tienes el HTML, Beautiful Soup te ayuda a organizarlo ().

Playwright: Automatización moderna de navegadores para scraping en Python

¿Qué es?

es la nueva generación de automatización de navegadores, creada por Microsoft. Como Selenium, controla navegadores, pero es más rápido, soporta varios motores (Chromium, Firefox, WebKit) y tiene una API más moderna.

Cómo se usa:

Obtener el contenido de una página:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()Ventajas:

- Maneja sitios dinámicos y con mucho JavaScript

- Soporte multi-navegador (Chromium, Firefox, WebKit)

- Espera automática de elementos (menos fallos que Selenium)

- Soporta asincronía y paralelismo

Desventajas:

- Sigue siendo pesado en recursos (automatización de navegador)

- Curva de aprendizaje, sobre todo para código asíncrono

- No es inmune a la detección anti-bot

Ideal para:

Apps web modernas, sitios que cambian según el navegador o cuando necesitas interceptar peticiones de red ().

Scrapy: Framework escalable de Web Scraping en Python

¿Qué es?

es un framework completo para scraping. Está pensado para crawling a gran escala, con concurrencia, pipelines y opciones de exportación integradas. Si necesitas raspar miles de páginas, Scrapy es tu aliado.

Cómo se usa:

Define un spider:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Ejecuta con scrapy crawl quotes dentro de un proyecto Scrapy.

Ventajas:

- Alto rendimiento, concurrencia integrada

- Estructura de proyecto clara (spiders, pipelines, middlewares)

- Exportación fácil a CSV, JSON, bases de datos

- Gran comunidad y muchos plugins

Desventajas:

- Curva de aprendizaje pronunciada para principiantes

- Requiere configuración de proyecto (no ideal para tareas rápidas)

- Soporte limitado para JavaScript de serie (necesita add-ons)

Ideal para:

Crawling masivo y repetible—por ejemplo, reunir listados inmobiliarios de varios sitios o catálogos completos de productos ().

Urllib3: HTTP confiable para Web Scraping en Python

¿Qué es?

es un cliente HTTP de bajo nivel que usan otras librerías como Requests. Si necesitas control detallado sobre conexiones, reintentos o pools, urllib3 es tu opción.

Cómo se usa:

Obtener una página:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])Ventajas:

- Pooling de conexiones rápido y eficiente

- Seguro para hilos, ideal para scraping concurrente

- Control detallado del comportamiento HTTP

Desventajas:

- Más trabajo manual que Requests

- No parsea HTML ni ejecuta JavaScript

- Menos documentación para principiantes

Ideal para:

Escenarios HTTP personalizados, scraping de alta concurrencia o cuando necesitas el máximo rendimiento ().

HTTPX: Cliente HTTP moderno y asíncrono para Web Scraping en Python

¿Qué es?

es la evolución de Requests, con soporte asíncrono y HTTP/2 de serie. Si quieres raspar miles de páginas en paralelo, HTTPX es tu aliado.

Cómo se usa:

Síncrono:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)Asíncrono:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))Ventajas:

- Soporte asíncrono para scraping de alta concurrencia

- HTTP/2 integrado (más rápido en muchos sitios)

- API similar a Requests (fácil migración)

- Mejor manejo de errores

Desventajas:

- Más reciente, menos tutoriales que Requests

- Asincronía requiere entender event loops

- No parsea HTML de serie

Ideal para:

Scraping de alto rendimiento, APIs o cuando necesitas velocidad ().

lxml: Parseo rápido y potente de HTML/XML en Python

¿Qué es?

es una librería de alto rendimiento para parsear HTML y XML, con soporte para XPath y selectores CSS. Es el motor detrás de muchas otras herramientas (incluidos los selectores de Scrapy).

Cómo se usa:

Extraer citas y autores:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))Ventajas:

- Muy rápido, incluso con documentos grandes

- Soporte potente para XPath (consultas complejas)

- Eficiente en memoria

Desventajas:

- Curva de aprendizaje para XPath

- Documentación menos amigable que BS4

- Instalación puede ser complicada en algunos sistemas

Ideal para:

Parseo de HTML/XML grande o complejo, o cuando necesitas consultas avanzadas ().

Pydantic: Validación de datos para resultados limpios en Web Scraping con Python

¿Qué es?

no es un scraper, sino una librería para validar y modelar datos. Tras raspar, Pydantic te ayuda a asegurar que tus datos sean limpios, tipados y listos para usarse en el negocio.

Cómo se usa:

Validar datos extraídos:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))Ventajas:

- Validación estricta (detecta errores temprano)

- Conversión automática de tipos (strings a números, fechas, etc.)

- Modelos de datos declarativos (código claro y mantenible)

- Maneja datos complejos y anidados

Desventajas:

- Curva de aprendizaje para la sintaxis de modelos

- Añade algo de sobrecarga al pipeline

Ideal para:

Asegurar que tus datos extraídos sean limpios, consistentes y listos para análisis o importación ().

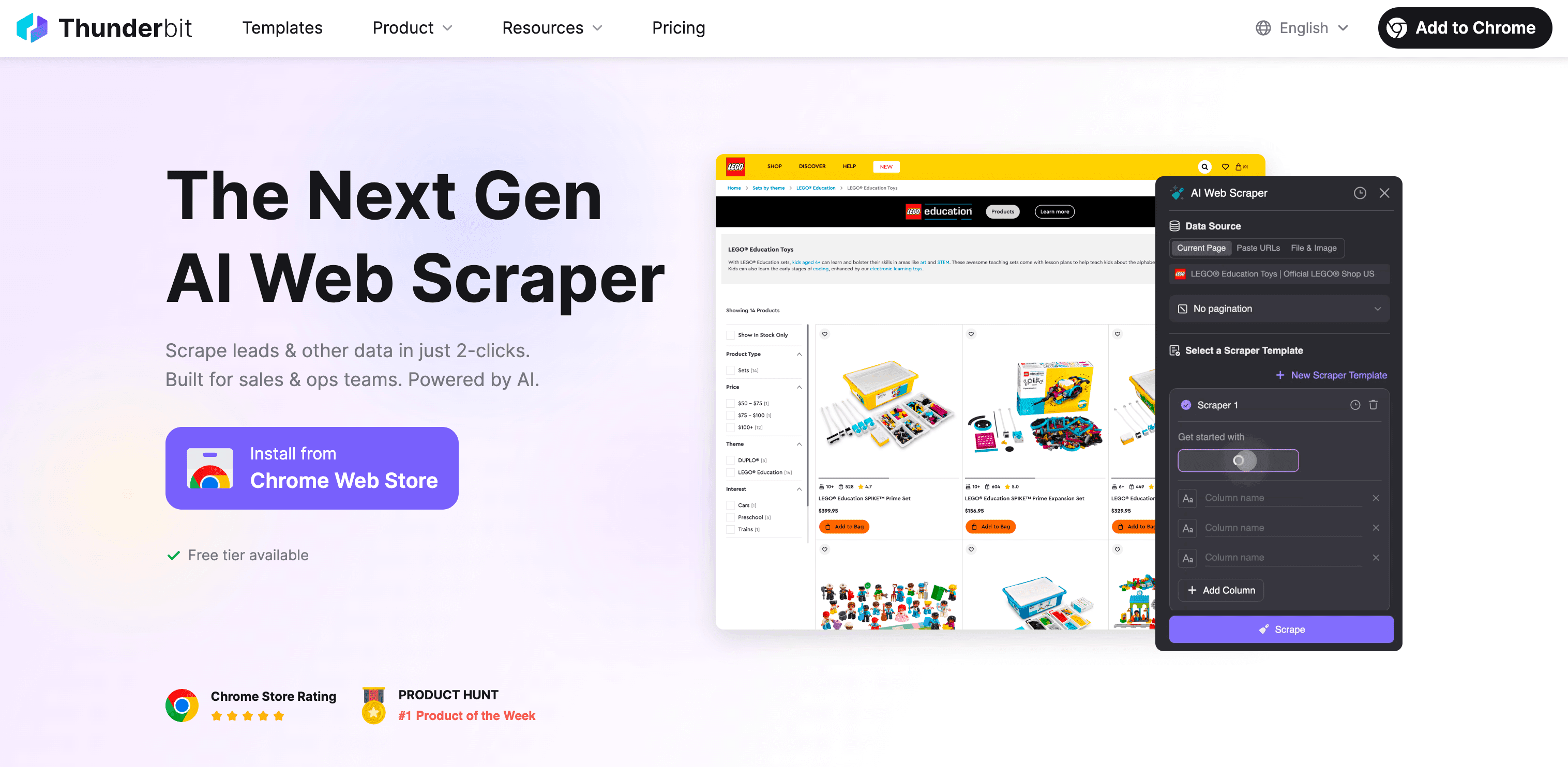

Alternativa sin código: Thunderbit Raspador Web IA para usuarios de negocio

Seamos sinceros. Si has llegado hasta aquí y sigues pensando: “Python es potente, pero no quiero pasarme el finde aprendiendo XPath”, no eres el único. Por eso creamos .

¿Qué es Thunderbit?

Thunderbit es una extensión de Chrome para web scraping sin código, potenciada por IA. Está pensada para usuarios de negocio—ventas, operaciones e-commerce, marketing, agentes inmobiliarios—que necesitan datos web pero no quieren pelearse con código, proxies o bloqueos anti-bot.

¿Por qué Thunderbit es mejor que las librerías de Python para quienes no programan?

- Sin programar: Solo haz clic en “AI Sugerir Campos”, deja que la IA de Thunderbit lea la página y pulsa “Raspar”. Así de fácil. Puedes extraer datos de cualquier web, PDF o imagen en dos clics.

- Maneja contenido dinámico: Al funcionar en tu navegador (o en la nube), Thunderbit puede extraer datos de sitios con JavaScript, scroll infinito o incluso detrás de logins.

- Scraping de subpáginas: ¿Necesitas detalles de cada producto o perfil? Thunderbit puede visitar cada subpágina y enriquecer tu tabla automáticamente.

- Estructuración de datos con IA: Thunderbit sugiere nombres de campos, tipos de datos e incluso prompts personalizados. Puedes etiquetar, formatear, traducir y organizar datos al instante.

- Resistente a bloqueos: No necesitas configurar proxies ni preocuparte por bloqueos—Thunderbit usa sesiones reales de navegador y IA para evitar la mayoría de obstáculos anti-scraping.

- Exporta donde quieras: Descarga tus datos a Excel, Google Sheets, Airtable, Notion, CSV o JSON—gratis y sin límites.

- Plantillas listas para usar: Para sitios populares (Amazon, Zillow, Instagram, Shopify, etc.), solo elige una plantilla y listo. Sin configuración.

- Funciones gratuitas: Los extractores de email, teléfono e imágenes son totalmente gratis. También el autocompletado IA para formularios online.

¿Cómo se compara con las librerías de Python?

| Funcionalidad | Librerías Python | Thunderbit |

|---|---|---|

| Requiere código | Sí | No |

| Contenido dinámico | A veces (con navegador) | Sí (navegador/nube) |

| Manejo anti-bot | Manual (proxies, headers) | Integrado (sesión navegador, IA) |

| Estructuración de datos | Manual (código, parseo) | Automático con IA |

| Scraping de subpáginas | Código personalizado | 1 clic |

| Opciones de exportación | CSV/JSON (código) | Excel, Google Sheets, Airtable, Notion, etc. |

| Plantillas | DIY o comunidad | Integradas para sitios populares |

| Mantenimiento | Tú (actualizas scripts) | El equipo de Thunderbit lo gestiona |

¿Para quién es Thunderbit?

Si trabajas en ventas, operaciones e-commerce, marketing o inmobiliaria y necesitas datos web—leads, precios, información de productos, listados de propiedades—pero no tienes perfil técnico, Thunderbit es para ti. Es la forma más rápida de pasar de “necesito estos datos” a “aquí tienes tu hoja de cálculo”, sin tocar Python.

¿Quieres verlo en acción? y pruébala gratis. O descubre más consejos en el .

Conclusión: ¿Qué librería de Python (o herramienta sin código) elegir para Web Scraping?

En resumen: las librerías de Python para web scraping son potentes, flexibles y pueden adaptarse a casi cualquier escenario—si te manejas con código y tienes tiempo para invertir. Repasemos:

- ZenRows: Perfecta para scraping masivo en sitios protegidos, con funciones anti-bot integradas.

- Selenium y Playwright: Ideales para sitios dinámicos e interactivos, aunque más complejos y pesados.

- Requests y HTTPX: Geniales para páginas estáticas y APIs; HTTPX destaca en scraping asíncrono y rápido.

- Beautiful Soup y lxml: Los clásicos para parsear HTML—BS4 para quienes empiezan, lxml para velocidad y potencia.

- Scrapy: El framework para crawling estructurado a gran escala.

- urllib3: Para necesidades HTTP personalizadas y alta concurrencia.

- Pydantic: Garantiza que tus datos extraídos sean limpios y listos para el negocio.

Pero si no eres programador—o simplemente quieres resultados rápidos— es tu atajo. Sin código, sin mantenimiento, solo resultados.

Mi consejo:

- Si te gusta Python y quieres control total, elige la librería que mejor se adapte a tu caso y nivel.

- Si solo quieres los datos (y dormir un poco más), deja que la IA de Thunderbit haga el trabajo duro.

En cualquier caso, la web está llena de datos esperando convertirse en insights. Seas un crack de Python o un usuario de negocio que no quiere programar, en 2025 hay una herramienta para ti. Y si alguna vez quieres charlar sobre scraping, automatización o la pizza favorita de los CEOs, ya sabes dónde encontrarme.

¡Feliz scraping!

Preguntas frecuentes

1. ¿Cuáles son las librerías de Python más populares para web scraping?

Algunas de las librerías más usadas son Requests para páginas estáticas, Selenium para sitios dinámicos con JavaScript y Scrapy para crawling a gran escala. La elección depende de la complejidad de los datos, la necesidad de concurrencia y el nivel de dinamismo del contenido.

2. ¿Cómo lidiar con sitios web que usan mucho JavaScript al hacer scraping?

Para sitios con mucho JavaScript, Selenium y Playwright son excelentes opciones. Permiten simular acciones de usuario y cargar contenido dinámico como si fueras un visitante real. ZenRows es otra alternativa, con una API sencilla que maneja JavaScript y esquiva mecanismos anti-bot sin configuración extra.

3. ¿Cómo puede ayudar Thunderbit a mi negocio con el web scraping?

Thunderbit es un raspador web IA sin código que permite a usuarios de negocio recolectar datos web sin programar. Ya sea para precios de la competencia, generación de leads o datos de productos, Thunderbit facilita el scraping con automatización IA, manejo de contenido dinámico, funciones anti-bot y opciones de exportación en solo dos clics.

Más información: