Imagina la escena: son las dos de la tarde un martes cualquiera, tu jefe te pide que le consigas una lista de precios de la competencia y tienes delante una web repleta de datos valiosos... pero todos escondidos entre líneas de HTML. ¿Te animas a programar un raspador web en Python? ¿O preferirías tener un botón mágico que lo hiciera todo por ti?

El web scraping ya no es solo cosa de frikis con sudadera o científicos de datos rodeados de pantallas. Hoy es una habilidad fundamental para equipos de ventas, marketing, investigación y cualquier persona que quiera transformar páginas web en hojas de cálculo. De hecho, el sector del web scraping está en pleno auge—valorado en y creciendo a toda velocidad. Pero con tantas opciones, elegir la herramienta adecuada puede ser como decidir entre una navaja suiza y un bisturí. Hoy vamos a comparar los dos pesos pesados de Python—Scrapy y Beautiful Soup—y veremos cómo soluciones sin código como pueden ser la alternativa perfecta para quienes prefieren no programar.

Scrapy vs. Beautiful Soup: Lo básico del web scraping en Python

Si alguna vez buscaste “python scraper” en Google, seguro que te topaste con Scrapy y Beautiful Soup. Ambos son referentes en el raspado web con Python, pero cada uno tiene su propio enfoque.

- Scrapy es un framework. Imagínalo como un set completo de electrodomésticos de cocina: se encarga de todo, desde descargar páginas, seguir enlaces, extraer datos y exportar resultados. Está pensado para grandes volúmenes—cientos o miles de páginas, gestión de peticiones y flujos de datos robustos.

- Beautiful Soup es una librería. Es como un cuchillo de chef bien afilado: perfecto para cortar y analizar HTML, pero tú tienes que poner los ingredientes (el HTML) y encargarte del resto (descargar, recorrer, guardar).

Ambos sirven para crear “raspadores web en Python”—scripts o programas que extraen datos de sitios web. Pero la elección no depende solo de las funciones, sino de tu proyecto y tu experiencia programando.

Cuándo usar Scrapy: Potencia y escalabilidad para proyectos de scraping

Supón que tienes que extraer datos de todo un ecommerce—miles de productos, actualizaciones frecuentes y, quizás, sortear bloqueos anti-bots. Aquí es donde Scrapy brilla.

Scrapy está hecho para scraping automatizado y a gran escala. Ofrece:

- Peticiones asíncronas: Descarga decenas de páginas a la vez, no una tras otra.

- Crawling integrado: Sigue enlaces, gestiona paginación y mantiene una cola de URLs automáticamente.

- Pipelines: Limpia, valida y exporta datos a CSV, JSON o bases de datos—sin código extra.

- Rotación de proxies y user-agent: Evita bloqueos básicos con middleware incluido.

- Programación de tareas: Ejecuta spiders de forma periódica para monitorizar o actualizar datos.

Si necesitas algo que funcione a diario, gestione errores y escale según crecen tus necesidades, Scrapy es como tener un equipo profesional en la cocina.

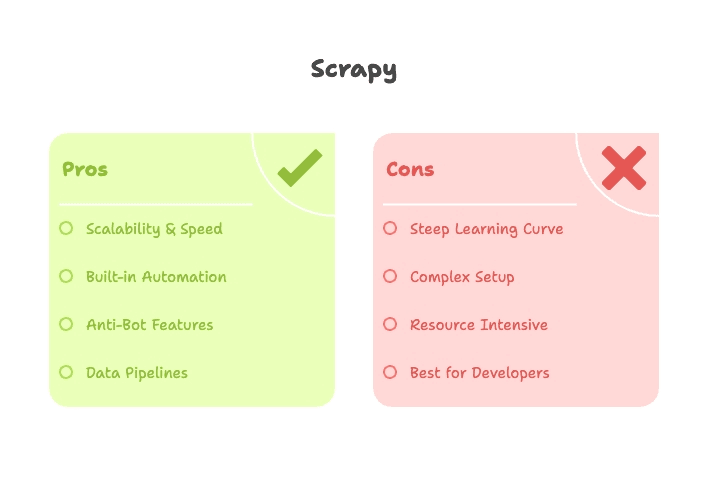

Ventajas de Scrapy para proyectos de scraping en Python

- Escalabilidad: Scrapy puede recorrer miles (o millones) de páginas gestionando concurrencia y memoria de forma eficiente ().

- Velocidad: Su motor asíncrono permite un alto rendimiento—ideal para grandes volúmenes ().

- Extensible: ¿Necesitas resolver CAPTCHAs, renderizar JavaScript o exportar a S3? Hay plugins y middlewares para eso.

- Automatización: Scrapy está pensado para scraping recurrente y en producción—lo configuras y te olvidas.

Limitaciones y curva de aprendizaje de Scrapy

Pero ojo: Scrapy no es precisamente para principiantes. Hay que aprender sobre spiders, pipelines, middlewares y la estructura de proyectos. Instalarlo puede ser complicado (hola, dependencias de Twisted) y depurar selectores sin entorno visual requiere paciencia.

- Curva de aprendizaje pronunciada: Prepárate para invertir varias horas (o días) en poner en marcha tu primer spider ().

- No es ideal para tareas pequeñas: Si solo quieres extraer una página, Scrapy puede ser excesivo.

- Sitios con mucho JavaScript: Scrapy por sí solo no ejecuta JavaScript—hay que integrarlo con Splash o Selenium para contenido dinámico.

Beautiful Soup: Rápido, flexible y fácil para quienes empiezan

Ahora imagina que solo quieres extraer los titulares de una página de noticias o una tabla de Wikipedia para un análisis puntual. Aquí Beautiful Soup es la mejor opción.

Beautiful Soup es una librería ligera para analizar HTML/XML. No descarga páginas—normalmente la combinas con la librería requests para obtener el HTML y luego usas Beautiful Soup para navegar y extraer los datos.

- Configuración mínima: Instala con pip, importa y listo.

- Curva de aprendizaje suave: Incluso si eres nuevo en Python, puedes obtener resultados en una o dos horas ().

- Análisis flexible: Busca por etiqueta, clase, ID o texto—ideal para HTML desordenado o irregular.

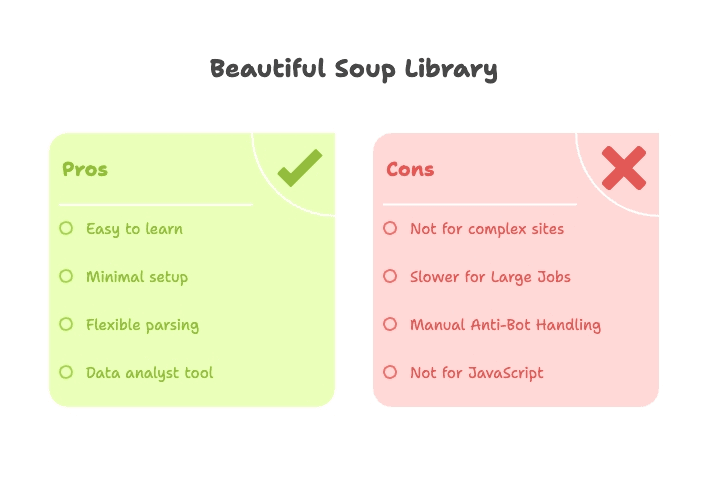

Ventajas de Beautiful Soup para quienes empiezan con scraping en Python

- Ideal para principiantes: No necesitas aprender un framework—solo Python básico y algo de HTML.

- Resultados rápidos: Perfecto para prototipos, proyectos académicos o extracciones puntuales.

- Flexible: Se integra fácilmente con otras librerías de Python (requests, pandas, etc.).

- Tolera HTML desordenado: Beautiful Soup es muy permisivo, incluso con código mal formado.

Limitaciones de Beautiful Soup

Pero Beautiful Soup no es una solución completa de scraping:

- Sin crawling integrado: Tienes que recorrer páginas o enlaces manualmente.

- Lento para grandes volúmenes: Trabaja de forma secuencial; extraer cientos de páginas puede ser lento.

- Pocas funciones anti-bot: Debes configurar headers o proxies manualmente y gestionar bloqueos por tu cuenta.

- No apto para contenido dinámico: Si el sitio depende de JavaScript, tendrás que usar Selenium o Playwright.

Scrapy vs. Beautiful Soup: Comparativa de funciones

Veámoslos cara a cara:

| Función | Scrapy | Beautiful Soup |

|---|---|---|

| Tipo | Framework (todo en uno) | Librería (solo parser) |

| Configuración | Estructura de proyecto, CLI, archivos de config | Script simple, pip install |

| Ideal para | Scraping a gran escala, recurrente, automatizado | Tareas pequeñas, prototipos, trabajos puntuales |

| Velocidad | Rápido a gran escala (async, concurrente) | Rápido en páginas sueltas, lento a gran escala |

| Crawling | Integrado (sigue enlaces, paginación) | Manual (escribes tus propios bucles) |

| Anti-bot | Proxies, rotación de user-agent, reintentos, plugins | Manual (headers, proxies en requests) |

| Extensible | Plugins, middlewares, pipelines | Combina con otras librerías Python |

| Curva de aprendizaje | Pronunciada (spiders, pipelines, async) | Suave (Python básico + HTML) |

| Contenido dinámico | Requiere plugins (Splash, Selenium) | Requiere Selenium/Playwright |

| Exportación de datos | CSV, JSON, BD (integrado) | Manual (escribir a archivo o usar pandas) |

| Perfil ideal | Desarrolladores, ingenieros de datos, proyectos continuos | Principiantes, analistas, scripts rápidos |

En resumen: Scrapy es tu aliado para scraping grande, complejo o recurrente—si te manejas bien con Python y frameworks. Beautiful Soup es perfecto para tareas pequeñas o si estás empezando.

Curva de aprendizaje: ¿Qué raspador web de Python es más sencillo para principiantes?

Seamos sinceros—nadie quiere pasarse una semana aprendiendo una herramienta solo para extraer una tabla de una web.

- Beautiful Soup: Puedes pasar de cero a scraping en una tarde. Solo necesitas Python básico y algo de HTML. Hay muchísimos tutoriales y verás resultados rápido ().

- Scrapy: Hay que aprender sobre spiders, pipelines, asincronía y herramientas de línea de comandos. No es ciencia de cohetes, pero sí más que un simple “hola mundo” ().

Si no eres técnico o solo quieres resultados rápidos, Beautiful Soup es una puerta de entrada más sencilla. Pero si planeas crear un raspador web que funcione a diario, gestione errores y escale, invertir tiempo en Scrapy merece la pena.

Rendimiento y anti-bot: Scrapy vs. Beautiful Soup en acción

Rendimiento:

- Scrapy: Gestiona concurrencia de serie. Puedes extraer 16, 32 o más páginas en paralelo, mucho más rápido para grandes volúmenes ().

- Beautiful Soup: Trabaja de forma secuencial salvo que añadas hilos o lógica async. Perfecto para pocas páginas, lento para muchas.

Anti-bot:

- Scrapy: Middleware para proxies, rotación de user-agent, reintentos e incluso plugins para resolver CAPTCHAs o renderizar JavaScript ().

- Beautiful Soup: Depende de ti. Puedes configurar headers o proxies en tus requests, pero no hay protección integrada. Si te bloquean, tendrás que buscar la solución por tu cuenta ().

Casos de uso habituales: Eligiendo el raspador web de Python según tu proyecto

Aquí tienes una guía rápida para elegir la herramienta adecuada:

| Caso de uso | Mejor herramienta | ¿Por qué? |

|---|---|---|

| Generación de leads (pocos datos) | Beautiful Soup | Extracción rápida y puntual de pocas páginas |

| Generación de leads (gran volumen/continuo) | Scrapy o Thunderbit | Scrapy para devs, Thunderbit para usuarios no técnicos—gestiona escala y automatización |

| Monitorización de precios ecommerce | Scrapy o Thunderbit | Scrapy para crawls personalizados y continuos; Thunderbit para scraping instantáneo y sin código |

| Seguimiento de noticias/contenido | Scrapy o Thunderbit | Scrapy para crawls programados en varios sitios; Thunderbit para usuarios de negocio y configuración rápida |

| Auditorías SEO (pocas páginas) | Beautiful Soup | Fácil de programar, resultados rápidos |

| Auditorías SEO (todo el sitio) | Scrapy | Recorre cientos de páginas y exporta datos estructurados |

| Scraping de redes sociales | Thunderbit | Plantillas predefinidas, gestiona contenido dinámico, sin necesidad de programar |

| Investigación académica (puntual) | Beautiful Soup | Prototipado rápido, configuración mínima |

| Enriquecimiento/agrupación de datos | Thunderbit | Enriquecimiento con IA, exportación sencilla a Sheets/Airtable |

Para la mayoría de usuarios de negocio, si no eres desarrollador, herramientas como marcan la diferencia (o mejor dicho... te ahorran un montón de tiempo).

Más allá de Python: Thunderbit para web scraping sin código

Vamos al grano: no todo el mundo quiere programar. Y, siendo sinceros, no deberías tener que hacerlo—sobre todo si solo quieres convertir una web en una hoja de cálculo, no lanzar un cohete a la luna.

Aquí es donde entra . Thunderbit es un raspador web IA sin código—una extensión de Chrome que te permite extraer datos de cualquier web en solo un par de clics. Así cambia las reglas del juego:

- Sin Python ni configuraciones: Instala la extensión, abre la página y listo.

- Sugerencia de campos con IA: Haz clic en “AI Suggest Fields” y Thunderbit lee la página, recomienda columnas y configura tu tabla automáticamente ().

- Scraping de subpáginas: ¿Necesitas detalles de páginas enlazadas? Thunderbit sigue los enlaces y enriquece tus datos—sin bucles anidados ni spiders ().

- Paginación y scroll infinito: Gestiona listados multipágina o scroll infinito con solo activar una opción.

- Exportación instantánea: Envía tus datos directamente a Google Sheets, Airtable, Notion o descárgalos como CSV/Excel ().

- Vista previa en tiempo real: Ve los resultados mientras extraes—adiós a programar “a ciegas”.

- Enriquecimiento con IA: Resume, categoriza o traduce datos al instante ().

Y sí, Thunderbit incluye plantillas predefinidas para sitios populares como Amazon, LinkedIn, Google Maps y más. Para la mayoría de necesidades de scraping empresarial, es lo más parecido a “solo pulsa el botón”.

¿Por qué elegir Thunderbit frente a herramientas de scraping en Python?

- Cero curva de aprendizaje: No necesitas saber Python, HTML ni cómo depurar un error 403. Si sabes usar un navegador, sabes usar Thunderbit.

- Rapidez: Pasa de “necesito estos datos” a “aquí tienes tu hoja de cálculo” en minutos, no en horas o días.

- Sin mantenimiento: La IA de Thunderbit se adapta a muchos cambios en los sitios y las plantillas se actualizan automáticamente. Olvídate de scripts que fallan de madrugada.

- Gestión anti-bot: Funciona en tu navegador (como un usuario real) o en la nube, con estrategias integradas para evitar bloqueos.

- Colaboración: Comparte plantillas y resultados con tu equipo, sin repositorios de código ni control de versiones.

- Asequible: Plan gratuito para tareas pequeñas y opciones de pago económicas para proyectos más grandes ().

Para ventas, marketing, operaciones o cualquiera que necesite datos ya, Thunderbit es un soplo de aire fresco. (Y como alguien que ha pasado demasiadas noches depurando scripts en Python, lo agradezco mucho).

¿Qué herramienta de web scraping elegir? Guía práctica

Entonces, ¿cuál deberías elegir? Aquí tienes una guía rápida:

- ¿Te sientes cómodo programando en Python?

- Sí: Pasa al paso 2.

- No: Usa u otra herramienta sin código.

- ¿Tu proyecto es pequeño (una página, puntual o prototipo)?

- Sí: Usa Beautiful Soup (con requests).

- No: Usa Scrapy para tareas grandes, recurrentes o complejas.

- ¿Necesitas gestionar anti-bots, concurrencia o automatización?

- Sí: Scrapy es tu aliado.

- No: Beautiful Soup es suficiente para tareas simples y de bajo riesgo.

- ¿Quieres resultados instantáneos, exportación fácil o colaboración en equipo?

- Sí: Thunderbit es la mejor opción—sin código ni complicaciones.

Aquí tienes un resumen:

| Tu necesidad | Mejor herramienta |

|---|---|

| Sin programar, resultados al instante | Thunderbit |

| Tarea pequeña, script puntual | Beautiful Soup |

| Scraping grande, automatizado y complejo | Scrapy |

| Recopilación de datos empresarial continua | Thunderbit o Scrapy |

| Prototipado académico | Beautiful Soup |

Conclusión: Scrapy, Beautiful Soup o Thunderbit—¿cuál es mejor para ti?

El web scraping es más accesible—y más necesario—que nunca. Ya seas desarrollador construyendo un pipeline robusto o usuario de negocio que solo quiere pasar una web a Excel, hay una herramienta para ti.

- Scrapy: Ideal para desarrolladores, scraping a gran escala, recurrente o complejo. Potente, pero con curva de aprendizaje.

- Beautiful Soup: Perfecto para principiantes, analistas o quienes necesitan extraer datos de unas pocas páginas. Sencillo, flexible y genial para prototipos.

- Thunderbit: La solución sin código y potenciada por IA para todos los demás. Si quieres evitar programar, depurar y mantener scripts, Thunderbit te permite extraer, enriquecer y exportar datos en minutos—directamente desde tu navegador.

Si quieres probar el scraping sin código, y pruébala. O visita nuestro para más guías, consejos y casos de uso.

Al final, la mejor herramienta es la que te da los datos que necesitas—sin convertir tu martes por la tarde en una maratón de depuración en Python. Y si alguna vez quieres compartir anécdotas de scraping, ya sabes dónde encontrarme.

Preguntas frecuentes

1. ¿Cuál es mejor para principiantes: Scrapy o Beautiful Soup?

Beautiful Soup es mucho más amigable para quienes empiezan. Es fácil de instalar, sencilla de entender e ideal para tareas pequeñas. Scrapy es potente pero tiene una curva de aprendizaje más pronunciada—mejor para desarrolladores que crean crawlers grandes o recurrentes.

2. ¿Puedo usar Scrapy o Beautiful Soup sin programar?

No realmente. Ambas requieren conocimientos de Python y algo de HTML. Si no te sientes cómodo escribiendo scripts, una herramienta sin código como es mejor opción—te permite extraer datos usando lenguaje natural, directamente en tu navegador.

3. ¿Necesito usar Scrapy y Beautiful Soup juntos?

En la mayoría de casos, no. Scrapy tiene su propio motor de análisis y funciona de forma independiente. Beautiful Soup suele usarse sola para tareas pequeñas. Usuarios avanzados a veces las combinan, pero rara vez es necesario—especialmente si buscas resultados rápidos y prácticos.

4. ¿Qué pasa si el sitio usa JavaScript o scroll infinito?

Ni Scrapy ni Beautiful Soup pueden manejar JavaScript de serie—tendrás que integrar herramientas como Selenium. gestiona muchos sitios modernos automáticamente, incluidos los de scroll infinito o contenido dinámico.

5. Solo quiero pasar una web a una hoja de cálculo. ¿De verdad tengo que aprender Python?

No. Si tu objetivo es obtener datos estructurados rápidamente—como una lista de precios o un directorio en Excel—aprender Scrapy o Beautiful Soup suele ser excesivo. lo hace en dos clics, sin escribir ni una línea de código.

¿Quieres saber más? Echa un vistazo a , , o explora más en el .