Déjame contarte cómo fue la primera vez que intenté sacar datos de productos de una tienda online. Tenía Python, una taza de café y la ilusión de montar un rastreador de precios para Amazon. Unas horas después, ese “proyecto rápido” se había convertido en un lío de selectores XPath, problemas con la paginación y más horas de depuración de las que me gustaría reconocer. Si alguna vez has intentado conseguir datos de la web con código, seguro que conoces esa mezcla de emoción y frustración: “¿por qué es tan complicado?”

La verdad es que el web scraping ya no es solo cosa de ingenieros o científicos de datos. Hoy es una habilidad clave para equipos de ventas, responsables de ecommerce, marketers y cualquiera que quiera convertir el caos de la web en información útil para el negocio. De hecho, el mercado de software para web scraping llegó a los , y sigue creciendo. Aunque Python y frameworks como Scrapy siguen siendo la referencia para proyectos grandes y a medida, no son precisamente sencillos para quienes empiezan. Por eso, en este tutorial te voy a guiar paso a paso con Scrapy usando un caso real de Amazon, y te voy a mostrar una alternativa mucho más fácil y con IA para quienes no programan: .

¿Qué es Scrapy Python? Tu herramienta potente para el Web Scraping

Vamos a lo básico. Scrapy es un framework open-source de Python creado justo para rastrear y extraer datos de páginas web. Piénsalo como un kit completo para construir “arañas” (así llama Scrapy a sus rastreadores) capaces de navegar por páginas, seguir enlaces, manejar paginación y sacar datos estructurados a gran escala.

¿En qué se diferencia Scrapy de usar solo requests y BeautifulSoup? Esas librerías van bien para extracciones simples y puntuales, pero Scrapy está pensado para proyectos grandes y complejos, donde necesitas:

- Rastrear miles de páginas (por ejemplo, todo el catálogo de una tienda online)

- Seguir enlaces y manejar la paginación automáticamente

- Procesar datos de forma asíncrona para ir más rápido

- Estructurar, limpiar y exportar datos de manera repetible

En resumen, Scrapy es como la navaja suiza del web scraping: potente, flexible y (para quien empieza) un poco intimidante.

¿Por qué usar Scrapy Python para Web Scraping?

Entonces, ¿por qué tantos desarrolladores y equipos de datos eligen Scrapy? Aquí tienes un resumen de sus ventajas:

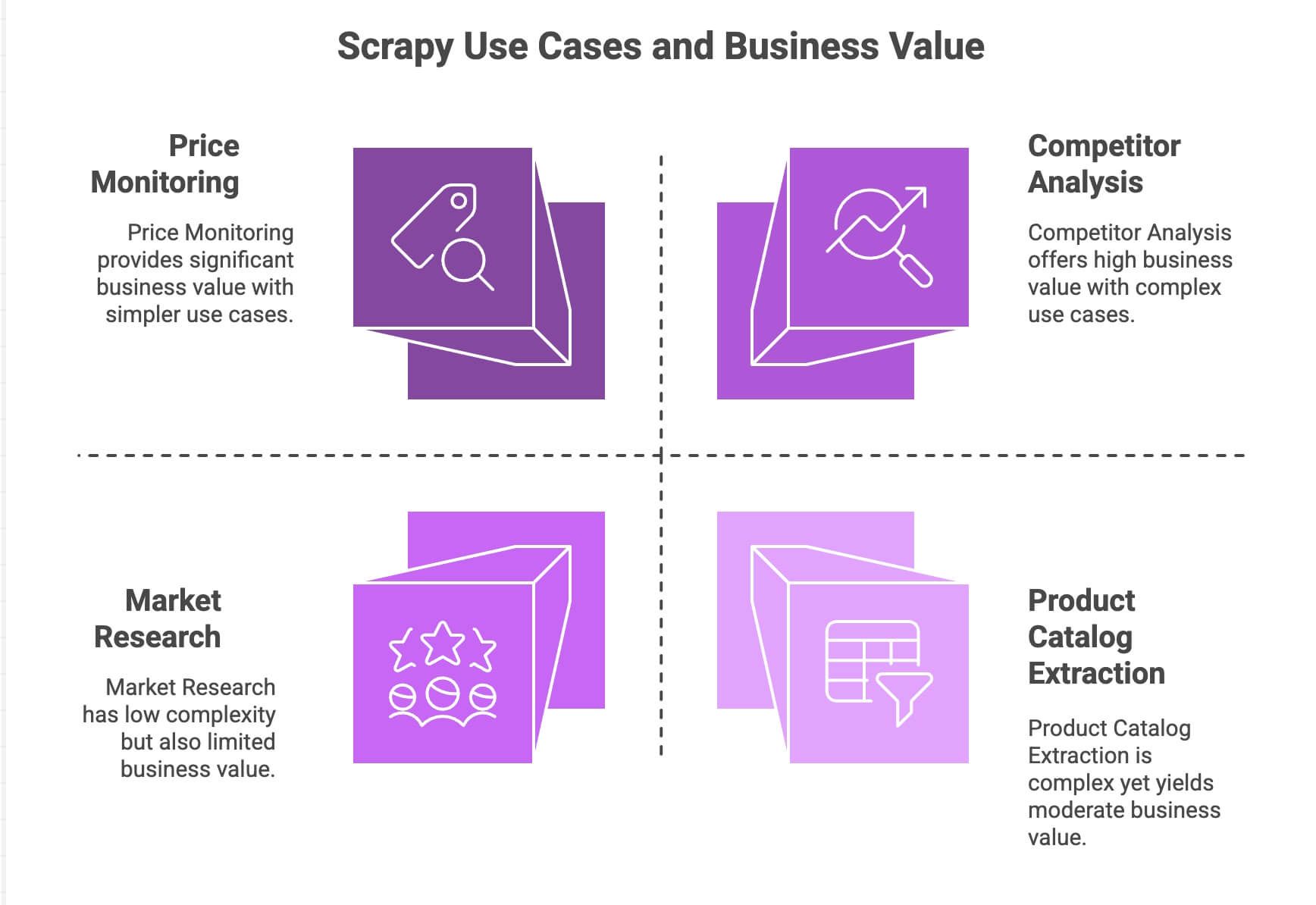

| Caso de uso | Fortalezas de Scrapy | Valor para el negocio |

|---|---|---|

| Monitoreo de precios | Maneja paginación, peticiones asíncronas, programación de tareas | Mantente por delante de la competencia, precios dinámicos |

| Extracción de catálogos de productos | Sigue enlaces, extrae datos estructurados | Construye bases de datos de productos, alimenta analíticas |

| Análisis de la competencia | Escalable, resistente a cambios en el sitio | Detecta tendencias, lanzamientos, niveles de stock |

| Investigación de mercado | Pipelines modulares para limpiar/transformar datos | Agrupa reseñas, realiza análisis de sentimiento |

El motor asíncrono de Scrapy (basado en Twisted) le permite sacar varias páginas a la vez, lo que lo hace rápido y escalable. Su diseño modular te deja añadir lógica personalizada (como proxies, user-agents o pasos de limpieza de datos). Y con los pipelines, puedes procesar, validar y exportar los datos como prefieras: CSV, JSON, bases de datos, etc.

Para equipos con experiencia en Python, Scrapy es una herramienta muy potente. Pero seamos sinceros: para el usuario de negocio promedio, no es precisamente “enchufar y listo”.

Cómo preparar tu entorno de Scrapy Python

¿Listo para ponerte manos a la obra? Así puedes instalar Scrapy desde cero:

1. Instala Scrapy

Primero, asegúrate de tener Python 3.9 o superior. Luego, abre la terminal y ejecuta:

1pip install scrapyVerifica la instalación con:

1scrapy versionSi usas Windows o Anaconda, te conviene crear un entorno virtual para evitar líos. Scrapy funciona en Windows, macOS y Linux.

2. Crea un nuevo proyecto Scrapy

Vamos a crear un proyecto llamado amazonscraper:

1scrapy startproject amazonscraperVas a ver una estructura de carpetas como esta:

1amazonscraper/

2├── scrapy.cfg

3├── amazonscraper/

4│ ├── __init__.py

5│ ├── items.py

6│ ├── pipelines.py

7│ ├── middlewares.py

8│ ├── settings.py

9│ └── spiders/¿Para qué sirve cada archivo?

scrapy.cfg: Configuración general del proyecto (casi nunca lo tocas)items.py: Define los modelos de datos (por ejemplo, Producto con nombre, precio, etc.)pipelines.py: Aquí limpias, validas y exportas los datosmiddlewares.py: Temas avanzados (proxies, cabeceras personalizadas)settings.py: Ajusta el comportamiento de Scrapy (concurrencia, retrasos, etc.)spiders/: Donde va la lógica de scraping

Si ya te sientes un poco perdido, tranquilo, no eres el único. Aquí es donde muchos que no programan empiezan a sudar.

Construyendo un Python Scraper: Extrayendo datos de productos de Amazon con Scrapy

Vamos a ver un ejemplo real: extraer datos de productos de los resultados de búsqueda de Amazon. (Ojo: los términos de Amazon no permiten scraping y tienen fuertes medidas anti-bots. Esto es solo educativo).

1. Crea una araña (spider)

Dentro de la carpeta spiders/, crea un archivo llamado amazon_spider.py:

1import scrapy

2class AmazonSpider(scrapy.Spider):

3 name = "amazon_example"

4 allowed_domains = ["amazon.com"]

5 start_urls = ["https://www.amazon.com/s?k=smartphones"]

6 def parse(self, response):

7 products = response.xpath("//div[@data-component-type='s-search-result']")

8 for product in products:

9 yield {

10 'name': product.xpath(".//span[@class='a-size-medium a-color-base a-text-normal']/text()").get(),

11 'price': product.xpath(".//span[@class='a-price-whole']/text()").get(),

12 'rating': product.xpath(".//span[@aria-label]/text()").get()

13 }

14 next_page = response.xpath("//li[@class='a-last']/a/@href").get()

15 if next_page:

16 yield scrapy.Request(url=response.urljoin(next_page), callback=self.parse)¿Qué hace este código?

- Empieza en una página de resultados de Amazon para “smartphones”.

- Por cada producto, saca nombre, precio y valoración usando selectores XPath.

- Busca el enlace a la “siguiente página” y le dice a Scrapy que lo siga para seguir extrayendo productos.

2. Ejecuta tu araña

Desde la raíz del proyecto, ejecuta:

1scrapy crawl amazon_example -o products.jsonListo: Scrapy recorrerá los resultados, seguirá la paginación y guardará los datos en un archivo JSON.

Cómo manejar paginación y contenido dinámico

Scrapy facilita seguir enlaces y manejar la paginación. Pero, ¿qué pasa con el contenido dinámico, como páginas que cargan datos con JavaScript? De forma nativa, Scrapy solo ve el HTML estático. Si necesitas extraer datos cargados por JavaScript (scroll infinito, pop-ups de reseñas, etc.), tendrás que integrar herramientas como Selenium o Splash. Eso ya es otro rollo.

Procesar y exportar datos con Scrapy Python

Una vez que tienes los datos, seguramente querrás limpiarlos y exportarlos a algún sitio útil.

- Pipelines: En

pipelines.pypuedes crear clases en Python para limpiar, validar o enriquecer los datos (por ejemplo, convertir precios a números, eliminar filas incompletas o traducir textos usando una API). - Exportar: Scrapy puede exportar directamente a CSV, JSON o XML usando el flag

-o. Para exportaciones más avanzadas (como enviar a Google Sheets), tendrás que programar o usar librerías externas.

¿Quieres hacer análisis de sentimiento o traducir descripciones? Tendrás que integrar APIs o librerías de Python externas; no viene de serie.

Los costes ocultos: Retos de Scrapy Python para usuarios de negocio

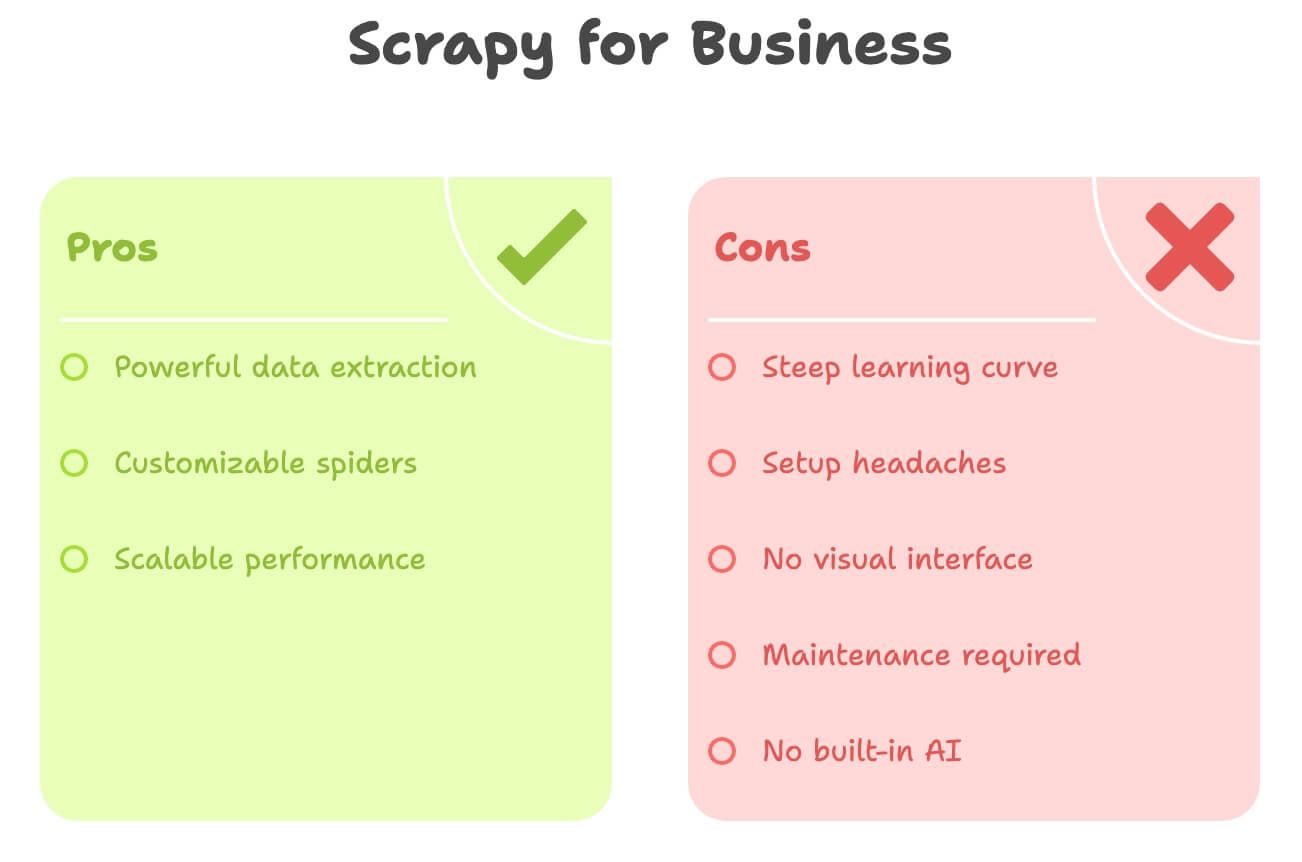

Seamos claros: Scrapy es potente, pero no es nada amigable para quienes no programan. Estos son los principales obstáculos:

- Curva de aprendizaje pronunciada: Debes saber Python, HTML, selectores XPath/CSS y la estructura de Scrapy. Puede llevar días o semanas pillarle el truco.

- Problemas de instalación: Instalar Python, gestionar dependencias y resolver errores puede ser un dolor de cabeza, sobre todo en Windows.

- Sin interfaz visual: Todo es código. No puedes simplemente “hacer clic” para seleccionar datos.

- Mantenimiento: Si la web cambia, tu araña se rompe. Te toca arreglarla.

- Sin IA integrada: ¿Quieres traducir, resumir o analizar sentimiento? Todo requiere código extra.

Aquí tienes una comparación rápida:

| Desafío | Scrapy (Python) | Necesidades del usuario de negocio |

|---|---|---|

| ¿Requiere código? | Sí | Prefiere sin código |

| Tiempo de configuración | Horas (o días) | Minutos |

| Mantenimiento | Constante (cambios en el sitio) | Mínimo |

| Exportación de datos | CSV/JSON (integración manual) | Directo a Excel/Sheets/Notion |

| Funciones de IA | Ninguna (integración manual) | Traducción/análisis de sentimiento integrados |

Si eres marketer, comercial o responsable de operaciones, Scrapy puede sentirse como usar un cañón para matar moscas.

Conoce Thunderbit: la alternativa sin código a Scrapy Python

Aquí es donde entra . Tras años creando herramientas de automatización, te lo digo claro: la mayoría de usuarios de negocio no quiere programar, solo quiere los datos, rápido.

Thunderbit es un Raspador Web IA en forma de extensión de Chrome. Está pensado para usuarios no técnicos que quieren:

- Extraer datos de cualquier web en pocos clics

- Describir lo que buscan en lenguaje natural (“Nombre del producto, Precio, Valoración”)

- Manejar paginación y subpáginas automáticamente

- Exportar datos directo a Excel, Google Sheets, Airtable o Notion

- Traducir, resumir o analizar sentimiento al instante

Sin Python. Sin selectores. Sin dolores de cabeza por mantenimiento.

Thunderbit está pensado para quienes quieren ir rápido y dejar el trabajo pesado a la IA.

Thunderbit vs. Scrapy Python: Comparativa directa

Veamos una comparación punto por punto:

| Aspecto | Scrapy (Python) | Thunderbit (Herramienta IA) |

|---|---|---|

| Habilidad necesaria | Python, HTML, selectores | Ninguna: solo clics y lenguaje natural |

| Tiempo de configuración | Horas (instalar, programar, depurar) | Minutos (instalar extensión, iniciar sesión) |

| Estructuración de datos | Manual (definir items, pipelines) | IA detecta columnas y sugiere campos |

| Paginación/subpáginas | Requiere código | 1 clic (la IA lo gestiona) |

| Traducción | Código propio o integración API | Integrado: solo activa “Traducir” |

| Análisis de sentimiento | Librería/API externa | Integrado: añade columna “Sentimiento” |

| Opciones de exportación | CSV/JSON (importación manual) | 1 clic a Excel, Google Sheets, Airtable, Notion |

| Mantenimiento | Manual (actualizar código si cambia el sitio) | La IA se adapta automáticamente a cambios menores |

| Escalabilidad | Ideal para proyectos grandes y continuos | Perfecto para tareas rápidas y escala moderada (cientos/miles de filas) |

| Coste | Gratis (pero consume tiempo/recursos de desarrollo) | Plan gratuito + opciones de pago (desde $9/mes, ahorra mucho tiempo y esfuerzo) |

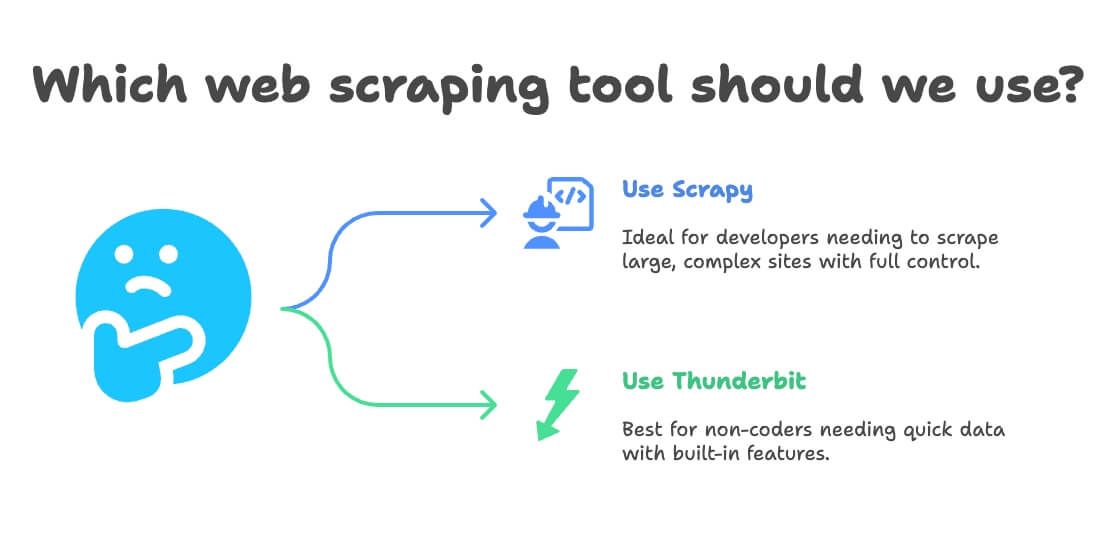

¿Cuándo elegir Scrapy Python o Thunderbit para Web Scraping?

Mi consejo:

- Usa Scrapy si:

- Eres desarrollador o tienes uno en tu equipo

- Necesitas extraer decenas de miles de páginas o crear un pipeline personalizado y recurrente

- El sitio es muy complejo o requiere lógica avanzada

- Quieres control total (y no te importa el mantenimiento)

- Usa Thunderbit si:

- No programas (o no quieres hacerlo)

- Necesitas datos rápido, para una tarea puntual o recurrente de negocio

- Quieres traducción, análisis de sentimiento o enriquecimiento de datos integrados

- Valorás la rapidez y flexibilidad más que la personalización total

Aquí tienes un pequeño diagrama de decisión:

- ¿Sabes programar en Python?

- Sí → Scrapy o Thunderbit (para tareas rápidas)

- No → Thunderbit

- ¿Tu proyecto es grande y continuo?

- Sí → Scrapy

- No → Thunderbit

- ¿Necesitas traducción o análisis de sentimiento?

- Sí → Thunderbit

- No → Cualquiera de los dos

Paso a paso: Extraer datos de productos de Amazon con Thunderbit (sin código)

Vamos a repetir el ejemplo de Amazon, pero de la forma sencilla.

1. Instala Thunderbit

- Regístrate (hay plan gratuito)

2. Ve a Amazon y busca tu producto

- Abre y busca “laptops” (o cualquier producto)

3. Lanza Thunderbit en la página

- Haz clic en el icono de Thunderbit en tu navegador

- Se abrirá el panel lateral, reconociendo la página de Amazon

4. Usa la función de IA para sugerir campos

- Haz clic en “IA Sugerir Campos”

- La IA de Thunderbit escaneará la página y sugerirá columnas como “Nombre del producto”, “Precio”, “Valoración”, “Número de reseñas”

- Añade o elimina columnas según necesites (¿quieres “URL del producto” o “Prime”? Solo escríbelo)

5. Activa paginación y extracción de subpáginas

- Activa Paginación: Thunderbit hará clic en “Siguiente” y extraerá todas las páginas

- Activa Extracción de subpáginas: Thunderbit visitará cada página de producto y extraerá información extra (como descripciones o número ASIN)

6. Ejecuta la extracción

- Haz clic en Extraer

- Verás cómo Thunderbit recopila los datos en tiempo real, página a página

7. Traduce y analiza sentimiento (opcional)

- ¿Quieres traducir descripciones? Activa “Traducir” en esa columna

- ¿Quieres analizar sentimiento en reseñas? Añade la columna “Sentimiento” y la IA de Thunderbit lo hará automáticamente

8. Exporta tus datos

- Haz clic en Exportar

- Elige Excel, Google Sheets, Airtable o Notion

- Tus datos estarán listos para usar, sin importar ni manipular CSVs

9. Programa extracciones recurrentes (opcional)

- Configura una programación (por ejemplo, cada día a las 8am)

- Thunderbit ejecutará la extracción automáticamente y actualizará tu destino elegido

Eso es todo. Sin código, sin selectores, sin mantenimiento. Solo datos listos para tu negocio.

Consejos extra: Sácale más partido a tus proyectos de Web Scraping

Ya uses Scrapy, Thunderbit u otra herramienta, aquí tienes algunos consejos que aprendí a base de experiencia:

- Valida tus datos: Revisa siempre si hay valores faltantes o extraños (como precios en $0 o nombres vacíos)

- Cumple las normas: Consulta los términos de uso del sitio, respeta el

robots.txty no sobrecargues los servidores - Automatiza con cabeza: Programa extracciones para mantener los datos frescos, pero no extraigas más de lo necesario

- Aprovecha herramientas gratuitas: Thunderbit incluye extractores gratuitos de emails, teléfonos e imágenes, ideales para generación de leads o curación de contenido

- Organiza para analizar: Exporta directo a Sheets/Excel para filtrar, hacer tablas dinámicas y visualizar rápido

Para más consejos, visita el o su .

Para más consejos, visita el o su .

Conclusión: Web Scraping fácil—elige la herramienta adecuada para tu equipo

En resumen: Scrapy es una herramienta muy potente para desarrolladores, pero suele ser excesiva para la mayoría de usuarios de negocio. Si te manejas con Python y necesitas un scraper personalizado y a gran escala, Scrapy es una gran opción. Pero si quieres ir rápido, sin programar, y obtener datos (con traducción y análisis de sentimiento incluidos), es la mejor alternativa.

He visto de primera mano cuánto tiempo y frustración ahorra Thunderbit a equipos no técnicos. Puedes pasar de “ojalá tuviera estos datos” a “ya están en mi hoja de cálculo” en minutos, no en horas o días. Y con funciones como IA Sugerir Campos, extracción de subpáginas y exportación en un clic, nunca ha sido tan fácil convertir la web en inteligencia de negocio.

Así que, la próxima vez que necesites extraer datos de productos, monitorizar precios o crear una lista de leads, pregúntate: ¿quieres escribir Python o quieres resultados? Prueba el plan gratuito de Thunderbit y descubre lo sencillo que puede ser el web scraping.

¿Quieres saber más? Visita el , o explora las mejores prácticas de web scraping en el .

Lecturas recomendadas:

Aviso legal: Asegúrate siempre de que tus actividades de web scraping cumplen con los términos del sitio y la legislación local. Si tienes dudas, consulta con un abogado; nadie quiere recibir una carta de cese y desista por una hoja de cálculo.

Escrito por Shuai Guan, Cofundador y CEO de Thunderbit. Llevo años en SaaS, automatización e IA—para que tú no tengas que hacerlo.