¿Alguna vez te has quedado mirando una página web y has pensado lo genial que sería volcar toda esa info en una hoja de cálculo, sin tener que pasarte horas copiando y pegando? Créeme, no eres el único. Ya en 2025, extraer datos de la web dejó de ser solo cosa de programadores: ahora es una herramienta clave para cualquier negocio. Desde equipos de ventas que arman listas de prospectos hasta encargados de ecommerce que vigilan los precios de la competencia, todos quieren datos web, y los quieren ¡ya! ¿La buena noticia? Python hace que extraer datos sea no solo posible, sino sorprendentemente fácil, incluso si lo último que programaste fue tu perfil de MySpace.

En este tutorial te voy a mostrar, paso a paso, cómo extraer datos usando Python. Vamos a ver lo básico, cómo enfrentarte a sitios estáticos y dinámicos, y cómo puedes llevar tu flujo de trabajo al siguiente nivel combinando Python con , nuestro Raspador Web IA. Tanto si eres nuevo en esto como si ya tienes algo de experiencia, aquí vas a encontrar consejos prácticos, ejemplos de código reales y algunos trucos que he aprendido tras años metido en SaaS y automatización.

¿Qué es la extracción de datos web y por qué usar Python?

Vamos a lo esencial. La extracción de datos web es básicamente enseñarle a tu compu a “leer” una web y sacar justo lo que te interesa—precios, titulares, contactos—para que no tengas que hacerlo a mano (). Las empresas lo usan para todo: monitorear a la competencia en tiempo real, hacer estudios de mercado, generar leads o hasta entrenar modelos de IA ().

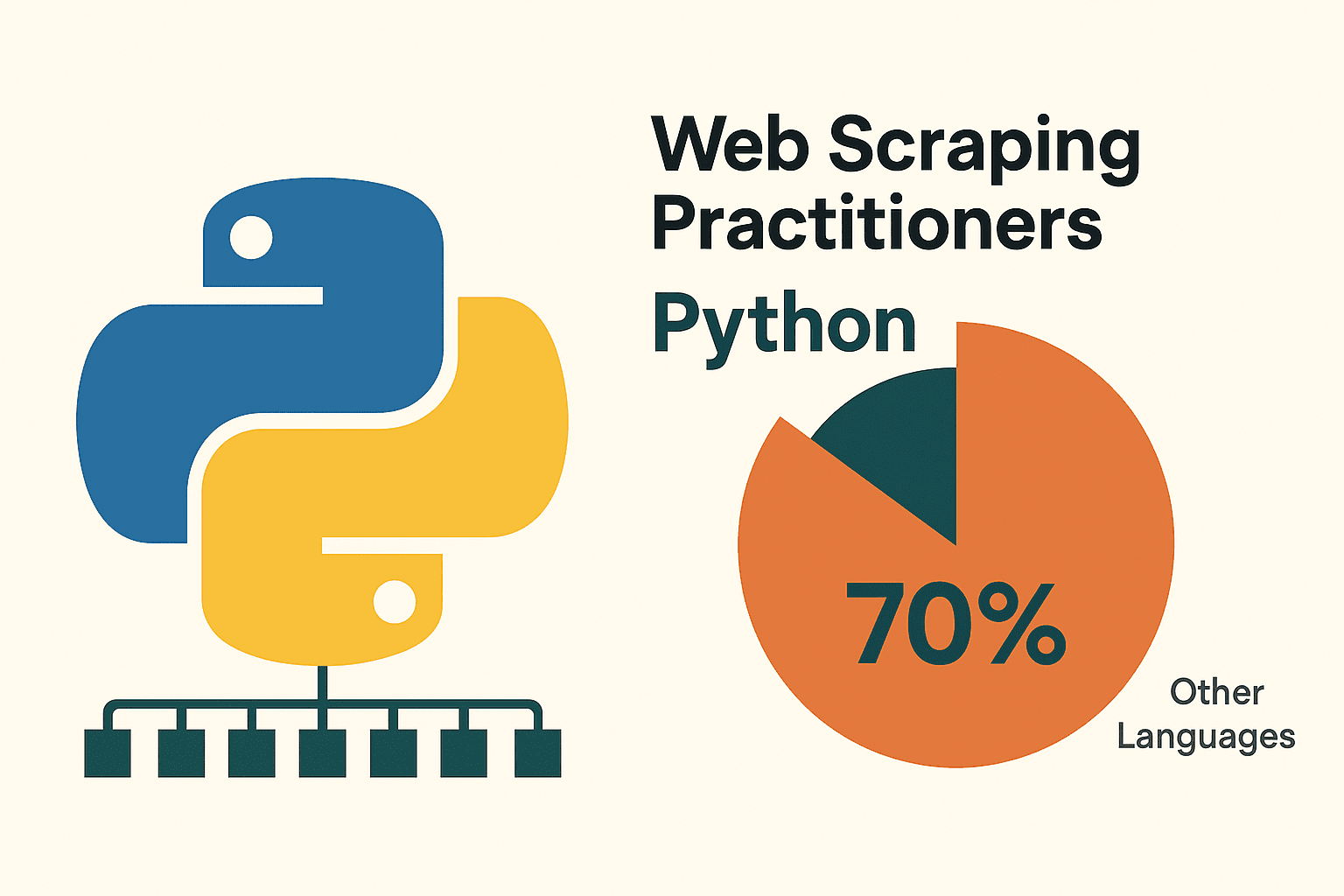

¿Y por qué Python es el favorito para extraer datos? Primero, porque es fácil de entender—su sintaxis es casi como leer inglés, ideal si apenas estás empezando. Pero lo que realmente lo hace imbatible es su ecosistema: librerías como requests, BeautifulSoup, Scrapy, Selenium y pandas cubren todo el proceso, desde descargar páginas hasta analizar el HTML y exportar los datos limpios. No es casualidad que casi el , muy por delante de otros lenguajes.

¿Por qué elegir Python para extraer datos web?

He probado varios lenguajes a lo largo de los años, pero Python siempre sale ganando cuando se trata de extraer datos web—sobre todo si estás empezando. Aquí te cuento por qué:

- Simplicidad y legibilidad: La sintaxis de Python es clara y directa, así que escribir y depurar scripts es pan comido ().

- Montón de librerías: Herramientas como requests (para HTTP), BeautifulSoup (para analizar HTML), Scrapy (para scraping a gran escala), Selenium (para automatizar el navegador) y pandas (para análisis de datos) cubren cada paso ().

- Comunidad gigante: Si te atoras, seguro que alguien ya resolvió el problema y lo compartió online.

¿Y cómo se compara Python con otras opciones? Mira esta tabla rápida:

| Enfoque | Ventajas | Desventajas |

|---|---|---|

| Python | Fácil de aprender, gran ecosistema de librerías, ideal para análisis de datos, versátil | Requiere algo de programación, necesita herramientas extra para webs con mucho JavaScript |

| JavaScript/Node | Maneja contenido dinámico de forma nativa, asincrónico, mismo lenguaje que el front-end web | Curva de aprendizaje más pronunciada, menos librerías específicas para scraping, más verboso para principiantes |

| R (rvest) | Útil para extracción rápida en investigación, se integra con el análisis de R | Ecosistema de scraping más pequeño, menos robusto para sitios dinámicos |

| Herramientas No-Code | No necesitas programar, configuración rápida, asistentes visuales/IA (como Thunderbit) | Flexibilidad limitada para lógica personalizada, límites de uso, menos control |

(, )

Para la mayoría de quienes trabajan con datos o negocios, Python es la mejor opción: potente, flexible y nada intimidante.

Cómo preparar tu entorno Python para extraer datos

Antes de lanzarte a extraer datos, tienes que preparar tu entorno Python. Tranquilo, es más fácil que armar un mueble de IKEA (y con menos piezas sobrantes).

1. Instala Python:

Descarga la última versión de Python 3 desde . Si usas Windows, marca la opción “Add Python to PATH” durante la instalación. En Mac, puedes usar Homebrew (brew install python3). Si tienes Linux, probablemente ya lo tienes, pero apt install python3 python3-pip te sirve ().

2. (Recomendado) Crea un entorno virtual:

Así mantienes las librerías de tu proyecto separadas. En la carpeta de tu proyecto:

1python -m venv venv

2# Actívalo:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. Instala las librerías esenciales:

Abre la terminal y ejecuta:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests: Para hacer peticiones HTTPbeautifulsoup4: Para analizar HTMLpandas: Para manipular/exportar datosselenium: Para sitios dinámicos (opcional)lxml: Análisis rápido de HTML/XML

4. Elige un editor de código:

- (con extensión de Python): Ligero, popular y fácil para quienes empiezan.

- : Súper completo y especializado en Python.

- : Interactivo, ideal para experimentar y analizar datos ().

5. (Para Selenium) Instala un WebDriver:

Selenium necesita un driver de navegador (por ejemplo, ChromeDriver). Lo más fácil es usar webdriver_manager:

1pip install webdriver-managerLuego en tu script:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))Tip: Si pip no se reconoce, asegúrate de que Python está en tu PATH y el entorno virtual está activado.

Extrayendo datos de sitios estáticos con Python: paso a paso

Las webs estáticas son el mejor punto de partida. Si puedes ver los datos en el “Ver código fuente” de tu navegador, puedes extraerlos con Python.

Vamos a practicar con , un clásico para aprender.

Paso 1: Descarga la página

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200 significa OKPaso 2: Analiza el HTML

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")Paso 3: Extrae los datos

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")Paso 4: Maneja la paginación

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)Y así de fácil, ya tienes varias páginas extraídas y los datos guardados en un CSV. Nada mal para unas cuantas líneas de código, ¿no? ()

Tip: Revisa siempre el robots.txt y los términos de uso del sitio antes de extraer datos. Y sé buena onda: no satures el servidor con peticiones rápidas. Un pequeño time.sleep(1) entre peticiones es buena práctica.

Extrayendo datos de sitios dinámicos: usando Selenium con Python

Algunas webs son más rebuscadas. Si los datos aparecen solo después de que se ejecute JavaScript (scroll infinito, pop-ups, dashboards dinámicos), necesitas una herramienta que actúe como un navegador real. Aquí entra Selenium.

Paso 1: Abre el navegador

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")Paso 2: Espera a que cargue el contenido

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)Paso 3: Haz scroll o clic para cargar más

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightPaso 4: Extrae los datos

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})Paso 5: Guarda y cierra

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()Tips:

- Usa esperas explícitas (

WebDriverWait) para evitar errores si los elementos aún no han cargado (). - Para modo sin ventana (headless), añade

options.headless = Truea las opciones de Chrome. - Si encuentras un endpoint de API JSON en el tráfico de red, puedes saltarte Selenium y usar

requests—¡mucho más rápido!

Combinando Thunderbit y Python para flujos de trabajo avanzados

Aquí es donde la cosa se pone buena. A veces, incluso con las librerías de Python, extraer datos de un sitio complicado puede ser un dolor de cabeza. Ahí es donde entra .

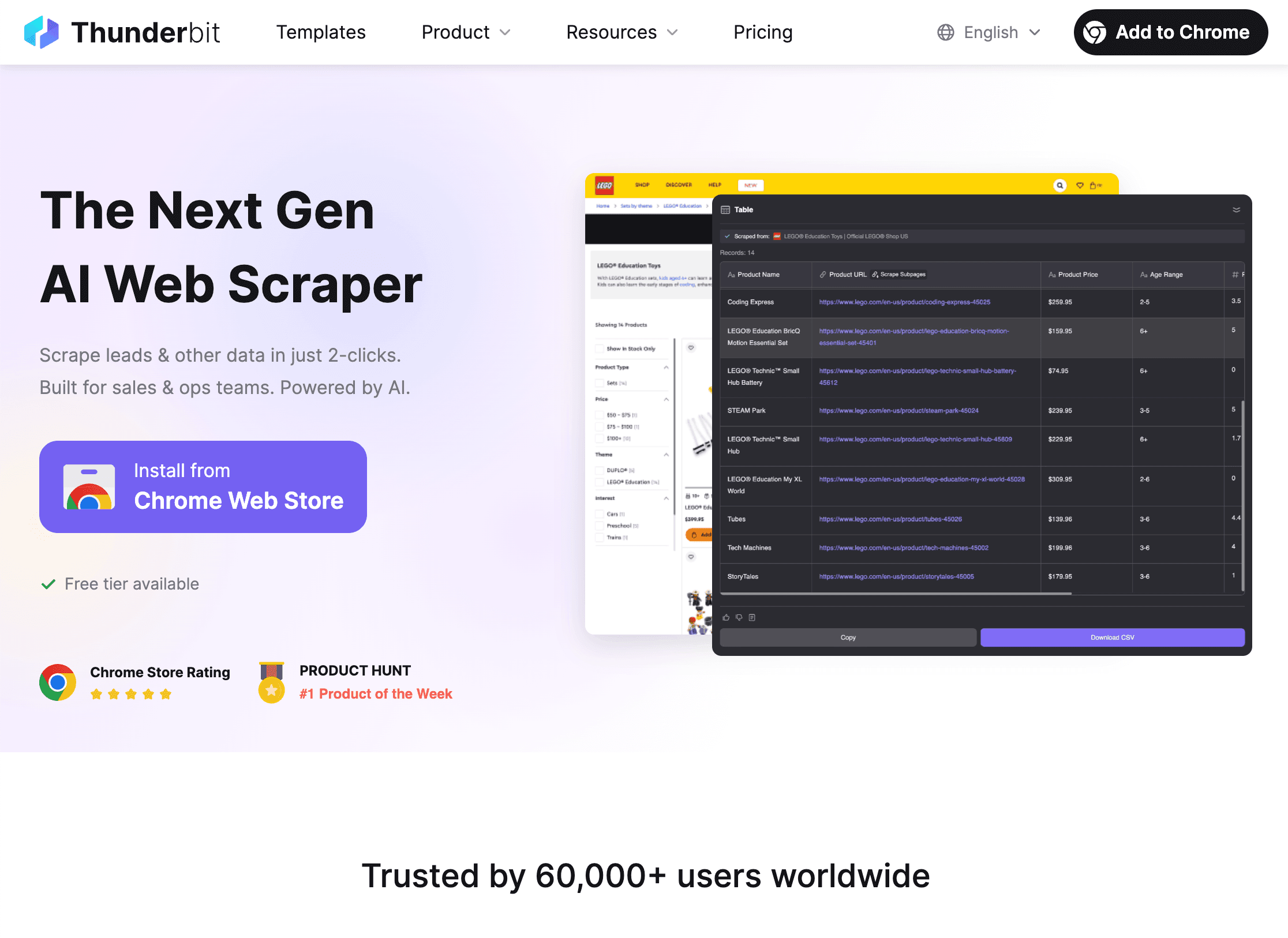

Thunderbit es una extensión de Chrome con IA que te permite seleccionar y extraer datos de cualquier web—sin programar. Es ideal para quienes necesitan datos ya, pero también se integra perfecto con Python para flujos de trabajo más avanzados.

¿Cómo potencian tu flujo Thunderbit + Python?

¿Cómo potencian tu flujo Thunderbit + Python?

-

Usa Thunderbit para extraer datos:

- Abre la .

- Haz clic en “Sugerir campos con IA” y deja que Thunderbit te recomiende qué extraer.

- Gestiona paginación, subpáginas e incluso imágenes o PDFs con un clic.

- Exporta los datos directo a CSV, Excel, Google Sheets, Notion o Airtable.

-

Analiza y limpia los datos en Python:

- Carga el archivo exportado en Python con pandas:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - Ahora puedes filtrar, limpiar, combinar, visualizar o hacer análisis avanzados según lo que necesites.

- Carga el archivo exportado en Python con pandas:

-

Automatiza el proceso:

- Thunderbit permite programar extracciones, así que puedes recibir datos frescos cada día.

- Combínalo con scripts de Python para informes automáticos, alertas o procesamiento extra.

¿Por qué usar ambos? Thunderbit te ahorra horas de código y depuración, sobre todo en sitios complejos o tareas puntuales. Python te da el poder de analizar, limpiar e integrar esos datos en tus procesos. Es como pan con chocolate: por separado están bien, pero juntos son imbatibles ().

Cómo resolver los problemas más comunes al extraer datos con Python

Extraer datos web no siempre es un paseo. Aquí tienes algunos problemas típicos—y cómo solucionarlos:

1. Bloqueos (errores 403/429, CAPTCHAs):

- Cambia el User-Agent para simular un navegador real.

- Usa proxies para rotar IPs ().

- Añade pausas entre peticiones (

time.sleep()). - Respeta robots.txt y las reglas de crawl-delay.

- Para CAPTCHAs, usa Selenium para resolverlos manualmente o un servicio especializado.

2. Contenido dinámico que no carga:

- Usa Selenium para páginas con mucho JavaScript.

- Busca llamadas a APIs internas en la pestaña de red del navegador—puede que puedas obtener los datos directo en JSON.

3. Problemas de login o sesión:

- Usa

requests.Session()para mantener las cookies. - Automatiza el login con Selenium si hace falta.

4. Cambios en la estructura de la web:

- Escribe selectores robustos (mejor IDs que clases).

- Supervisa cambios y actualiza tu script cuando sea necesario.

- La IA de Thunderbit puede adaptarse automáticamente a cambios de diseño, ahorrándote mantenimiento.

5. Grandes volúmenes de datos:

- Usa concurrencia (

concurrent.futuresoasyncio) para acelerar la extracción. - Guarda los datos por partes o en una base de datos para evitar problemas de memoria.

(, )

Solución de problemas: depuración y optimización de tus scripts

Cuando algo falla (y va a pasar), aquí tienes una lista rápida:

- HTTP 404/403/429: Revisa la URL, los headers y la frecuencia de peticiones.

- Timeouts/Errores de conexión: Implementa reintentos con backoff exponencial.

- AttributeError/NoneType: Añade comprobaciones antes de acceder a elementos; revisa el HTML que realmente recibes.

- Problemas de codificación: Usa

response.encoding = 'utf-8'o especifica la codificación al guardar archivos. - Elemento no encontrado en Selenium: Usa esperas explícitas; revisa bien tus selectores.

- Errores de memoria: Guarda los datos por lotes, usa generadores o una base de datos para conjuntos muy grandes.

- Depuración: Usa prints, logs o guarda el HTML en un archivo para inspeccionarlo.

Para mejorar el rendimiento, puedes usar peticiones asíncronas (aiohttp), hilos o un framework como Scrapy para proyectos grandes. Pero no te obsesiones con optimizar si tu tarea es pequeña—la claridad es más importante cuando estás aprendiendo.

Buenas prácticas para una extracción de datos ética y legal

Con gran poder de extracción viene gran responsabilidad. Así te mantienes dentro de la ley (y el sentido común):

- Respeta robots.txt y los Términos de Servicio: Si un sitio prohíbe la extracción, mejor no lo hagas.

- Evita datos personales o sensibles: Limítate a info pública; no recojas datos que no te gustaría que recojan de ti.

- Sé considerado: Limita la frecuencia de tus peticiones, evita extraer durante horas pico y no sobrecargues los servidores.

- Identifícate: Usa un User-Agent personalizado con info de contacto si corresponde.

- Consulta la legislación: En EE.UU., extraer datos públicos suele ser legal, pero saltarse los Términos de Servicio o extraer datos privados puede meterte en líos ().

- Usa APIs si existen: Si el sitio ofrece una API, úsala—es más seguro y estable.

(, )

Conclusión y puntos clave

Aprender a extraer datos con Python es una de las habilidades más valiosas hoy en día, donde los datos lo son todo. En resumen:

- Python es la mejor opción para extraer datos web por su sencillez, librerías y comunidad ().

- Empieza con sitios estáticos usando requests y BeautifulSoup; usa Selenium para contenido dinámico.

- Thunderbit puede ahorrarte horas con webs complejas o tareas puntuales—luego usa Python para analizar y automatizar.

- Supera los retos rotando headers, usando proxies, pausas y buen manejo de errores.

- Extrae datos de forma ética: Respeta los sitios, evita datos sensibles y cumple la ley.

¿Mi consejo? Empieza por lo sencillo: elige una web fácil, escribe tu primer script y mira qué puedes conseguir. Cuando te sientas cómodo, prueba a combinar Thunderbit y Python para flujos de trabajo aún más potentes. Y recuerda: cada error es solo un reto por resolver (a veces con ayuda de Stack Overflow).

¿Quieres ver Thunderbit en acción o aprender más sobre extracción de datos? Visita el o suscríbete a nuestro para tutoriales y consejos.

¡Feliz extracción! Que tus datos siempre estén limpios, tus scripts sin errores y tu IP sin bloqueos.

Preguntas frecuentes

1. ¿Qué es la extracción de datos web y es legal?

La extracción de datos web es obtener información de sitios de forma automatizada. Extraer datos públicos suele ser legal en EE.UU. y muchos países, pero debes respetar los términos del sitio, evitar datos sensibles y cumplir las leyes de privacidad ().

2. ¿Por qué la mayoría usa Python para extraer datos web?

Python es fácil de aprender, tiene librerías potentes para cada paso (requests, BeautifulSoup, Selenium, pandas) y una comunidad enorme ().

3. ¿Cuándo usar Selenium en vez de requests/BeautifulSoup?

Usa Selenium cuando los datos se cargan dinámicamente con JavaScript y no aparecen en el HTML inicial. Selenium automatiza un navegador real, así que “ve” lo mismo que un usuario.

4. ¿Cómo funciona Thunderbit con Python?

Thunderbit te permite extraer datos complejos o desordenados con IA en pocos clics, luego exportarlos a CSV/Excel/Sheets. Después puedes cargarlos en Python para limpiar, analizar o automatizar—ahorrando horas de código.

5. ¿Consejos para evitar bloqueos al extraer datos?

Cambia el User-Agent, usa proxies, añade pausas, respeta robots.txt y evita datos sensibles o privados. Para extracciones intensivas, considera herramientas anti-bots o servicios especializados.

¿Listo para probar la extracción de datos? Descarga la y descubre lo fácil que es combinar IA y Python en tu próximo proyecto de datos. Y si te atoras, recuerda: todo gran extractor empezó con una sola línea de código.

Más información