Todavía tengo muy presente la primera vez que intenté sacar datos de una web. Estaba en mi escritorio, con un café al lado, decidido a dejar de perder horas copiando y pegando precios de productos. Abrí Python, instalé BeautifulSoup y me lancé... solo para toparme con un mar de HTML caótico y un montón de errores. Si alguna vez has probado el web scraping python, seguro que conoces esa mezcla de emoción, confusión y, a veces, ganas de tirar el portátil por la ventana.

Pero la realidad es esta: los datos web valen oro. Las empresas necesitan información al instante, ya sea para vigilar precios de la competencia, crear bases de prospectos o analizar tendencias del mercado. Python ha sido durante años la opción favorita para python web scraping, pero a medida que las webs se vuelven más complejas y las defensas anti-scraping más duras, el método tradicional de programar empieza a quedarse... un poco viejo. Por eso hoy quiero enseñarte los dos mundos: el clásico kit de herramientas de scraping con Python y la nueva generación de raspador IA como que están cambiando la forma de trabajar de equipos de ventas, ecommerce y operaciones.

¿Qué es el Web Scraping con Python?

Vamos a lo básico: web scraping es una forma elegante de decir “sacar datos de páginas web de manera automática”. En vez de copiar y pegar a mano, escribes un script que lo hace por ti. Python es el lenguaje favorito de muchos porque es fácil de leer, tiene una comunidad enorme y cuenta con librerías que facilitan el scraping, incluso si no eres programador profesional.

¿Por qué Python?

- Fácil de pillar: La sintaxis de Python es famosa por ser amigable para quienes empiezan.

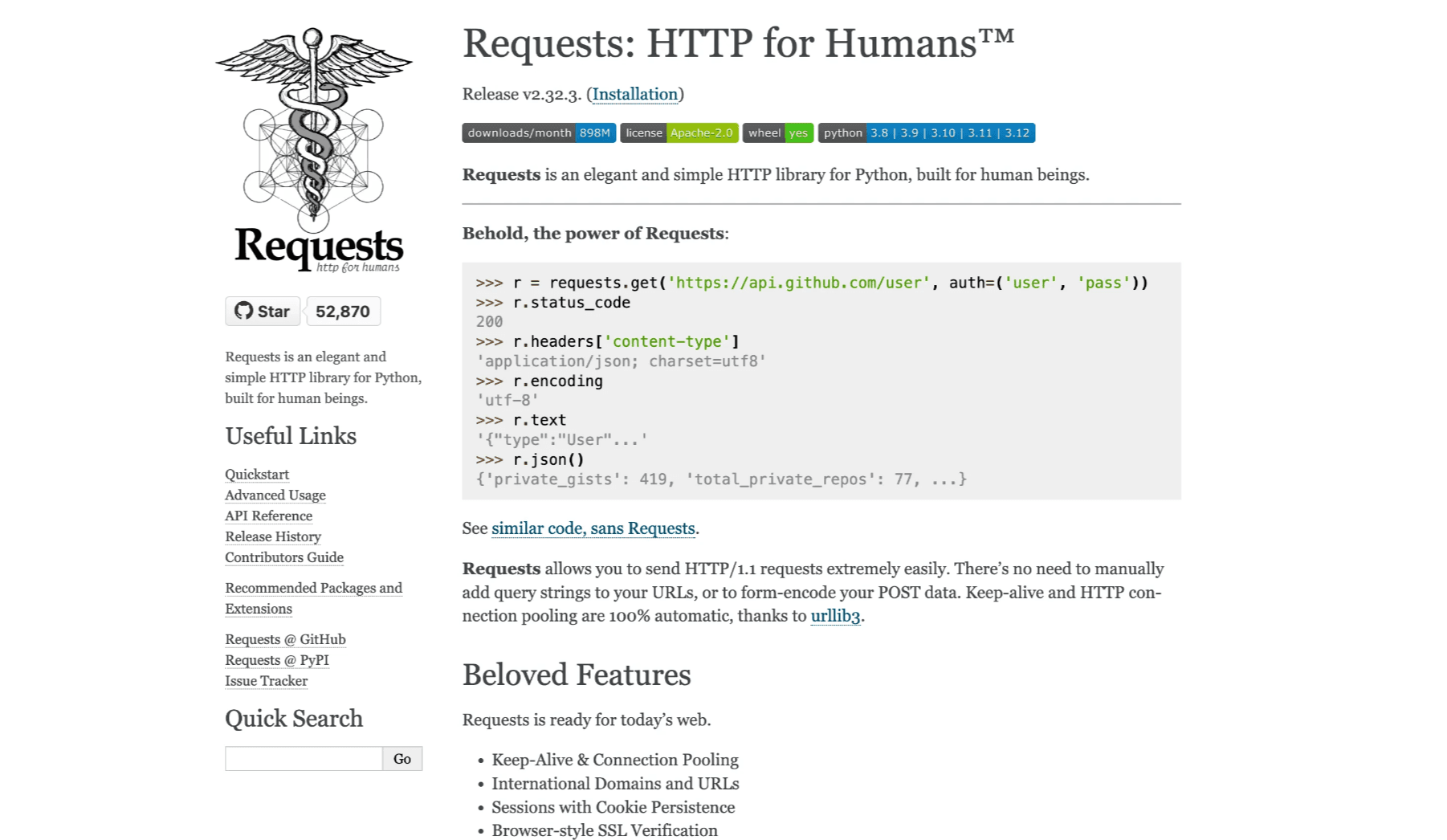

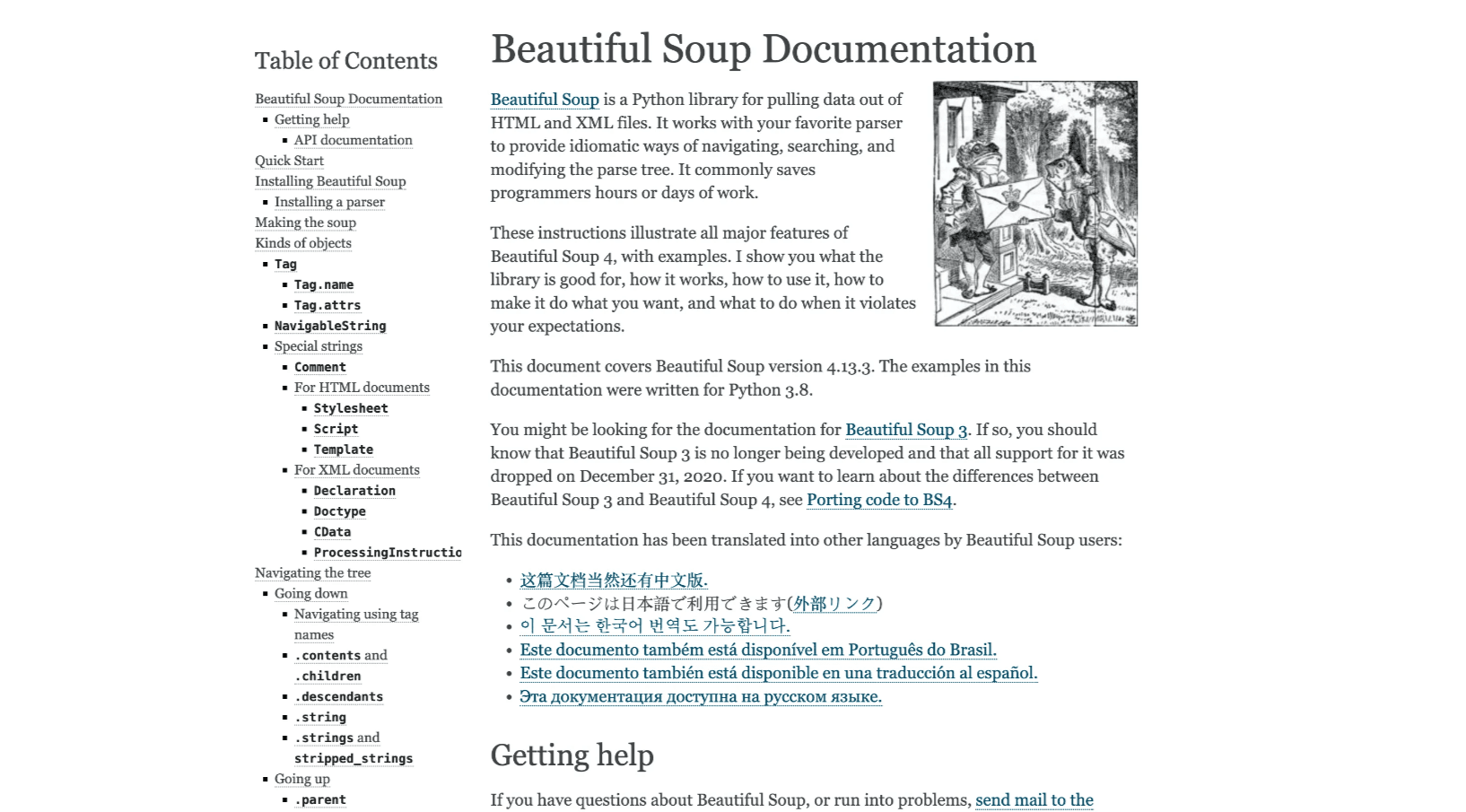

- Librerías potentes: Herramientas como Requests, BeautifulSoup, Selenium y Scrapy cubren desde webs sencillas hasta sitios llenos de JavaScript.

- Comunidad gigante: Si te atascas, seguro que alguien ya tuvo ese problema (o al menos lo preguntó en Stack Overflow).

Usos Comunes

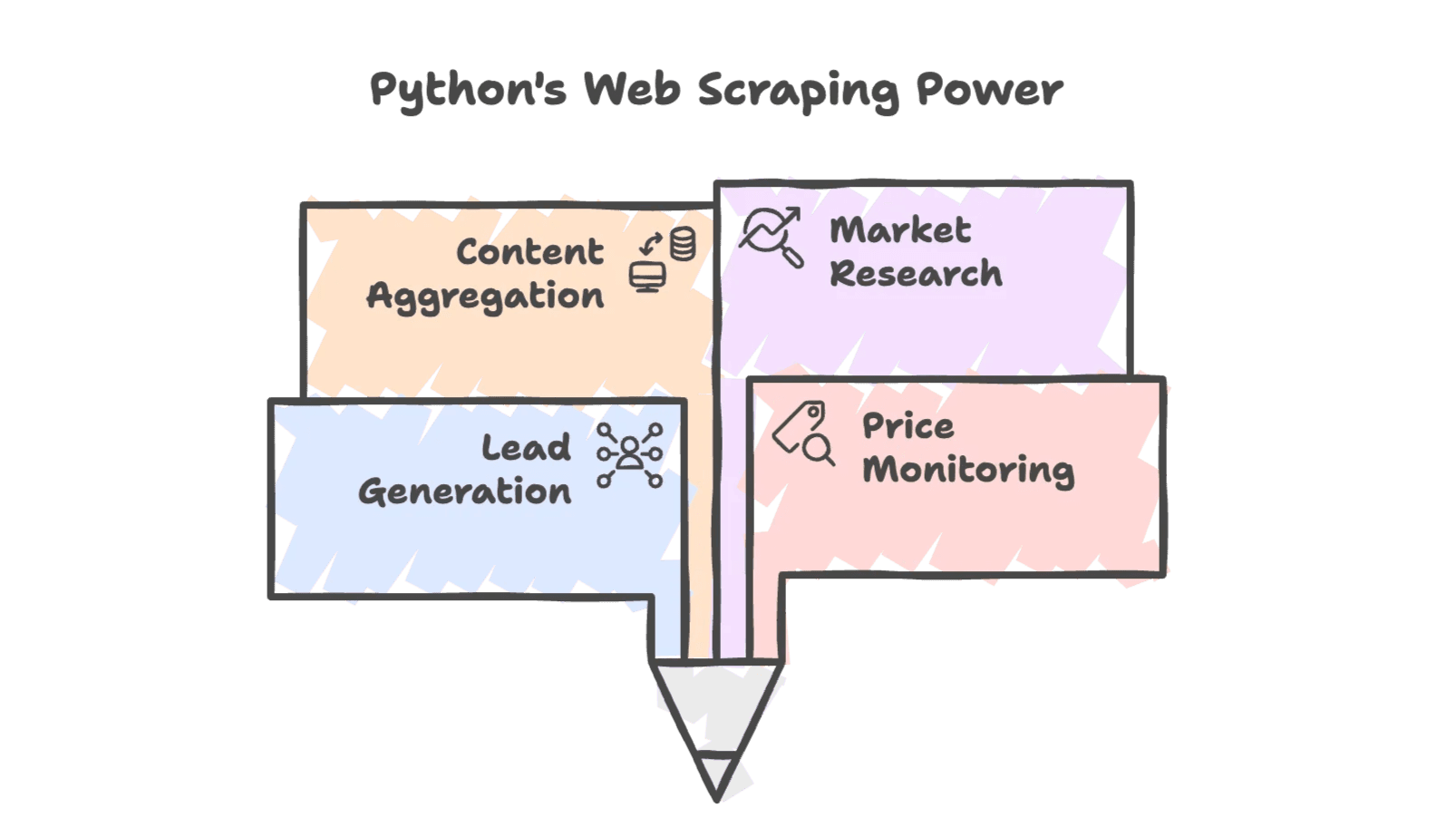

El python web scraping se usa en todo tipo de negocios:

- Generar leads: Sacar datos de contacto de directorios o redes sociales.

- Monitorear precios: Vigilar precios de la competencia para ajustar tu estrategia.

- Agregación de contenido: Recopilar noticias, reseñas o listados de productos.

- Investigación de mercado: Analizar tendencias en foros, redes sociales o resultados de búsqueda.

Y no es solo para informáticos: equipos de ventas, ecommerce e incluso inmobiliarias dependen de datos extraídos para seguir en la pelea. De hecho, ya usan web scraping para crear bases de datos personalizadas y analizar leads.

¿Por qué las empresas usan Python para el Web Scraping?

La flexibilidad de Python y sus librerías lo hacen ideal para el raspado web. Mira estos ejemplos reales:

| Escenario | ¿Cómo ayuda el Web Scraping con Python? | Beneficio Ejemplo (ROI) |

|---|---|---|

| Generación de Leads | Extraer nombres, emails y teléfonos de directorios | Crear una lista de 500 prospectos en una noche, frente a 50 manualmente |

| Monitoreo de Precios | Obtener precios de productos de la competencia regularmente | Permitir precios dinámicos—un minorista aumentó ventas un 4% usando datos extraídos |

| Seguimiento de Inventario | Revisar el stock de la competencia | Atacar clientes cuando los rivales están sin stock, ahorrando horas de revisiones manuales |

| Análisis de la Competencia | Rastrear detalles de productos y reseñas | Analizar más de 1,000 reseñas de la competencia para marketing y desarrollo de producto |

| Investigación de Mercado | Agregar datos de foros, redes sociales y búsquedas | Guiar campañas con tendencias actualizadas, alineando la estrategia con el interés real del consumidor |

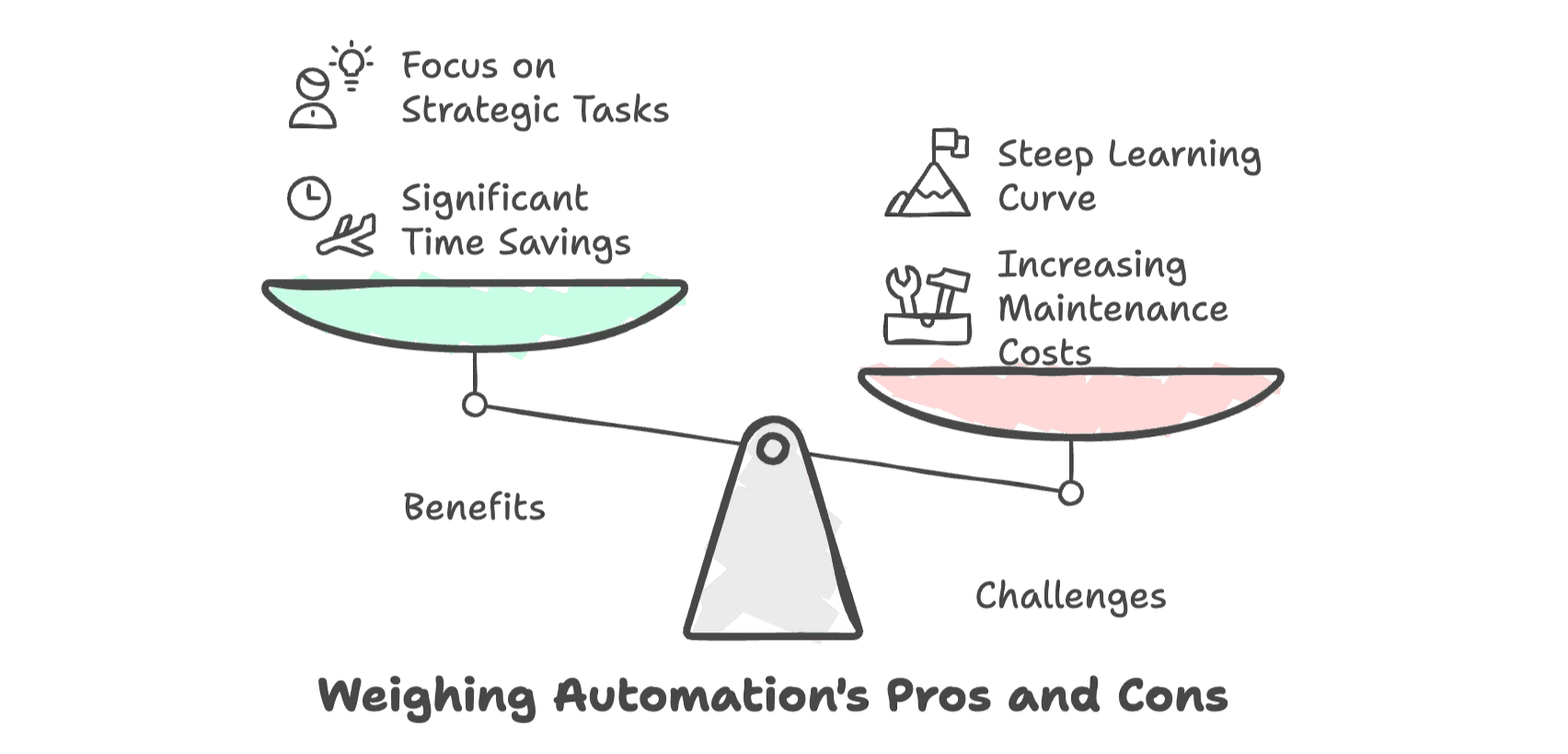

El beneficio es claro: automatizar la recolección de datos con Python puede ahorrarte hasta un 80% de tiempo comparado con hacerlo a mano (). Eso significa que tu equipo dedica menos tiempo a tareas repetitivas y más a cerrar ventas o analizar tendencias.

Pero—y es un pero grande—a medida que las webs se complican, el coste (en tiempo, frustraciones y mantenimiento) de mantener esos scripts funcionando no para de crecer. Para quienes no son técnicos, la curva de aprendizaje puede ser dura y la frustración, real.

Herramientas Esenciales para el Web Scraping con Python

Si estás empezando, el mundo Python tiene varias herramientas top. Aquí va un resumen rápido:

| Herramienta | Ideal para | ¿Maneja JavaScript? | Dificultad de Aprendizaje | Velocidad y Escalabilidad |

|---|---|---|---|---|

| Requests + BeautifulSoup | Páginas estáticas y simples | No | Baja | Rápido para páginas individuales |

| Selenium | Sitios dinámicos con JS; interacción | Sí | Media | Más lento por página |

| Scrapy | Crawling estructurado y a gran escala | Parcial (con plugins) | Alta | Alto rendimiento, escalable |

Requests + BeautifulSoup

La pareja clásica para webs estáticas. Requests descarga el HTML y BeautifulSoup lo analiza para que puedas sacar los datos que te interesan. Es ligero, fácil y perfecto para proyectos pequeños (, ).

Selenium

Cuando necesitas sacar datos que solo aparecen tras cargar JavaScript, Selenium es tu mejor amigo. Automatiza un navegador real, así que puede con inicios de sesión, clics y desplazamientos (). ¿El problema? Es más lento y requiere más configuración.

Scrapy

Para proyectos grandes—como rastrear miles de páginas o crear pipelines de datos recurrentes—Scrapy es el peso pesado. Es un framework completo para construir spiders robustos, manejar concurrencia y organizar tu código (). La curva de aprendizaje es mayor, pero compensa en trabajos a gran escala.

Paso a Paso: Tu Primer Raspador Web en Python

Vamos a ponernos manos a la obra con un ejemplo real. Vamos a sacar títulos y precios de libros de , una web de práctica para scraping.

Configurando tu Entorno Python

Primero, asegúrate de tener Python instalado. Luego, abre la terminal y ejecuta:

1pip install requests beautifulsoup4Te recomiendo usar un editor de código cómodo como VS Code o PyCharm. Créeme, tu yo del futuro te lo agradecerá.

Escribiendo tu Primer Script de Web Scraping

Aquí tienes un script sencillo para pillar la página principal y sacar los datos de los libros:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)¿Qué pasa aquí?

- Descargamos el HTML con Requests.

- Lo analizamos con BeautifulSoup.

- Buscamos todos los listados de libros.

- Sacamos el título y el precio de cada libro.

Exportando los Datos Extraídos

Para aprovechar tus datos, guárdalos en un archivo CSV:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)Ahora puedes abrir books.csv en Excel o Google Sheets y trabajar con tus datos.

Consejos Pro:

- Revisa siempre tu salida para detectar errores o datos que falten.

- Si ves caracteres raros, asegúrate de usar codificación UTF-8.

- Si tu script deja de funcionar, revisa si la web ha cambiado.

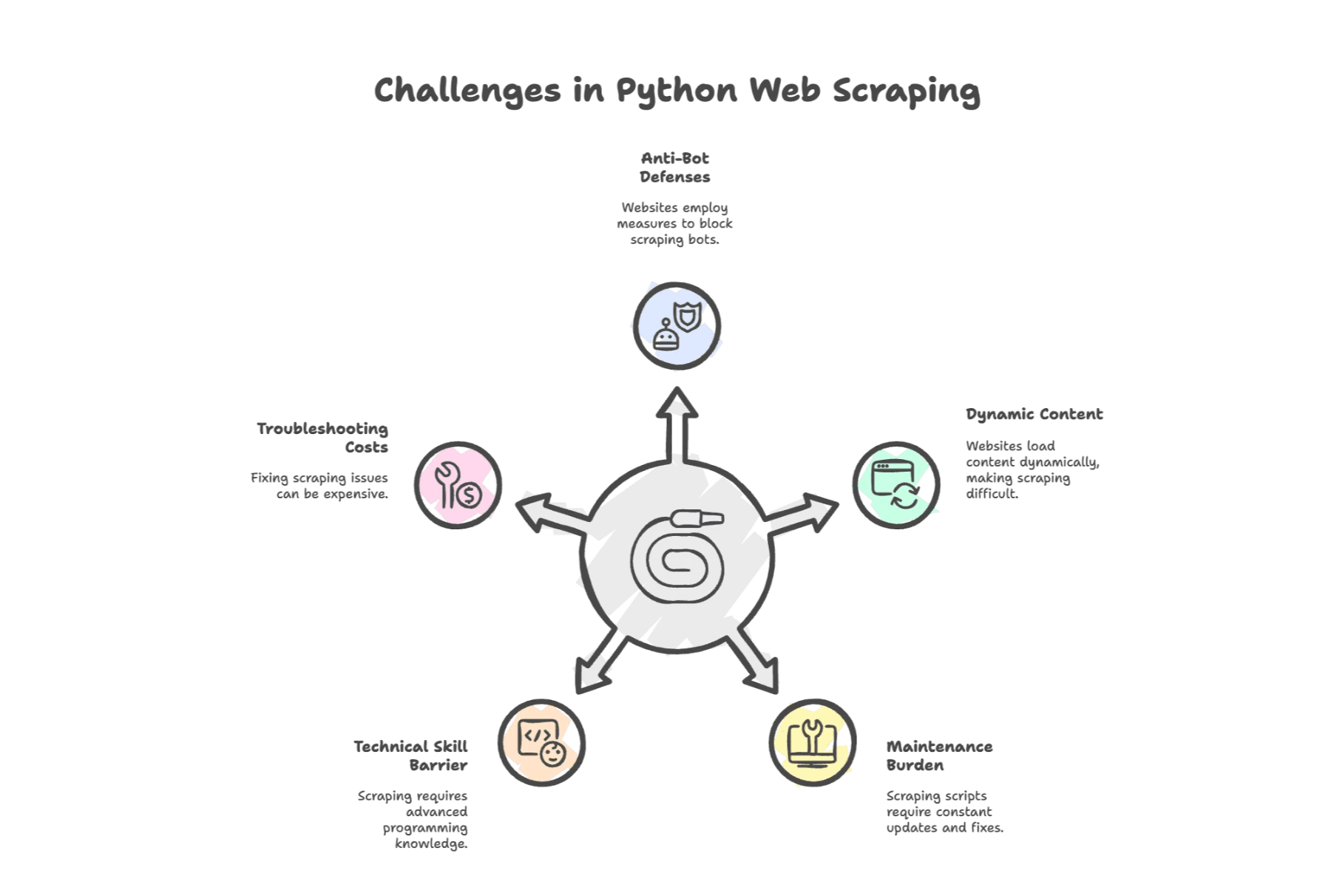

Retos Comunes del Web Scraping con Python

Aquí es donde la cosa se pone complicada. El scraping con Python es potente, pero no todo es tan fácil. Mira los dolores de cabeza más comunes:

1. Defensas Anti-Bots

Las webs se protegen. En una encuesta reciente, mencionó bloqueos (baneos de IP, CAPTCHAs) como su mayor problema. Los sitios pueden detectar scripts y poner barreras—como los CAPTCHAs.

2. Contenido Dinámico

Las webs modernas adoran JavaScript. Si los datos que buscas se cargan después de la página inicial, tu script con Requests + BeautifulSoup no encontrará nada. Tendrás que usar Selenium o buscar una API.

3. Mantenimiento Constante

Las webs cambian. Mucho. Un pequeño cambio en el HTML puede romper tu script. Un estudio mostró que los desarrolladores dedican a arreglar raspadores rotos, y las empresas pueden gastar $15,000 al año solo en mantenimiento.

4. Barrera Técnica

Aunque Python es sencillo, necesitas entender HTML, selectores CSS y a veces protocolos HTTP. Para quienes no son programadores, puede sentirse como aprender otro idioma—porque, en realidad, lo es.

5. Costes de Solución de Problemas

Cuando algo falla (y pasará), puede que necesites invertir en proxies, navegadores sin cabeza o servicios de terceros. Cada hora depurando es una hora menos para tu trabajo real.

Herramientas de Web Scraping Automatizado: El Siguiente Nivel

Entonces, ¿qué puede hacer alguien de negocio (o de ventas con poco tiempo)? Aquí entran las herramientas de web scraping automatizada—y, más recientemente, los raspadores IA.

Estas herramientas te quitan el trabajo duro: se encargan de todo el proceso. Olvídate de programar para cada web o de noches arreglando errores. Solo selecciona, haz clic y consigue tus datos.

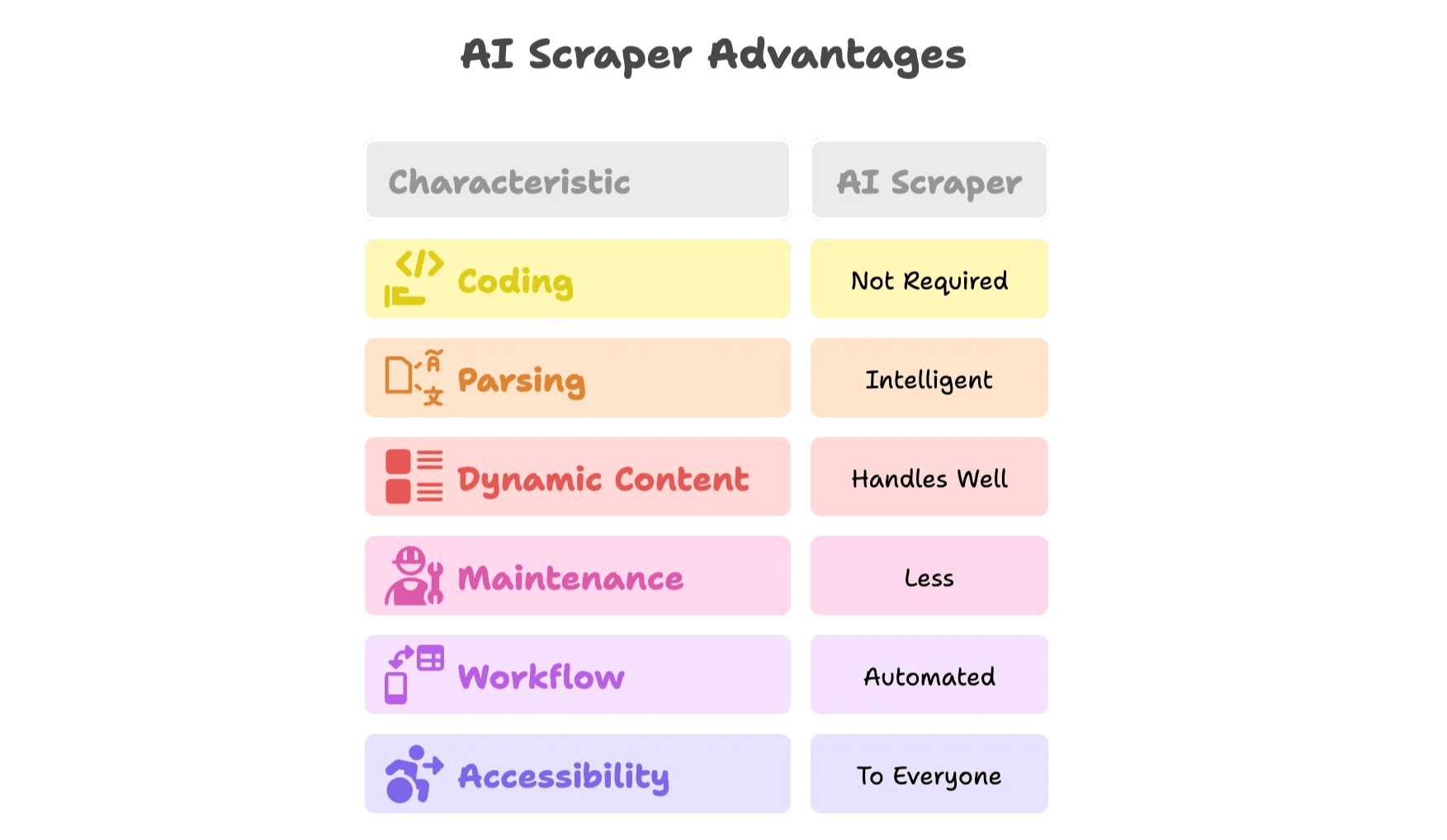

¿Qué hace diferente a un Raspador IA?

El raspador IA es un salto de nivel. Mira por qué:

- Sin programar: Interfaces visuales o extensiones de navegador te dejan seleccionar los datos y la IA hace el resto.

- Análisis inteligente: La IA detecta automáticamente campos como nombres, precios o emails, sin que tengas que mirar el HTML.

- Maneja contenido dinámico: Los raspadores IA funcionan en navegadores reales, así que pueden con JavaScript, scroll y clics.

- Menos mantenimiento: Si una web cambia, la IA se adapta—o el equipo de la herramienta actualiza las plantillas por ti.

- Automatización de flujos de trabajo: Programa extracciones, exporta directo a Google Sheets, Airtable, Notion o Excel.

- Accesible para todos: Ya no dependes del “experto en Python” de tu equipo.

Veamos cómo funciona esto en la práctica con .

Thunderbit: Una Alternativa Más Inteligente al Web Scraping con Python

Co-fundé Thunderbit porque vi de cerca cuánto tiempo y energía perdían los equipos con el scraping manual. ¿Nuestro objetivo? Que los datos web sean accesibles para todos—sin código, sin líos, solo resultados.

Funcionalidades Clave del Raspador IA de Thunderbit

- Raspador Web IA en 2 clics: Solo abre una web, pulsa “AI Suggest Fields” y deja que la IA de Thunderbit te recomiende las mejores columnas para extraer. Haz clic en “Scrape” y listo.

- Plantillas listas para usar: Para webs populares (Amazon, Zillow, LinkedIn, etc.), usa plantillas instantáneas—sin configurar nada.

- Raspado de subpáginas y paginación: Thunderbit entra automáticamente en subpáginas (como detalles de productos) y maneja paginación o scroll infinito.

- Exportación gratuita de datos: Exporta tus datos a Excel, Google Sheets, Airtable o Notion—sin bloqueos ni complicaciones.

- Extractores de emails y teléfonos: Saca al instante información de contacto de cualquier web, ideal para ventas y generación de leads.

- Transformación de datos con IA: Resume, categoriza, traduce o da formato a los datos al momento.

- Raspado programado: Configura extracciones recurrentes usando lenguaje natural.

- Opciones en la nube y navegador: Elige entre scraping rápido en la nube o desde el navegador para webs que requieren login.

- Soporte para 34 idiomas: Thunderbit está pensado para equipos de todo el mundo.

¿Quieres verlo en acción? Prueba nuestra y visita el para tutoriales y casos reales.

¿Cuándo Cambiar de Python a un Raspador IA?

Aquí tienes una lista rápida para decidir:

| Situación | Script en Python | Raspador IA (Thunderbit) |

|---|---|---|

| Extracción puntual, página estática simple | ✔️ | ✔️ |

| Contenido dinámico (JS, logins, scroll infinito) | ⚠️ | ✔️ |

| Cambios frecuentes en la web, alto mantenimiento | ⚠️ | ✔️ |

| Equipo no técnico, necesidad de rapidez | ⚠️ | ✔️ |

| Integración multiplataforma (Sheets, CRM) | ⚠️ | ✔️ |

| Raspado recurrente y a gran escala | ⚠️ | ✔️ |

| Necesidad de programación, enriquecimiento o automatización | ⚠️ | ✔️ |

Si ves muchos ⚠️ en tu día a día, probablemente es hora de probar un raspador IA.

Extra: Consejos para una Recolección de Datos Web Eficiente y Sostenible

Ya uses Python o una herramienta IA, algunos buenos hábitos marcan la diferencia:

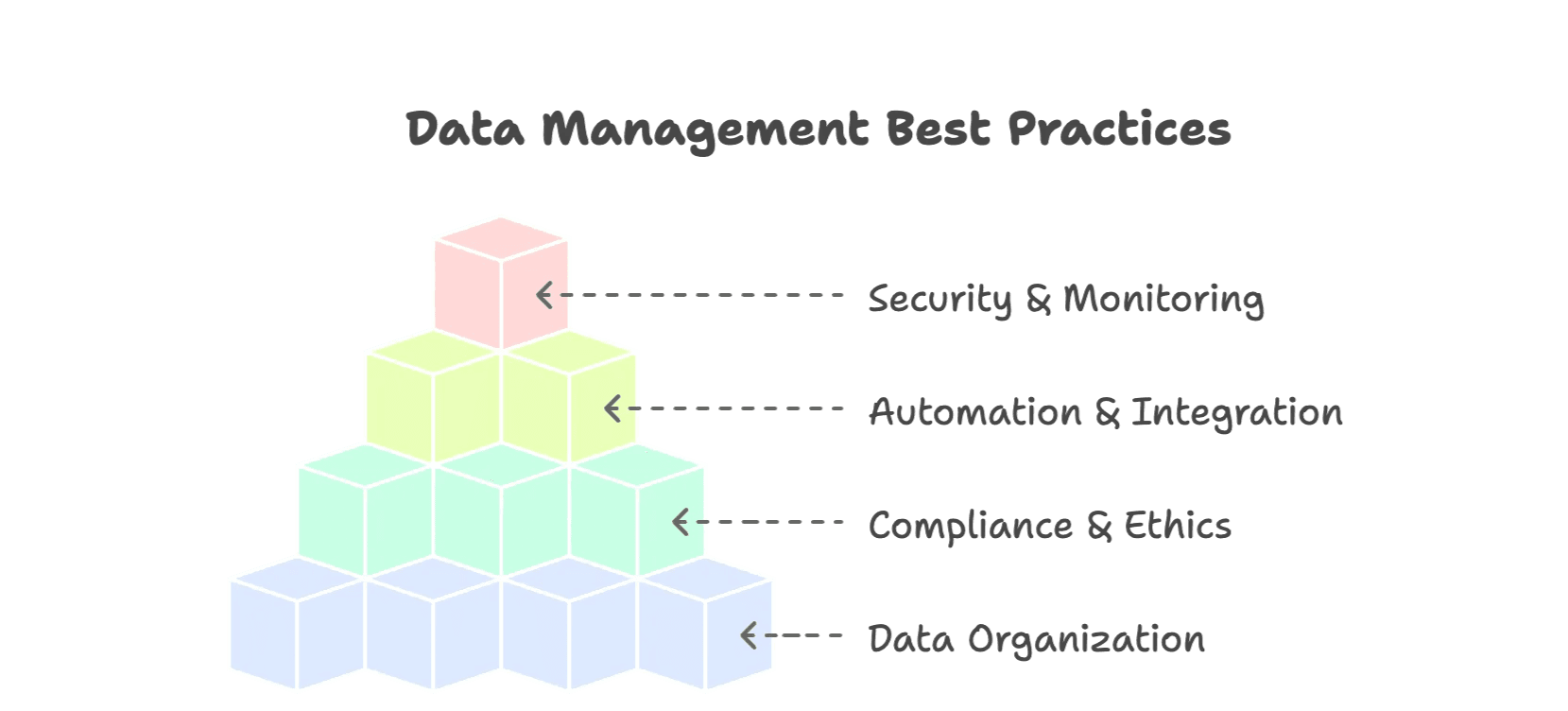

1. Mantén tus Datos Organizados

- Usa formatos estructurados (CSV, Excel, bases de datos).

- Normaliza campos (fechas, monedas, categorías).

- Añade metadatos (fuente, fecha de extracción) para contexto.

- Elimina duplicados y valida tus datos.

2. Cumple con la Normativa y la Ética

- Respeta robots.txt y los términos de uso de las webs ().

- No sobrecargues los sitios—usa pausas entre peticiones.

- Evita extraer datos personales o sensibles.

- Usa APIs públicas cuando estén disponibles.

3. Automatiza e Integra

- Programa extracciones recurrentes para tener datos frescos.

- Exporta directo a tus herramientas de trabajo (Sheets, Airtable, Notion).

- Usa alertas o monitoreo para detectar errores a tiempo.

4. Seguridad y Monitoreo

- Registra tus ejecuciones y errores de scraping.

- Haz copias de seguridad de tus datasets.

- Restringe el acceso a datos sensibles.

Para más buenas prácticas, revisa .

Conclusión: El Futuro del Web Scraping es Más Inteligente

Hemos avanzado mucho desde los días de scripts en Python hechos a mano y horas arreglando selectores rotos. Los datos web son ahora un activo estratégico— se destinan a datos públicos, y se espera que el mercado de herramientas de scraping con IA alcance los .

Python sigue siendo una gran forma de aprender lo básico y resolver tareas pequeñas de scraping. Pero a medida que las webs se complican, nuestras herramientas deben evolucionar. El raspador IA como Thunderbit ofrece una forma más inteligente y eficiente de recolectar y aprovechar datos web—pensada para la forma en que trabajan los equipos hoy.

Si pasas más tiempo arreglando errores que sacando resultados, o tienes curiosidad por ver cómo es el scraping moderno, prueba Thunderbit: . Tu equipo de ventas, ecommerce u operaciones lo va a notar.