Déjame contarte cómo fue la primera vez que intenté sacar datos de una web para mi negocio. Estaba sentado en la mesa de la cocina, con un café en una mano y un script de Python a medio hacer en la otra, intentando conseguir los precios de productos de un competidor. Pensé: “¿Qué tan complicado puede ser esto?” Spoiler: acabé con un archivo CSV lleno de celdas vacías y un nuevo respeto por quienes dicen “eso se automatiza con Python”. Saltemos a 2025: el raspado web se ha vuelto el motor de los negocios que viven de los datos, impulsando ventas, ecommerce, marketing y operaciones con información al instante que sería imposible recolectar a mano.

Pero aquí viene lo bueno: aunque el raspado web con Python es más potente que nunca, el panorama está cambiando. El mercado de raspado web está en pleno auge—valorado en . Casi para tomar mejores decisiones. Sin embargo, el verdadero reto no es solo programar, sino elegir la herramienta adecuada, escalar y no volverse loco manteniendo decenas de scripts. En esta guía definitiva, te voy a mostrar todas las librerías principales de Python para raspado web (con ejemplos de código), casos reales de empresas y por qué, aunque me encanta Python, creo que las soluciones sin código como son la mejor opción para la mayoría de los negocios en 2025.

¿Qué es el Raspado Web con Python? Una Explicación Clara

En pocas palabras, raspado web es una forma elegante de decir “copiar y pegar de manera automática”. En vez de contratar a un ejército de becarios para recopilar precios, contactos o reseñas, usas un software que visita páginas web, saca los datos que necesitas y los guarda en una hoja de cálculo o base de datos. Hacer raspado web con Python significa que usas scripts en este lenguaje para obtener páginas web, analizar el HTML y extraer la información relevante.

Imagínalo como tener un asistente digital que navega por internet por ti, las 24 horas, sin pedir descanso. ¿Qué datos suelen extraer las empresas? Precios, detalles de productos, contactos, reseñas, imágenes, noticias e incluso anuncios inmobiliarios. Aunque algunos sitios ofrecen APIs, la mayoría no lo hace o limitan el acceso. Ahí es donde entra el raspado web: te permite acceder a datos públicos a gran escala, incluso cuando no hay un botón de “descargar”.

¿Por Qué el Raspado Web con Python es Clave para los Equipos de Negocio?

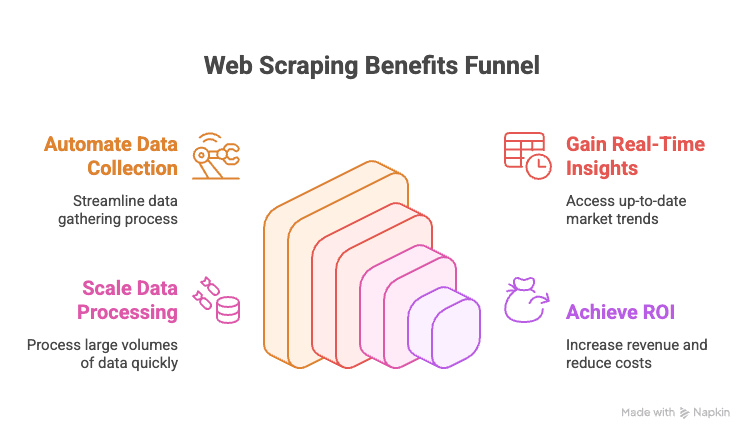

Vamos al grano: en 2025, si tu empresa no aprovecha el raspado web, probablemente está dejando pasar oportunidades. Aquí tienes algunas razones:

- Automatiza la recolección de datos: Olvídate de copiar y pegar filas de sitios de la competencia o directorios online.

- Información en tiempo real: Obtén precios, inventario o tendencias de mercado actualizadas al instante.

- Escalabilidad: Saca datos de miles de páginas en lo que calientas la comida.

- Retorno de inversión: Las empresas que usan estrategias basadas en datos reportan .

Aquí tienes una tabla rápida con casos de uso de alto impacto:

| Departamento | Ejemplo de uso | Valor aportado |

|---|---|---|

| Ventas | Extraer leads de directorios, enriquecer con emails | Listas de prospectos más grandes y precisas |

| Marketing | Monitorear precios, promociones y reseñas de la competencia | Campañas más inteligentes, reacción rápida |

| Ecommerce | Vigilar precios, stock y reseñas de productos | Precios dinámicos, alertas de inventario |

| Operaciones | Unificar datos de proveedores, automatizar reportes | Ahorro de tiempo, menos errores manuales |

| Inmobiliaria | Recopilar anuncios de varias webs | Más propiedades, respuesta más ágil al cliente |

En resumen: el raspado web es el ingrediente secreto para tomar decisiones más rápidas, inteligentes y competitivas.

Resumen: Las Principales Librerías de Python para Raspado Web (Con Ejemplos)

Te prometí un repaso completo, así que prepárate. El ecosistema de Python para raspado web es enorme—hay una librería para cada necesidad, desde descargar páginas simples hasta automatizar navegadores completos. Aquí tienes un panorama general, con ejemplos de código:

urllib y urllib3: Lo Básico para Solicitudes HTTP

Estas son las herramientas integradas de Python para hacer peticiones HTTP. Son de bajo nivel, algo toscas, pero fiables para tareas sencillas.

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # Código de estado HTTP

6print(response.data[:100]) # Primeros 100 bytes del contenidoÚsalas si quieres cero dependencias o necesitas control total. Pero para la mayoría de tareas, preferirás algo más amigable, como requests.

requests: La Librería de Raspado Web Más Popular en Python

Si el raspado web en Python tuviera mascota, sería la librería requests. Es sencilla, potente y se encarga de todo el trabajo pesado de HTTP.

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # Contenido JSON parseado (si la respuesta es JSON)¿Por qué es tan popular? Maneja cookies, sesiones, redirecciones y más—para que te concentres en los datos, no en los detalles técnicos de HTTP. Solo recuerda: requests solo descarga el HTML. Para extraer datos, necesitas un parser como BeautifulSoup.

BeautifulSoup: Análisis de HTML y Extracción de Datos Fácil

BeautifulSoup es la opción preferida para analizar HTML en Python. Es tolerante, fácil de usar y funciona muy bien junto a requests.

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"Perfecto para proyectos pequeños o medianos, o si estás empezando. Para grandes volúmenes o consultas complejas, quizá prefieras lxml.

lxml y XPath: Análisis Rápido y Potente de HTML/XML

Si necesitas velocidad o quieres usar XPath (un lenguaje de consulta para XML/HTML), lxml es tu aliado.

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")XPath te permite extraer datos con precisión quirúrgica. lxml es rápido y eficiente, aunque la curva de aprendizaje es un poco mayor que con BeautifulSoup.

Scrapy: El Framework para Raspado Web a Gran Escala

Scrapy es el peso pesado para proyectos grandes de scraping. Es un framework completo—piensa en él como el Django del raspado web.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }Scrapy gestiona peticiones asíncronas, sigue enlaces, administra pipelines y exporta datos en varios formatos. Es demasiado para scripts pequeños, pero imbatible para rastrear miles de páginas.

Selenium, Playwright y Pyppeteer: Raspado de Sitios Dinámicos

Cuando te enfrentas a webs que cargan datos con JavaScript, necesitas automatización de navegador. Selenium y Playwright son los referentes aquí.

Ejemplo con Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Ejemplo con Playwright:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")Estas herramientas pueden manejar cualquier sitio que un humano pueda ver, pero son más lentas y pesadas que el scraping puro por HTTP. Úsalas solo cuando sea necesario.

MechanicalSoup, RoboBrowser, PyQuery, Requests-HTML: Otras Herramientas Útiles

-

MechanicalSoup: Automatiza formularios y navegación, basado en Requests y BeautifulSoup.

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser: Similar a MechanicalSoup, pero menos actualizado.

-

PyQuery: Análisis de HTML al estilo jQuery.

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML: Combina peticiones HTTP, análisis y hasta renderizado de JavaScript.

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

Úsalas cuando quieras atajos para formularios, selectores CSS o un poco de JavaScript.

Asyncio y Aiohttp: Acelera tu Raspado Web en Python

Para sacar datos de cientos o miles de páginas, las peticiones síncronas son demasiado lentas. Aquí entran aiohttp y asyncio para scraping concurrente.

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))Este enfoque permite descargar decenas de páginas a la vez, acelerando mucho el proceso.

Librerías Especializadas: PRAW (Reddit), PyPDF2 y Más

-

PRAW: Para extraer datos de Reddit usando su API.

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2: Para extraer texto de archivos PDF.

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

Otras: Hay librerías para Instagram, Twitter, OCR (Tesseract) y más. Si tienes una fuente de datos poco común, probablemente ya existe una librería de Python para ello.

Tabla Comparativa: Librerías de Python para Raspado Web

| Herramienta / Librería | Facilidad de uso | Velocidad y escalabilidad | Ideal para |

|---|---|---|---|

| Requests + BeautifulSoup | Fácil | Moderada | Principiantes, sitios estáticos, scripts rápidos |

| lxml (con XPath) | Media | Rápida | Grandes volúmenes, análisis complejo |

| Scrapy | Difícil | Muy rápida | Empresas, rastreos masivos, pipelines |

| Selenium / Playwright | Media | Lenta | Sitios con mucho JavaScript, interacción |

| aiohttp + asyncio | Media | Muy rápida | Alto volumen, páginas mayormente estáticas |

| MechanicalSoup | Fácil | Moderada | Logins, formularios, gestión de sesiones |

| PyQuery | Media | Rápida | Fans de selectores CSS, manipulación DOM |

| Requests-HTML | Fácil | Variable | Trabajos pequeños, algo de JavaScript |

Guía Paso a Paso: Cómo Crear un Raspador Web en Python (Con Ejemplo)

Vamos a ver un ejemplo real: extraer listados de productos de una tienda online (hipotética), manejar la paginación y exportar a CSV.

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")¿Qué pasa aquí?

- Recorremos las páginas, sacamos el HTML, extraemos productos, guardamos nombre y precio, y paramos cuando ya no hay más productos.

- Exportamos los resultados a CSV para analizarlos fácilmente.

¿Prefieres exportar a Excel? Usa pandas:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)Cómo Gestionar Formularios, Logins y Sesiones en Raspado Web con Python

Muchos sitios requieren iniciar sesión o enviar formularios. Así puedes hacerlo:

Con requests y sesión:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")Con MechanicalSoup:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()Las sesiones te permiten mantener cookies y seguir logueado mientras navegas por varias páginas.

Raspado de Contenido Dinámico y Páginas Renderizadas con JavaScript

Si los datos no están en el HTML (al ver el código fuente ves divs vacíos), necesitas automatización de navegador.

Ejemplo con Selenium:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_sourceO, si encuentras el endpoint de la API que usa el JavaScript, simplemente usa requests para obtener el JSON directamente—es mucho más rápido.

Exportar los Datos Extraídos: CSV, Excel, Bases de Datos y Más

-

CSV: Usa el módulo

csvde Python (ver arriba). -

Excel: Usa pandas o openpyxl.

-

Google Sheets: Usa la librería

gspread.1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

Bases de datos: Usa

sqlite3,pymysql,psycopg2o SQLAlchemy para bases SQL. Para NoSQL, usapymongopara MongoDB.

Comparando el Raspado Web con Python y las Soluciones No-Code Modernas: Por Qué Thunderbit es la Mejor Opción en 2025

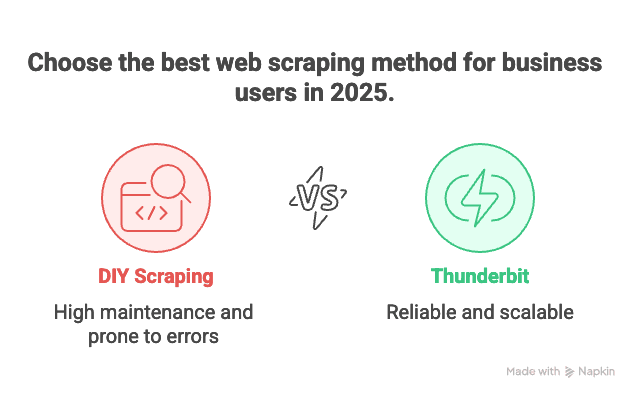

Ahora hablemos del elefante en la habitación: el mantenimiento. Programar tus propios raspadores está bien—hasta que tienes que sacar datos de 100 sitios distintos, cada uno con sus manías, y todos fallan la noche antes de tu informe importante. Lo he vivido, y no es nada divertido.

Por eso soy tan fan de . Aquí tienes mis razones para recomendarlo a empresas en 2025:

- No necesitas programar: Thunderbit te da una interfaz visual. Haz clic en “Sugerir campos con IA”, ajusta las columnas, pulsa “Extraer” y listo. Sin Python, sin depurar, sin buscar en foros.

- Escala a miles de páginas: ¿Necesitas extraer 10.000 productos? El motor en la nube de Thunderbit lo hace por ti, sin que tengas que vigilar un script.

- Cero mantenimiento: Si analizas 100 webs de la competencia, mantener 100 scripts de Python es una pesadilla. Con Thunderbit, solo eliges o ajustas una plantilla y su IA se adapta automáticamente a los cambios de diseño.

- Soporte para subpáginas y paginación: Thunderbit puede seguir enlaces, manejar paginación y enriquecer tus datos visitando las páginas de detalle de cada producto.

- Plantillas instantáneas: Para sitios populares (Amazon, Zillow, LinkedIn, etc.), Thunderbit ya tiene plantillas listas. Un clic y tienes tus datos.

- Exportación gratuita de datos: Exporta a Excel, Google Sheets, Airtable o Notion—sin coste extra.

En resumen: si eres usuario de negocio y solo quieres los datos, Thunderbit es como tener un mayordomo digital. Si eres desarrollador y te gusta trastear, Python sigue siendo tu campo de juego—pero incluso así, a veces solo quieres resultados rápidos.

Buenas Prácticas para un Raspado Web Ético y Legal con Python

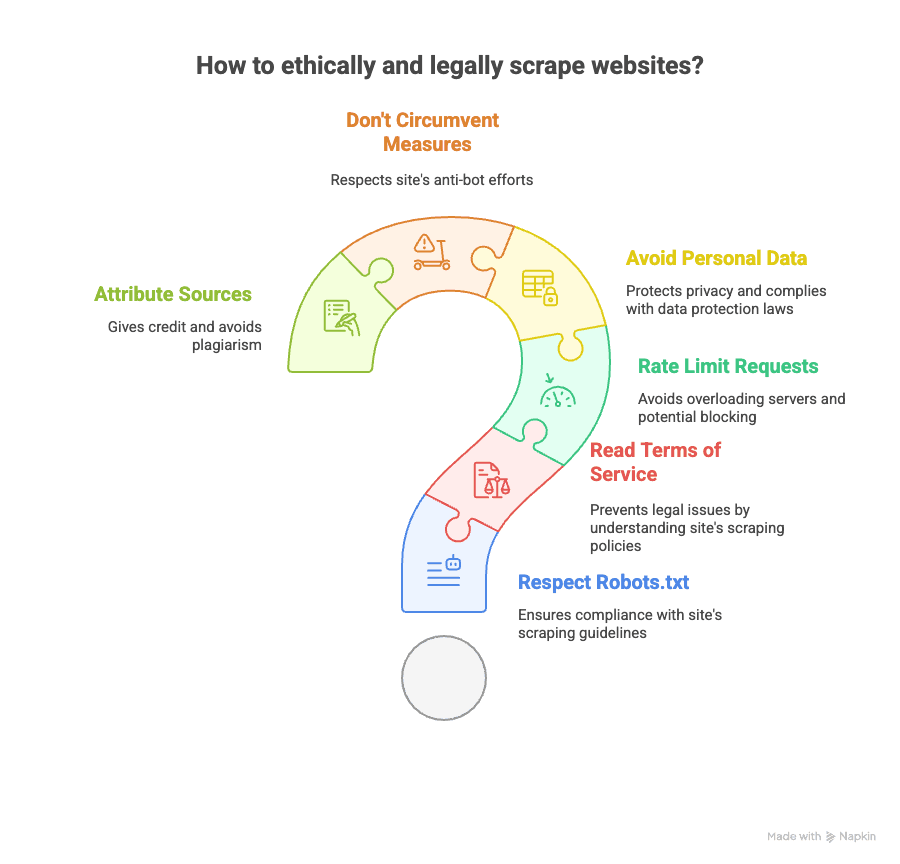

El raspado web es potente, pero implica responsabilidad. Así puedes mantenerte dentro de la legalidad (y la ética):

- Revisa el robots.txt: Respeta lo que el sitio permite extraer.

- Lee los Términos de Servicio: Algunos sitios prohíben el scraping. Saltártelos puede llevarte a bloqueos o incluso problemas legales.

- Limita la velocidad: No satures los servidores—añade pausas entre peticiones.

- Evita datos personales: Ten cuidado al extraer emails, teléfonos o cualquier dato protegido por GDPR o CCPA.

- No burles medidas anti-bots: Si un sitio usa CAPTCHAs o bloqueos agresivos, piénsalo dos veces.

- Atribuye las fuentes: Si publicas análisis, da crédito a los sitios de donde obtuviste los datos.

Para más información legal, revisa este y .

Recursos para Aprender Más sobre Raspado Web con Python (Cursos, Documentación, Comunidades)

¿Quieres profundizar? Aquí tienes mi selección de los mejores recursos:

- Documentación oficial:

- Libros:

- “Web Scraping with Python” de Ryan Mitchell

- “Automate the Boring Stuff with Python” de Al Sweigart

- Guías online:

- Tutoriales en video:

- Canal de YouTube de Corey Schafer

- Comunidades:

Y por supuesto, si quieres ver cómo funciona el scraping sin código, visita el o el .

Conclusión y Claves: Cómo Elegir la Mejor Solución de Raspado Web en 2025

- El raspado web con Python es increíblemente potente y flexible. Si te gusta programar, quieres control total y no te importa el mantenimiento, es una gran opción.

- Hay una librería de Python para cada necesidad: páginas estáticas, contenido dinámico, formularios, APIs, PDFs, lo que sea.

- Pero para la mayoría de empresas, mantener decenas de scripts es un dolor de cabeza. Si tu objetivo es obtener datos rápido, a escala y sin ser ingeniero, es la mejor alternativa.

- La interfaz sin código y potenciada por IA de Thunderbit te permite extraer datos de cualquier web en pocos clics, manejar subpáginas y paginación, y exportar los datos donde los necesites—sin usar Python.

- La ética y la legalidad importan: Revisa siempre las políticas de los sitios, respeta la privacidad y haz scraping de forma responsable.

Así que, tanto si eres un crack de Python como si solo quieres los datos sin líos, las herramientas nunca han sido mejores que en 2025. ¿Mi consejo? Prueba ambos enfoques, elige el que mejor se adapte a tu día a día y no temas dejar que los robots hagan el trabajo aburrido—solo asegúrate de que sean educados.

Y si ya estás harto de scripts que se rompen, prueba la . Tu yo del futuro (y tu café) te lo agradecerán.

¿Quieres más? Échale un ojo a o para guías prácticas y las últimas estrategias de scraping.