La web en 2025 es como un mundo salvaje que nunca se queda quieto: un día estás revisando los precios de tus rivales y al siguiente, te topas con laberintos de JavaScript y sistemas anti-bots que parecen sacados de una película de acción. Después de años creando herramientas de automatización para equipos de ventas y operaciones, te lo digo claro: el uso del Raspador Web ya no es solo una habilidad útil, es una ventaja competitiva que marca la diferencia. Con dependiendo del análisis de datos para tomar decisiones clave y la cantidad de información online creciendo casi , saber transformar ese caos digital en insights accionables es lo que separa a los que lideran del resto.

Pero vamos al grano: el scraping ya no es lo que era. Aquellos días de sacar HTML estático con un par de líneas de Python ya casi son historia. Ahora te enfrentas a contenido dinámico, scroll infinito y defensas anti-bots que no perdonan. Seas novato o quieras llevar tu stack de scraping al siguiente nivel, esta guía te va a mostrar las mejores prácticas, herramientas y flujos de trabajo para dominar el scraping con Python en 2025—y cómo llevar tus proyectos al siguiente nivel con herramientas de IA como .

De principiante a experto: Fundamentos del scraping con Python

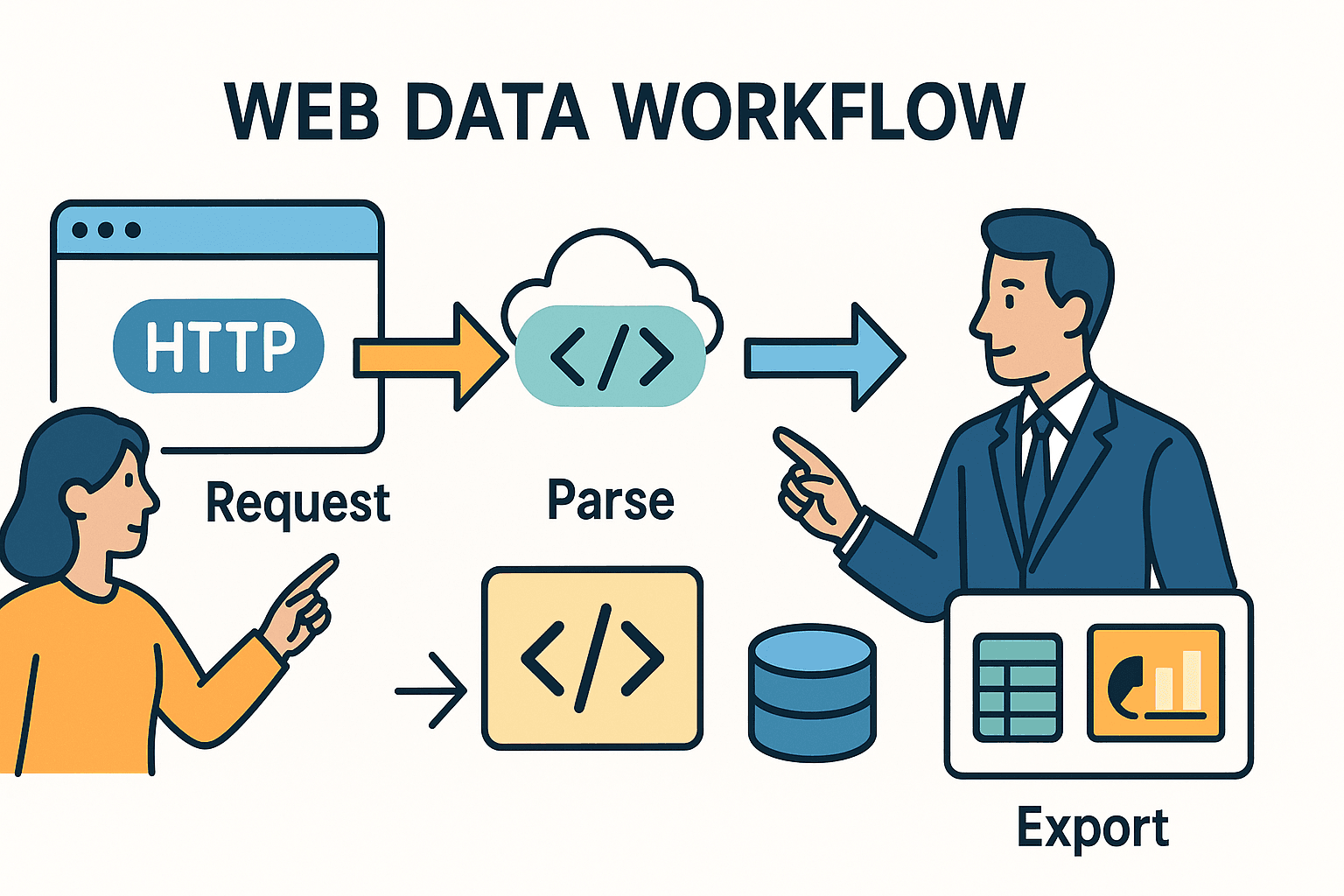

Vamos desde lo básico. El Raspador Web, en esencia, es automatizar lo que harías a mano en el navegador: entras a una página, buscas la info que te interesa y la guardas para después. En Python, normalmente esto se resume en tres pasos:

- Mandar una solicitud HTTP (igual que tu navegador cuando visitas una URL).

- Analizar el HTML para encontrar los datos que buscas.

- Exportar o procesar esos datos—quizá a una hoja de cálculo, base de datos o dashboard.

El truco está en que las herramientas que elijas (y los retos que enfrentes) dependen de lo complicado que sea el sitio y de lo que quieras lograr.

Scraping con Python: ¿Cómo funciona?

Piensa en el scraping como mandar a un bibliotecario a buscar un periódico y luego usar tijeras para recortar solo los artículos que te interesan. La librería requests de Python es tu bibliotecario—te trae el HTML. BeautifulSoup son tus tijeras—te ayuda a seleccionar y sacar lo que necesitas.

¿Pero qué pasa si el periódico está escrito con tinta invisible (¡hola, JavaScript!) o los artículos están repartidos en decenas de páginas? Ahí es cuando necesitas herramientas más potentes—o un poco de magia de IA.

Comparando las herramientas principales

Aquí tienes un resumen de las principales herramientas de scraping en Python y cuándo conviene usarlas:

| Herramienta/Librería | Úsala cuando... | Ventajas | Desventajas |

|---|---|---|---|

| Requests + BeautifulSoup | Para páginas estáticas o tareas pequeñas | Sencillo, rápido, ideal para principiantes. Control total. | No maneja JavaScript ni scraping a gran escala. |

| Scrapy | Proyectos grandes, muchas páginas/sitios | Alto rendimiento, crawling integrado, asincrónico, pipelines, manejo robusto de errores. | Curva de aprendizaje más alta, configuración inicial. |

| Selenium/Playwright | Páginas con JavaScript, logins o acciones de usuario | Puede extraer cualquier cosa visible en el navegador. Maneja contenido dinámico, logins, scroll infinito. | Más lento, consume más recursos, despliegue más complejo. |

| Thunderbit (IA) | Datos no estructurados, PDFs, imágenes o sin código | La IA detecta campos automáticamente, maneja subpáginas, exporta a Excel/Sheets, no requiere código. | Menos personalizable para casos muy específicos, uso basado en créditos. |

Para la mayoría de quienes trabajan en negocios, empezar con requests y BeautifulSoup es perfecto para sitios simples y estáticos. Para proyectos grandes o complejos, Scrapy es tu mejor amigo. Y si te topas con contenido dinámico, anti-bots o datos desordenados, herramientas de IA como te pueden salvar el día.

Mapeando el terreno: mejores prácticas paso a paso para scraping avanzado

Entonces, ¿cómo pasas de “quiero esos datos” a tener un scraper robusto y fácil de mantener? Aquí te dejo mi flujo de trabajo probado:

1. Inspecciona y comprende el sitio objetivo

Antes de escribir una sola línea de código, abre las Herramientas de Desarrollador de tu navegador (F12 o clic derecho > Inspeccionar). Ubica los datos que buscas en el HTML. ¿Están en una tabla? ¿En una serie de <div>? ¿Hay una llamada API oculta que devuelve JSON? Muchas veces, la solución más fácil está justo frente a ti.

Tip: Si ves una solicitud de red que trae JSON al hacer clic en “siguiente página” o “cargar más”, muchas veces puedes saltarte el parsing de HTML y llamar directamente a esa API con Python.

2. Haz una prueba en una sola página

Empieza en pequeño. Usa requests para obtener una página y luego BeautifulSoup para extraer algunos campos. Imprime los resultados. Si te bloquean o faltan datos, prueba añadiendo headers (como el User-Agent de un navegador real), o verifica si el contenido se carga con JavaScript (en ese caso, ve al paso 3).

3. Maneja contenido dinámico y paginación

Si los datos no están en el HTML, probablemente los carga JavaScript. ¿Qué hacer?

- Automatización de navegador: Usa o para abrir la página, esperar el contenido y obtener el HTML renderizado.

- Llamadas API: Busca solicitudes XHR en la pestaña de red. Si encuentras un endpoint que devuelve JSON, replica esa llamada con

requests. - Paginación: Para datos en varias páginas, recorre los números de página o sigue los enlaces “Siguiente”. Para scroll infinito, usa Selenium para bajar o simula las llamadas API que se activan al hacer scroll.

4. Manejo de errores y buenas prácticas

A los sitios web no siempre les gustan los scrapers. Para evitar bloqueos:

- Respeta

robots.txt: Revisa siempreexample.com/robots.txtpara ver rutas prohibidas o retrasos de rastreo. - Limitación de velocidad: Añade

time.sleep()entre solicitudes. Sirobots.txtindicaCrawl-delay: 5, espera al menos 5 segundos. - User-Agent personalizado: Identifica tu scraper de forma educada (por ejemplo,

"MiScraper/1.0 (tu@email.com)"). - Lógica de reintentos: Usa bloques try/except. Reintenta en caso de fallos y espera si recibes HTTP 429 (demasiadas solicitudes).

5. Extrae y limpia los datos

Usa BeautifulSoup o selectores de Scrapy para extraer los campos. Limpia espacios, convierte precios a números, analiza fechas y valida la integridad. Para grandes volúmenes, usa pandas para limpiar y eliminar duplicados.

6. Scraping de subpáginas

Muchas veces, la información valiosa está en páginas de detalle. Extrae una lista de enlaces y visita cada uno para obtener más datos. En Python, esto implica recorrer URLs y obtener cada página. En , puedes usar la función “Scrape Subpages” para automatizar este paso—la IA visitará cada subpágina y enriquecerá tu dataset.

7. Exporta y automatiza

Exporta tus datos limpios a CSV, Excel, Google Sheets o una base de datos. Para tareas recurrentes, programa tu script con cron, Airflow o (si usas Thunderbit) configura un scraping programado en la nube usando lenguaje natural (“cada lunes a las 9am”).

Thunderbit: cuando la IA potencia tu flujo de scraping con Python

Hablemos claro: a veces, ni el mejor código en Python puede con datos desordenados, no estructurados o protegidos. Ahí es donde entra .

Cómo Thunderbit complementa a Python

Thunderbit es una extensión de Chrome impulsada por IA que lee páginas web (o PDFs, imágenes, etc.) y genera datos estructurados—sin necesidad de programar. Así la combino con Python:

- Para datos no estructurados: Si me topo con un PDF, imagen o un sitio con HTML impredecible, dejo que la IA de Thunderbit lo procese. Puede extraer tablas de PDFs, sacar texto de imágenes e incluso sugerir campos automáticamente.

- Para scraping de subpáginas y pasos múltiples: La función “Scrape Subpages” de Thunderbit ahorra mucho tiempo. Extrae una página de listado y deja que la IA visite cada detalle y combine los resultados—sin bucles anidados ni gestión de estados.

- Para exportar: Thunderbit exporta directamente a Excel, Google Sheets, Notion o Airtable. Luego puedo importar esos datos a mi pipeline de Python para análisis o reportes.

Ejemplo real: Python + Thunderbit en acción

Supón que estoy monitoreando anuncios inmobiliarios. Uso Python y Scrapy para recolectar URLs de listados de varios sitios. Pero uno de ellos solo publica especificaciones detalladas en PDFs descargables. En vez de programar un parser de PDF, subo esos archivos a Thunderbit, dejo que la IA extraiga las tablas y exporto a CSV. Luego, uno todos los datos en Python para un análisis de mercado unificado.

O, si estoy creando una lista de leads para ventas. Uso Python para extraer URLs de empresas y luego los extractores de email y teléfono de Thunderbit (¡funciones gratuitas!) para obtener contactos de cada sitio—sin dolores de cabeza con regex.

Construyendo un flujo de scraping sostenible: del código al pipeline

Un script puntual es útil para una tarea rápida, pero la mayoría de necesidades de scraping en negocios son recurrentes. Así estructuro un stack de scraping escalable y fácil de mantener:

El marco CCCD: Crawl, Collect, Clean, Debug

- Crawl: Junta todas las URLs objetivo (de sitemaps, páginas de búsqueda o listas).

- Collect: Extrae datos de cada URL (con Python, Thunderbit o ambos).

- Clean: Normaliza, elimina duplicados y valida los datos.

- Debug/Monitor: Registra cada ejecución, maneja errores y configura alertas para fallos o anomalías.

Imagínalo como una tubería:

URLs → [Crawler] → [Scraper] → [Cleaner] → [Exporter] → [Plataforma de negocio]

Programación y monitoreo

- Con Python: Usa cron jobs, Airflow o programadores en la nube para ejecutar scripts periódicamente. Registra salidas y envía alertas por email o Slack ante errores.

- Con Thunderbit: Usa el programador integrado—solo escribe “cada lunes a las 9am” y Thunderbit ejecutará el scraping en la nube y exportará los datos donde los necesites.

Documentación y traspaso

Guarda tu código en control de versiones (Git), documenta el flujo y asegúrate de que al menos otra persona sepa cómo ejecutar o actualizar el pipeline. Para flujos mixtos Python/Thunderbit, anota qué herramienta maneja cada sitio y dónde se almacenan los resultados (ejemplo: “Thunderbit extrae el sitio C a Google Sheets, Python une todos los datos semanalmente”).

Ética y cumplimiento: raspado responsable en 2025

Con gran poder de scraping viene gran responsabilidad. Así te mantienes dentro de la ley y las buenas prácticas:

Robots.txt y limitación de velocidad

- Revisa robots.txt: Siempre consulta el robots.txt del sitio para rutas prohibidas y retrasos. Usa

robotparserde Python para automatizarlo. - Scraping educado: Añade pausas entre solicitudes, especialmente si hay

Crawl-delay. Nunca satures un sitio con peticiones rápidas. - User-Agent: Identifica tu scraper honestamente. No finjas ser Googlebot ni otro navegador.

Privacidad de datos y cumplimiento

- GDPR/CCPA: Si extraes datos personales (nombres, emails, teléfonos), eres responsable de cumplir las leyes de privacidad. Solo extrae lo necesario, protege los datos y prepárate para eliminarlos si te lo solicitan.

- Términos de servicio: No extraigas detrás de logins sin permiso. Muchos ToS prohíben el acceso automatizado—incumplirlos puede llevar a bloqueos o consecuencias legales.

- Solo datos públicos: Limítate a información disponible públicamente. No intentes extraer datos privados, con copyright o sensibles.

Lista de verificación de cumplimiento

- [ ] Revisado robots.txt para reglas y retrasos

- [ ] Añadida limitación de velocidad y User-Agent personalizado

- [ ] Extrayendo solo datos públicos y no sensibles

- [ ] Gestionando datos personales conforme a la ley

- [ ] Sin violar ToS ni derechos de autor

Errores comunes y consejos de depuración: haz tu scraping más robusto

Incluso los mejores scrapers encuentran obstáculos. Aquí los problemas más frecuentes—y cómo los resuelvo:

| Tipo de error | Síntoma/Mensaje | Consejo de depuración |

|---|---|---|

| HTTP 403/429/500 | Bloqueo, límite de velocidad o error del servidor | Revisa headers, reduce la velocidad, rota IPs o usa proxies. Respeta los retrasos de rastreo. |

| Datos faltantes/NoneType | Datos no encontrados en el HTML | Imprime e inspecciona el HTML. Puede que la estructura haya cambiado o sea una página de bloqueo. |

| Datos renderizados por JavaScript | Datos ausentes en HTML estático | Usa Selenium/Playwright o busca la llamada API subyacente. |

| Problemas de parsing/codificación | Errores Unicode, caracteres extraños | Configura la codificación correcta, usa .text o html.unescape(). |

| Duplicados/inconsistencias | Datos repetidos o desiguales | Elimina duplicados por ID único o URL. Valida la integridad de los campos. |

| Anti-bot/CAPTCHA | Página de CAPTCHA o login requerido | Reduce la velocidad, usa automatización de navegador o cambia a Thunderbit/IA para casos difíciles. |

Flujo de depuración:

- Imprime el HTML bruto cuando algo falle.

- Usa las DevTools del navegador para comparar lo que ve tu script vs. el navegador.

- Registra cada paso—URLs, códigos de estado, número de elementos extraídos.

- Prueba con una muestra pequeña antes de escalar.

Ideas de proyectos avanzados: lleva tu scraping con Python al siguiente nivel

¿Listo para poner en práctica las mejores técnicas? Aquí tienes proyectos reales para probar:

1. Panel de monitoreo de precios para e-commerce

Extrae precios y stock de Amazon, eBay y Walmart. Maneja medidas anti-bot, contenido dinámico y exporta diariamente a Google Sheets para análisis de tendencias. Usa para resultados rápidos.

2. Agregador de ofertas de empleo

Reúne anuncios de empleo de Indeed y portales especializados. Extrae títulos, empresas, ubicaciones y fechas de publicación. Maneja paginación y elimina duplicados por ID de oferta. Programa ejecuciones diarias y exporta a Airtable.

3. Extractor de contactos para generación de leads

Dada una lista de URLs de empresas, extrae emails y teléfonos de las páginas principales y de contacto. Usa regex en Python o los extractores gratuitos de Thunderbit para resultados instantáneos. Exporta a Excel para tu equipo de ventas.

4. Comparador de anuncios inmobiliarios

Extrae listados de Zillow y Realtor.com para una región específica. Normaliza direcciones y precios, compara tendencias y visualiza resultados en Google Sheets.

5. Monitor de menciones en redes sociales

Rastrea menciones de marca en Reddit usando su API JSON. Agrega recuentos de publicaciones, analiza sentimiento y exporta datos temporales para insights de marketing.

Conclusión: puntos clave para el scraping con Python en 2025

Vamos a resumir lo más importante:

- El scraping web es más crucial que nunca para inteligencia de negocio, ventas y operaciones. La web es una mina de oro—si sabes cómo extraerla.

- Python es tu navaja suiza: Empieza simple con

requestsyBeautifulSoup, escala con Scrapy y usa automatización de navegador para sitios dinámicos. - Las herramientas de IA como Thunderbit son tu as bajo la manga para scraping complejo, no estructurado o sin código. Combina Python e IA para máxima eficiencia.

- Las buenas prácticas importan: Inspecciona primero, programa de forma modular, maneja errores, limpia tus datos y automatiza tu flujo.

- El cumplimiento no es opcional: Revisa siempre robots.txt, respeta las leyes de privacidad y haz scraping de forma ética.

- Mantente flexible: La web cambia—monitorea tus scrapers, depura a menudo y prepárate para ajustar tu enfoque.

El futuro del scraping web es híbrido, ético y orientado al negocio. Seas principiante o experto, sigue aprendiendo, mantente curioso y deja que los datos impulsen tu próximo gran logro.

Apéndice: recursos y herramientas para scraping con Python

Aquí tienes mi lista de referencia para aprender y resolver problemas:

- – HTTP para humanos, con todas las opciones.

- – Aprende a analizar HTML como un profesional.

- – Para scraping a gran escala y en producción.

- / – Para automatización de navegador y contenido dinámico.

- – El Raspador Web IA más sencillo para usuarios de negocio.

- – Tutoriales, casos de uso y mejores prácticas de scraping con IA.

- – Mantente al día en cumplimiento y ética.

- / ** – Comunidad para preguntas y resolución de problemas.

Y si quieres ver cómo Thunderbit puede facilitarte el scraping, visita nuestro para demos y tutoriales.

Preguntas frecuentes

1. ¿Cuál es la mejor librería de Python para scraping web en 2025?

Para páginas estáticas y tareas pequeñas, requests + BeautifulSoup sigue siendo la combinación ideal. Para scraping a gran escala o multipágina, es la mejor opción. Para contenido dinámico, usa o . Para datos complejos o no estructurados, las herramientas de IA como son muy útiles.

2. ¿Cómo manejo sitios con mucho JavaScript o dinámicos?

Utiliza herramientas de automatización de navegador como Selenium o Playwright para renderizar la página y extraer los datos. Alternativamente, inspecciona la pestaña de red para encontrar llamadas API que devuelvan JSON—suelen ser más fáciles y fiables de extraer.

3. ¿Es legal el scraping web?

Extraer datos públicos suele ser legal en EE.UU., pero revisa siempre el , respeta los términos del sitio y cumple con leyes de privacidad como GDPR/CCPA. Nunca extraigas información privada, con copyright o sensible.

4. ¿Cómo puedo automatizar y programar mis flujos de scraping?

Para scripts en Python, usa cron jobs, Airflow o programadores en la nube. Para automatización sin código, ofrece programación integrada—solo describe tu horario en lenguaje natural y deja que se ejecute en la nube.

5. ¿Qué hago si mi scraper deja de funcionar?

Primero, revisa si la estructura del sitio cambió o si te están bloqueando (HTTP 403/429). Inspecciona el HTML, actualiza tus selectores, reduce la velocidad de las solicitudes y verifica medidas anti-bot. Si el problema persiste, prueba las funciones de IA de Thunderbit o cambia a automatización de navegador.

¡Feliz scraping! Que tus datos siempre sean limpios, legales y listos para usar. Si quieres ver cómo Thunderbit puede integrarse en tu flujo de trabajo, y pruébala. Y si buscas más consejos, el siempre está disponible.