Seamos realistas: nadie se despierta con ganas de copiar y pegar 500 filas de precios de productos en una hoja de cálculo. (Si eres de esos, te admiro y te recomiendo una buena muñequera). Ya trabajes en ventas, operaciones o simplemente quieras que tu empresa vaya un paso por delante de la competencia, seguro que alguna vez has sufrido intentando recopilar datos de páginas web. Hoy en día, los datos web son el combustible de los negocios y la demanda de extracción automatizada está creciendo a toda velocidad—.

Llevo años metido en el mundo SaaS y la automatización, y he visto de todo: desde macros épicas en Excel hasta scripts de Python hechos a las tantas de la madrugada. En esta guía te voy a enseñar cómo usar un analizador HTML en Python para extraer datos reales (sí, vamos a sacar las valoraciones de películas de IMDb juntos), y también te mostraré por qué, en 2025, existen alternativas mucho más eficientes—herramientas con IA como que te permiten olvidarte del código y centrarte directamente en los resultados.

¿Qué es un analizador HTML y por qué usarlo en Python?

Vamos a lo básico: ¿para qué sirve realmente un analizador HTML? Piensa en él como tu bibliotecario personal de la web. Lee el HTML caótico de una página y lo convierte en una estructura ordenada y jerárquica. Así puedes sacar solo la información que te interesa—títulos, precios, enlaces—sin perderte entre etiquetas y divs.

Python es el lenguaje favorito para esto, y no es casualidad. Es fácil de entender, perfecto para quienes empiezan y tiene un montón de librerías para scraping y análisis de HTML. De hecho, , gracias a su curva de aprendizaje suave y a su comunidad tan activa.

Los principales analizadores HTML en Python

Estos son los cracks cuando se trata de analizar HTML en Python:

- BeautifulSoup: El de toda la vida, ideal para quienes empiezan.

- lxml: Súper rápido y potente, permite consultas avanzadas.

- html5lib: Muy tolerante con HTML desordenado, como lo haría tu navegador.

- PyQuery: Permite usar selectores tipo jQuery en Python.

- HTMLParser: El analizador que viene con Python—siempre disponible, aunque algo básico.

Cada uno tiene sus particularidades, pero todos te ayudan a convertir HTML en datos bien estructurados.

Casos de uso clave: cómo las empresas aprovechan los analizadores HTML en Python

La extracción de datos web ya no es solo cosa de técnicos o científicos de datos. Ahora es una actividad clave para muchas áreas de negocio, sobre todo ventas y operaciones. ¿Por qué?

| Caso de uso (Industria) | Datos extraídos habitualmente | Beneficio para el negocio |

|---|---|---|

| Monitoreo de precios (Retail) | Precios de la competencia, stock | Precios dinámicos, mejores márgenes (fuente) |

| Inteligencia de productos de la competencia | Listados, reseñas, disponibilidad | Detectar oportunidades, generar leads (fuente) |

| Generación de leads (Ventas B2B) | Nombres de empresas, emails, contactos | Prospección automatizada, crecimiento del pipeline (fuente) |

| Análisis de sentimiento (Marketing) | Publicaciones, reseñas, valoraciones | Feedback en tiempo real, detectar tendencias (fuente) |

| Agregadores inmobiliarios | Listados, precios, datos de agentes | Análisis de mercado, estrategia de precios (fuente) |

| Inteligencia de reclutamiento | Perfiles, salarios | Búsqueda de talento, benchmarking salarial (fuente) |

En resumen: si sigues copiando datos a mano, estás perdiendo tiempo y dinero.

Conoce las principales librerías de análisis HTML en Python

Vamos a lo práctico. Aquí tienes una comparativa rápida de las librerías más populares para analizar HTML en Python, para que elijas la que mejor te encaje:

| Librería | Facilidad de uso | Velocidad | Flexibilidad | Mantenimiento | Ideal para |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | Moderado | Principiantes, HTML desordenado |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | Moderado | Velocidad, XPath, documentos grandes |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | Bajo | Parsing tipo navegador, HTML roto |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | Moderado | Fans de jQuery, selectores CSS |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | Bajo | Tareas simples, integrado |

BeautifulSoup: la opción más amigable para principiantes

BeautifulSoup es el “hola mundo” del análisis HTML. Su sintaxis es sencilla, la documentación es clara y es muy tolerante con HTML mal formado (). ¿El punto flojo? No es la más rápida, sobre todo en páginas grandes o complejas, y no soporta selectores avanzados como XPath de forma nativa.

lxml: velocidad y potencia

Si necesitas rapidez o quieres usar consultas XPath, lxml es tu mejor amigo (). Está construido sobre librerías en C, así que es muy veloz, aunque puede ser más complicado de instalar y tiene una curva de aprendizaje más pronunciada.

Otras opciones: html5lib, PyQuery y HTMLParser

- html5lib: Analiza HTML igual que tu navegador—perfecto para código roto o raro, pero es lento ().

- PyQuery: Permite usar selectores tipo jQuery en Python, ideal si vienes del mundo front-end ().

- HTMLParser: Opción integrada en Python—rápida y siempre disponible, aunque con menos funcionalidades.

Paso 1: Configura tu entorno de análisis HTML en Python

Antes de analizar nada, tienes que preparar tu entorno de Python. Así se hace:

-

Instala Python: Descárgalo desde si aún no lo tienes.

-

Instala pip: Suele venir con Python 3.4+, pero puedes comprobarlo ejecutando

pip --versionen la terminal. -

Instala las librerías (usaremos BeautifulSoup y requests en este tutorial):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4es el analizador.requestste permite obtener páginas web.lxmles un analizador rápido que BeautifulSoup puede usar por dentro.

-

Verifica la instalación:

1python -c "import bs4, requests, lxml; print('¡Todo listo!')"

Trucos para resolver problemas:

- Si tienes errores de permisos, prueba con

pip install --user ... - En Mac/Linux, puede que necesites usar

python3ypip3. - Si ves “ModuleNotFoundError”, revisa la ortografía y el entorno de Python.

Paso 2: Analiza tu primera página web con Python

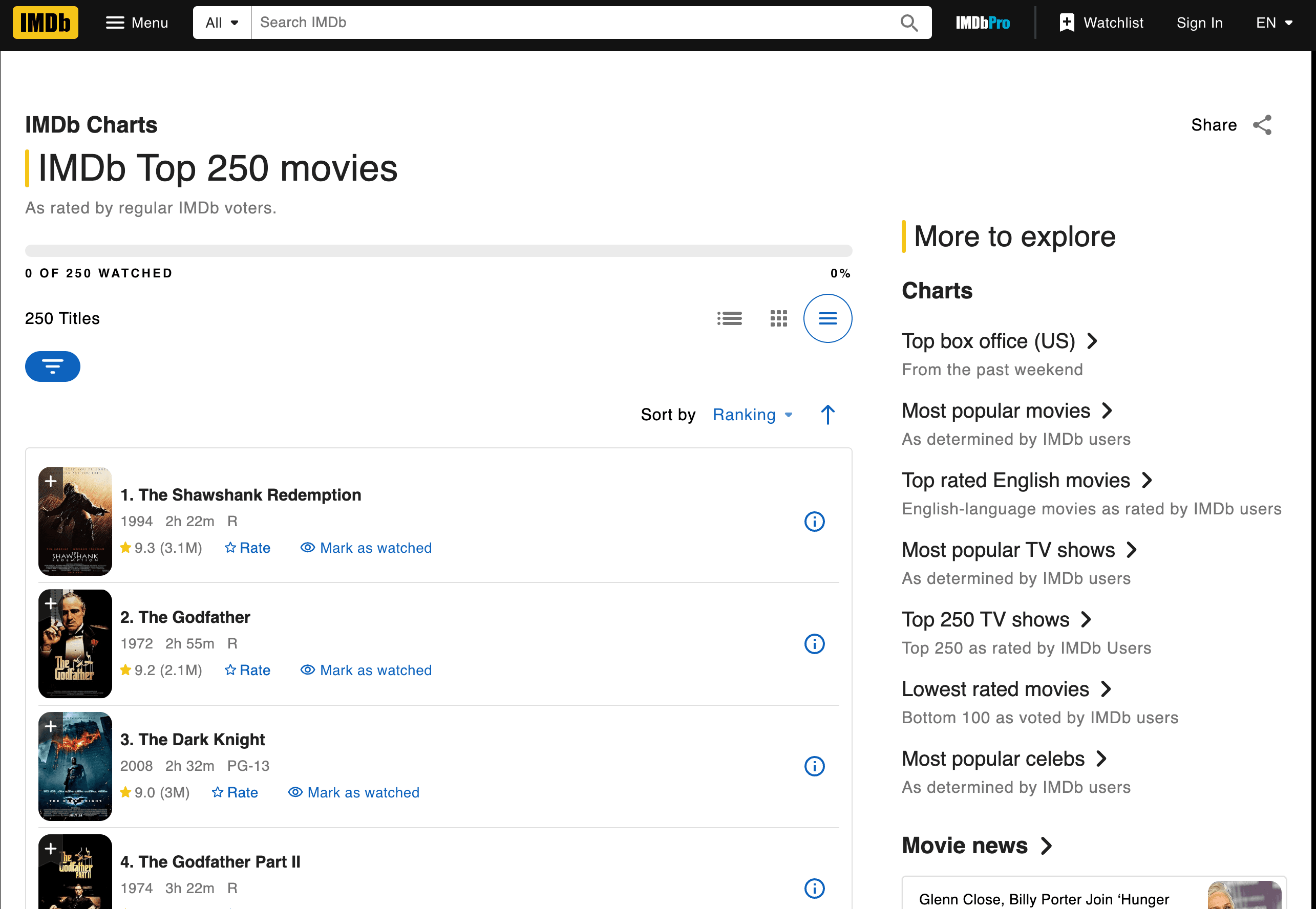

Vamos a ponernos manos a la obra y extraer los datos de las 250 mejores películas de IMDb. Sacaremos los títulos, años y valoraciones.

Descargando y analizando la página

Aquí tienes un script paso a paso:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# Encuentra todas las celdas de título y valoración

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# Itera sobre las primeras 3 películas como ejemplo

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Rating: {rating}")¿Qué está pasando aquí?

- Usamos

requests.get()para descargar la página. BeautifulSoupanaliza el HTML.- Buscamos los elementos

<td>relevantes por su clase. - Extraemos el texto de título, año y valoración.

Resultado:

11. The Shawshank Redemption (1994) -- Rating: 9.3

22. The Godfather (1972) -- Rating: 9.2

33. The Dark Knight (2008) -- Rating: 9.0Extrayendo datos: cómo identificar títulos, valoraciones y más

¿Cómo supe qué etiquetas y clases usar? Inspeccioné el HTML de la página de IMDb (clic derecho > Inspeccionar elemento en tu navegador). Busca patrones—en este caso, cada película está en un <td class="titleColumn"> y las valoraciones en <td class="ratingColumn imdbRating"> ().

Truco de la casa: Si vas a extraer datos de otra web, empieza inspeccionando la estructura HTML y localizando nombres de clase o etiquetas únicas.

Guardando y exportando tus resultados

Vamos a guardar los datos en un archivo CSV:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Title', 'Year', 'Rating'])

13 writer.writerows(movies)Consejos de limpieza:

- Usa

.strip()para quitar espacios en blanco. - Maneja datos faltantes con condicionales

if. - Para exportar a Excel, abre el CSV en Excel o usa

pandaspara escribir archivos.xlsx.

Paso 3: Cómo lidiar con cambios en el HTML y retos de mantenimiento

Aquí es donde la cosa se complica. Los sitios web suelen cambiar su diseño—y a veces parece que lo hacen solo para fastidiar a los scrapers. Si IMDb cambia class="titleColumn" por class="movieTitle", tu script dejará de funcionar de repente. Me ha pasado, créeme.

Cuando los scripts fallan: problemas reales

Problemas típicos:

- Selectores no encontrados: Tu código no localiza la etiqueta o clase indicada.

- Resultados vacíos: La estructura de la página cambió o el contenido ahora se carga con JavaScript.

- Errores HTTP: El sitio ha puesto medidas anti-bots.

¿Qué hacer?

- Comprueba que el HTML que analizas coincide con el que ves en el navegador.

- Actualiza tus selectores según la nueva estructura.

- Si el contenido se carga dinámicamente, quizá debas usar una herramienta de automatización de navegador (como Selenium) o buscar un endpoint de API.

¿El verdadero dolor de cabeza? Si extraes datos de 10, 50 o 500 sitios distintos, acabarás dedicando más tiempo a arreglar scripts que a analizar datos ().

Paso 4: Escalando—los costes ocultos del análisis HTML manual en Python

Supón que quieres extraer datos no solo de IMDb, sino también de Amazon, Zillow, LinkedIn y muchos otros sitios. Cada uno necesita su propio script. Y cada vez que un sitio cambia, tienes que volver al editor de código.

Los costes ocultos:

- Mantenimiento: .

- Infraestructura: Necesitarás proxies, gestión de errores y monitorización.

- Rendimiento: Escalar implica manejar concurrencia, límites de velocidad y más.

- Control de calidad: Más scripts = más puntos donde pueden fallar las cosas.

Para equipos no técnicos, esto se vuelve insostenible muy rápido. Es como contratar un ejército de becarios para copiar y pegar datos todo el día—solo que los becarios son scripts de Python y se “ponen malos” cada vez que cambia una web.

Más allá de los analizadores HTML en Python: conoce Thunderbit, la alternativa con IA

Aquí es donde la cosa se pone interesante. ¿Y si pudieras olvidarte del código, del mantenimiento y obtener los datos que necesitas—sin importar cómo cambie la web?

Eso es justo lo que hemos creado con . Es una extensión de Chrome con IA que te permite extraer datos estructurados de cualquier web en solo dos clics. Sin Python, sin scripts, sin dolores de cabeza.

Analizadores HTML en Python vs. Thunderbit: comparación directa

| Aspecto | Analizadores HTML en Python | Thunderbit (ver precios) |

|---|---|---|

| Tiempo de configuración | Alto (instalar, programar, depurar) | Bajo (instalar extensión, clic) |

| Facilidad de uso | Requiere programación | Sin código—selecciona y listo |

| Mantenimiento | Alto (los scripts fallan a menudo) | Bajo (la IA se adapta sola) |

| Escalabilidad | Complejo (scripts, proxies, infraestructura) | Integrado (scraping en la nube, trabajos por lotes) |

| Enriquecimiento de datos | Manual (más código) | Integrado (etiquetado, limpieza, traducción, subpáginas) |

¿Para qué programar si puedes resolverlo con IA?

¿Por qué elegir IA para la extracción de datos web?

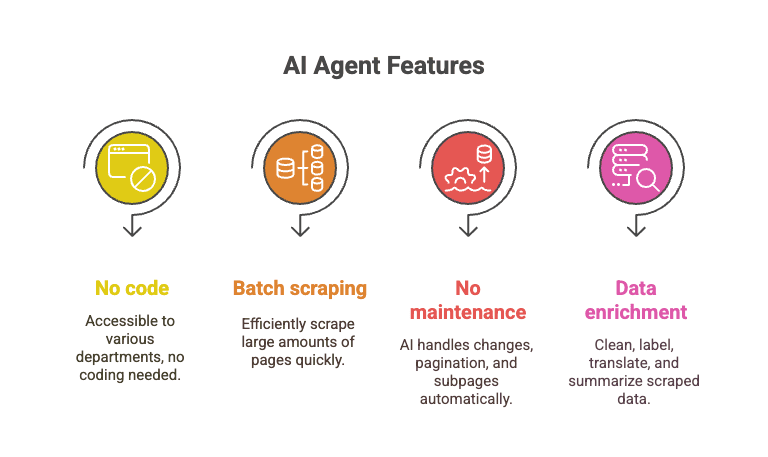

El agente de IA de Thunderbit analiza la página, entiende su estructura y se adapta cuando hay cambios. Es como tener un super-becario que nunca duerme y nunca se queja si cambian los nombres de las clases.

- Sin necesidad de programar: Cualquiera puede usarlo—ventas, operaciones, marketing, etc.

- Scraping por lotes: Extrae datos de más de 10,000 páginas en el tiempo que tardarías en depurar un solo script de Python.

- Sin mantenimiento: La IA gestiona cambios de diseño, paginación, subpáginas y más.

- Enriquecimiento de datos: Limpia, etiqueta, traduce y resume los datos mientras los extraes.

Imagina extraer todas las películas del Top 250 de IMDb, más los detalles de cada una y sus reseñas, en unos pocos clics—mientras tus scripts de Python siguen atascados en la línea 12 con un error de “NoneType”.

Paso a paso: extrayendo valoraciones de películas de IMDb con Thunderbit

Veamos cómo Thunderbit resuelve la misma tarea de IMDb:

- Instala la .

- Entra en la .

- Haz clic en el icono de Thunderbit.

- Haz clic en “AI Suggest Fields”. Thunderbit leerá la página y te sugerirá columnas (Título, Año, Valoración).

- Revisa o ajusta las columnas si lo necesitas.

- Haz clic en “Scrape”. Thunderbit extraerá las 250 filas al instante.

- Exporta a Excel, Google Sheets, Notion o CSV—como prefieras.

Eso es todo. Sin código, sin depurar, sin momentos de “¿por qué está vacía la lista?”.

¿Quieres verlo en acción? Mira los tutoriales en el o revisa nuestra para otro ejemplo real.

Conclusión: elige la herramienta adecuada para tus necesidades de datos web

Los analizadores HTML en Python como BeautifulSoup y lxml son potentes, flexibles y gratuitos. Son perfectos para desarrolladores que quieren control total y no les importa ensuciarse las manos. Pero tienen una curva de aprendizaje, requieren mantenimiento constante y pueden generar costes ocultos—sobre todo si tus necesidades de scraping crecen.

Para usuarios de negocio, equipos de ventas o cualquiera que solo quiera los datos (y no el código), las herramientas con IA como son una auténtica revolución. Permiten extraer, limpiar y enriquecer datos web a gran escala, sin programar y sin preocuparse por el mantenimiento.

¿Mi consejo? Usa Python si disfrutas programando y necesitas personalización total. Pero si valoras tu tiempo (y tu tranquilidad), dale una oportunidad a Thunderbit. ¿Para qué crear y cuidar scripts si la IA puede hacer el trabajo duro por ti?

¿Quieres aprender más sobre web scraping, extracción de datos y automatización con IA? Explora más tutoriales en el , como o .