La web en 2026 es como el lejano oeste digital: la mitad del tráfico viene de bots, y los rastreadores web open-source son los héroes anónimos que hacen posible desde comparar precios hasta entrenar modelos de IA. Después de años metido en SaaS y automatización, te puedo decir que elegir el rastreador autoalojado correcto te puede ahorrar meses de dolores de cabeza (y varias noches sin dormir peleando con bugs). Ya sea que solo quieras sacar datos de unas cuantas páginas de productos o que necesites rastrear millones de URLs para investigación, las alternativas open-source a Firecrawl que te traigo aquí cubren cualquier necesidad, sin importar el tamaño de tu proyecto, tu stack o el nivel de complejidad que busques.

Pero ojo: no hay una herramienta mágica que sirva para todo. Algunos equipos necesitan la potencia bruta de Scrapy o la capacidad de archivo de Heritrix, mientras que otros pueden ver que mantener librerías open-source es demasiado trabajo. Así que aquí te presento las 9 mejores alternativas open-source a Firecrawl para 2026, con lo que destaca cada una y cómo elegir la ideal para tu negocio—sin tener que pasar por el calvario de prueba y error.

Cómo elegir la mejor alternativa open-source a Firecrawl para tu empresa

Antes de lanzarnos a la lista, hablemos de estrategia. El mundo de los rastreadores web open-source nunca ha sido tan variado, y tu elección depende de varios factores clave:

- Facilidad de uso: ¿Prefieres una interfaz visual o te manejas bien programando en Python, Go o JavaScript?

- Escalabilidad: ¿Solo vas a extraer datos de un sitio o necesitas rastrear millones de páginas en cientos de dominios?

- Tipo de contenido: ¿El sitio objetivo es HTML estático o depende mucho de JavaScript y carga dinámica?

- Integraciones: ¿Cómo quieres usar los datos? ¿Exportar a Excel, mandar a una base de datos o alimentar un pipeline de analítica?

- Mantenimiento: ¿Tienes recursos para mantener código propio o prefieres una herramienta que se adapte sola a los cambios de los sitios?

Aquí tienes una tabla rápida para orientarte:

| Escenario | Mejor herramienta(s) |

|---|---|

| Sin código, navegación offline | HTTrack |

| Rastreo a gran escala y multidominio | Scrapy, Apache Nutch, StormCrawler |

| Sitios dinámicos/con mucho JS | Puppeteer |

| Automatización de formularios/login | MechanicalSoup |

| Descarga/archivo de sitios estáticos | Wget, HTTrack, Heritrix |

| Desarrollador Go, alto rendimiento | Colly |

Ahora sí, vamos con las 9 mejores alternativas open-source a Firecrawl para 2026.

1. Scrapy: Perfecto para rastreos a gran escala en Python

es el peso pesado de los rastreadores web open-source. Hecho en Python, es la opción favorita para quienes necesitan rastrear a lo grande—hablamos de millones de páginas, actualizaciones constantes y lógica compleja.

¿Por qué elegir Scrapy?

- Escalabilidad brutal: Scrapy puede manejar miles de peticiones por segundo y lo usan empresas que extraen miles de millones de páginas al mes ().

- Extensible y modular: Puedes crear spiders a medida, añadir middlewares para proxies, gestionar logins y exportar a JSON, CSV o bases de datos.

- Comunidad activa: Hay montones de plugins, documentación y respuestas en Stack Overflow.

- Probado en producción: Lo usan equipos de e-commerce, medios y centros de investigación en todo el mundo.

Limitaciones: La curva de aprendizaje es dura si no eres desarrollador, y tendrás que mantener tus spiders cuando los sitios cambien. Pero si buscas control total y escalabilidad, Scrapy es difícil de igualar.

2. Apache Nutch: El rey para motores de búsqueda empresariales

es el abuelo de los rastreadores open-source, pensado para rastreos a escala de Internet y uso empresarial. Si sueñas con crear tu propio motor de búsqueda o rastrear millones de dominios, Nutch es tu mejor amigo.

¿Por qué Apache Nutch?

- Escalabilidad con Hadoop: Basado en Hadoop, Nutch puede rastrear miles de millones de páginas en clústeres de servidores ( lo usa para rastrear la web pública).

- Rastreo por lotes: Le das una lista de URLs y lo dejas trabajar—ideal para tareas programadas y de gran volumen.

- Integración: Compatible con Solr, Elasticsearch y pipelines de big data.

Limitaciones: Configuración compleja (clústeres Hadoop, archivos de configuración en Java), y está más orientado al rastreo masivo que a la extracción de datos estructurados. Es demasiado para proyectos pequeños, pero imbatible para rastreos a escala web.

3. Heritrix: El mejor para archivado web y cumplimiento

es el rastreador de la Internet Archive, creado especialmente para archivado web y preservación digital.

¿Por qué Heritrix?

- Archivado total: Captura cada página, recurso y enlace—ideal para cumplimiento legal o snapshots históricos.

- Salida WARC: Guarda todo en archivos Web ARChive estandarizados, listos para análisis o reproducción.

- Administración web: Configura y monitorea rastreos desde una interfaz web.

Limitaciones: Consume muchos recursos (disco y memoria), no ejecuta JavaScript y genera archivos de archivo en bruto, no tablas de datos estructurados. Perfecto para bibliotecas, archivos o sectores regulados.

4. Colly: El favorito de los devs Go que buscan velocidad

es el preferido de los desarrolladores Go: rápido, ligero y con alta concurrencia.

¿Por qué Colly?

- Velocidad brutal: La concurrencia de Go permite a Colly rastrear miles de páginas usando pocos recursos ().

- API sencilla: Define callbacks para elementos HTML, gestiona cookies y robots.txt automáticamente.

- Ideal para sitios estáticos: Perfecto para páginas renderizadas en servidor, APIs o cuando quieres integrar el rastreo en un backend Go.

Limitaciones: No incluye renderizado de JavaScript (para sitios dinámicos, tendrás que combinarlo con algo como Chromedp), y necesitas saber Go.

5. MechanicalSoup: Automatización sencilla de formularios

es una librería Python que cubre el hueco entre simples peticiones HTTP y la automatización completa de navegadores.

¿Por qué MechanicalSoup?

- Automatización de formularios: Permite iniciar sesión, rellenar formularios y mantener sesiones fácilmente—ideal para extraer datos tras autenticación.

- Ligero: Usa Requests y BeautifulSoup, así que es rápido y fácil de configurar.

- Perfecto para sitios interactivos: Si necesitas enviar formularios de búsqueda o extraer datos tras login, MechanicalSoup es una gran opción ().

Limitaciones: No ejecuta JavaScript, así que no sirve para sitios con mucho JS. Mejor para páginas estáticas o renderizadas en servidor con interacciones simples.

6. Puppeteer: El as para sitios dinámicos y con mucho JavaScript

es la navaja suiza para extraer datos de sitios modernos y llenos de JavaScript. Es una librería Node.js que te da control total sobre un navegador Chrome sin interfaz.

¿Por qué Puppeteer?

- Maneja contenido dinámico: Extrae datos de SPAs, scroll infinito y páginas que cargan datos vía AJAX ().

- Simulación de usuario: Haz clics, rellena formularios, toma capturas de pantalla e incluso resuelve CAPTCHAs (con plugins).

- Automatización potente: Ideal para testing, monitoreo y extracción de cualquier cosa que vea un usuario real.

Limitaciones: Consume muchos recursos (ejecuta instancias completas de Chrome), es más lento que los scrapers solo HTTP y escalarlo requiere hardware potente o soluciones en la nube.

7. Wget: El clásico para descargas rápidas desde la terminal

es la herramienta clásica de línea de comandos para descargar sitios y archivos estáticos.

¿Por qué Wget?

- Simplicidad: Descarga sitios o directorios completos con un solo comando—sin necesidad de programar.

- Velocidad: Escrito en C, es rápido y eficiente.

- Ideal para contenido estático: Perfecto para sitios de documentación, blogs o descargas masivas de archivos ().

Limitaciones: No ejecuta JavaScript ni gestiona formularios, y descarga páginas en bruto (no datos estructurados). Piénsalo como una aspiradora digital para sitios estáticos.

8. HTTrack: El más fácil para navegación offline (sin código)

es el primo amigable de Wget, con una interfaz gráfica para clonar sitios web.

¿Por qué HTTrack?

- Simplicidad visual: Un asistente paso a paso lo hace accesible para usuarios sin conocimientos técnicos.

- Navegación offline: Ajusta los enlaces para que puedas explorar los sitios clonados localmente.

- Ideal para archivado: Perfecto para investigadores, marketers o cualquiera que quiera una copia de un sitio sin programar ().

Limitaciones: No soporta contenido dinámico, puede ser lento en sitios grandes y no está pensado para extraer datos estructurados.

9. StormCrawler: El pro para rastreo distribuido en tiempo real

es el rastreador distribuido y moderno para equipos que necesitan datos web en tiempo real y a gran escala.

¿Por qué StormCrawler?

- Rastreo en tiempo real: Basado en Apache Storm, procesa datos como flujos—ideal para monitoreo de noticias o motores de búsqueda ().

- Modular y escalable: Añade módulos de parsing, indexado y procesamiento personalizado según lo necesites.

- Usado por Common Crawl: Alimenta el dataset de noticias de uno de los mayores archivos web abiertos.

Limitaciones: Requiere desarrollo en Java y un clúster Storm, así que es mejor para equipos con experiencia en sistemas distribuidos. Es demasiado para proyectos pequeños.

Comparativa de alternativas open-source a Firecrawl: ¿Qué competidor gratuito te conviene?

Aquí tienes una comparativa de las 9 herramientas:

| Herramienta | Mejor caso de uso | Ventajas clave | Desventajas | Lenguaje / Configuración |

|---|---|---|---|---|

| Scrapy | Rastreo frecuente y a gran escala | Potente, escalable, gran comunidad | Curva de aprendizaje, requiere Python | Framework Python |

| Apache Nutch | Rastreo empresarial y a escala web | Escalabilidad Hadoop, probado en grandes | Configuración compleja, por lotes | Java/Hadoop |

| Heritrix | Archivado y cumplimiento | Captura completa, salida WARC | Pesado, sin JS, archivos en bruto | App Java, interfaz web |

| Colly | Devs Go, scraping de alto rendimiento | Rápido, API simple, concurrencia | Sin JS, requiere Go | Librería Go |

| MechanicalSoup | Automatización de formularios/login | Ligero, gestiona sesiones | Sin JS, escala limitada | Librería Python |

| Puppeteer | Sitios dinámicos/con mucho JS | Control total, automatización | Requiere recursos, Node.js necesario | Librería Node.js |

| Wget | Descarga de sitios estáticos, acceso offline | Simple, rápido, CLI | Sin JS, páginas en bruto | Herramienta de línea de comandos |

| HTTrack | Usuarios no técnicos, archivado | GUI, navegación offline fácil | Sin JS, lento en sitios grandes | App de escritorio (GUI) |

| StormCrawler | Rastreo distribuido en tiempo real | Escalable, modular, en tiempo real | Requiere Java/Storm | Clúster Java/Storm |

¿Conviene crear tu propio rastreador o usar una alternativa open-source?

La verdad es que crear tu propio rastreador suena tentador—hasta que te topas con el mantenimiento, los proxies y los bloqueos anti-bot. Las herramientas open-source de arriba condensan años de experiencia y conocimiento de la comunidad. Según los expertos, usar soluciones existentes es la forma más rápida y confiable de obtener resultados y no reinventar la rueda ().

- Elige open-source si: Tus necesidades encajan con lo que ya existe, quieres reducir tiempos de desarrollo y te interesa el soporte de la comunidad.

- Crea tu propio rastreador si: Tienes requisitos muy específicos, un equipo experto y el scraping es clave para tu negocio.

Eso sí, open-source no significa "gratis" si cuentas el tiempo de ingeniería, el mantenimiento de servidores y las actualizaciones constantes para esquivar bloqueos. Si buscas la potencia de un rastreador sin programar, hay una opción más.

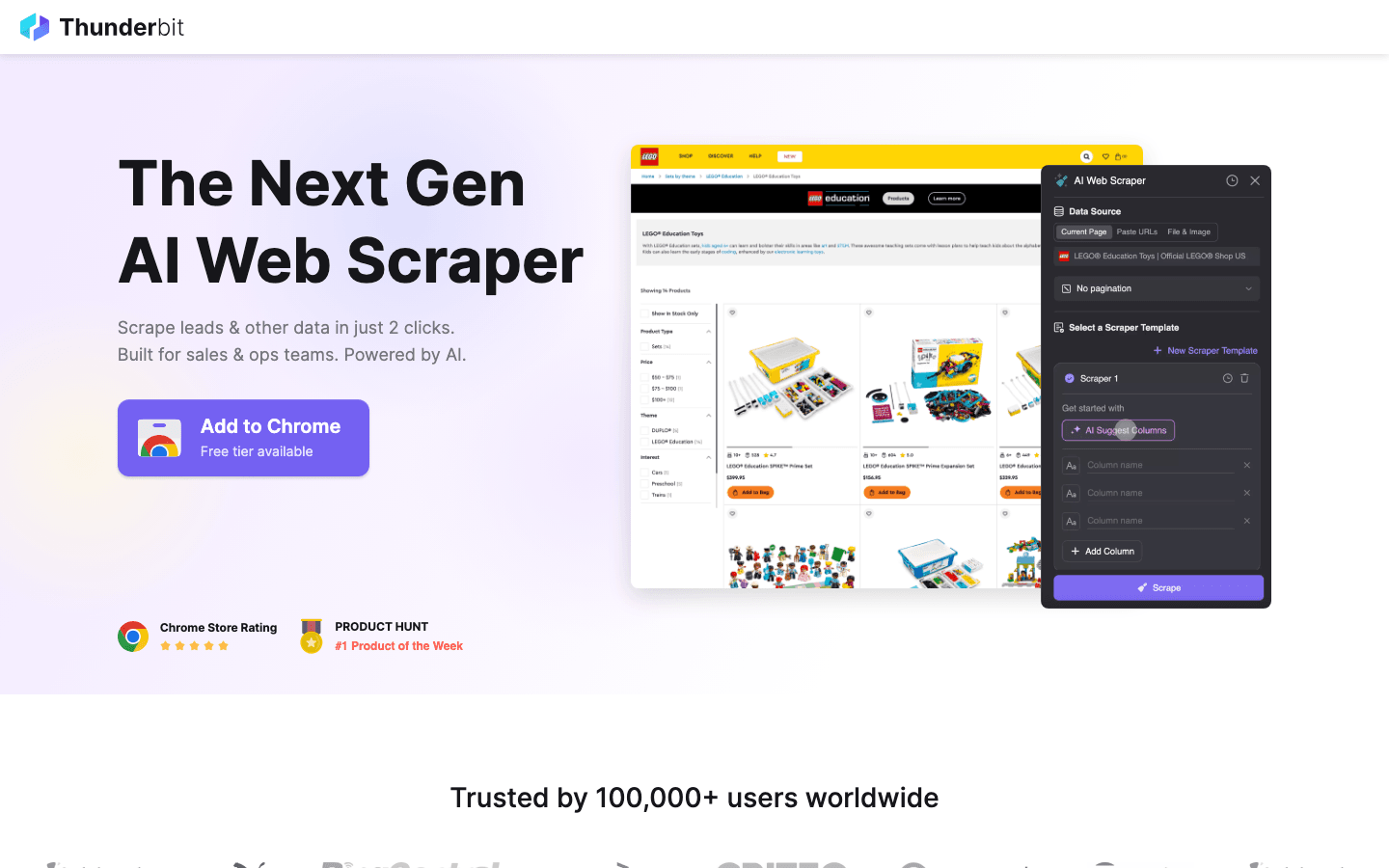

Extra: Cuando open-source es demasiado, prueba Thunderbit

Aunque las herramientas anteriores son geniales para desarrolladores, todas tienen sus límites: requieren saber programar, sufren con anti-bots basados en IA y necesitan mantenimiento constante.

es mi recomendación para quienes quieren saltarse esos obstáculos. Es el puente entre la potencia del scraping y la facilidad de uso.

¿Por qué elegir Thunderbit frente a open-source?

- Sin programar: A diferencia de Scrapy o Puppeteer, Thunderbit es una extensión de Chrome con IA. Solo tienes que hacer clic en “AI Suggest Fields” y la herramienta crea el raspador por ti.

- Resuelve lo difícil: El contenido dinámico, el scroll infinito y la paginación se gestionan automáticamente con IA, ahorrándote horas de scripts personalizados.

- Exportación instantánea: Pasa de la web a Excel, Google Sheets o Notion en dos clics.

- Sin mantenimiento: No tienes que actualizar tu código cuando un sitio cambia—la IA de Thunderbit se adapta por ti.

Si eres comercial, marketer o investigador y necesitas datos ya sin aprender Python o Go, Thunderbit es el complemento perfecto a las herramientas open-source de esta lista.

¿Quieres verlo en acción? y pruébala tú mismo.

Conclusión: Elige el rastreador web autoalojado ideal para 2026

El mundo de las alternativas open-source a Firecrawl nunca ha sido tan completo. Ya sea que necesites la potencia de Scrapy o Nutch, o la fidelidad de archivo de Heritrix, hay una solución para cada escenario. La clave está en ajustar la herramienta a tus necesidades—no te pases si solo necesitas un volcado rápido de datos, y no te quedes corto si vas a rastrear a escala de Internet.

Y recuerda, si la vía open-source se te hace demasiado técnica o consume mucho tiempo, herramientas con IA como Thunderbit están listas para echarte una mano.

¿Listo para empezar? Lanza Scrapy en tu próximo proyecto de datos, o para un scraping sencillo y potenciado por IA. Si quieres más consejos sobre web scraping, visita el para tutoriales y análisis en profundidad.

Preguntas frecuentes

1. ¿Cuál es la principal ventaja de usar alternativas open-source a Firecrawl? Las alternativas open-source te dan flexibilidad, ahorro de costes y la posibilidad de autoalojar y personalizar tu rastreador. Evitas el bloqueo de proveedores y te beneficias del soporte y las actualizaciones de la comunidad.

2. ¿Qué herramienta es mejor para usuarios no técnicos que necesitan resultados rápidos? es una buena opción open-source para navegación offline. Pero si quieres extraer datos estructurados (como tablas para Excel), te recomiendo la herramienta extra por sus capacidades de IA.

3. ¿Cómo puedo extraer datos de sitios web dinámicos y con mucho JavaScript? es tu mejor opción—controla un navegador real, así que puede extraer cualquier cosa que vea un usuario, incluidas SPAs y contenido cargado por AJAX.

4. ¿Cuándo debo usar un rastreador potente como Apache Nutch o StormCrawler? Si necesitas rastrear millones de páginas en muchos dominios, o requieres rastreo distribuido en tiempo real (como para motores de búsqueda o monitoreo de noticias), estas herramientas están hechas para la escala y la fiabilidad.

5. ¿Es mejor crear mi propio rastreador o usar una solución open-source existente? Para la mayoría de equipos, usar y personalizar una herramienta open-source existente es más rápido, barato y confiable. Solo crea tu propio rastreador si tienes necesidades muy especializadas y recursos para mantenerlo a largo plazo.

¡Feliz rastreo! Que tus datos siempre estén frescos, estructurados y listos para usar.

Más información