Imagina la escena: es lunes, apenas te estás tomando el primer sorbo de café y ya tienes la bandeja de entrada repleta de alertas. Otra herramienta con IA se volvió viral por filtrar datos sensibles. El CEO quiere respuestas ya. El equipo legal está en modo pánico. ¿Y los clientes? No paran de preguntar cómo se maneja su información en todos esos sistemas “inteligentes” que lanzaste hace poco. Así es el 2026: la privacidad de los datos en IA dejó de ser solo un tema técnico y ahora es un asunto estratégico que puede definir la reputación de tu empresa y tu futuro profesional.

La verdad es que la IA ya está metida en todos los rincones del mundo empresarial, desde ventas y marketing hasta inmobiliarias y e-commerce. Pero a medida que la IA se vuelve más común, los riesgos también se disparan. Solo en el último año, los incidentes de privacidad ligados a IA crecieron un impresionante 56%, y apenas el 47% de las personas en el mundo confía en que las empresas de IA cuiden sus datos personales—y esa cifra sigue bajando (, ). Llevo años creando plataformas SaaS y de automatización (y ahora, como cofundador de ), y te lo digo claro: estar al día con las estadísticas de privacidad de datos en IA no es solo para cumplir la ley—es la diferencia entre crecer o quedarte atrás en la era digital.

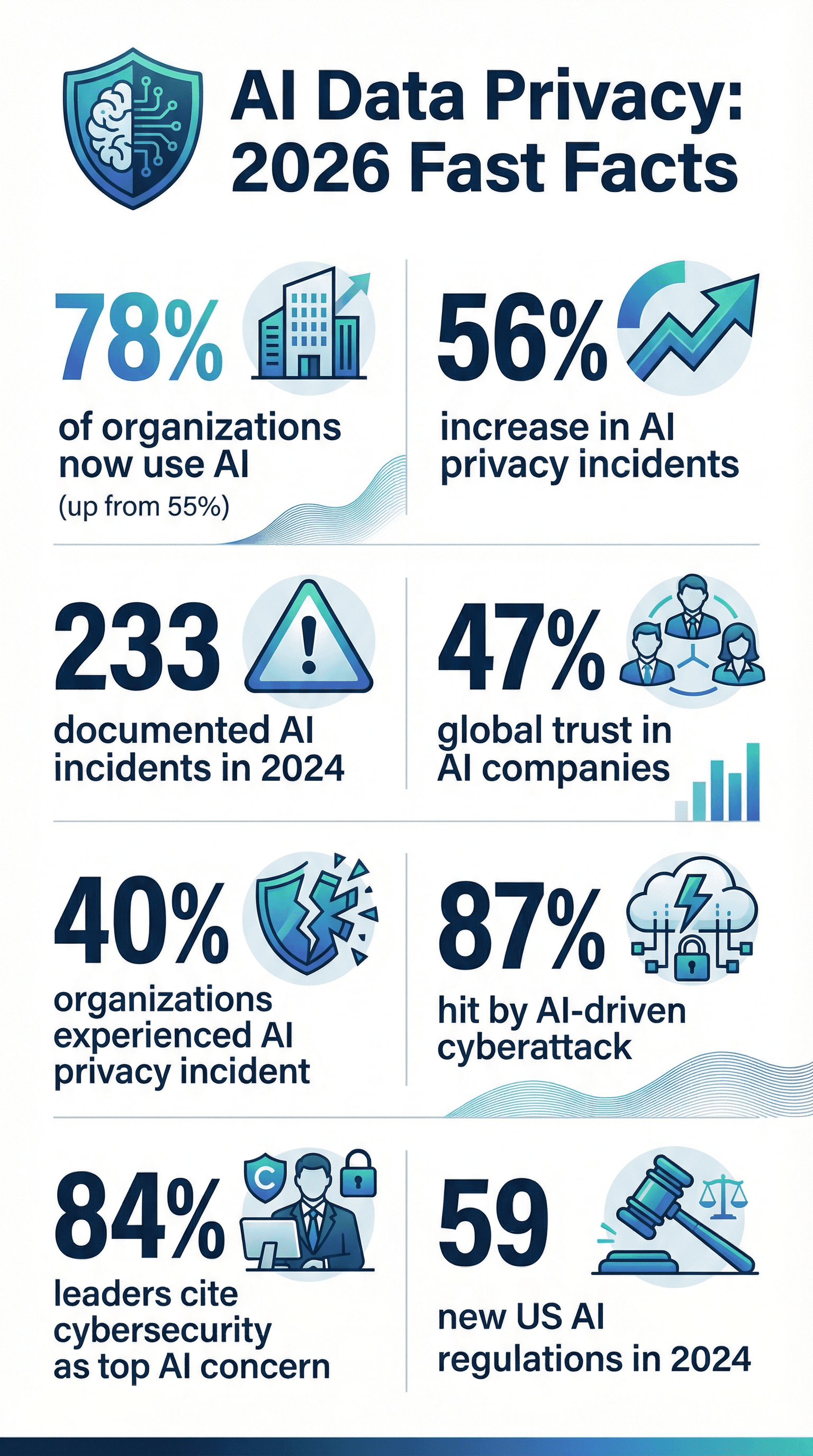

Estado de la privacidad de datos en IA en 2026: datos rápidos

Vamos directo al grano. Si necesitas datos potentes para tu próxima junta o presentación, aquí tienes las estadísticas clave sobre privacidad de datos en IA para 2026:

- La IA está en todos lados: El 78% de las empresas usaba IA en 2024, frente al 55% del año anterior ().

- Los incidentes se disparan: Los problemas de privacidad y seguridad con IA subieron un 56% en solo un año, con 233 casos documentados en 2024 ().

- Las brechas son comunes: El 40% de las empresas ya vivió un incidente de privacidad con IA (), y el 21% sufrió un ciberataque en el último año ().

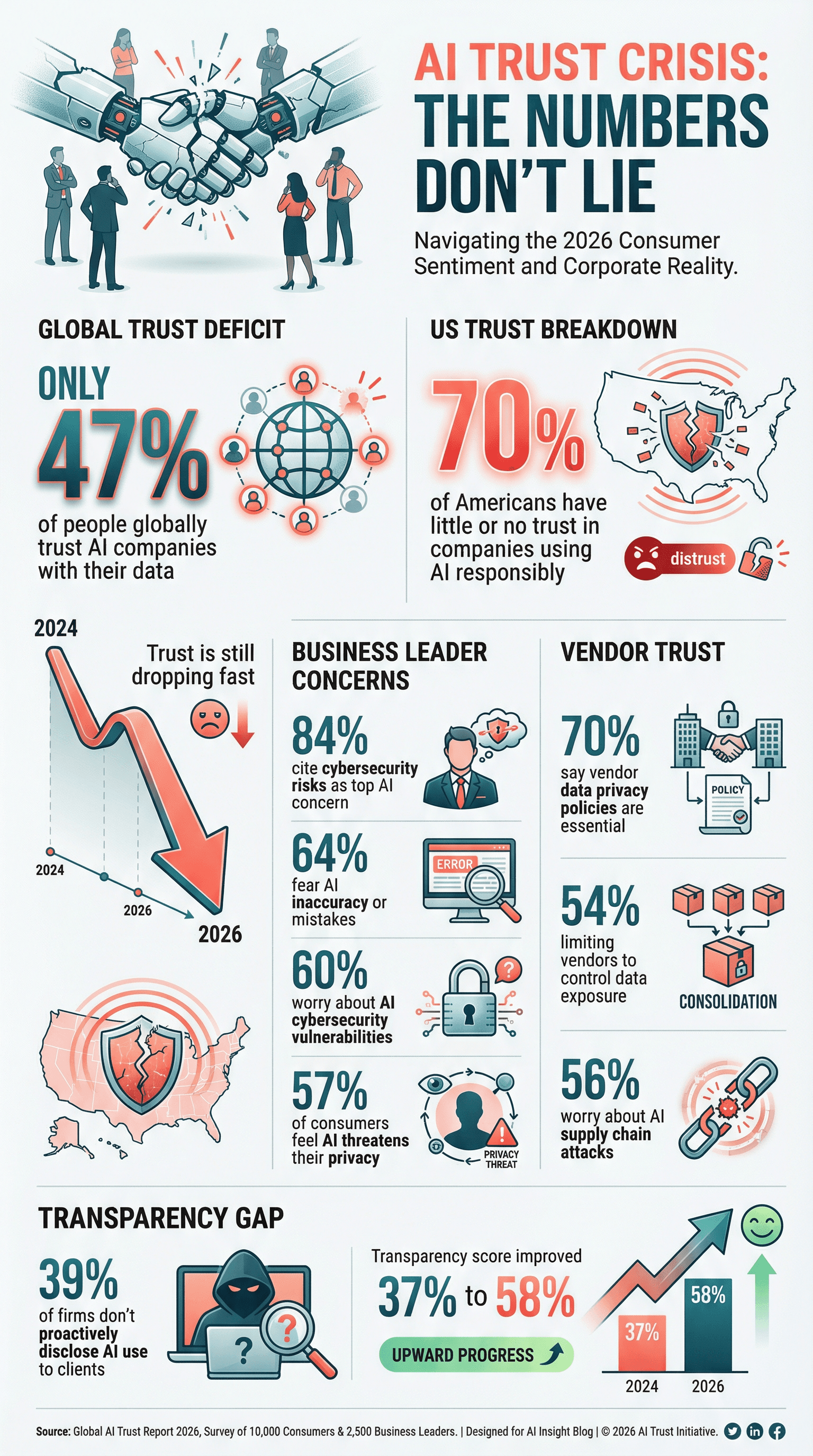

- La confianza está por los suelos: Solo el 47% de la gente a nivel global confía en las empresas de IA para proteger sus datos, y en EE. UU., el 70% tiene poca o nada de confianza en que las compañías usen la IA de forma responsable ().

- La privacidad es prioridad: El 61% de las empresas ya pone la ciberseguridad—incluida la protección de datos en IA—entre sus tres prioridades principales ().

- Examen estricto a los proveedores: El 70% de las empresas ve la política de privacidad de datos de un proveedor como clave al elegir socios tecnológicos ().

- La IA preocupa a los jefes: El 84% de los líderes empresariales ve los riesgos de ciberseguridad como su mayor inquietud al adoptar IA ().

- La regulación se endurece: Las agencias federales de EE. UU. sacaron 59 regulaciones sobre IA en 2024, más del doble que en 2023 ().

- Faltan políticas formales: Solo el 43% de las empresas tiene una política de gobernanza de IA, aunque el 77% está trabajando en ello (, ).

- Los ciberataques con IA ya son lo normal: El 87% de las empresas sufrió un ciberataque con IA en el último año ().

Estos números no son solo para asustar: son una alerta para cualquier persona encargada de datos, cumplimiento o transformación digital.

Por qué la privacidad de datos en IA importa más que nunca

La IA no es solo una mejora de TI: es un cambio total en cómo las empresas recolectan, procesan y usan la información. A diferencia del software clásico, los sistemas de IA aprenden de montones de datos desordenados, desde correos de clientes hasta historiales médicos. Y aquí está el lío: los modelos de IA pueden “memorizar” y soltar información privada de formas que nadie esperaba ().

La escala es brutal. Un solo modelo de IA puede procesar millones de registros o sacar datos de toda la web—muchas veces sin permiso claro. Eso sube la vara para proteger la información. Y como la IA toma decisiones en segundos (por ejemplo: aprobar créditos, filtrar candidatos), cualquier error o sesgo se multiplica rápido, causando violaciones de privacidad y hasta líos legales.

Si piensas: “Ya tenemos política de privacidad, estamos cubiertos”, mejor piénsalo dos veces. La IA trae riesgos nuevos—como envenenamiento de datos, inversión de modelos y ataques adversarios—que los controles de siempre no pueden manejar. ¿Y el golpe a la reputación tras un fallo de privacidad en IA? Es demoledor. Los clientes se van, los reguladores multan y tu marca puede tardar años en recuperarse. En 2026, la privacidad de datos en IA no es solo cumplir la ley: es sobrevivir.

Estadísticas sobre privacidad de datos en IA: adopción, preocupaciones y cumplimiento

La adopción de IA es casi universal

Seamos realistas: la IA ya no es “tecnología nueva”. Es lo normal. Para 2024, el 78% de las empresas usaba IA, frente al 55% del año anterior (). En sectores como el legal y financiero, la adopción es aún mayor—el 42% de los despachos de abogados usaba IA en 2025, casi el doble que el año anterior (). Esto significa que se recolecta, analiza y (a veces) expone más información que nunca.

Las preocupaciones sobre privacidad van en aumento

Con gran poder viene gran responsabilidad—y mucha preocupación. El 57% de los consumidores en el mundo cree que la IA es una amenaza seria para su privacidad (). En EE. UU., el 70% de quienes conocen la IA tiene poca o nada de confianza en que las empresas usen los datos de IA de forma responsable (). Incluso los jefes están preocupados: el 64% teme errores de la IA, y el 60% menciona vulnerabilidades de ciberseguridad con IA como un problema grave ().

Con gran poder viene gran responsabilidad—y mucha preocupación. El 57% de los consumidores en el mundo cree que la IA es una amenaza seria para su privacidad (). En EE. UU., el 70% de quienes conocen la IA tiene poca o nada de confianza en que las empresas usen los datos de IA de forma responsable (). Incluso los jefes están preocupados: el 64% teme errores de la IA, y el 60% menciona vulnerabilidades de ciberseguridad con IA como un problema grave ().

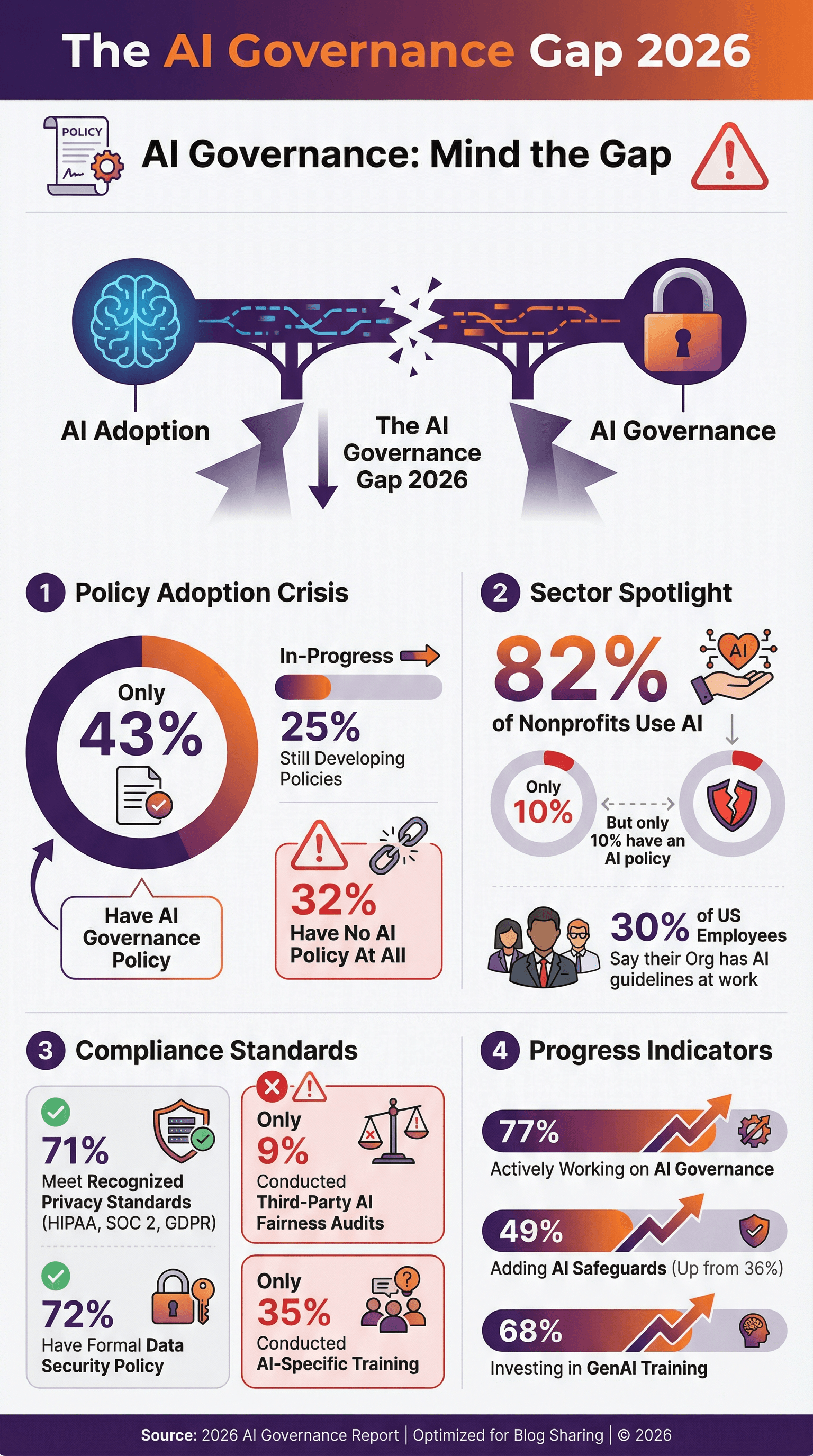

Cumplimiento: un objetivo en movimiento

Las empresas intentan cumplir con normas como GDPR, CCPA, HIPAA y SOC 2—pero la IA siempre suma nuevos retos. El 71% de las empresas dice cumplir con estándares reconocidos de privacidad de datos (), y el 72% tiene una política formal de seguridad de datos. Pero ojo: menos de la mitad tiene una política específica de gobernanza o ética para IA. Solo el 43% de las empresas tiene una política de gobernanza de IA, y otro 25% está en proceso de crearla (, ). ¿El resto? Va a ciegas.

Adopción de políticas de privacidad de datos en IA

Las políticas formales de privacidad de datos en IA ya no son un “plus”, son una necesidad. Pero los datos muestran que aún hay mucho por hacer:

- Solo el 43% de las empresas tiene una política de gobernanza de IA, y otro 25% está en proceso ().

- En EE. UU., solo el 30% de los empleados dice que su empresa tiene reglas claras para el uso de IA en el trabajo ().

- Entre las ONGs, el 82% usa IA, pero solo el 10% tiene una política de IA ().

- ¿La buena? El 77% de las empresas está trabajando en gobernanza de IA, y entre los que más usan IA, esa cifra roza el 90% ().

Los pioneros ya están actualizando sus políticas para incluir cláusulas sobre usos prohibidos de IA, revisión humana obligatoria y compromisos de equidad y transparencia. Si tu empresa aún no empezó, es el momento—antes de que una brecha o una nueva ley te obligue.

Auditorías y certificaciones de privacidad de datos en IA

Las políticas son clave, pero las auditorías y certificaciones demuestran que realmente cumples lo que prometes.

- El 71% de las empresas dice cumplir con estándares como HIPAA, SOC 2 o GDPR ().

- El 51% exige a los proveedores cumplir con HIPAA para datos de salud, y el 45% pide cifrado de extremo a extremo ().

- Solo el 9% de las empresas ha hecho auditorías externas sobre equidad o sesgo en su IA—pero se espera que ese número suba con más regulación ().

Certificaciones como SOC 2, ISO 27001 y HITRUST ya son ventajas competitivas. Si eres proveedor, prepárate para que te pidan pruebas. Si eres cliente, exige garantías a tus socios.

Ciberseguridad en IA: amenazas, incidentes y respuesta

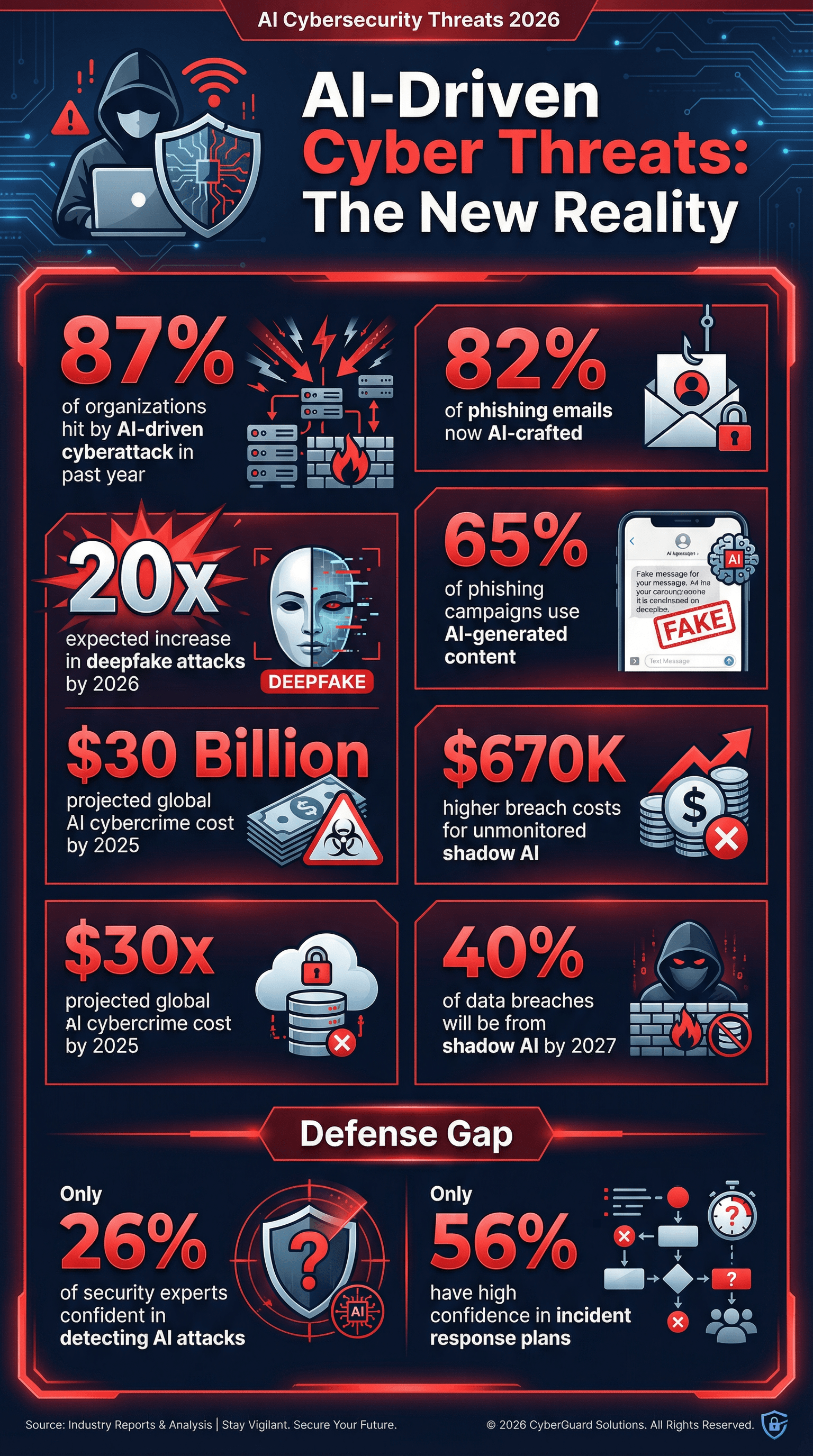

Vamos al grano: la IA no solo es blanco de ciberataques, también es la herramienta favorita de los atacantes. Y los números, la verdad, asustan.

- El 87% de las empresas sufrió un ciberataque con IA en el último año ().

- El 65% de las campañas de phishing ya usa contenido generado por IA para hacerse pasar por fuentes confiables ().

- Se calcula que el 82% de los correos de phishing son creados con ayuda de IA ().

- Se espera que los ataques con deepfakes se multipliquen por 20 para 2026 ().

- El Shadow AI (uso no autorizado de IA por empleados) es un riesgo creciente—Gartner predice que el 40% de las brechas de datos serán por mal uso de IA o “Shadow AI” para 2027 ().

Y aquí una estadística que quita el sueño: solo el 26% de los expertos en seguridad confía plenamente en poder detectar ataques con IA (). Es como jugar a las escondidas con un mago.

Ciberataques impulsados por IA: lo que muestran los datos

- El 87% de las empresas enfrentó un ataque con IA en los últimos 12 meses ().

- El phishing es más pro: Para finales de 2025, más del 82% de los correos de phishing eran generados por IA ().

- Los deepfakes se disparan: Se espera que los ataques con deepfakes de audio/video se multipliquen por 20 para 2026.

- El Shadow AI es peligroso: Para 2027, el 40% de las brechas de datos serán por mal uso de IA o “Shadow AI” ().

- El coste de las brechas sube: Las empresas con IA descontrolada o Shadow AI tuvieron costes de brecha promedio $670,000 más altos que las que sí tienen controles ().

- Coste global: Se estima que el cibercrimen con IA llegará a los $30 mil millones para 2025 ().

Si no estás haciendo simulacros de phishing con correos generados por IA o probando tus defensas contra deepfakes, te estás arriesgando demasiado.

Inversión organizacional en ciberseguridad de IA

¿La buena noticia? Las empresas están invirtiendo más que nunca en ciberseguridad para IA:

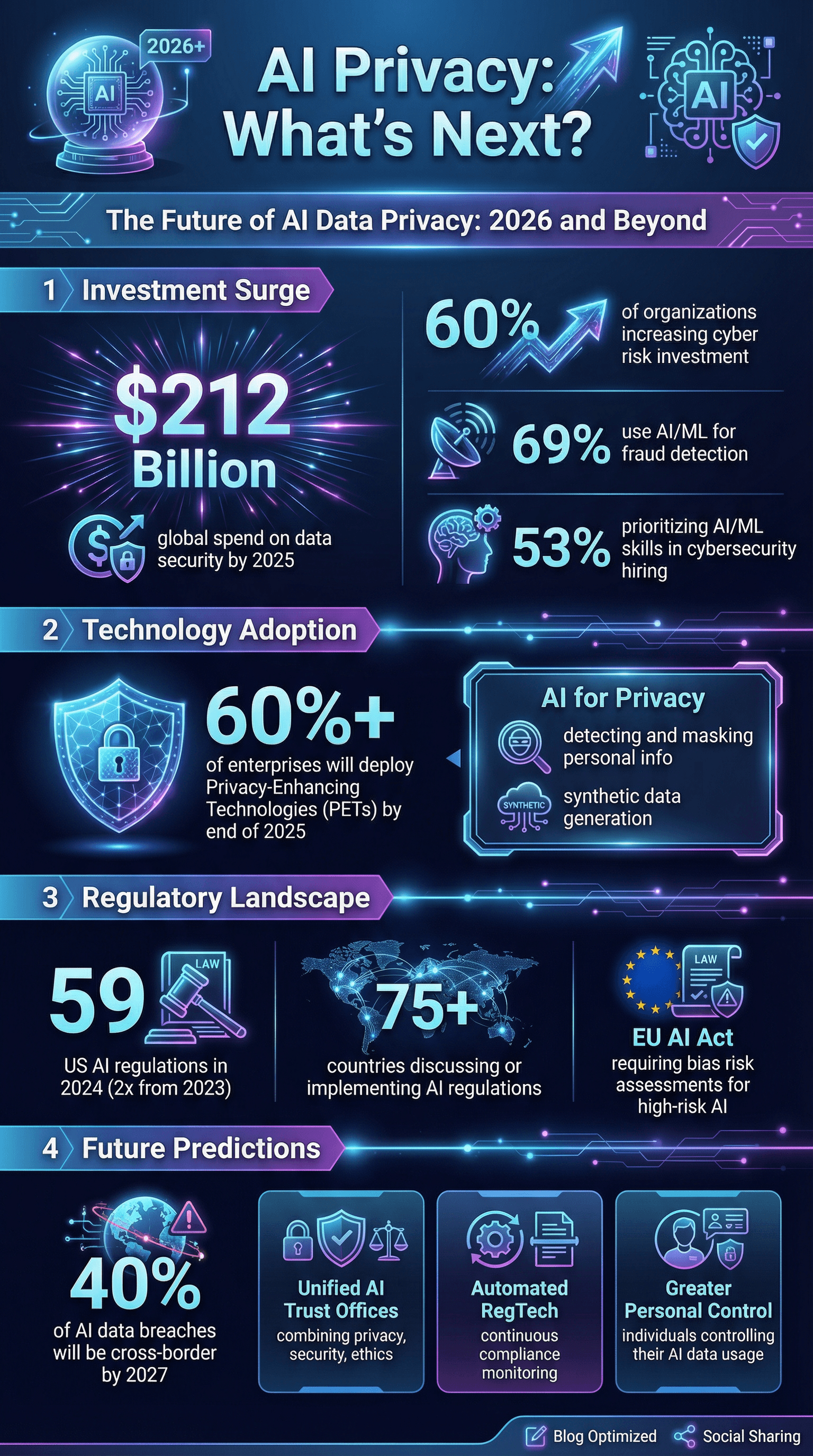

- El 60% de las empresas está subiendo la inversión en mitigación de riesgos cibernéticos, con la IA como motor ().

- El 69% usa IA o machine learning para detectar y prevenir fraudes ().

- El 53% prioriza habilidades de IA y ML al contratar para ciberseguridad ().

- El gasto global en seguridad de datos y gestión de riesgos podría llegar a los $212 mil millones para 2025 ().

Pero aún hay brecha: solo el 56% de las empresas confía plenamente en sus planes de respuesta ante incidentes cibernéticos, y menos aún cubren escenarios específicos de IA.

Gobernanza de datos en IA: formación, supervisión y mitigación de sesgos

Puedes tener la mejor tecnología, pero si tu equipo y procesos no están listos, sigues siendo vulnerable.

- Solo el 35% de las empresas ha dado formación específica en IA a sus equipos sobre privacidad, seguridad o ética ().

- El 68% de las empresas invierte en formación en IA generativa para empleados ().

- El 30% confía en la supervisión humana como control para la IA ().

- Solo el 9% usa auditorías independientes para la equidad en IA ().

- El 49% está en proceso de añadir salvaguardas de gobernanza de IA, frente al 36% del año anterior.

El sesgo es también un gran problema de privacidad. Los sistemas de IA que tratan los datos personales de forma diferente según raza, género u otros atributos pueden causar daños desiguales y problemas legales. El 46% de los directivos dice que lograr una IA responsable—incluida la equidad—es un objetivo clave de sus inversiones en IA (). Pero medir y reducir el sesgo sigue siendo un reto para la mayoría.

Sesgo y equidad en IA: implicaciones para la privacidad

- Los incidentes por sesgo o problemas de seguridad en IA suben cada año ().

- Reducción del 25% en la brecha de género en recomendaciones de candidatos tras esfuerzos para reducir sesgos.

- La presión regulatoria crece: el GDPR de la UE y la próxima Ley de IA exigirán evaluaciones de riesgo de sesgo para sistemas de IA “de alto riesgo”.

Si no estás evaluando el sesgo en tu IA, no solo te arriesgas a mala prensa—también a demandas y pérdida de clientes.

Riesgos de proveedores y ecosistema: consolidación y exposición a terceros

Nadie trabaja solo. Casi todas las empresas dependen de una red de proveedores, servicios en la nube y socios—y todos pueden traer riesgos de privacidad.

- El 54% de las empresas está reduciendo el número de proveedores para controlar costes y minimizar la exposición de datos ().

- El 70% de las compañías ve la política de privacidad de datos como esencial al elegir proveedores tecnológicos.

- El 56% teme ataques a la cadena de suministro con IA ().

¿La tendencia? Menos proveedores, controles de privacidad más duros y tratar a los socios como parte de tu propio perímetro de seguridad.

Presión regulatoria y de clientes: transparencia y divulgación en privacidad de datos en IA

Reguladores y clientes están subiendo la vara. En 2024, EE. UU. tuvo 59 acciones regulatorias sobre IA, más del doble que el año anterior. A nivel global, al menos 75 países han debatido o implementado regulaciones sobre IA ().

- La transparencia es la nueva regla: Los clientes esperan que se les informe sobre el uso de IA, pero el 39% de las empresas admite que no lo comunica de forma proactiva ().

- Preparación para auditorías: Debes estar listo para demostrar cumplimiento—HIPAA, SOC 2, listas de herramientas de IA y controles de manejo de datos.

- Las puntuaciones de transparencia de los principales desarrolladores de modelos de IA subieron del 37% al 58% en solo seis meses ().

Si no estás listo para una auditoría o un cuestionario exigente de un cliente, no estás listo para 2026.

El futuro de la privacidad de datos en IA: predicciones y tendencias emergentes

Mirando hacia adelante, esto es lo que se viene (y lo que dicen los expertos):

- La privacidad como ventaja competitiva: Las empresas que demuestren que su IA es segura, respeta la privacidad y es ética ganarán clientes ().

- Gobernanza unificada: Veremos oficinas de “Confianza en IA” que integren privacidad, seguridad y ética.

- Tecnologías de mejora de la privacidad (PETs): Más del 60% de las empresas planea implementar PETs para finales de 2025 ().

- Cumplimiento automatizado: El RegTech para IA será clave, con herramientas que monitoreen el cumplimiento de los sistemas de IA en tiempo real.

- Desafíos de datos transfronterizos: Para 2027, el 40% de las brechas de datos con IA vendrán del mal uso de datos entre países ().

- Mayor control personal: Habrá herramientas para que los usuarios decidan cómo se usa su información en IA.

- IA para la privacidad: La IA se usará para detectar y anonimizar datos personales, crear datos sintéticos y más.

- Respuesta ante incidentes y resiliencia: Las empresas pasarán de solo prevenir a ser resilientes, incluyendo seguros para incidentes de IA y simulacros de recuperación ante envenenamiento de datos o corrupción de modelos.

Como alguien que vive la automatización y la IA (y sí, con una buena dosis de paranoia por la privacidad), estoy seguro de que los ganadores de la próxima década serán quienes pongan la privacidad y la seguridad en el centro, no como un extra.

Conclusiones: qué significan las estadísticas de privacidad de datos en IA para tu organización en 2026

Vamos a lo práctico, porque nadie quiere ser el próximo caso viral por un escándalo de datos:

- Haz de la privacidad de datos en IA el corazón de tu estrategia. No la dejes para el final—inclúyela desde el principio.

- Haz evaluaciones completas de riesgos en IA. Conoce tus sistemas de IA, flujos de datos y puntos críticos.

- Invierte en formación y gobernanza específica para IA. No dejes que tu equipo sea el punto débil.

- Refuerza las defensas técnicas pensando en la IA. Usa IA para combatir IA—implementa herramientas avanzadas de monitoreo y detección.

- Mejora la gestión de proveedores. Reduce, revisa y exige pruebas de cumplimiento.

- Apuesta por la transparencia. Informa a clientes y usuarios cuándo y cómo usas IA—antes de que lo descubran por otro lado.

- Implementa tecnologías que mejoren la privacidad. Anonimiza, cifra y minimiza los datos siempre que puedas.

- Prepárate para lo peor. Ten un plan de respuesta ante incidentes de IA y pruébalo seguido.

- Mantente al día con las leyes y estándares. El entorno regulatorio cambia rápido—no te quedes atrás.

- Haz de la confianza tu bandera. En 2026 y más allá, la confianza es tu mayor activo.

Fuentes citables y lecturas recomendadas

¿Quieres profundizar o necesitas datos para tu próxima presentación? Aquí tienes algunos de los mejores recursos que usé para este resumen:

- )

Para más info sobre IA, automatización y privacidad de datos, visita el o explora nuestras guías sobre y .