La web está llena de datos y, si trabajas en ventas, operaciones o en casi cualquier área de negocio hoy en día, seguro que alguna vez te ha tocado lidiar con el reto de convertir ese desorden en información útil. He visto de cerca cómo los equipos buscan automatizar la recolección de datos—ya sea para captar leads, vigilar precios o investigar el mercado. Y seamos sinceros, nadie quiere pasarse el día copiando y pegando datos de páginas web. Aquí es donde el 웹 스크래퍼 se vuelve clave, y por qué Python se ha ganado el puesto de favorito para esta tarea.

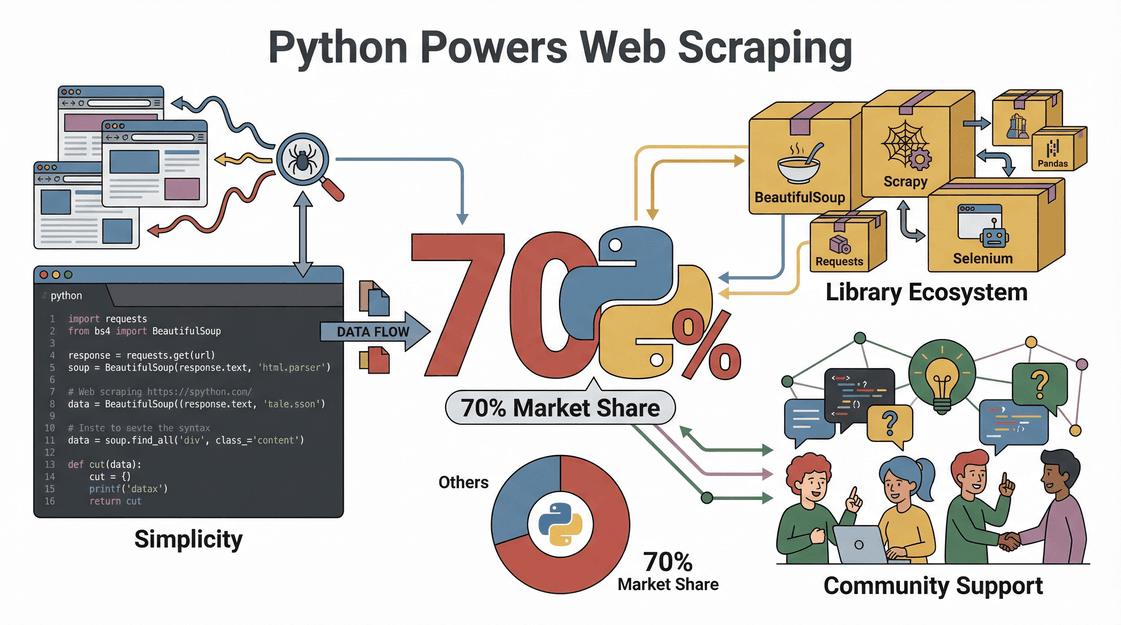

La fama de Python en el mundo del 웹 스크래퍼 no es solo moda—los números lo confirman. Casi usan Python, gracias a su sencillez, su arsenal de librerías y una comunidad que siempre tiene una solución para cualquier problema de scraping. En esta guía, te voy a mostrar paso a paso cómo hacer scraping con Python, desde la configuración inicial hasta tu primer script—y también cómo puede hacerte la vida aún más fácil, sobre todo si prefieres hacer clic en vez de programar.

¿Qué es el 웹 스크래퍼 y por qué usar Python?

Vamos a lo básico. El 웹 스크래퍼 es el proceso de extraer datos automáticamente de sitios web—imagina que tienes un asistente digital que copia información de una página y la pega en una hoja de cálculo, solo que mucho más rápido y sin pedir pausas para el café. Las empresas usan el 웹 스크래퍼 para todo, desde .

Entonces, ¿por qué Python es el lenguaje estrella para el 웹 스크래퍼?

- Fácil de usar: La sintaxis de Python es clara y directa, perfecta incluso si no eres programador de carrera.

- Librerías potentes: Con librerías como Requests, BeautifulSoup, Selenium y Scrapy, Python cubre desde el análisis de HTML sencillo hasta sitios complejos llenos de JavaScript.

- Comunidad activa: Si te atoras, seguro que alguien en Stack Overflow o GitHub ya resolvió ese lío.

- Rápido y flexible: Los scripts en Python se adaptan fácil a nuevos sitios o estructuras de datos, y escalan bien desde tareas pequeñas hasta proyectos grandes.

En resumen, Python es como la navaja suiza del 웹 스크래퍼: potente, flexible y amigable para quienes están empezando.

Valor para el negocio: cómo el 웹 스크래퍼 con Python impulsa resultados

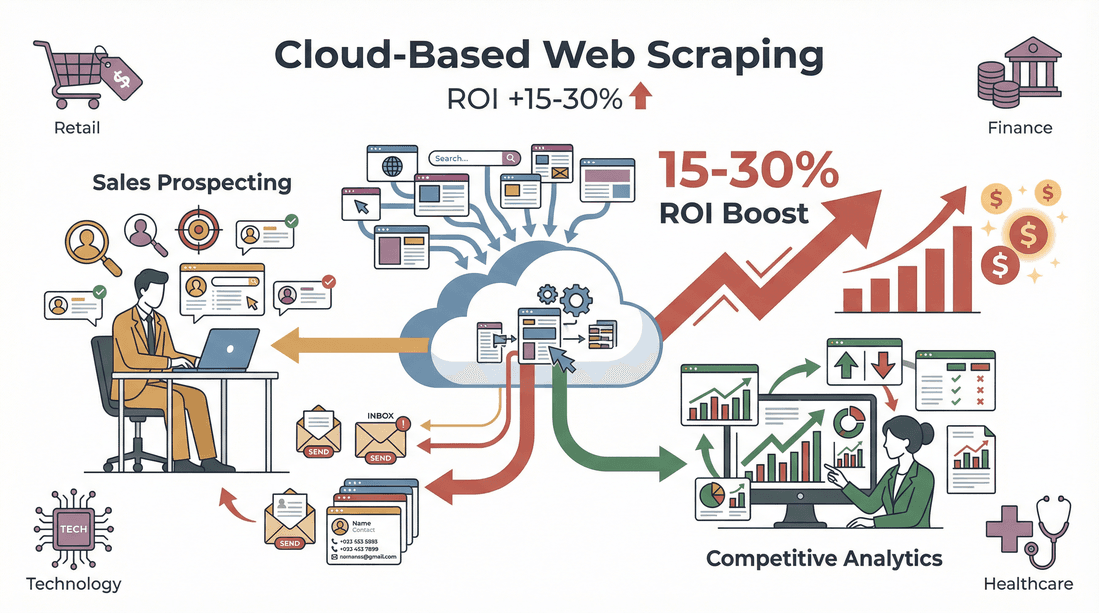

El 웹 스크래퍼 no es solo una técnica, es un acelerador para el negocio. Así es como las empresas usan el scraping con Python para sacar ventaja:

| Caso de uso | Cómo ayuda Python | Impacto en el negocio |

|---|---|---|

| Generación de leads | Extrae contactos de directorios, LinkedIn, etc. | Llena tu CRM con leads frescos y segmentados |

| Monitorización de precios | Rastrea precios de la competencia en e-commerce | Permite precios dinámicos y mantenerte competitivo |

| Investigación de mercado | Agrupa reseñas, artículos o menciones en redes | Detecta tendencias y toma decisiones basadas en datos |

| Datos inmobiliarios | Extrae anuncios de propiedades de varios portales | Crea bases de datos unificadas y actualizadas |

| Gestión de catálogos | Obtiene especificaciones y stock de proveedores | Automatiza inventarios y reduce errores manuales |

¿Y el retorno? Un mostró que automatizar la captación de leads ahorró 8 horas semanales a los reclutadores. En diferentes sectores, en prospección de ventas y análisis competitivo.

Prepara tu entorno Python para el 웹 스크래퍼

Antes de arrancar, necesitas tener Python listo. Así te recomiendo montar tu entorno, incluso si eres nuevo en esto de programar.

1. Instala Python

- Descarga Python: Ve a la y baja la última versión (3.10+ es apuesta segura).

- Agrega Python al PATH: En Windows, marca la casilla “Add Python to PATH” durante la instalación. Así podrás correr Python desde la terminal sin líos ().

2. Crea un entorno virtual

Un entorno virtual mantiene las librerías de tu proyecto ordenadas y evita que se mezclen.

1# En Windows

2python -m venv venv

3venv\Scripts\activate

4# En Mac/Linux

5python3 -m venv venv

6source venv/bin/activate3. Elige un editor de código

- VS Code: Gratis, ligero y con muchas extensiones.

- PyCharm: Perfecto para proyectos grandes, con sugerencias inteligentes.

- Jupyter Notebook: Ideal para experimentar y visualizar datos.

4. Tips para resolver problemas

- Si los comandos de Python no jalan, revisa tu PATH.

- Si ves errores de permisos, abre la terminal como administrador.

- En Mac, puede que necesites instalar Xcode Command Line Tools (

xcode-select --install).

Elige las librerías Python adecuadas para el 웹 스크래퍼

El poder de Python está en sus librerías. Aquí tienes un resumen de las más populares y cuándo usarlas:

| Librería | Ideal para | Facilidad de uso | Velocidad | Soporte JavaScript | Escalabilidad |

|---|---|---|---|---|---|

| Requests | Obtener páginas web (HTTP) | Fácil | Rápida | No | Buena |

| BeautifulSoup | Analizar HTML/XML | Muy fácil | Media | No | Buena |

| lxml | Análisis rápido de XML/HTML | Media | Muy rápida | No | Buena |

| Selenium | Interactuar con sitios dinámicos | Media | Lenta | Sí (navegador real) | Moderada |

| Scrapy | Scraping automatizado a gran escala | Media | Muy rápida | Parcial/Sí | Excelente |

- Requests es ideal para peticiones HTTP sencillas.

- BeautifulSoup es muy querida por su sintaxis sencilla—perfecta para extraer datos de HTML.

- lxml es rapidísima para documentos grandes, aunque menos intuitiva para quienes empiezan.

- Selenium abre una ventana de navegador, permitiendo interactuar con sitios llenos de JavaScript.

- Scrapy es un framework completo para crear scrapers robustos y escalables—ideal para proyectos grandes.

Para la mayoría que empieza, la dupla Requests + BeautifulSoup es la más equilibrada ().

Paso a paso: cómo hacer 웹 스크래퍼 con Python

Vamos con un ejemplo práctico: extraer datos de productos de un sitio e-commerce (imaginario).

1. Inspecciona la estructura del sitio

Abre las herramientas de desarrollador de tu navegador (F12 o clic derecho > Inspeccionar). Ubica los elementos HTML que contienen los datos que buscas—como títulos, precios o valoraciones. Este paso es clave: necesitas saber qué vas a buscar en tu código ().

2. Haz una petición HTTP

Usa Requests para obtener la página.

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. Analiza el HTML con BeautifulSoup

Extrae los datos que necesitas.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. Extrae y limpia los datos

Recorre cada producto y saca los detalles.

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # Limpia el precio para cálculos

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. Exporta los datos a CSV/Excel

Usa Pandas para guardar los resultados.

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

¡Y listo! Ya tienes los datos ordenados, listos para analizar o cargar en tu CRM.

Cómo manejar contenido dinámico y paginación

No todos los sitios lo ponen fácil. Algunos cargan datos con JavaScript o reparten los resultados en varias páginas. Así puedes enfrentarte a estos casos:

웹 스크래퍼 de contenido dinámico

Si ves resultados vacíos o datos que faltan, puede que el sitio cargue el contenido dinámicamente. Aquí entra Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# Usa BeautifulSoup como antes()

Cómo manejar la paginación

Para extraer datos de varias páginas, recorre los números de página o los botones “Siguiente”.

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # Analiza y extrae como antes()

Para proyectos grandes, Scrapy puede automatizar el rastreo de cientos de páginas ().

Exporta y usa tus datos extraídos

Una vez que tienes los datos, es momento de sacarles jugo.

- Exporta a CSV/Excel: Como vimos antes, Pandas lo hace fácil.

- Limpia y normaliza: Elimina duplicados, corrige errores y estandariza formatos ().

- Integra con tus flujos de trabajo: Importa el CSV en Salesforce, HubSpot o tu herramienta de análisis favorita. Incluso puedes automatizarlo con scripts de Python.

Thunderbit: simplificando el 웹 스크래퍼 en Python para equipos de negocio

Seamos claros—Python es potente, pero si no eres programador, no siempre es la vía más rápida para conseguir datos. Por eso creamos , una pensada para usuarios de negocio que quieren resultados sin complicaciones.

Esto es lo que hace de Thunderbit una herramienta revolucionaria para equipos de ventas y operaciones:

- Mapeo de campos con IA: Haz clic en “Sugerir campos con IA” y Thunderbit analiza la página, recomienda columnas (como Nombre, Precio, Email) y configura la extracción automáticamente—sin tener que mapear campos a mano.

- 웹 스크래퍼 de subpáginas: Thunderbit puede visitar automáticamente cada subpágina (como detalles de productos o perfiles de LinkedIn) y enriquecer tu tabla con información extra.

- Paginación y contenido dinámico: Gestiona listas paginadas y scroll infinito sin necesidad de código.

- Plantillas instantáneas: Para sitios populares (Amazon, Zillow, Shopify, etc.), solo elige una plantilla y haz clic en “Raspar”.

- Exportación gratuita de datos: Exporta directo a Excel, Google Sheets, Airtable o Notion—sin pasos extra.

- Sin mantenimiento: La IA de Thunderbit se adapta a los cambios de los sitios, así que no tienes que estar arreglando scripts rotos.

He visto usuarios pasar de “necesito estos datos pero no sé por dónde empezar” a “aquí tienes mi hoja de cálculo lista” en menos de cinco minutos. Y sí, hay una para que lo pruebes sin compromiso.

Combinando Thunderbit con Python: el combo definitivo para recolectar datos

Si eres usuario avanzado o analista de datos, no tienes que elegir entre Thunderbit y Python—puedes usar ambos. Así suelo combinarlos:

- Usa Thunderbit para extraer: Raspa rápido datos estructurados de sitios complejos o desconocidos, exportando a CSV o Excel.

- Procesa con Python: Carga los datos exportados en Pandas para limpiar, analizar o automatizar tareas extra.

- Automatiza flujos de trabajo: Programa extracciones regulares con Thunderbit y luego ejecuta scripts de Python para procesar y subir los datos donde los necesites.

Este enfoque mixto te permite avanzar rápido, ser flexible y no reinventar la rueda en cada proyecto.

Consideraciones legales y éticas en el 웹 스크래퍼

Vamos al tema delicado: ¿es legal el 웹 스크래퍼? La respuesta corta es sí—si sigues las reglas.

- Respeta robots.txt y los Términos de Servicio: Algunos sitios prohíben el scraping; revisa antes de empezar ().

- No extraigas datos personales o con derechos de autor: Limítate a información pública y factual.

- Controla la frecuencia de tus peticiones: No sobrecargues los servidores. Añade pausas y respeta los límites ().

- Cumple con las leyes de privacidad: Si recoges emails o datos personales, asegúrate de cumplir con GDPR, CCPA y otras normativas ().

Thunderbit está diseñado para ayudarte a cumplir, extrayendo solo lo que es visible y accesible en tu navegador, y facilitando el respeto a los límites de los sitios.

Resolución de problemas y buenas prácticas para el 웹 스크래퍼 en Python

Incluso los mejores scrapers se topan con obstáculos. Aquí tienes mi checklist para resolver problemas:

- Solicitudes bloqueadas: Cambia el user agent, usa proxies o baja la velocidad de tus peticiones ().

- Errores de análisis: Revisa tus selectores HTML—los sitios cambian de diseño seguido.

- Datos que faltan: Asegúrate de que el contenido no se cargue dinámicamente (usa Selenium si hace falta).

- Captchas o muros de inicio de sesión: Algunos sitios bloquean bots; considera alternativas o extracción manual.

Buenas prácticas:

- Prueba tu scraper con un lote pequeño antes de escalar.

- Registra errores y maneja excepciones con elegancia.

- Respeta las reglas del sitio y evita datos sensibles o restringidos.

- Documenta tu código y mantenlo modular para facilitar cambios.

- Programa mantenimiento regular—los sitios cambian, y tus scrapers también deben hacerlo ().

Conclusión y puntos clave

El 웹 스크래퍼 con Python es un superpoder para los equipos de negocio modernos—transformando la web caótica en datos claros y útiles. Recuerda:

- Python es la mejor opción para el 웹 스크래퍼 por su facilidad, librerías potentes y comunidad activa.

- El flujo de trabajo es sencillo: inspecciona el sitio, obtén la página, analiza el HTML, extrae y limpia los datos, y expórtalos a CSV o Excel.

- Thunderbit hace el scraping accesible para quienes no programan, automatizando el mapeo de campos, la extracción de subpáginas y la exportación de datos en pocos clics.

- Combina Thunderbit y Python para lo mejor de ambos mundos: extracción rápida y procesamiento avanzado de datos.

- Sé legal y ético: respeta las reglas de los sitios, evita datos personales y mantén tus scrapers amigables.

¿Listo para empezar? Prueba a crear tu primer scraper en Python—o, si prefieres evitar el código, y descubre lo fácil que es recolectar datos web. Para más consejos y guías, visita el .

Preguntas frecuentes

1. ¿Qué es el 웹 스크래퍼 y por qué Python es tan popular para ello?

El 웹 스크래퍼 es la extracción automática de datos de sitios web. Python es popular por su sintaxis sencilla, librerías potentes (como Requests y BeautifulSoup) y una comunidad enorme que apoya tanto a quienes empiezan como a los expertos ().

2. ¿Qué librerías de Python debo usar para el 웹 스크래퍼?

Para la mayoría de proyectos, arranca con Requests (para obtener páginas) y BeautifulSoup (para analizar HTML). Para sitios dinámicos o con mucho JavaScript, usa Selenium. Para proyectos grandes o complejos, Scrapy es una excelente opción ().

3. ¿Cómo se compara Thunderbit con el 웹 스크래퍼 en Python?

Thunderbit es una extensión de Chrome con IA que te permite extraer datos en solo dos clics—sin programar. Es ideal para usuarios de negocio que buscan resultados rápidos, mientras que Python ofrece más flexibilidad para proyectos personalizados o a gran escala ().

4. ¿Es legal el 웹 스크래퍼?

El 웹 스크래퍼 es generalmente legal si te limitas a datos públicos, respetas robots.txt y los términos de servicio, y evitas información personal o protegida por derechos de autor. Siempre revisa las reglas del sitio antes de extraer datos ().

5. ¿Cómo puedo combinar Thunderbit con Python para flujos de trabajo avanzados?

Usa Thunderbit para extraer datos estructurados y exportarlos a CSV o Excel. Luego, utiliza Python (con Pandas u otras librerías) para limpiar, analizar o automatizar el procesamiento—obteniendo lo mejor de ambos mundos.

¿Listo para convertir la web en la mejor fuente de datos para tu negocio? Prueba Python y Thunderbit—y deja que los datos trabajen por ti.

Más información