La web está llena de datos; tanto así que en 2024 el mundo llegó a la impresionante cifra de de información digital. Un dato que sorprende: más del 90% de los datos del mundo se generaron en los últimos dos años. Para quienes están en el mundo de los negocios, esto significa que tu próxima gran oportunidad, cliente o ventaja competitiva probablemente está en internet—si logras acceder a esos datos.

Aquí es donde entra el raspado web. Ya sea que trabajes en ventas, e-commerce o investigación de mercados, automatizar la recolección y organización de datos web es una habilidad clave. Y si no tienes experiencia programando, tranquilo: Python hace que el raspado web sea accesible para cualquiera. En este tutorial práctico, te voy a guiar paso a paso, desde la configuración hasta la limpieza de datos, e incluso te mostraré una alternativa sin código con para cuando necesitas resultados al instante.

¿Qué es el Raspado Web con Python?

Vamos a lo básico: raspado web es el proceso automatizado de extraer información de páginas web. Imagina que quieres recopilar precios de productos de una tienda online, armar una lista de contactos desde un directorio o monitorear noticias de la competencia. En vez de copiar y pegar a mano (¿quién tiene tiempo para eso?), el raspado web te permite crear un script que hace todo el trabajo pesado por ti.

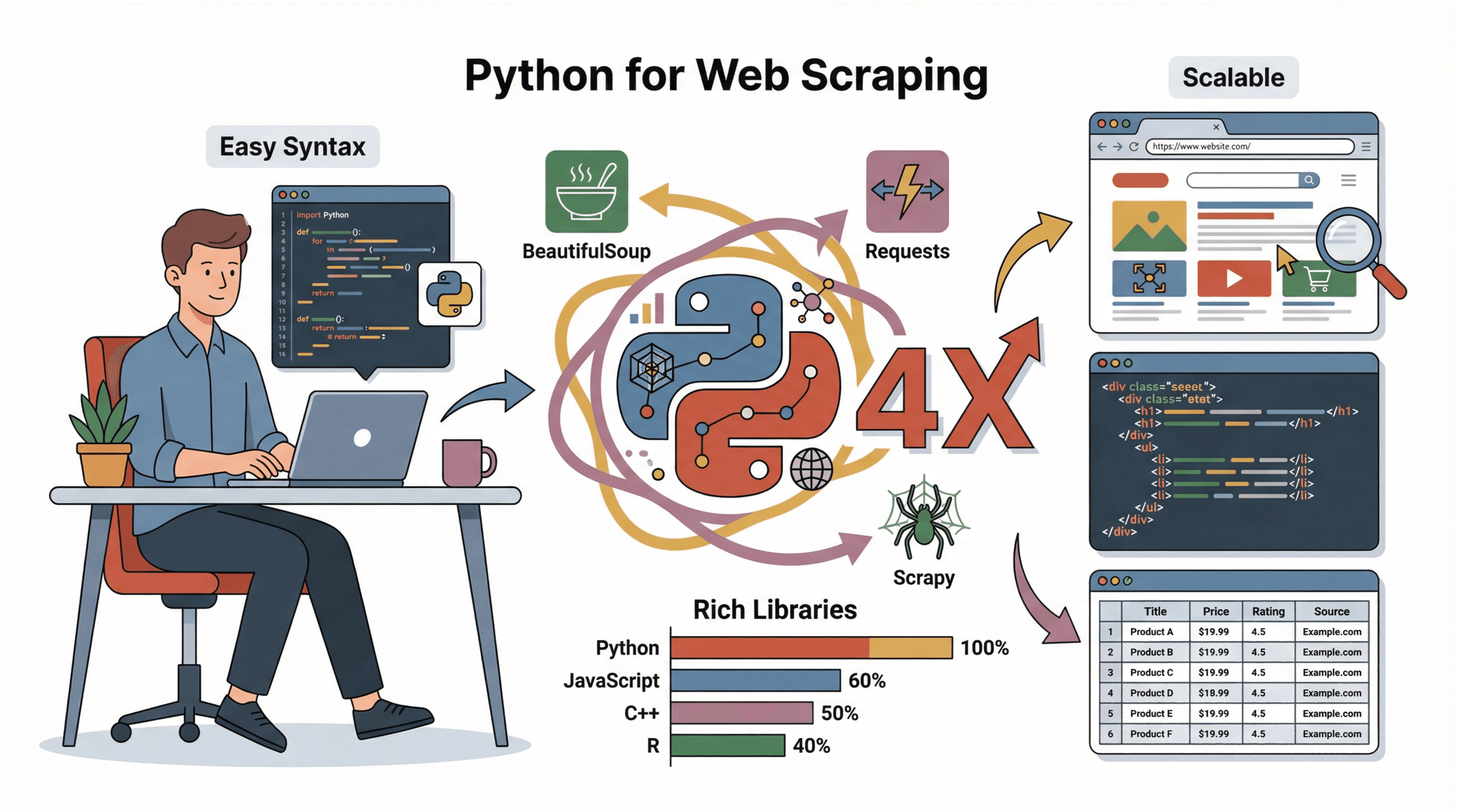

Raspado web con Python significa usar este lenguaje para automatizar ese proceso. Gracias a su sintaxis sencilla y a sus librerías potentes, Python es la herramienta favorita para scraping, incluso para quienes apenas están empezando a programar. Puedes obtener páginas web, analizar su contenido y guardar los datos estructurados en minutos.

Los equipos de negocio usan el raspado web para:

- Generar leads: Crear listas de prospectos desde directorios o sitios de reseñas.

- Monitorear precios: Seguir los precios de la competencia o la disponibilidad de productos.

- Investigar el mercado: Reunir noticias, opiniones o menciones en redes sociales.

- Operaciones: Recopilar información de proveedores, ofertas de empleo o anuncios inmobiliarios.

En resumen, si los datos están en una web, Python puede ayudarte a conseguirlos rápido y a gran escala.

Por qué Python es la Mejor Opción para Raspado Web

He probado varios lenguajes para scraping (y sí, he tenido mis momentos de “¿por qué esto no funciona?”). Pero Python destaca, y aquí te cuento por qué:

He probado varios lenguajes para scraping (y sí, he tenido mis momentos de “¿por qué esto no funciona?”). Pero Python destaca, y aquí te cuento por qué:

- Fácil de aprender: La sintaxis de Python es clara y sencilla, ideal para quienes no son programadores.

- Ecosistema completo: Librerías como , y facilitan la descarga, análisis y almacenamiento de datos.

- Gran comunidad: Hay muchísimos tutoriales, foros y ejemplos de código para cualquier reto de scraping.

- Escalabilidad: Python sirve tanto para scripts rápidos como para proyectos de scraping a gran escala.

Comparado con JavaScript, C++ o R, Python es mucho más accesible y perfecto para prototipar y analizar datos rápido (). Por eso es la opción favorita tanto para principiantes como para empresas.

Primeros Pasos: Configura tu Entorno de Raspado en Python

Antes de empezar a extraer datos, necesitas instalar Python y algunas librerías clave. Así lo puedes hacer, incluso si nunca has instalado Python:

-

Instala Python:

- Descarga la última versión desde .

- En Windows, marca la opción “Add Python to PATH” durante la instalación.

- En Mac, puedes usar con

brew install python3. - En Linux, usa tu gestor de paquetes:

sudo apt install python3 python3-pip.

-

Instala pip (el gestor de paquetes de Python):

- La mayoría de las instalaciones de Python ya incluyen pip. Verifica con

pip --version. - Si no aparece, reinstala Python o usa

python -m ensurepip --upgrade.

- La mayoría de las instalaciones de Python ya incluyen pip. Verifica con

-

Crea un entorno virtual (opcional, pero recomendado):

- En la carpeta de tu proyecto, ejecuta:

python -m venv env - Actívalo:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- En la carpeta de tu proyecto, ejecuta:

-

Instala las librerías necesarias:

- Con el entorno virtual activo, ejecuta:

1pip install requests beautifulsoup4 pandas scrapy - Para scraping avanzado (sitios dinámicos), también puedes instalar

selenium.

- Con el entorno virtual activo, ejecuta:

-

Elige un editor de código:

- Para quienes empiezan, , o son excelentes opciones.

Tips para resolver problemas:

- Si

pipno es reconocido, prueba conpython -m pip install .... - Si tienes errores de permisos, ejecuta la terminal como administrador o usa

sudoen Mac/Linux. - En Windows, reinicia la terminal después de instalar Python.

Cómo Inspeccionar una Página Web Antes de Hacer Raspado

Antes de escribir código, necesitas entender cómo está armada la web que quieres extraer. Así lo hago yo:

-

Abre las herramientas de desarrollador:

- En Chrome, haz clic derecho sobre cualquier elemento y selecciona “Inspeccionar”, o presiona

F12. - Verás la estructura HTML en la pestaña “Elements”.

- En Chrome, haz clic derecho sobre cualquier elemento y selecciona “Inspeccionar”, o presiona

-

Ubica los datos que te interesan:

- Usa la herramienta de selección (el icono de puntero) para hacer clic sobre el dato que quieres (por ejemplo, el título de un producto o su precio).

- El HTML correspondiente se resaltará.

-

Identifica patrones:

- Busca etiquetas, clases o IDs únicos. Por ejemplo:

<h2 class="product-title">Laptop XYZ</h2>. - Observa si los datos están en una lista (

<ul>,<div class="item">, etc.) o en una tabla.

- Busca etiquetas, clases o IDs únicos. Por ejemplo:

-

Revisa si hay paginación:

- Busca botones de “Siguiente” o números de página en el HTML. Si ves URLs como

?page=2, puedes recorrerlas en tu script.

- Busca botones de “Siguiente” o números de página en el HTML. Si ves URLs como

-

¿El contenido es dinámico?

- Si los datos no aparecen en el código fuente (

Ctrl+U), puede que se carguen con JavaScript. En ese caso, podrías necesitar Selenium o buscar un endpoint de API.

- Si los datos no aparecen en el código fuente (

Para una guía visual, es muy útil.

Usando Requests para Descargar el Contenido de una Página Web

La librería es tu aliada para descargar páginas web con Python. Ejemplo básico:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # Lanza error si la respuesta es incorrecta

6html = response.textTips:

- Siempre usa un

User-Agentrealista para evitar bloqueos (). - Revisa

response.status_code(200 es OK, 404 no encontrado, 403 prohibido, 429 demasiadas solicitudes).

Analizando HTML con BeautifulSoup: Extrae los Datos que Necesitas

Ya tienes el HTML, ahora toca extraer lo importante. lo hace sencillo:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]Tareas comunes:

- Extraer texto:

element.get_text(strip=True) - Obtener enlaces:

[a['href'] for a in soup.select('a')] - Buscar por clase:

soup.find_all('span', class_='price') - Extraer imágenes:

[img['src'] for img in soup.select('img')] - Manejar tablas: Usa

soup.select('table')y recorre filas/celdas.

Tips para HTML desordenado:

- Usa

soup.select_one()para el primer resultado. - Si falta un campo, verifica que no sea

Noneantes de acceder a sus atributos. - Para estructuras inconsistentes, quizá debas usar lógica personalizada o expresiones regulares.

Scrapy: Framework Eficiente y Escalable para Raspado Web

Cuando tus necesidades de scraping crecen (cientos o miles de páginas), es tu mejor opción. Scrapy es un framework completo para rastrear webs, gestionar solicitudes, seguir enlaces y exportar datos.

¿Por qué usar Scrapy?

- Velocidad: Scrapy descarga varias páginas en paralelo (de forma asíncrona).

- Funciones integradas: Maneja reintentos, caché y exportación a CSV/JSON.

- Escalabilidad: Perfecto para proyectos grandes o extracciones recurrentes.

Flujo básico con Scrapy:

- Instala:

pip install scrapy - Crea un proyecto:

scrapy startproject myproject - Define una clase Spider con

start_urlsy un métodoparse. - Usa

yieldpara seguir enlaces o extraer datos. - Ejecuta:

scrapy crawl spidername -o output.csv

Para empezar rápido, revisa .

Alternativa Sin Código: Raspador Web IA de Thunderbit para Resultados Instantáneos

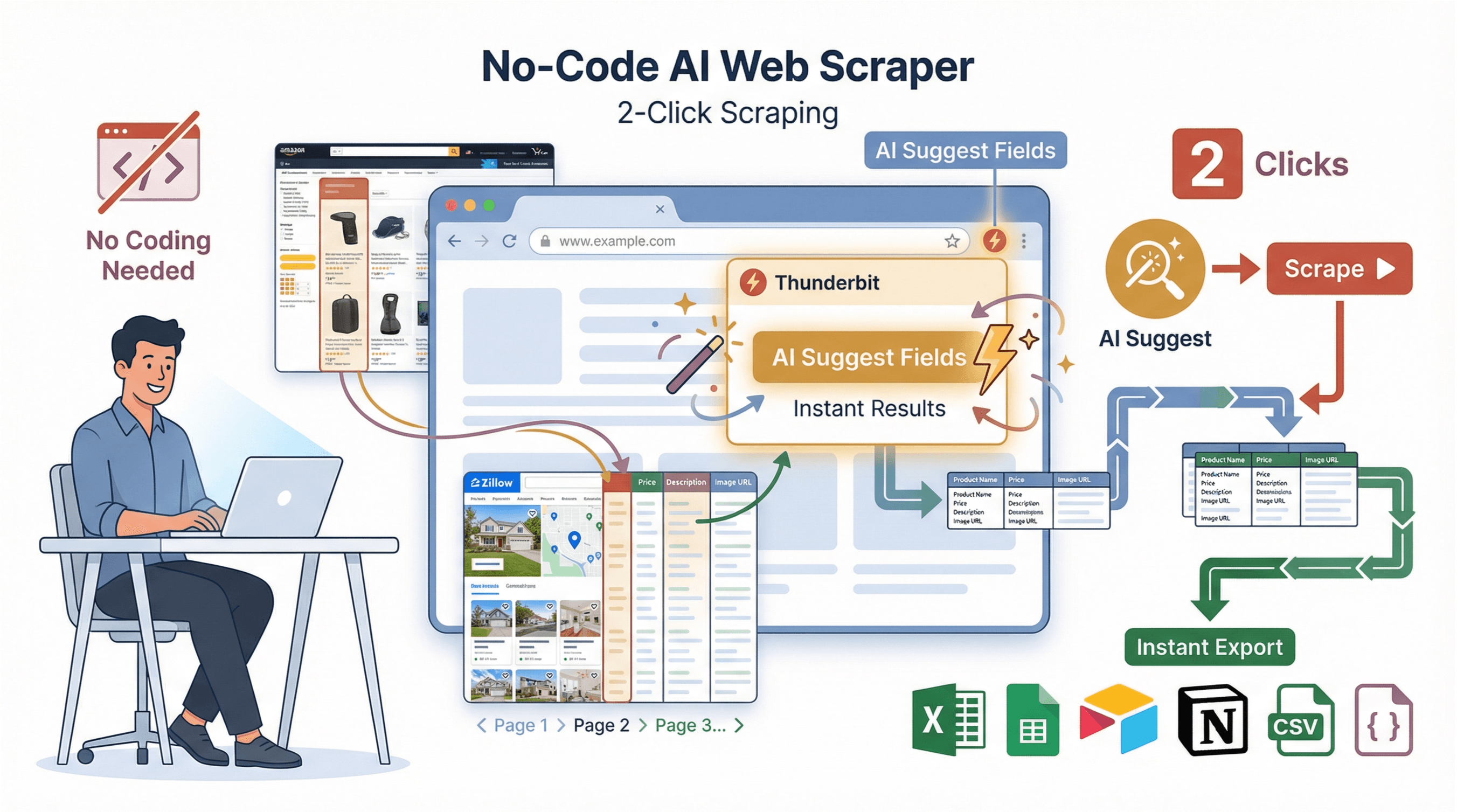

Seamos sinceros: no todos quieren lidiar con código, dependencias o errores. Por eso creamos : una extensión de Chrome con IA pensada para usuarios de negocio que quieren resultados en dos clics.

Seamos sinceros: no todos quieren lidiar con código, dependencias o errores. Por eso creamos : una extensión de Chrome con IA pensada para usuarios de negocio que quieren resultados en dos clics.

¿Cómo funciona Thunderbit?

- AI Suggest Fields: Haz clic en “AI Suggest Fields” y Thunderbit analiza la página, recomendando las mejores columnas para extraer.

- Scraping en 2 clics: Haz clic en “Scrape” y Thunderbit se encarga del resto—paginación, subpáginas y hasta estructuras complicadas.

- Extracción en subpáginas: ¿Necesitas más detalles? Thunderbit puede visitar cada subpágina (como fichas de producto o perfiles) y enriquecer tu tabla automáticamente.

- Plantillas instantáneas: Para sitios populares (Amazon, Zillow, Instagram, Shopify), usa plantillas listas para exportar en un clic.

- Exportación gratuita: Exporta a Excel, Google Sheets, Airtable, Notion, CSV o JSON—sin muros de pago ni complicaciones.

Thunderbit vs. Python: Comparativa Rápida

| Funcionalidad | Python (Manual) | Thunderbit (Sin Código) |

|---|---|---|

| Tiempo de configuración | 30–60 minutos | 2 minutos |

| ¿Requiere programación? | Sí | No |

| Maneja paginación | Con código personalizado | Sí, automáticamente |

| Scraping en subpáginas | Bucles manuales | 1 clic |

| Exportación de datos | Código para CSV/Excel | 1 clic a Sheets/Excel/Notion |

| Mantenimiento | Actualizaciones manuales | La IA se adapta automáticamente |

| Ideal para | Lógica personalizada, integración | Resultados rápidos, no programadores |

Para más información, revisa .

Limpieza y Almacenamiento de Datos: Haz Útil tu Información Extraída

Los datos extraídos rara vez están listos para usarse. Así puedes limpiarlos y guardarlos usando :

1import pandas as pd

2# Supón que tienes una lista de diccionarios llamada scraped_data

3df = pd.DataFrame(scraped_data)

4# Elimina duplicados

5df = df.drop_duplicates()

6# Filtra filas con valores faltantes

7df = df.dropna(subset=['title', 'price'])

8# Convierte el precio a float (elimina $ y comas)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# Guarda en CSV

11df.to_csv('results.csv', index=False)Buenas prácticas:

- Revisa siempre si hay datos faltantes o inconsistentes.

- Normaliza formatos (fechas, precios, etc.).

- Guarda en CSV para compartir fácilmente, o usa Excel/Google Sheets para colaborar.

- Para grandes volúmenes, considera una base de datos (como SQLite o PostgreSQL).

Tutorial Paso a Paso de Raspado Web con Python: De Principio a Fin

Veamos un ejemplo real: extraer títulos y precios de productos de un sitio de e-commerce de prueba.

1. Inspecciona la Página Web

Supón que quieres extraer datos de . Al inspeccionar la página, notarás:

- Los títulos de los libros están en etiquetas

<h3>dentro de<article class="product_pod">. - Los precios están en

<p class="price_color">.

2. Descarga la Página

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. Analiza y Extrae los Datos

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. Limpia y Guarda los Datos

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"Guardados {len(df)} libros en books.csv")5. Tips para Resolver Problemas

- Si

booksestá vacío, revisa tus selectores CSS. - Si tienes errores de codificación, abre el CSV con codificación UTF-8.

- Para varias páginas, recorre URLs como

http://books.toscrape.com/catalogue/page-2.html.

Tip avanzado: Para sitios dinámicos o flujos complejos, usa Selenium o Scrapy—o simplemente deja que Thunderbit lo haga por ti.

Conclusión y Puntos Clave

El raspado web con Python abre un mundo de posibilidades para usuarios de negocio, desde generación de leads hasta inteligencia de mercado. Resumiendo:

- Python es la mejor opción para raspado web por su simplicidad y potentes librerías.

- Requests y BeautifulSoup son esenciales para descargar y analizar HTML.

- Scrapy es ideal para proyectos de scraping robustos y a gran escala.

- Thunderbit ofrece una alternativa sin código, impulsada por IA, perfecta para quienes quieren resultados inmediatos sin programar.

- La limpieza y almacenamiento de datos es clave para convertir datos en información útil.

Si quieres profundizar, prueba crear tu propio raspador en un sitio de práctica, o y comprueba lo rápido que puedes obtener datos estructurados de cualquier web. Para más consejos y tutoriales, visita el .

¡Feliz scraping! Que tus datos siempre estén limpios, organizados y listos para usar.

Preguntas Frecuentes

1. ¿Es legal el raspado web?

El raspado web suele ser legal cuando se recopilan datos públicos, pero siempre debes respetar los términos de uso del sitio, el archivo robots.txt y leyes de privacidad como el RGPD. Evita extraer datos personales sin consentimiento y nunca intentes saltar barreras de seguridad o inicio de sesión ().

2. ¿Cuál es la diferencia entre Requests, BeautifulSoup y Scrapy?

- Requests descarga páginas web.

- BeautifulSoup analiza y extrae datos del HTML.

- Scrapy es un framework completo para rastrear y extraer datos a gran escala, gestionando múltiples páginas y exportaciones.

3. ¿Qué pasa si la web carga datos con JavaScript?

Si los datos no están en el HTML inicial, usa o Playwright para automatizar un navegador, o inspecciona las llamadas de red para encontrar endpoints de API accesibles.

4. ¿Cómo evito ser bloqueado al hacer scraping?

Usa cabeceras realistas (especialmente User-Agent), añade retrasos aleatorios entre solicitudes y no sobrecargues el servidor. Para scraping a gran escala, rota IPs o usa proxies ().

5. ¿Puedo extraer datos sin programar?

Por supuesto. te permite extraer datos de cualquier web en dos clics usando IA—sin necesidad de código. Solo instala la extensión de Chrome, describe lo que necesitas y exporta tus datos al instante.

Para más guías y consejos avanzados, no te pierdas el .

Más información