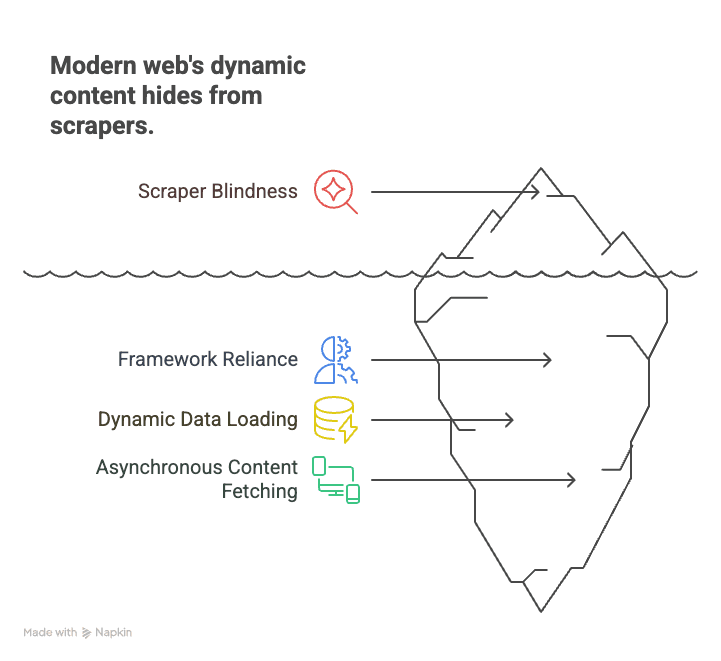

¿Alguna vez has intentado sacar datos de una web moderna—como un portal de pisos, una tienda online o tu red social favorita—y te has encontrado con un muro? Abres la página, miras el HTML y… nada. Los datos que buscas (precios, listados, reseñas) no aparecen por ningún lado. Esto pasa porque hoy en día la web no es solo HTML: la mayoría de los sitios funcionan con JavaScript, y casi el 99% de las páginas usan scripts del lado del cliente para mostrar su contenido (). Los raspadores clásicos son como leer el libreto de una serie: te pierdes toda la acción en directo.

Después de años metido en SaaS y automatización, he visto cómo este cambio ha dejado a equipos de ventas, investigadores y usuarios de negocio sin saber por dónde tirar. Pero la buena noticia es que el crawling de JavaScript ya no es solo para programadores. Con el enfoque correcto (y la ayuda de herramientas con IA como ), cualquiera puede sacar datos incluso de los sitios más dinámicos e interactivos. Vamos a ver qué es el crawling de JavaScript, por qué es tan importante y cómo puedes empezar—sin tener que programar ni una línea.

¿Qué es el crawling de JavaScript? ¿Por qué es tan importante para sacar datos de la web actual?

Vamos a lo básico. El crawling de JavaScript es usar una herramienta o bot capaz de cargar una web, ejecutar todo su JavaScript y sacar el contenido que aparece después de que se ejecutan los scripts. Es un salto enorme respecto al scraping clásico de HTML, que solo pilla el código fuente que manda el servidor. Hoy, ese HTML suele ser solo la estructura: el contenido real (productos, reseñas, precios) lo mete JavaScript, a veces solo después de que interactúas con la página.

¿Por qué es tan clave? Porque la web moderna se monta con frameworks como React, Angular y Vue. Estas aplicaciones de una sola página (SPA) cargan los datos en tiempo real, haciendo que los raspadores estáticos sean “ciegos” para la mayoría del contenido. Por ejemplo:

- Ecommerce: Los precios y el stock aparecen solo después de filtrar o hacer scroll.

- Inmobiliarias: Los listados se cargan a medida que bajas, con detalles que llegan al vuelo.

- Redes sociales: Publicaciones, comentarios y likes se obtienen de forma asíncrona, no están en el HTML inicial.

Los raspadores clásicos ven una página vacía y se pierden lo importante. El crawling de JavaScript, en cambio, es como abrir la página en Chrome, dejar que se cargue todo y luego sacar lo que ves—igual que haría cualquier persona.

En resumen: Si quieres sacar datos de casi cualquier web moderna en 2025, tienes que dominar el crawling de JavaScript. Si no, te vas a perder la mayor parte de la información ().

Los retos del crawling de JavaScript (y cómo superarlos)

El crawling de JavaScript no es solo “scraping con más pasos”. Tiene sus propios retos. Aquí te cuento los más comunes—y cómo puedes solucionarlos.

Renderizado dinámico de contenido

El problema: La mayoría del contenido no está en el HTML. Se carga con JavaScript después de abrir la página—y a veces solo tras hacer scroll, clic o una petición de red. Si solo descargas el HTML, verás contenedores vacíos o marcadores de posición.

La solución: Usa un navegador sin interfaz gráfica (headless browser)—una herramienta que simula un navegador real, ejecuta todos los scripts y espera a que aparezca el contenido. Herramientas como y son el estándar. Permiten:

- Abrir una página y dejar que se ejecute el JavaScript.

- Esperar a que se carguen elementos concretos (como “.product-list”).

- Sacar el contenido ya renderizado del DOM.

Este método es el que manda para sacar datos de sitios dinámicos ().

Barreras anti-bots y de automatización

El problema: Los sitios web cada vez ponen más trabas para bloquear bots. Puedes encontrarte con:

- CAPTCHAs

- Bloqueos de IP o límites de velocidad

- Fingerprinting del navegador (para ver si eres un usuario real)

- Trampas tipo “honeypot” (enlaces falsos para pillar bots)

La solución: Haz crawling de forma responsable y simula el comportamiento humano:

- Respeta el robots.txt y los términos de uso.

- Espacia tus peticiones—mete retrasos aleatorios, no satures el servidor.

- Rota las IPs si vas a sacar datos a lo grande (siempre de forma ética).

- Usa cabeceras de navegador reales y evita señales de bot.

- No saques datos tras login ni intentes saltar CAPTCHAs sin permiso.

Thunderbit, por ejemplo, recomienda sacar solo datos públicos y aplica buenas prácticas para cumplir la normativa ().

Scroll infinito y eventos de usuario

El problema: Muchos sitios usan scroll infinito o requieren clics para cargar más datos. Si tu extractor solo pilla lo que se ve al principio, te pierdes la mayoría del contenido.

La solución: Usa automatización de navegador para:

- Simular el scroll (cargar más resultados como haría un usuario).

- Hacer clic en botones de “Cargar más” o pestañas.

- Esperar a que aparezca el nuevo contenido antes de extraerlo.

La IA de Thunderbit puede detectar estos patrones y gestionar el scroll o la paginación por ti, sin que tengas que programar nada ().

Rendimiento y escalabilidad

El problema: Ejecutar un navegador sin interfaz por cada página gasta muchos recursos. Sacar cientos o miles de páginas puede ser lento y pesado para tu PC.

La solución: Usa crawling concurrente—lanza varios navegadores o pestañas a la vez. O mejor aún, haz el trabajo en la nube. El acelerador en la nube de Thunderbit (Lightning Network) puede sacar hasta 50 páginas a la vez, acelerando mucho los procesos grandes ().

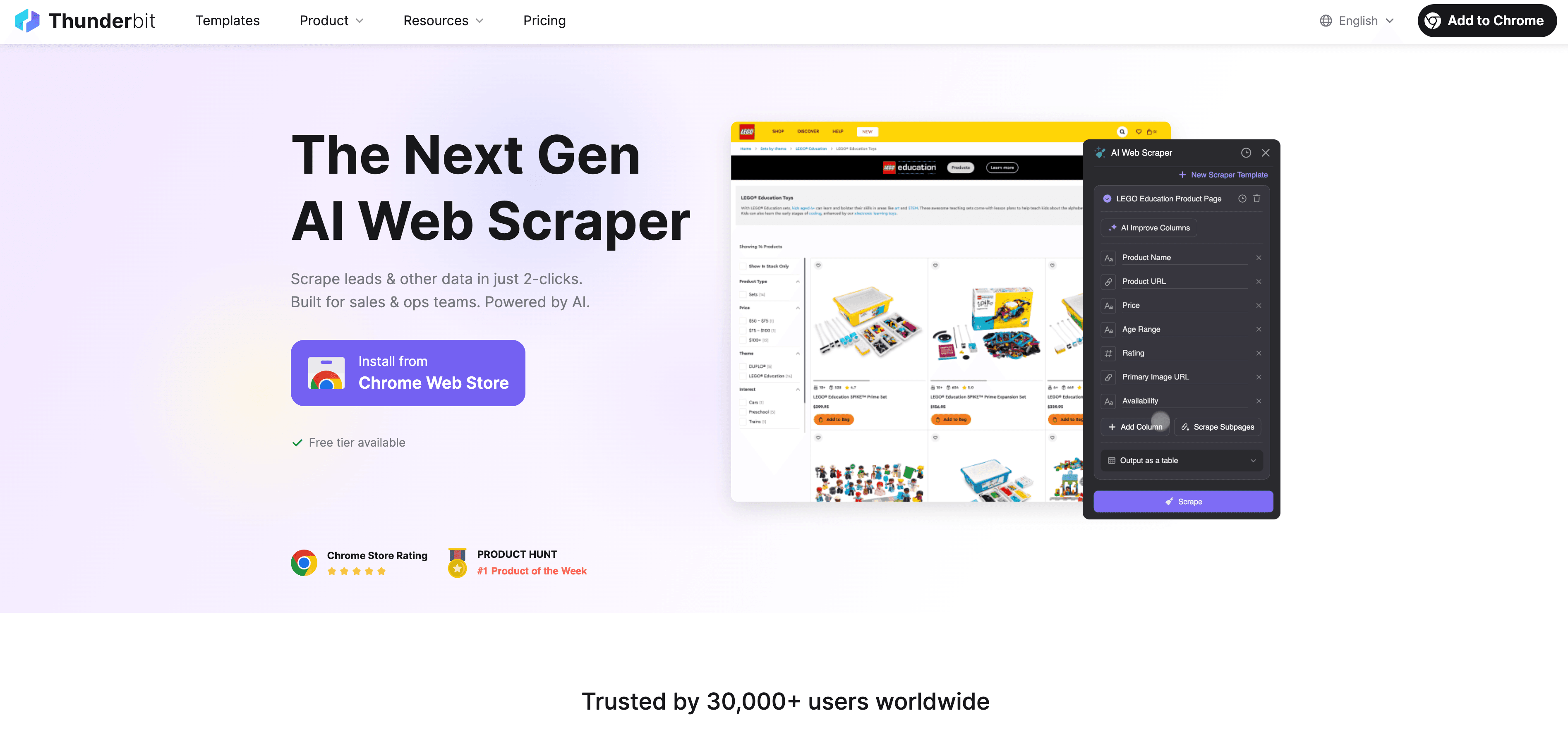

Thunderbit: Crawling de JavaScript fácil y potente

Seamos sinceros: la mayoría de la gente de negocio no quiere programar, ni pelearse con selectores, ni estar pendiente de scripts. Por eso creamos : un 웹 스크래퍼 con IA pensado para quienes necesitan datos de sitios dinámicos con JavaScript, pero no son desarrolladores.

Así es como Thunderbit te lo pone fácil con el crawling de JavaScript:

- Sugerencia de campos con IA: Solo haz clic en “Sugerir campos con IA” y la IA de Thunderbit analiza la página, te recomienda las mejores columnas a sacar y define el tipo de dato adecuado. Olvídate de adivinar o probar a ciegas.

- Extracción en lenguaje natural: Describe lo que quieres en español (“Extrae nombre del producto, precio y valoración”) y Thunderbit se encarga del resto.

- Gestiona contenido dinámico: Thunderbit funciona en un navegador real (tu Chrome o en la nube), ejecutando todo el JavaScript y esperando a que cargue el contenido—igual que una persona.

- Soporte para subpáginas y paginación: ¿Necesitas sacar varias páginas o seguir enlaces a subpáginas (como detalles de productos)? Thunderbit lo hace solo y junta todos los datos en una sola tabla.

- Aceleración en la nube: Para trabajos grandes, la Lightning Network de Thunderbit saca hasta 50 páginas a la vez en la nube, sin cargar tu ordenador.

- Interfaz sin código y fácil de usar: Si sabes usar Excel, puedes usar Thunderbit. Todo es visual, sin líos técnicos.

- Exportación gratuita de datos: Exporta tus datos a Excel, Google Sheets, Airtable, Notion o JSON—sin costes extra.

Thunderbit ya es la herramienta de confianza de más de 30,000 usuarios en todo el mundo, desde equipos de ventas hasta operadores de ecommerce y profesionales inmobiliarios ().

Sugerencia de campos con IA y extracción en lenguaje natural

Aquí es donde Thunderbit marca la diferencia. En vez de buscar en el HTML o escribir selectores XPath, solo tienes que pulsar un botón y la IA de Thunderbit hace el trabajo duro. Analiza la página, entiende su estructura y te recomienda exactamente qué sacar. Si buscas algo concreto, solo escríbelo en lenguaje natural—la IA lo encuentra por ti.

Esto es un antes y un después para quienes empiezan. No necesitas saber nada de HTML, CSS o JavaScript. Solo di lo que quieres y deja que la IA se encargue ().

Crawling de paginación y subpáginas

Thunderbit no se queda en una sola página. Puede:

- Detectar y gestionar la paginación (haciendo clic en “Siguiente” o haciendo scroll para cargar más).

- Sacar subpáginas (como detalles de productos, perfiles de autores o reseñas) y unir los datos en tu tabla principal.

- Gestionar scroll infinito simulando acciones de usuario, para que consigas todos los datos, no solo los que se ven al principio.

Por ejemplo, si quieres sacar una categoría de ecommerce con 20 páginas de productos, Thunderbit recorrerá automáticamente todas las páginas y juntará los resultados. ¿Necesitas detalles de cada producto? Usa el crawling de subpáginas y Thunderbit visitará cada enlace, recogerá la información extra y enriquecerá tu base de datos ().

Lightning Network y aceleración en la nube: escala tu crawling de JavaScript

Cuando necesitas sacar datos de cientos o miles de páginas, hacerlo una a una no es opción. Aquí entra la Lightning Network de Thunderbit.

- Crawling en la nube: Deja el trabajo duro a los servidores de Thunderbit (en EE.UU., Europa y Asia). La nube puede sacar hasta 50 páginas a la vez, acelerando mucho los procesos grandes.

- Crawling concurrente: En vez de esperar a que cada página cargue en tu navegador, la nube de Thunderbit reparte el trabajo entre muchos trabajadores. ¿Tienes que sacar 1,000 productos? La nube puede terminar en minutos, no en horas.

- Crawling programado: ¿Necesitas monitorizar precios o listados cada día? Programa una extracción en lenguaje natural (“cada día a las 9am”) y Thunderbit ejecutará el trabajo automáticamente, exportando los datos a tu Google Sheet o base de datos ().

Esto es ideal para equipos de ventas, ecommerce y operaciones que necesitan datos frescos a gran escala—sin contratar desarrolladores ni montar servidores.

Extracción masiva y multipágina

Thunderbit te permite:

- Sacar directorios o catálogos completos (por ejemplo, todos los productos de una categoría, todos los anuncios de una zona).

- Exportar los resultados a Excel, Google Sheets, Airtable o Notion con un solo clic.

- Ahorrar horas (o días) de trabajo manual—un usuario sacó cientos de anuncios inmobiliarios, con datos de agentes incluidos, en menos de 10 minutos.

Guía paso a paso: cómo empezar con el crawling de JavaScript en Thunderbit

¿Listo para probarlo? Así puedes empezar con Thunderbit, aunque nunca hayas sacado datos de una web.

Configura tu primer crawling

- Instala Thunderbit: Descarga la . Regístrate gratis.

- Elige tu objetivo: Ve al sitio web que quieres extraer. Si requiere login, inicia sesión primero (Thunderbit funciona en el contexto de tu navegador).

- Abre Thunderbit: Haz clic en el icono de Thunderbit en la barra de Chrome. Elige la fuente de datos (página actual, lista de URLs o archivo).

- Selecciona el modo de ejecución: Para trabajos pequeños o sitios con login, usa el modo navegador. Para grandes volúmenes, cambia a modo nube para extraer en paralelo.

- Sugerir campos con IA: Haz clic en “Sugerir campos con IA”. La IA de Thunderbit analizará la página y te recomendará columnas a extraer (como “Nombre del producto”, “Precio”, “URL de imagen”).

- Ajusta las columnas: Renombra, añade o elimina campos según lo que necesites. Añade instrucciones personalizadas si quieres formatear o categorizar los datos.

- Configura paginación/scroll: Si el sitio usa paginación o scroll infinito, activa la opción correspondiente en la configuración de Thunderbit.

- Haz clic en “Extraer”: Thunderbit cargará la(s) página(s), ejecutará todo el JavaScript y sacará los datos en una tabla.

Extracción y exportación de datos

- Previsualiza los resultados: Thunderbit muestra tus datos en una tabla. Revisa que todo esté completo y correcto.

- Exporta: Haz clic en “Exportar” para descargar en Excel, CSV, JSON o enviar directamente a Google Sheets, Airtable o Notion.

- Valida: Comprueba algunas filas con la web original para asegurarte de que todo coincide.

- Solución de problemas: Si falta información, prueba a hacer scroll en la página, ajusta las instrucciones de IA o cambia al modo nube para mejor rendimiento.

Para tutoriales más detallados, consulta la o el .

Buenas prácticas para un crawling de JavaScript seguro y legal

Con gran poder de extracción viene gran responsabilidad. Así puedes mantenerte dentro de la legalidad (y la ética):

- Respeta el robots.txt y los Términos de Servicio: Comprueba siempre si el sitio permite scraping. Si prohíbe bots, no lo fuerces ().

- Evita sacar datos personales: El RGPD y la CCPA consideran protegidos nombres, emails y perfiles—aunque sean públicos. Solo saca datos personales si tienes un motivo legítimo y consentimiento.

- No saltes logins ni CAPTCHAs: Es un área legal gris (o peor). Limítate a datos públicos.

- Espacia tus peticiones: No sobrecargues los servidores. El modo nube de Thunderbit reparte las peticiones y rota IPs para evitar bloqueos.

- Usa los datos de forma ética: No publiques contenido protegido ni uses la información de forma indebida.

- Elimina datos si te lo piden: Si alguien pide que borres su información, hazlo.

Thunderbit está pensado para fomentar el cumplimiento: solo datos públicos, sin hackeos y con opciones claras de exportación para un uso responsable.

Cómo evitar riesgos legales

- Limítate a datos públicos y no personales.

- No saques de sitios que lo prohíban expresamente.

- Si tienes dudas, pide permiso o usa la API oficial del sitio.

- Guarda registros de lo que sacas y cuándo.

- Atiende de inmediato cualquier solicitud de retirada de datos.

Para más información, consulta .

Comparativa de soluciones de crawling de JavaScript: Thunderbit vs. herramientas tradicionales

| Aspecto | Puppeteer/Playwright (Código) | Sitebulb (Crawler SEO) | Thunderbit (IA sin código) |

|---|---|---|---|

| Tiempo de configuración | Horas (requiere código) | Moderado (configuración) | Minutos (clics) |

| Nivel de habilidad | Alto (solo desarrolladores) | Medio | Bajo (cualquiera) |

| Gestiona contenido JS | Sí (programación manual) | Sí (para SEO) | Sí (IA, automático) |

| Paginación/Subpáginas | Programación manual | Limitado | Automático (IA detecta) |

| Mantenimiento | Alto (se rompe con cambios) | Moderado | Bajo (IA se adapta) |

| Escalabilidad | Manual (escribir código) | Limitada | Nube integrada (50x) |

| Opciones de exportación | Manual (escribir código) | CSV/Excel | Excel, Sheets, Notion |

| Ideal para | Desarrolladores, flujos personalizados | Auditorías SEO | Usuarios de negocio, analistas |

Thunderbit es la mejor opción para usuarios de negocio que buscan resultados rápidos y sin líos técnicos ().

Conclusión y puntos clave

El crawling de JavaScript ya no es una habilidad de nicho—es imprescindible para cualquiera que necesite datos web en 2025. Con casi el 99% de los sitios usando scripts del lado del cliente, el scraping tradicional ya no da la talla (). ¿La buena noticia? No necesitas ser desarrollador para dominarlo.

Recuerda:

- El contenido dinámico está en todas partes: Si quieres sacar datos de sitios modernos, necesitas una herramienta que ejecute JavaScript.

- Los retos existen, pero tienen solución: Navegadores sin interfaz, esperas inteligentes y aceleración en la nube permiten sacar hasta los datos más complejos.

- Thunderbit lo pone fácil: Con sugerencias de campos por IA, extracción en lenguaje natural, soporte para subpáginas y paginación, y aceleración en la nube, Thunderbit acerca el crawling de JavaScript a todos.

- Cumple siempre la normativa: Respeta las reglas de cada sitio, las leyes de privacidad y los principios éticos.

- Empieza hoy mismo: Instala Thunderbit, elige un sitio y descubre cuántos datos puedes sacar en solo unos clics.

¿Quieres profundizar más? Visita el para más guías, o mira nuestros para ver ejemplos paso a paso.

¡Feliz crawling! Que tus datos sean siempre dinámicos, completos y listos para usar.

Preguntas frecuentes

1. ¿Qué es el crawling de JavaScript y en qué se diferencia del scraping tradicional?

El crawling de JavaScript usa una herramienta que carga la página, ejecuta todo el JavaScript y saca el contenido que aparece después. El scraping tradicional solo toma el HTML, perdiendo la mayor parte de la información en sitios modernos.

2. ¿Por qué necesito crawling de JavaScript para sacar datos de negocio?

Porque casi todos los sitios actuales usan JavaScript para cargar contenido dinámicamente. Sin crawling de JavaScript, te pierdes listados de productos, reseñas, precios y otros datos clave.

3. ¿Cómo facilita Thunderbit el crawling de JavaScript para principiantes?

Thunderbit usa IA para sugerir campos, gestionar contenido dinámico y automatizar la paginación y el crawling de subpáginas. Puedes describir lo que quieres en lenguaje natural—sin programar.

4. ¿Es legal el crawling de JavaScript? ¿Qué debo tener en cuenta?

El crawling de JavaScript es legal si se hace de forma responsable: limítate a datos públicos, respeta robots.txt y los términos de uso, y no saques datos personales sin consentimiento. Thunderbit fomenta el cumplimiento y el uso responsable.

5. ¿Cómo puedo escalar el crawling de JavaScript para trabajos grandes?

La Lightning Network de Thunderbit (crawling en la nube) te permite sacar hasta 50 páginas a la vez, facilitando tareas como monitorización de precios o generación de leads en miles de páginas.

Más información: