Todavía me acuerdo de la primera vez que intenté sacar datos de una página para armar una lista de prospectos de ventas. Pensé: “Bueno, sé JavaScript. ¿Qué tan complicado puede ser esto?” Un par de horas después, estaba perdido entre selectores raros, contenido que desaparecía de la nada y una nueva admiración por los bloqueos anti-bots. Y no era solo yo: dicen que los datos son cada vez más importantes para su negocio, y el web scraping es clave en esa movida. Pero a medida que las webs se ponen más complejas, hacer scraping con JavaScript es tanto una ventaja como un dolor de cabeza.

En esta guía te voy a contar todo lo que he aprendido sobre el web scraping usando JavaScript: desde lo más básico hasta los retos más locos, y cómo herramientas modernas con IA como pueden ahorrarte muchos dolores de cabeza con los selectores. Ya sea que estés recolectando productos para tu tienda online o armando una base de leads para ventas, vamos a meternos de lleno en cómo extraer datos de la web con JavaScript (y un poco de ayuda de la IA).

Web Scraping usando JavaScript: Lo básico y sus límites

Vamos a lo esencial: hacer web scraping usando JavaScript es extraer datos de páginas web de forma programada, ya sea corriendo scripts en el navegador o usando Node.js en el backend. JavaScript es el idioma de la web, así que es lógico usarlo para scraping, sobre todo con la cantidad de librerías como Cheerio (para analizar HTML estático) y Puppeteer o Playwright (para automatizar navegadores sin interfaz).

¿Por qué JavaScript es tan usado para scraping?

- Acceso directo al DOM: Puedes manipular el DOM en el navegador igual que lo haría cualquier persona.

- Ecosistema: Node.js te da acceso a librerías potentes para hacer peticiones HTTP, analizar datos y automatizar tareas.

- Flexibilidad: Puedes automatizar inicios de sesión, clics, scrolls... todo lo que harías en Chrome, lo puedes programar.

Pero aquí viene el lío: las webs modernas cambian todo el tiempo. Usan JavaScript para cargar contenido dinámico, reorganizar el DOM y poner defensas anti-bots. Eso significa que tu script puede funcionar hoy y romperse mañana. Vas a estar actualizando selectores, peleando con pop-ups y persiguiendo datos que se cargan de forma asíncrona. Es como jugar al “whack-a-mole”, pero con corchetes y llaves.

Por qué las webs modernas complican el scraping usando JavaScript

Antes, hacer scraping era tan fácil como descargar el HTML y buscar los datos que necesitabas. Pero hoy la web es otra cosa. Sitios como Facebook Marketplace, Amazon o hasta portales inmobiliarios locales funcionan con frameworks de JavaScript que generan el contenido en tiempo real, esconden datos tras scrolls infinitos y anidan la información en estructuras de DOM súper enredadas.

El análisis tradicional de HTML ya no alcanza. Por ejemplo, sacar reseñas de productos o comentarios anidados no es solo encontrar el <div> correcto: hay que entender cómo se relacionan los elementos, el contexto de cada campo e incluso el sentido de los datos.

Ahí es donde entra el preprocesamiento inteligente. En vez de solo capturar el HTML y rezar, necesitas una forma de entender semánticamente la página: ¿qué es el nombre del producto, el precio, una reseña? Eso es mucho pedir para JavaScript puro, pero justo ahí es donde las herramientas con IA pueden marcar la diferencia.

Herramientas clásicas de Web Scraping usando JavaScript

Vamos a hablar de herramientas. El stack clásico de scraping usando JavaScript suele incluir una (o varias) de estas opciones:

- Cheerio: Perfecto para analizar HTML estático. Es como jQuery, pero para el servidor.

- Puppeteer/Playwright: Automatización de navegadores sin interfaz. Estas herramientas abren un navegador real, ejecutan JavaScript y te dejan interactuar con la página como si fueras una persona (o un robot con cafeína).

El flujo típico es así:

- Pedir la página (con o sin navegador sin interfaz).

- Esperar a que cargue el contenido (a veces usando

waitForSelectoro algo parecido). - Analizar el DOM para encontrar los datos que buscas.

- Extraer y estructurar los resultados.

¿Suena fácil? Pero aquí está el truco: cada vez que la web cambia su diseño, tus selectores dejan de funcionar. Si aparece un pop-up nuevo, tu script se cae. Si cambian el orden de los campos, tus datos se mezclan. El mantenimiento se vuelve eterno.

Comparativa de las librerías de scraping más usadas en JavaScript

| Funcionalidad | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| Ideal para | HTML estático | Páginas dinámicas | Páginas dinámicas |

| Automatización de navegador | No | Sí | Sí |

| Maneja contenido JS | No | Sí | Sí |

| Velocidad | Rápido | Más lento | Más lento |

| Simplicidad de API | Sencilla | Moderada | Moderada |

| Evasión anti-bot | Limitada | Moderada | Moderada |

| Multinavegador | No | Solo Chrome | Chrome, Firefox, WebKit |

| Casos de uso | Sitios simples, APIs | Sitios interactivos | Sitios interactivos |

Cheerio es rapidísimo para páginas estáticas o APIs que devuelven HTML, pero no puede ejecutar JavaScript. Puppeteer y Playwright son ideales para páginas dinámicas, aunque son más pesados y requieren más configuración. Ambos pueden automatizar inicios de sesión, clics y scrolls, pero tendrás que programar la lógica para cada cambio que haga el sitio.

Thunderbit: Web Scraping con IA para flujos en JavaScript

Aquí es donde la cosa se pone buena. En Thunderbit, nos dimos cuenta de que el scraping no es solo capturar HTML: se trata de entender la página como lo haría una persona. Por eso creamos , una extensión de Chrome de Raspador Web IA que le da comprensión semántica al web scraping.

¿Cómo funciona?

- Thunderbit convierte la página web en una versión en Markdown—más limpia y estructurada.

- Después, nuestra IA analiza ese Markdown para identificar campos, relaciones y contexto—sabe qué es un precio, una reseña o un emoji decorativo.

- ¿El resultado? Obtienes datos estructurados y etiquetados, resistentes a cambios de diseño, contenido dinámico y hasta jerarquías de DOM cambiantes.

Para los usuarios de negocio, esto significa menos limpieza manual de datos, menos scripts rotos y más tiempo para analizar la info. Y para los desarrolladores, permite enfocarse en automatizar la navegación (inicios de sesión, clics, scroll) y dejar que Thunderbit se encargue de la extracción complicada.

Paso a paso: Web Scraping usando JavaScript (tradicional y con Thunderbit)

Vamos a la acción. Te muestro un ejemplo real: extraer listados de productos de una tienda online de prueba. Primero, lo hacemos a la vieja escuela con Puppeteer. Después, verás cómo mejorar tu flujo delegando la extracción a Thunderbit.

Paso 1: Prepara tu entorno de scraping usando JavaScript

Primero, necesitas tener instalado. Una vez listo, instala Puppeteer:

1npm install puppeteerSi prefieres Playwright (que soporta más navegadores), usa:

1npm install playwrightSi no eres técnico: tranquilo, no necesitas ser un crack en JavaScript. Solo copia y pega los códigos, y te explico cada parte.

Paso 2: Navega e interactúa con páginas dinámicas

Las webs modernas suelen esconder datos tras inicios de sesión, pop-ups y scrolls infinitos. Así puedes automatizar esos pasos con Puppeteer:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // Ir a la página de login

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'tu_usuario');

8 await page.type('#password', 'tu_contraseña');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // Ir a los productos

12 await page.goto('https://example.com/products');

13 // Hacer scroll para cargar más

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // Esperar a que carguen los productos

21 await page.waitForSelector('.product-card');

22 // ... (extraeremos los datos en el siguiente paso)

23})();Este script inicia sesión, navega a la página de productos y hace scroll para cargar más elementos. Lo importante es esperar a que los elementos aparezcan—si no, te llevas datos vacíos.

Paso 3: Extrae datos con JavaScript

Ahora, vamos a sacar los datos. Supón que cada producto está en un div .product-card:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);Errores típicos:

- Los selectores se rompen fácil. Si la web cambia

.product-titlepor.title, tu script falla. - Datos ocultos. A veces, los precios o reseñas se cargan por AJAX después de cargar la página.

- Medidas anti-bot. Si haces muchas peticiones, te pueden bloquear.

Paso 4: Lleva la extracción al siguiente nivel con Thunderbit IA

Aquí entra Thunderbit. En vez de pelearte con selectores y lógica frágil, puedes pasar el HTML renderizado (o hasta una captura de pantalla) a Thunderbit para que la IA haga la extracción.

¿Cómo funciona en la práctica?

- Usa Puppeteer o Playwright para automatizar la navegación, inicios de sesión y scrolls.

- Cuando estés en la página que quieres extraer, captura el HTML:

1const pageContent = await page.content();- Envía este HTML a Thunderbit (usando la ) para la extracción con IA.

Thunderbit hará lo siguiente:

- Convertirá la página a Markdown para un análisis semántico más fácil.

- Usará IA para identificar campos, relaciones y contexto.

- Te dará datos estructurados que puedes exportar a Excel, Google Sheets, Airtable o Notion.

Olvídate de perseguir selectores que cambian o limpiar datos desordenados.

Cómo lidiar con contenido dinámico y carga asíncrona

El contenido dinámico es el enemigo de todo raspador. Las webs suelen cargar datos después del render inicial—scroll infinito, botones “Cargar más” o reseñas que llegan por AJAX.

Estrategias clásicas:

- Usa

waitForSelectorpara pausar hasta que aparezcan los elementos. - Espera a que la red esté “idle” (sin más peticiones) antes de extraer.

- Haz scrolls o clics manualmente para cargar más datos.

Pero estos métodos son frágiles. Si la web cambia su lógica de carga, tu script se rompe.

El enfoque de Thunderbit: Al convertir la página a Markdown y dejar que la IA analice la estructura, Thunderbit depende menos de jerarquías o IDs específicos del DOM. Incluso si la web cambia su diseño, mientras el contenido esté ahí, la IA de Thunderbit suele encontrarlo y extraerlo. Eso significa menos mantenimiento y datos más confiables.

Armando un flujo de datos sostenible: del script al insight de negocio

El scraping no es solo una tarea puntual—es el inicio de un flujo de datos. Así me gusta verlo:

- Automatiza la navegación y extracción con JavaScript (Puppeteer/Playwright).

- Delega a Thunderbit la estructuración y etiquetado con IA.

- Exporta los resultados a tu herramienta favorita: Excel, Google Sheets, Airtable, Notion.

- Programa tareas recurrentes con el de Thunderbit—solo describe el intervalo (“cada lunes a las 9am”), pon tus URLs y deja que Thunderbit haga el resto.

- Cierra el ciclo integrando los datos estructurados en tus flujos de negocio—ya sea prospección de ventas, monitoreo de precios o investigación de mercado.

Esta combinación—JavaScript para la automatización, Thunderbit para la extracción con IA—te permite crear flujos de datos repetibles y de bajo mantenimiento que mantienen tu negocio actualizado con información precisa.

Conclusión: ¿Qué enfoque de Web Scraping te conviene?

Entonces, ¿cuál es la mejor forma de hacer scraping web usando JavaScript? Mi opinión:

- El scraping tradicional con JavaScript (Cheerio, Puppeteer, Playwright) es ideal para sitios simples o cuando necesitas control total sobre la automatización del navegador. Pero implica mucho mantenimiento: los selectores se rompen, los diseños cambian y las defensas anti-bot son cada vez más duras.

- La extracción con IA de Thunderbit suma una capa de comprensión semántica. Es más resistente a los cambios, requiere menos limpieza manual y te deja enfocarte en el análisis en vez de depurar scripts.

¿Cuándo usar cada uno?

- Para extracciones rápidas y puntuales de páginas simples, usa Cheerio o Puppeteer.

- Para sitios complejos y dinámicos—o si quieres un flujo de trabajo a prueba de cambios—combina tus scripts de JavaScript con la extracción IA de Thunderbit.

- Para usuarios de negocio que no quieren programar, la extensión de Chrome de Thunderbit es la forma más fácil de pasar de una web a una hoja de cálculo en dos clics.

¿Quieres ver más ejemplos? Date una vuelta por el para guías detalladas sobre , y mucho más.

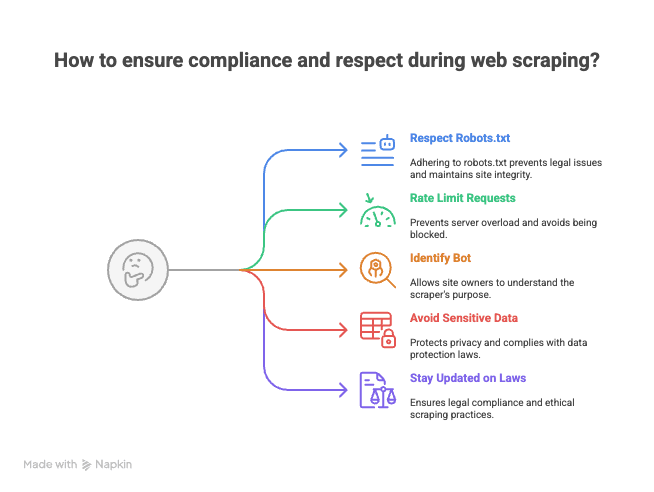

Extra: Consejos para hacer scraping de forma ética y legal

Antes de lanzar tus scripts de scraping al mundo, un consejo rápido (de alguien que ya recibió algún que otro email “amable” de administradores web):

- Respeta robots.txt y los términos de uso. No todos los sitios permiten ser scrapeados.

- Limita la frecuencia de tus peticiones. No satures los servidores—espacia tus solicitudes para evitar bloqueos (o algo peor, que te metan en una lista negra).

- Identifica tu bot. Usa un User-Agent personalizado para que los administradores sepan quién eres.

- Evita extraer datos sensibles o personales. Limítate a información pública y respeta la privacidad.

- Mantente informado sobre leyes y buenas prácticas. El web scraping está en una zona legal gris en algunos países.

Recuerda: con gran poder de scraping viene una gran responsabilidad (y, a veces, una carta de cese y desista).

El web scraping usando JavaScript es tanto arte como ciencia. Con las herramientas adecuadas—y un poco de ayuda de la IA—puedes convertir la web en tu propio campo de datos estructurados. Y si alguna vez te atascas, ya sabes dónde encontrarme (seré el que está depurando selectores con un café y una pestaña de Thunderbit abierta).

¡Feliz scraping!

Preguntas frecuentes

1. ¿Qué es el web scraping usando JavaScript y por qué es tan popular?

El web scraping usando JavaScript es extraer datos de páginas web de forma programada, ejecutando scripts en el navegador o usando Node.js en el backend. Es popular porque JavaScript permite acceso directo al DOM, tiene un ecosistema rico de librerías para peticiones HTTP y automatización, y ofrece flexibilidad para automatizar interacciones como inicios de sesión, clics y scrolls.

2. ¿Cuáles son los principales retos al extraer datos de sitios web modernos y dinámicos?

Las webs modernas suelen usar frameworks de JavaScript para cargar contenido dinámico, esconder datos tras scrolls infinitos o pop-ups y cambiar su diseño seguido. Esto hace que los métodos tradicionales de scraping sean frágiles, ya que los scripts pueden romperse fácil si cambian los selectores o si los datos se cargan de forma asíncrona.

3. ¿Cómo se comparan las herramientas tradicionales de scraping en JavaScript como Cheerio, Puppeteer y Playwright?

- Cheerio es ideal para HTML estático y es rápido, pero no puede manejar contenido generado por JavaScript ni automatizar navegadores.

- Puppeteer y Playwright están pensados para páginas dinámicas, soportan automatización de navegador y pueden manejar contenido JavaScript, pero son más lentos y requieren más configuración. Playwright soporta varios navegadores, mientras que Puppeteer está enfocado en Chrome.

4. ¿Qué ventajas ofrece Thunderbit frente a los métodos tradicionales de scraping?

Thunderbit usa IA para entender semánticamente las páginas web, convirtiéndolas en un formato estructurado en Markdown y extrayendo campos de datos etiquetados. Este enfoque es más resistente a cambios de diseño, reduce la necesidad de limpiar datos manualmente y minimiza el mantenimiento frente al scraping tradicional basado en selectores.

5. ¿Cuáles son las mejores prácticas para hacer web scraping de forma ética y legal?

- Revisa y respeta siempre el robots.txt y los términos de uso de la web.

- Limita la frecuencia de tus peticiones para no sobrecargar los servidores.

- Identifica tu bot con un User-Agent personalizado.

- Evita extraer datos sensibles o personales y limítate a información pública.

- Mantente informado sobre las consideraciones legales y mejores prácticas en tu país.

Más información: