Nunca se me va a olvidar la primera vez que intenté estar al tanto de todas las noticias durante el lanzamiento de un producto. Tenía tres monitores encendidos, un montón de pestañas de Google News abiertas y esa sensación de que seguro se me escapaba algo importante—como un anuncio inesperado de la competencia o una crisis de reputación de la nada. Y no era solo yo: hoy en día, más de pueden publicarse en internet en un solo día. Eso es más de lo que podría leer en toda mi vida, y ni hablar de antes de tomarme el primer café.

Si trabajas en ventas, marketing, operaciones o comunicación, seguro sabes de lo que hablo. Hacer seguimiento manual de las noticias es como intentar tomar agua de una manguera a presión. Por eso, automatizar la extracción de noticias de Google con Python es tan poderoso: te permite recolectar información automáticamente, analizar datos y no perderte nada—ya sea para monitorear tu marca, vigilar a la competencia o detectar tendencias antes de que exploten. En esta guía, te voy a mostrar desde un ejemplo básico hasta cómo armar un google news scraper python robusto y fácil de repetir. Vamos a hablar de código, buenas prácticas y cómo dejar tus datos listos para análisis (con alguna anécdota y chiste de por medio).

¿Por qué es clave la extracción de noticias de Google para los negocios?

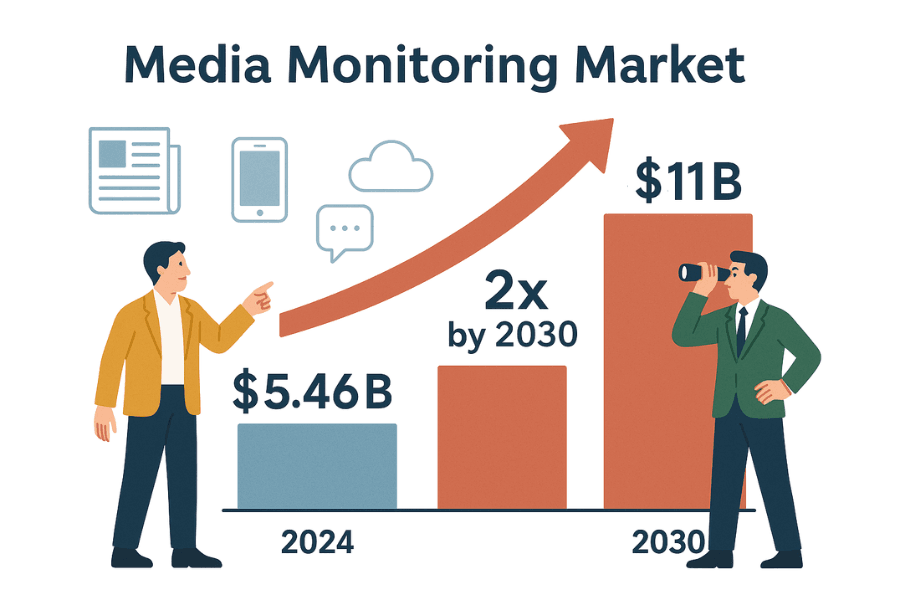

Seamos realistas: los negocios se mueven al ritmo de los titulares. Ya sea en comunicación, ventas o estrategia, necesitas saber qué se está diciendo—y necesitas saberlo ya. El mercado global de herramientas de monitoreo de medios ya vale y se espera que se duplique para 2030. ¿Por qué? Porque las empresas no pueden darse el lujo de perderse una noticia que pueda afectar su reputación, ventas o cumplimiento normativo.

Así es como extraer resultados de Google News puede convertirte en el crack de la oficina (o al menos en la persona que siempre está al tanto):

| Caso de uso | Ventaja de automatizar la recopilación de noticias |

|---|---|

| Monitoreo de reputación de marca | Detecta prensa negativa o crisis a tiempo y responde rápido (mira cómo Dove evitó una crisis de reputación). |

| Inteligencia competitiva | Sigue lanzamientos, cambios de directivos o fusiones de la competencia para ajustar tu estrategia (más info). |

| Detección de oportunidades de venta | Monitorea empresas objetivo para detectar rondas de financiación, expansiones o eventos relevantes (caso de estudio). |

| Análisis de tendencias y mercado | Agrupa noticias del sector para identificar tendencias emergentes y el sentimiento del mercado (por qué es importante). |

| Gestión de riesgos | Configura alertas sobre demandas, regulaciones o cambios de políticas que puedan afectar a tu empresa (ejemplos). |

¿Hacerlo a mano? Es lento, te puedes equivocar y seguro se te escapan oportunidades o amenazas importantes (). Automatizar el web scraping google news, en cambio, te da un flujo constante y ordenado de noticias—sin miedo a perderte nada, solo inteligencia lista para usar.

Primeros pasos: Fundamentos del web scraping con Python (ejemplo para principiantes)

Antes de meternos de lleno con Google News, vamos a practicar con un sitio abierto: . Este sitio es ideal para aprender, así que puedes experimentar sin miedo a bloqueos o líos legales.

Nuestro plan:

- Hacer una petición a la página principal.

- Analizar el HTML con BeautifulSoup.

- Extraer títulos y precios de los libros.

- Guardar los datos en un DataFrame de pandas y exportar a CSV.

- Recorrer la paginación y manejar errores.

Paso 1: Hacer peticiones y analizar HTML

Primero, pedimos la página principal usando la librería requests de Python:

1import requests

2url = "http://books.toscrape.com/index.html"

3response = requests.get(url)

4print(response.status_code) # Debería mostrar 200 si todo salió bienUn código 200 significa que todo va bien ().

Ahora, analizamos el HTML:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(response.text, 'html.parser')Esto nos da un objeto soup—la forma más sencilla de navegar el DOM de la página en Python ().

Paso 2: Extraer datos y guardar en CSV

Vamos a obtener todos los libros:

1books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

2print(f"Encontrados {len(books)} libros en esta página")Ahora, extraemos títulos y precios:

1book_list = []

2for item in books:

3 title = item.h3.a["title"]

4 price = item.find("p", class_="price_color").get_text()

5 book_list.append({"Title": title, "Price": price})Guardamos en CSV usando pandas:

1import pandas as pd

2df = pd.DataFrame(book_list)

3df.to_csv("books.csv", index=False)O, si prefieres, con el módulo csv de Python:

1import csv

2keys = book_list[0].keys()

3with open("books.csv", "w", newline="", encoding="utf-8") as f:

4 writer = csv.DictWriter(f, fieldnames=keys)

5 writer.writeheader()

6 writer.writerows(book_list)Abre books.csv en Excel y disfruta de tus nuevos superpoderes de datos.

Paso 3: Manejar paginación y errores

¿Quieres todos los libros, no solo los de la primera página? Usa un bucle:

1all_books = []

2for page in range(1, 51): # 50 páginas en total

3 url = f"http://books.toscrape.com/catalogue/page-{page}.html"

4 try:

5 res = requests.get(url, timeout=10)

6 if res.status_code != 200:

7 break

8 soup = BeautifulSoup(res.text, 'html.parser')

9 books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

10 for item in books:

11 title = item.h3.a["title"]

12 price = item.find("p", class_="price_color").get_text()

13 all_books.append({"Title": title, "Price": price})

14 except requests.exceptions.RequestException as e:

15 print(f"Fallo en la petición: {e}")

16 continueEste bucle recorre las páginas, se detiene si una no existe y captura errores de red. (Tip: añade time.sleep(1) entre peticiones para no saturar el sitio.)

¡Listo! Ya tienes lo básico del web scraping: peticiones, análisis, extracción, paginación y manejo de errores. Estos mismos pasos usaremos para el raspado de noticias de Google.

Extracción de noticias de Google con Python: paso a paso

¿Listo para subir de nivel? Vamos a crear un raspador Google News con Python que saque titulares, enlaces, fuentes y fechas—convirtiendo el caos de noticias en datos ordenados para análisis.

Prepara tu entorno de Python

Asegúrate de tener Python 3 y estas librerías:

1pip install requests beautifulsoup4 pandas()

También vas a necesitar un User-Agent para simular un navegador real—si no, Google puede bloquearte ().

Armando el raspador de Google News en Python

Vamos por partes:

1. Define la URL de búsqueda y los parámetros

Las URLs de búsqueda de Google News tienen este formato:

1https://news.google.com/search?q=TU_CONSULTA&hl=es-ES&gl=ES&ceid=ES:esq: tu término de búsquedahl: idioma (por ejemplo,es-ES)gl: país (por ejemplo,ES)ceid: país:idioma (por ejemplo,ES:es)

Así lo configuras en Python:

1base_url = "https://news.google.com/search"

2params = {

3 'q': 'tecnología',

4 'hl': 'es-ES',

5 'gl': 'ES',

6 'ceid': 'ES:es'

7}

8headers = {

9 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)...'

10}()

2. Obtén la página de resultados

1response = requests.get(base_url, params=params, headers=headers)

2html = response.text

3print(response.status_code)()

3. Analiza y extrae los datos

Analiza el HTML y extrae los artículos:

1soup = BeautifulSoup(html, 'html.parser')

2articles = soup.find_all('article')

3news_data = []

4for art in articles:

5 headline_tag = art.find('h3')

6 title = headline_tag.get_text() if headline_tag else None

7 link_tag = art.find('a')

8 link = link_tag['href'] if link_tag else ''

9 if link.startswith('./'):

10 link = 'https://news.google.com' + link[1:]

11 source_tag = art.find(attrs={"class": "wEwyrc"})

12 source = source_tag.get_text() if source_tag else None

13 time_tag = art.find('time')

14 time_text = time_tag.get_text() if time_tag else None

15 snippet_tag = art.find('span', attrs={"class": "xBbh9"})

16 snippet = snippet_tag.get_text() if snippet_tag else None

17 news_data.append({

18 "title": title,

19 "source": source,

20 "time": time_text,

21 "link": link,

22 "snippet": snippet

23 })()

Guarda los resultados en CSV:

1df = pd.DataFrame(news_data)

2df.to_csv("google_news_results.csv", index=False)Manejo de datos faltantes

Siempre revisa si las etiquetas existen antes de acceder a ellas. El HTML de Google puede cambiar—algunas veces tendrás un resumen, otras no. Si falta un campo, ponlo como None o vacío.

Extraer varias páginas y evitar bloqueos

Google News usa scroll infinito, no paginación tradicional. Con requests, normalmente solo obtendrás el primer lote de resultados. Si necesitas más:

- Usa el feed RSS de tu consulta (puede devolver más resultados; mira )

- Usa un navegador sin cabeza (Selenium, Playwright) para hacer scroll (avanzado)

- O simplemente raspa con frecuencia (por ejemplo, cada hora) para captar nuevos artículos

Ojo: Google puede bloquearte si haces peticiones muy rápido. Algunos usuarios reportan errores 429 tras solo 10 peticiones seguidas (). Para evitarlo:

- Añade

time.sleep(random.uniform(2,6))entre peticiones - Rota User-Agents e IPs si raspas a gran escala

- Detecta CAPTCHAs o páginas de bloqueo en el HTML y detén el raspado

Cómo hacer tu extracción de Google News reproducible y lista para análisis

El truco está aquí: un buen raspado no es solo “obtener los datos”—es hacerlos repetibles y listos para análisis. Si quieres que tus dashboards, monitoreo de reputación o seguimiento de la competencia funcionen a largo plazo, debes controlar idioma, región, tiempo y duplicados.

Filtrar por idioma, región y tiempo

Google News personaliza mucho el contenido. Para resultados consistentes:

- Usa los parámetros

hl,glyceidpara idioma y región () - Por ejemplo,

hl=es&gl=ES&ceid=ES:espara noticias en español de España

Para filtrar por tiempo:

- Google News no tiene un parámetro directo para “últimas 24 horas”, pero los resultados suelen estar ordenados por fecha

- Puedes filtrar después de raspar: si

timecontiene “hace una hora”, “hace minutos” o “Hoy”, consérvalo; si no, descártalo - Para más control, usa el feed RSS o los operadores avanzados de búsqueda (aunque no siempre funcionan)

Filtrado y eliminación de duplicados

Los duplicados arruinan cualquier análisis. Así puedes evitarlos:

- Lista blanca de fuentes/temas: Filtra tus datos para incluir solo ciertas fuentes o temas. Incluso puedes usar el operador

source:en tu consulta (por ejemplo,q=Tesla source:Reuters). - Eliminar duplicados por URL: Normaliza las URLs quitando parámetros de seguimiento (como

utm_*). Por ejemplo:

1import urllib.parse

2clean_link = urllib.parse.urljoin(link, urllib.parse.urlparse(link).path)()

- Eliminar duplicados por título: Si varios artículos tienen títulos muy parecidos, quédate solo con uno. Puedes comparar en minúsculas y sin signos de puntuación.

- Registrar artículos vistos: Si raspas a diario, guarda un hash de cada URL normalizada. Antes de añadir un artículo nuevo, revisa si ya lo tienes.

Así tus datos estarán limpios y listos para análisis—sin contar titulares dos veces ni sesgar resultados de sentimiento ().

Comparando enfoques: Python Scraper vs. APIs de Google News

¿Conviene crear tu propio raspador en Python o usar una API de Google News de terceros? Comparemos:

| Criterio | Raspador Python DIY | API de Google News de terceros |

|---|---|---|

| Esfuerzo de implementación | Escribir y depurar código; adaptarse a cambios del sitio | Llamadas API listas para usar; sin parseo de HTML |

| Flexibilidad | Extrae cualquier campo o sigue subenlaces | Limitado a los campos y opciones que ofrece la API |

| Control de datos | Control total sobre los datos en bruto | Los datos ya vienen procesados; dependes del proveedor |

| Escalabilidad y velocidad | Limitado por tu IP/recursos; riesgo de bloqueos | Pensado para escalar; el proveedor gestiona proxies y bloqueos |

| Fiabilidad | Puede fallar si Google cambia el HTML o bloquea tu IP | Muy fiable; las APIs se adaptan a los cambios de Google |

| Mantenimiento | Continuo: actualizar selectores, manejar anti-bots | Mínimo: el proveedor se encarga del mantenimiento |

| Coste | Gratis (salvo tu tiempo y posibles proxies) | De pago—normalmente por petición o cuota mensual (ejemplos de precios) |

| Riesgo de bloqueo | Alto si no tienes cuidado; Google puede banear tu IP | Bajo; la API gestiona bloqueos y reintentos |

| Actualidad de los datos | Tú decides cuándo raspar, pero si es muy frecuente puedes ser bloqueado | En tiempo real; límites altos con el plan adecuado |

| Consideraciones legales/Términos de uso | Debes cumplir los términos de Google; el riesgo es tuyo | Aún debes tener cuidado, pero las APIs suelen alegar uso legítimo (¡no es asesoría legal!) |

Para proyectos personales o monitoreo pequeño, el DIY es ideal para aprender y tener control. Para producción o gran escala, las APIs te ahorran tiempo y dolores de cabeza. (Y si quieres lo mejor de ambos mundos—sin código ni mantenimiento—mira Thunderbit más abajo.)

Solución de problemas comunes al extraer noticias de Google

Raspar Google News no siempre es pan comido. Esto es lo que puede fallar (y cómo arreglarlo):

- CAPTCHAs o páginas de “tráfico inusual”: Baja la velocidad de tus peticiones, rota User-Agents y usa proxies si hace falta. Si ves un CAPTCHA, para el raspado y espera ().

- Errores HTTP 429/503: Te están bloqueando o limitando. Implementa backoff exponencial, revisa robots.txt y evita scrapers en paralelo.

- Cambios en la estructura HTML: Google actualiza su interfaz seguido. Inspecciona el nuevo HTML y actualiza tus selectores. Usa try/except para evitar caídas.

- Campos faltantes: No todos los artículos tienen resumen o fuente. Adapta tu código para manejarlo.

- Entradas duplicadas: Elimina duplicados como explicamos antes.

- Problemas de codificación: Usa UTF-8 siempre al guardar archivos.

- Contenido cargado por JavaScript: La mayoría de resultados de Google News son server-side, pero si necesitas contenido renderizado por JS, usa Selenium o Playwright (avanzado).

Para más tips, revisa y .

Buenas prácticas para extraer noticias de Google de forma responsable

Hablemos de ética y buenas prácticas—porque con gran poder de scraping viene gran responsabilidad:

- Respeta robots.txt: El robots.txt de Google News prohíbe rastrear ciertos caminos (). Aunque puedas raspar, es buena práctica seguir estas reglas.

- No sobrecargues los servidores: Añade pausas, raspa en horas de baja demanda y no satures el sitio.

- Usa los datos solo para fines permitidos: Limítate a titulares, resúmenes y enlaces para análisis. No publiques artículos completos ().

- Cita y atribuye las fuentes: Si compartes análisis, menciona a Google News y a los medios originales.

- Monitorea y actualiza tu web scraper: La web cambia—tu código también debe hacerlo.

- Cumple con la privacidad y la ley: Guarda los datos de forma segura y cumple con las normativas de privacidad.

- Uso legítimo y límites de frecuencia: No abuses—raspa a pequeña escala y prepárate para detenerte si te lo piden ().

En resumen: raspa como un buen ciudadano digital. Tu yo del futuro (y tu equipo de IT) te lo agradecerán.

Resumen y próximos pasos

En resumen:

- Aprendiste los fundamentos del web scraping con requests y BeautifulSoup en Python—empezando por un sitio estático y luego con Google News.

- Construiste un flujo repetible para extraer noticias de Google: controlando idioma, región y tiempo; eliminando duplicados y dejando los datos listos para análisis.

- Comparaste el raspado DIY con las APIs: entendiendo las ventajas y desventajas en control, fiabilidad y coste.

- Te llevaste trucos para solucionar problemas y buenas prácticas para un scraping responsable y ético.

¿Y ahora? Aplica estas técnicas a lo que necesites: monitorea tu marca, sigue a la competencia o crea tu propio dashboard de noticias. ¿Quieres ir más allá? Prueba a raspar otros sitios de noticias, automatiza tu pipeline de datos o haz análisis de sentimiento sobre los titulares.

Y si te cansas de mantener scripts en Python (o simplemente quieres ahorrar tiempo), prueba . Thunderbit es una extensión de Chrome con IA que te permite extraer noticias de Google y otros sitios en solo un par de clics—sin necesidad de programar. Con funciones como “Sugerir campos con IA”, raspado programado, navegación por subpáginas y exportación instantánea a Excel o Google Sheets, es la forma más sencilla de automatizar la recopilación de noticias para tu equipo. (Incluso puedes .)

Para más consejos sobre scraping, visita el , o explora nuestras guías sobre , y .

¡Feliz scraping! Que tus feeds de noticias siempre estén frescos, ordenados y un paso adelante de la competencia.

Escrito por Shuai Guan, Cofundador y CEO de Thunderbit. Llevo años en SaaS, automatización e IA, y todavía disfruto convirtiendo el caos en datos útiles. Si tienes preguntas o quieres compartir experiencias de scraping, ¡conectemos!

Preguntas frecuentes

1. ¿Por qué las empresas deberían considerar extraer noticias de Google con Python?

Extraer noticias de Google permite a las empresas automatizar la recopilación de artículos relevantes para su marca, competencia o sector. Esta automatización ayuda a monitorear en tiempo real posibles crisis de reputación, movimientos de la competencia, oportunidades de ventas, tendencias de mercado y riesgos. El seguimiento manual es lento y puede pasar por alto novedades importantes, mientras que el scraping garantiza un flujo estructurado y actualizado de titulares y noticias relevantes.

2. ¿Cuáles son los pasos básicos para extraer noticias de Google con Python?

El proceso incluye:

- Configurar el entorno de Python con librerías como

requests,BeautifulSoupypandas. - Definir la URL de búsqueda de Google News y los parámetros (consulta, idioma, región).

- Hacer una petición para obtener la página de resultados con los encabezados adecuados (incluyendo User-Agent).

- Analizar el HTML para extraer detalles como título, enlace, fuente, fecha y resumen.

- Guardar los datos extraídos en un archivo CSV para su análisis.

- Manejar datos faltantes y eliminar duplicados para obtener un dataset limpio y listo para análisis.

3. ¿Qué desafíos puedo encontrar al extraer noticias de Google y cómo los soluciono?

Desafíos comunes:

- CAPTCHAs o advertencias de “tráfico inusual”: Reduce la velocidad, rota User-Agents y usa proxies si es necesario.

- Limitaciones de frecuencia (errores HTTP 429/503): Añade pausas y evita el scraping en paralelo.

- Cambios en la estructura HTML: Actualiza tus selectores y usa bloques try/except.

- Campos de datos faltantes o inconsistentes: Verifica siempre si existe la etiqueta antes de extraer datos.

- Entradas duplicadas: Elimina duplicados por URL o título.

- Problemas de codificación: Usa codificación UTF-8 al guardar archivos.

- Contenido cargado por JavaScript: Para necesidades avanzadas, usa herramientas como Selenium o Playwright.

4. ¿Cómo puedo hacer que mi flujo de extracción de noticias de Google sea reproducible y listo para análisis?

Para asegurar reproducibilidad y datos limpios:

- Controla idioma y región usando los parámetros

hl,glyceiden la URL. - Filtra resultados por tiempo, ya sea después de raspar o usando feeds RSS.

- Elimina duplicados normalizando URLs y comparando títulos.

- Lleva registro de los artículos ya vistos para evitar contar dos veces.

- Guarda tus datos de forma segura y documenta tu proceso para futuras actualizaciones.

5. ¿Debería crear mi propio raspador de Google News o usar una API de terceros?

Crear tu propio raspador te da control total, flexibilidad y suele ser gratis (salvo tu tiempo y posibles proxies). Sin embargo, requiere mantenimiento continuo, es más propenso a fallos si Google cambia el HTML y tiene mayor riesgo de bloqueo. Las APIs de terceros son más fiables, fáciles de escalar y gestionan los bloqueos por ti, pero tienen coste y pueden limitar el control sobre los datos. Para proyectos pequeños o aprendizaje, el DIY es ideal; para producción o gran escala, las APIs suelen ser la mejor opción.