En estos tiempos donde los datos mandan y la competencia por sacarles jugo es cada vez más feroz, el raspado web se ha vuelto una herramienta clave. Todos los días, se extraen miles de millones de páginas web para conseguir información, comparar precios, generar leads o hacer investigaciones, lo que mueve desde guerras de precios en e-commerce hasta los avances más recientes en IA (). El mercado global del raspado web apunta a superar los 9 mil millones de dólares para finales de 2025, así que si todavía no estás usando un raspador web eficiente, probablemente estés dejando pasar oportunidades enormes ().

Después de años metido en SaaS y automatización, te puedo decir que elegir el raspador web correcto puede cambiar el rumbo de cualquier proyecto. Últimamente, Rust me ha dejado boquiabierto por todo lo que ofrece. En esta guía te cuento por qué Rust es una opción brutal para crear tu propio raspador web, cómo arrancar paso a paso y cómo puedes combinar Rust con herramientas de IA como para tener lo mejor de los dos mundos: velocidad, seguridad y menos dolores de cabeza.

¿Por qué apostar por Rust para tu raspador web?

Vamos al grano: ¿por qué Rust? Es una duda muy común, sobre todo si vienes de Python o Node.js para scraping. Aquí te dejo las razones por las que Rust sobresale:

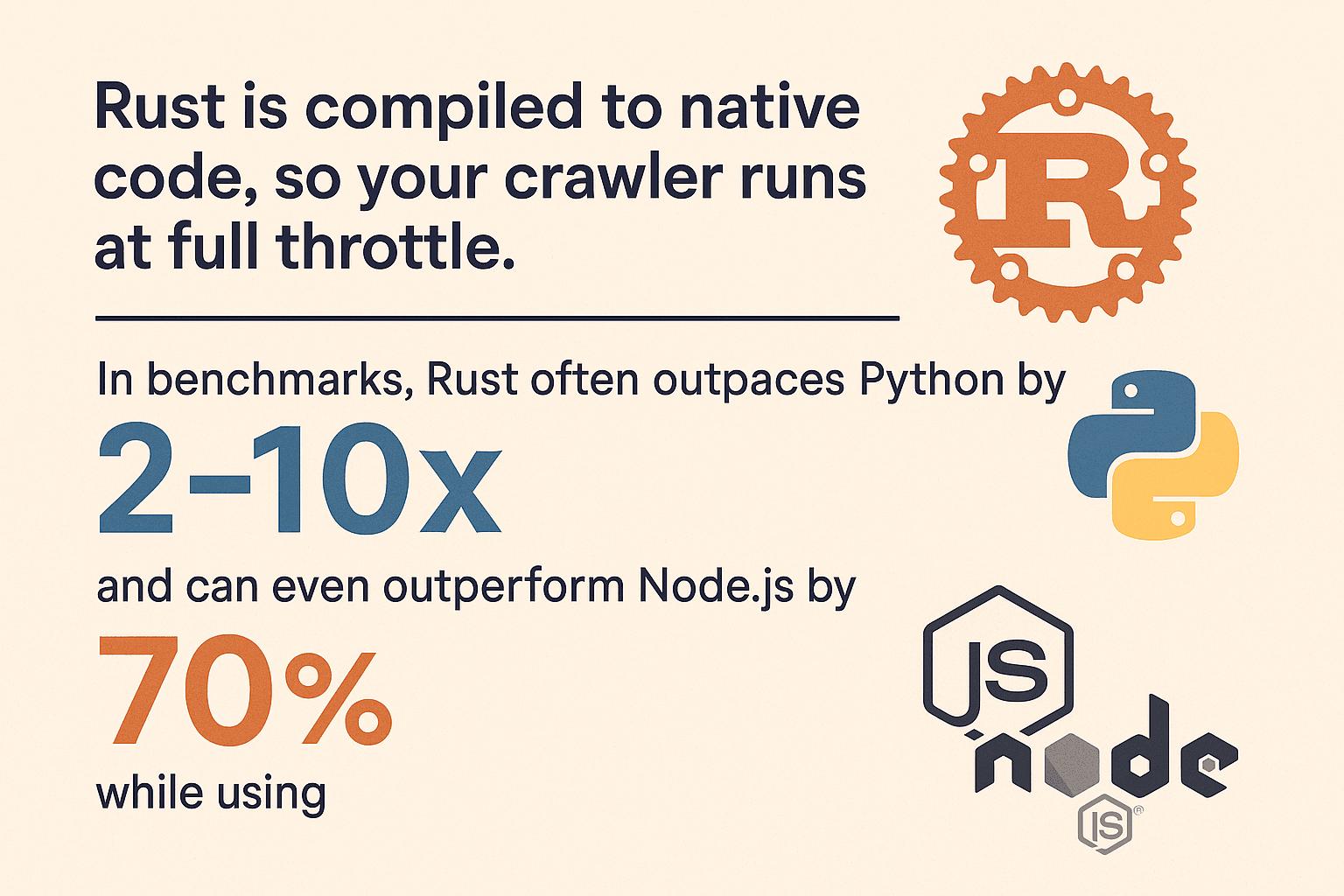

- Velocidad brutal: Rust se compila a código nativo, así que tu raspador va a toda máquina. En pruebas, Rust suele ser 2 a 10 veces más rápido que Python y hasta 70% más veloz que Node.js usando 90% menos memoria (, ).

- Gestión de memoria segura: El sistema de propiedad de Rust elimina los bugs raros y las fugas de memoria. El compilador te avisa antes de que la líes.

- Concurrencia sin miedo: Rust está pensado para la concurrencia. ¿Quieres procesar 100 páginas a la vez? Adelante: el sistema de tipos de Rust mantiene tus hilos bajo control y evita condiciones de carrera.

- Fiabilidad: El manejo de errores de Rust (con

ResultyOption) te obliga a pensar en los posibles fallos. Tu raspador no se va a caer por un error inesperado. - Seguridad: Sin desbordamientos de búfer ni referencias nulas. Las garantías de Rust hacen que tu raspador sea menos vulnerable a webs maliciosas o con errores.

Si lo comparas con Python (fácil, pero lento y traga memoria) o Node.js (bueno para I/O, pero monohilo y pesado), Rust te da rendimiento y estabilidad top, sobre todo cuando tu proyecto crece ().

Cómo preparar tu entorno para un raspador web en Rust

¿Listo para arrancar? Así puedes dejar todo listo para trabajar con Rust:

1. Instala Rust y Cargo

Rust se instala con , que gestiona las versiones de Rust y la herramienta de construcción cargo. Descarga el instalador para tu sistema operativo y sigue los pasos. En Windows, puede que te pida instalar Visual C++ Build Tools.

Verifica que todo esté bien:

1rustc --version

2cargo --versionSi ves los números de versión, ya estás listo.

2. Crea un proyecto nuevo

Abre la terminal y ejecuta:

1cargo new rust_web_crawler

2cd rust_web_crawlerEsto te crea un proyecto con Cargo.toml y src/main.rs.

3. Agrega las dependencias clave

Para el raspado web, vas a necesitar:

- (cliente HTTP)

- (parseo HTML con selectores CSS)

- (runtime asíncrono, si quieres scraping async)

- (para exportar datos)

Agrégalas así:

1cargo add reqwest scraper csv tokio --features fullO edita tu Cargo.toml:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. Elige tu editor y herramientas

Te recomiendo VS Code con la extensión . Te da autocompletado, documentación y todo el linting que necesitas. Para proyectos grandes, JetBrains CLion o IntelliJ con el plugin de Rust también van de lujo.

5. Tips para resolver problemas

- Si

cargono aparece, revisa que.cargo/binesté en tu PATH. - En Windows, instala las herramientas de compilación C++ si te lo pide.

- Si tienes errores de dependencias, ejecuta

cargo updateo revisa que no haya errores de tipeo enCargo.toml.

Paso a paso: tu primer raspador web en Rust

Vamos a montar un raspador básico que obtenga una página, saque datos de productos y los exporte a CSV. Es un ejemplo sencillo, pero puedes ampliarlo como quieras.

Obtener páginas web con Rust

Empieza importando reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}En producción, cambia los unwrap() por un manejo de errores decente:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};Parseo y extracción de datos

Ahora, usa scraper para analizar el HTML y sacar la info de los productos.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}Este método, inspirado en , funciona para la mayoría de páginas de e-commerce o directorios.

Gestión de URLs y evitar duplicados

En un raspador real, vas a querer seguir enlaces y evitar visitar la misma página dos veces. Aquí tienes un patrón clásico:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // Usa el crate `url`!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}No olvides normalizar las URLs (usando el crate ) para manejar rutas relativas, barras finales y fragmentos.

Sácale el jugo a la concurrencia para raspar más rápido

Aquí es donde Rust realmente se luce. Procesar páginas una a una es lento; mejor hazlo en paralelo.

Opción 1: Multihilo

Crea varios hilos, cada uno trabajando con la cola de URLs. Usa Arc<Mutex<>> para compartir el estado. Para proyectos pequeños, esto va de sobra.

Opción 2: Async/Await con Tokio

Si quieres máxima velocidad, usa asincronía. Con tokio y reqwest async, puedes lanzar cientos de peticiones en paralelo sin saturar la memoria.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;El Rust asíncrono no solo es rápido, también es seguro: sin condiciones de carrera ni bugs raros, solo rendimiento puro ().

Exporta y guarda los datos extraídos

Cuando ya tienes los datos, seguro quieres exportarlos. El crate lo hace facilísimo:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();También puedes serializar estructuras directamente con o exportar a JSON si necesitas datos más complejos.

Cómo Thunderbit te ahorra tiempo y dolores de cabeza extrayendo datos web

Ahora hablemos de . Aunque me encanta programar, a veces solo quiero los datos rápido. Thunderbit es una extensión de Chrome con IA que te permite extraer datos en segundos, sin escribir ni una línea de código.

Thunderbit es un Raspador Web IA para Chrome que ayuda a usuarios de negocio a extraer datos de páginas web usando inteligencia artificial. Es una herramienta de productividad que ahorra tiempo y automatiza tareas repetitivas en la web.

¿Por qué Thunderbit es diferente?

- Sugerencia de campos con IA: Thunderbit analiza la página y te sugiere columnas para extraer—nombres, emails, precios, lo que necesites ().

- Raspado con un clic: Solo haz clic en “Scrape” y Thunderbit organiza los datos en una tabla estructurada.

- Raspado de subpáginas: ¿Necesitas información de páginas de detalle? Thunderbit puede visitar cada enlace y enriquecer tu tabla automáticamente ().

- Paginación y scroll infinito: Thunderbit detecta y gestiona páginas con paginación o scroll infinito.

- Exportación gratuita de datos: Exporta a Excel, Google Sheets, Notion, Airtable o CSV, sin complicaciones.

- AI Autofill: Automatiza el llenado de formularios o inicios de sesión con IA, facilitando el raspado de datos detrás de autenticaciones.

Thunderbit es un salvavidas tanto para usuarios de negocio como para desarrolladores, sobre todo cuando te enfrentas a sitios dinámicos o llenos de JavaScript.

¿Cuándo usar Thunderbit y cuándo Rust?

- Thunderbit: Perfecto para prototipos rápidos, extracciones puntuales o cuando necesitas que personas sin perfil técnico puedan extraer datos.

- Rust: Ideal para proyectos grandes, personalizados o integrados, donde buscas el máximo rendimiento y control.

Y la verdad, la combinación de ambos es donde está la magia.

Comparativa de rendimiento: Rust frente a otras tecnologías

Vamos a lo técnico. ¿Cómo se mide Rust frente a otras opciones populares?

| Lenguaje/Framework | Velocidad | Uso de Memoria | Concurrencia | Estabilidad | Ecosistema |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 Baja | 🟢 Excelente | 🟢 Alta | Media |

| Python (Scrapy) | 🚀 | 🔴 Alta | 🟡 Limitada | 🟡 Media | 🟢 Grande |

| Node.js | 🚀🚀 | 🔴 Alta | 🟢 Buena | 🟡 Media | 🟢 Grande |

| Go | 🚀🚀 | 🟢 Baja | 🟢 Excelente | 🟢 Alta | Media |

- Rust suele ser 2 a 10 veces más rápido que Python y puede usar menos del 10% de la memoria (, ).

- Node.js es bueno para I/O, pero su ejecución JS es monohilo y puede atascarse con parseos pesados.

- Go es un gran rival, pero la seguridad de memoria y las abstracciones de bajo coste de Rust le dan ventaja en raspadores de alto rendimiento y larga duración.

Si necesitas escalar o exprimir cada recurso, Rust es difícil de igualar.

Combina Thunderbit y Rust para máxima eficiencia

Mi forma favorita de trabajar: usar Thunderbit y Rust juntos.

- Prototipado rápido: Usa Thunderbit para mapear un sitio y sacar datos de muestra. Así entiendes la estructura antes de programar.

- Divide y vencerás: Deja que Thunderbit gestione páginas dinámicas, complejas o autenticadas (con AI Autofill y subpáginas), mientras tu raspador en Rust procesa el grueso de páginas estáticas o APIs.

- Raspado programado: Configura extracciones periódicas con Thunderbit y deja que tu backend en Rust procese o combine los resultados.

- Empodera a los no desarrolladores: Permite que tu equipo de operaciones o marketing use Thunderbit para necesidades puntuales, liberando a los desarrolladores para tareas más complejas.

- Resiliencia: Si tu raspador en Rust falla por un cambio de diseño, la IA de Thunderbit suele adaptarse al instante, sin tocar el código.

Este enfoque híbrido te da lo mejor de los dos mundos: velocidad y flexibilidad con Thunderbit, potencia y control con Rust.

Consejos y buenas prácticas para raspadores web en Rust

Montar un raspador robusto no es solo cuestión de código: hay que anticipar el caos de la web.

Retos comunes

- Medidas anti-bots: Usa User-Agents realistas, respeta el

robots.txt, limita la velocidad de tus peticiones y considera proxies para scraping intensivo (). - CAPTCHAs e inicios de sesión: Para sitios con CAPTCHAs o logins complejos, usa el AI Autofill de Thunderbit o un navegador sin cabeza (por ejemplo, o ), solo si es necesario.

- Sitios con mucho JavaScript: Si los datos se cargan por AJAX, busca las llamadas API subyacentes. Si necesitas renderizar JS, considera Thunderbit o un navegador sin cabeza.

- Manejo de errores: Usa siempre un manejo de errores adecuado (

Result,Option), pon timeouts y registra los errores para depurar. - Concurrencia: Utiliza estructuras seguras para hilos (

Arc<Mutex<>>oDashMap) y evita cuellos de botella en el estado compartido. - Gestión de memoria: Si vas a procesar millones de páginas, guarda los datos en disco en vez de mantener todo en memoria.

- Ética y cumplimiento: Respeta los términos de los sitios, no sobrecargues servidores y cumple con las leyes de privacidad de datos.

Buenas prácticas

- Código modular: Separa la lógica de obtención, parseo y almacenamiento para que sea fácil de mantener.

- Parámetros configurables: Usa archivos de configuración o argumentos de línea de comandos para URLs, concurrencia, retrasos, etc.

- Logs: Utiliza el crate

logpara registros estructurados. - Pruebas: Escribe tests unitarios para tu lógica de parseo usando HTML de ejemplo.

- Monitoreo: Supervisa la salud de tu raspador—CPU, memoria, errores—sobre todo en trabajos largos.

Para más consejos, échale un ojo a la guía de y el tutorial de .

Conclusión y puntos clave

Crear un raspador web en Rust no solo es un reto técnico interesante, sino una ventaja estratégica en el mundo actual dominado por los datos. Quédate con esto:

- Rust es una bestia para el raspado web: rápido, seguro y preparado para la concurrencia.

- El paso a paso importa: Prepara tu entorno, obtén y parsea páginas, gestiona URLs, añade concurrencia y exporta tus datos.

- Thunderbit es tu as bajo la manga para scraping rápido y sin código, sobre todo en sitios complejos o dinámicos.

- Combina ambos para máxima eficiencia: Usa Thunderbit para prototipos y páginas complicadas, Rust para escalar y personalizar.

- Sé práctico: A veces la mejor solución son unos clics, no cientos de líneas de código.

Si quieres llevar tu raspado web al siguiente nivel, prueba Rust—y no dudes en dejar que haga el trabajo pesado cuando lo necesites. ¿Buscas más consejos sobre scraping y automatización? Visita el .

¡Feliz raspado! Que tus datos sean siempre limpios, rápidos y un poco más inteligentes.

Preguntas frecuentes

1. ¿Por qué debería usar Rust para crear un raspador web en vez de Python o Node.js?

Rust ofrece un rendimiento, seguridad de memoria y soporte de concurrencia muy superiores. Python y Node.js son más sencillos para scripts rápidos, pero Rust es ideal para raspadores a gran escala, de larga duración o críticos donde la velocidad y la fiabilidad son clave ().

2. ¿Cuáles son las librerías esenciales para crear un raspador web en Rust?

Necesitarás reqwest para peticiones HTTP, scraper para parsear HTML, tokio para concurrencia asíncrona y csv para exportar datos. El crate url también es útil para normalizar URLs.

3. ¿Cómo puedo manejar sitios con mucho JavaScript o autenticación en Rust?

Para sitios con mucho JS, busca las llamadas API subyacentes o usa un navegador sin cabeza con crates como fantoccini. Para páginas autenticadas, gestiona cookies con reqwest o utiliza la función AI Autofill de Thunderbit para automatizar inicios de sesión.

4. ¿Qué ventaja tiene combinar Thunderbit con Rust?

Thunderbit acelera la extracción de datos con scraping sin código impulsado por IA—perfecto para prototipos, páginas dinámicas o para usuarios no técnicos. Rust es ideal para raspadores personalizados y de alto rendimiento. Juntos, te permiten avanzar rápido y escalar eficientemente.

5. ¿Cómo evito bloqueos o baneos al raspar?

Respeta el robots.txt, usa cabeceras realistas, limita la velocidad de tus peticiones y considera proxies para scraping masivo. Siempre haz scraping de forma ética y cumpliendo las normas del sitio y las leyes de privacidad ().

¿Quieres ver Thunderbit en acción? y empieza a raspar de forma más inteligente hoy mismo. Y para más guías sobre automatización web, visita el .

Más información