¿Alguna vez has sentido que te ahogas entre tanta información digital? Créeme, no eres el único. Hoy, cada vez que haces clic, te desplazas o tocas la pantalla, se generan nuevos datos en algún rincón del planeta. De hecho, para 2025 se calcula que llegaremos a la increíble cifra de de datos a nivel mundial, suficiente para poner a prueba hasta al más crack de las hojas de cálculo. Pero aquí está el verdadero desafío: no basta con tener todos esos datos, lo importante es saber recolectar la información correcta, en el momento justo, y convertirla en algo útil para tu negocio.

Aquí es donde la recolección de datos se vuelve clave. Y en 2025, con los Raspadores Web IA liderando la carga, recolectar datos ya no es solo juntar información: es el primer paso para construir una estrategia de datos sólida. Después de años metido en SaaS y automatización, he visto de cerca cómo pasar de la recolección manual a las herramientas con IA está revolucionando equipos de ventas, e-commerce y operaciones. Así que vamos al grano: ¿qué es la recolección de datos, por qué es tan importante y cómo la IA está cambiando las reglas para empresas de todos los tamaños?

Desmitificando la recolección de datos: ¿Qué significa recolectar datos?

Vamos a lo básico. La recolección de datos es el proceso de juntar y extraer grandes cantidades de información de diferentes fuentes—como páginas web, APIs, bases de datos online, redes sociales y más—para analizarlas y tomar decisiones (). En otras palabras: es la forma de conseguir la materia prima (los datos) que alimenta desde estudios de mercado hasta modelos de IA.

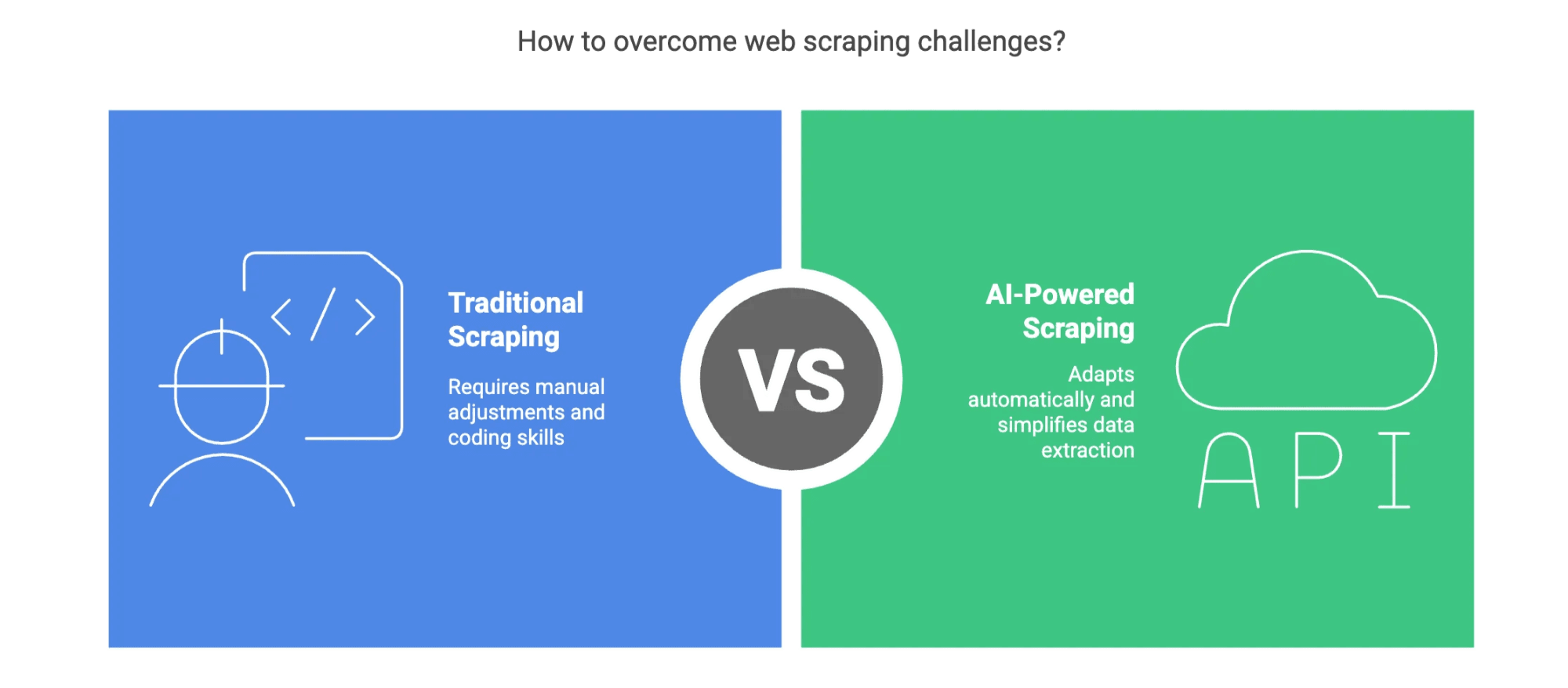

Pero aquí viene lo interesante. Antes, recolectar datos era un trabajo manual y pesado: copiar y pegar, escribir scripts frágiles y rezar para que la web no cambiara de diseño de un día para otro. Hoy, la recolección moderna de datos, sobre todo con IA, es otra historia. Los Raspadores Web IA pueden leer, entender y estructurar datos incluso de las webs más caóticas, usando procesamiento de lenguaje natural (NLP) y aprendizaje automático para adaptarse en tiempo real ().

Y ojo con un error común: recolectar datos ≠ pensar en datos. Recolectar es solo el primer paso—el acto de juntar información. Pensar en datos es transformar esa materia prima en ideas y acciones estratégicas. No puedes tener una sin la otra, pero no confundas la pala con el jardín.

Por qué la recolección de datos es clave para el éxito de tu empresa

¿Por qué deberías preocuparte por la recolección de datos en 2025? Fácil: se ha convertido en la columna vertebral de cualquier estrategia empresarial moderna. Ya sea en ventas, marketing, e-commerce o inmobiliarias, la capacidad de recolectar y usar datos de forma eficiente es lo que separa a los que lideran del resto.

Estas son las razones que hacen que esto sea urgente:

![]()

- ROI y eficiencia: afirma que invertir en datos e IA trae beneficios reales. La recolección de datos con IA reduce el trabajo manual, minimiza errores y te da información más actual y útil.

- Inteligencia competitiva: Tener datos en tiempo real te permite vigilar a la competencia, seguir tendencias del mercado y reaccionar más rápido que nunca.

- Generación de leads y automatización: Los equipos de ventas pueden crear listas de prospectos en minutos, no semanas. Marketing puede automatizar la investigación de campañas. Operaciones puede optimizar flujos de trabajo.

Para que lo veas más claro, aquí tienes una tabla con ejemplos reales:

| Industria | Caso de uso de recolección de datos | Valor estratégico |

|---|---|---|

| Ecommerce | Monitoreo de precios, scraping de SKUs | Precios dinámicos, optimización de inventario |

| Bienes raíces | Listados de propiedades, seguimiento de precios | Captación más rápida de oportunidades, análisis de mercado |

| Ventas | Generación de leads, extracción de contactos | Leads más calificados, contacto personalizado |

| Marketing | Análisis de sentimiento, campañas de la competencia | Análisis de tendencias en tiempo real, benchmarking de campañas |

| Finanzas | Scraping de noticias, fuentes de datos alternativos | Señales de trading más rápidas, evaluación de riesgos |

En resumen: recolectar datos no es solo una tarea técnica—es una palanca estratégica para crecer, ser eficiente e innovar.

La evolución: de la recolección manual a la recolección de datos con IA

Todavía me acuerdo cuando “recolectar datos” era copiar y pegar, noches eternas y alguna que otra crisis existencial cuando una web cambiaba de diseño. (Si alguna vez perdiste horas por un raspador roto, sabes de lo que hablo). Pero esos días ya están quedando atrás.

El salto a la recolección de datos con IA es una revolución total. Así ha cambiado el panorama:

| Aspecto | Scraping manual | Scraping con IA |

|---|---|---|

| Velocidad | 2–3 páginas por minuto | 1000+ páginas por minuto |

| Precisión | Propenso a errores humanos | Más del 99% de precisión |

| Escalabilidad | Limitado por el trabajo humano | Tareas concurrentes casi ilimitadas |

| Adaptación a cambios | Se rompe si el sitio cambia | Algoritmos de ML se adaptan automáticamente |

| Contenido dinámico | Dificultad con sitios JavaScript | Maneja contenido dinámico y pesado en JS |

| Eficiencia de costos | Costos laborales altos | Menor costo por dato |

Los Raspadores Web IA usan NLP y reconocimiento inteligente de campos para “leer” páginas web casi como lo haría una persona, pero a la velocidad y escala de una máquina. Se adaptan a cambios de diseño, manejan contenido dinámico y estructuran los datos automáticamente. Eso significa menos trabajo repetitivo, menos errores y mucho más tiempo para analizar.

Herramientas de AI Web Scraper: Cómo Thunderbit lleva la recolección inteligente de datos al siguiente nivel

Hablemos un poco de Thunderbit. Como cofundador y CEO, de verdad creo que estamos creando una solución que simplifica radicalmente la recolección de datos para cualquier usuario de negocio.

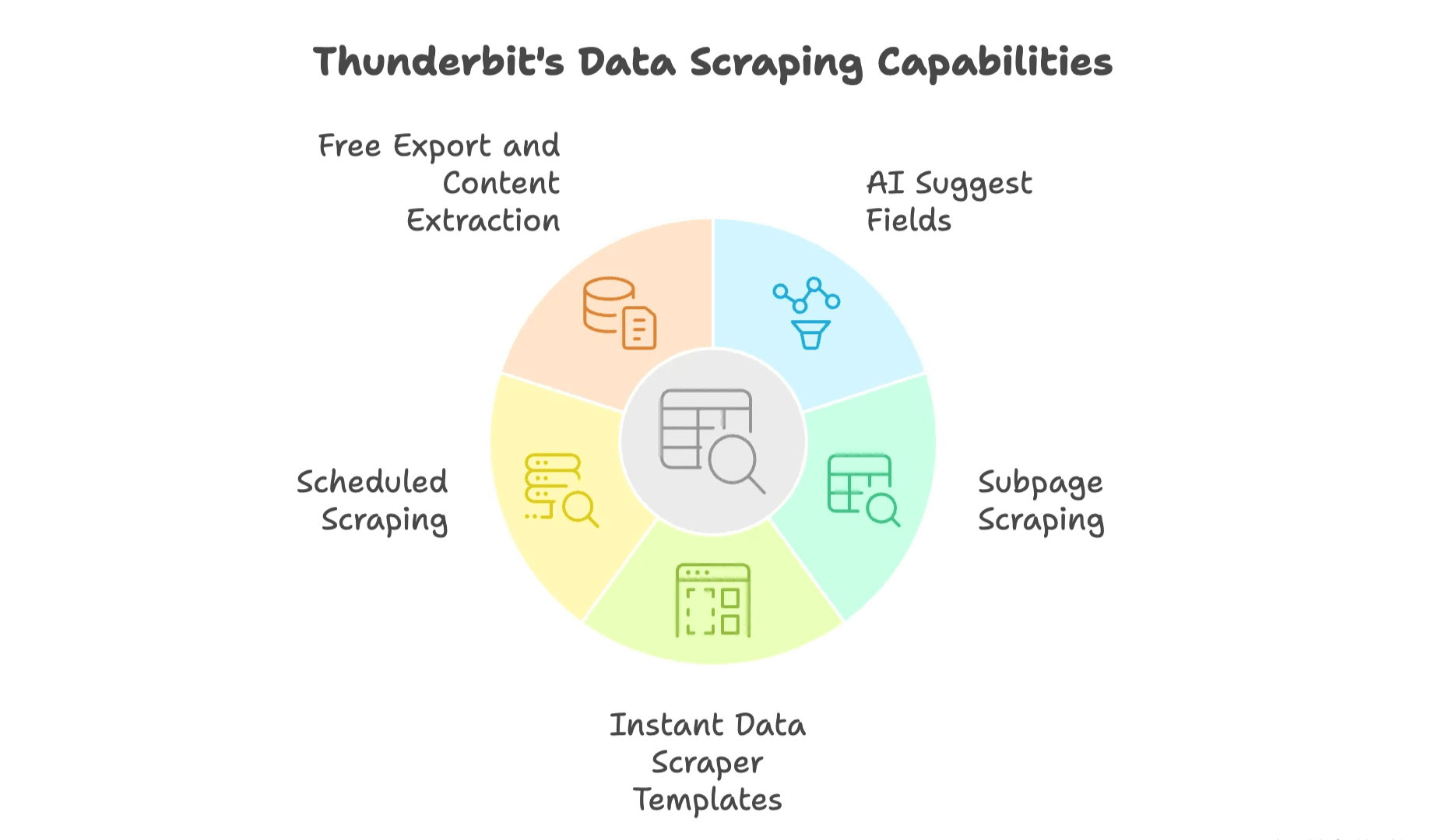

es una extensión de Chrome de AI Web Scraper pensada para cualquiera que necesite recolectar datos web—sin tener que programar. Así se diferencia:

- AI Suggest Fields – Thunderbit analiza la página y sugiere de forma inteligente las columnas y tipos de datos más relevantes, eliminando la incertidumbre y ahorrando horas de configuración.

- Scraping de subpáginas – Va más allá de la página principal. Thunderbit puede navegar automáticamente a subpáginas (como fichas de productos o perfiles) y extraer datos adicionales para enriquecer tu tabla.

- Plantillas de scraping instantáneo – Para webs populares como Amazon, Zillow o Instagram, usa plantillas listas para extraer datos con un solo clic—ideal para tareas repetitivas.

- Scraping programado – Mantén tus datos siempre al día. Solo describe tu horario en lenguaje natural (por ejemplo, “cada lunes a las 9am”) y Thunderbit ejecutará el raspador por ti—sin recordatorios ni pasos manuales.

- Exportación gratuita y extracción de contenido – Exporta tus datos directamente a Google Sheets, Excel, Airtable o Notion—sin muros de pago ni actualizaciones forzadas. Además, extrae emails, teléfonos e imágenes de cualquier web con un solo clic.

Y sí, soportamos 34 idiomas—porque la web es global, y nuestros usuarios también. Si quieres saber más, échale un ojo a nuestro .

Estrategias de recolección de datos según el sector

Algo que he aprendido: la recolección de datos no es igual para todos. Los métodos, el valor y hasta la “densidad” de datos útiles varían mucho según el sector.

- Ecommerce: El foco está en monitoreo de precios, scraping de SKUs y seguimiento de inventario. El valor viene de la actualización en tiempo real y la amplitud—cubrir la mayor cantidad de productos y competidores posible.

- Bienes raíces: Aquí lo importante son los listados, el historial de precios y los datos de ubicación. La profundidad es clave—los detalles de cada propiedad pueden marcar la diferencia.

- Ventas: La generación de leads es lo principal. El objetivo es extraer información de contacto limpia y útil, así como datos de empresas desde directorios especializados o redes sociales.

La “densidad de valor” de los datos recolectados es fundamental. En ecommerce, puedes necesitar miles de SKUs para detectar una tendencia de precios. En bienes raíces, los datos de una sola propiedad pueden valer miles de euros. Conocer el panorama de datos de tu sector te ayuda a diseñar estrategias de recolección más inteligentes.

Cómo montar sistemas automáticos de entrada de datos con IA

Aquí es donde la cosa se pone realmente interesante (sí, soy fan de los datos): la recolección de datos es solo el principio. La verdadera magia ocurre cuando conectas herramientas de recolección con IA a tus sistemas de automatización.

Imagina esto: Thunderbit extrae datos frescos de productos de tus proveedores cada mañana, los manda directo a tu sistema de inventario y activa actualizaciones automáticas de precios en tu tienda online. O tu equipo de ventas recibe diariamente nuevos leads, ya limpios y listos para contactar.

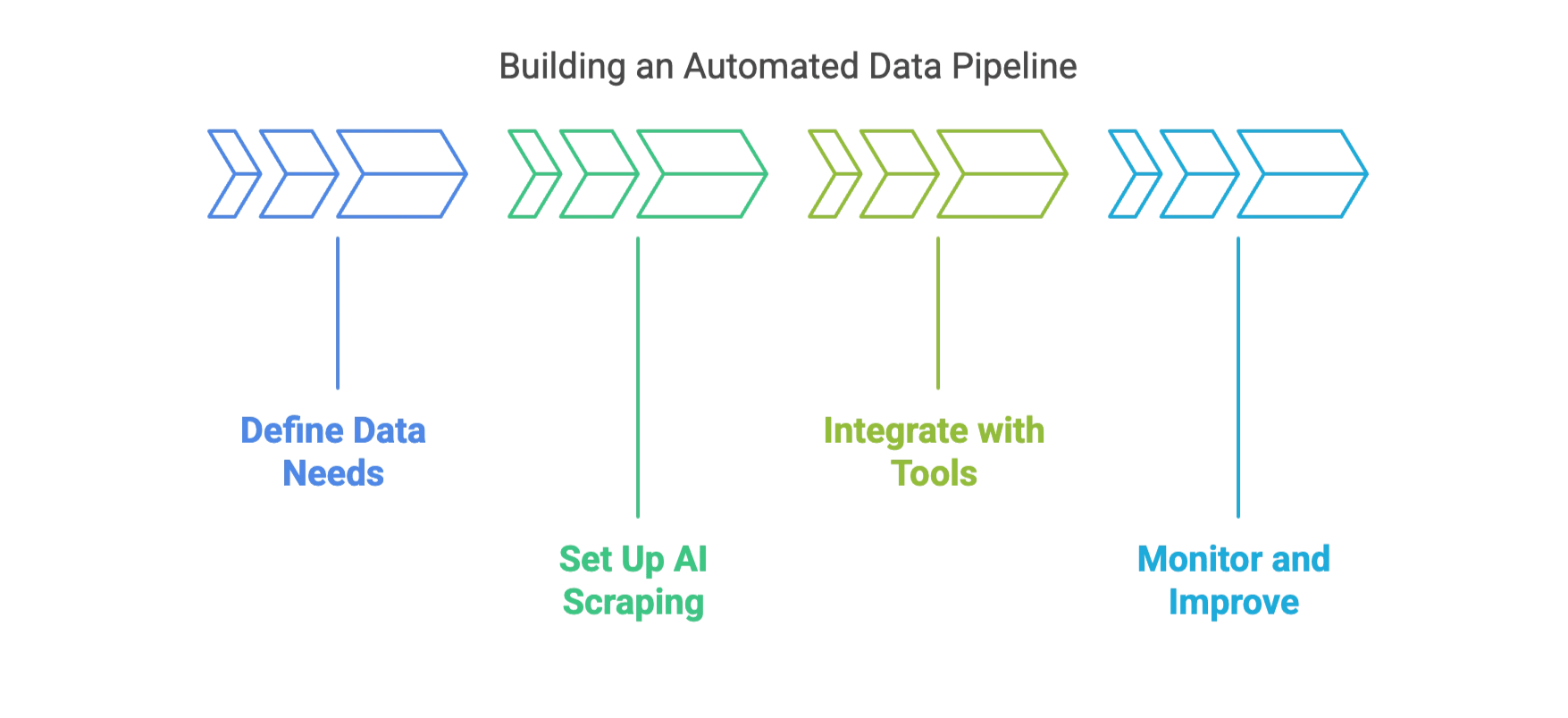

Algunos consejos prácticos para crear tu propio flujo automático de datos:

- Define tus necesidades de datos: Empieza por el objetivo. ¿Qué datos necesitas realmente? ¿En qué formato?

- Configura flujos de scraping con IA: Usa las funciones de y programación de Thunderbit para automatizar la recolección.

- Integra con tus herramientas: Exporta directamente a Excel, Google Sheets, Airtable o Notion. Usa APIs o plataformas de automatización para conectar con tu CRM o ERP.

- Monitorea y mejora: Revisa periódicamente la calidad de tus datos y ajusta el flujo según evolucionen tus necesidades.

Esto no solo ahorra tiempo (aunque lo hará). Se trata de construir un sistema donde los datos fluyen automáticamente, impulsando decisiones más rápidas e inteligentes en tu empresa.

Buenas prácticas de recolección de datos para 2025

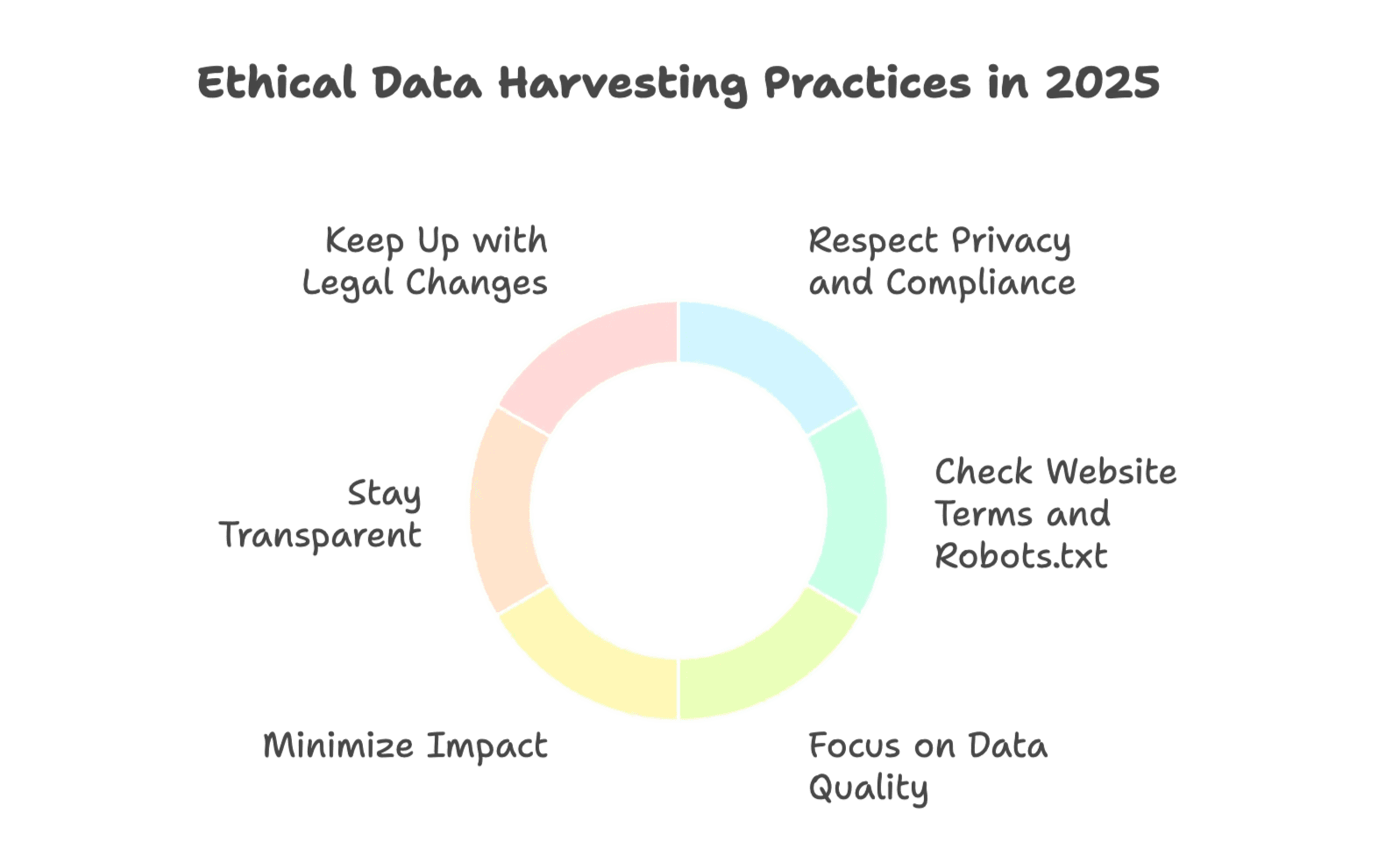

Con gran poder viene gran responsabilidad (y, seamos sinceros, bastante papeleo de cumplimiento). Aquí tienes algunas buenas prácticas para recolectar datos de forma efectiva y ética en 2025:

- Respeta la privacidad y la normativa: Cumple siempre con regulaciones como . Evita recolectar datos personales salvo que tengas una base legal clara.

- Revisa los términos del sitio y robots.txt: No extraigas datos de sitios donde no está permitido. Consulta los términos y el archivo robots.txt antes de recolectar.

- Prioriza la calidad de los datos: Usa herramientas de IA para limpiar, validar y eliminar duplicados. Haz muestreos regulares para asegurar la precisión.

- Minimiza el impacto: Configura tus raspadores para no sobrecargar los sitios objetivo. Usa tasas de solicitud moderadas y estrategias de retroceso.

- Sé transparente: Comunica dentro de tu organización (y a los usuarios, si aplica) qué datos recolectas y por qué.

- Mantente actualizado con la ley: Las reglas sobre recolección de datos web cambian constantemente. Mantente informado y consulta a expertos legales para proyectos a gran escala.

Aquí tienes una lista rápida para usuarios de negocio:

- Identifica tus fuentes y necesidades de datos

- Usa herramientas con IA para configurar y extraer

- Valida y limpia tus datos regularmente

- Cumple con la ley y los términos de los sitios

- Automatiza la integración con tus sistemas

- Monitorea y ajusta según cambien tus necesidades

Para más detalles, revisa nuestra .

Cómo superar los retos comunes en la recolección de datos con IA

Incluso con toda la tecnología de IA, recolectar datos no siempre es pan comido. Estos son algunos obstáculos típicos—y cómo los Raspadores Web IA te ayudan a superarlos:

- Cambios en los sitios web: Las webs cambian de diseño todo el tiempo. Los raspadores con IA usan machine learning para adaptarse automáticamente, así no tienes que rehacer tu flujo cada semana ().

- Contenido dinámico: Antes, los sitios llenos de JavaScript eran un dolor de cabeza. Ahora, los navegadores con IA pueden interactuar con las páginas como una persona, cargando y extrayendo datos incluso de los sitios más complejos.

- Calidad de los datos: Los datos web en bruto pueden ser un caos. Las herramientas de limpieza y validación con IA filtran el ruido, eliminan duplicados y detectan errores antes de que lleguen a tus análisis.

- Defensas anti-scraping: Algunos sitios usan CAPTCHAs y bloqueos de IP. Los raspadores con IA rotan proxies, simulan comportamiento humano e incluso resuelven CAPTCHAs para pasar desapercibidos.

- Brecha de habilidades: No todos saben programar. Herramientas no-code como Thunderbit permiten que cualquier usuario configure y gestione raspadores de forma visual, democratizando el acceso a los datos.

¿El resultado? Menos tiempo resolviendo problemas y más tiempo usando los datos para obtener resultados.

Conclusiones: El futuro de la recolección de datos con IA

Para cerrar, veamos el panorama general. En 2025, la recolección de datos no es solo una tarea técnica—es un activo estratégico. La explosión de datos globales, junto con el auge de los AI Web Scraper, permite a las empresas recolectar, limpiar y utilizar información a una escala y velocidad impensables hace pocos años.

Pero aquí está la clave: recolectar datos es solo el primer paso. El verdadero valor surge al integrar la recolección con IA en tu estrategia de datos—construyendo flujos automáticos, adaptando el enfoque a tu sector y priorizando la calidad y el cumplimiento.

Si todavía dependes de métodos manuales, es hora de replantear tu estrategia. Las herramientas adecuadas facilitan como nunca aprovechar el poder de la recolección de datos con IA. Y mirando al futuro, las empresas que traten la recolección de datos como un proceso estratégico, automatizado y adaptado a su industria serán las que lideren el mercado.

¿Listo para convertir la avalancha de datos en tu ventaja competitiva? El futuro ya está aquí—y viene de la mano de la IA.

Preguntas frecuentes

1. ¿Qué es un AI Web Scraper? Un AI Web Scraper utiliza inteligencia artificial para extraer datos de páginas web automáticamente—sin necesidad de programar. 2. ¿Es legal recolectar datos? Sí, siempre que respetes las leyes de privacidad (como GDPR/CCPA) y cumplas los términos y robots.txt del sitio web. 3. ¿Qué sectores se benefician más de la recolección de datos? Áreas como e-commerce, inmobiliarias y ventas sacan gran provecho de la extracción estructurada de datos web. 4. ¿Thunderbit permite automatización? Sí, Thunderbit permite scraping programado y exportación directa a herramientas como Google Sheets o Notion.

Más información