¿Alguna vez te has preguntado cómo Google logra saber hasta del rincón más escondido de internet —incluyendo ese blog olvidado que escribiste hace años? No eres el único. El truco no es magia ni un batallón de practicantes trasnochados revisando la web sin parar. Son los crawlers: exploradores digitales que recorren, mapean y catalogan sin descanso los sitios web de todo el mundo. Después de años creando herramientas de automatización e IA (y sí, rompiendo más de una web en el camino), aprendí a valorar el impacto brutal que estos bots tienen en lo que todos vemos online. Si tienes un sitio web, entender cómo funcionan los crawlers no es solo una curiosidad geek: puede ser la diferencia entre que te encuentren o quedarte en el anonimato.

Vamos a ver qué son los crawlers, cómo “leen” tu web, por qué son la base del SEO y qué puedes hacer para que tu contenido no se pierda en el océano digital. Y como soy fan de la automatización inteligente, también te voy a mostrar cómo herramientas con IA como están cambiando el juego tanto para dueños de sitios como para equipos que viven de los datos.

Fundamentos de los crawlers en sitios web: ¿qué son y cómo funcionan?

Piensa en un crawler como un bibliotecario digital —o una araña con doctorado en organización— cuya misión es recorrer la web, enlace por enlace. Técnicamente, un crawler (también llamado spider o bot) es un software que navega sistemáticamente por los sitios, recuperando páginas, siguiendo enlaces y recopilando información de lo que encuentra. Así es como los buscadores como Google, Bing y compañía arman sus enormes índices de contenido online.

El proceso básico es así:

- Arranca con una lista de URLs conocidas (como tu home o algunos sitios “semilla”).

- Descarga el HTML de cada página.

- Saca los hipervínculos y los suma a la lista de páginas por visitar.

- Repite el ciclo, saltando de enlace en enlace, catalogando nuevas páginas y actualizando el índice del buscador.

Si te imaginas a un bibliotecario corriendo entre estantes, anotando cada título y cruzando referencias —pero a la velocidad y escala de internet—, vas bien. Sin los crawlers, la mayor parte de la web sería invisible para los buscadores y, por lo tanto, para los usuarios.

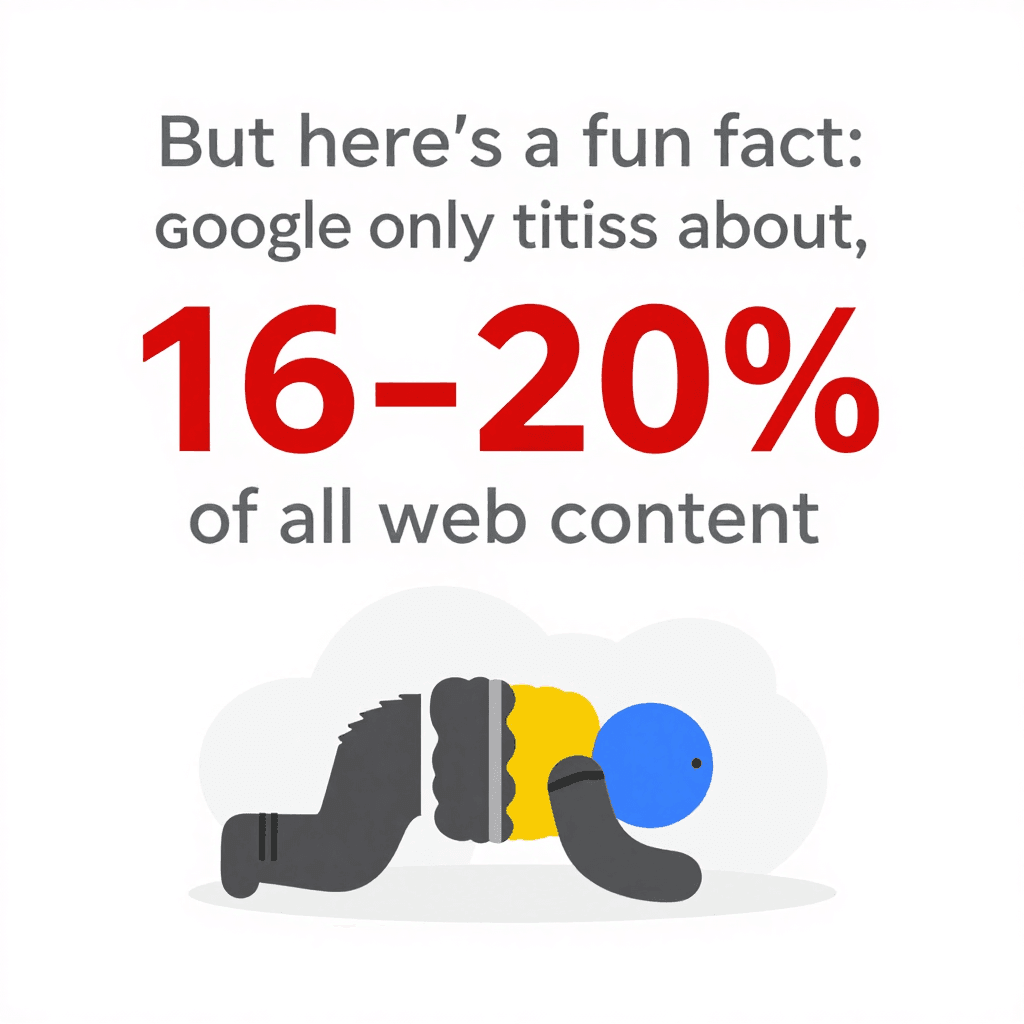

Dato curioso: incluso con todo ese poder de rastreo, Google solo indexa cerca del . El resto queda en la “web profunda”, fuera del radar de la mayoría de los bots. Por eso, la estructura de tu sitio —y lo fácil que se lo pongas a los crawlers— es clave.

Dato curioso: incluso con todo ese poder de rastreo, Google solo indexa cerca del . El resto queda en la “web profunda”, fuera del radar de la mayoría de los bots. Por eso, la estructura de tu sitio —y lo fácil que se lo pongas a los crawlers— es clave.

Cómo los crawlers ven y entienden el contenido de tu web

Los crawlers no ven tu sitio como lo haría una persona. No les importan las tipografías cool, las imágenes bonitas ni ese efecto parallax que tanto te costó. Ellos cargan el HTML puro, escanean el texto, leen las etiquetas y siguen los enlaces. Es como leer los planos de un edificio en vez de recorrerlo.

Esto es lo que más les importa a los crawlers:

- Estructura HTML: Buscan encabezados, párrafos, listas y enlaces.

- Enlaces internos: Son los caminos que guían a los crawlers por tu web. Si una página no está enlazada, para un crawler es casi invisible.

- Navegación y sitemaps: Menús bien armados y sitemaps actualizados funcionan como GPS, asegurando que los crawlers encuentren tu contenido más importante.

- Metadatos y datos estructurados: Etiquetas como

<title>,<meta description>y el marcado Schema.org ayudan a los crawlers a entender de qué va una página, incluso si no es obvio en el texto principal.

Si quieres verlo en modo geek, imagina tu web como una ciudad. Los crawlers son repartidores, y tus enlaces internos y sitemaps son las señales y mapas que les permiten llegar a cada dirección.

El papel de los sitemaps y robots.txt en el comportamiento de los crawlers

Dos archivos son clave en la relación de los crawlers con tu web:

-

XML Sitemap: Es una lista legible por máquinas de las páginas más importantes de tu sitio. Es como darle al bibliotecario un inventario de todos tus libros y dónde están. Un buen sitemap asegura que los crawlers no se pierdan contenido relevante, incluso si tu enlazado interno no es perfecto. En sitios grandes o complejos, sumar un sitemap completo puede .

-

robots.txt: Es un archivo de texto simple en la raíz de tu web que le dice a los crawlers dónde pueden y no pueden entrar. ¿Quieres evitar que los bots entren al área de administración o bloquear páginas duplicadas? Aquí lo configuras. Pero ojo: un error tonto (como

Disallow: /) puede bloquear todo tu sitio de los buscadores —un clásico fail de SEO. Usa robots.txt para .

Tip: Siempre indica la ubicación de tu sitemap en el robots.txt. Es como decirles: “¡Empiecen el recorrido aquí!”

Por qué los crawlers son clave para tu web: impacto en SEO y visitantes

Hablemos claro: si un crawler no puede entrar a una página, es como si no existiera. Sin rastreo = sin indexación = sin tráfico de búsqueda. Todo el esfuerzo que pusiste en crear contenido, diseño y marca… se pierde si Googlebot no lo encuentra.

¿Y por qué importa? Porque y . Si tu web no es amigable para los crawlers, estás dejando pasar la mayor fuente de visitas.

Un sitio bien rastreado significa:

Un sitio bien rastreado significa:

- Más páginas indexadas: Más chances de aparecer en los resultados de búsqueda.

- Mejores posiciones: Los buscadores pueden evaluar mejor la relevancia de tu contenido.

- Actualizaciones más rápidas: El contenido nuevo se indexa y posiciona antes.

- Mejor experiencia de usuario: Los usuarios encuentran lo que buscan, lo que mejora tu reputación y tráfico.

Hay muchos casos de webs que multiplicaron su tráfico solo arreglando problemas de rastreo —como enlaces rotos o etiquetas noindex mal puestas. Es el típico caso de “oculto a simple vista”.

Cómo influyen los crawlers en el posicionamiento de tu web

Los buscadores usan los datos de los crawlers para decidir qué páginas son más relevantes para cada búsqueda. Analizan:

- Calidad del contenido y palabras clave

- Enlaces internos y externos

- Actualización y frecuencia de cambios

- Adaptación a móviles (Google ahora prioriza la indexación móvil)

En sitios grandes, también existe el concepto de presupuesto de rastreo: el número de páginas que un buscador rastrea en un periodo determinado. Si tienes 100,000 páginas pero Googlebot solo rastrea 5,000 al día, puede tardar semanas en indexarlo todo. Por eso, una (donde la mayoría de páginas están a pocos clics de la principal) es tan efectiva: ayuda a los crawlers a llegar y volver a rastrear tu contenido más rápido.

Los límites de los crawlers tradicionales: retos con webs modernas

Aquí es donde la cosa se pone interesante. La web de hoy está llena de JavaScript, contenido dinámico y muros de acceso. Los crawlers tradicionales —sobre todo los más básicos— pueden perderse, quedarse atascados o rendirse.

Los problemas más comunes son:

- Contenido dinámico y JavaScript: Muchos crawlers solo ven el HTML inicial. Si tu contenido se carga con JavaScript (como scroll infinito o botones de “ver más”), un bot básico puede no ver nada. Incluso el crawler de Google, que puede renderizar JavaScript, a veces solo indexa parcialmente webs muy dependientes de JS, sobre todo si el contenido tarda en cargar o requiere interacción ().

- Contenido tras login: Si una página pide iniciar sesión, la mayoría de los crawlers no pueden entrar. Suele ser intencional, pero a veces contenido público importante queda bloqueado por error.

- robots.txt o metaetiquetas mal configuradas: Un simple fallo puede bloquear a los crawlers de secciones enteras de tu web.

- Medidas anti-bots: CAPTCHAs, límites de velocidad agresivos o bloquear agentes desconocidos pueden frenar a los crawlers.

Con , los crawlers han tenido que evolucionar mucho. Pero aún hay muchas formas en que tu contenido puede quedar oculto.

Cuando las herramientas de crawlers no alcanzan: contenido dinámico y JavaScript

Supón que tienes una tienda online donde los productos se cargan al hacer scroll. Un crawler tradicional solo verá los primeros 20 productos, perdiendo el resto. O si las reseñas aparecen solo al hacer clic en una pestaña, la mayoría de los bots tampoco las verán.

¿El resultado? Contenido valioso que no se indexa y pérdida de tráfico. La solución es ofrecer rutas alternativas (como enlaces de paginación o HTML renderizado en el servidor) y probar cómo ven los crawlers tu web con herramientas como la Inspección de URLs de Google Search Console.

Crawlers inteligentes: cómo Thunderbit gestiona páginas complejas

Aquí es donde me emociono —porque justo para esto creamos . Thunderbit no es solo otro crawler; es un agente de raspado web con IA capaz de “leer” sitios como una persona, extraer datos estructurados y adaptarse a los detalles del diseño web moderno.

¿Qué hace diferente a Thunderbit?

- Sugerencia de campos con IA: En vez de que tú busques en el HTML o escribas código, la IA de Thunderbit analiza la página y te sugiere las mejores columnas para extraer —como “Nombre del producto”, “Precio” o “Correo de contacto”. Puedes ajustar las sugerencias, pero el trabajo pesado ya está hecho.

- Raspado de subpáginas: ¿Necesitas más detalles? Thunderbit puede visitar automáticamente cada subpágina (como fichas de producto o perfiles de usuario), recopilar la información extra y enriquecer tu base de datos. Olvídate de hacer clic o copiar y pegar manualmente.

- Soporta JavaScript y logins: Como Thunderbit funciona como extensión de Chrome (o en un navegador real en la nube), puede ejecutar JavaScript, esperar a que cargue el contenido dinámico e incluso extraer datos de páginas donde ya has iniciado sesión.

- Se adapta a cambios en la web: Los scrapers tradicionales se rompen si cambia el diseño de la web. La IA de Thunderbit lee la página desde cero cada vez, así que los pequeños cambios no afectan tu flujo de trabajo.

- Raspado programado: ¿Quieres monitorizar precios o actualizar una lista de leads cada mañana? Solo programa la tarea en lenguaje natural (“cada lunes a las 9am”) y Thunderbit se encarga del resto.

Thunderbit está pensado para usuarios de negocio —ventas, marketing, ecommerce, inmobiliarias— que necesitan datos, no complicaciones. Y sí, exportar a Google Sheets, Notion o Airtable es cuestión de un clic (y totalmente gratis).

Funciones de IA de Thunderbit para optimizar el rastreo web

La verdadera magia de Thunderbit está en su procesamiento de lenguaje natural. No solo extrae texto sin más: entiende el contexto. Por ejemplo, distingue entre un número de teléfono, un email o un precio, y puede extraer, etiquetar e incluso traducir los datos automáticamente.

La respuesta de los usuarios ha sido excelente. Un usuario comentó: “Thunderbit es mi herramienta favorita para obtener datos de contacto de influencers. Antes pagaba por bases de datos, ahora las creo en minutos.” Ese es el tipo de mejora de flujo de trabajo que me encanta ver.

Y si alguna vez has intentado raspar una web que cambia de diseño cada semana (sí, hablo de muchas tiendas online), vas a valorar el enfoque “sin mantenimiento” de Thunderbit. La IA se adapta, así que no tienes que estar arreglando scripts rotos.

Cómo optimizar tu web para los crawlers: estructura, estrategia y herramientas inteligentes

¿Qué puedes hacer para que tu web sea el paraíso de los crawlers? Aquí tienes algunas estrategias probadas:

- Diseña una arquitectura lógica: Mantén las páginas importantes a pocos clics de la principal. Una (navegación amplia, poca profundidad) mejora la eficiencia del rastreo y la indexación.

- Enlazado interno robusto: Conecta páginas relacionadas con enlaces contextuales. Revisa y corrige enlaces rotos con regularidad.

- Mantén actualizado el sitemap XML: Incluye todas las URLs importantes y envíalo a Google Search Console y Bing Webmaster Tools.

- Optimiza tu robots.txt: Permite el acceso al contenido clave, bloquea solo lo necesario y revisa que no haya bloqueos accidentales.

- La velocidad importa: Las páginas rápidas y sin errores se rastrean mejor. Optimiza imágenes, usa CDN y corrige errores de servidor.

- Gestiona el contenido duplicado: Usa etiquetas canónicas y evita que el presupuesto de rastreo se desperdicie en páginas duplicadas o casi iguales.

- Aprovecha los datos estructurados y metadatos: Implementa Schema.org para productos, artículos, eventos, etc., y gestiona bien tus metaetiquetas.

- Monitorea la actividad de rastreo: Usa los informes de Cobertura e Información de rastreo de Google Search Console para detectar problemas a tiempo.

- Prueba con herramientas inteligentes: Usa Thunderbit o herramientas similares para ver cómo ve tu web un crawler y mantener tus flujos de datos funcionando sin problemas.

Alineando la arquitectura web con las necesidades de los crawlers

Una estructura bien pensada no solo ayuda a los bots, también mejora la experiencia de los usuarios. Auditorías regulares (con herramientas como Screaming Frog o Sitebulb) te permiten detectar problemas de rastreo, enlaces rotos y páginas huérfanas antes de que afecten tu posicionamiento.

Y no olvides el móvil: con la indexación mobile-first de Google, tu versión móvil debe tener todo el contenido y enlaces importantes que la de escritorio. Si no, podrías dejar páginas valiosas fuera del índice ().

Thunderbit vs. crawlers tradicionales: comparación rápida

Vamos al grano:

| Aspecto | Thunderbit (AI Web Scraper) | Crawler/Scraper tradicional |

|---|---|---|

| Facilidad de uso | Sin código, IA sugiere campos, cualquier usuario puede empezar en 2 clics. | Configuración técnica, suele requerir código o seleccionar manualmente. |

| Adaptabilidad | La IA se adapta a cambios de diseño, casi sin mantenimiento. | Se rompe si cambia la estructura del sitio, requiere ajustes manuales. |

| Contenido dinámico | Soporta JavaScript, logins y elementos interactivos por defecto. | Limitado a HTML estático, problemas con JS o contenido tras login. |

| Rastreo de subpáginas | Rastreo de subpáginas y paginación integrado, fusiona datos automáticamente. | Configuración manual para profundidad, rastreo recursivo requiere trabajo extra. |

| Estructuración de datos | La IA genera tablas listas para usar con columnas significativas, soporta tipos de datos ricos (texto, números, emails, imágenes, PDFs, etc.). | Salida en bruto, el usuario debe definir la estructura, limitado a HTML salvo programación personalizada. |

| Integración | Exportación a Google Sheets, Notion, Airtable, CSV, etc. con un clic. | Suele requerir exportación/importación manual, pocas integraciones directas. |

| Obstáculos para bots | Gestiona proxies, user agents, reintentos automáticamente; enfoque en cascada para maximizar el éxito. | El usuario debe gestionar bloqueos de IP, CAPTCHAs, etc.—a menudo complejo y costoso. |

| Usuarios objetivo | Usuarios de negocio no técnicos: ventas, marketing, operaciones, ecommerce, inmobiliarias. | Desarrolladores, IT, ingenieros de datos. |

| Precios | Por créditos, con plan gratuito disponible, pagas solo por lo que usas. | Suscripción, por usuario o servidor; a menudo hay costes ocultos por proxies o mantenimiento. |

En resumen: Thunderbit pone el poder del rastreo avanzado al alcance de todos, no solo de los desarrolladores. Es rápido, preciso y se adapta a la web en constante cambio.

Conclusiones: cómo aprovechar los crawlers en tu web

- Los crawlers son la puerta de entrada a la visibilidad online. Si tu web no es amigable para ellos, perderás tráfico y nuevos visitantes.

- La estructura y la estrategia importan. Navegación lógica, enlaces internos, sitemaps y robots.txt son tus mejores aliados.

- Las webs modernas necesitan crawlers más inteligentes. JavaScript, contenido dinámico y logins pueden bloquear a los bots básicos, pero herramientas con IA como pueden con ello.

- El monitoreo constante es clave. Usa Search Console, auditorías de rastreo y herramientas inteligentes para mantener tu web sana y visible.

- Mejora tu kit de herramientas. Ya sea para SEO o para crear tus propios flujos de datos, los crawlers inteligentes te ahorran tiempo, mejoran la precisión y apoyan mejores decisiones de negocio.

¿Listo para ver cómo Thunderbit puede ayudarte a rastrear, indexar y extraer datos incluso de las webs más complejas? y pruébala. Y para más consejos sobre web scraping, SEO y automatización, visita el .

Preguntas frecuentes

1. ¿Qué es un crawler y por qué es importante para mi web?

Un crawler es un bot de software que navega e indexa el contenido de los sitios para los motores de búsqueda. Si tu web no es amigable para los crawlers, tus páginas pueden no aparecer en los resultados y los usuarios no te encontrarán.

2. ¿Cómo afectan los sitemaps y robots.txt a los crawlers?

Los sitemaps guían a los crawlers hacia tus páginas más importantes, mientras que robots.txt les indica dónde pueden y no pueden entrar. Ambos son esenciales para un rastreo e indexación eficientes.

3. ¿Qué problemas tienen los crawlers tradicionales con webs modernas?

Los crawlers tradicionales tienen dificultades con contenido cargado por JavaScript, elementos dinámicos, páginas tras login y medidas anti-bots. Por eso pueden perderse o indexar solo parcialmente contenido relevante.

4. ¿Cómo gestiona Thunderbit las webs complejas de forma diferente?

Thunderbit usa IA para “leer” páginas como una persona, soporta JavaScript y logins, y extrae datos estructurados incluso de subpáginas y contenido dinámico. Se adapta a cambios y no requiere programación.

5. ¿Cuáles son las mejores prácticas para que mi web sea amigable para los crawlers?

Mantén una estructura lógica, usa enlaces internos, actualiza tu sitemap y robots.txt, optimiza la velocidad y monitoriza la actividad de rastreo. Usa herramientas inteligentes como Thunderbit para probar y mejorar la rastreabilidad de tu web.

¿Quieres profundizar más? Explora más guías en el o suscríbete a nuestro para estar al día en automatización web y scraping con IA.

Más información