Los datos web son el nuevo oro digital, y en 2025 están moviendo desde ventas más inteligentes hasta estudios de mercado mucho más afinados. He visto a equipos de ecommerce, inmobiliarias o SaaS batallando para convertir páginas web caóticas en hojas de cálculo limpias y útiles. Si llegaste hasta aquí, seguro también quieres sacarle jugo a ese potencial. ¿La buena noticia? Python es tu mejor compañero para el web scraping, y hoy en día es más fácil que nunca, incluso si no eres desarrollador.

En esta guía te voy a mostrar lo básico para hacer web scraping con Python, desde tu primer script hasta cómo escalar con frameworks como Scrapy. También vamos a ver cómo herramientas con IA como están cambiando la forma de extraer datos para usuarios de negocio, haciéndolo más rápido y sencillo. Seas principiante curioso o profesional buscando optimizar, aquí vas a encontrar pasos prácticos, fragmentos de código y consejos reales para que puedas extraer datos como todo un pro.

¿Qué es el Web Scraping en Python? Un Resumen Rápido

El web scraping es básicamente enseñarle a tu computador a copiar y pegar datos de sitios web por ti, pero a una velocidad y escala que ningún humano podría igualar. En Python, esto significa escribir scripts que descargan páginas web, analizan su HTML y extraen justo la información que te interesa: precios, contactos, reseñas, lo que sea.

Para los negocios, el web scraping es una mina de oro. Los equipos de ventas lo usan para armar listas de prospectos, los de ecommerce para monitorear precios de la competencia y los analistas para seguir tendencias del mercado, todo convirtiendo contenido web desordenado en datos estructurados listos para analizar. Python brilla porque es potente y fácil de aprender, por eso es el lenguaje favorito para proyectos de scraping grandes y chicos ().

¿Por Qué Python es el Lenguaje Preferido para Web Scraping?

¿Por qué todo el mundo elige Python para web scraping? Por tres razones: su sencillez, su ecosistema de librerías y una comunidad que siempre está lista para echarte una mano.

- Sintaxis clara: El código en Python es fácil de escribir y todavía más fácil de leer. No necesitas ser ingeniero para arrancar.

- Librerías potentes: Herramientas como BeautifulSoup, Scrapy y Requests hacen que extraer, analizar y navegar por sitios web sea pan comido.

- Versatilidad: Python no solo sirve para scraping; también es top en análisis de datos y automatización, así que puedes pasar de datos crudos a insights sin cambiar de lenguaje.

- Comunidad activa: ¿Te trabaste con un HTML raro? Seguro que alguien en Stack Overflow ya lo resolvió.

Así se compara Python con otros lenguajes:

| Lenguaje | Ventajas | Desventajas | Ideal para |

|---|---|---|---|

| Python | Sintaxis sencilla, librerías robustas, comunidad | Más lento que C++/Java en velocidad bruta | Todo tipo de scraping, de pequeño a grande |

| JavaScript | Maneja sitios con mucho JS de forma nativa | Análisis HTML menos maduro, problemas con async | Apps de una sola página, sitios dinámicos |

| R | Bueno para análisis de datos | Menos frameworks de scraping | Tareas pequeñas y estadísticas |

| Java/C# | Rápido y de nivel empresarial | Verboso, mucho código repetitivo | Sistemas grandes e integrados |

Python sigue siendo de los lenguajes más usados para web scraping, y en 2023 superó a SQL como el tercer lenguaje más popular del mundo ().

Herramientas y Librerías Esenciales para Web Scraping en Python

Aquí tienes el kit básico para arrancar con web scraping en Python:

- Requests: La librería estándar para hacer peticiones HTTP. Descarga páginas web tan fácil como abrirlas en tu navegador.

- BeautifulSoup: El “cuchillo suizo” para analizar HTML y XML. Permite buscar, filtrar y extraer datos de páginas web.

- Scrapy: Un framework completo para scraping y crawling a gran escala.

- Selenium: Automatiza navegadores para extraer datos de sitios dinámicos llenos de JavaScript.

- Otras:

lxmlpara análisis rápido,pandaspara manipular datos yPlaywrightpara automatización moderna de navegadores.

¿Cuándo usar cada una?

- Requests + BeautifulSoup: Perfecto para páginas estáticas y proyectos pequeños.

- Scrapy: Ideal para rastrear muchas páginas, manejar paginación y exportar datos a gran escala.

- Selenium/Playwright: Úsalos cuando necesites interactuar con JavaScript o simular acciones de usuario.

Primeros Pasos: Configura tu Entorno de Web Scraping en Python

Vamos a dejar todo listo para que empieces. Incluso si eres nuevo en Python, este proceso es muy directo.

-

Instala Python: Descarga Python 3.x desde . Asegúrate de agregarlo al PATH de tu sistema.

-

Crea un entorno virtual: Así mantienes las dependencias de tu proyecto bien ordenadas.

1python3 -m venv venv 2# Activar: 3# En Windows: 4venv\Scripts\activate 5# En Mac/Linux: 6source venv/bin/activate -

Instala las librerías:

1pip install requests beautifulsoup4 scrapy selenium -

Organiza tu proyecto: Para scripts pequeños, un solo archivo

.pybasta. Para Scrapy, usascrapy startproject miproyectopara crear la estructura. -

Prueba tu entorno:

1import requests, bs4, scrapy, selenium 2print("¡Todas las librerías se importaron correctamente!") -

Configura un User-Agent (recomendado): Algunos sitios bloquean “Python-requests” por defecto. Simula un navegador:

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

¡Listo! Ya puedes empezar a extraer datos.

Analizando HTML con BeautifulSoup: Tu Primer 웹 스크래퍼 en Python

Vamos a crear un 웹 스크래퍼 sencillo. Extraeremos frases y autores de , un sitio perfecto para practicar.

Paso 1: Inspecciona la Estructura del Sitio

- Abre el sitio en Chrome.

- Haz clic derecho sobre una frase y selecciona “Inspeccionar”.

- Verás que cada frase está en un

<div class="quote">, el texto en<span class="text">y el autor en<small class="author">.

Paso 2: Escribe y Ejecuta tu 웹 스크래퍼

Aquí tienes un script básico:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"La petición falló: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")Errores comunes:

- Si falta un elemento, verifica que no sea

Noneantes de usar.get_text(). - Revisa siempre tus selectores en el navegador.

Escalando: Optimiza tu Web Scraping en Python con Scrapy

Cuando necesitas pasar de “solo esta página” a “todo el sitio y sus subpáginas”, es momento de usar Scrapy.

- Arquitectura: Scrapy utiliza “spiders” (clases que definen cómo navegar y extraer), pipelines (para procesar datos) y peticiones asíncronas para mayor velocidad.

- ¿Por qué Scrapy? Está hecho para escalar: puede extraer miles de páginas, manejar errores y exportar datos a CSV/JSON fácilmente.

¿Cuándo Usar Scrapy en Lugar de BeautifulSoup?

- Si necesitas rastrear muchas páginas o seguir enlaces automáticamente.

- Si quieres soporte integrado para reintentos, límites de velocidad y procesamiento de datos.

- Si vas a ejecutar el 웹 스크래퍼 regularmente o compartirlo con tu equipo.

Scrapy en Acción: Ejemplo de Proyecto

Aquí tienes un spider que extrae todas las frases de todas las páginas:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)Ejecuta con:

1scrapy crawl quotes -O quotes.jsonY tendrás un archivo JSON con todos los datos, sin bucles manuales.

Cuando tu proyecto crece, la arquitectura y velocidad de Scrapy lo convierten en la mejor opción para extracción de datos a gran escala.

Thunderbit: Herramientas de IA que Potencian el Web Scraping en Python

Seamos sinceros: incluso con Python, el scraping puede complicarse, sobre todo con sitios dinámicos, subpáginas o cambios de diseño. Ahí es donde entra .

Thunderbit es una extensión de Chrome con IA que te permite extraer datos de cualquier web en solo dos clics:

- Sugerencia de campos con IA: La IA analiza la página y te sugiere las mejores columnas para extraer (como “Nombre del producto”, “Precio”, etc.).

- Extraer: Haz clic de nuevo y Thunderbit recoge todos los datos, gestionando paginación, subpáginas e incluso scroll infinito.

Por qué me encanta Thunderbit:

- No necesitas programar: Perfecto para usuarios de negocio y analistas.

- Maneja sitios complejos: ¿Contenido dinámico, subpáginas o cambios de diseño? La IA se adapta.

- Exportación instantánea: Envía los datos directamente a Excel, Google Sheets, Airtable o Notion.

- Scraping de subpáginas: ¿Necesitas detalles de cada producto o perfil? Thunderbit visita cada subpágina y enriquece tu tabla automáticamente.

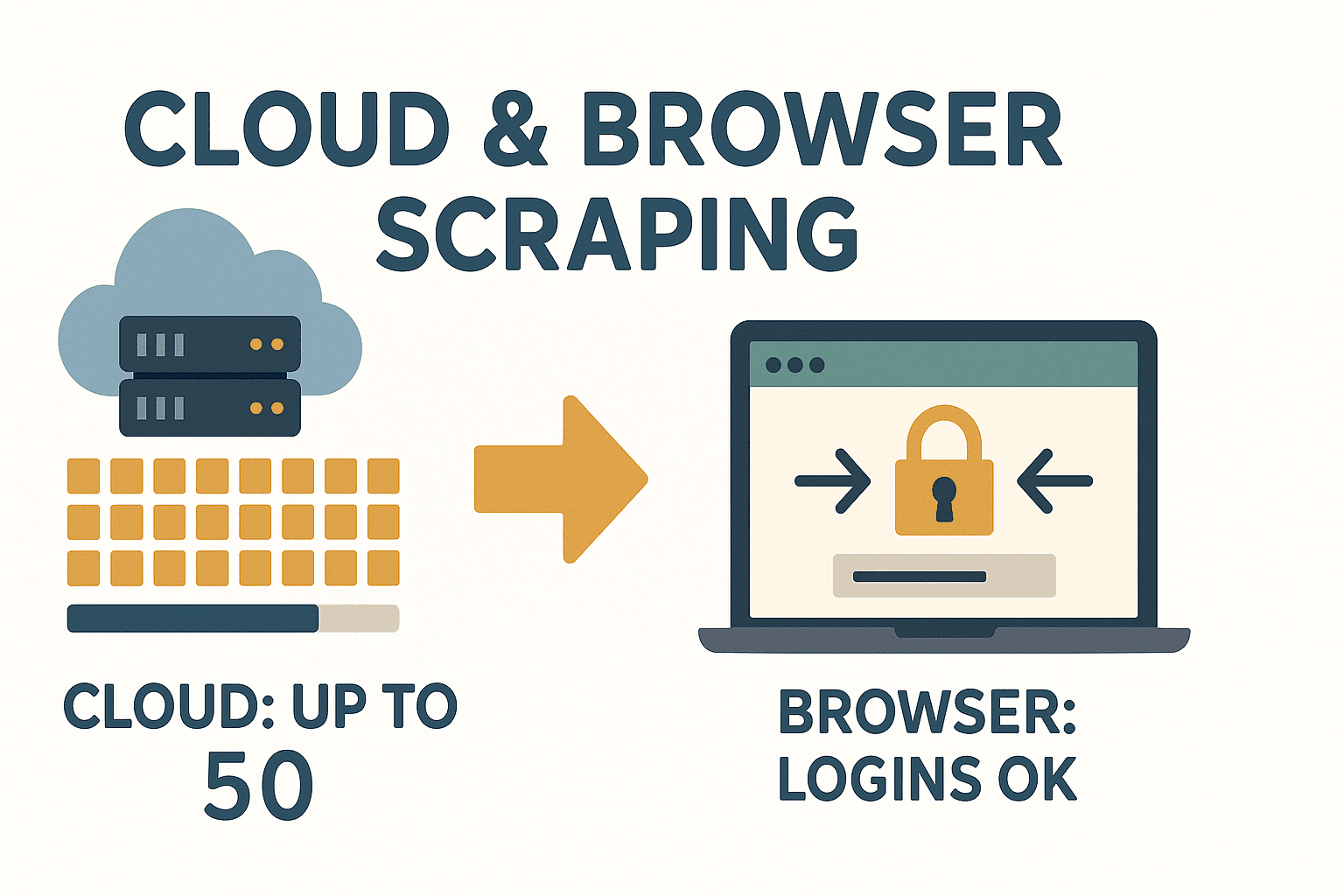

- Modo nube o navegador: Extrae hasta 50 páginas a la vez en la nube, o usa tu navegador para sitios que requieren inicio de sesión.

Thunderbit es un antes y un después para quienes necesitan datos rápido y no quieren pelearse con el código cada vez que un sitio cambia.

Thunderbit es un antes y un después para quienes necesitan datos rápido y no quieren pelearse con el código cada vez que un sitio cambia.

¿Cuándo Usar Herramientas de IA como Thunderbit?

- Necesitas datos ya y no quieres esperar a IT ni escribir código.

- El sitio es complejo, dinámico o cambia con frecuencia.

- Quieres que miembros no técnicos del equipo puedan recolectar datos.

- Necesitas extraer y enriquecer datos (traducir, categorizar, etc.) en un solo paso.

Thunderbit encaja perfecto en los flujos de trabajo con Python: úsalo para prototipos rápidos, sitios complicados o cuando quieras evitar el mantenimiento. Para más información, revisa el .

Cómo Manejar Contenido Dinámico y Paginación en Web Scraping con Python

Los sitios modernos usan mucho JavaScript, lo que puede complicar la extracción de datos. Así puedes enfrentarlo:

- Contenido dinámico: Si los datos se cargan con JS (y no están en el HTML original), usa Selenium o Playwright para automatizar el navegador, espera a que cargue el contenido y luego extrae.

- Paginación: Recorre los enlaces de “Siguiente” o incrementa el número de página en la URL. Scrapy lo gestiona fácilmente con su sistema de seguimiento de peticiones.

Ejemplo: Manejo de paginación con BeautifulSoup

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...extraer frases...

12 page += 1Para scroll infinito o botones “Cargar más”: Usa Selenium para hacer scroll o clic, o revisa la pestaña de red para encontrar llamadas a APIs que puedas replicar con Requests.

Almacenamiento de Datos: Guarda lo Extraído para Uso Empresarial

Una vez que tienes los datos, querrás guardarlos de forma útil.

- CSV: Universal, fácil de abrir en Excel o Sheets.

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel: Usa pandas para exportar rápidamente.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - Base de datos: Para proyectos grandes o continuos, usa SQLite o PostgreSQL.

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...crear tabla, insertar datos... 4conn.close()

Elige el formato que mejor se adapte a tu flujo de trabajo. Para compartir con compañeros no técnicos, Excel o Google Sheets suelen ser la mejor opción.

Consideraciones Legales y Éticas en el Web Scraping con Python

El scraping es poderoso, pero conlleva responsabilidad. Así puedes mantenerte dentro de la legalidad:

- Solo extrae datos públicos: Si necesitas iniciar sesión o está tras un muro de pago, piénsalo dos veces.

- Revisa los Términos de Servicio: Algunos sitios prohíben explícitamente el scraping. Ignorarlo puede llevarte a ser bloqueado o algo peor ().

- Respeta robots.txt: No es legalmente vinculante, pero es una buena práctica.

- Evita datos personales: Leyes como GDPR y CCPA prohíben extraer nombres, emails o teléfonos sin consentimiento.

- No sobrecargues los servidores: Añade pausas, limita la frecuencia de peticiones y extrae datos en horarios de baja demanda.

Lista rápida de cumplimiento:

- Lee los Términos de Servicio y robots.txt del sitio.

- Evita extraer datos personales o sensibles.

- Atribuye tus fuentes de datos.

- Sé respetuoso: no satures el servidor.

Para más sobre buenas prácticas legales, revisa .

Solución de Problemas y Buenas Prácticas para Web Scraping Confiable en Python

El web scraping no siempre es un paseo. Así puedes superar los obstáculos:

- Errores HTTP (403, 404, 429): Usa un User-Agent realista, baja la velocidad de tus peticiones y maneja los errores con elegancia.

- Bloqueo de IPs: Usa proxies o rota tu IP si extraes datos a gran escala, pero siempre considera la ética.

- CAPTCHAs: Si te topas con un CAPTCHA, evalúa si vale la pena seguir. Hay servicios para resolverlos, pero es un área gris.

- Cambios en la estructura del sitio: Usa selectores robustos, verifica

Noneantes de extraer y envuelve tu código en bloques try/except. - Problemas de codificación: Usa siempre UTF-8 y prueba tu salida en Excel o Sheets.

Buenas prácticas:

- Registra cada paso, así sabrás dónde falló el proceso.

- Reintenta peticiones fallidas con backoff.

- Prueba tu 웹 스크래퍼 en algunas páginas antes de escalar.

- Supervisa la salida: si baja el número de elementos, algo cambió.

Y si te cansas de arreglar scrapers cada vez que un sitio cambia, recuerda: usa IA para adaptarse automáticamente a los cambios de diseño.

El enfoque con IA de Thunderbit te permite centrarte en el análisis, no en el mantenimiento.

Conclusión y Puntos Clave

El web scraping en Python es una herramienta brutal para usuarios de negocio: convierte el caos de la web en datos estructurados y útiles. Resumamos lo aprendido:

- Python es la mejor opción para web scraping, gracias a su sintaxis clara y librerías potentes.

- Requests + BeautifulSoup son ideales para tareas pequeñas y estáticas; Scrapy es tu aliado para crawling automatizado a gran escala.

- Thunderbit aporta IA, haciendo el scraping accesible para todos: sin código, sin complicaciones, solo datos.

- Gestiona contenido dinámico y paginación con Selenium o las funciones integradas de Scrapy.

- Guarda tus datos en CSV, Excel o bases de datos, según lo que necesite tu empresa.

- Sé legal y ético: Extrae solo datos públicos, respeta las reglas del sitio y evita información personal.

- Crea scrapers robustos: Registra, reintenta y monitoriza los cambios. O deja que la IA de Thunderbit haga el trabajo pesado.

¿Listo para empezar? Prueba a crear tu primer 웹 스크래퍼 en Python o, si prefieres evitar el código, y descubre lo fácil que es extraer datos web. Para más consejos y tutoriales, visita el .

Preguntas Frecuentes

1. ¿Es legal hacer web scraping en Python?

El web scraping es legal si recolectas datos públicos y respetas los términos de servicio del sitio, robots.txt y leyes de privacidad como GDPR. Evita extraer información personal o sensible y revisa siempre las reglas antes de empezar ().

2. ¿Cuál es la diferencia entre BeautifulSoup y Scrapy?

BeautifulSoup es un analizador HTML ligero, ideal para tareas pequeñas o páginas individuales. Scrapy es un framework completo para rastrear muchas páginas, manejar paginación y exportar datos a gran escala. Usa BeautifulSoup para scripts rápidos y Scrapy para proyectos grandes ().

3. ¿Cómo manejo sitios con mucho JavaScript en Python?

Utiliza Selenium o Playwright para automatizar el navegador, espera a que cargue el JavaScript y luego extrae los datos. Alternativamente, revisa la pestaña de red para encontrar llamadas a APIs que puedas replicar con Requests.

4. ¿Qué diferencia a Thunderbit de las librerías de scraping en Python?

Thunderbit usa IA para sugerir campos, manejar subpáginas y adaptarse a cambios de diseño, sin necesidad de código. Es perfecto para usuarios de negocio y equipos que quieren datos rápido, sin los dolores de cabeza del mantenimiento tradicional ().

5. ¿Cómo puedo guardar y compartir los datos extraídos con mi equipo?

Exporta tus datos a CSV o Excel para compartir fácilmente, o usa pandas para guardarlos en bases de datos en proyectos grandes. Thunderbit permite exportar directamente a Google Sheets, Airtable, Notion o descargar en CSV/Excel gratis.

¡Feliz scraping! Que tus datos siempre sean limpios, estructurados y listos para usar.