La web está creciendo a una velocidad impresionante y, si te mueves en el mundo de los negocios, la tecnología o simplemente eres un fanático de los datos como yo, seguro ya lo notaste: el verdadero poder está en los datos que puedes recopilar, no solo en los que ves a simple vista. Hoy en día, las empresas están en una carrera por automatizar la recolección de datos online, y se espera que la industria global del 웹 스크래퍼 llegue a los . Un dato que sorprende: más del ya usan rastreadores o 웹 스크래퍼 para alimentar sus sistemas de IA, análisis y flujos de trabajo internos.

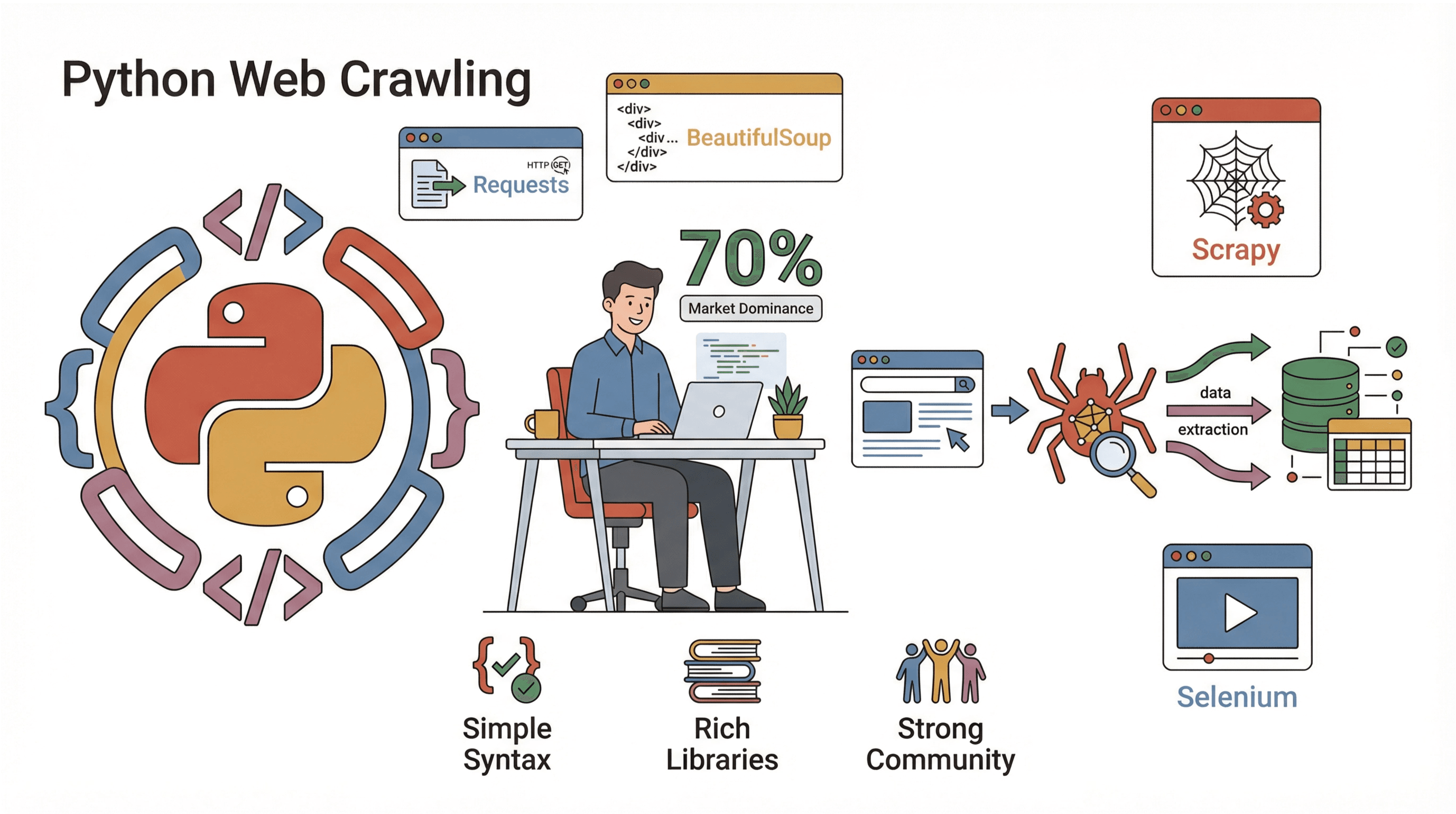

¿Y cómo puedes sumarte a esta ola? Para la mayoría, la respuesta es Python. Es el lenguaje favorito para crear rastreadores web: fácil, potente y con un montón de librerías que te hacen la vida más sencilla. En esta guía te voy a contar qué es un rastreador web, por qué Python es la mejor opción, cómo crear uno paso a paso y cómo herramientas como pueden hacer todo aún más fácil (sobre todo si prefieres hacer clic en vez de programar). Seas desarrollador, marketero de datos o simplemente alguien que quiere automatizar tareas repetitivas, aquí tienes recursos para llevar tu manejo de datos web al siguiente nivel.

¿Qué es un rastreador web? (Y por qué te debería importar)

En pocas palabras, un rastreador web es un programa que navega por la web de forma automática, visitando páginas, siguiendo enlaces y (si quieres) recopilando datos en el camino. Imagina un supernavegante que nunca se cansa, no se distrae y jamás cierra la pestaña equivocada. Los rastreadores son la base de los motores de búsqueda (como Googlebot), pero también los usan las empresas para cosas como monitoreo de precios o investigación de mercado.

¿Pero cuál es la diferencia entre rastrear y raspar? Rastrear es descubrir y navegar páginas (como hacer el mapa de una ciudad), mientras que raspar es extraer datos concretos de esas páginas (como recopilar todos los menús de restaurantes de la ciudad). En la práctica, la mayoría de los proyectos hacen ambas cosas: rastrean para encontrar páginas y raspan para sacar la información que necesitan ().

Ejemplos de uso empresarial de los rastreadores:

- Generación de leads: Recoge automáticamente información de contacto de directorios o redes sociales.

- Monitoreo de precios: Vigila los precios y el stock de la competencia en miles de productos.

- Monitoreo de contenido: Recibe alertas cuando mencionan tu marca en noticias, blogs o foros.

- Auditoría SEO: Analiza tu web en busca de enlaces rotos o metadatos que faltan.

- Investigación de mercado: Junta listados inmobiliarios, ofertas de empleo o reseñas de productos para analizarlos.

Si alguna vez quisiste clonarte para investigar en la web, un rastreador es lo más parecido.

Por qué los rastreadores web son clave para la automatización empresarial

Vamos a lo concreto. ¿Por qué las empresas apuestan por rastreadores y 웹 스크래퍼? Porque el retorno de inversión es enorme. Aquí tienes un resumen de cómo los equipos los usan y qué beneficios obtienen:

| Caso de uso | Beneficio principal | Quién lo usa |

|---|---|---|

| Generación de leads | Automatiza la creación de listas de prospectos, ahorra horas | Ventas, Reclutamiento |

| Seguimiento de precios | Información en tiempo real de la competencia, precios dinámicos | E-commerce, Equipos de producto |

| Monitoreo de contenido | Protección de marca, detección de tendencias | Marketing, PR |

| Auditoría SEO | Salud del sitio, mejora de posicionamiento | SEO, Webmasters |

| Investigación de mercado | Datos actualizados y a gran escala para análisis | Analistas, Equipos de investigación |

Un caso real mostró que automatizar una tarea semanal de recolección de datos (raspando 5-7 sitios) le ahorró a un solo empleado más de 50 horas al año. Si multiplicas eso por todo un equipo, entiendes por qué una vez que empiezan a usar rastreadores.

Python: la mejor opción para crear un rastreador web

¿Por qué Python es el rey del rastreo web? Por tres razones principales:

¿Por qué Python es el rey del rastreo web? Por tres razones principales:

- Simplicidad: Su sintaxis es clara, fácil de aprender y te permite crear rastreadores funcionales en pocas líneas.

- Ecosistema de librerías: Python tiene herramientas para cada etapa: obtener páginas, analizar HTML, manejar JavaScript y más.

- Comunidad: Casi el usan Python, así que hay una comunidad enorme, muchísimos tutoriales y soluciones para casi cualquier problema.

Principales librerías de Python para rastreo web:

- Requests: La forma más sencilla de obtener páginas web (HTTP GET/POST).

- BeautifulSoup: Perfecta para analizar HTML y buscar elementos.

- Scrapy: Un framework completo para proyectos de rastreo a gran escala.

- Selenium: Automatiza navegadores para raspar sitios con mucho JavaScript.

Comparado con otros lenguajes (como Java o C#), Python te permite pasar de la idea al rastreador funcional en mucho menos tiempo. Y si trabajas con datos, puedes conectar la salida de tu rastreador directamente a Pandas para analizarla, sin líos de exportar/importar.

Comparativa de métodos de análisis: Regex vs. BeautifulSoup vs. Scrapy

A la hora de extraer datos de páginas web, tienes varias opciones. Así se comparan los principales métodos:

| Método | Cómo funciona | Ventajas 🟢 | Desventajas 🔴 | Ideal para |

|---|---|---|---|---|

| Regex | Busca patrones en el HTML en bruto | Rápido para patrones simples y conocidos | Frágil, falla si cambia el HTML | Hacks rápidos, extraer URLs |

| BeautifulSoup | Analiza HTML en árbol, busca por etiquetas | Fácil, flexible, soporta HTML desordenado | Más lento en páginas grandes, lógica manual | Scripts de scraping pequeños/medianos |

| Scrapy | Framework completo, análisis CSS/XPath | Rápido, escalable, gestiona rastreo y análisis | Curva de aprendizaje, más configuración | Rastreadores grandes y en producción |

- Regex es como usar un detector de metales en la playa: rápido, pero te puedes perder cosas si la arena cambia.

- BeautifulSoup es como tener un mapa y una pala: puedes excavar donde quieras, pero tienes que recorrer la playa tú mismo.

- Scrapy es como llevar un equipo con camiones y GPS: demasiado para una caja de arena, pero imbatible en grandes proyectos.

Si estás empezando, te recomiendo Requests + BeautifulSoup. Aprenderás lo básico y, cuando necesites escalar, puedes pasar a Scrapy.

Paso a paso: cómo crear un rastreador web sencillo en Python

¿Listo para ensuciarte las manos? Vamos a armar un rastreador básico que visite páginas, siga enlaces y recoja datos. Te guío paso a paso, con código que puedes copiar y adaptar.

Paso 1: Prepara tu entorno Python

Primero, asegúrate de tener Python 3.10+ instalado (verifícalo con python --version). Te recomiendo crear un entorno virtual para tu proyecto:

1python -m venv venv

2source venv/bin/activate # En Windows: venv\Scripts\activateLuego, instala las librerías necesarias:

1pip install requests beautifulsoup4¡Listo! Abre tu editor de código favorito y prepárate para programar tu rastreador.

Paso 2: Escribe tu primer script de rastreo web

Empecemos obteniendo una sola página. Aquí tienes un ejemplo sencillo:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # Lanza error si no es 200 OK

5 print(response.text[:500]) # Muestra los primeros 500 caracteres

6crawl_page("https://www.scrapingcourse.com/ecommerce/")Deberías ver un fragmento de HTML en la consola: ¡ya estás interactuando con la web!

Paso 3: Sigue enlaces y recopila más datos

Ahora, hagamos que el rastreador siga enlaces y visite varias páginas. Mantendremos una lista de URLs por visitar y un conjunto de URLs ya vistas (para evitar bucles):

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # Límite de seguridad

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"No se pudo acceder a {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Rastreado: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) y url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)Este script rastreará hasta 20 páginas, siguiendo enlaces dentro del mismo sitio. Verás cada URL a medida que se rastrea.

Paso 4: Extrae datos de las páginas

Supongamos que quieres obtener nombres y precios de productos en cada página. Así podrías hacerlo:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ... (igual que antes)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ... (resto de la lógica)

18# Guardar en CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Se extrajeron {len(product_data)} productos.")Ahora tendrás un archivo CSV con todos los productos extraídos, listo para analizar, subir o presumir con tus amigos.

Paso 5: Depura y optimiza tu rastreador

Crear un rastreador es una cosa; hacerlo robusto es otra. Aquí algunos consejos basados en mi experiencia (y varios dolores de cabeza):

- Configura el User-Agent: Algunos sitios bloquean “Python-requests” por defecto. Hazte pasar por un navegador:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - Maneja errores con elegancia: Usa try/except para saltar páginas rotas o bloqueadas.

- Evita bucles infinitos: Lleva registro de las URLs visitadas y pon un límite de páginas.

- Controla la velocidad: Añade

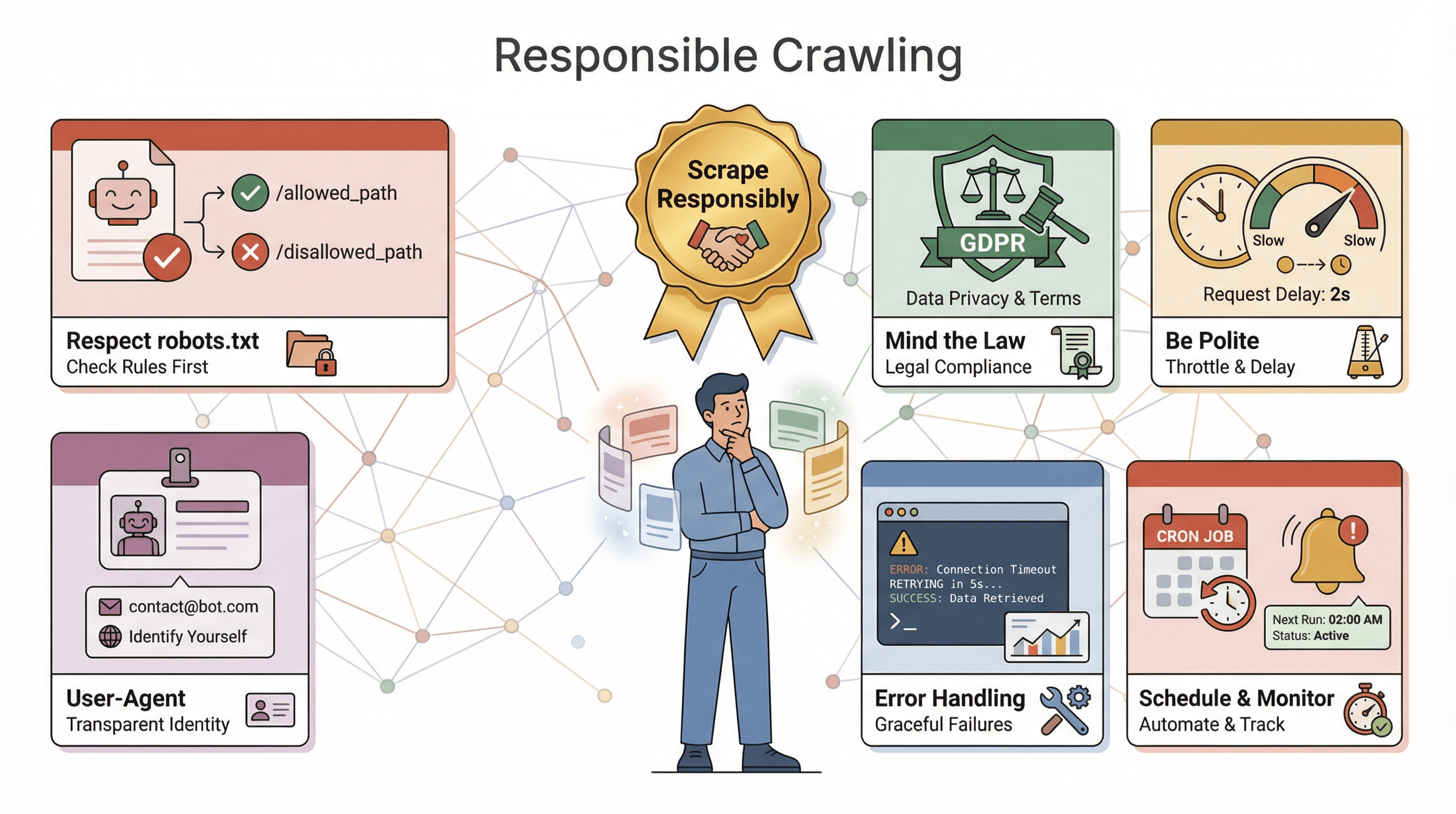

time.sleep(1)entre peticiones para evitar bloqueos. - Revisa robots.txt: Respeta siempre las reglas de rastreo de cada sitio ().

- Registra tu progreso: Imprime o guarda cada URL rastreada; te salvará en la depuración.

Si tu rastreador es bloqueado, recibe contenido raro o pierde datos, revisa los encabezados, baja la velocidad y asegúrate de no estar violando medidas anti-bots.

Thunderbit: simplifica el rastreo web con IA

Ahora hablemos del “botón fácil” para el rastreo web: . Aunque me encanta Python, a veces solo quieres los datos, sin configuraciones, errores ni mantenimiento. Thunderbit es una extensión de Chrome con IA que te permite extraer datos de cualquier web en solo unos clics.

¿Por qué Thunderbit es diferente?

- Sugerencia de campos por IA: Su IA analiza la página y te sugiere qué datos puedes extraer, sin necesidad de inspeccionar el HTML ni escribir selectores.

- Sin código, desde el navegador: Funciona directamente en tu navegador, incluso en sitios con login o mucho JavaScript.

- Raspado de subpáginas: ¿Necesitas más detalles? Thunderbit puede visitar automáticamente cada subpágina (como fichas de producto) y enriquecer tu tabla.

- Exportación instantánea: Exporta tus datos a Excel, Google Sheets, Airtable o Notion, sin pelearte con archivos CSV.

- Raspado en la nube o local: Elige entre velocidad en la nube (para sitios públicos) o modo navegador (para sitios con login o complejos).

- Programación de tareas: Configura extracciones automáticas, sin necesidad de cron ni servidores.

Para usuarios de negocio, Thunderbit es un antes y un después. Pasas de “necesito estos datos” a “aquí está mi hoja de cálculo” en minutos. Y si eres desarrollador, Thunderbit complementa tus scripts: úsalo para tareas rápidas o como respaldo cuando tu código falle.

¿Quieres verlo en acción? y prueba a extraer datos de tu web favorita. El plan gratuito te deja raspar algunas páginas, y los planes de pago empiezan en solo $15/mes por 500 créditos.

Aspectos clave al crear un rastreador web en Python

Antes de lanzar tu rastreador al mundo, unas palabras de precaución (y sentido común):

Antes de lanzar tu rastreador al mundo, unas palabras de precaución (y sentido común):

- Respeta robots.txt: La mayoría de los sitios publican un archivo

robots.txtque indica a los rastreadores qué está permitido. Ignorarlo puede llevarte a bloqueos o incluso problemas legales. Revisa y cumple siempre estas reglas (). - Cumple la ley: Algunos sitios prohíben el scraping en sus términos de uso. Y si recopilas datos personales, pueden aplicarse leyes de privacidad como GDPR o CCPA (). Ante la duda, limítate a datos públicos y no sensibles.

- Sé educado: No satures los sitios con peticiones; regula la velocidad, añade retrasos aleatorios y evita raspar en horas punta.

- Identifícate: Usa un User-Agent personalizado e incluye información de contacto si vas a raspar a gran escala.

- Maneja errores y registra: Espera que los sitios cambien, las páginas fallen y los datos se desordenen. Implementa manejo de errores, logs y monitoreo para solucionar rápido.

- Programa y monitorea: Para extracciones regulares, usa herramientas de programación (como cron o el programador de Thunderbit) y configura alertas si tu rastreador falla o no recoge datos.

La regla de oro: raspa con responsabilidad. La web es de todos; no seas “ese bot” que lo arruina para los demás.

Consejos avanzados: escala y mejora tu rastreador web en Python

Cuando domines lo básico, quizá quieras llevar tu rastreador al siguiente nivel. Aquí algunas ideas:

- Maneja JavaScript: Usa Selenium o Playwright para raspar sitios que cargan datos dinámicamente.

- Escala: Para proyectos grandes, pásate a Scrapy o usa librerías asíncronas (como

aiohttp) para peticiones concurrentes. - Utiliza proxies: Rota direcciones IP para evitar bloqueos en extracciones de alto volumen.

- Automatiza flujos de datos: Escribe directamente en bases de datos o integra con almacenamiento en la nube para grandes volúmenes.

- Monitorea y alerta: Configura logs, chequeos de salud y notificaciones para rastreadores de larga duración.

Si tu rastreador se vuelve crítico, considera servicios gestionados o APIs para delegar el trabajo pesado. Y si raspas varios sitios con estructuras distintas, modulariza tu código para actualizar los analizadores fácilmente.

Conclusión y puntos clave

Crear un rastreador web en Python es una de las habilidades más valiosas en el mundo actual orientado a los datos. Resumamos lo aprendido:

- Los rastreadores web automatizan la visita y extracción de datos de páginas, esenciales para automatización, investigación e inteligencia competitiva.

- Python es la mejor opción para crearlos, gracias a su sintaxis sencilla, potentes librerías y gran comunidad.

- Los métodos de análisis importan: usa regex para tareas rápidas, BeautifulSoup para la mayoría de scripts y Scrapy para proyectos grandes.

- Paso a paso, puedes pasar de obtener una página a rastrear un sitio completo y guardar datos estructurados, sin necesidad de ser experto.

- Thunderbit va más allá, permitiéndote extraer datos con IA, sin código y con exportaciones instantáneas, ideal para usuarios de negocio o quienes buscan rapidez.

- La responsabilidad es clave: respeta las reglas de los sitios, maneja errores y prioriza la ética.

- Escalar es posible con las herramientas adecuadas: Selenium para JavaScript, Scrapy para concurrencia o Thunderbit para automatización sin código.

La mejor forma de aprender es empezar poco a poco: escribe un script, prueba Thunderbit y descubre qué datos puedes obtener. La web es tuya (o tu buffet de datos, si eres tan fan como yo).

¿Quieres profundizar? Mira estos recursos:

- para más consejos, guías y técnicas avanzadas.

¡Feliz rastreo! Que tus 웹 스크래퍼 sean rápidos, tus datos limpios y nunca te falte café.

Preguntas frecuentes

1. ¿Cuál es la diferencia entre un rastreador web y un 웹 스크래퍼?

Un rastreador visita y descubre páginas sistemáticamente (como mapear un sitio), mientras que un 웹 스크래퍼 extrae datos concretos de esas páginas. En la práctica, la mayoría de proyectos combinan ambos: rastrean para encontrar páginas y raspan para obtener la información.

2. ¿Por qué Python es tan popular para crear rastreadores web?

Python es fácil de aprender, tiene librerías potentes (Requests, BeautifulSoup, Scrapy, Selenium) y una comunidad enorme. Casi el 70% de los proyectos de 웹 스크래퍼 usan Python, lo que lo convierte en el estándar del sector.

3. ¿Cuándo usar regex, BeautifulSoup o Scrapy para analizar datos?

Usa regex para patrones simples y predecibles. BeautifulSoup es ideal para la mayoría de scripts: fácil y flexible. Scrapy es perfecto para rastreadores grandes o en producción que requieren velocidad, concurrencia y robustez.

4. ¿Cómo se compara Thunderbit con programar un rastreador en Python?

Thunderbit te permite extraer datos con IA y sin código: solo haz clic, selecciona campos y exporta. Es ideal para usuarios de negocio o tareas rápidas. Python ofrece más control y personalización, pero requiere programación y mantenimiento.

5. ¿Qué aspectos legales o éticos debo tener en cuenta al rastrear sitios web?

Revisa y respeta siempre el robots.txt, cumple los términos de uso del sitio, evita recopilar datos sensibles o personales sin consentimiento y regula la velocidad de tus peticiones para no sobrecargar los servidores. El raspado responsable mantiene la web abierta para todos.

¿Listo para probarlo? o abre tu editor Python favorito y comienza a rastrear. Los datos están ahí fuera, ¡ve por ellos!

Más información